论文笔记:Multilingual Multimodal Pre-training for Zero-Shot Cross-Lingual Transfer of Vision-Language Mo

视觉-语言模型零镜头跨语言迁移的多语种多模态预训练

- 摘要

- 介绍

- 方法

-

- 3.1 Multilingual Multimodal Transformers

- 3.2 Multilingual Text-Video Alignment

- 3.3 When Visually-Pivoted MultilingualAnnotations Are Available

- 4 The Multilingual HowTo100M Dataset

- 5 Experiment

-

- 5.1 Evaluation Datasets

- 5.2 Implementation Details

- 5.3 Experimental Setup

- 5.4 Comparison Experiments and Ablations

- 5.5 VTT Zero-Shot Cross-Lingual Transfer

- 5.6 Comparison to Supervised State of the Art

- 6 Conclusion

摘要

本文研究视觉-语言模型的零镜头跨语言迁移。具体来说,我们关注于多语言文本到视频的搜索,并提出了一个基于Transformer-based的模型来学习语境化的多语言多模态嵌入。在零镜头设置下,我们的经验表明,当我们使用非英语句子查询多语言文本-视频模型时,性能会显著下降。为了解决这一问题,我们引入了一种多语言多模态的预训练策略,并收集了一个新的多语言教学视频数据集(MultiHowTo100M)进行预训练。在VTT上的实验表明,我们的方法在不需要额外标注的情况下,显著提高了非英语语言的视频搜索。此外,当多语言注释可用时,我们的方法在VTT和VATEX上的多语言文本到视频搜索中大大优于最近的基线;以及Multi30K上的多语言文本到图像搜索。

介绍

计算机视觉(CV)和自然语言处理(NLP)交叉点的关键挑战之一是建立通用的视觉语言模型,该模型不仅适用于英语,而且适用于全世界约7000种语言。由于在所有语言中收集和注释特定于任务的并行多模态数据是不切实际的,因此非常需要一个框架,使视觉语言模型跨语言通用化。

一种有望大大提高NLP模型对新语言的适用性的技术是零帧跨语言迁移,即在源语言上训练的模型被应用到另一种语言上,而不需要任何额外的标注训练数据。 特别是,最近的跨语言迁移技术已经证明,通过在多种语言上执行语言或翻译模型的无监督学习,然后仅使用英语注释进行下游任务微调,模型仍然可以推广到非英语语言。这一成功归因于许多语言共享相当数量的基础词汇或结构。 在词汇水平上,语言通常有来自同一起源的单词,例如英语中的“desk”和德语中的“Tisch”都来自拉丁语的“discus”。在结构层次上,所有语言都有一个递归结构,许多语言在词法或词序方面有共同的特征。

对于视觉-语言模型的跨语言迁移,视觉信息显然是一个必不可少的要素。为此,我们做出了一个重要但尚未充分探索的步骤,将视觉-文本关系纳入到改进多语言模型中,虽然口语可能不同,但所有人类都有相似的视觉系统,许多视觉概念都可以被普遍理解,例如,说英语的人叫“cat”,说法语的人叫“chat”;他们理解类似。我们利用这一观察来学习将不同语言的句子与视觉概念联系起来,以促进视觉语言模型的跨语言迁移。

在本研究中,我们专注于文本到视频的多语言搜索任务,并提出了一个基于Transformer的视频文本模型来学习上下文多语言多模态表示。当使用多语言注释进行训练时,我们的普通模型在多语言文本→视频搜索中产生了最先进的性能。然而,在零镜头设置下,相当令人惊讶的是,英语和非英语查询之间存在显著的性能差距(详见§5.5)。为了解决这个问题,受大规模语言模型和多模态前训练的最新进展的推动,我们提出了一种多语言多模态预训练(MMP)策略,以利用大规模多语言文本-视频数据的弱监督。 我们构建了Multilingual-HowTo100M数据集,该数据集扩展了英语HowTo100M (Miech等人,2019)数据集,为120万个教学视频包含9种语言的字幕。

我们的方法有两个重要的好处。首先,与仅针对英语视频数据的预培训相比,针对多语言文本视频数据的预培训利用了来自多种语言的额外监督,因此提高了针对单个语言的搜索性能。其次,通过将视觉数据作为一个隐式的尺度“轴心”,我们的方法在多语言多模态嵌入空间(如“cat”–“chat”)中学习到更好的对齐,从而改善视觉语言模型的零镜头跨语言迁移(如从“cat”到“chat”–)。

在我们对VTT(Xu等人,2016)和V A-TEX(Wang等人,2019)的实验中,我们的方法产生了最先进的英语→视频搜索性能。对于零镜头跨语言迁移,提出的多语言多模态预训练将9种语言的英语视频预训练平均提高2 ~ 2.5平均R@1。我们的方法在多语言文本→VATEX上的视频搜索和在Multi30K上的文本→图像搜索方面的性能大大优于它们。

综上所述,我们做出了以下贡献:

(1)我们提出了一种transformer-based的视频文本模型,可以学习上下文多语言多模态表示(§3.1)。

(2)我们的经验证明,视觉语言模型不同于NLP模型,具有有限的零镜头跨语言可移动性。(§5.5)。

(3)引入多语言多模态预训练策略,构建新的Multi-HowTo100M数据集(§4)进行预训练,以提高视觉-语言模型的零镜头跨语言能力。

(4)我们展示了我们的方法的有效性,在零镜头(§5.5)和完全监督设置(§5.6)中实现了最先进的多语言文本→视频搜索性能。

方法

我们考虑从视频文本对 { ( x i , v i ) } i = 1 C \{(x_i, v_i)\}^C_{i=1} {(xi,vi)}i=1C的语料中学习多语言多模态表示的问题,其中 v i v_i vi是一个视频剪辑, x i x_i xi是用k种语言中的一种编写的相应文本(字幕或转录)。我们的目标是学习共享的多语言文本编码器 c x = Φ ( x ) c_x= Φ(x) cx=Φ(x)和视频编码器 c v = Ψ ( v ) c_v= Ψ(v) cv=Ψ(v),两者都将输入投射到共享的d维嵌入空间 c v , c t ∈ R D c_v, c_t∈R^D cv,ct∈RD,其中语义相似的实例(即paired ( x i , v i ) (x_i, v_i) (xi,vi))比不同的实例(即 ( x i , v j ) (x_i, v_j) (xi,vj), i ≠ j i \ne j i=j)彼此更接近。下面,我们将一批多语言文本-视频样本表示为 B = { ( x i , v i ) i = 1 B } B=\{(x_i, v_i)^B_{i=1}\} B={(xi,vi)i=1B}其中B⊂C。

3.1 Multilingual Multimodal Transformers

多语言多模态转换器

图1给出了该方法的概述。我们的文本编码器由一个多语言Transformer(例如,多语言BERT (Devlin et al., 2019))和一个文本Transformer pooling head(如下所述)组成。类似地,我们的视频编码器由3D-CNN(例如R(2+1)D网络(Tran等人,2018))和视频Transformer pooling head组成。我们使用这些multilingual multimodal Transformers对文本和视频进行编码以进行对齐。

与之前利用单词嵌入和rnn的多语言文本图像模型不同,我们的多语言文本编码器是建立在一个多语言Transformer上的,它生成上下文多语言表征性 e x ∈ R N × D e_x∈R^{N×D} ex∈RN×D,以编码包含N个单词的x个句子。我们使用了一个额外的2层Transformer,我们将其称为“Transformer pooling head (TP)”,因为它作为一个池函数,有选择地对可变长度的句子进行编码,并将它们与相应的视觉内容对齐。我们使用第2个Transformer层的第一个输出标记作为最后的句子表示。

c x = T r a n s x ( 2 ) ( q u e r y = k e y = v a l u e = e x ) [ 0 ] c_x= Trans^{(2)}_x(query=key=value=e_x)[0] cx=Transx(2)(query=key=value=ex)[0]

其中 t r a n s x ( 2 ) trans^{ (2)}_x transx(2)是一个2层的transformer堆栈,在multihead注意中 e x e_x ex有(query,key,value)。请注意,我们使用相同的文本编码器来编码所有语言的句子。

对于视频编码,我们的模型使用预先训练的3D CNN对视频中的时空上下文进行编码,对于m秒的视频v,我们将R(2+1)D 和S3D网络应用于其帧,连接网络输出,并应用一个线性层对视觉输入 e v ∈ R M × D e_v∈R^{M×D} ev∈RM×D编码到我们的模型中。与文本部分类似,我们使用一个two-layer Transformer as the pooling head ,将不同长度的视频编码为固定长度的表示。![]()

由于视频通常很长,帧率很高(例如,30fps),因此无法同时更新3d - cnn,因此我们使用了预先提取的视频特征。用 θ = θ m B E R T ∪ θ T r a n s x ∪ θ T r a n s v θ=θ_{mBERT}∪θ_{Trans_x}∪θ_{Trans_v} θ=θmBERT∪θTransx∪θTransv对模型进行参数化。

3.2 Multilingual Text-Video Alignment

多语言文字-视频对齐

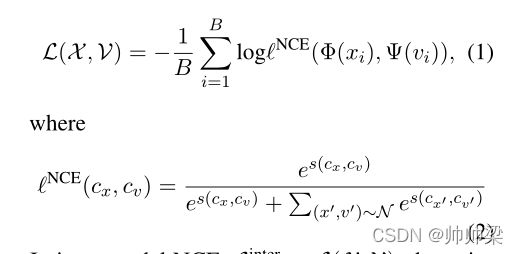

在学习多模态表示时,通常的做法是最小化对比目标,将相关的(视频、文本)嵌入映射到共享的嵌入空间中彼此接近。在视频文本中,The inter-modal max-margin triplet loss得到了广泛的研究和图像-文本研究。在这项工作中,我们用噪声对比估计目标(NCE)概括和建模所有的跨模态、内模态和跨语言实例

Inter-modal NCE. : 设X和V分别表示b中采样的多语言句子和视频的子集。令s(a, b)为余弦相似度度量。我们使用一个(跨模态)NCE目标定义为:

在Inter-modal NCE中, L i n t e r = L ( X , V ) L_{inter}=L(X,V) Linter=L(X,V),噪声N是一组“负”视频文本对,这些视频文本对被采样以加强成对视频文本对的相似性,成对的文本相似度高,否则相似度低。

直观地说,跨模态NCE将成对(语义相似)实例拉近,并将非成对(不同)实例推开。请注意,我们不区分X中的语言类型,所有语言的句子都将在共享的多语言文本视频嵌入空间中绘制到相应的视频中。 (这个很重要,也就是我们的训练不区分英文中文,同时训练投影)

Intra-modal NCE. : 模态内NCE

除了跨模态匹配之外,我们还利用模态内对比目标来学习和保存视频和文本模态中的底层结构。For example,威尔斯柯基犬 hould be closer to 哈士奇 than 巴厘猫,我们的模型利用了模态内的NCE,该NCE约束学习的表示对噪声保持不变,并同时保持内模态结构。

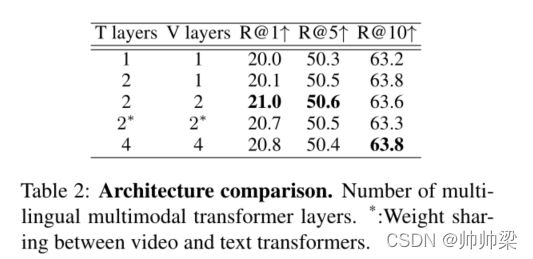

我们最大限度地减少了以下模态内NCE损失:

其中 x m 和 v m x^m和v^m xm和vm是原始句子和视频的噪声版本。对于噪声,我们随机屏蔽5%的多语言文本标记和视频剪辑。我们通过以下方式优化我们的模型:

3.3 When Visually-Pivoted MultilingualAnnotations Are Available

当视觉上旋转多语言注释时可用 —当可视轴多语言批注可用时

在许多多语言多模态数据集中,有不同语言的句子描述共享的视觉环境。

例如,VATEX中的每个视频都有10个英文和10个中文描述。通过这些视觉旋转(弱平行)句子(x,y),我们进一步修改对比目标,以利用这一额外的监督信号。给定一个包含所有可能的视觉数据透视对组合{(xi,vi,yi)}cpi=0的视觉数据透视语料库Cp,我们对批次 B p = { ( x i , v i , y i ) } i = 1 b p B^p=\{(x_i,v_i,y_i)\}^{b_p}_{i=1} Bp={(xi,vi,yi)}i=1bp, B p B^p Bp⊂ C p C^p Cp并将对比目标修改为:

Visual-pivoted Cross-lingual NCE. : 视觉轴心跨语言交际

受XLM(Lample和Conneau,2019)中的翻译语言建模(TLM)的启发,我们提出了一个类似于TLM的多模态对比目标,它促进了描述同一视频的不同语言描述的对齐。我们使用直觉,以视频为条件,不同语言中的描述(不必是翻译对)可能在语义上相似。为此,我们将跨语言NCE设置为:

对于视觉中枢句子,如图1所示,我们根据它们描述的视频生成它们的表示。

在推理时,我们简单地应用 c x = Φ ( x ) 和 c v = ψ ( v ) c_x=Φ(x)和c_v=ψ(v) cx=Φ(x)和cv=ψ(v)对多语言文本查询和视频进行编码。对于文本到视频搜索,我们根据文本查询的余弦相似性分数对视频进行排序。

4 The Multilingual HowTo100M Dataset

由于大规模的预训练在最近的NLP和vision语言模型中已显示出重要意义,我们构建了多语言HOWT100M数据集(Multi-HOWT100M),以促进多语言多模态学习的研究。最初的HowTo100M(Miech et al.,2019)数据集是YouTube上120万个教学视频(约1.38亿个剪辑/片段)的大规模视频集合,以及作为字幕的自动语音识别(ASR)转录。对于HowTo100M中的每一个视频,我们抓取并收集YouTube提供的多语言字幕,这些字幕要么由用户生成,要么由Google ASR生成,在没有用户生成字幕的情况下进行翻译。基本上,我们收集9种语言的视频字幕:英语(en)、德语(de)、法语(fr)、俄语(ru)、西班牙语(es)、捷克语(cz)、斯瓦希里语(sw)、汉语(zh)、越南语(vi)。

在收集数据集时(2020年5月),有110万个视频可用,每个视频都有7-9种语言的字幕。视频长度从1分钟到超过20分钟不等。我们利用Multi-HowTo100M进行多语言多模态预训练,以利用大规模多语言文本视频数据的弱监控。在图2中,我们提供了Multi-HowTo100M的少数实例的可视化,以及相应的视频帧、时间戳和不同语言的转录。有关更多详细信息和数据集统计信息,请参阅附录。

5 Experiment

在本节中,我们首先描述我们的实验装置(§5.1-5.3)。在§5.4中,我们进行了消融研究,以验证提议的多语言文本视频模型的有效性。利用手头上最好的模型,我们在§5.5中调查了它们的零射程跨语言迁移能力,其中我们展示了提议的多语言多模态预培训是关键的促进者。然后我们验证高级文本→在§5.6中的单语、多语和跨模态设置下,我们的方法的视频搜索性能。

5.1 Evaluation Datasets

- MSR-VTT (VTT): MSR-VTT (VTT)包含10K视频,其中每个视频都带有20个字幕。此外,我们使用现成的机器翻译模型将英文字幕翻译成8种语言,从而创建了伪多语言数据。1我们使用官方培训集(6.5K视频)和验证集(497视频)。我们遵循Miech等人(2019)的协议;Liu et al.(2019)对文本进行评估→使用Yu等人(2018)定义的1K测试集进行视频搜索。

- VATEX: 是一个包含35K视频的多语言(中文和英文)视频文本数据集。每个视频有五个(en,zh)翻译对和五个非成对的en和zh描述。我们使用官方培训分割(26K视频)并遵循Chen等人(2020a)的测试协议,将验证集平均分割为1.5K验证和1.5K测试视频。

- **Multi30K ** :是Flickr30K的多语言扩展(Young等人,2014)。对于每幅图像,有两种类型的注释可用:(1)一种平行(英语、德语、法语、捷克语)翻译对和(2)五种独立收集的英语和五种德语描述。训练、验证和测试分割分别包含29K、1K和1K图像。

5.2 Implementation Details

对于视频主干,我们使用了一个34层的R(2+1)-D(Tran等人,2018)网络,该网络在IG65M(Ghadiyaram等人,2019年)上进行了预培训,而S3D(Miech等人,2020年)网络在HowTo100M上进行了预培训。我们预先提取视频特征,并将两个3D-CNN输出连接起来,形成 e x ∈ R M × 1024 e_x∈ R^{M×1024} ex∈RM×1024作为视频输入。

对于文本主干,我们使用多语言BERT(mBERT)(Devlin et al.,2019)或XLM Robertalarge(XLM-R)(Artetxe et al.,2020),后者实现NLP任务的近SoTA零炮跨语言传输性能。继Hu等人(2020年)之后,我们不再使用顶层,而是以XLM-R和mBERT输出第12层。对于视觉语言任务,我们将层冻结在9以下,因为根据经验,此设置执行得最好。

我们的模型为文本和视频转换器池(TP)模块采用了一个2层转换器和4头注意。嵌入维度D设置为1024。我们使用Adam(Kingma和Ba,2015)优化器和0.0002的学习率来训练我们的模型16个(预训练)和10个(微调)阶段。所有噪声对比目标中的softmax温度设置为0.1。

5.3 Experimental Setup

我们使用Multi-HowTo100M进行多语言多模式预培训(MMP)。对于每个视频,我们随机采样开始和结束时间来构建视频剪辑。对于一个视频剪辑,我们从9种语言中随机抽取一种语言类型,并使用时间最接近的连续ASR转录本组成(文本视频)对进行训练。为了简单和快速,我们遵循XLMR的训练协议,在不使用翻译对的多语言语料库上进行预训练,也就是说,我们使用多语言文本-视频对(x,v),但不使用从Multi-HowTo100M的翻译对(仅仅使用翻译对,但是不使用文本对),并且只使用模式间和模式内(没有跨语言)(等式1-3)进行MMP训练。

我们在VTT、VATEX和上对模型进行微调,在Multi30K上评估文本→视频搜索任务。在零镜头跨语言迁移实验中,我们仅使用英语视频数据,并使用公式1-3进行微调。然后,我们用非英语查询测试模型。当其他语言的注释可用时(由VATEX中的人类和VTT中的MT模型(即翻译列车)提供的Multi30K),我们利用所有可用的多语言注释(即,完全监督)并迭代所有可能的(x、v、y)对,使用等式5-7进行训练,以证明评估VTT上的zeroshot跨语言迁移的强大性能目标,并与多语言文本中的其他完全监督基线进行公平比较→在VATEX和Multi30K上进行视频搜索。我们在k报告标准召回(R@k)指标(越高越好)。

5.4 Comparison Experiments and Ablations

在本节中,我们将对不同的文本/视频编码器、转换器模型架构和英语学习目标进行分析和比较→视频搜索VTT。

文本和视频编码器 :表1比较了不同的文本和视频编码器主干。对于视觉编码器,虽然R(2+1)D优于S3D(两种结构吧),但其输出特性的简单串联(即早期融合)提供了1.5∼ 2.0改进R@1.对于文本编码器,XLM-R的性能明显优于mBERT。

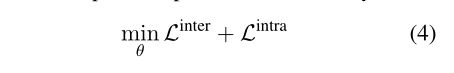

Transformer Pooling :表2比较了提议的变压器池模块的各种配置。我们观察到,一个简单的2层变压器实现了最好的性能。 视频和文本转换器的权重共享会略微降低性能。因此,我们选择将它们分开。

Learning Objective. : 从表3可以看出,模内对比目标对于NCE和三重态丢失都很重要。总的来说,NCE损耗优于三重态损耗。提出的模式间和模式内NCE目标实现了最佳性能。当多种语言的字幕可用时,跨语言NCE还提供了一致的改进。

5.5 VTT Zero-Shot Cross-Lingual Transfer

表4显示了多语言文本→视频搜索结果在VTT上。有了最好的英语视频模型(以mBERT或XLM-R作为文本主干),我们首先调查这些模型在零镜头设置下转换到其他非英语语言的效果。然后,我们分析了建议的多语言多模式预培训的好处。

表4:Recall@1多语种文本的翻译→视频搜索VTT

Upper::Zero-shot cross-lingual transfer.。

Lower::使用用于培训的合成伪多语言注释的性能。

MMP:多语种多模式 on Multi-HowTo100M. :。

MP: Multimodal (English-Video) pre-training on HowTo100M.

上半部分显示了Zero-shot结果。与NLP任务中的跨语言迁移不同,在视觉语言任务中使用多语言transformer显然不能很好地跨语言推广。例如,当直接将英语微调模型应用于德语→视频搜索时,R@1 (mBERT 21.0→XLM-R)的搜索结果显著下降(19.9→11.1(-44%)→16.3(-24%)。相比之下,在XNLI中,XLM-R在en→de跨语迁移上只有-10%的退化(Conneau等人,2018)。与从头开始的模型相比,HowTo100M上的多模式(英语视频)预训练(MP)只提高了平均R@1(+0.1或mBERT和+1.1的XLM-R)。相比之下,我们提出的多语言多模态预训练(MMP)是零镜头跨语言迁移的关键促进因素。MMP提高了德语→视频搜索(11.1→15.0,mBERT为+35%,XLM-R为16.3→19.4,+20%),平均提高了2.6 ~ 2.8。我们将MMP的有效性归因于学习在共享嵌入空间中提高了多语言文本和视觉上下文之间的对齐,通过微调,我们观察到英语→视频和非英语→视频之间的相对平衡的改进。

图3显示了R@1的趋势,同时为MMP增加了额外的语言。对于XLM-R,当使用更多的多语言文本-视频对进行前训练时,R@1的改进渐近收敛。另一方面,对于零拍德语→视频搜索,即使附加语言(如法语)与目标语言(如德语)不同,使用更多语言进行预训练也能不断提高搜索性能。

表4的下半部分显示了使用(合成的)伪多语言注释进行微调的模型的结果。它可以被视为translate-train 场景,作为评估零镜头跨语言迁移的一个强大的性能目标,如Lample和Conneau, 2019;胡等人,2020年)。

mBERT和XLM-R都使用域内翻译的伪多语言注释在非英语语言中产生了更好的性能。然而,对于英语→视频搜索,与零镜头设置相比下降了0.7。这可能是由于翻译的字幕中的噪音。值得注意的是,使用mBERT模型的零镜头和转换列车设置之间仍然存在性能差距。相比之下,对于使用XLM-R的模型,这种差距要小得多。在下面的部分中,我们将our - mmp作为最好的模型,以XLMR作为文本主干,并将其与其他最先进的方法进行比较。

Qualitative Results : 图4为零拍设置下VTT上our - mmp (VTT:en-only)的多语言文字→视频搜索结果。请注意,所有语言的文本→视频搜索只使用一个共享的英语微调模型。正如所演示的,所提出的模型成功地检索了英语(en)和俄语(ru)查询的正确视频。其他排名靠前的视频也与正确的视频有着相似的视觉外观。对于将英语微调模型的零镜头转换到遥远的语言(如越南语(vi)和汉语(zh)),我们观察到,我们的零镜头模型在理解抽象概念(如“空间项目”)和将小对象(如“麦克风”)与遥远语言的文本查询相关联方面仍然存在局限性。

5.6 Comparison to Supervised State of the Art

**English→Video Search on VTT. ** :表5为英语→视频模式在VTT上的对比。为了与其他基线进行公平的比较,我们的模型只对VTT上的原始英文注释进行了微调。结果表明,我们的模型大大优于其他基线。具体来说,我们的模型比原始的HowTo100M模型(Miech等人,2019)和其他近期在HowTo100M上进行预训练的基线实现了8.9 R@1的改进。使用更小的视觉特征集,并在更小的(6,513 vs 9,000)训练集2上进行训练,我们的模型在有或没有预先训练的情况下也优于CE (Liu et al., 2019)。

Multilingual Text→Video Search on VA-TEX. :表6总结了VATEX数据集上英文→视频和中文→视频的搜索性能。在我们只用英语视频对进行训练的零镜头设置下,我们的模型已经优于其他基线。然而,在英语→视频搜索和汉语→视频搜索之间观察到明显的性能差距,表明即使使用XLM-R,跨语言迁移到远程语言仍然具有挑战性。随着MMP的提出,差距在R@1/5/10中显著缩小了5.8/8.1/7.7。当领域内的人类注释中文字幕可用时,我们的模型的性能可以进一步提高,并且我们的模型产生了新的最先进的性能。

Cross-Modality Transfer to Multi30K: From Video-Text to Image-Text. :为了扩展图像-文本任务中零镜头跨语言迁移的研究,我们研究了视频-文本模型跨模式迁移的可行性。我们将原始视频文本模型中的3D-CNN替换为2D-CNN,对图像进行编码。在实践中,在mh - d (Huang et al., 2019b)之后,我们利用在视觉基因组(Krishna et al., 2016)中预先训练的fast - rcnn (Ren et al., 2015)来提取区域视觉特征。本质上,图像被编码为ev = RM ×H,其中M = 36是图像中可视对象的最大数量。对于使用MMP的模型,我们使用在Multi-HowTo100M上预先训练的模型来初始化它们的权值。为了解决2D-CNN和3D-CNN之间的特征不匹配,我们利用一个学习速度加倍的线性层来将2D-CNN特征映射到与3D-CNN特征相同的维度上。

表7显示了Multi30K的结果。对于零镜头跨语言迁移,当从头开始训练(M30K:en-only)时,我们的模型获得了与MHA-D相当的性能,但在德语→图像搜索中滞后,因为它只使用了英语注释。 在our - mmp中,即使存在模态差异,前训练也能改善所有的回忆指标。R@1的平均改进是3.2。我们观察到(相对)资源较少的语言(如捷克语)获得了更大的收益。在不使用任何捷克语注释的情况下,我们的MMP零镜头模型实现了与smallr (Burns et al., 2020)相当的捷克语→图像搜索性能,后者使用包括捷克语在内的10种语言。然而,当跨模式迁移且仅使用英语注释时,英语→Image和德语/捷克语→Image搜索之间存在性能差异,这意味着跨模式迁移模型是可行的,但仍具有挑战性。我们认为零镜头跨语模态跨语迁移是我们未来的工作。

为了与其他基线进行公平的比较,当使用Multi30K提供的所有4种语言的注释进行训练时,我们的模型在多语言文本→图像搜索中大大优于所有基线。

6 Conclusion

我们提出了一种多语言多模态预训练(MMP)策略、Multi-HowTo100M数据集和一个基于变压器的文本-视频模型来学习语境多模态表示。本文的研究结果有力地证明了MMP是视觉-语言模型零镜头跨语言迁移的重要组成部分。与此同时,还存在许多挑战,如解决零镜头和领域内非英语标注训练之间的性能差距;以及转换多种视觉语言模型(例如,VQA (Goyal等人,2017)、TVQA (Lei等人,2020))或视觉增强的NLP模型,如无监督多模态机器翻译(Huang等人,2020b)。我们相信,我们提出的方法,以及我们释放的相应资源,将是在这个方向上推动更多研究的重要的第一步。