深度学习第一篇论文阅读笔记(VQA Visual Question Answering)

1 VQA Visual Question Answering

-

- 一,介绍

- 二,数据集收集

-

- 1,图像

- 2,问题

- 3,答案

- 三,数据集分析

-

- 1,问题

- 2,答案

- 3,常识与标题

- 四,VQA基线和方法

-

- 1,基线

- 2,方法

- 五,结论

- 相关链接

前言 写这篇论文笔记之前,我已经学习了cs231n的课程并浏览了余俊老师发表的《视觉问答技术研究》。

一,介绍

这篇论文介绍了视觉问题回答(VQA)的任务是给定一个图像和一个开放式的、关于图像的自然语言问题,提供一个准确的自然语言答案。论文提供了一个包含超过250K 图像,760K 问题和大约 10M 答案的数据集。介绍了数据集(包括图像,问题和答案)收集,然后对数据集进行了细致地分析,展示了各种各样的问题和答案,以及在计算机视觉、自然语言处理和常识推理方面所需的各种各样的技术和方法。提出将问题的 LSTM 与图像的 CNN 相结合来生成答案。最后给出了各种(包括最佳运行模型(deep LSTM Q + norm I))进行视觉问答的方法和结论。

二,数据集收集

因为任务是一个给定图像和一个关于图像的自然语言问题,提供一个标准的自然语言答案。所以,数据集包括图像,问题和答案。

1,图像

真实图像real images

包含多个对象和丰富的上下文。 (MS COCO)数据集的 123,287 张训练和验证图像和 81,434 张测试图像。将场景分为 20K/10K/20K分别用于训练,验证和测试。

抽象场景 abstract scenes

单个的图像。一个包含 50K 场景的新的抽象场景数据集。数据集包含 20 个“纸娃娃”人体模型,跨越性别、种族和年龄,有 8 种不同的表情。四肢是可调的,以允许连续的姿态变化。剪纸可以用来描绘室内和室外的场景。这组照片里有 100 多个物体和 31 只动物,摆出各种姿势。

2,问题

要求:多样,有趣,恰当,让人类受试者结合图像回答问题,包含了0.76亿个问题。每张图像至少 3 个问题,每个问题 10 个正确答案。

3,答案

开放性问题的答案

使用这个精度,进行度量与评估

这意味着如果至少有3名工作人员提供了确切的答案,则答案被认为是100%准确的。

多项选择问题的答案

对于多项选择题,每个问题有 18 个候选答案。收集了正确的:似是而非的:普遍的;随机的共18个独一无二的答案。

1,正确答案:通过十个注释给出的最常见的答案。

2,合理的答案:从注释者那里收集三个答案,而不看图像。

3,热门答案:数据集中最受欢迎的十大答案(如“是”,“否”,“2”,“1”,“白”,“3”,“红”,“蓝”,“4”用于真实图像的“绿色”)

4, 随机答案:为其他问题随机选择正确的答案。

三,数据集分析

1,问题

鉴于英语中产生问题的结构,我们可以按问题开头的单词将问题分成不同的类型。下图是基于问题的前四个单词的问题分布情况,展示了不同类型题型的百分比。大多数问题都有4 到 10 个单词。

2,答案

答案的类型有比较常见的典型的,比如是和不是,左右,颜色等。也有丰富多样的。

答案多为单字,真实图像中包含 1 个、2 个、3 个单词的答案分布分别为 89.32%、6.91%、2.74%,抽象场景中包含 1 个、2 个、3 个单词的答案分布分别为 90.51%、5.89%、2.49%。

对于答案也考虑了受试者回答问题时的信心,平均来说,无论是真实图像(83.30%)还是抽象场景(87.49%),人们之间的回答都有显著的一致性。

3,常识与标题

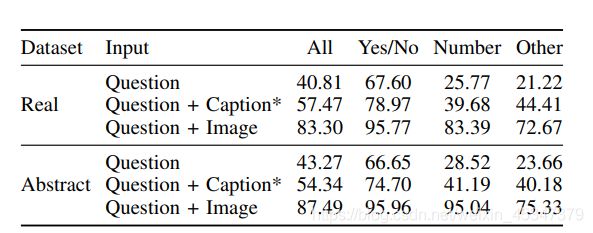

有些问题有时仅凭常识就能正确回答,而不需要借助图像,如“消防栓的颜色是什么?”。下图反映了真实图片与抽象场景在仅考虑问题,问题与标题结合,以及问题与图像结合三种情况下的准确性。对于使用问题与图片标题结合的情况,其准确率比仅使用问题高得多,但是比结合图像的低的多。

四,VQA基线和方法

1,基线

论文实现了下面这几种基线:

1)随机: 从 VQA train/val 数据集的前 1K 个答案中随机选择一个答案。

2)优先(“是”): 对于开放性和多项选择题,我们总是选择最普遍的答案(“是”)。请注意,“是”总是多项选择题的选项之一。

3) 问题型优先: 对于开放式的任务,选择每个类型的问题最常见的答案。对于多项选择任务,我们使用特性空间中的余弦相似度,从提供的选项中选择与开放式任务中选择的答案最相似的答案。

4)最近邻: 给定一幅测试图像,一对问题,我们首先从训练集中找到 K 个最近邻问题和相关图像。接下来,对于开放式任务,我们从这组最近邻问题图像对中选择最常见的正确答案。类似于“问题类型优先”的基线,对于多项选择任务,选择(从提供的选项)的答案是最相似的,为开放式任务使用余弦相似度。

2,方法

开发了一个 2 通道的视觉(图像)+语言(问题)模型。

图像通道:

- I: 利用 VGGNet最后一层隐藏层的激活作为 4096- dim 图像嵌入。

- norm I: 这些是在 VGGNet的最后一个隐藏层使用L2正则化激活。

问题通道:三种方法进行嵌入:

1 词袋问题(BoW Q) 问题和答案的第一个单词有很强的相关性。选择前30个创建一个词袋。

2 LSTM Q 具有一个隐藏层的lstm对1024维的问题进行嵌入。对对每一个问题字进行编码,采用全连通层+tanh 非 线 性 将 其 进 行 300维 嵌 入 , 然后供给LSTM。

3 deeper LSTM Q:使用具有两层隐藏LSTM将问题进行2048维嵌入,然后利用全连通层+ tanh 非线性函数将 2048-dim 嵌入变换为 1024维。

多层感知机:将图像和问题结合。首先通过全连通层+ tanh 非线性将图像嵌入变换为 1024-dim 来匹配问题的 LSTM 嵌入。转换后的图像和 LSTM 嵌入(在公共空间中)然后通过元素的乘法进行融合。

论文的最佳运行模型(deep LSTM Q + norm I),该模型使用两层 LSTM 对问题进行编码,使用 VGGNet的最后一层隐藏层对图像进行编码。图像特征是L2 归一化。问题和图像特征都被转换到一个公共空间,并通过元素逐点相乘法进行融合,然后通过一个完全连接层,接着是一个 softmax 层,以获得答案的分布。

五,结论

忽略图像的单独语言方法(per Q-type prior, BoW Q, LSTM Q)表现令人惊讶,其中 BoW Q 在开放性测试中达到48.09%(多选项测试中 53.68%),LSTM Q 在开放性测试中达到 48.76%(多选项测试中54.75%);两者都优于最近邻基线(开放式:42.70%,多项选择:48.49%)。

最佳模型(深层 LSTM Q + norm I,在 VQA 测 试 标 准 上 的 准 确 率 为58.16%(开放的)/ 63.09%(多项选择)。最佳模型能够显著地优于视觉基线和语言基线。一般的趋势是选择题的结果比开放式的好。所有的方法都比人类的性能差得多。

在验证问题上评估最佳模型(更深入的 LSTM Q + norm I),有年龄注释(一个人需要多大岁数才能正确回答这个问题),为 5-8 岁是数据集中最常见的年龄组。

相关链接

文章链接:https://visualqa.org/index.html

代码链接;https://github.com/GT-Vision-Lab/VQA_LSTM_CNN

几种常见正则化方式(L2/L1/Maxnorm/Dropout):

https://zhuanlan.zhihu.com/p/21560667?refer=intelligentunit

几种常见激活函数对比(svm/softmax/tanh等):

https://zhuanlan.zhihu.com/p/21462488?refer=intelligentunit

LSTM:https://zhuanlan.zhihu.com/p/32085405

VGGNet:https://blog.csdn.net/u013181595/article/details/80974210

几种常见的卷积神经网络(LeNet / AlexNet / ZFNet / GoogLeNet / VGGNet):

https://zhuanlan.zhihu.com/p/22038289?refer=intelligentunit

VGGNet:它主要的贡献是展示出网络的深度是算法优良性能的关键部分。他们最好的网络包含了16个卷积/全连接层。网络的结构非常一致,从头到尾全部使用的是3x3的卷积和2x2的汇聚。