全球44家机构,55位大佬,历时两年,打造最强NLG评测基准!

文 | 小轶

(大家好,我是已经鸽了夕总仨月没写文章了的小轶(yì)!新的一年一定改过自新,多读paper多写稿,望广大读者敦促(ง •̀_•́)ง)

今天要和大家分享的是卖萌屋学术站上的本月最热paper。何以最热,看它头上顶了多少大厂tag大概就知道了:

点开paper以后,小铁我更是直呼好家伙.....

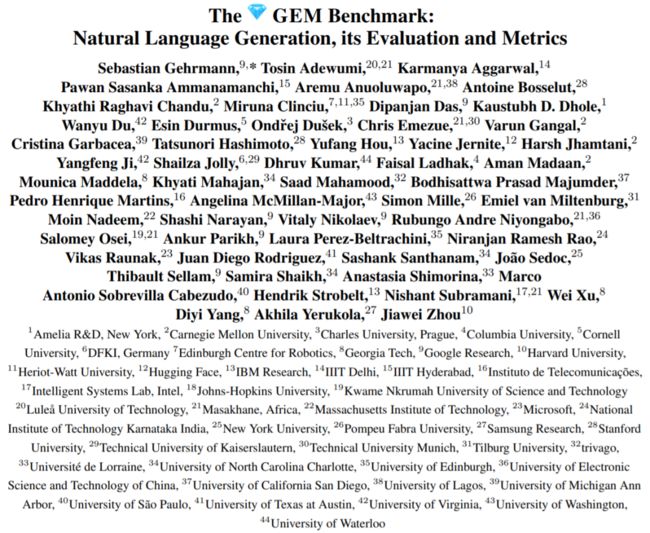

超长author list——55位作者众星云集,来自共计全球44家不同机构。并且,在paper末尾更是花了近两页纸的篇幅详细记录每一位作者的贡献。足见项目之庞大,工作量之大。

这个集结了这么多各地大佬的神仙项目,致力于打造一个最强自然语言生成(NLG)评测基准——GEM。同名ACL 2021 workshop正在征稿,workshop的目标亦在于进一步强化完善GEM的评测体系。不出意外的话,GEM未来很可能成为NLG community中主流认可的评测基准。

论文题目:

The GEM Benchmark: Natural Language Generation, its Evaluation and Metrics

论文链接:

https://arxiv.org/pdf/2102.01672.pdf

项目主页:

https://gem-benchmark.com/

Arxiv访问慢的小伙伴也可以在 【夕小瑶的卖萌屋】订阅号后台回复关键词 【0301】 下载论文PDF~

NLG评测困境

NLG评测困境

NLG评测一直以来都存在诸多困难。我们可以从数据集和评测指标两方面来总结一下。

首先是 数据集 。一方面是数据集的易用性。作者提倡每个数据集都配有一张Data Card,清晰地说明它的任务、语言、数据格式、潜在问题和局限性等等 [1]。另一方面是数据集的研究意义。随着NLG技术的不断发展,一些早期提出的数据集已经能够被很好地解决了。相应地,继续在这样的数据集上进行评测就意义不大了,不能因为这个数据集citation高就坚持用它。而那些真正具有进一步研究意义的数据集应该被加以更多的重视。

除了数据集,还有就是 评测指标 的问题。大家其实都知道BLEU、ROUGE等传统自动化指标的评测是不全面的。模型的更多特性,例如公平性、安全性、鲁棒性等等,都不能够通过它们准确度量。但大家还是用得义无反顾,因为测试成本低,也便于和prior works比较。当然,人工评测是一种解决办法。但人工毕竟成本高昂。另一个比较大的问题就是人工评测存在难以复现、标准不统一的问题。

那么,究竟哪些数据集是当前NLG领域最具代表性研究意义的?又应该采用哪些评测指标呢?

GEM的提出就意在解决上述两个问题。显然,这两个问题的答案是有时效性的。随着NLG技术的发展、新的数据集和评测指标的不断提出,问题的答案自然也会相应变化。所以,作者在论文中一再强调:GEM是一个将会不断更新的“活”基准(living benchmark)。

GEM的作者团队已经根据NLG领域当前的发展现状,初步探讨了GEM_1.0版本应该包含的数据集和评测指标。同时,更是为之举办了同名ACL workshop,邀请NLG community的同僚们对GEM进行测评,并提出完善建议。

GEM的数据集

GEM的数据集

为了确定GEM应该包含哪些数据集,作者团队精挑细选,经历了一个漫长的讨论过程。首先由作者团队中每个人提议若干数据集作为候选。然后,在团队中进行问卷调查,并不断讨论,确立了一系列数据集挑选准则,例如:

所选数据集应覆盖多个NLG代表性任务

所选数据集应覆盖多语种

multi-reference者优先

high-resource和low-resource的数据集应同时兼具

.....

最后,团队成员根据挑选准则为候选数据集打分。其中11个数据集脱颖而出,有幸得到了GEM_1.0官方盖章。

▲GEM的11个数据集

▲GEM的11个数据集

为了进一步提高所选数据集的质量,作者团队对其中多个数据集进行了清洗和加工,并为每一个数据集配上Data Card,说明它针对的任务、语言、数据格式和局限性等等。

GEM的评测指标

GEM的评测指标

由于workshop还在征稿,GEM的测试集细节和评测指标并没有完全披露。目前已公布的自动化评测指标如下图所示。

▲GEM已经公布的评测指标

▲GEM已经公布的评测指标

其中,在语义相似度方面,GEM推荐了两个较新的指标——BERTScore[2]和BLEURT[3],分别发表于ICLR'20和ACL'20,都是基于预训练模型构建的。作者认为,GEM的存在能够快速推广新的、更有效的评测指标,解决研究者们总是停滞于使用早期指标的问题。

除此之外,GEM workshop举办后,将公布一些系统在测试集上的输出和相应的人工评测结果。这些数据可以用于研究与人工评测结果一致性更高的新指标。

小结与感想

小结与感想

为解决NLG评测困境,55位大佬联合打造NLG评测基准GEM,收录了当今NLG领域最具代表性的11个数据集和多个评测指标。除了评测NLG系统,GEM亦可用于支持新的自动化评测指标研究。

能够看到来自全球的各路大佬,为一份有意义的工作集结在一起,感觉很酷乁( ˙ ω˙乁)!

刚刚本科毕业于北大计算机系的美少女学霸!目前在腾讯天衍实验室做NLP研究实习生。原计划是要赴美国就读CMU的王牌硕士项目MCDS,不过因为疫情正处于gap year,于是就来和小夕愉快地玩耍啦~文风温柔优雅,偶尔暴露呆萌属性,文如其人哦!知乎ID:小轶。

作品推荐:

1.有钱可以多任性?OpenAI提出人肉模型训练,文本摘要全面超越人类表现!

2.ACL20 Best Paper揭晓!NLP模型评价体系或将迎来重大转折

3.Attention模型:我的注意力跟你们人类不一样

4.谷歌重磅:可以优化自己的优化器!手动调参或将成为历史!?

5.EMNLP'20最佳论文揭晓!八块肌肉=能打电话?!

6.这篇顶会paper,讲述了疫情期间憋疯的你和我

加入卖萌屋NLP/IR/Rec与求职讨论群

后台回复关键词【顶会】

获取ACL、CIKM等各大顶会论文集!

[1] https://gem-benchmark.com/data_cards/MLSum

[2] https://arxiv.org/abs/1904.09675

[3] https://arxiv.org/pdf/2004.04696.pdf