姿态估计——HigherHRNet:Scale-Aware Representation Learning for Bottom-Up Human Pose Estimation

论文原文:https://arxiv.org/pdf/1908.10357.pdf

github:https://github.com/HRNet/HigherHRNet-Human-Pose-Estimation

Abstract

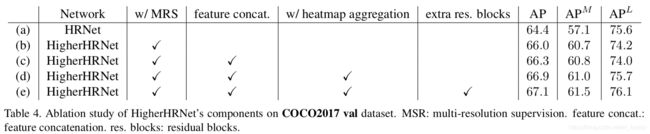

自底向上的人体姿态估计方法由于尺度变化的挑战,在预测小个体的正确姿态方面存在困难。在这篇论文中,我们提出了HigherHRNet。一个新的自下而上的方法,使用高分辨率的特征金字塔学习scale-aware表达。 多分辨率监督用于训练和多分辨率聚合用于推理, 该方法能够解决自下而上多人姿态估计中的尺度变化挑战,并更精确地定位关键点,尤其是small persons。 HigherHRNet中的特征金字塔由来自HRNet的特征图输出和通过转置卷积的上采样高分辨率输出组成。 HigherHRNet对于medium person 在COCO测试上的性能优于以前最好的自下而上方法, 表明了其处理规模变化的有效性。此外,在不使用改进或其他后处理技术的情况下,HigherHRNet在COCO的test-dev (70.5%AP)上获得了新的最先进的结果, 超越所有现有的自下而上的方法。 在CrowdPose test(67.6% AP)中 HigherHRNet甚至超过了所有自上而下的方法。 表明它在拥挤场景中的鲁棒性。代码:https://github.com/HRNet/ Higher-HRNet-Human-Pose-Estimation

1.Introduction

2D人体姿态估计旨在定位人体解剖关键点(例如肘部、手腕等。) 。 作为人类行为理解的基本技术,近年来受到越来越多的关注。目前的人体姿态估计方法可分为自顶向下和自下而上的方法。自顶向下的方法依赖人体检测和单人姿态估计。 由于自顶向下的方法可以通过裁剪和调整检测到的人员包围框的大小,将所有人员标准化到大致相同的规模, 它们通常对人的尺度差异不太敏感。 因此,在各种多人人体姿态估计基准上的最先进性能大多是通过自顶向下的方法来实现的。然而,由于这种方法依赖于一个单独的人检测器,需要单独估计每个人的姿态, 它们通常是计算密集型的,而不是真正的端到端系统。 相反,自下而上的方法首先通过预测不同解剖关键点的热图来定位输入图像中所有人的关键点,然后对关键点进行分组连接。 这种策略有效地使自下而上的方法更快,更能够实现实时姿态估计。 然而,由于自下而上的方法需要处理尺度变化, 自下而上和自上而下两种方法的性能之间仍然存在很大的差距,特别是对于small scale的人来说。

在预测small persons的关键点方面两个挑战:

- 一是处理尺度变化,即提高small person的表现,而不影响large persons的表现。

- 另一方面是生成高分辨率的高质量热图,用于精确定位small person的关键点。

以往的自下而上方法主要集中在对关键点进行分组,简单地使用一个分辨率的特征图,即输入图像分辨率的四分之一来预测热图关键点。 这些方法忽视了尺度变化的挑战,在推理过程中依赖于图像金字塔。如图1 ,a所示。

特征金字塔是处理尺度变化的基本组成部分, 然而,自顶向下特征金字塔中的较小分辨率特征图通常面临第二个挑战。PersonLab 通过增加输入分辨率生成高分辨率热图,如图1,b所示。虽然随着输入分辨率的增加,small person的表现一直在增加,但当输入分辨率太大时,large person的表现开始下降。 在不牺牲计算成本的情况下,以自然和简单的方式为自下而上的关键点预测生成空间上更精确和scale-aware的热图是至关重要的。

在这篇论文中,我们提出了Scale-Aware HighResolution NetWork(HigherHRNet)来解决这些挑战。HigherHRNet 通过一个新的高分辨率特征金字塔模块生成高分辨率热图。 传统的特征金字塔,它从1/32的分辨率开始, 采用横向连接的双线性上采样,逐渐将特征图分辨率提高到1/4。 而高分辨率特征金字塔直接从1/4分辨率开始,这是主干网中分辨率最高的特征,并生成更高分辨率的反卷积特征地图。如图1,c所示。 我们在HRNet的1/4分辨率路径上构建了高分辨率特征金字塔, 使它有效。 使HigherHRNet能够处理规模变化,我们进一步提出了一种多分辨率监督策略(Multi-Resolution Supervison strategy ),将不同分辨率的训练目标分配到相应的特征金字塔级别。 最后,我们在推理过程中引入了一种简单的多分辨率热图聚合策略,以生成具有尺度感知的高分辨率热图。

我们在COCO关键点检测数据集上验证了我们的方法,表现出了优越的关键点检测性能。 此外,我们还观察到,大部分增益来自medium person(关键点检测任务没有small person 标注)。 这一观察验证了HigherHRNet确实解决了尺度变化的挑战。在CrowedPose test 胜过了所有现存的方法。

总结我们的贡献:

- 我们试图解决尺度变化的挑战,这在以前自下而上的多人姿态估计中是很少研究的;

- 我们提出了一个HigherHRNet,它在训练阶段产生带有多分辨率监督的高分辨率特征金字塔,在推理阶段产生多分辨率热图聚合来预测scale-aware的高分辨率热图,这对small persons 非常有用。

- 我们在COCO数据集上展示了HigherHRNet的有效性。 我们的模型优于所有其他自下而上的方法。 我们特别注意到,medium person中效果很大。

- 在CrowdPose 数据集上,我们实现了最优结果, 表明了自下而上的方法比自上而下的方法更适合拥挤的场景。

2.Related works

Top-down methonds:

自顶向下的方法检测一个人包围框内的单个人的关键点。person bounding boxes 通常由目标检测Mask R-CNN直接生成, 在更快的R-CNN上添加一个关键点检测分支,并在ROIPooling之后重用特征。 进一步将自上而下的方法分为两个步骤,并使用单独的模型进行人的检测和姿态估计。

Bottom-up methods:

自下而上的方法检测图像中所有人的身体关节,然后将他们分组。 OpenPose使用两个分支,一个分支用于热图预测,一个分支用于分组。 OpenPose使用了一种名为part affinity field的分组方法,它学习连接两个关键点的二维向量场。Newell使用堆叠的沙漏结构(stacked hourglass network)用来热图预测和分组。 分组是通过名为associate embedding的方法来完成的,它为每个关键点分配一个“标记”(向量表示),并根据标记向量之间的L2距离对关键点进行分组。PersonLab使用扩张(dilated)的ResNet, 通过直接学习每对关键点的2D偏移字段来分组关键点。PifPaf使用Part Intensity Field(PIF)来定位body parts,使用Part Association Field(PAF)来关联body parts,形成完整的人体姿态。

Feature pyramid:

金字塔表示在最近的目标检测和分割框架中被广泛采用来处理尺度变化。SSD和MSCNN 在网络的多层中预测对象,而不合并特征。 特征金字塔网络用自顶向下的路径扩展骨干模型,逐渐将特征分辨率从1/32恢复到1/4, 使用双线性上采样和横向连接。共同的动机是让不同金字塔级别的特征来预测不同尺度的实例。然而, 这种金字塔表示在自下而上的多人姿态估计中很少被探索。 在本工作中,我们设计了一个高分辨率的特征金字塔,将金字塔扩展到不同的方向, 从1/4分辨率特征开始,生成具有更高分辨率的特征金字塔。

High resolution feature maps:

生成高分辨率特征图的方法主要有4种。

- 编码器-解码器,在编码器中获取上下文信息,并在解码器中恢复高分辨率特征。 解码器通常包含具有相同分辨率的编码器特征的跳过连接的双线性上采样操作序列。

- 空洞卷积,用于移除几个步长卷积/最大池化以保持特征图分辨率。 空洞卷积可以防止丢失空间信息,但引入了更多的计算成本。

- 转置卷积,反卷积, 在网络末端使用,以有效地提高特征图分辨率。 SimpleBaseLine证明了反卷积可以为热图预测生成高质量的特征图。

- 最近,提出了一个高分辨率网络(HRNet),在整个网络中保持高分辨率。 HRNet由多个不同分辨率的分支组成。 低分辨率分支捕获上下文信息,高分辨率分支保留空间信息。HRNet 分支之间的多尺度融合, 可以生成具有丰富语义的高分辨率特征图。

我们采用HRNet作为我们的基本网络来生成高质量的特征图。 我们增加了一个反卷积模块来生成更高分辨率的特征图来预测热图。 得到的模型被命名为Scale-Aware High-Resolution NetWork(HigherHRNet)。由于HRNet和反卷积是有效的, HigherHRNet是生成高分辨率特征图用于热图预测的有效模型。

3.Higher-Resolution Network

在这一部分中,我们介绍了我们提出的HigherHRNet。 图2说明了我们方法的总体架构。 我们将首先简要概述所提出的HigherHRNet,然后详细描述其组件。

3.1HigherHRNet

HRNet:

HR Net[38,40]最初是为自顶向下的姿态估计而设计的。 在本工作中,我们采用HRNet自下而上的方法,通过添加1×1卷积来预测类似于的热图和标签图, 我们只使用最高分辨率(输入图像的1/4)特征图进行预测。

HigherHRNet:

热图的分辨率对于预测small persons的关键点至关重要。大多数现有的人体姿态估计方法都是通过准备ground-truth来预测高斯平滑的热图,并将一个未归一化的高斯核应用于每个关键点位置。 添加这个高斯核有助于训练网络,因为CNNs倾向于输出空间平滑的响应作为卷积操作的一种性质。 然而,应用高斯核也会给关键点的精确定位带来混乱,尤其是对于small person的关键点。减少这种混乱的一个繁琐方法就是减少高斯核的标准差。 然而,我们经验性地发现,它使优化变得更加困难,并导致更糟糕的结果。

我们通过在不同分辨率下预测标准差不变的高分辨率热图来解决这个问题。 自下而上的方法通常预测输入图像分辨率1/4的热图。 然而,我们发现这个分辨率还不足以预测精确的热图。由于反卷可以有效地生成高质量、高分辨率的特征图,我们在HRNet中的最高分辨率特征图之上构建了HigherHRNet,如图2所示,方法是添加反卷积模块,如3.3节所讨论的。

反卷积模块将HRNet的特征和预测热图作为输入,并生成分辨率比输入特征图大2倍的新特征图。 因此,反卷积模块与HRNet的特征图一起生成具有两个分辨率的特征金字塔。 反卷积模块还通过增加额外的1×1卷积来预测热图。 我们按照3.4节训练不同分辨率的热图预测器,并使用(3.5节)中描述的热图聚合策略进行推理。

如果需要更大的分辨率,可以添加更多的反卷积模块。 我们发现反卷积模块的数量取决于数据集中人的规模分布。 一般来说, 包含small persons的数据集需要更大的分辨率特征图来进行预测,反之亦然。 在实验中,我们发现添加一个反卷积模块在COCO数据集上达到了最佳的性能。

3.2 Grouping

最近的工作表明,采用关联嵌入(associate embedding)的简单方法可以很好地解决分组问题。我们使用associate embedding 进行关键点分组。 分组过程通过对标签具有小l2距离的关键点进行分组,将无标识关键点聚类成个体。

3.3. Deconvolution Module

我们提出了一个简单的反卷积模块,用于生成分辨率比输入特征图高两倍的高质量特征图。我们使用4×4卷积(a.k.a。 转置卷积),然后是BatchNorm和ReLU,来学习对输入特征图进行上采样。 或者,我们可以在反卷积后进一步添加几个Basic Residual Blocks,来调整上采用的特征图。我们在HigherHRNet中增加了4个残差块。

我们反卷积模块的输入是特征图和来自HRNet或之前反卷积模块的预测热图的连接。每个反卷积模块的输出也用来以多尺度方式预测热图。

3.4Multi-Resolution Supervision

与其他自下而上的方法不同,他们只对最大分辨率的热图应用监督, 我们在训练过程中引入了一种多分辨率监督来处理尺度变化。 我们将ground-truth关键点位置转换为所有分辨率热图上的位置,以产生不同分辨率的ground-truth热图。 然后,我们将具有相同标准差的高斯核(默认情况下使用标准差=2)应用于所有这些ground-truth热图。 我们发现重要的是不要缩放高斯核的标准差。 这是因为特征金字塔的不同分辨率适合于预测不同尺度的关键点。 在高分辨率特征图上, 为了更精确地定位small person的关键点,需要一个相对较小的标准差(与特征图的分辨率相比)。

在HigherHRNet中的每个预测尺度上, 我们计算了该尺度的预测热图与其相关的ground-truth热图之间的均方误差。 热图的最终损失是所有分辨率的均方误差之和。 值得强调的是,由于以下原因,我们没有将不同规模的人分配到特征金字塔的不同层次:

- 用于分配训练目标的启发式依赖于数据集和网络体系结构

- 其次,应用了高斯核,ground-truth关键点目标相互作用。 因此,通过简单地设置忽略区域来解耦关键点是非常困难的

我们认为模型有能力在特征金字塔的不同层次自动聚焦于特定的尺度。

Tagmaps与热图在HigherHRNet中的训练不同,我们只以最低分辨率预测标记图,而不是使用所有分辨率。 这是因为学习tagmap需要全局推理,更适合以较低的分辨率预测tagmap。 我们也发现更高的分辨率并不能很好地预tagmap,甚至不能收敛。因此, 我们以输入图像的1/4分辨率训练特征图上的tagmap。

3.5. Heatmap Aggregation for Inference

我们提出了一种推理过程中的热图聚合策略。 我们使用双线性插值对所有具有不同分辨率的预测热图进行上采样。 这种策略与以前的方法有很大的不同,它只使用来自单个尺度或单个阶段的热图进行预测。 我们使用热图聚合的原因是启用Scale-aware的姿态估计。例如,COCO 关键点数据集 包含从32^2像素到128^2像素以上的大规模方差的人。 自顶向下的方法通过将人区域近似归一化为一个尺度来解决这个问题。 然而,自下而上的方法需要意识到尺度,才能从所有尺度检测关键点。我们发现不同尺度的热图在HigherHRNet中更好地捕捉不同尺度的关键点。 例如,低分辨率热图中漏掉的small persons的关键点可以在高分辨率热图中恢复。 因此,对不同分辨率的预测热图进行平均,使HigherHRNet成为一种scal-aware的姿态估计器。

4.Experiments

5.Conclusion

我们提出了Scale-Aware High-Resolution Network(HigherHRNet)来解决自下而上的多人姿态估计问题中的尺度变化问题, 特别是对于精确定位small persons的关键点。 我们发现多尺度图像金字塔和较大的输入大小部分解决了这个问题, 但是这些方法的计算成本很高。为了解决这个问题, 我们提出了一种基于HRNet的高效高分辨率特征金字塔, 并对其进行多分辨率监督训练。 在推理过程中,具有多分辨率热图聚集的HigherHRNet能够有效地生成多分辨率和高分辨率的热图,以获得更精确的人体姿态估计。 在COCO数据集上,HigherHRNet在很大程度上优于所有现有的自下而上方法,特别是对于small persons。