ResNet or DenseNet? Introducing Dense Shortcuts to ResNet ResNet还是DenseNet?即插即用的DS涨点神器来了!

DSNet比ResNet取得了更好的结果,并且具有与DenseNet相当的性能,但需要的计算资源更少。其中改进的DS2Res2Net性能非常强大。

作者:ChaucerG

来源:AI人工智能初学者微信公众号

作者单位:韩国科学技术院(KAIST)

论文:https://arxiv.org/abs/2010.12496

1、简介

大多数基于深度学习的方法都是通过backbone网络实现的,其中两个最有名的方法就是ResNet和DenseNet。尽管它们具有差不多的性能和受欢迎程度,但它们两个都存在固有的缺点。对于ResNet,稳定训练的identity shortcut方式也限制了其表示能力,而DenseNet具有更高的特征,可以进行多层特征串联。但是,密集级联会引起新的问题,即需要较高的GPU内存和更多的训练时间。部分由于这个原因,在ResNet和DenseNet之间不是一个简单的选择。

本文提供了dense summation的统一视角来分析它们,从而有助于更好地了解它们的核心差异。同时进一步提出了dense weighted normalized shortcuts,以解决它们之间的难题。所提出的密集快捷方式继承了ResNet和DenseNet中简单设计的设计理念。

2、相关方法

2.1、Micro-module design

都是耳熟能详的操作,大家可以自行进行调研和研读:

- normalization modules

- attention modules

- group convolutions

- bottleneck design

- weight normalization

- instance normalization

- group normalization

2.2、Macro-architecture design

都是耳熟能详的模型,大家可以自行进行调研和研读:

- AlexNet

- VGGNet

- GoogleNet

- ResNet

- DenseNet

- WideResnet

- ResNext

- Preactivation-ResNet

- CondenseNet

- Dual path network

- mixed link network

- FractalNet

3、本文方法

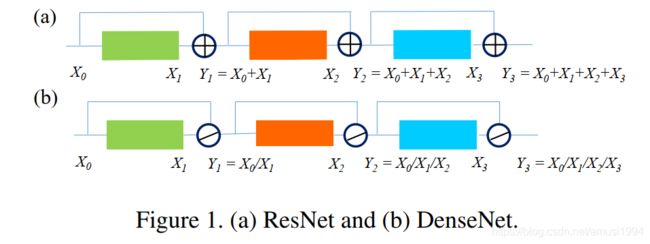

3.1、ResNet和DenseNet中的Dense Connection

ResNet和DenseNet的区别是什么?顾名思义,区别似乎在于ResNet只使用前面的一个特征图,而DenseNet使用了前面所有卷积块的特性。

似乎结果像前面说的那样,而实际上通过上图可以看出ResNet与DenseNet的不同之处在于,ResNet采用求和的方法将之前所有的feature map连接起来,而DenseNet将所有feature map使用cat的方法连接起来。

3.2、Unified perspective with dense summation

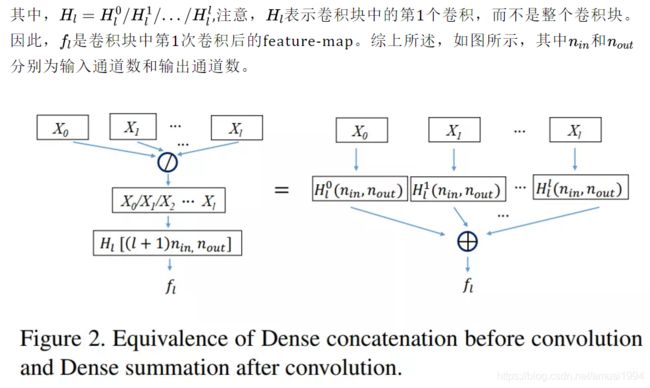

在这里,作者证明了卷积运算前的dense concatenation可以等价于卷积后的dense summation:

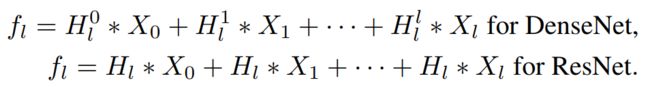

最终可以得到关于ResNet和DenseNet的如下表达式:

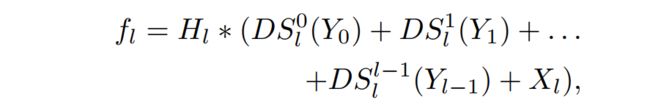

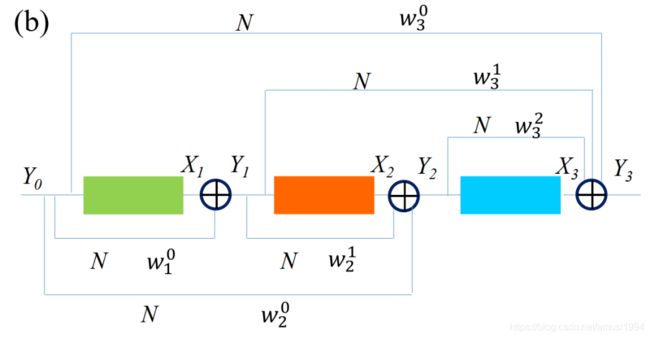

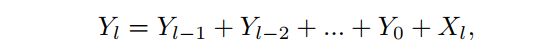

3.3、Dense shortcut and DSNet

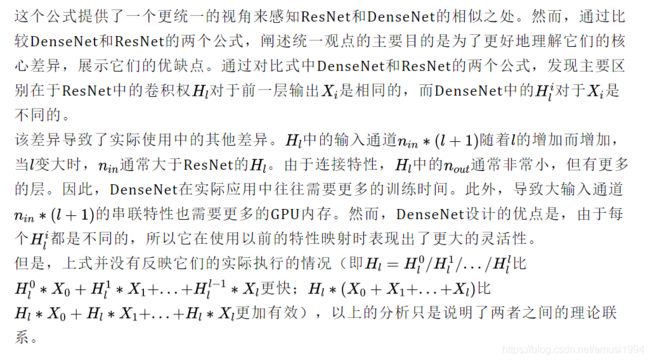

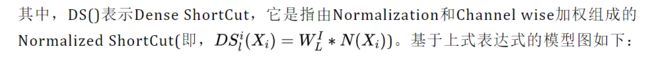

通过以上统一可以看出ResNet和DenseNet的核心区别在于,对于前面的每个输出,卷积参数Hl是否共享。这使得DenseNet在需要更多GPU资源的情况下获得了更好的性能。这种差异的根源在于采用了不同的Dense Connection、identity shortcut和Dense Concatenation。基于上述的问题提出了一种可选择的Dense Connection来缓解该缺点。它引入了使用前面的feature-maps的灵活性,同时对前面的每个feature-map仍然使用相同的Hl。基于ResNet的Benchmask,文中提出的方法可以表达为:

但是feature-map在aggregation输出Yl中包含的有用的特征比对应的单卷积块输出Xl更多,因此提出了另一种变体,将Xl替换为Yl:

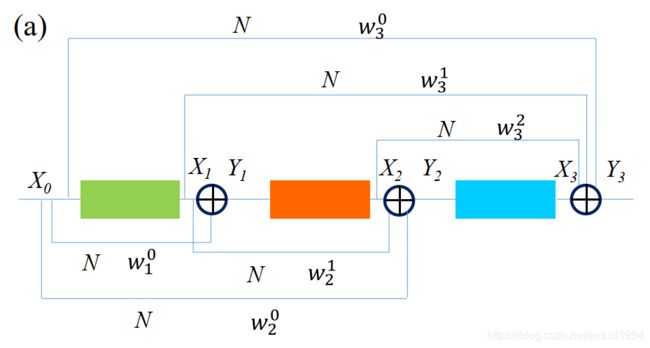

实验结果也证明了该结论的成立:

作者将所提出的网络命名为采用Adopting DS ShortCut的DSNet。DSNet采用与ResNet相同的网络Backbone(卷积块本身和块设计)。ResNet主干是为identity shortcut定制的,而不是为提出的DS ShortCut定制的。如果重新设计主干结构可能会进一步提高DSNet的性能。

注:DSNet和ResNet唯一区别是用提出的dense shortcut代替了identity shortcut.

3.4、实现插入方式

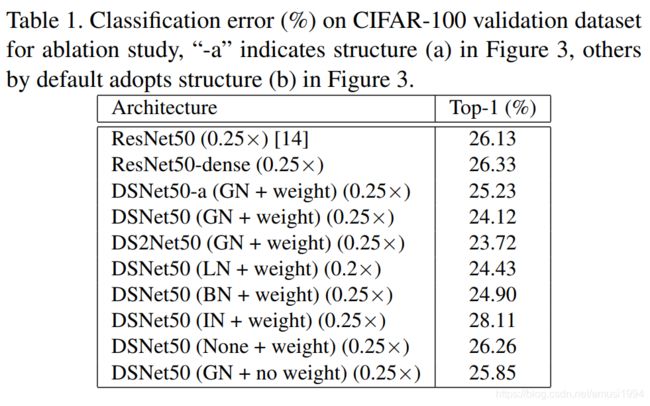

为了在ResNet中引入dense shortcut,一种简单的方法是将Yl=Yl-1+Xl中的单个identity shortcut替换为dense shortcut,从而连接所有前面的特征映射,得到:

可以递归地扩展为:

![]()

比较dense shortcut等价于在每个卷积块的末端增加额外的常数。表1中所示的ResNet50-Dense的这种设计并没有取得比原来的ResNet50更好的性能。于是便设计了DS ShortCut,而这里使用归一化的动机是为了将前面的所有特征归一化到一个相似的尺度,方便训练。加权求和是为了让网络根据特征图的显著性给每个归一化特征图分配适当的权值。

此外,在实验中发现,在3*3卷积的卷积块内插入weighted normalized shortcut也有助于性能的提高,由于增加的计算负担几乎很少,值得考虑。这里称之为DS2Net。

4、实验结果

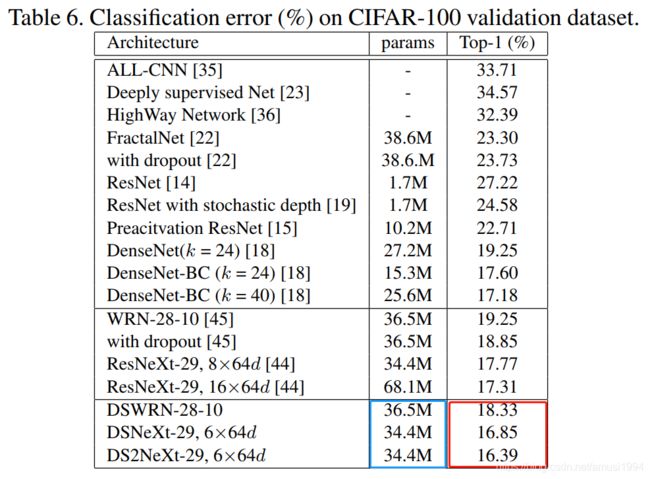

4.1、基于CIFAR-100实验

可以看出在CIFAR-100数据集上基于DS的设计,参数更少,精度更高;

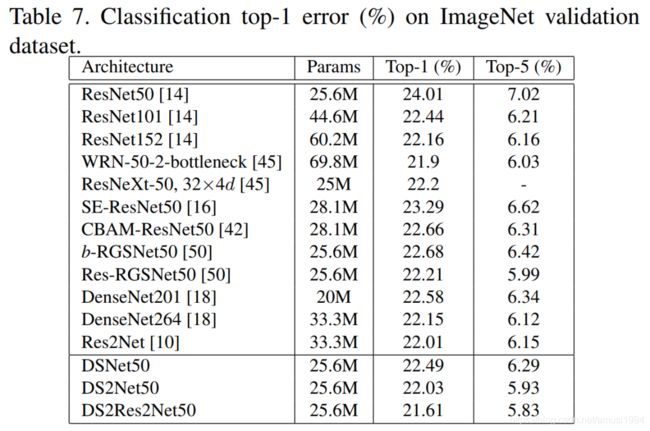

4.2、基于ImageNet实验

可以看出在ImageNet数据集上基于DS的设计,参数更少,精度更高;

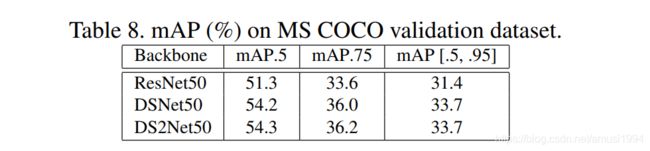

4.3、基于MS COCO 2014检测实验

可以看出在ResNet中使用DSNet提升mAP将近3个百分点;

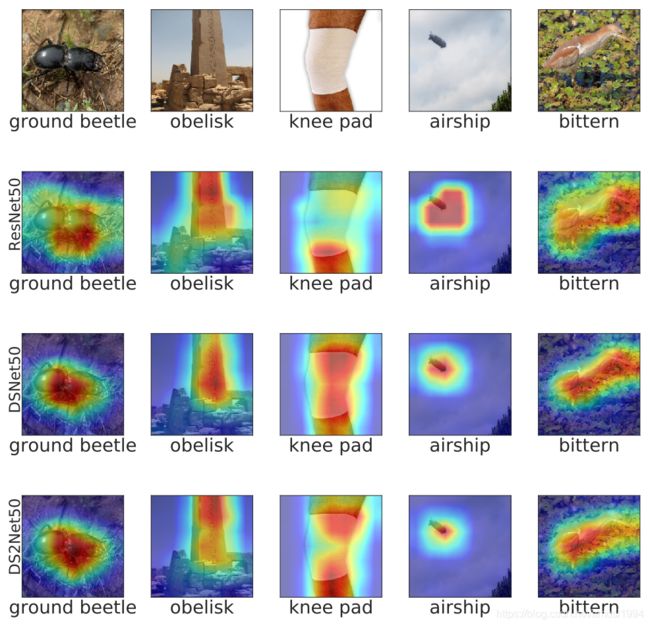

4.4、Grad-CAM可视化实验

可以看出对于DSNet,其对于目标的识别区域更加的准确和集中,也因此会带来更好的效果。

更为详细内容可以参见论文中的描述。

References

[1] ResNet or DenseNet? Introducing Dense Shortcuts to ResNet

论文下载

在CVer公众号后台回复:DSNet,即可下载本论文