【多聚焦图像:GAN:无监督】

MFF-GAN: An unsupervised generative adversarial network with adaptive and gradient joint constraints for multi-focus image fusion

(MFF-GAN: 具有自适应和梯度联合约束的无监督生成对抗网络,用于多焦点图像融合)

从梯度的角度来进行判别

现有的大多数方法都会生成决策图以实现多焦点图像融合,这通常会由于分类错误而导致细节丢失,尤其是在聚焦和散焦区域的边界线附近 ,为了克服这一挑战,本文提出了一种具有自适应和梯度联合约束的新型生成对抗网络,以融合多焦点图像。引入了自适应决策块,以基于重复模糊的差异来确定源像素是否被聚焦。在它的指导下,一个专门设计的内容损失可以动态地指导优化趋势,即迫使生成器产生与聚焦源图像具有相同分布的融合结果。为了进一步增强纹理细节,我们建立了对抗博弈,以迫使融合结果的梯度图近似于基于源图像构建的联合梯度图。我们的模型是无监督的,不需要ground-truth。

介绍

多聚焦融合的方法可以分为两类: 空间域方法和转换域方法。在空间域融合方法中,融合通常基于像素,块或区域。同的是,变换域方法的思想是将图像变换到其他域,并利用域的特性来更有效地实现目标,包括多尺度变换,稀疏表示,混合,子空间等方法。

目前的方法人有许多限制:

首先,现有方法通常需要手动设计活动水平测量和融合规则,这限制了融合结果,因为不可能以一种手动设计的方式考虑所有因素。

其次,现有的许多方法通过生成决策图来执行多焦点图像融合,本质上更像是基于清晰度检测的分类问题。这些方法通常无法对边界线附近的聚焦和散焦区域进行分类。

再次,几乎所有基于深度学习的方法在生成决策图时都需要进行后处理,例如一致性检查,这大大增加了方法的复杂性。

最后,这些方法通常需要手动构建决策图作为地面真相来训练网络,这进一步限制了此类方法的应用范围。

为了解决上述挑战,我们设计了具有自适应和梯度联合约束的无监督生成对抗网络,称为MFF-GAN。

总体流程叙述:

我们提出了一种自适应决策块,它使用重复模糊原理来确定相应像素是否被聚焦。具体地,当清晰图像模糊时,前后像素值的变化大于原来就是模糊图像再次模糊的变化(即利用该原理可以判别出,这一片区域原先是清楚地还是本身就是模糊的)。决策块为每个源图像生成得分图,该得分图具有与源图像相同的大小。换句话说,决策块为每个像素做出明确的分数。根据最大选择原则,可以从得分图中获得用于指导优化的筛选图(screening map)。筛选图作用于专门设计的损失函数,该损失函数迫使生成器生成与清晰源图像一致的融合图像。为了进一步增强融合图像的纹理细节,我们在生成器和鉴别器之间建立了对抗性游戏。经过连续的对抗性学习,融合图像的梯度图将近似于我们构建的联合梯度图(成功骗过判别器),从而包含更丰富的纹理细节。

优势

首先,我们的方法不需要设计活动级别测量和融合规则,也不需要任何后处理,可以实现多焦点图像的简单快速融合。

其次,我们的网络不需要有监督学习的ground truth(几乎所有流行的方法都不需要),而是具有弱约束的无监督学习。结果,我们可以在任何一对多焦点图像上轻松训练网络。

最后,我们的方法不是基于决策图,而是通过提取和重建信息来实现多焦点图像融合,因此在边界线附近几乎没有模糊和细节损失。

( 值得注意的是,由于使用了1 × 1卷积内核以及对特征通道数量的控制,我们网络中的参数数量被限制在一定范围内)

贡献

首先,我们提出了一种新的具有自适应和梯度联合约束的无监督GAN模型,用于多焦点图像融合,该模型通过提取和重构信息来实现融合。结果,在聚焦区域和散焦区域的边界线附近几乎没有模糊和细节损失。

其次,我们设计了一种基于重复模糊原理的自适应决策块,该块可以有效地以像素为单位进行焦点检测,从而指导生成器自适应地学习清晰源图像的分布,避免生成清晰度和模糊之间的融合结果。

再次,我们提出了基于联合梯度约束的特定对抗损失函数,该函数可以进一步增强融合结果的纹理细节。

最后,我们基于公开数据集创建了一个新的多焦点图像融合数据集MFI-WHU,其中包含120个高质量的图像对

是生成器, 表示判别器, 表示决策块生成的筛选图。Gradjoint是关节梯度图,Gradfused是指融合图像的梯度图。此外,L表示损失函数。

relate works

(对于基于深度学习的多聚焦融合和以及GAN及其变体,不再赘述)

基于深度学习的多聚焦融合:

这些方法的发展是从监督到无监督的过渡,但其中大多数仍然专注于准确决策图的生成。

Liu等人利用卷积神经网络 (CNN) 对聚焦区域和散焦区域进行分类,从而生成了用于融合的决策图。值得注意的是,他们使用手动构建的决策图作为监督训练的地面真实,以提高分类的准确性。

此外,Du等人 提出了一种新颖的基于图像分割的多焦点图像融合算法,其中,检测决策图的任务被视为源图像中聚焦区域和散焦区域之间的图像分割。尽管这种基于分割的方法在一定程度上提高了决策图中边界线的准确性,但仍会导致细节的丢失。

Guo等人提出使用条件GAN进行多焦点图像融合。但是,在这种方法中仍然需要标记的图像来进行有监督的网络训练。为了解决这个问题,Ma等人提出了一种无监督网络来生成用于融合的决策图。

仅依靠神经网络的学习能力,即使有地面真理可供参考,这些方法也无法生成理想的决策图。因此,它们需要后处理来进一步优化决策图,例如一致性验证或引导过滤,这似乎没有充分利用神经网络的性能。相比之下,我们提出的MFF-GAN不仅是无监督的,而且不需要任何后处理。

我们的方法是基于GAN。在这里,我们介绍了GAN及其变体的一些基本概念,

GAN:

从框架结构来看,GAN主要由两个部件组成: 生成器 和鉴别器 。生成器和鉴别器之间的min- max博弈可以逐渐提高他们的能力,最终得到可以估计目标分布的期望生成器。在这里,我们对此过程给出了更正式的描述。假设训练数据为 = { 1, 2,…,},则生成器可以从这些数据中估计分布特征,然后尝试生成与该分布相匹配的数据 ()。对于鉴别器,任务是尽可能地识别出哪些是真实的训练数据 ,哪些是生成器生成的假数据 ()。换句话说,整个GAN的目的是使估计的数据分布 和真实数据分布 数据之间的发散尽可能小。因此,GAN的目标函数定义如下:

随着生成器和鉴别器的持续对抗性学习,生成器生成的数据分布越来越接近真实数据分布,直到鉴别器无法区分它们是真实数据还是假数据。此时,经过训练的生成器是可以生成类真实数据的预期生成器。

LSGAN:

最小二乘GAN (the least squaresGAN (LSGAN))。LSGAN是GAN的改进,由Mao等人2017年提出。传统的GAN采用交叉熵损失函数,训练时容易出现梯度消失。LSGAN可以更好地解决这个问题。相反,它使用最小二乘损失作为损失函数,并引入标签作为网络优化的目标:

其中 (⋅) 是鉴别器函数,(⋅) 是生成器函数。另外, 是(鉴别器认为由生成器生成的假数据)假标签, 是(鉴别器认为是真数据)真标签, 是生成器期望鉴别器确定假数据的标签。显然, 尽可能接近0(因为生成器希望可以骗过判别器)。相反, 和 尽可能接近1。也就是说,鉴别器希望能够准确地区分真实数据和虚假数据,而生成器被训练以生成可以被鉴别器区分为真实数据的数据。

DCGANs:

受DCGANs的启发,我们的方法结合了CNN和GAN,以更好地实现多焦点图像融合任务。Radrord等人首先提出了DCGANs,他们讨论了CNN和GAN的结合,并给出了一系列建议。具体来说,DCGANs提供了五种改进,以实现CNN和GAN的更好结合,从而尽可能减少训练过程中的不稳定性。

First,在生成器和鉴别器中删除池化层。相反,在鉴别器中使用步幅卷积(stride convolution) 来实现下采样,而在生成器中应用转置卷积来实现上采样。

Second,将批归一化层(防止梯度爆炸or消失)应用于生成器和鉴别器。

Third,整流线性单元 (ReLU) 激活函数用于发生器的除输出层以外的所有层,而输出层则使用tanh作为激活函数。

Finally,leaky ReLU用作鉴别器所有层上的激活函数。最后,在更深的模型中删除了完全连接的层。

总体而言,DCGANs将CNN强大的特征提取能力引入GAN。一方面,可以提高鉴别器的判断精度。另一方面,可以促进生成器的特征提取和重建性能。

方法

Overview of the proposed method

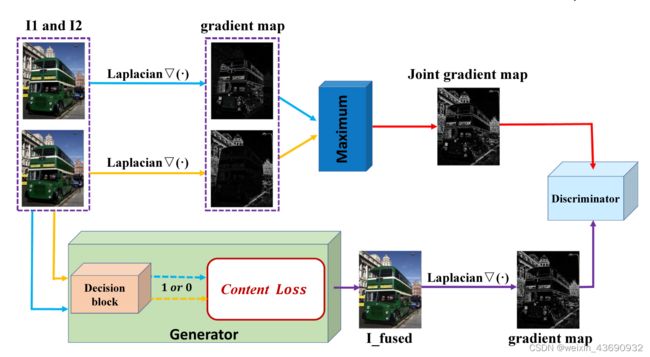

对于多焦点图像融合,最有意义的信息是源图像中的尖锐区域,这些区域反映在强度分布和纹理细节上。自然,在信息提取过程中,应该保留尖锐区域中的这些信息,并丢弃模糊区域中的这些信息。因此,有必要引入一种机制来调整优化过程中的损失函数,从而约束网络选择性地提取和重构信息。此外,应加强结果的细节,以减少神经网络在图像生成任务中常见的平滑效果。基于这些考虑,我们设计了具有自适应和梯度联合约束的生成对抗网络,总体融合框架如图下图所示

首先,我们设计一个自适应决策块,它可以基于重复模糊原理来评估每个像素的锐度,如下图所示。即清晰度较高的图像,在模糊后,像素值变化较大。基于此观察结果,生成筛选图以表征有效信息的位置。筛选地图作用于我们构建的特定内容损失函数,从而在像素尺度上调整优化目标。总之,决策块可以自适应地引导融合结果在像素尺度上近似清晰源图像的强度分布和梯度分布。我们的具体方法是在两个源图像的相应像素位置选择得分较大 (放弃较小的) 的像素作为优化目标。在决策块和内容损失的共同作用下,生成器可以获得相对清晰和自然的结果。与传统神经网络的固定损失函数不同,我们模型中的损失函数是动态构造的**。具体地,只有那些被决策块判断为尖锐的像素才能参与优化过程中的损失函数计算**。

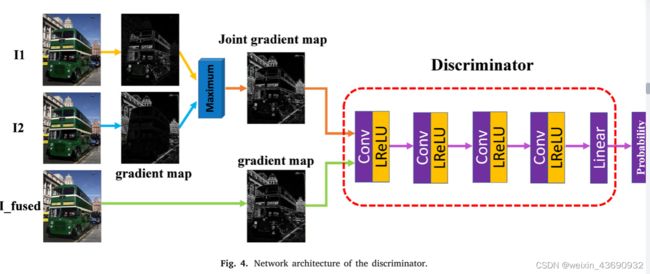

为了进一步增强纹理细节并提高融合图像的质量,我们在生成器和鉴别器之间建立了对抗性游戏。具体来说,我们使用Laplacian operator ∇(⋅) 来找到两个源图像的梯度图,然后根据最大选择原理构造更强的联合梯度图。我们将联合梯度图定义为真实数据,将融合图像的梯度图定义为假数据。持续的对抗性学习可以引导生成器更加专注于纹理的保存。结果,我们可以获得质量更高的融合结果,其中包含更丰富的纹理细节。

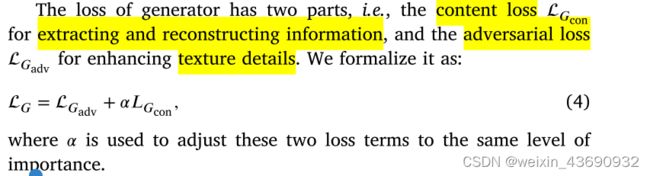

Loss Function

有两部分组成:内容损失和对抗损失

Loss function of generator

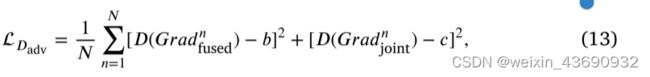

生成器的对抗性损失是为了进一步增强融合图像的纹理细节,其定义为:

其中, 是训练过程中一批融合图像的数量, 是生成器期望鉴别器确定融合图像的概率标签,而 ∇(⋅) 表示使用Laplacian算子查找梯度图的操作。

这种对抗性损失可以迫使生成器更加注意纹理细节的保存。换句话说,对抗性游戏在满足生成器融合规则的前提下,使融合图像倾向于具有更强的纹理。这里 应该设置为1。

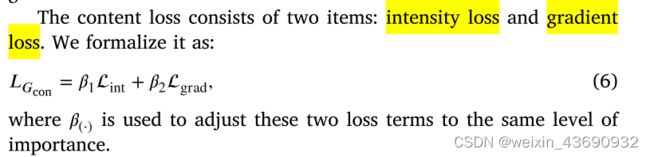

内容损失包含强度损失和梯度损失

(因为两张筛选图是互补的,两张图的强度和梯度相加)

强度损失 Lint可以约束融合图像与源图像的清晰区域具有相同的强度分布,定义为:

其中, 和 表示筛选图或源图像中第 行第 列的像素, 和 表示图像的高度和宽度, 1和 2为源图像, fused为生成器生成的融合图像,由 ( 1, 2) 定义。此外,(⋅) 是决策块根据源图像的清晰度生成的筛选图。具体地,筛选图的生成过程可以形式化:

其中min(⋅) 表示最小函数,sign (⋅) 是符号函数。重复模糊函数 (⋅) = (, − (, )),(⋅) 表示低通滤波函数。值得注意的是,(⋅) 的大小也是 × 。

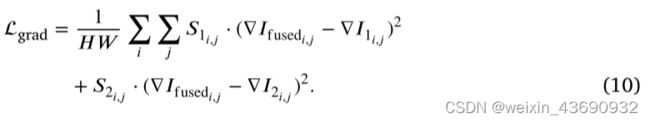

梯度损失项可以约束生成器,以使融合图像具有与清晰的源图像相同的纹理细节,这对于提高被融合图像的清晰度至关重要。梯度损失仍然与决策块生成的筛选图相关,并形式化为:

Loss function of discriminator

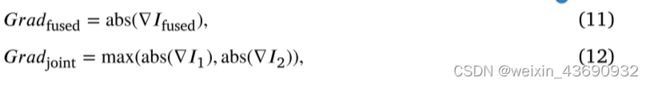

鉴别器的损失函数使鉴别器能够准确识别真实数据和虚假数据。在我们的方法中,假数据是融合图像的梯度图。真实数据是我们构建的联合梯度图。它是根据最大选择原理获得的,具有更强的梯度分布。融合图像和联合梯度图的梯度图可以形式化为:

其中abs(⋅) 是绝对值函数,max(⋅) 是最大值函数。然后,判别器的损失函数定义为:

其中 是融合图像的梯度图的标签,应该设置为0。 是联合梯度的标签,应该设为1。也就是说,鉴别器期望准确地将联合梯度图识别为真实数据,并将融合图像的梯度图识别为假数据。在这种约束下,鉴别器可以指导生成器在信息维护方面的趋势,即支持强烈纹理的保存。

网络架构

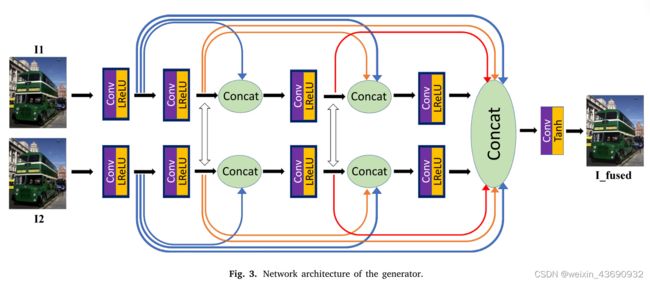

Generator architecture

生成器的网络结构如下图所示,我们将生成器分成两条路径提取信息,对应两个源图像。发电机网络的设计灵感来自伪暹罗网络(pseudo-Siamesenetwork),它熟练地处理两个相对不同的输入。由于多焦点图像对在相应的像素位置处是尖锐的或模糊的,因此pseudo-Siamese network适用于此类图像。

在两种路径中,都有四个卷积层来提取特征。第一个卷积层使用5 × 5卷积内核,其余三个使用3 × 3卷积内核。它们都使用Leaky ReLU作为激活函数。为了防止卷积过程中信息的丢失,我们根据DenseNet的思想重用了特征。也就是说,每个卷积层的输入由所有先前的卷积层的输出连接。同时,为了提取更充分的信息,我们在两条路径之间交换信息。具体地说,交换的信息是通过连接和卷积的方法生成的。然后,将交换的信息与所有先前卷积层的输出连接在一起,作为下一个卷积层的输入。

最后,我们将两条路径中所有卷积层的输出连接起来,然后通过一个卷积层生成融合图像。卷积层的核尺寸为1 × 1,激活函数为tanh。值得注意的是,在所有卷积层中,填充模式都设置为「相同」,即特征图的大小在整个卷积过程中不会发生变化,与源图像的大小相同。

Discriminator architecture

鉴别器的结构如上图所示,鉴别器中的输入有两种类型,即基于源图像的联合梯度图和融合图像的梯度图。鉴别器由四个卷积层和一个线性层组成。四个卷积层的卷积核尺寸为3 × 3,它们都使用Leaky ReLU激活函数。这些卷积层的步幅设置为2。最后一层是用来求分类概率的线性层。