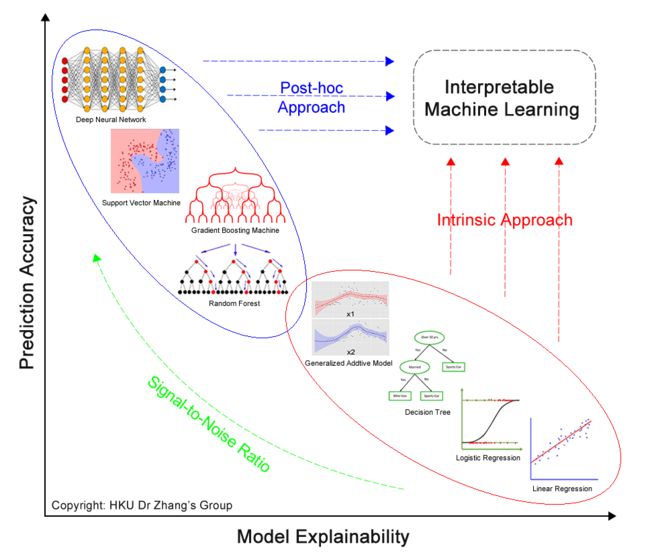

可解释机器学习研究

1.一些方法综述

[机器学习]关于可解释性(interpretability)这个领域,看这里~ - 知乎(现在是2021年)本文介绍一下ML子领域interpretability,并整理目前以及未来一些主要的研究方向,比较受关注的(近年来文献中提到的)主要方向有 一直以来的大方向:定义和方法。定义可解释的角度,以及各个角度…![]() https://zhuanlan.zhihu.com/p/397234336

https://zhuanlan.zhihu.com/p/397234336

告别 AI 模型黑盒:可解释机器学习研究报告

https://www.baidu.com/link?url=lzI-UzQ0rhxZMA3vMDa2tmdvONnUjUwDYnZh8Znr8MA4YO1PBcHdtU21zneLbwui_YGNONDxXbblhpJgy7TttK&wd=&eqid=c65da3560005584e00000004628cf1e8![]() https://www.baidu.com/link?url=lzI-UzQ0rhxZMA3vMDa2tmdvONnUjUwDYnZh8Znr8MA4YO1PBcHdtU21zneLbwui_YGNONDxXbblhpJgy7TttK&wd=&eqid=c65da3560005584e00000004628cf1e8一文读懂模型的可解释性

https://www.baidu.com/link?url=lzI-UzQ0rhxZMA3vMDa2tmdvONnUjUwDYnZh8Znr8MA4YO1PBcHdtU21zneLbwui_YGNONDxXbblhpJgy7TttK&wd=&eqid=c65da3560005584e00000004628cf1e8一文读懂模型的可解释性

原创 | 一文读懂模型的可解释性(附代码&链接) - 云+社区 - 腾讯云目前人工智能应用已经渗透到我们生活的方方面面,成为我们生活中重要的一部分。我们相信,随着机器学习技术的不断进步,未来有望产生一个能够感知、学习、做出决策和采取独...![]() https://cloud.tencent.com/developer/article/1629351关于机器学习模型可解释性一系列:

https://cloud.tencent.com/developer/article/1629351关于机器学习模型可解释性一系列:

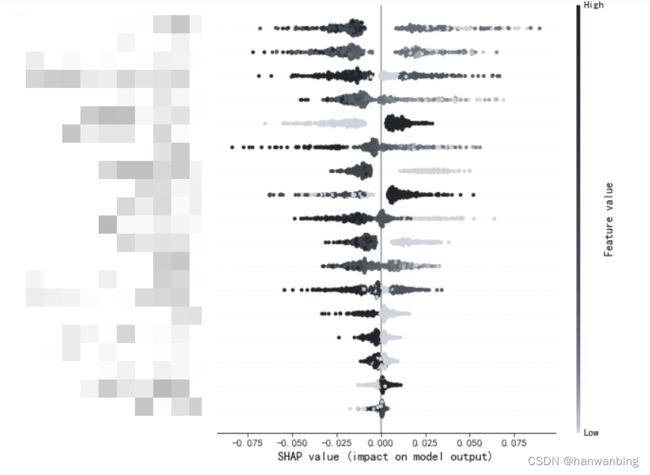

机器学习模型可解释性进行到底 —— SHAP值理论(一)_悟乙己的博客-CSDN博客_shap值最近在系统性的学习AUTOML一些细节,本篇单纯从实现与解读的角度入手,因为最近SHAP版本与之前的调用方式有蛮多差异,就从新版本出发,进行解读。不会过多解读SHAP值理论部分,相关理论可参考:关于SHAP值加速可参考以下几位大佬的文章:文章目录1 介绍2 可解释图2.1 单样本特征影响图1 介绍文章可解释性机器学习_Feature Importance、Permutation Importance、SHAP来看一下SHAP模型,是比较全能的模型可解释性的方法,既可作用于之前的全局解释,.https://mattzheng.blog.csdn.net/article/details/115400327?spm=1001.2014.3001.5506机器学习模型可解释性进行到底 —— 从SHAP值到预测概率(二)_悟乙己的博客-CSDN博客_shap值 可解释性原理第一篇主要把SHAP值的各类图表操作方式进行展示:机器学习模型可解释性进行到底 —— SHAP值理论(一)接下来主要围绕一篇文章的内容展开【黑盒模型实际上比逻辑回归更具可解释性】源代码部分:smazzanti/tds_black_box_models_more_explainable自己的测试代码:mattzheng/ml_interpretability非常有意思的一个案例,里面把SHAP值的解释性又增强了一步。SHAP值对于人类来说是不可理解的(即使对于数据科学家来说也是如此),概率的概念要https://mattzheng.blog.csdn.net/article/details/115556182?spm=1001.2101.3001.6650.2&utm_medium=distribute.pc_relevant.none-task-blog-2~default~CTRLIST~default-2-115556182-blog-115400327.nonecase&depth_1-utm_source=distribute.pc_relevant.none-task-blog-2~default~CTRLIST~default-2-115556182-blog-115400327.nonecase&utm_relevant_index=3机器学习模型可解释性进行到底 ——PDP&ICE图(三)_悟乙己的博客-CSDN博客_pdp图之前两篇有专门介绍shap值,可以说非常好用,机器学习模型可解释性进行到底 —— 从SHAP值到预测概率(二)机器学习模型可解释性进行到底 —— SHAP值理论(一)文章目录1 部分依赖图(Partial Dependence Plot)1.1 理论解读1.2 如何根据PDP 进行特征筛选2 个体条件期望图(Individual Conditional Expectation Plot)3 sklearn 0.24+实现:PDP&ICE图3.1 部分依赖图(Partial Dependenhttps://blog.csdn.net/sinat_26917383/article/details/115669705机器学习模型可解释性进行到底——特征重要性(四)_悟乙己的博客-CSDN博客文章目录1 四种全局可解释的方法论1.1 过滤法1.1.1 方差过滤方差过滤1.1.2 相关性过滤1.2 嵌入法1.2.1 SelectFromModel - 筛选特征1.2.2 PermutationImportance - 排列重要性1.3 包装法1.4 几种方法对比1.5 额外的交叉特征筛选模型:AutoFIS2 SHAP(SHapley Additive exPlanation)2.1 SHAP 与 Permutation importance 的差异2.2 特征归因的一致性2.2.1 树模型https://blog.csdn.net/sinat_26917383/article/details/1156808072.SHAP模型

用 SHAP 可视化解释机器学习模型实用指南(上) - 墨天轮机器学习输出可视化https://www.modb.pro/db/117067

用 SHAP 可视化解释机器学习模型实用指南(下) - 墨天轮机器学习输出可视化https://www.modb.pro/db/129193

SHAP(SHapley Additive exPlanation):Python的可解释机器学习库_python机器学习建模的博客-CSDN博客_python shap值可解释机器学习在这几年慢慢成为了机器学习的重要研究方向。作为数据科学家需要防止模型存在偏见,且帮助决策者理解如何正确地使用我们的模型。越是严苛的场景,越需要模型提供证明它们是如何运作且避免错误的证据关于模型解释性,除了线性模型和决策树这种天生就有很好解释性的模型意外,sklean中有很多模型都有importance这一接口,可以查看特征的重要性。其实这已经含沙射影地体现了模型解释性的理念。只不过传统的importance的计算方法其实有很多争议,且并不总是一致。有兴趣可以之后阅读相关文章 permutatihttps://blog.csdn.net/fulk6667g78o8/article/details/122317850?spm=1001.2014.3001.5506SHAP模型:可解释机器学习模型_努力成为白糖大机智的博客-CSDN博客_shap模型小白进阶选手,如果写的内容有什么问题大家一起讨论学习呀 :)模型介绍首先个人理解SHAP模型是对机器学习模型进行解释的一个模型上面这个图就是一个比较直观的解释机器学习模型一般都是一个黑盒。比如某个模型要进行一些预测任务,首先对模型输入一些已知条件(Age=65,Sex=F,BP=180,BMI=40),然后模型根据输入进行训练,最终训练完的模型可以对该条件输出预测结果(Output=0.4)所以这样模型只能得到最终的结果,至于模型内部是怎么计算的,输入的已知条件(...https://blog.csdn.net/weixin_41968505/article/details/119885046?spm=1001.2014.3001.5506

关于颜色更改:

# Create colormap

#clist=['#EEB4B3',"#C179B9","#A42CD6","#502274",'#2F242C']

clist=['#F3F5F7',"#E9ECEF","#DEE2E6","#CED4DA",'#ADB5BD',"#6C757D","#495057","#343A40",'#212529']

newcmp = LinearSegmentedColormap.from_list('chaos',clist,N=9, gamma=0.5)

plt.figure()

class_names = ['类别1', '类别2','类别3','类别4','类别5','类别6','类别7','类别8','类别9']

shap.summary_plot(shap_values, X_test1,plot_type="bar", class_names= class_names, color=newcmp,axis_color='#2F242C')同理:

clist=["#CED4DA",'#ADB5BD',"#6C757D","#495057","#343A40",'#212529']

#clist=['#EEB4B3',"#C179B9","#A42CD6","#502274",'#2F242C']

newcmp = LinearSegmentedColormap.from_list('chaos',clist,N=100, gamma=0.5)

plt.figure()

shap.summary_plot(shap_values[1], X_test1, cmap=newcmp,axis_color='#212529')同理:

shap.initjs()

shap.plots.force(shap_values[1], plot_cmap=['#EEB4B3',"#C179B9"])3.Shapash

这是心动的感觉!最棒的模型可解释性算法包:Shapash - 知乎欢迎关注 @Python与数据挖掘 ,专注 Python、数据分析、数据挖掘、好玩工具!Shapash 是一个非常炫酷的模型解释性工具包,它有很多东西是基于之前文章中介绍的两款工具Shap和LIME。Shapash 致力于帮助大家能更加轻…![]() https://zhuanlan.zhihu.com/p/402445647

https://zhuanlan.zhihu.com/p/402445647

里面的代码有点问题:

算法模型该如何解释?_炼丹笔记的博客-CSDN博客最近时晴又发现了个炼丹神器Shapash,就迫不及待的要推荐给大家.这是个python的开源库,可以让炼丹师们在炼丹过程中理解自己为什么能练出"好"丹.相信诸位炼丹师和我一样,不仅追求一个好的模型,同时也追究模型的可解释性,废话不多说,我们看看"太阳女神"如何解释我们的模型吧.Shapashshapash适用于很多模型:Catboost,Xgboost,LightGBM,Sklearn Ensem...https://blog.csdn.net/m0_52122378/article/details/119079792?spm=1001.2014.3001.55064.可解释助推器(EBM)

https://www.5axxw.com/wiki/content/6phl6h![]() https://www.5axxw.com/wiki/content/6phl6h基于LIME的改进机器学习可解释性方法#https://www.hanspub.org/journal/PaperInformation.aspx?paperID=41346

https://www.5axxw.com/wiki/content/6phl6h基于LIME的改进机器学习可解释性方法#https://www.hanspub.org/journal/PaperInformation.aspx?paperID=41346