GPT-3等三篇论文获NeurIPS 2020 最佳论文奖!华人一作获时间检验奖

作者 | AI科技评论

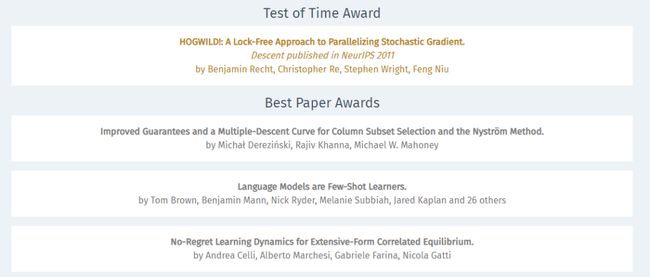

刚刚,NeurIPS 2020在官网公布了2020年度最佳论文奖和时间检验奖两项大奖!

今年一共有三篇论文共同获得最佳论文奖,其中第二篇获奖论文就是来自OpenAI团队打造的今年AI圈最为火爆的GPT-3 !

时间检验奖则是由威斯康星麦迪逊分校团队发表于NeurIPS 2011上的一篇论文获得,其一作为本科毕业于清华大学计算机系的华人Feng Niu。

1

最佳论文奖

最佳论文获奖一:《Language Models are Few-Shot Learners》

![]()

论文链接:https://papers.nips.cc/paper/2020/file/1457c0d6bfcb4967418bfb8ac142f64a-Paper.pdf

这篇获奖论文工作就是无人不知无人不晓的来自OpenAI团队打造的今年AI圈最为火爆的GPT-3 !

![]()

论文摘要:

我们证明,通过扩大语言模型的参数规模,可以极大地提高与任务无关的、少样本学习性能,有时甚至可以与现有的当前最佳微调方法相提并论。

具体来说,我们训练了GPT-3(一个具有1750亿个参数的自回归语言模型,参数量是以前的任何非稀疏语言模型的10倍),并在少样本学习设置下测试其性能。

对于所有任务,GPT-3都可以在不进行任何梯度更新或微调的情况下使用,仅需要通过与模型的文本交互指定任务和少量演示即可。

GPT-3在许多NLP数据集上均具有出色的性能,包括翻译、问答等任务。不过,我们还发现了一些数据集,在这些数据集上GPT3的少样本学习仍然困难重重。此外,在一些数据集上,GPT-3也面临一些与大型Web语料库训练有关的方法论问题。

获奖理由:

语言模型是解决NLP中一系列问题的现代技术的骨干部分。这篇论文表明,当将此类语言模型扩展到前所未有的参数数量时,语言模型本身可以用作少样本学习的工具,无需任何额外的训练就可以在许多NLP问题上取得非常出色的表现。

GPT-3是一个令人感到震撼的工作,有望对NLP领域产生重大影响,并经受住时间的考验。除了科学上的突破,这篇论文还对工作的深远影响进行了和全面且深入的诠释,可以作为NeurIPS社区思考如何考虑研究的实际影响的示例。

最佳论文获奖二:《Improved guarantees and a multiple-descent curve for Column Subset Selection and the Nystrom method》.

论文链接:https://proceedings.neurips.cc/paper/2020/file/342c472b95d00421be10e9512b532866-Paper.pdf

论文摘要:

列子集选择问题(CSSP)和Nystrom方法是机器学习和科学计算中构造大数据集、小低阶秩近似的主要工具之一。这个领域的一个基本问题是:大小为k的数据子集与最佳秩k近似的竞争程度如何?

我们开发了利用数据矩阵的光谱(spectra)特性的技术,以获得超出标准最差用例(worstcase)分析的改进近似保证。对于已知奇异值衰减率(如多项式或指数衰减)的数据集,我们的方法可以得到更好的边界(bound)。

我们的分析还揭示了一个有趣的现象:近似因子作为k的函数可能会出现多个峰和谷,我们称之为多重下降曲线(multipledescent curve)。

我们建立的一个下限表明,这种行为不是我们分析的产物,而是CSSP和Nystrom任务的固有属性。

最后,以径向基函数(RBF)核为例,本文证明了只要改变RBF参数,我们的改进边界和多重下降曲线都可以在真实数据集上观察到。

获奖理由:

从大矩阵中选择一个小型但有代表性的列向量子集并不容易。针对这个问题,找到一种基于基数受限的行列式点过程(determinantal point processes,DPP)的方法,就代表要提供一个实用的近似解决方案。

这篇论文针对最佳可能的低秩近似(low-rank approximation)推导了近似解中近似因子的新上限和下限,甚至可以捕获子集尺寸的多重下降行为。此外,该论文将分析进一步扩展,以获得Nyström方法。

由于这些近似技巧已在机器学习中得到广泛应用,因此,这篇论文有望产生重大影响,并为核方法、特征选择和神经网络的双下降行为等提供新的见解。

最佳论文获奖三:《No-Regret Learning Dynamics for Extensive-Form Correlated Equilibrium》

论文链接:https://proceedings.neurips.cc/paper/2020/file/5763abe87ed1938799203fb6e8650025-Paper.pdf

论文摘要:

在多智能体系统理论中,有一个值得称赞的结果,即简单、不耦合的无遗憾(no-regret)动态在常规形式的博弈中收敛到相关的均衡中。具体地说,这个结果已经有20多年的历史了。当所有玩家都试图在重复的常规形式博弈中最大程度地减少其内部遗憾(internal regret )时,博弈的经验频率会收敛至常规形式的相关平衡。广义形式的博弈(即树状形式的博弈)通过对顺序移动(sequential move)、同时移动(simultaneous move)以及私人信息进行建模来泛化常规形式的博弈。

由于博弈的顺序性质,以及部分信息的存在,广义形式的关联与常规形式的关联相比,具有显着不同的属性,其中许多仍然是开放的研究方向。广义形式的相关均衡(Extensive-form correlated equilibrium,EFCE)已被提议为常规形式的相关均衡的自然广义对应。但是,目前尚不知道EFCE是不是由于未耦合的智能体动态而产生的。

在本文中,我们给出了第一个解耦的无遗憾动态,该动态收敛到具有完美召回作用的n玩家一般和(general-sum)广泛形式博弈中的EFCE集。

首先,我们在广义形式的博弈中引入触发遗憾(trigger regret)的概念,从而扩展了在常规形式的博弈中内部遗憾的概念。当每个玩家的触发遗憾低时,经验的博弈频率接近EFCE。然后,我们给出了一种有效的无触发遗憾算法。我们的算法将触发遗憾在每个决策点分解为玩家的局部子问题,并根据每个决策点的局部解构造玩家的全局策略。

获奖理由:

相关均衡(correlated equilibria,CE)容易计算,对社会的帮助比常见的纳什均衡(Nash equilibria)大很多。在许多博弈中,CE都展示了一个令人惊讶的性能:可以通过简单且分散的算法将所谓的内部遗憾降到最低,从而找到CE。

这篇论文表明,在大规模博弈中,即广义(或树型)博弈中,确实存在能够将遗憾降到最低的、收敛到CE的算法。

论文结果通过博弈论、计算机科学和经济学的交叉解决了一个长期存在的开放性问题,并且对涉及调解器的博弈具有潜在的巨大影响,比如通过导航app有效规划交通路线。

2

时间检验奖

获奖论文:《HOGWILD!: A Lock-Free Approach to Parallelizing Stochastic Gradient Descent》.

论文链接:https://papers.nips.cc/paper/2011/file/218a0aefd1d1a4be65601cc6ddc1520e-Paper.pdf

论文作者:Feng Niu、Benjamin Recht、Christopher Re、Stephen J. Wright。

论文华人一作Feng Niu

Feng Niu本科就读于清华大学计算机系,2012年博士毕业于威斯康星麦迪逊分校计算机系,目前在苹果公司任研究科学家。

论文摘要:

随机梯度下降算法(SGD)是一种非常流行的算法,可以在各种机器学习任务上实现SOTA的性能。一些研究人员最近提出了SGD的并行化方案,但是都需要降低性能的内存锁定和同步(memory locking and synchronization)。

本文工作的目的是使用新的理论分析、算法和实现来证明SGD可以在没有任何锁定( locking)的情况下实现。

我们提出了一个称为HOGWILD!的新方案,它允许处理器访问共享内存,有可能重写对方的工作。

我们证明了,当相关优化问题稀疏时,大多数梯度更新只能修改决策变量的一小部分,而HOGWILD!几乎达到最佳收敛率。我们用实验证明,HOGWILD!的性能优于使用锁定( locking)方案一个数量级。

获奖理由:

这篇论文首先展示了如何在没有任何锁定机制的情况下将普遍使用的随机梯度下降算法并行,同时又能实现强大的性能。

近期,一些研究人员虽然提出了并行SGD的方法,但他们的方法均需要不同工作器进行内存锁定和同步。

本文针对稀疏问题提出了一种简单的策略,称为Hogwild!方法:让每个工作器在不同的数据子集上同时运行SGD,并在托管模型参数的共享内存中执行完全异步更新。

通过理论和实验,他们证明Hogwild! 成功在满足适当稀疏条件的数据上实现了相对于处理器数量的近乎线性的加速。

3

获奖论文评选过程

在评选获奖论文时,评奖委员会使用了以下评审标准:

该论文是否能经受实验考验?

它是否提供新的(最好是深入的)见解?

它是具有创意的、意想不到的吗?

它会改变人们未来的思维方式吗?

它是否严谨而优雅,但并未夸大其重要性?

它是科学的、可复现的吗?

它是否准确地描述了研究的更广泛影响?

最佳论文奖评选过程

为了选出NeurIPS最佳论文奖的获奖者,奖项委员会经过了严格的两阶段选拔过程:

第一阶段,两名委员会成员阅读了30篇具有最高评分的NeurIPS论文。委员会成员还阅读了相应的论文评论和反驳。在此基础上,委员会根据评审标准选择了9篇突出的论文。

第二阶段,所有委员会成员都阅读了入围名单上的9篇论文,并根据审查标准对它们进行了排名。接下来,委员会举行虚拟会议,并最终确定获奖者。

时间检验奖评选过程

委员会确定了大约十年前在NeurIPS上发表的12篇论文的清单(NeurIPS 2009,NeurIPS 2010,NeurIPS 2011),这些论文是自发表以来在NeurIPS中被引用次数最多的论文。

委员会还通过汇总这些论文在过去两年中在NeurIPS、ICML和ICLR上受到的引用,收集了有关这些论文最近引用次数的数据。

然后,委员会要求整个高级计划委员会(64个SAC)对其中的三篇论文进行投票,以挑选出一篇有影响力的论文。

参考链接:https://neuripsconf.medium.com/announcing-the-neurips-2020-award-recipients-73e4d3101537

重磅!DLer-AI顶会交流群已成立!

大家好,这是DLer-AI顶会交流群!首先非常感谢大家的支持和鼓励,欢迎各位加入DLer-AI顶会交流群!本群旨在学习交流人工智能顶会(CVPR/ICCV/ECCV/NIPS/ICML/ICLR/AAAI等)、顶刊(IJCV/TPAMI/TIP等)写作与投稿事宜。包括第一时间发布论文信息和公开演讲视频,以及各大会议的workshop等等。希望能给大家提供一个更精准的研讨交流平台!!!

添加请备注:AI顶会+学校/公司+昵称(如CVPR+上交+小明)

![]()

???? 长按识别添加,即可进群!