空间分析——统计基础

空间分析——统计基础

- 基础知识

-

- 随机变量

-

- 随机变量的分布

- 随机变量的数字特征

-

- 1. 期望

- 2. 方差

- 3. 协方差与相关系数

- 4. 矩的概念

- 重要统计量及其抽样分布

-

- 正态分布

- chi-square分布

- t分布

- F分布

- 参数估计

-

- 点估计

- 区间估计

- 假设检验

-

- 基本思想与步骤

- 常见假设检验

- 方差分析

-

- 基本原理(单因素方差分析)

-

- 前提条件

- 回归分析

-

- 简单线性回归

- 多元线性回归

- logistics回归

- 地理加权回归

- 相关分析

-

- 简单线性相关

-

- 秩相关

- 偏相关

- 复相关

- 典型相关

- 空间自相关

-

- 全局莫兰指数

- 全局Geti统计法

- 局部莫兰指数

基础知识

随机变量

背景: 为了对随机现象进行定量的数学处理,必须把随机现象的结果数量化,所以我们引入随机变量。

定义: 随机变量就是“其值随机会而定”的变量,它是一个用来表示随机现象结果的变量。

随机变量的随机性体现着当实验没有进行时,它可以取实数空间内任意的值(但是取到某个值是有一定概率的),一旦实验进行完毕得到观测结果,随机变量就退化为一个确定性变量。

在概率论领域,对于一个随机实验我们所关心的往往是与所研究的特定问题有关的某个或某些量,这些量就是随机变量。

例子:一个人的年收入

确定性变量:年收入在3000元以下的低收入者的比率——静态角度

随机变量:X = 随机抽取一个人,其年收入是多少?——动态角度

3000元以下可表示为:P{X<3000}

随机变量的分布

1. 概率

定义: 概率用来描述随机事件发生的可能性的大小。

例如,投骰子,是一个随机实验,取到的点数(X = n,n∈1,2,3,4,5,6)是一个随机事件,而取到某一个点数的可能性用概率来描述。即 P(X = n) = p。

2. 分布函数

定义: 设X是一个随机变量,对于任意实数x,称 F ( x ) = P ( X ⩽ x ) F(x)=P(X \leqslant x) F(x)=P(X⩽x)为随机变量X的分布函数。

3. 概率密度函数

定义:(针对连续型变量)如果存在实数轴上的一个非负可积的函数p(x),对任意实数x有: F ( x ) = ∫ − ∞ x p ( x ) d x F(x)=\int_{-\infty}^x p(x) d x F(x)=∫−∞xp(x)dx

p ( x ) p(x) p(x)称为X的概率密度函数。

随机变量的数字特征

1. 期望

(1)离散型

定义: 设随机变量X的分布列为: p ( x i ) = P ( X = x i ) , i = 1 , 2 , ⋯ , n , ⋯ p\left(x_i\right)=P\left(X=x_i\right), i=1,2, \cdots, n, \cdots p(xi)=P(X=xi),i=1,2,⋯,n,⋯,如果: ∑ i = 1 ∞ ∣ x i ∣ p ( x i ) < ∞ \sum_{i=1}^{\infty}\left|x_i\right| p\left(x_i\right)<\infty ∑i=1∞∣xi∣p(xi)<∞(满足收敛性)

则称 E ( X ) = ∑ i = 1 ∞ x i p ( x i ) E(X)=\sum_{i=1}^{\infty} x_i p\left(x_i\right) E(X)=∑i=1∞xip(xi) 为随机变量X的数学期望。

(2)连续型

定义: 设 p ( x ) p(x) p(x) 为随机变量X的密度函数,如果 ∫ − ∞ ∞ ∣ x ∣ p ( x ) d x < ∞ \int_{-\infty}^{\infty}|x| p(x) \mathrm{d} x<\infty ∫−∞∞∣x∣p(x)dx<∞(满足收敛性),

则称 E ( X ) = ∫ − ∞ ∞ x p ( x ) d x E(X)=\int_{-\infty}^{\infty} x p(x) \mathrm{d} x E(X)=∫−∞∞xp(x)dx为随机变量X的数学期望

理解:

物理解释:重心所在的位置

理论意义:消除随机性的主要手段

统计意义:E(X)常用作一种统计指标,来代表X的分布

2. 方差

定义:

若随机变量 X 2 X^2 X2的数学期望 E ( X 2 ) E\left(X^2\right) E(X2)存在,则称偏差的平方的数学期望: Var ( X ) = E ( X − E ( X ) ) 2 \operatorname{Var}(X)=E(X-E(X))^2 Var(X)=E(X−E(X))2 为随机变量 X X X的方差

理解

反映了随机变量取值的集中与分散程度

方差与标准差:有无量纲

3. 协方差与相关系数

定义:

(1) 协方差

定义: 描述两个分量之间的互相关联程度的一个特征数。表示两个变量同时变化的程度。

背景: 二维联合分布中除了含有各分量的边际分布外,还含有两个分量之间相互关联的信息

数学表达为: C o v ( X , Y ) = E [ x − E ( x ) ] [ y − E ( y ) ] = E ( x y ) − E ( x ) E ( y ) Cov(X, Y) = E[x-E(x)][y-E(y)]=E(xy)-E(x)E(y) Cov(X,Y)=E[x−E(x)][y−E(y)]=E(xy)−E(x)E(y)

(2)相关系数

背景: 协方差是有量纲的量,相关系数是为了消除这种量纲。所以 Cov ( X , Y ) σ X σ Y \frac{\operatorname{Cov}(X, Y)}{\sigma_X \sigma_Y} σXσYCov(X,Y)

另一种理解方式是它是标准化变量的协方差 X ∗ = X − μ X σ X , Y ∗ = Y − μ Y σ Y X^*=\frac{X-\mu_X}{\sigma_X}, \quad Y^*=\frac{Y-\mu_Y}{\sigma_Y} X∗=σXX−μX,Y∗=σYY−μY。

解释:

>0,正相关,因为两项有同时增加或减少的倾向,又因为E(x),E(y)都是常数,等同于X、Y有同时增加或减少的倾向。

<0,……

=0:毫无关联,一个增大的同时另一个增大减小是随机的,相互抵消。or 非线性,如圆周曲线的情况,x增大,y由小变大又变小。

4. 矩的概念

- 一阶原点矩:期望

- 二阶中心矩:方差

- 协方差又称为变量X,Y的二阶混合中心矩

重要统计量及其抽样分布

统计量

设 x 1 , x 2 , ⋯ , x n x_1, x_2, \cdots, x_n x1,x2,⋯,xn是取自某总体的样本,若样本函数 T T T = T T T( x 1 , x 2 , ⋯ , x n x_1, x_2, \cdots, x_n x1,x2,⋯,xn)中不含有任何未知参数,则称 T T T 为统计量,统计量的分布成为“抽样分布”

若 x 1 , x 2 , ⋯ , x n x_1, x_2, \cdots, x_n x1,x2,⋯,xn为样本,则 ∑ i = 1 n x i \sum_{i=1}^n x_i ∑i=1nxi、 ∑ i = 1 n ( x i ) 2 \sum_{i=1}^n\left(x_i\right)^2 ∑i=1n(xi)2 都是统计量

尽管统计量不依赖于未知参数,但是它的分布一般还是依赖于未知参数的

正态分布

- 表示: X ∼ N ( μ , σ 2 ) X \sim N\left(\mu, \sigma^2\right) X∼N(μ,σ2)

μ \mu μ是位置参数; σ 2 \sigma^2 σ2是尺度参数

- 概率密度函数: f ( x ) = 1 2 π σ e − ( x − μ ) 2 2 σ 2 f(x)=\frac{1}{\sqrt{2 \pi} \sigma} \mathrm{e}^{-\frac{(x-\mu)^2}{2 \sigma^2}} f(x)=2πσ1e−2σ2(x−μ)2

chi-square分布

定义: 设 X 1 , X 2 , ⋯ , X n i.i.d. ∼ N ( 0 , 1 ) X_1, X_2, \cdots, X_n \text { i.i.d. } \sim N(0,1) X1,X2,⋯,Xn i.i.d. ∼N(0,1),构造统计量 X = ∑ i = 1 n X i 2 X=\sum_{i=1}^n X_i^2 X=∑i=1nXi2,则称 X X X的分布是自由度为 n n n 的 χ 2 \chi^2 χ2分布,记作: X ∼ χ n 2 X \sim \chi_n^2 X∼χn2

图像:

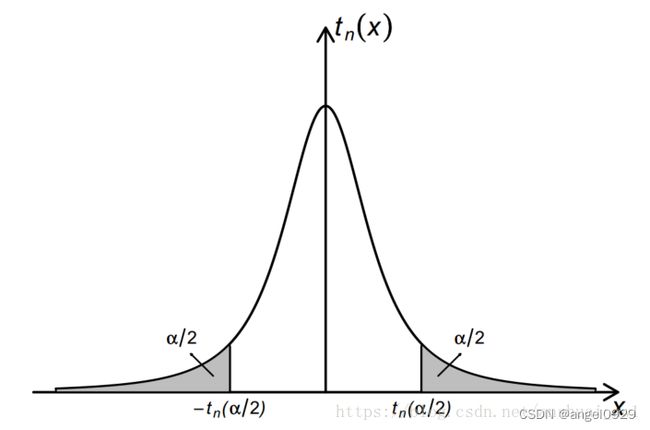

t分布

定义: 设随机变量 X X X, Y Y Y相互独立,且 X ∼ N ( 0 , 1 ) , Y ∼ χ n 2 X \sim N(0,1), Y \sim \chi_n^2 X∼N(0,1),Y∼χn2,则称 T = X Y / n T=\frac{X}{\sqrt{Y / n}} T=Y/nX 的分布为自由度为 n n n 的 t t t 分布。

图像:

来源:

Gosset 在检测酿酒质量的时候根据中心极限定理构造统计量,用样本方差代替总体方差计算得到的异常结果(大于 ± 2 σ ±2\sigma ±2σ)的频率总是偏大,于是他经过研究发现 n ( X ˉ − μ ) s \frac{\sqrt{n}(\bar{X}-\mu)}{s} sn(Xˉ−μ) 的分布与 N ( 0 , 1 ) N(0,1) N(0,1)的分布并不相同,尤其是尾部的概率相差较大,因而提出了 t t t 分布。

即 n ( X ˉ − μ ) s \frac{\sqrt{n}(\bar{X}-\mu)}{s} sn(Xˉ−μ) 服从自由度为 n − 1 n-1 n−1 的 t t t 分布。

F分布

定义: 设随机变量 X ∼ χ m 2 , Y ∼ χ n 2 X \sim \chi_m^2, Y \sim \chi_n^2 X∼χm2,Y∼χn2, 且 X X X 和 Y Y Y 独立, 则称 F = X / m Y / n F=\frac{X / m}{Y / n} F=Y/nX/m 的分布为自由度为 m m m与 n n n的 F F F 分布,记作 F ∼ F ( m , n ) F \sim F(m,n) F∼F(m,n)

图像:

参数估计

点估计

定义: 设 x 1 , ⋯ , x n x_1, \cdots, x_n x1,⋯,xn 是来自总体的一个样本, 用于估计末知参数 θ \theta θ 的 统计量 θ ^ = θ ^ ( x 1 , ⋯ , x n ) \hat{\theta}=\hat{\theta}\left(x_1, \cdots, x_n\right) θ^=θ^(x1,⋯,xn) 称为 θ \theta θ 的估计量, 或称为 θ \theta θ 的点估计。

方法:

- 矩估计法

思想: 构造样本和总体的矩,然后用样本的矩去估计总体的矩。 - 最大似然估计

思想: 利用已知的样本结果,反推最有可能(最大概率)导致这样结果的参数值。

区间估计

定义: 设 θ \theta θ 是总体的一个参数, x 1 , ⋯ , x n x_1, \cdots, x_n x1,⋯,xn 是样本, 所诮区间估计就是要找两个统计 量 θ ^ L = θ ^ L ( x 1 , ⋯ , x n ) \hat{\theta}_L=\hat{\theta}_L\left(x_1, \cdots, x_n\right) θ^L=θ^L(x1,⋯,xn) 和 θ ^ U = θ ^ U ( x 1 , ⋯ , x n ) \hat{\theta}_U=\hat{\theta}_U\left(x_1, \cdots, x_n\right) θ^U=θ^U(x1,⋯,xn), 使得 θ ^ L < θ ^ U \hat{\theta}_L<\hat{\theta}_U θ^L<θ^U, 在得到样本观测值之后, 就把 θ \theta θ 估计在区间 [ θ ^ L , θ ^ v ] \left[\hat{\theta}_L, \hat{\theta}_v\right] [θ^L,θ^v] 内.

置信区间: [ θ ^ L , θ ^ v ] \left[\hat{\theta}_L, \hat{\theta}_v\right] [θ^L,θ^v]

置信上限: θ ^ L \hat{\theta}_L θ^L;置信下限: θ ^ v \hat{\theta}_v θ^v

置信水平: 1 − α 1-\alpha 1−α

目标: 给定置信水平,求该置信水平下的置信上下限,即:

P θ ( θ ^ L ⩽ θ ⩽ θ ^ L ) ⩾ 1 − α P_\theta\left(\hat{\theta}_L \leqslant \theta \leqslant \hat{\theta}_L\right) \geqslant 1-\alpha Pθ(θ^L⩽θ⩽θ^L)⩾1−α

- 枢轴量法

思想: 构造一个含有待估参数但分布与待估参数无关的统计量,这样的话给定置信区间就可以根据统计量的分布得到置信上下限 ( c , d ) (c,d) (c,d),此时不等式 c ≤ S ( θ ) ≤ d \mathrm{c} \leq \mathrm{S(\theta)}\leq \mathrm{d} c≤S(θ)≤d 中唯一的未知数就是 S ( θ ) S(\theta) S(θ)中的 θ \theta θ,因而可以自然的解出 θ \theta θ 的区间估计

假设检验

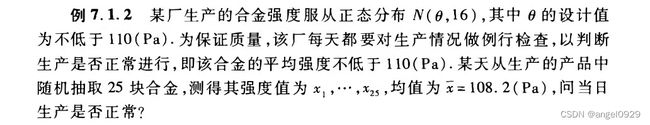

基本思想与步骤

目标: 判断 x ˉ = 108.2 \bar{x}=108.2 xˉ=108.2 是否落在 H 0 H_0 H0: θ ⩾ 110 \theta \geqslant 110 θ⩾110 的接受域内?

所以,设接受域的边界为 c c c,即求 x ˉ ≥ c \bar{x}≥c xˉ≥c 的区域是否包含 108.2 108.2 108.2

基于 x ˉ \bar{x} xˉ,构造一个统计量,使其分布不依赖于未知参数

Q2: 如何确定 c c c?

计算在上述分布的情况下,使得大部分合理的样本能满足 x ˉ ≥ c \bar{x}≥c xˉ≥c,即约束条件+1:: P ( x ˉ ⩾ c ) ⩾ 1 − α P(\bar{x} \geqslant c) \geqslant 1-\alpha P(xˉ⩾c)⩾1−α

结果: 最后求得 c c c 的临界值为108.684,即 x ˉ ≥ 108.684 \bar{x}≥108.684 xˉ≥108.684 是原价是的接受域,108.2未落在接受域内。

常见假设检验

方差分析

方差分析不是分析样本方差,它是用来分析多组数据之间的均值是否有显著性差异。但在判断均值之间是否有差异时需要借助于方差。

它是通过对数据误差来源的分析来判断不同总体的均值是否相等,进而分析自变量对因变量是否有显著影响。

基本原理(单因素方差分析)

总误差(SST)= 组内误差(SSE)+ 组间误差(SSA)

组内误差: SSE = ∑ i = 1 k ∑ j = 1 n i ( y i j − y ˉ i ) 2 \operatorname{SSE}=\sum_{i=1}^k \sum_{j=1}^{n_i}\left(y_{i j}-\bar{y}_i\right)^2 SSE=∑i=1k∑j=1ni(yij−yˉi)2

组间误差: SSA = ∑ i = 1 k n i ( y ˉ i − y ˉ ) 2 \operatorname{SSA}=\sum_{i=1}^k n_i\left(\bar{y}_i-\bar{y}\right)^2 SSA=∑i=1kni(yˉi−yˉ)2

总误差: SST = ∑ i = 1 k ∑ j = 1 n i ( y i j − y ˉ ) 2 \operatorname{SST}=\sum_{i=1}^k \sum_{j=1}^{n_i}\left(y_{i j}-\bar{y}\right)^2 SST=∑i=1k∑j=1ni(yij−yˉ)2

目标: 比较组内误差和组间误差之间是否存在显著差异

提出假设: H 0 : μ 1 = μ 2 = ⋯ = μ i = ⋯ = μ k H_0: \mu_1=\mu_2=\cdots=\mu_i=\cdots=\mu_k H0:μ1=μ2=⋯=μi=⋯=μk,自变量对因变量没有显著影响

构造统计量:

M S A = 组间平方和 自由度 = S S A k − 1 M S E = 组内平方和 自由度 = S S E n − k M S A=\frac{\text { 组间平方和 }}{\text { 自由度 }}=\frac{S S A}{k-1} \quad M S E=\frac{\text { 组内平方和 }}{\text { 自由度 }}=\frac{S S E}{n-k} MSA= 自由度 组间平方和 =k−1SSAMSE= 自由度 组内平方和 =n−kSSE

F = M S A M S E ∼ F ( k − 1 , n − k ) F=\frac{M S A}{M S E} \sim F(k-1, n-k) F=MSEMSA∼F(k−1,n−k)

前提条件

- 变量之间相互独立

- 满足正态分布——正态性检验

- 各组之间的方差相同—方差齐次性检验

回归分析

回归分析用以估算自变量和因变量之间的定量关系,二者的函数关系。评估给定自变量的情况下因变量的条件期望值(预测)。

简单线性回归

R 2 = SSR R^2=\operatorname{SSR} R2=SSR(自变量解释的方差) / S S T \mathrm{SST} SST(总方差)

参数估计方法:

- 最小二乘法

- 最大似然估计

- Theil-Sen estimator

最小二乘法对异常值敏感,Theil-Sen estimator将斜率的估计计算为成对点斜率 ( y j − y i ) / ( x j − x i ) \left(y_j-y_i\right) /\left(x_j-x_i\right) (yj−yi)/(xj−xi) 的中位数(median) m m m, 截距为成对点截距的中位数 y i − m x i y_i-m x_i yi−mxi, 进而有效地排除异常值的影响

显著性检验:

-

整体拟合度检验

OLS整体拟合采用方差分析。

∑ ( Y i − Y ˉ ) 2 = ∑ ( Y ^ i − Y ˉ ) 2 + ∑ ( Y i − Y ^ i ) 2 \sum\left(Y_i-\bar{Y}\right)^2=\sum\left(\hat{Y}_i-\bar{Y}\right)^2+\sum\left(Y_i-\hat{Y}_i\right)^2 ∑(Yi−Yˉ)2=∑(Y^i−Yˉ)2+∑(Yi−Y^i)2 ( Y i Y_i Yi:观测值; Y ˉ \bar{Y} Yˉ:观测平均值; Y ^ \hat{Y} Y^:拟合值)

总误差(SST)= 回归平方和(SSR)+ 残差平方和(SSE)– 统计量: F = S S R / m S S E / ( n − m − 1 ) ∼ F ( m , n − m − 1 ) n F=\frac{S S R / m}{S S E /(n-m-1)} \sim F(m, n-m-1) \quad n F=SSE/(n−m−1)SSR/m∼F(m,n−m−1)n-样本数, m m m-解释变量个数

-

回归系数显著性:

H 0 : β 1 = 0 H_0: \beta_1=0 H0:β1=0

t = β ^ 1 / ( σ ∑ ( X − X ˉ ) 2 ) σ = ∑ ( Y i − Y ^ ) 2 n − 2 , n − 2 t=\hat{\beta}_1 /\left(\frac{\sigma}{\sqrt{\sum(X-\bar{X})^2}}\right) \quad \sigma=\sqrt{\frac{\sum\left(Y_i-\hat{Y}\right)^2}{n-2}} \quad,n-2 t=β^1/(∑(X−Xˉ)2σ)σ=n−2∑(Yi−Y^)2,n−2 个自由度

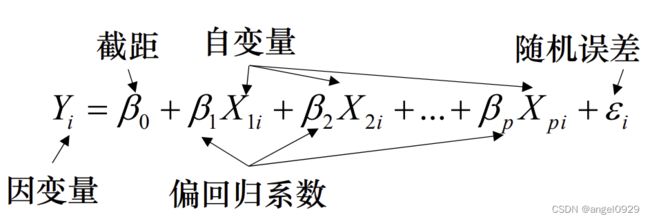

多元线性回归

拟合一个因变量与多个自变量之间的线性依赖关系

自变量对因变量的解释程度:

R a d j 2 = 1 − ( 1 − R 2 ) n − 1 n − p − 1 n 为样本数 p 为解释变量数 R_{a d j}^2=1-\left(1-R^2\right) \frac{n-1}{n-p-1} \quad \begin{aligned} & n \text { 为样本数 } \\ & p \text { 为解释变量数 }\end{aligned} Radj2=1−(1−R2)n−p−1n−1n 为样本数 p 为解释变量数

因为决定系数 R 会随着自变量个数的增加而递增,即使增加的自变量与因变量之间无关,所以引入校正的决定系数,剔除了自变量个数的影响。

Beta拟合系数:

解释变量量纲不同时,不容易比较单位自变量的变化引起多少因变量的改变。所以将所有变量进行标准化变换 (方差=1) 后进行拟合,产生beta拟合系数解释为自变量一个标准差的变化会引起因变量多少标准差的变化。

显著性检验:

- 残差分析

残差是因变量未被解释的部分。在自然界中残差是必然存在的,我们可以将回归方程理解为“趋势”+“随机”,建模拟合的目标是找到由自变量体现的因变量的“趋势”部分,即可预测部分。所以我们期望剩余的误差应该是随机的,同时残差应该具有“不可预测性”

1、残差不应该与另外的变量有所相关。即,无法用自变量预测。

2、相邻残差不应该相互关联(残差的自相关性)。即,无法使用一个残差来预测得到下一个残差。

所以要进行残差的独立性,正态性,方差齐次性检验

- 残差正态性检验

当模型的残差服从正态性假设时,才能保证模型偏回归系数对于的t值和模型的F值是有效的。

- 回归方程显著性:F检验

- 回归系数显著性:t 检验

- 检验解释变量的多重共线性

多重共线性是指 线性回归模型 中的解释变量之间由于存在精确相关关系或高度相关关系而使模型估计失真或难以估计准确。

一旦发现变量之间存在多重共线性的话,可以考虑删除变量和重新选择模型(岭回归法)。

可以用主成分回归方法解决,即是将一组解释变量利用主成分变换(线性组合)的方法产生新变量, 与因变量做回归

分类解释变量:

不同类别具有不同的截距

(20.1376: 斜率;4.6308: gdp贡献的截距;Estimate剩下的部分为每一个类别增加的截距。eg.预测亚洲的人均寿命时,在原始回归方程的基础上再加上10.1144)

logistics回归

逻辑回归是统计学习中的经典分类方法,属于对数线性模型,所以也被称为对数几率回归。这里要注意,虽然带有回归的字眼,但是该模型是一种分类算法,逻辑斯谛回归是一种线性分类器,针对的是线性可分问题。

回归方程式:

h ( w ) = w 1 x 1 + w 2 x 2 + w 3 x 3 + … … + b h(w)=w_1 x_1+w_2 x_2+w_3 x_3+……+b h(w)=w1x1+w2x2+w3x3+……+b,

可写成: y ^ = w T X + b \hat{y}=w^T X+b y^=wTX+b

通过sigmod函数: 1 1 + e − h \frac{1}{1+e^{-h}} 1+e−h1 把值域限制在0-1,从而实现分类

地理加权回归

背景: 空间的非平稳性为题,即由地理位置变化引起的空间异质性。

地理加权回归是一种基于空间变化关系建模的局部线性回归方法,它在研究区域的每一处产生一个描述局部关系的回归模型,从而能很好的解释变量的局部空间关系与空间异质性。

公式: y i = β 0 ( u i , v i ) + ∑ k = 1 m β k ( u i , v i ) x i k + ε i y_i=\beta_0\left(u_i, v_i\right)+\sum_{k=1}^m \beta_k\left(u_i, v_i\right) x_{i k}+\varepsilon_i yi=β0(ui,vi)+∑k=1mβk(ui,vi)xik+εi

y i y_i yi 为在位置 i i i 处的因变量值;

x i k x_{i k} xik为 i i i 处的自变量值;

( u i , v i ) \left(u_i, v_i\right) (ui,vi) 为坐标;

β 0 ( u i , v i ) \beta_0\left(u_i, v_i\right) β0(ui,vi)为截距项;

β k ( u i , v i ) \beta_k\left(u_i, v_i\right) βk(ui,vi)为回归分析系数:通过距离衰减函数计算得到每个要素在局部回归方程里的权重。修正了普通的线性回归未考虑空间关系而带来的误差。

相关分析

用于测试随机变量之间的统计依赖性,相关系数用于定量给出相关性的大小。

简单线性相关

Pearson’s相关系数: 是一种参数方法,用于衡量变量之间的线性相关性,反映整个样本的平均响应。

总体: ρ X , Y = cov ( X , Y ) σ X σ Y \rho_{X, Y}=\frac{\operatorname{cov}(X, Y)}{\sigma_X \sigma_Y} \quad ρX,Y=σXσYcov(X,Y)

样本: r x y = ∑ i = 1 n ( x i − x ˉ ) ( y i − y ˉ ) ∑ i = 1 n ( x i − x ˉ ) 2 ∑ i = 1 n ( y i − y ˉ ) 2 r_{x y}=\frac{\sum_{i=1}^n\left(x_i-\bar{x}\right)\left(y_i-\bar{y}\right)}{\sqrt{\sum_{i=1}^n\left(x_i-\bar{x}\right)^2} \sqrt{\sum_{i=1}^n\left(y_i-\bar{y}\right)^2}} rxy=∑i=1n(xi−xˉ)2∑i=1n(yi−yˉ)2∑i=1n(xi−xˉ)(yi−yˉ)

显著性检验:

t = r n − 2 1 − r 2 t=r \sqrt{\frac{n-2}{1-r^2}} t=r1−r2n−2,用自由度为n-2的 t 分布近似。

秩相关

Spearman’s rank correlation: 是一种非参数方法,适用于连续与离散型变量,刻画的是随机变量之间的单调关系,测量的是样本对排序的响应。

ρ = 1 − 6 ∑ d i 2 n ( n 2 − 1 ) d i = rg ( X i ) − rg ( Y i ) d i \rho=1-\frac{6 \sum d_i^2}{n\left(n^2-1\right)} \quad d_i=\operatorname{rg}\left(X_i\right)-\operatorname{rg}\left(Y_i\right) \quad d_i ρ=1−n(n2−1)6∑di2di=rg(Xi)−rg(Yi)di 是对应观测值的排序差, n n n 为观测个数

显著性检验:

t = r n − 2 1 − r 2 t=r \sqrt{\frac{n-2}{1-r^2}} t=r1−r2n−2,用自由度为n-2的 t 分布近似。

偏相关

背景: 相关系数有时又被称为“完全相关系数”,因为它里面包含了一切可能的相关性。这就解释了为何看来彼此并无密切因果关系的变量,在观察结果上会显示出较强的相关性。

例子: 收入高的人各方面消费都倾向于高,它会带动吃(X1)和穿(X2)的增长,以至于使得二者显示出较强的正相关。但是把收入(X3)的影响消去,二者可能会转换为负相关,因为一个人收入一定时,它一方面消费较大一般会导致另一方面消费的减少

“消除”的含义:

复相关

定义: 设 X 1 , X 2 , ⋯ , X p X_1, X_2, \cdots, X_p X1,X2,⋯,Xp, X 1 X_1 X1对每个 X j X_j Xj的相关性不一定很显著,但是全体 X 2 , ⋯ , X p X_2, \cdots, X_p X2,⋯,Xp联合起来则与 X 1 X_1 X1有较显著的相关性。

“复”的含义:

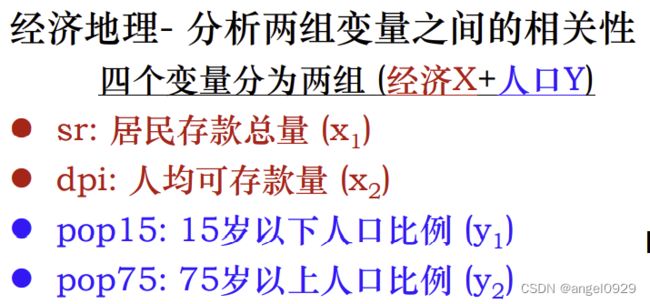

典型相关

定义: 典型相关分析用于研究两组变量(每组变量中都可能有多个指标)之间相关关系的一种多元统计方法。它能够揭示出两组变量之间的内在联系。

思想: 将一组变量和另一组变量之间的相关性转化为两个新的综合变量(原变量的线性组合-主成分)之间的相关,并使得新的综合变量之间存在最大可能的相关性。与主成分分析的思想类似。

空间自相关

全局莫兰指数

计算公式: I = N W ∑ i ∑ j w i j ( x i − x ˉ ) ( x j − x ˉ ) ∑ i ( x i − x ˉ ) 2 I=\frac{N}{W} \frac{\sum_i \sum_j w_{i j}\left(x_i-\bar{x}\right)\left(x_j-\bar{x}\right)}{\sum_i\left(x_i-\bar{x}\right)^2} I=WN∑i(xi−xˉ)2∑i∑jwij(xi−xˉ)(xj−xˉ)

含义: 只有 x i x_i xi 和 x j x_j xj 都大于或小于 x ˉ \bar{x} xˉ 时, I > 0 I>0 I>0,表示高值/低值在相近的空间上会同时出现,容易聚集在一起。

I < 0 I<0 I<0 表示一个增大的同时另一个减小,即呈现负相关关系

缺点: 只能衡量全局上某空间随机变量整体的自相关程度,即属性相似的单元间是否呈聚集状态,但是无法表达空间中聚集区的分布,也无法判断时高值聚集还是低值聚集。

全局Geti统计法

计算公式: G = ∑ i = 1 n ∑ j = 1 n w i j x i x j ∑ i = 1 n ∑ j = 1 n x i x j G=\frac{\sum_{i=1}^n \sum_{j=1}^n w_{i j} x_i x_j}{\sum_{i=1}^n \sum_{j=1}^n x_i x_j} G=∑i=1n∑j=1nxixj∑i=1n∑j=1nwijxixj

功能: 衡量全局尺度上某空间随机变量聚集程度的统计量,同时识别是高值聚集还是低值聚集,即区分“冷点区”和“热点区”

缺点: 用于识别空间负相关的效果差

局部莫兰指数

计算公式: I i = x i − X ˉ S i 2 ∑ j = 1 n w i j ( x j − X ˉ ) I_i=\frac{x_i-\bar{X}}{S_i^2} \sum_{j=1}^n w_{i j}\left(x_j-\bar{X}\right) Ii=Si2xi−Xˉ∑j=1nwij(xj−Xˉ)

含义: 前者可反映出第 i i i 个地区的经济发展水平与整个区域的平均水平之间的高低情况,后者则反映出第 i i i 个地区的周边地区与整个区域水平之间的高低情况。

作用: 识别空间中哪些地方存在空间聚集现象,是高值聚集还是低值聚集;or哪些地方存在空间负相关。