【论文 AAAI 2020】强化学习投资组合 + 自然语言处理

论文题目:Reinforcement-Learning Based Portfolio Management with Augmented Asset Movement Prediction States

会议: The Thirty-Fourth AAAI Conference on Artificial Intelligence (AAAI-2020) (CCF A)

目录

-

- abstract

- introduction

- Related Work

- Background and Problem Formulation

- SARL: A Framework of Deep RL with Augmented Asset Movement Prediction States

-

- Augmented Asset Movement Prediction State

- Deterministic Policy Gradient(DPG)

- Action and Reward for Portfolio Optimization

- Experimental Results

-

- Datasets

- Evaluation Metrics

- Baselines

- Data Challenge

- Results and Discussion

abstract

投资组合管理(Portfolio management ,PM)是一项基本的财务规划任务,旨在实现投资目标,如最大利润或最小风险。它的决策过程包括从各种数据源中不断提取有价值的信息和顺序决策优化,这是强化学习(RL)的一个前瞻性研究方向。

在本文中,我们提出了SARL模型,一种新的基于强化学习的状态增强PM框架。

旨在解决PM中的两个独特挑战:

(1)数据异构性–为每项资产收集的信息通常是多样的、嘈杂的和不平衡的(例如:新闻文章);

(2)环境不确定性——金融市场是多功能的、非平稳的。

为了整合异构数据,并增强对环境不确定性的鲁棒性,我们的SARL增加了资产信息,将其作为价格预测的附加状态,其中预测可以完全基于财务数据(例如:资产价格)或其他来源(如新闻),利用除了经典的金融数据之外的其他信息,进行市场预测。

通过对两个真实数据集进行实验:(i)比特币市场和(ii)高科技股票市场,数据为7年的 Reuters 新闻文章,验证了SARL的有效性,在累积利润和风险调整利润方面优于现有PM方法。

此外,还进行了大量的仿真,以证明状态增强的重要性,提供了新的见解,性能明显优于基于标准RL的PM方法、其他基线方法。

introduction

contributions:

- 为PM提出了一种新的状态增强RL框架(SARL),可以利用不同来源的附加信息进行市场预测,作为增强的状态嵌入RL框架中,以提高PM性能

- 我们在两个真实数据集上评估了提出的SARL,结果表明,SARL在比特币数据集和高科技数据集上的表现分别比最新方法高140.9%和15.7%

- 我们对基于RL的标准PM方法和SARL进行了深入分析,结果表明,SARL在数据分布转移方面比前者更具普遍性。我们还进行模拟以证明其合理性;

- 我们进行了大量的实验,发现:1)利用不同的信息可以减少环境不确定性的影响。2) 即使在信息嘈杂的情况下,高密度(更频繁)的外部信息也有助于提高PM的整体性能。3) 低密度但高精度的外部信息也可以改善PM性能。

Related Work

Background and Problem Formulation

PM是一项基本的财务规划任务,旨在通过资产配置实现预测利润最大化(或计算风险最小化)。

我们假设市场具有足够的流动性,因此任何交易都可以在对市场影响最小的情况下立即执行。

对于PM,我们考虑的情况是:有一种机器学习算法,可以从市场收集所有可行的信息,然后逐步改善其交易策略。

在这里,由PM的所有资产和其他可用信息组成的市场称为环境。基于流动性假设,可以将观察环境然后做出与市场互动和重新平衡投资组合的决策的算法定义为agent。

在本文中,我们考虑,环境提供资产价格(内部数据源)、财务新闻文章(外部数据源)。agent可以访问当前时间段的所有历史价格和新闻文章,以进行低水平预测,如价格变化,或高水平预测,如资产变化(上升/下降)。

低水平预测应该是对应单只股票的涨跌,高水平预测对应投资组合。

直观地说,agent准确预测资产价格变化过于理想化,由于市场不确定性、训练和测试的环境可能分布不同,很难在实践中进行训练。

另一方面,预测高水平变化(如资产变化)可能更容易,这反过来又会在资产价格上涨以重新分配投资组合时,提供更可靠的预测信息。

设 v ( i , t ) v(i,t) v(i,t), i={1,…,n}表示第i项资产在时间t的收盘价,其中n为资产数量。价格向量 v t v_t vt由n种资产的收盘价组成。

类似地, v t H v_t^H vtH和 v t L v_t^L vtL分别为 t 时刻的最高价和最低价,t 代表不同交易日。

除了n个资产的投资组合外,我们引入了 v ( 0 , t ) v(0,t) v(0,t),表示现金价格。

我们将 v t v_t vt中的所有时间变量进行标准化,现金价格为常数。

将PM问题建模为马尔可夫决策过程,下一个状态仅取决于当前状态和action。

将PM问题表述为三元组(S,A,r),其中S是一组状态,a是一组动作,r:S×A→ R是奖励函数。

我们引入再分配权重分数,根据每种资产的权重,重新分配资产:

w t = ( w ( 0 , t ) , w ( 1 , t ) , . . . , w ( n , t ) ) T w_t=(w(0,t), w(1, t),..., w(n, t))^T wt=(w(0,t),w(1,t),...,w(n,t))T,其中, ∑ i n w ( i , t ) = 1 \sum_i^nw(i,t)=1 ∑inw(i,t)=1

SARL: A Framework of Deep RL with Augmented Asset Movement Prediction States

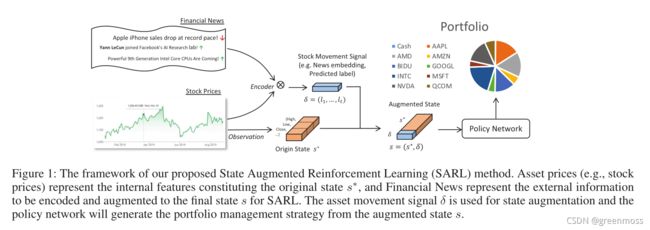

我们将PM问题描述为基于异构数据的决策过程,我们提出了一种分层方法,结合监督学习和RL,并使用标准RL方法对其进行训练,如图1所示。

我们使用end-to-end-network从内部来源(例如,历史价格涨跌的预测标签)或外部来源(例如,新闻)提取资产变动信息。

然后,我们将其与资产价格相结合,即增强后的状态。

最后,我们采用基于 状态增强 的 确定性策略梯度 算法来学习PM策略。

SARL框架可以通过encode进行状态扩充,合并不同的数据源。

Augmented Asset Movement Prediction State

在实际PM方法中,通常将人工设计的特征与资产价格相结合,以更好地预测和重新分配资产。

在SARL框架中,我们已经使其通用化,将异构数据合并到标准RL训练过程中。

如图1所示,我们提出了一种编码器(encode) δ \delta δ,它接受不同类型的数据源,并将其内容转换为资产价格的增量形式,用于训练agent。

例如,编码器可以是一个分类器,将过去某个时期的资产价格作为输入,并预测资产变化,或者它可以是一个从文本分类器派生的特征提取函数,文本分类器根据新闻单词的embedding进行训练,预测资产变化。

s ∗ s^* s∗是与低水平观察相关的可观察状态(即当前资产价格), δ \delta δ是总结高水平观察(根据过去资产价格或新闻预测资产变化)的编码器。

在SARL框架中,我们提供了采用内部或外部信息来增强状态的方法。

对于内部信息,我们使用过去的价格来预测资产的变化,然后将预测结果整合到状态中。

直觉是,在PM问题中,资产价格是最关键的信息。从过去的资产价格中增加资产变化预测,可以提供一些额外的高水平、鲁棒的信息,以改进决策,仅使用原始资产价格进行训练时,这些信息可能不明显或不充分。

具体而言,我们训练了一个LSTM的递归神经网络,来预测资产变化。二进制输出(价格上升/下降)将指导模型选择更好的策略。

对于外部特征,我们收集了与资产相关的金融新闻文章,它们为资产变化预测提供了新的但可能相关的信息。

我们使用不同的自然语言处理(NLP)方法作为编码器来embed新闻,然后将embedding信息反馈到 hierarchical attention network(HAN)中,以训练二元分类器来预测价格变动。

softmax层之前的最后一层,用于提取新闻特征。

最后,我们将embedding加入到状态中进行扩充。

状态增强RL的一个优点是,通过编码器合并异构数据源是通用的,并且状态增强与标准RL训练算法兼容。

从实验部分可以明显看出,使用内部或外部信息进行状态增强确实可以显著提高PM的性能。

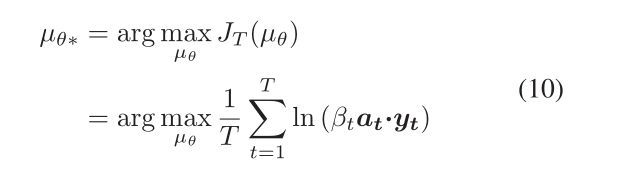

Deterministic Policy Gradient(DPG)

确定性策略梯度(DPG)利用深度神经网络学习确定性目标策略,输入state,输出action。

策略梯度通过参数概率分布 π θ ( a ∣ s ) = P ( a ∣ s ; θ ) \pi_\theta(a|s)=P(a|s; \theta) πθ(a∣s)=P(a∣s;θ)表示策略,根据参数向量θ,从状态s的动作空间中选择动作a。对于确定性策略 a = μ θ ( s ) a=\mu_\theta(s) a=μθ(s),根据state产生确定的策略。

回报 r t γ r_t^\gamma rtγ 定义为:从时间 t 开始的total discounted reward;

![]()

其中r是reward函数,γ是折扣因子,其中0<γ<1。

Action and Reward for Portfolio Optimization

Action:

需要调整权重 w ( t + 1 ) w(t+1) w(t+1),重新分配资产。在时间t,action向量为重新分配的权重: a t = [ a ( 0 , t ) , a ( 1 , t ) , . . . , a ( n , t ) ] T a_t=[a(0,t), a(1, t), ... , a(n,t)]^T at=[a(0,t),a(1,t),...,a(n,t)]T,且 ∑ i n a ( i , t ) = 1 \sum_i^na(i,t)=1 ∑ina(i,t)=1

在时间t采取行动,资产配置将受到价格变动 y t y_t yt 的影响:

Reward:

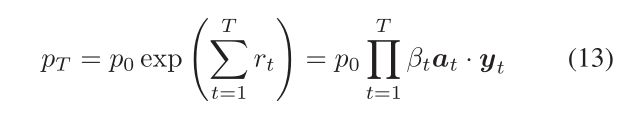

每个时间 t 的reward函数可以根据agent的利润定义。每项资产的价值波动为 a ( t , i ) y ( t , i ) a(t,i)y(t,i) a(t,i)y(t,i)。因此,时间 t 的总利润为 a t y t a_ty_t atyt.

交易花费:

![]()

为了便于微分:

![]()

佣金率保持不变:

reward函数:

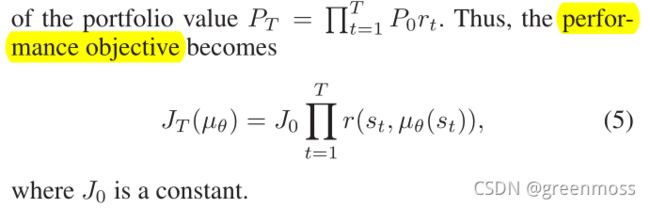

最优策略:

Experimental Results

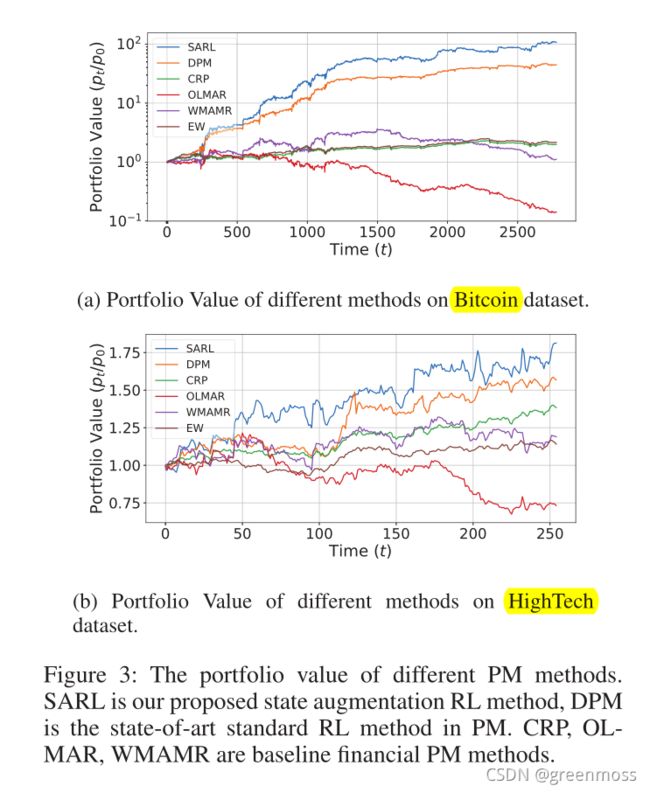

在本节中,我们将在两个数据集(比特币和高科技)上比较SARL与其他方法的性能。

Datasets

比特币:

包含2015-06-30至2017-0630年间10种不同加密货币的价格。对于每一种加密货币,我们有35089个数据点,代表半小时内记录的价格。按时间顺序将数据集分为训练(32313个数据点)和测试(2776个数据点)两部分。

高科技:

包括2006-10-20至2013-1120年间的每日收盘资产价格和财务新闻。

即使我们选择了新闻尽可能多的公司,图2中所选公司的新闻文章分布情况也表明,我们无法获得特定公司的日常新闻。

为了有足够的外部信息来证明在真实市场中使用状态增强的合理性,我们从数据集中选择了9家新闻最多的公司。

通过公司名称匹配筛选的9只股票共有4810篇相关文章。这些新闻文章共覆盖了72.48%(1293/1784)的交易日。

我们将数据集按时间顺序分为1529天用于训练,255天用于测试。

Evaluation Metrics

Baselines

- CRP:持续再平衡投资组合(Cover 2011),它每天在一组资产之间保持相同的财富分配。也就是说,每天开始时,某一特定资产占总财富的比例是相同的。

- OLMAR:在线移动平均回归(Li和Hoi 2012)是一种利用移动平均回归克服单周期平均回归假设局限性的方法。

- WMAMR:加权移动平均回归(Gao和Zhang 2013)是一种利用等权移动平均充分利用过去时期的价格相关性,然后通过在线学习技术学习投资组合的方法;

- EW:“等权重”是一个简单的基线,agent统一投资所有股票。EW的趋势可以反映市场的宏观走势。

- DPM:Deep Portfolio Management(Jiang、Xu、Liang 2017)是一种基于相同独立评估者(EIIE)拓扑集成的方法。DPM使用资产价格作为状态,并使用深度神经网络(DNN)近似策略函数训练代理,以评估每个资产在近期的潜在增长,这是PM的最先进的RL算法。

Data Challenge

数据挑战,包括不平衡的数据分布、噪声数据和环境不确定性,这将用于解释不同PM方法的性能变化。

数据分布不均衡——尽管我们已经选择了9家业绩评估新闻最多的公司,但图2显示,财务新闻在各公司之间的分布高度不均衡。例如,苹果的新闻量是百度的33倍。此外,不平衡的新闻分布也会随着时间的推移而发生——不能保证每家公司每天都有一篇相关的新闻文章。更一般地说,并非每个状态st都有其相应的外部特征。

嘈杂的外部数据——由于新闻可以涵盖多个主题,而且只要提及公司名称,我们就会保留一篇新闻文章,而不管上下文如何,因此可能存在大量与投资组合管理无关的冗余和无用信息。为了证明新闻中固有噪声的问题,我们训练了一个文本分类器,分级的attention网络(HAN),采用了三种不同的embedding技术。我们还采用自动短语(Shang et al.2018)进行短语挖掘,并训练随机初始化嵌入网络。股票变化预测的平均训练、测试精度如表1所示,其中最佳训练/测试精度不超过66%/61%,表明收集的新闻中存在噪音信息。

环境不确定性–与具有特定规则的游戏任务不同,PM深受市场动态的影响。如果市场动态发生实质性变化(即分布变化问题),则根据过去市场动态训练的标准RL agent的PM策略可能无法推广到未来市场。我们将使用不同测试时间段的夏普比率来说明环境不确定性的影响。

Results and Discussion

-

Portfolio Value (PV)

在比特币数据集中,我们使用过去30天的先前价格,来训练用于价格上涨/下跌预测的分类器。我们采用了一种基于LSTM的神经网络作为编码器,分类器训练集的准确率为65.08%,测试集的准确率为60.10%。

在高科技数据集中,我们使用与股票相关的金融新闻训练分类器。我们选择Glove作为embedding方法,并使用一个HAN作为编码器,来获得每个新闻的预测股票变化的100维嵌入向量。训练/测试准确率为64.10%、60.99%.

每个数据集分类器的训练和测试的划分遵循上述设置。

在SARL训练中,我们使用过去30天的价格作为标准状态s∗.

在比特币中,我们使用它们的相关预测标签来增强状态。

在高科技中,过去12天的平均新闻嵌入量被用于增强状态。在时间t没有外部来源的情况下,我们令 δ \delta δ为零。

如图3a和3b所示,测试集的PV证明了SARL的有效性。与现有RL算法DPM相比,SARL使PV提高140.9%和15.7%。由于加密货币市场的波动性更大,一个好的agent更容易获得更多的利润。 -

夏普比率

我们在表2和表3中报告了不同时间段的SR。在PM中,由于环境分布的变化,SR通常会随着时间的推移而降低。

尽管SARL的训练目标函数不涉及风险相关概念,但在大多数情况下,SARL的SR最高,表明其学习风险的能力。

此外,与DPM相比,SARL的优势也验证了整合外部数据的重要性,加强了鲁棒性。

-

预测精度与稀疏性研究

在这里,我们使用模拟预测标签作为状态增强,来研究预测准确率和标签密度(每个时间步进行标签预测的频率)对PM的影响。

使用与原始数据集相同的标签密度模式,图4显示,当准确率高于60%时,尽管预测有噪声,但SARL可以学习更好的PM策略。准确度越高,策略越好。此外,我们还模拟了标签密度变化时的稀疏性测试。

图5显示,比特币数据集上的PM性能也得益于更高的标签密度。通过模拟结果,我们可以发现,即使我们只有密度为50%、精度为70%的标签,与DPM相比,投资组合价值仍有90.3%的提高。

这种现象表明,如果我们有高置信度的标签,即使标签稀疏,我们也可以改进PM策略。类似的观察结果也适用于高科技数据集,其中稀疏性测试的数字在补充材料中给出。

-

新闻中的隐性关联

图4中的模拟结果显示,即使在准确率为60%的情况下,与DPM相比,SARL也有相对轻微的改进。

然而,当我们使用金融新闻的嵌入来增强状态时,获得了显著的改进,在测试集上获得了相似的准确率(约为60%)。结果揭示了金融新闻中隐藏的相关性,而不是随机模拟的标签预测。

为了验证SARL可以利用的金融新闻的隐藏相关性,我们使用表1中的不同单词嵌入方法,并在高科技数据集上以相同的模拟训练/测试精度训练SARL进行比较。

图6验证了金融新闻中隐藏相关性的存在。结果表明,在相同的准确度下,在金融新闻上训练的SARL的性能,要比在随机模拟标签上训练的SARL好得多。研究结果也证实了SARL能够从外部信息中学习以提高PM。 -

用不同的RL算法训练SARL

由于我们的SARL框架与标准RL训练兼容,我们采用了不同的RL算法,包括DPG、PPO、PG来验证SARL的通用性。

与DPM相比,不同RL训练方法的大多数SARL变体确实表现出一致的性能提升。