【图像超分辨率重建】——SAN论文精读笔记

2019-Second-order Attention Network for Single Image Super-Resolution(SAN)

基本信息

作者: Tao Dai, Jianrui Cai, Yongbing Zhang, Shu-Tao Xia,Lei Zhang

期刊: CVPR

引用:

摘要: 近年来,深度卷积神经网络(CNN)在单图像超分辨率(SISR)中得到了广泛的研究,并取得了显著的性能。然而,大多数现有的基于CNN的SISR方法主要侧重于更广泛或更深入的架构设计,而忽略了中间层的特征相关性,因此阻碍了CNN的代表能力。为了解决这个问题,在本文中,我们提出了一种二阶注意力网络(SAN),用于更强大的特征表达和特征相关性学习。具体而言,开发了一种新的可训练二阶信道注意(SOCA)模块,通过使用二阶特征统计来自适应地重新调整信道方向特征,以获得更具鉴别性的表示。此外,我们提出了一种非局部增强的残差组(NLRG)结构,它不仅结合了非局部操作来捕获长距离空间上下文信息,还包含重复的局部源残差注意组(LSRAG)来学习日益抽象的特征表示。实验结果表明,在定量度量和视觉质量方面,我们的SAN网络优于最先进的SISR方法。

1.简介

介绍了单幅图像超分辨的发展大致过程(插值、基于示例、CNN等),目前基于CNN的SR具有的限制如下:

- 大多数基于CNN的图像SR方法没有充分利用原始LR图像的信息,从而导致相对较低的性能

- 大多数现有的基于CNN的SR模型主要集中于设计更深或更宽的网络,以学习更具鉴别性的高级特征,而很少利用中间层的固有特征相关性,从而阻碍了CNN的表示能力

本文的贡献:

- 提出了一种用于精确图像SR的深度二阶注意力网络(SAN)。在公共数据集上的大量实验表明,在定量和视觉质量方面,我们的SAN优于最先进的方法。

- 提出了二阶通道注意(SOCA)机制,通过考虑高于一阶的特征统计,自适应地重新调整特征。这种SOCA机制允许我们的网络关注更多信息特征,并增强辨别学习能力。此外,我们还利用协方差归一化的迭代方法来加快网络的训练。

- 提出了非本地增强残差组(NLRG)结构来构建深度网络,该结构进一步结合了非本地操作来捕获空间上下文信息,并共享源残差组结构来学习深度特征。此外,通过共享源跳过连接的共享源剩余组结构可以允许绕过来自LR输入的更丰富的信息,并简化深度网络的训练。

2.相关工作

- 基于CNN的SR模型:SRCNN、VDSR、DRCN、EDSR、MemNet、RDN、NLRN、RCAN等

- 注意力机制:视频分类、图像分类(SENet)等领域应用广泛

SENet引入SR领域(RDN网络),并取得很好的效果,但是只使用了一阶,阻碍了网络的辨别能力,本文将一阶拓展为二阶,提出了SAN。

3.SAN网络

3.1.网络结构

浅层特征提取——基于非局部增强残差组(NLRG)的深度特征提取——上采样模块——重建模块

3.2.非本地增强残差组(NLRG)

- NLRG:非本地增强残差组。

- SSRG:共享源残差组。

- RL-NL:区域级非本地模块,改进自全局非本地模块。利用LR特征中的丰富结构线索(前)与在HR自然场景中的自相似性(后)

- LSRAG:本地残余注意力组,由残差块和SOCA组成。

- SOCA:二阶通道注意力。学习通过考虑特征的二阶统计来自适应地重新缩放信道特征。

3.3.二阶通道注意力(SOCA)

以前大多数基于CNN的SR模型都没有考虑功能的相互依赖性。为了利用这些信息,在CNN中引入了SENet,以重新缩放图像SR的信道特征。然而,SENet仅通过全局平均池利用特征的一阶统计,而忽略高于一阶的统计,从而阻碍了网络的辨别能力。另一方面,最近的研究表明,深度神经网络中的二阶统计量比一阶统计量更有助于更具鉴别性的表示。

- 协方差归一化

- 通道注意力

3.4.协方差归一化加速

3.5.实施

LSRAG共20个,头尾各有一个RL-NL模块,每个LSRAG中有10个残差块,SOCA中使用1x1卷积,缩减比为16,上采样使用亚像素卷积。

3.6.讨论

- 与NLRN的不同:NLRN引入了非局部操作,以在图像恢复中捕获长距离空间上下文信息。NLRN和我们的SAN之间存在一些差异。首先,NLRN在用于图像恢复的递归神经网络(RNN)中嵌入了非局部操作,而我们的SAN在用于图像SR的深度卷积神经网络(CNN)框架中结合了非局部运算。其次,NLRN只考虑每个位置与其邻域之间的空间特征相关性,而忽略了信道方向的特征相关性。而我们的SAN主要侧重于学习这种具有二阶特征统计的通道式特征相关性,以获得更强大的表示能力。

- 与RDN的不同:第一个是基本块的设计。 RDN主要是利用局部残差学习将密集块与局部特征融合相结合,而我们的SAN是建立在残差块的基础上的。第二个是增强网络判别能力的方法。通道注意力已被证明对于更好的判别表示是有效的。然而,RDN 不考虑这些信息,而是注意利用所有卷积层的层次特征。相反,我们的 SAN 严重依赖通道注意力来获得更好的判别表示。因此,我们提出了二阶通道注意(SOCA)机制来有效地学习通道特征的相互依赖性。

- 与RCAN的不同:首先,RCAN 由几个具有长跳跃连接的残差组组成。而SAN通过share-source skip connections堆叠重复的residual groups,可以绕过更丰富的低频信息。其次,RCAN 只能利用局部感受野中的上下文信息,而无法利用局部区域之外的信息。而 SAN 可以通过结合非局部操作来缓解这个问题,不仅可以捕获远距离空间上下文信息,还可以扩大感受野。第三,为了增强网络的判别能力,RCAN 仅通过全局平均池化考虑基于通道注意力的一阶特征统计。而我们的 SAN 基于二阶特征统计学习通道注意力。

4.实验

4.1.实验配置

- 训练集:DIV2K(0-800)

- 测试集:Set5、Set14、BSD100、Urban100、Manga109

- 退化模型:BI、BD

- 评价参数:PSNR、SSIM(通过YCbCr评价)

- 数据增强:随机旋转90、180、270、水平翻转

- 其他:Patch=48x48…

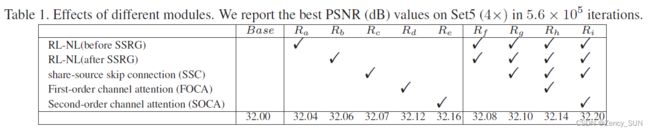

4.2消融性研究

4.3.BI退化验证结果

Bicubic,SRCNN, FSRCNN , VDSR , LapSRN, Mem-Net, EDSR, SRMD, NLRN, DBPN,RDN and RCAN.

在2,3,4倍情况下在验证集上可以获得非常不错的结果,部分情况比RCAN稍差

4.4.BD退化验证结果

Bicubic,SPMSR,SRCNN, FSRCNN , IRCNN, SRMD,RDN and RCAN.

在3倍情况下在验证集上可以获得非常不错的结果,全部达到SOTA.

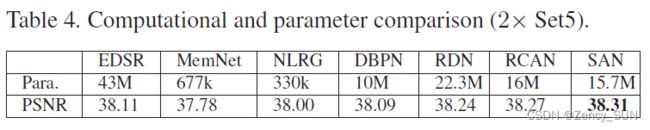

4.5.模型尺寸分析

MemNet 和 NLRG 以性能下降为代价包含更少的参数。相反,我们的 SAN 具有比 RDN 和 RCAN 更少的参数,但获得了更高的性能,这意味着我们的 SAN 可以在性能和模型复杂性之间进行良好的权衡

5.结论

我们提出了一个用于准确图像 SR 的深度二阶注意力网络 (SAN)。具体来说,非局部增强残差组 (NLRG) 结构允许 SAN 通过在网络中嵌入非局部操作来捕获长距离依赖关系和结构信息。同时,NLRG 允许通过共享源跳过连接绕过 LR 图像中丰富的低频信息。除了利用空间特征相关性之外,我们还提出了二阶通道注意 (SOCA) 模块,通过全局协方差池来学习特征相互依赖性,以获得更具辨别力的表示。使用 BI 和 BD 退化模型对 SR 进行的广泛实验显示了我们的 SAN 在定量和视觉结果方面的有效性。

代码实现

https://github.com/daitao/SAN

个人总结

- 基于注意力机制的图像超分辨,效果优于RCAN