YOLOv5 自学笔记(持续更新)

本文为自学笔记,文中内容大部分为其他博客内容,如有侵权可删。

目录

1 YOLOv5 五种网络模型

1.1 YOLOv5 网络结构图

1.2 两个版本的区别

2 YOLOv5-6.x 版本核心基础内容

2.1 输入端

2.2 Backbone

2.2.1 四种结构的参数

2.2.2 网络深度

2.2.3 Neck

2.2.4 输出端

1 YOLOv5 五种网络模型

在YOLOv5官方代码中,给出的目标检测网络中一共有5个版本,分别是YOLOv5n6、YOLOv5s6、YOLOv5l6、YOLOv5x6五个模型。

YOLOv5开源代码链接:https://github.com/ultralytics/yolov5

1.1 YOLOv5 网络结构图

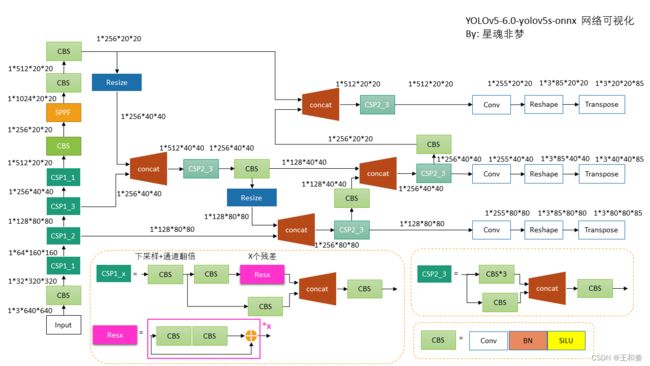

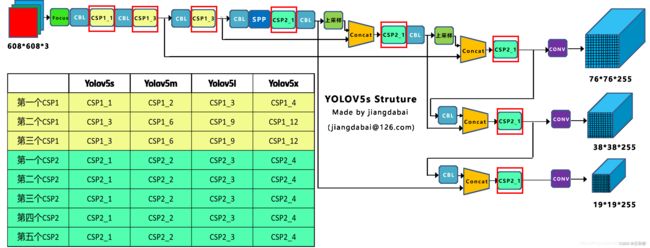

YOLOv5-6.x版本。YOLOv5s6 整体网络结构图。 YOLOv5s6 其余的四个模型只是在该模型的基础上在深度和宽度上进行增减。

YOLOv5-5.x版本。在6.0版本相较于5.0版本多了YOLOv5n6模型,该模型为更加轻量级模型。

1.2 两个版本的区别

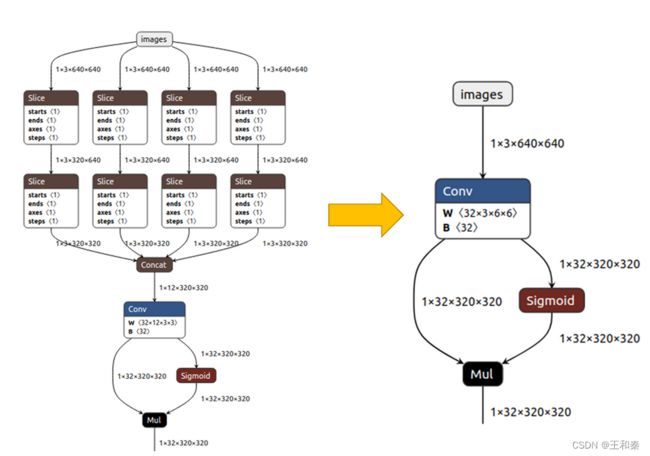

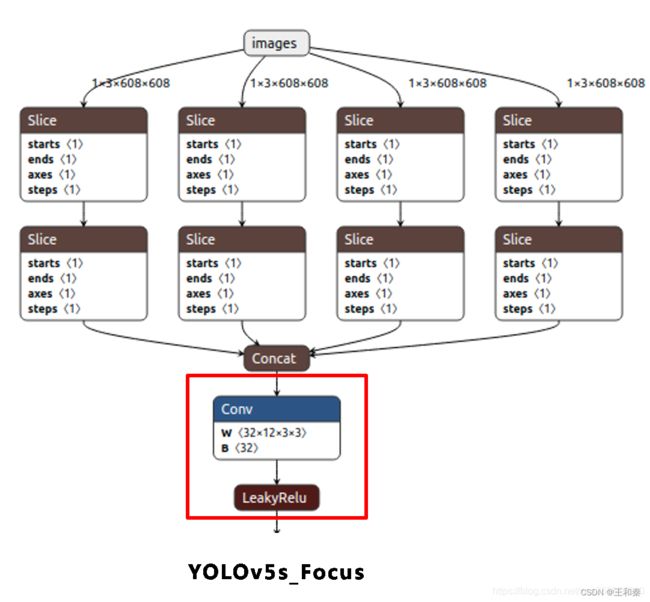

(1)切片操作

6.x 版本将focus模块替换成Conv(k=6, s=2, p=2)。

(2)基础模块结构的区别

6.x 版本:基础模块CBS

5.0版本:基础模块CBL

两个版本的基础模块的区别主要在于激活函数的不同。

Leaky ReLU的提出就是为了解决神经元“死亡”问题,Leaky ReLU与ReLU很相似,仅在输入小于0的部分有差别,ReLU输入小于0的部分值都为0,而LeakyReLU输入小于0的部分,值为负,且有微小的梯度。公式为

使用Leaky ReLU作为激活函数的优点就是在反向传播过程中也可以计算输入小于零部分的梯度,而不是像ReLU激活函数对于输入小于零部分的计算得到的梯度值为0,这样就避免了梯度方向锯齿问题。

SiLU/Swish 的优点:

- 是通过NAS搜索得到的,其取值范围是[-0.278, +∞),且平滑、非单调;

- Swish 在深层模型上的效果优于 ReLU。例如,仅仅使用 Swish 单元替换 ReLU 就能把 Mobile NASNetA 在 ImageNet 上的 top-1 分类准确率提高 0.9%,Inception-ResNet-v 的分类准确率提高 0.6%。

缺点:计算量大

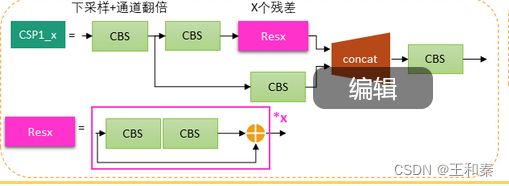

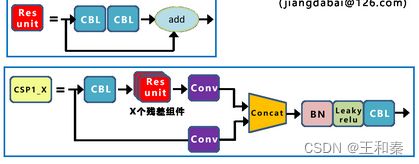

(3) CSP1_x和Resx模块的区别

6.x 版本

5.x 版本

从上面两个图可以看出,Resx模块的区别主要在于基础模块的不同。

CSP1_x模块区别:

- 基础模块的不同,6.x版本多加了一个CBS

- 6.x版本将5.x版本的Conv全部换成CBS模块

- 6.x版本的concat之后接的是CBS,而5.x的concat后接的是BN,Leaky relu,CBL

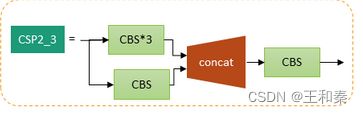

(4)CSP2_x 模块的区别

6.x版本:

5.x版本:

6.x版本的CSP2_x 模块将5.x版本的CBL和Conv都换成了CBS,concat后面直接CBS。

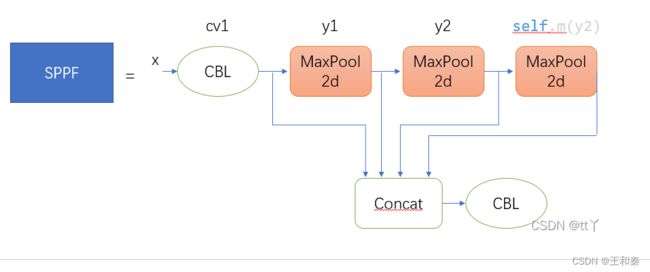

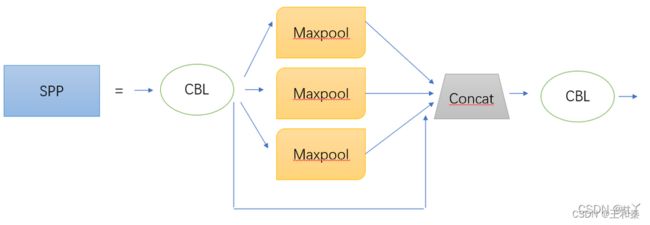

(5)SPP和SPPF

6.x版本使用的是SPPF,是一个串联的结构,在官方代码里池化窗口大小为5*5。

SPPF相较于SPP的优点:

- 降低重复计算量

- 计算速度快

图里的CBL应换成CBS

5.x版本使用的是SPP。一个并联的操作,池化窗口大小为1*1,5*5,9*9,13*13

2 YOLOv5-6.x 版本核心基础内容

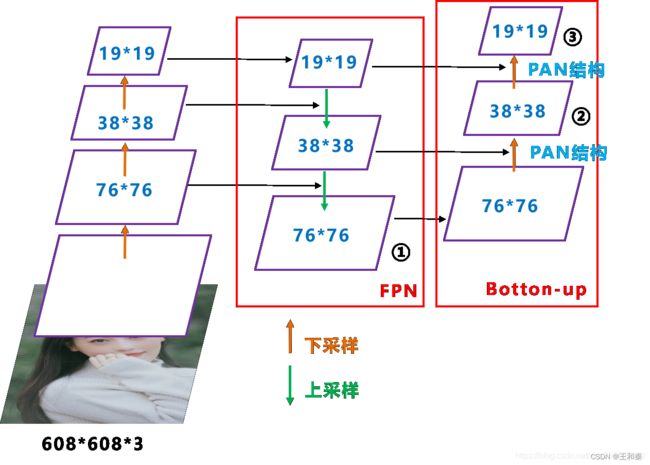

上图即YOLOv5-6.x版本的网络结构图,可以看出还是分为输入端、Backbone、Neck、Prediction四个部分

- 输入端:Mosaic数据增强、自适应锚框计算

- Backbone:SPPF,CSP结构

- Neck:FPN+PAN结构

- prdoction:GIOU_loss

2.1 输入端

(1) Mosaic数据增强

Mosaic数据增强提出的作者也是来自Yolov5团队的成员,不过,随机缩放、随机裁剪、随机排布的方式进行拼接,对于小目标的检测效果还是很不错的。

推荐链接:https://blog.csdn.net/nan355655600/article/details/106246625

主要有几个优点:

- a. 丰富数据集:随机使用4张图片,随机缩放,再随机分布进行拼接,大大丰富了检测数据集,特别是随机缩放增加了很多小目标,让网络的鲁棒性更好。

- b. 减少GPU:可能会有人说,随机缩放,普通的数据增强也可以做,但作者考虑到很多人可能只有一个GPU。

- 因此Mosaic增强训练时,可以直接计算4张图片的数据,使得Mini-batch大小并不需要很大,一个GPU就可以达到比较好的效果。

(2)自适应锚框计算

在Yolo算法中,针对不同的数据集,都会有初始设定长宽的锚框。

在网络训练中,网络在初始锚框的基础上输出预测框,进而和真实框groundtruth进行比对,计算两者差距,再反向更新,迭代网络参数。

因此初始锚框也是比较重要的一部分,比如Yolov5在Coco数据集上初始设定的锚框:

但Yolov5中将此功能嵌入到代码中,每次训练时,自适应的计算不同训练集中的最佳锚框值。

当然,如果觉得计算的锚框效果不是很好,也可以在代码中将自动计算锚框功能关闭。![]()

控制的代码即train.py中上面一行代码,设置成False,每次训练时,不会自动计算。

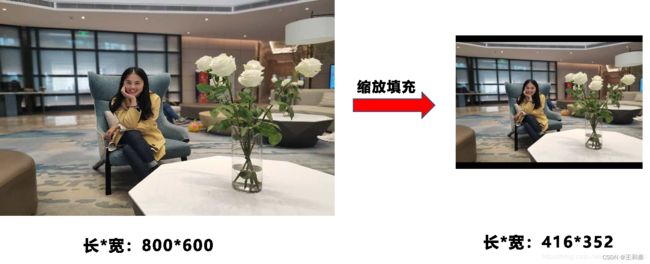

(3)自适应图片缩放

在常用的目标检测算法中,不同的图片长宽都不相同,因此常用的方式是将原始图片统一缩放到一个标准尺寸,再送入检测网络中。

比如Yolo算法中常用416×416,608×608等尺寸,比如对下面800*600的图像进行变换。

在YOLOv5算法中常用的是640x640,1280x1280

但Yolov5代码中对此进行了改进,也是Yolov5推理速度能够很快的一个不错的trick。

作者认为,在项目实际使用时,很多图片的长宽比不同。

因此缩放填充后,两端的黑边大小都不同,而如果填充的比较多,则存在信息冗余,影响推理速度。

因此在Yolov5代码中datasets.py的letterbox函数中进行了修改,对原始图像自适应的添加最少的黑边。

缩放后应该是416*320

图像高度上两端的黑边变少了,在推理时,计算量也会减少,即目标检测速度会得到提升。

第一步:计算缩放比例

原始缩放尺寸是416×416,都除以原始图像的尺寸后,可以得到0.52,和0.69两个缩放系数,选择小的缩放系数0.52。

第二步:计算缩放后的尺寸

原始图片的长宽都乘以最小的缩放系数0.52,宽变成了416,而高变成了312。

第三步:计算黑边填充数值

将416-312=104,得到原本需要填充的高度。再采用numpy中np.mod取余数的方式,得到8个像素,再除以2,即得到图片高度两端需要填充的数值。

此外,需要注意的是:

- a.这里大白填充的是黑色,即(0,0,0),而Yolov5中填充的是灰色,即(114,114,114),都是一样的效果。

- b.训练时没有采用缩减黑边的方式,还是采用传统填充的方式,即缩放到416×416大小。

- 只是在测试,使用模型推理时,才采用缩减黑边的方式,提高目标检测,推理的速度。

- c.为什么np.mod函数的后面用32?因为Yolov5的网络经过5次下采样,而2的5次方,等于32。所以至少要去掉32的倍数,再进行取余。

2.2 Backbone

前面已经介绍了,CBS、CSP、SPPF等模块,这里就不在进行叙述。

以下YOLOv5-5.x版本为例子,介绍一下四种网络结构。当然YOLOv5-6.x版本同样适用,没有什么不同。

参考链接:深入浅出Yolo系列之Yolov5核心基础知识完整讲解_江大白*的博客-CSDN博客_yolov5

2.2.1 四种结构的参数

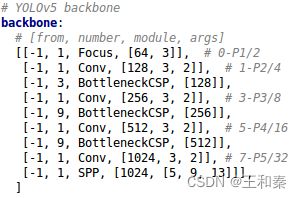

(1)Yolov5s.yaml

(2)Yolov5m.yaml

(3)Yolov5l.yaml

(4)Yolov5x.yaml

![]()

四种结构就是通过上面的两个参数,来进行控制网络的深度和宽度。其中depth_multiple控制网络的深度,width_multiple控制网络的宽度。

2.2.2 网络深度

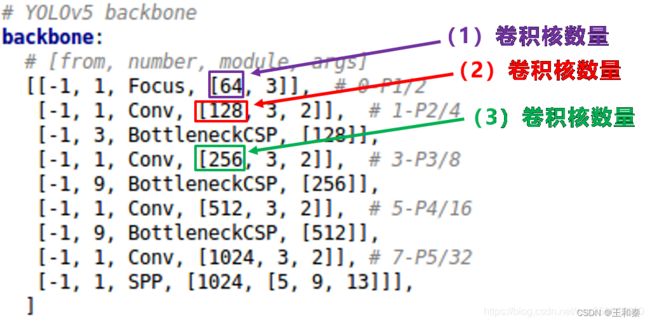

四种结构的yaml文件中,下方的网络架构代码都是一样的。

为了便于讲解,大白将其中的Backbon部分提取出来,讲解如何控制网络的宽度和深度,yaml文件中的Head部分也是同样的原理。

在对网络结构进行解析时,yolo.py中下方的这一行代码将四种结构的depth_multiple,width_multiple提取出,赋值给gd,gw。后面主要对这gd,gw这两个参数进行讲解。![]()

(1)不同网络的深度

在上图中,画了两种CSP结构,CSP1和CSP2,其中CSP1结构主要应用于Backbone中,CSP2结构主要应用于Neck中。

需要注意的是,四种网络结构中每个CSP结构的深度都是不同的。

- a. 以Yolov5s为例,第一个CSP1中,使用了1个残差组件,因此是CSP1_1。而在Yolov5m中,则增加了网络的深度,在第一个CSP1中,使用了2个残差组件,因此是CSP1_2。而Yolov5l中,同样的位置,则使用了3个残差组件,Yolov5x中,使用了4个残差组件其余的第二个CSP1和第三个CSP1也是同样的原理。

- b. 在第二种CSP2结构中也是同样的方式,以第一个CSP2结构为例。Yolov5s组件中使用了2×X=2×1=2个卷积,因为X=1,所以使用了1组卷积,因此是CSP2_1。而Yolov5m中使用了2组,Yolov5l中使用了3组,Yolov5x中使用了4组。其他的四个CSP2结构,也是同理。

Yolov5中,网络的不断加深,也在不断增加网络特征提取和特征融合的能力。

(2)控制深度的代码

控制四种网络结构的核心代码是yolo.py中下面的代码,存在两个变量,n和gd。

我们再将n和gd带入计算,看每种网络的变化结果。

![]()

(3)验证控制深度的有效性

我们选择最小的yolov5s.yaml和中间的yolov5l.yaml两个网络结构,将gd(height_multiple)系数带入,看是否正确。

a. yolov5s.yaml

其中depth_multiple=0.33,即gd=0.33,而n则由上面红色框中的信息获得。

以上面网络框图中的第一个CSP1为例,即上面的第一个红色框。n等于第二个数值3。

而gd=0.33,带入(2)中的计算代码,结果n=1。因此第一个CSP1结构内只有1个残差组件,即CSP1_1。

第二个CSP1结构中,n等于第二个数值9,而gd=0.33,带入(2)中计算,结果n=3,因此第二个CSP1结构中有3个残差组件,即CSP1_3。

第三个CSP1结构也是同理,这里不多说。

b. yolov5l.xml

其中depth_multiple=1,即gd=1

和上面的计算方式相同,第一个CSP1结构中,n=3,带入代码中,结果n=3,因此为CSP1_3。

下面第二个CSP1结构和第三个CSP1结构都是同样的原理。

2.2.3 网络的宽度

(1)不同网络的宽度

如上图表格中所示,四种Yolov5结构在不同阶段的卷积核的数量都是不一样的。

因此也直接影响卷积后特征图的第三维度,即厚度,大白这里表示为网络的宽度。

a. 以Yolov5s结构为例,第一个Focus结构中,最后卷积操作时,卷积核的数量是32个,因此经过Focus结构,特征图的大小变成304×304×32。

而Yolov5m的Focus结构中的卷积操作使用了48个卷积核,因此Focus结构后的特征图变成304×304×48。Yolov5l,Yolov5x也是同样的原理。

b. 第二个卷积操作时,Yolov5s使用了64个卷积核,因此得到的特征图是152×152×64。而Yolov5m使用96个特征图,因此得到的特征图是152×152×96。Yolov5l,Yolov5x也是同理。

c. 后面三个卷积下采样操作也是同样的原理,这样大白不过多讲解。

四种不同结构的卷积核的数量不同,这也直接影响网络中比如CSP1结构,CSP2等结构,以及各个普通卷积,卷积操作时的卷积核数量也同步在调整,影响整体网络的计算量。

大家最好可以将结构图和前面第一部分四个网络的特征图链接,对应查看,思路会更加清晰。

当然卷积核的数量越多,特征图的厚度,即宽度越宽,网络提取特征的学习能力也越强。

(2)控制宽度的代码

在Yolov5的代码中,控制宽度的核心代码是yolo.py文件里面的这一行:

![]()

它所调用的子函数make_divisible的功能是:

(3)验证控制宽度的有效性

我们还是选择最小的Yolov5s和中间的Yolov5l两个网络结构,将width_multiple系数带入,看是否正确。

a. yolov5s.yaml

其中width_multiple=0.5,即gw=0.5。

以第一个卷积下采样为例,即Focus结构中下面的卷积操作。

按照上面Backbone的信息,我们知道Focus中,标准的c2=64,而gw=0.5,代入(2)中的计算公式,最后的结果=32。即Yolov5s的Focus结构中,卷积下采样操作的卷积核数量为32个。

再计算后面的第二个卷积下采样操作,标准c2的值=128,gw=0.5,代入(2)中公式,最后的结果=64,也是正确的。

b. yolov5l.yaml

其中width_multiple=1,即gw=1,而标准的c2=64,代入上面(2)的计算公式中,可以得到Yolov5l的Focus结构中,卷积下采样操作的卷积核的数量为64个,而第二个卷积下采样的卷积核数量是128个。

2.2.3 Neck

参考链接:深入浅出Yolo系列之Yolov3&Yolov4&Yolov5&Yolox核心基础知识完整讲解_江大白*的博客-CSDN博客_大白的 yolo 系列

Yolov5现在的Neck和Yolov4中一样,都采用FPN+PAN的结构,但在Yolov5刚出来时,只使用了FPN结构,后面才增加了PAN结构,此外网络中其他部分也进行了调整。

2.2.4 输出端

(1)Bounding box损失函数

1 CIOU_loss

目标检测任务的损失函数一般由Classificition Loss(分类损失函数)和Bounding Box Regeression Loss(回归损失函数)两部分构成。

Bounding Box Regeression的Loss近些年的发展过程是:Smooth L1 Loss-> IoU Loss(2016)-> GIoU Loss(2019)-> DIoU Loss(2020)->CIoU Loss(2020)

我们从最常用的IOU_Loss开始,进行对比拆解分析,看下Yolov5为啥要选择CIOU_Loss。

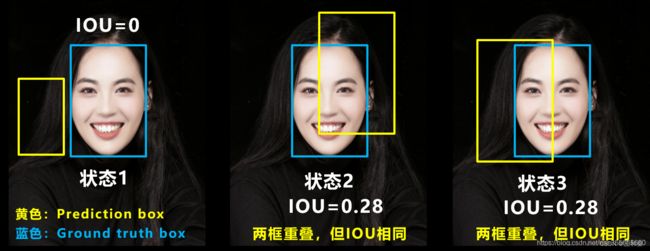

a. IOU_loss

可以看到IOU的loss其实很简单,主要是交集/并集,但其实也存在两个问题。

问题1:即状态1的情况,当预测框和目标框不相交时,IOU=0,无法反应两个框距离的远近,此时损失函数不可导,IOU_Loss无法优化两个框不相交的情况。

问题2:即状态2和状态3的情况,当两个预测框大小相同,两个IOU也相同,IOU_Loss无法区分两者相交情况的不同。

因此2019年出现了GIOU_Loss来进行改进。

可以看到右图GIOU_Loss中,增加了相交尺度的衡量方式,缓解了单纯IOU_Loss时的尴尬。

但为什么仅仅说缓解呢?因为还存在一种不足:

问题:状态1、2、3都是预测框在目标框内部且预测框大小一致的情况,这时预测框和目标框的差集都是相同的,因此这三种状态的GIOU值也都是相同的,这时GIOU退化成了IOU,无法区分相对位置关系。

基于这个问题,2020年的AAAI又提出了DIOU_Loss。

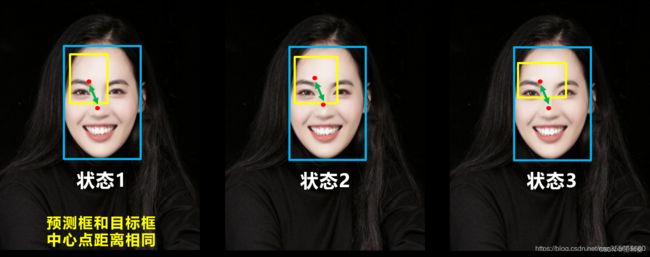

c. DIOU_loss

好的目标框回归函数应该考虑三个重要几何因素:重叠面积、中心点距离,长宽比。

针对IOU和GIOU存在的问题,作者从两个方面进行考虑

一:如何最小化预测框和目标框之间的归一化距离?

二:如何在预测框和目标框重叠时,回归的更准确?

针对第一个问题,提出了DIOU_Loss(Distance_IOU_Loss)

DIOU_Loss考虑了重叠面积和中心点距离,当目标框包裹预测框的时候,直接度量2个框的距离,因此DIOU_Loss收敛的更快。

但就像前面好的目标框回归函数所说的,这时并没有考虑到长宽比。

问题:比如上面三种状态,目标框包裹预测框,本来DIOU_Loss可以起作用。

但预测框的中心点的位置都是一样的,因此按照DIOU_Loss的计算公式,三者的值都是相同的。

针对这个问题,又提出了CIOU_Loss,不对不说,科学总是在解决问题中,不断进步!!

d. CIOU_loss

CIOU_Loss和DIOU_Loss前面的公式都是一样的,不过在此基础上还增加了一个影响因子,将预测框和目标框的长宽比都考虑了进去。

其中v是衡量长宽比一致性的参数,我们也可以定义为:

![]()

这样CIOU_Loss就将目标框回归函数应该考虑三个重要几何因素:重叠面积、中心点距离,长宽比全都考虑进去了。

再来综合的看下各个Loss函数的不同点:

IOU_Loss:主要考虑检测框和目标框重叠面积。

GIOU_Loss:在IOU的基础上,解决边界框不重合时的问题。

DIOU_Loss:在IOU和GIOU的基础上,考虑边界框中心点距离的信息。

CIOU_Loss:在DIOU的基础上,考虑边界框宽高比的尺度信息。

Yolov5中采用了CIOU_Loss的回归方式,使得预测框回归的速度和精度更高一些。

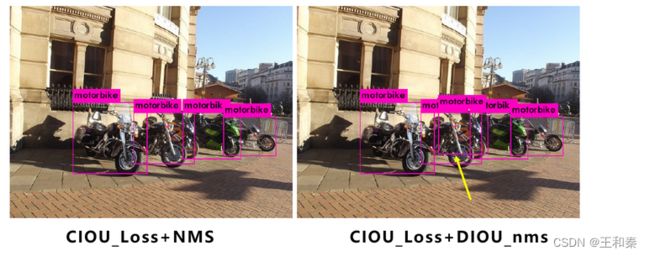

(2)DIOU_nms

nms主要用于预测框的筛选,常用的目标检测算法中,一般采用普通的nms的方式

将其中计算IOU的部分替换成DIOU的方式:

再来看下实际的案例:

在上图重叠的摩托车检测中,中间的摩托车因为考虑边界框中心点的位置信息,也可以回归出来。

因此在重叠目标的检测中,DIOU_nms的效果优于传统的nms。

注意:这里为什么不用CIOU_nms,而用DIOU_nms?

答:因为前面讲到的CIOU_loss,实在DIOU_loss的基础上,添加的影响因子,包含groundtruth标注框的信息,在训练时用于回归。

但在测试过程中,并没有groundtruth的信息,不用考虑影响因子,因此直接用DIOU_nms即可。

参考链接:

深入浅出Yolo系列之Yolov5核心基础知识完整讲解_江大白*的博客-CSDN博客_yolov5

【YOLOV5-6.x讲解】YOLO5.0VS6.0版本对比+模型设计_LiBiGo的博客-CSDN博客_yolov5 6.0改进【目标检测-YOLO】YOLOv5-v6.0-网络架构详解(第二篇)_理心炼丹的博客-CSDN博客_yolov5 6.0【YOLOV5-6.x讲解】YOLO5.0VS6.0版本对比+模型设计_LiBiGo的博客-CSDN博客_yolov5 6.0改进

深度学习常见的激活函数汇总(sigmoid/tanh/ReLU/Leaky ReLU/Swish/GeLU) - 知乎

YOLOv5中的SPP/SPPF结构详解_tt丫的博客-CSDN博客_sppf

深入浅出Yolo系列之Yolov3&Yolov4&Yolov5&Yolox核心基础知识完整讲解_江大白*的博客-CSDN博客_大白的 yolo 系列