C#联合Openvino实现PP-TinyPose检测

1、配置好paddlepaddle环境,详见PaddleDetection环境搭建测试

2、下载PaddleDetection源码,并配置好PaddleDetection环境,测试paddle运行正常

3、下载vs2019或vs2022

4、下载cmake,https://cmake.org/download/

5、安装opencv,https://opencv.org/releases/

6、以上这些都是构建项目的必须组件,现在开始openvino的安装

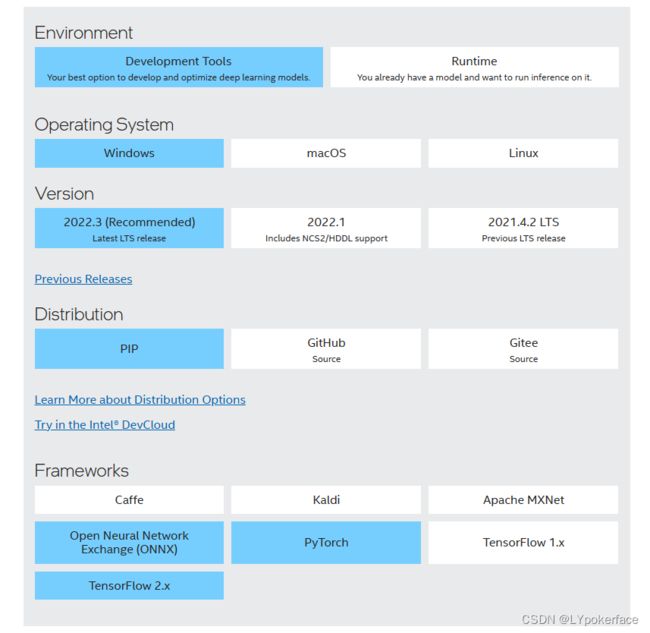

python下使用就直接PIP安装,安装Development Tools版本,如果是C++使用就安装runtime离线版本,后面C++内配置openvino需要用到runtime版本的dll和lib:

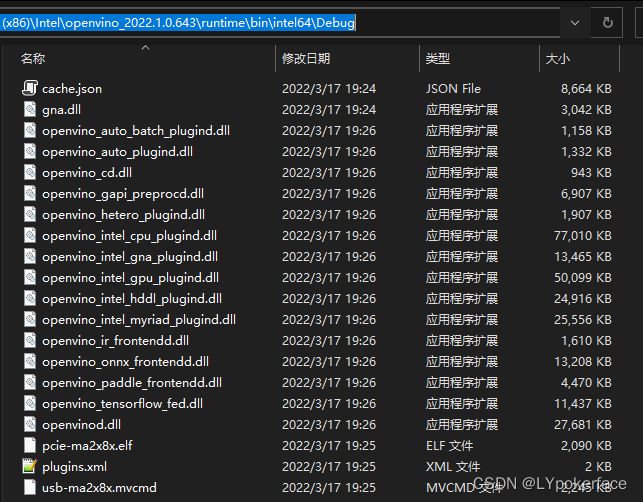

安装完成后,可以看到在C:\Program Files (x86)\Intel\openvino_2022.1.0.643文件夹中已经有相关的文件,python也可以把离线包内的Python包拷贝到conda环境使用,但建议还是直接Pip方便

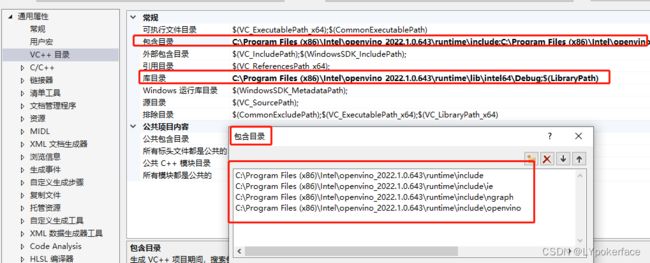

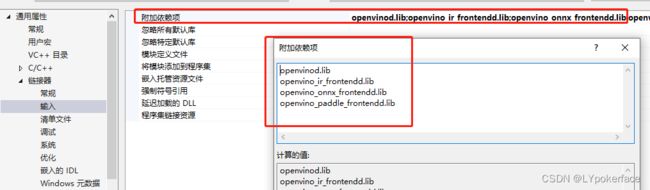

7、在vs内配置好opencv和openvino的库,都一样配置好三个地方就行,用属性表配置方便,用release还是debug版本根据需要选择就行:

包含目录、库目录、附加依赖项

openvino:

opencv:

8.增加OpenVinoAPI.cpp文件,代码引用自https://mp.weixin.qq.com/s/gOoeMPeAcvMSeGVqToKWuQ

// OpenVINO C++ dll code for C#

// 该项目支持模型格式:

// 1. paddlepaddle飞桨模型(.pdmodel)

// 2. onnx中间格式(.onnx)

// 3. OpenVINO的IR格式(.xml)

// 针对该项目所使用测试网络:

// 1. PaddleClas 图像分类模型 花卉种类识别网络的(.pdmodel)、(.onnx)、(.xml)格式;

// 2. Paddledetection 目标检测模型 车辆识别网络的(.pdmodel)格式;

// ONLY support batchsize = 1

#include