220609_Efficient Uncertainty-aware Decision-making for Automated Driving Using Guided Branching

0、摘要

1)提出了一个有效的不确定性感知决策 (EUDM) 框架

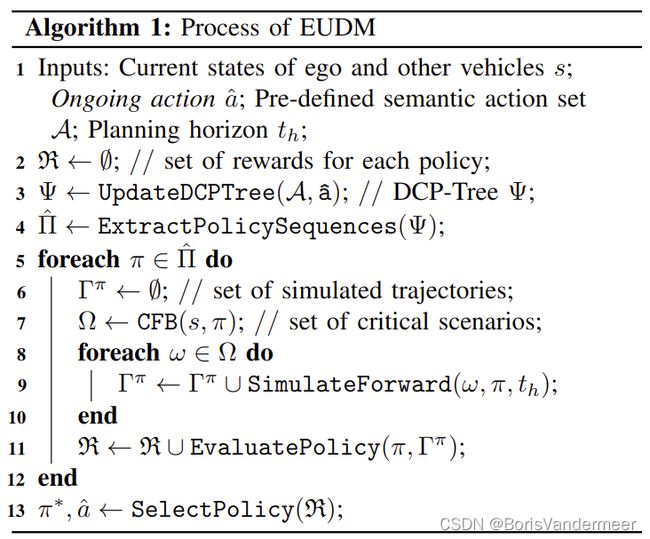

该框架在复杂的驾驶环境中实时生成长期的横向和纵向行为。通过闭环策略树(DCP-Tree)结构和条件聚焦分支(CFB)机制控制计算复杂度。主要思想:利用特定领域的专家知识来指导行动和意图空间的分支。

2)使用真实车辆捕获的车载传感数据和交互式多智能体模拟平台进行了验证。

3)发布了我们框架的代码以适应基准测试。

https://github.com/HKUST-Aerial-Robotics/EPSILON

1、介绍

主要目标是解决在决策过程中需要的算力问题,以确保实时性,保持足够的灵活性和保真度。提出了有效的不确定性感知决策(Efficient uncertainty-aware decision-making, EDUM).

首先使用特定领域的闭环策略树(domain-specific closed-loop policy tree,DCP-TREE),构建语义级动作空间。在这个策略树中每一个节点都是一个有界的自车的语义行为集合。从根节点到叶节点的每条轨迹都代表了自我车辆的一系列语义动作。每个轨迹都以类似于 [14] 的闭环模拟的形式进行评估,但允许自我行为在规划范围内改变。

为了解决当其他车辆的行为不确定时,其意图的组合呈现指数增长,对所有的意图进行采样是第小的。故通过条件聚焦分支(Conditional Focused Branching,CFB)机制,利用开环安全评估对自我行动序列进行调节,挑选出有潜在风险的情景。

主要的贡献如下:

1、EUDM自动驾驶框架

2、实时且开源的框架实施

3、通过实车数据进行全面的实验和比较,使用了多代理模拟平台。

第二部分对相关工作进行回顾,第三部分进行概述,第四部分是方法,第五部分是实施,第六部分是实验结果与分析,第七部分是总结

2、相关工作

将决策问题解耦为预测与规划,将规划问题拆分为路径与速度。

POMDP的一些发展,以及在自动驾驶上的一些应用。

MPDM,因为自我的行为在规划边界是固定的,规划只能是被动的。

本文基于MDPM的思想,使用DCP-Tree让决策的结果能够小范围的改变,更加适合长期的决策。其次,即使是完全不确定行为预测的青黄下,也能够找出有风险的长清,确保了结构的安全性。

3、系统概述

在本文框架与之前的工作框架类似(220228),但本文更加注重决策。

使用DCP-Tree用来指导动作域中的分支,并且使用之前的最佳决策更新语义级的决策树。对于每一个自我行动序列,CFB机制被应用于挑出附近车辆的风险隐藏意图,并实现意图空间的引导性分支。CFB过程是一组包含附近车辆不同隐藏意图组合的情形。

所有的场景都被输入到一个成本评估的模块,并对有风险的分支进行惩罚,输出最佳的策略。由闭环前向策略以0.4s的分辨率产生。

4、通过引导式分支进行决策

4.1 POMDP预备知识

一个POMDP的决策可以被定义为< S,A,T,R,Z,O,\gamma>,分别定义了状态空间、动作空间、状态转移函数、奖励函数、观测空间、观测汉书、折扣因子。每一个元素都是部分可观察的,并被描述为一个可信状态b,是对状态空间的概率上的描述。可以使用贝叶斯推理b_t = \tao(\b_{t-1},a_{t-1},z_t)在给定行动a和观测到的z的情况下状态b进行更新。在线的POMDP规划器的目标是找到一个最优策略\pi^*最大化总预期折扣奖励,通过在规划空间t_h中给出一个初始的可信状态b_0。[4][26]

着一个优化策略通常从当前的可信状态开始多段前向搜索,一个置信树可以使用belief update的方式。当决策树高度过高时,决策的规模也就更大了(O(|A|^h|Z|^h)),A是运动空间,Z是观测空间。[5][7][27]是最先进的POMDP算法通过蒙特卡洛采样来结局Curse of Dimensionality and Curse of History 。启发式搜索可以加速采样过程。本文也有使用引导性的分支。

4.2 特定领域的闭环策略树

相较POMDP将大量的运算量放入到了不太可能的空间的搜索。MPDM的关键特征是使用语义层面的策略而不是传统的 "状态 "层面的行动。通过使用语义级别的策略,状态空间调整由简单的闭环控制器进行引导。受此引发,本文中也使用的是语义级别的策略。由于MPDM很难进行多段的决策,所以很难用于更长期的决策。

本文中,DCP-Tree被用来生成未来的行动序列,使得能够在规划的范围内决策发生变化。每一个节点都是预先定义的与特定持续时间相关联的预定义语义级动作。树的有向边为时间上的顺序,树的根节点是当前的状态。

受人类驾驶员通常不会在一个决策周期内来回地改变驾驶策略。所以受此启发,正在进行的动作中,每一个策略序列一个规划周期中最多包含一个动作变化。来回的行为是重新规划实现的。相当于对局部的描述更加模糊了,但是能够搜到更远的地方了。

4.3 CFB,条件聚焦分支

DCP树让分支有了引导,仍需解决其他交通参与者的语义意图,然而相应的复杂度又随参与者指数增长。MPDM 通过在假设周围车辆意图的情况下,利用行为预测进行采样,由于样本数量有限,可能无法推出有影响的风险结果,尤其是当初始意图预测不准确时,存在风险。

本文提出了CFP机来解决这个问题,使用尽可能少的分支找到附近的车辆的意图。C-条件:以自车策略序列为条件。当采取不同策略是,人类对周围的车辆会有不同的想法。所以对周围的决策也应当给予自车已有的决策。未来可以融入学习的方法做这一部分。

基于自车策略序列,获取需要关注的车辆,并通过进一步的安全检查,再挑一次。通过multiple hypotheses(多重假设)实现一个前向模拟。首先通过前向模拟实现初步的安全评估,然后对于没有通过的需要进一步闭环前向评估,如果通过了,那么通过从初始状态开始的最大化后验来进行。所以EUDM能够更聚焦于有危险的情形。

5、实施细节

5.1 介绍了一些树的参数

5.2 介绍了一些前向模拟中使用的技术

5.3 介绍了置信状态是如何生成的

5.4 介绍了CFB机的选取

首先选取了一定范围内的车,然后选取三个意图概率接近的车。对于有着良好预测的车,选取MAP来进行结果边缘化意图概率。第三步使用开环正向仿真进行安全评估、计算前k个场景的概率,成为场景选择的权重。

5.5 策略选择

5.6 轨迹生成 - 使用[28] 这篇文章

994、阅读总结

995、知识点积累

POMDP:部分可观察的马尔可夫决策过程 (POMDP) 提供了一种系统化的方法来整合这些不确定性交通参与者潜在随即行为和感知的不确定性,缺点是难以扩展到现实世界的大型问题。

DCP-TREE:

997、TIPS

LK - lane keeping

LC - lane changing

998、 Linked Papers

[1] POMDP

[2] POMDP 的维度诅咒(curse of dimensionality)

[3] 在线POMDP

[4] POMCP - 一种在线的POMDP求解器

[5][6] DESPOT

[5] branch-and-bound

[7] ABT 启发式的搜索,reachability analysis

[8]-[13] POMDP求解器在自动车辆的许多不确定性感知规划算法中的应用

[10] 将规划问题解耦为路径寻找与速度规划,POMDP用于速度规划

[14]-[16] Multipolicy decision-making(MPDM)它将POMDP过程近似为预先定义的语义层面的驾驶政策的闭环模拟

[14] 闭环模拟的形式进行评估

[15] MPDM

[17][18] 如果初始行为预测不准确,则可能会低估风险,可能导致不安全的决策

[19][20] 自动驾驶决策

[21]-[24] 将决策分为预测和计划

[25] 预测范围,基于学习的意图追踪

[26] POMDP

[27] POMDP 求解器 维度爆炸和历史诅咒(Curse of History)

[28] 一个读过的文章,220228,使用时空走廊进行安全的轨迹规划

[29] 智能驾驶模型

[30] 纯跟踪控制

[31] responsibility-sensitive

[32] lane-change-model

999、词语积累

anticipate v.预测

state-of-the-art 最先进的

tackle v. 解决(问题)

endl;