单目深度估计 | Unsupervised Monocular Depth 学习笔记

文章目录

- 1.主要思想:

- 2 相关工作

- 3 主要算法

- 4.方法

- 6 结论

- 深度估计系列文章

景深 | Depth from Videos in the Wild: Unsupervised Monocular Depth Learning from Unknown Cameras

会议:cs.CV 2019

标题:《 Depth from Videos in the Wild: Unsupervised Monocular Depth Learning from Unknown Camera 》

论文链接: https://arxiv.org/abs/1904.04998v1

本文仅作为个人学习笔记分享,图片来自于论文,如有侵权,请联系删除。

1.主要思想:

我们提出了一种新的即时学习方法。只使用相邻视频帧之间的一致性作为监控信号,可以从单目摄像机中,实时获取深度、自运动、物体运动和照相机固定参数等。我们的工作是首先从视频中无监督的方式,学习相机的固有参数,包括镜头畸变,从而使我们能够从未知来源的任意视频在尺度上,提取准确的深度和运动。

2 相关工作

景深估计对于机器人导航和操纵是非常重要的。目前已有的方法,主要是基于输入的RGB图像和从监测传感器,比如雷达获取的数据,通过深度估计函数推算出来。主要有以下四种形式。

非监督深度学习,非监督深度学习主要是依靠单目相机本身,而不需要另外的深度传感器

从野外图像中学习深度信息,也属于主动搜索领域,大多聚焦于一个或多个视角的图像。像Li展示的联网图片更难,由于输入源的多样性和摄像机参数未知。我们的工作通过学习野外视频的固有参数来应对这一挑战。

遮挡感知学习,许多研究是基于光流法处理遮挡,这些研究都与几何信息无关。可分辨网格绘制,最近比较主流的一种形式。

学习内参学习预测摄像机内参被严格监督的方法限制了,我们的研究目前是唯一一种通过非监督的方式学习摄像机内参的方法,直接从视频联合景深,自运动和目标运动。

3 主要算法

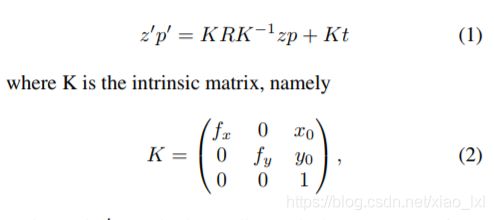

我们的方法在深度信息和运动的同时学习领域扩展了先前的技术。类似于先前的工作,我们方法的主要架构是一个用深度地图和摄像机矩阵连接了两个相邻视频帧的等式。

其中,p 和p’是由旋转矩阵R和平移矩阵T变换后的均匀形式的像素矩阵。 z和z’是各自的深度,K中的参数是摄像机的内参。

通过深度网络预测到的z,R,t 和公式1,从一个视频帧变换到另一个视频帧,将变换的结果与真实的另一个视频帧进行比对,这些差异就是训练误差的重要组成部分,前提是通过差异惩罚,网络可以学习并预测出更准确的z,R,t值。

4.方法

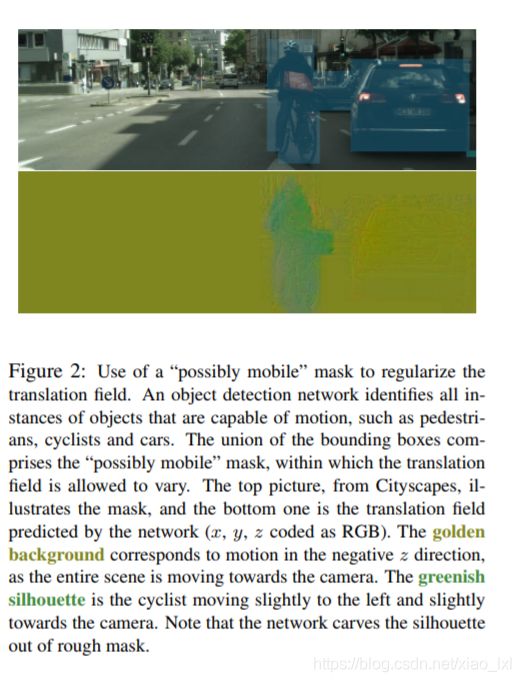

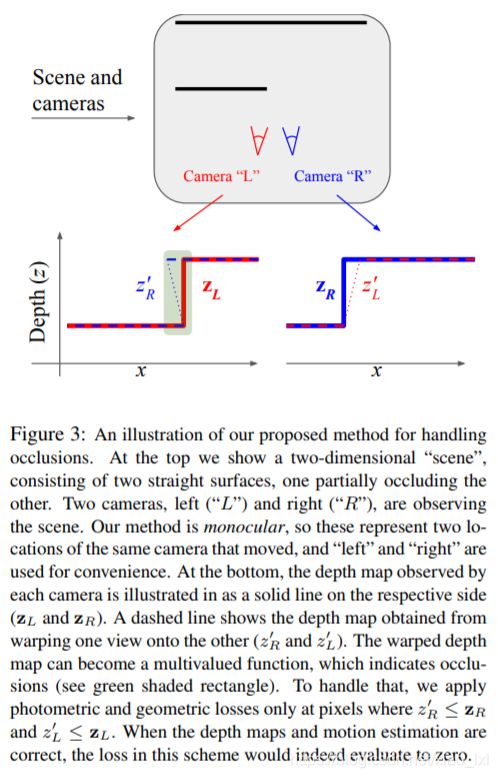

我们设计了一个运动-估计网络来预测摄像机运动,每个相对于背景运动的像素,和相机的内参:焦距,偏移和畸变。第二个网络预测深度地图,通过将相邻帧之间的一致性作为一种损失,网络实时学习预测深度地图,运动领域和摄像机固有参数。我们介绍了一种损失仅对在所有帧中都未被遮挡的像素,遮挡估计是以几何形式完成的,基于他们本身学到的深度图。运动场通过指示可能属于的像素的遮挡的帮助,从预训练分割或者物体检测网络获得移动对象。

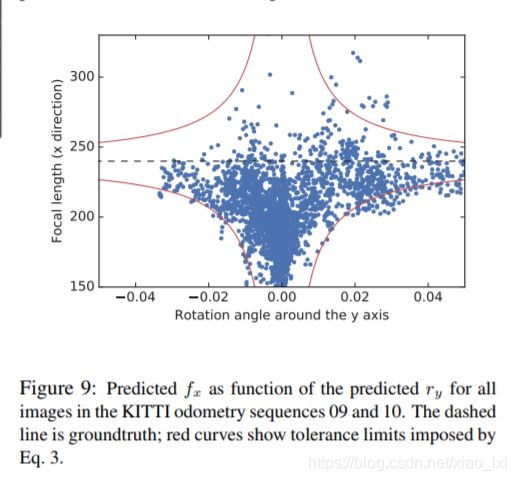

4.1 学习摄像机内参

4.2 学习物体运动

4.3 遮挡感知一致性

4.4 网络,损失和准则

5 实验

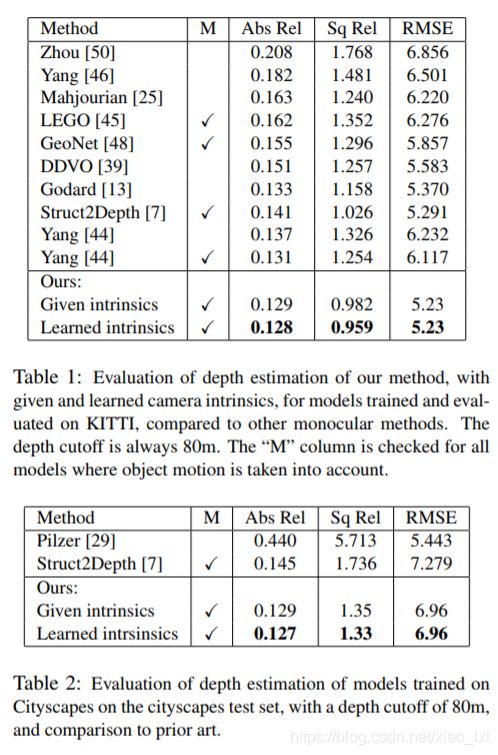

实验数据主要是采用KITTI数据集和 Cityscapes, EuRoC Micro Aerial Vehicle Dataset, YouTube8M videos数据集.

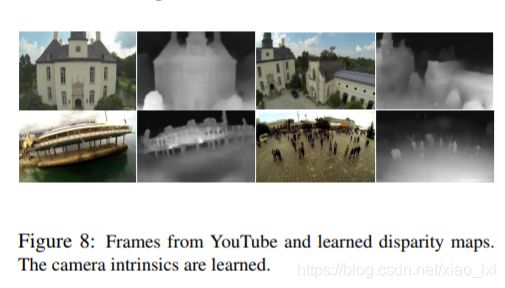

图4 是根据YouTube8M上的图片和搜集的差异学习的差异地图

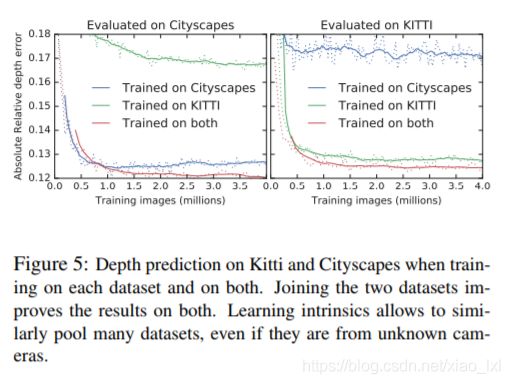

图5是Kitti 和 Cityscapes 数据集分别训练和一起训练时的深度预测结果。即使数据集来源于不同的摄像机,但是在学习摄像机内参时,数据还是越多效果越好。

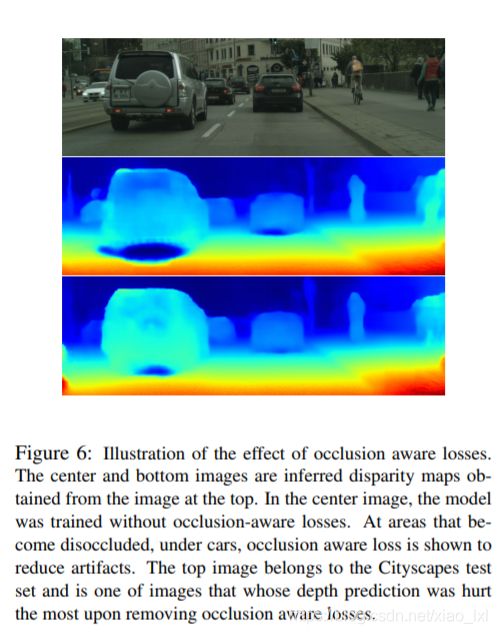

图6 遮挡感知损失信息的影响插图。从上面图中获取的差异地图在中间和下图中展示出来。中间图是阻塞感知损失信息训练的效果,可以明显的看出,在车下被遮挡的区域,为了减少伪影,遮挡感知的损失被显示出来。上图属于Cityscapes测试数据集中的一张,深度预测准确度受遮挡感知损失的影响最大。

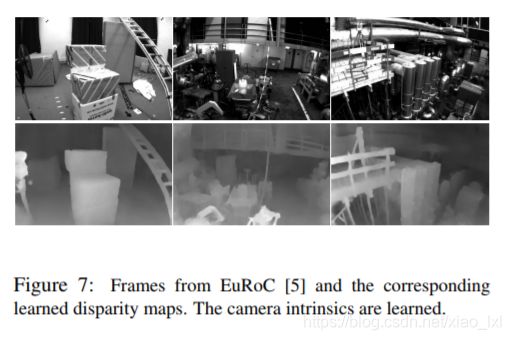

图7 EuRoC 上的视频帧和学习到的差异地图,相机的内参已经学习到了。

图8 YouTube上的视频帧和学习到的差异地图,相机的内参已经学习到了。

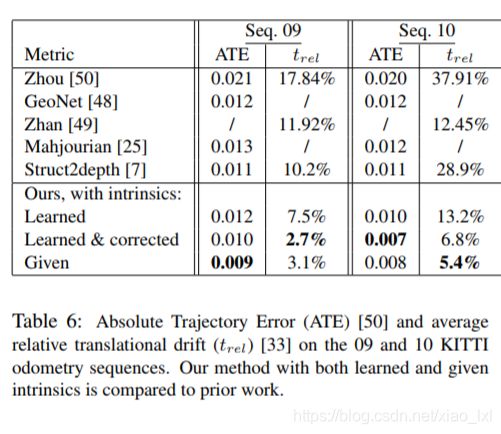

表6中可以看出,通过在KITTI数据集的09和10系列进行验证,我们的算法在ATE上有明显的优势。

6 结论

我们通过几何信息处理遮挡,解决了无监督学习景深和视觉里程测量,用一种简单的方式解释物体运动和新形势的规则是一项重大挑战。第一次,从未知摄像机拍摄的原始视频中通过无监督的形式学习景深,摄像机内参,透镜畸变等。

深度估计系列文章

单目深度估计 | Learning Depth from Monocular Videos using Direct Methods

单目深度估计 | Real-Time Monocular Depth Estimation using Synthetic Data with Domain Adaptation via Image

单目深度估计 | Depth from Videos in the Wild: Unsupervised Monocular Depth Learning from Unknown Cameras