Transformer-Attention is all your need论文详读-PartⅠ(摘要、引言、背景)

⭐原文链接:https://arxiv.org/abs/1706.03762

*黑字——原文翻译

*红字——存在问题

*蓝字——优势

*绿字——主观分析(未对全部细节进行分析,仅针对本文内容补充)

1.摘要

目前主要序列转换模型(dominant sequence transduction models)是基于复杂的循环或卷积神经网络(recurrent or convolutional neural networks),包括一个编码器(encoder)和一个解码器(decoder)表现最好的模型通过注意力机制(attention mechanism)连接编码器(encoder)和解码器(decoder)。我们提出了一个新的简单的网络架构Transformer,完全基于注意力机制(attention mechanism),放弃循环和卷积。

第一段涉及:

(1) 基于循环神经网络(recurrent neural networks)

一种常用的处理序列数据的方法

(2) 基于卷积神经网络(convolutional neural networks)

通常用于处理二维图像数据,也可以处理一维序列数据

(3) 编码器(Encoder)和解码器(Decoder)

a. Encoder-Decoder是一种通用的框架,而不是一种模型;

b. Encoder将Input序列转换成固定长度的向量,Decoder将生成的固定长度向量转换为Output;

c. 针对不同的任务Encoder和decoder中的模型可以是CNN、RNN、Attention等模型的组成。

(4) 注意力机制

涉及不同种的注意力机制(如Self-attention、Multi-head attention等),是本文主要讨论内容。

我们在两个机器翻译任务上进行实验,效果更好。同时具有更强的并行性(more parallelizable),所需的训练时间明显更少。我们的模型在2014年WMT英语-德语翻译任务中实现了28.4 BLEU,比现有的最佳结果,包括集成。提高了2个BLEU以上。在WMT 2014英法翻译任务中,我们的模型在8个gpu上训练3.5天后建立了一个新的最先进的单模型BLEU分数为41.8,仅为文献中最佳模型训练成本的一小部分。

第二段涉及:

(1) 并行性

a. 对于序列长度较长的数据来说,需要在处理的过程中不断保存前序数据的处理结果,造成内存负担。

b. 运算效率相对低下。

并行计算能够有效缓解上述问题。

(2) BLEU

BLEU全称Bilingual Evaluation Understudy,意为双语评估替补,即代替人进行翻译的结果评估。

通过成功地将Transformer应用于具有大量和有限训练数据的英语选区分析(English constituency parsing),我们表明Transformer可以很好地推广到其他任务。

第三段涉及:

(1) 英语选取分析

2.引言

循环神经网络(Recurrent neural networks),长短期记忆神经网络(Long short-term memory ne-ural networks)、门控循环神经网络(Gated recurrent neural networks)目前在序列建模和转换(sequ-ence modeling and transduction)问题是先进的技术,例如语言建模(language m-odeling)和机器翻译(machine translation)。目前也有许多研究推动循环语言模型(recurrent language models)和编码器-解码器架构(encoder-decoder architectures)的边界。

第一段涉及:

(1) 循环神经网络(RNN)

(2) 长短期记忆神经网络(LSTM)

(3) 门控循环神经网络(GRN)

上述三种网络模型是当时几年间主要应用于序列建模和转换问题的网络模型。

循环模型通常沿输入和输出序列的符号位置进行计算。在计算时间内将位置和步长对齐,它们生成一系列隐藏状态ht,作为前一个隐藏状态ht-1和位置t输入的函数。这种固有的序列性质(sequential nat-ure)排除(precludes)了训练示例中的并行化,这对于更长的序列是至关重要的,因为内存约束限制了跨示例的批处理。最近的工作通过因式分解技巧(factorization tricks)和条件计算(conditional computation)在计算效率方面取得了显著的改进,同时也改善了后者的模型性能。然而,顺序计算的基本约束仍然存在。

第二段涉及:

(1) 因式分解技巧

(2) 条件计算

在各种任务中,注意力机制(Attention mechanisms)已经成为引人注目的序列建模(sequence mod-eling)和转换模型(transduction models)的组成部分,允许对依赖关系建模(modeling of dependenc-ies),而不考虑它们在输入或输出序列中的距离。然而,除了少数研究外,所有这些注意机制都与循环网络结合使用。

第三段涉及:

(1) 允许对依赖关系建模(modeling of depe-ndencies),而不考虑它们在输入或输出序列中的距离。

依赖关系即输入序列各个部分间相关性,也是一个缺点,没有考虑位置的关系,需要其他方式进行优化。

在这项研究中, 我们提出了Transformer,这是一种避免循环的模型架构,完全依赖注意力机制来构建输入和输出的全局依赖关系。Transformer允许明显更多的并行化,并且在8个P100GPUs上经过12个小时的训练后,可以在翻译质量上达到一个新的水平。

3.背景

减少序列运算的目标也构成了Extended Neural GPU、ByteNet和ConvS2S的基础,所有这些都使用卷积神经网络作为基本构建块(basic building block),并行计算所有输入和输出位置的隐藏表示(hidd-en representations)。在这些模型中,将来自两个任意输入或输出位置的信号关联起来所需的操作数随着位置之间的距离而增长,对于ConvS2S是线性增长,对于ByteNet是对数增长。这使得学习距离较远的位置之间的依赖关系变得更加困难。在Transformer中,这被简化为一个恒定数量的操作,尽管是以平均注意力加权位置降低有效分辨率为代价的,我们在3.2节中使用多头注意力(Multi-Head Attention)来抵消这种影响。

第一段涉及:

(1) Extended Neural GPU

(2) ByteNet

(3) ConvS2S

自注意(Self-attention),有时也被称为内注意(intra-attention),是一种将单个序列的不同位置联系起来的注意机制,以计算序列的表示。自注意已成功地应用于阅读理解(reading comprehen-sion)、摘要总结(abstractive summa-rization)、文本蕴涵(textual entailment)和与学习任务无关的句子表征(learning task-independent sentence representations)等多种任务中。

第二段涉及:

(1) 自注意

端到端记忆网络(End-to-end memory networks)是基于循环注意机制(recurrent attention mecha-nism)而不是基于序列对齐,已被证明在简单语言问答和语言建模任务中表现良好。

第三段涉及:

(1) 端到端记忆网络

(2) 基于循环注意机制

(3) 基于序列对齐循环注意机制

然而,据我们所知,Transformer是第一个完全依靠自注意(self-attention)来计算其输入和输出表示的转换模型,而不使用序列对齐的RNN或卷积。接下来的章节中,我们将描述Transformer,激发自注意(motivate self-attention),讨论其相对于目前一些模型的优势。

4.参考文献

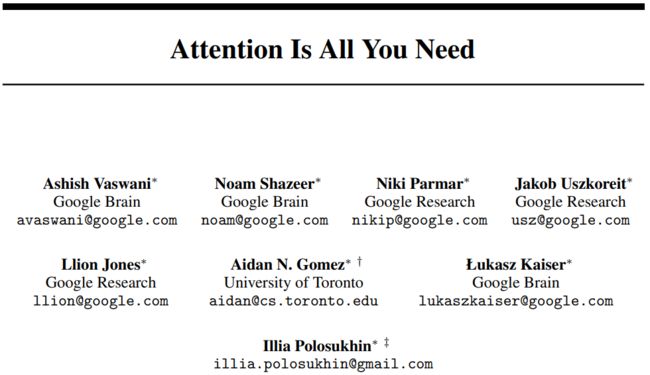

[1] Vaswani, A. , Shazeer, N. , Parmar, N. , Uszkoreit, J. , Jones, L. , & Gomez, A. N. , et al. (2017). Attention is all you need. arXiv.

*仅用于学习记录,文章内涉及的部分后续慢慢补充啦~