图深度学习_谱图论和图上的信号处理

谱图论和图上的信号处理

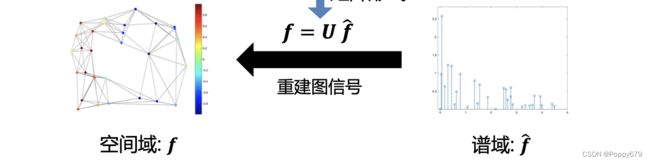

图信号,即图数据结构中存在的与节点相关联的特征或属性,它捕获结构信息(或节点之间的连接)和数据(或节点上的属性)。

当图中节点是一维信号时,对这样的图处理是直接将节点映射到向量, f 1 f_1 f1是节点1的信号, f n f_n fn是节点n的信号,那么就可以通过 f f f来把一维信号拓展到多维。

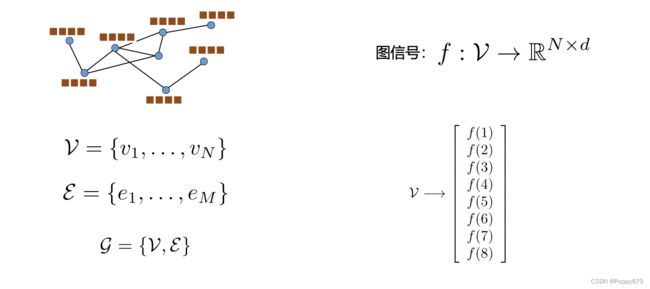

图最常见的表示方式:邻接矩阵

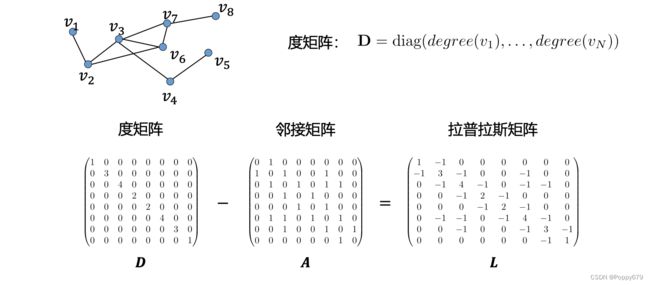

此外还有度矩阵:一个对角矩阵,所有其他节点都为0,只有对角线上为非0。对角线上的元素对应相对应节点的度

度矩阵表示: D = diag ( \mathbf{D}=\operatorname{diag}\left(\right. D=diag( degree ( v 1 ) , … , degree ( v N ) ) \left.\left(v_{1}\right), \ldots, \operatorname{degree}\left(v_{N}\right)\right) (v1),…,degree(vN))

拉普拉斯矩阵是谱图论的重要表示方式

拉普拉斯矩阵可以作为一个差分算子:测量当前节点 i i i信号和节点 j j j信号差别的和, j j j是 i i i的邻居。

h = L f = ( D − A ) f = D f − A f \mathbf{h}=\mathbf{L} \mathbf{f}=(\mathbf{D}-\mathbf{A}) \mathbf{f}=\mathbf{D} \mathbf{f}-\mathbf{A} \mathbf{f} h=Lf=(D−A)f=Df−Af

h ( i ) = ∑ v j ∈ N ( v i ) ( f ( i ) − f ( j ) ) \mathbf{h}(i)=\sum_{v_{j} \in \mathcal{N}\left(v_{i}\right)}(\mathbf{f}(i)-\mathbf{f}(j)) h(i)=∑vj∈N(vi)(f(i)−f(j))

但是信号之间的差距是有正有负,存在正负抵消的情况。所以常用拉普拉斯二次型:用于衡量所有节点对之间的信号差别。

f T L f = 1 2 ∑ i , j = 1 N A [ i , j ] ( f ( i ) − f ( j ) ) 2 \mathbf{f}^{T} \mathbf{L} \mathbf{f}=\frac{1}{2} \sum_{i, j=1}^{N} \mathbf{A}[i, j](\mathbf{f}(i)-\mathbf{f}(j))^{2} fTLf=21∑i,j=1NA[i,j](f(i)−f(j))2

拉普拉斯二次型整体衡量的就是 f f f在图信号上的光滑度或频率。相邻节点差距很小,那么频率就很低;相邻节点差距很大,那么频率就很高。(频率就是相似性的意思?)

在上述公式中, f f f是一个向量, f f f非0,那么等式右边一定大于0。因此可以得到拉普拉斯二次型是一个半正定矩阵。

半正定矩阵:对于任何非0向量,使用二次型得到的值都是非负的话,称这个矩阵是半正定矩阵.

对于半正定矩阵,可以进行矩阵分解。半正定矩阵事一个n维的方阵的话,那么就有n个特征向量,对应n个特征值。

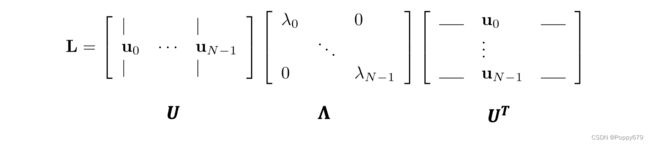

拉普拉斯矩阵的特征分解

拉普拉斯矩阵有一套完整的标准正交的特征向量。

通常将这些特征向量按照特征值从小到大排列

通常将这些特征向量按照特征值从小到大排列

0 = λ 0 < λ 1 ≤ ⋯ λ N − 1 0=\lambda_{0}<\lambda_{1} \leq \cdots \lambda_{N-1} 0=λ0<λ1≤⋯λN−1

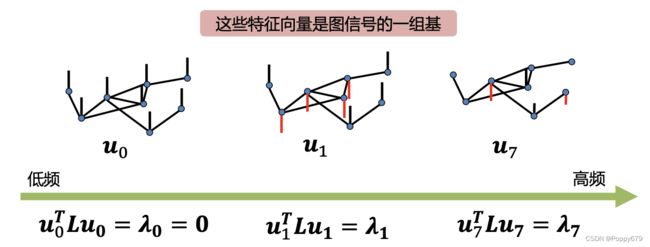

矩阵 U U U是一个正交矩阵,是特征向量作为列向量的特征矩阵, Λ \boldsymbol{\Lambda} Λ是一个对角矩阵,是所有特征值组成的对角矩阵。因为每个特征向量是n维的,可以把每个特征向量看成是图上的信号。信号的特点:

频率: u i T L u i = u i T λ i u i = λ i \mathbf{u}_{i}^{T} \mathbf{L} \mathbf{u}_{i}=\mathbf{u}_{i}^{T} \lambda_{i} \mathbf{u}_{i}=\lambda_{i} uiTLui=uiTλiui=λi

频率对应特征值,那么如果把特征向量看作图上的一个一维信号,信号的光滑程度就可以用信号的特征值来衡量。

特征向量是正交的,那么可以组成一个n维的空间。

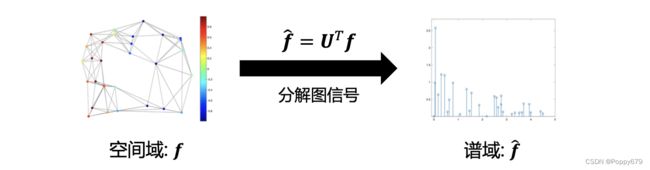

图傅立叶变换(GFT)

任意的图信号 f f f可以用图傅立叶级数表示

f = ∑ i = 0 N − 1 f ^ i ⋅ u i \mathbf{f}=\sum_{i=0}^{N-1} \hat{f}_{i} \cdot \mathbf{u}_{i} f=∑i=0N−1f^i⋅ui

f ^ i = f ⊤ u i \hat{f}_{i}=\boldsymbol{f}^{\top} \boldsymbol{u}_{i} f^i=f⊤ui

u i \mathbf{u}_{i} ui是基,即特征向量, λ i \lambda_{i} λi是基的频率,即特征值, f ^ i \hat{f}_{i} f^i 是傅立叶系数。