融合感知的高门槛,背后的传感器选型组合「奥秘」

如何更加合理解决感知选型问题,是摆在所有企业面前的一道坎。

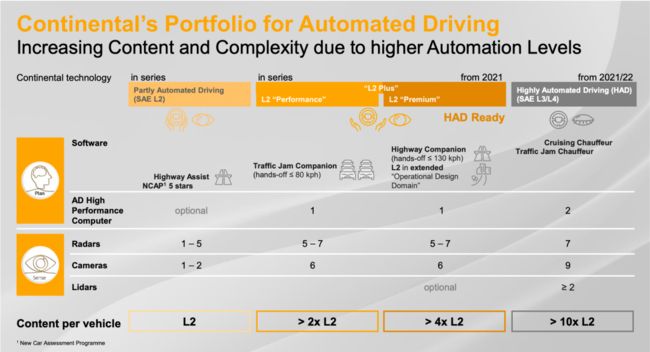

业内人士表示,目前,全球汽车制造商对哪种传感器组合真正适合高阶智能驾驶量产,还存在争议。这其中,涉及到融合技术能力储备、成本问题以及终端消费者的营销宣传。

特斯拉是一个阵营,倾向于采用纯视觉感知系统,一方面,单一感知可以减少不必要的“干扰”,降低决策的难度。Mobileye也是阵营的站队者之一,比如,全新Mobileye SuperVision™系统,同样基于纯摄像头感知,实现可脱手的智能驾驶。

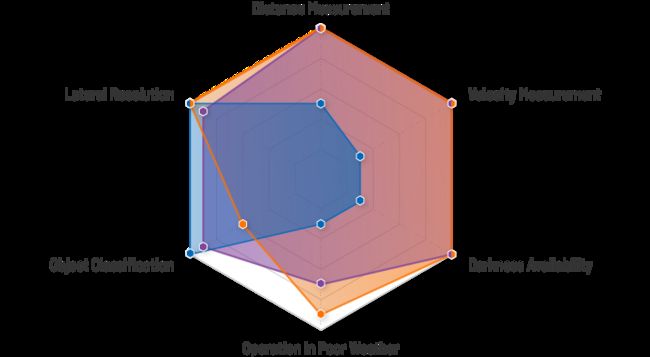

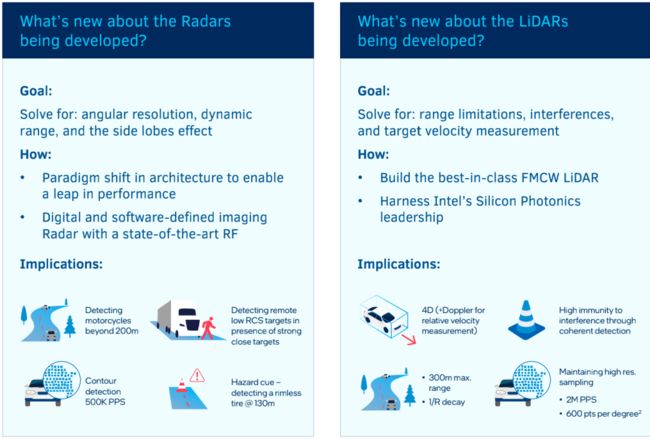

然而,一些汽车制造商强调了纯视觉感知系统的潜在挑战,包括摄像头可能无法在恶劣的天气条件下能否正常工作。同时,4D成像毫米波雷达技术增强了传统毫米波雷达的目标检测功能(比如,提升了角分辨率,输出类似激光雷达的点云),可以在全天候条件下工作。

4D成像雷达能否取代激光雷达?比如,替代低线束的激光雷达,用于补盲。比如,传统毫米波雷达芯片方案商NXP已经推出了适用于4D成像的雷达处理芯片(S32R45和S32R41系列),满足192个虚拟通道的方案落地。

其中,S32R45量产将于今年开始,S32R41将于2023年亮相。在NXP看来,激光雷达由于成本和复杂度的限制,其应用范围仅局限于少量的应用场景。不过,从商业逻辑角度来看,NXP当然希望大家都能用自家的4D方案(此前大陆集团采用的赛灵思FPGA方案,成本较高)。

不过,激光雷达同样不可或缺。

近日,刚刚与Luminar签署合作协议的日产汽车表示,激光雷达的技术优势能够弥补摄像头视觉信息的不足,提供更精准的位置和形状信息。不过,该公司也坦言,面对高速公路场景,市面上的激光雷达感知距离还需要提升性能,比如,测距要达到300米,分辨率还要进一步提升。

到目前为止,全球主要汽车制造商已经陆续选定首款车型的激光雷达定点方案,涉及法雷奥、Luminar、禾赛科技、速腾聚创、一径科技等供应商。但最终落地难度也不小,涉及到大量的数据采集、系统标定等工程化能力。

4D成像雷达,量产在即

在保证摄像头高像素(比如,8MP已经成为主流)的背景下,多感知落地方案主要有两种选择,其一就是视觉+4D雷达融合。优势在于,系统成本相对较低,可以满足L2+及以下的普及型市场。难度在于融合,以及如何有效发挥4D雷达的成像能力,而不是给视觉感知带来新的“噪音”。

4D雷达方案大部分的技术原理,都是通过增加信号通道阵列(芯片极联或者定制芯片组)或者软件算法的方式,来检测物体的相对速度、距离和方位角,以及物体的高度。

去年,AI视觉芯片方案商安霸收购了4D成像雷达初创公司傲酷(Oculii),后者的自适应软件算法可以在传统雷达芯片基础上实现高分辨率、更长距离和更高的探测精度。

接下来,傲酷的4D雷达软件可以直接部署在安霸的CVflow®SoC上,甚至可以提升传统雷达的分辨率和探测精度,从而提供全天候、低成本和可扩展的融合感知解决方案。

“我们希望傲酷独特的自适应雷达感知算法,结合安霸的视觉和人工智能处理能力,解锁更高水平的感知精度,而不是传统的视觉和雷达的后融合解决方案。”到目前为止,傲酷已经与超过10家客户签订了软件授权协议,并拿到了前装量产的商业开发合同。

4D成像雷达产生类似激光雷达的“点云”。同时,优点在于对于每个点,不仅知道X和Y,还可以直接得到距离和速度值。同时,还可以跟踪这些数据随着时间的变化。(比如,大陆集团的ARS540,12发16收,相当于8线激光雷达)

同时,AI技术(通过深度学习的训练)的加持,也在从视觉延伸至4D雷达。通过点云的优化处理,消除返回噪声,也包括从物体轮廓中识别目标和分类。

“雷达提供的数据,比视觉系统提供的要复杂得多;不过,前者除了提供目标的位置之外,还提供距离和速度等信息,这是相当有价值的。”安波福相关负责人表示,目前这家公司也在力推4D成像雷达。

不过,道理大家都懂。

比如,汽车行业需要更高性价比的方案。视觉+成像雷达是可扩展的低成本智能驾驶感知的最佳组合。“这样的产品正是市场所需要的。”在全新一代奔驰S级的DRIVE PILOT系统中,就搭载了Veoneer的双目立体视觉和大陆集团的ARS540成像雷达。

对于L2+/L3功能,如高速公路自动驾驶和车道改变辅助,用于前向的4D成像雷达可以提供更高的角分辨率数据以及高程感知能力,同时提升角雷达的近距离精准探测能力,提升高阶自动泊车的感知识别。

但,这仅仅是个开始。

随着数据集的细化和扩展,感知工程师开发基于4D雷达的新算法将成为新的竞争门槛,同时,这意味着后续与摄像头、激光雷达的“像素级”前融合成为可能,也可能成为障碍。

比如,如何明确定义和设置两种传感器所需的最低性能标准,包括分辨率、误检率、测距范围、延迟和灵敏度。然后,集成高级聚类、对象边界、高级自由空间映射算法和跟踪算法的能力——所有这些都是基于成像雷达的融合感知方案需要解决的问题。

随着点云数据的增加,噪音也会增加。比如,隧道对于传统雷达是一个具有挑战性的环境。隧道墙壁是一个巨大的反射面,可能导致非常多的返回点,甚至超过雷达处理目标的能力。

这就意味着,4D雷达需要克服同样的难题,如何以更高的精度过滤掉检测中的噪声。同时,还可以更好地“理解”隧道和其他封闭环境中的雷达回波,对扇形等目标进行分类。

此外,随着智能驾驶功能等级的不断提升,脱手脱眼正在成为感知组合的一道关键门槛。这对传感器的鲁棒性、冗余度、精度和准确性等指标提出了更高的要求。

“提升雷达的分辨率只是第一步,但目前还没有一款强大的软件能够开箱即用。”这是一家预测感知软件技术方案公司BlueSpace.ai给出的判断,原因是过去的感知模式,主要聚焦于物体识别和分类。

而从第一性原理出发,我们真正关心应该是安全规划的答案:物体的运动,以及它们将做什么(运动轨迹预测)。

4D成像雷达+激光雷达

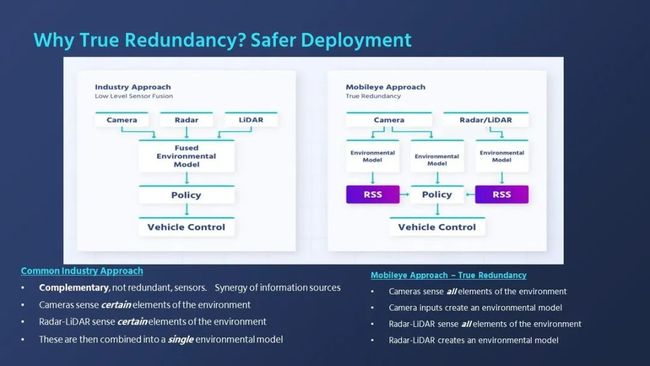

多感知落地方案的第二种落地选择,就是Mobileye提出的4D雷达+激光雷达融合。这也是BlueSpace.ai明确的方向,就是充分发挥4D感知传感器的作用,从而弥补传统深度学习方法无法实现的动态精度感知。为什么做出这种选择?

一方面,纯视觉感知系统,可以实现Vidar(基于多个摄像头),来估计物体之间的距离,并建立一个3D模型。同时,摄像头比其他传感器具有更好的目标分类优势,但在恶劣天气或光线不足的情况下可能会遇到困难。

这意味着,对于一套完整的安全冗余的系统而言,摄像头远远不够。

另一方面,与摄像头属于被动传感器不同,毫米波雷达和激光雷达都是通过主动发射信号(无线电波或者红外)并测量其返回信号来实现感知。相对而言,被动传感器较主动传感器具有抗干扰能力强的特点。

比如,摄像头和激光雷达的前融合,按照常理,合并在一起可以提供最佳的3D对象检测,但事实证明,两种不同的模式转换和融合,使得特征的精确对齐具有挑战性。同样的问题,也出现在摄像头和4D雷达的融合上。原因是,通常的处理方式,是来自两种模态的数据使用了不同的增强策略。

那么,是不是任何类型的毫米波雷达和激光雷达都可以实现有效的融合?答案也是否定的。任何传感器的有效融合,必须要找准两个传感器之间的对齐点。

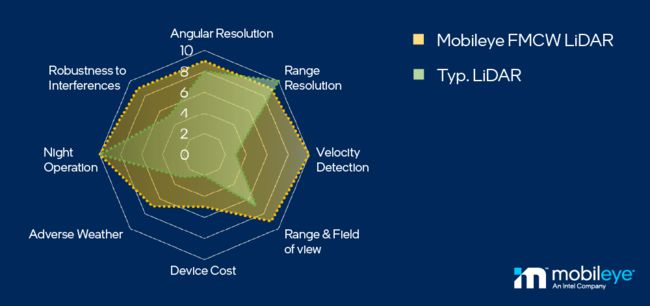

Mobileye提出的是4D成像雷达+FMCW激光雷达。尤其是后者,因为调频连续波(FMCW)和传统的飞行时间(ToF)不同,除了测距范围、仰角和方位采样能力之外,FMCW还增加了速度的直接获取。这意味着,可以与毫米波雷达同时实现对更远的距离快速识别小而快速的目标。

此外,考虑到毫米波雷达的全天候能力,这意味着激光雷达也必须满足这个条件。而FMCW技术的优势之一,就是抗恶劣天气条件、抗其他传感器干扰的能力,同时实现更高的检测和有效的动态范围。

最后,就是整套传感器组合的成本。

按照Mobileye给出的方案,L4级系统是基于360度环绕的摄像头、4D成像雷达,只需要一个高分辨率的前置FMCW激光雷达,就可以实现纯视觉感知,4D成像雷达+激光雷达两套并行的冗余感知组合。

而相对于目前一些厂商采用的三种传感器融合方案,从理论上讲,这应该会创建一个更可靠的模型。但,这样的系统更复杂,而且验证起来明显更困难。Mobileye的方案,是基于4D成像雷达+激光雷达提供一套独立的环境模型(配合RSS模型,但不提供决策控制),最终的路径规划和控制依然依赖于视觉系统。

原因是,决策的有效性,依赖于更容易验证的感知系统(而特斯拉此前决定撤下传统的毫米波雷达,原因之一也是因为与视觉感知系统无法形成有效的决策机制),并且数据量越小越好。

显然, 从这个角度来说,目前智能驾驶系统的开发仍处于第一阶段,即如何充分挖掘每种传感器的性能,并在相互权衡的基准上实现感知融合(不管是前融合,还是后融合)。