- 强化学习中策略网络模型设计与优化技巧

数字扫地僧

计算机视觉深度学习

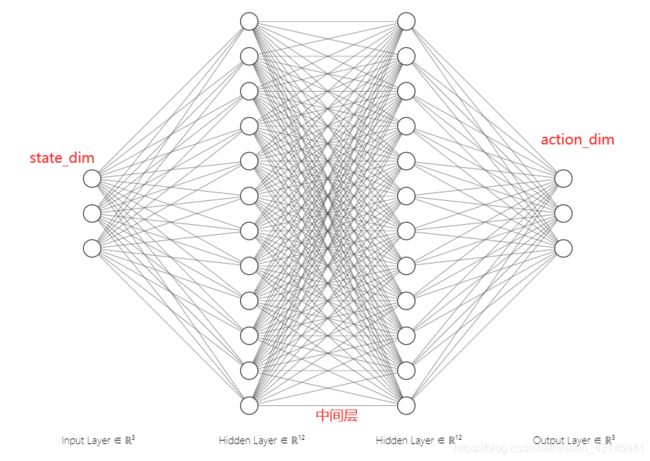

I.引言强化学习(ReinforcementLearning,RL)是一种通过与环境交互,学习如何采取行动以最大化累积奖励的机器学习方法。策略网络(PolicyNetwork)是强化学习中一种重要的模型,它直接输出动作的概率分布或具体的动作。本篇博客将深入探讨策略网络的设计原则、优化技巧,并结合具体实例展示其应用。II.策略网络的基本概念A.策略网络的定义策略网络是一种神经网络,它接受当前状态作为

- LLM-Agent方法评估与效果分析

agent人工智能ai开发

1.引言近年来,随着大型语言模型(LLM)的快速发展,基于强化学习(RL)对LLM进行微调以使其具备代理(Agent)能力成为研究热点。从基础的单智能体强化学习算法(如PPO)到多智能体协作、语料重组以及在线自学习等新技术不断涌现,研究人员致力于探索如何提高LLM在实际应用中的决策能力、推理能力和任务执行效率。本文主要聚焦于当前LLM-Agent方法的检索与评估,旨在全面探讨各类方法的技术实现、实

- 强化学习 Reward

百态老人

算法

在强化学习中,奖励(Reward)是智能体(Agent)与环境(Environment)交互过程中获得的重要反馈信号。奖励机制在强化学习中扮演着至关重要的角色,因为它不仅指导智能体如何在环境中行动,还影响其策略的优化和最终的学习效果。奖励是智能体在执行某个动作后从环境中获得的即时反馈,用于评估该动作的好坏。这种反馈帮助智能体调整其行为策略,以期在未来获得更多的奖励。奖励可以是正数、负数或零,其或负

- 强化学习中的深度卷积神经网络设计与应用实例

数字扫地僧

计算机视觉cnn人工智能神经网络

I.引言强化学习(ReinforcementLearning,RL)是机器学习的一个重要分支,通过与环境的交互来学习最优策略。深度学习,特别是深度卷积神经网络(DeepConvolutionalNeuralNetworks,DCNNs)的引入,为强化学习在处理高维度数据方面提供了强大工具。本文将探讨强化学习中深度卷积神经网络的设计原则及其在不同应用场景中的实例。II.深度卷积神经网络在强化学习中的

- PyTorch 深度学习实战(19):离线强化学习与 Conservative Q-Learning (CQL) 算法

进取星辰

PyTorch深度学习实战深度学习pytorch算法

在上一篇文章中,我们探讨了分布式强化学习与IMPALA算法,展示了如何通过并行化训练提升强化学习的效率。本文将聚焦离线强化学习(OfflineRL)这一新兴方向,并实现ConservativeQ-Learning(CQL)算法,利用Minari提供的静态数据集训练安全的强化学习策略。一、离线强化学习与CQL原理1.离线强化学习的特点无需环境交互:直接从预收集的静态数据集学习数据效率高:复用历史经验

- 一切皆是映射:DQN训练加速技术:分布式训练与GPU并行

AI天才研究院

计算AI大模型企业级应用开发实战ChatGPT计算科学神经计算深度学习神经网络大数据人工智能大型语言模型AIAGILLMJavaPython架构设计AgentRPA

1.背景介绍1.1深度强化学习的兴起近年来,深度强化学习(DeepReinforcementLearning,DRL)在游戏、机器人控制、自然语言处理等领域取得了令人瞩目的成就。作为一种结合深度学习和强化学习的强大技术,DRL能够使智能体在与环境交互的过程中学习最优策略,从而实现自主决策和控制。1.2DQN算法及其局限性深度Q网络(DeepQ-Network,DQN)是DRL的一种经典算法,它利用

- 实战LLM强化学习——使用GRPO(DeepSeek R1出圈算法)

大富大贵7

程序员知识储备1程序员知识储备2程序员知识储备3经验分享

引言近年来,深度强化学习(DRL)已经成为解决复杂决策问题的一个强有力工具,尤其是在自然语言处理(NLP)领域的广泛应用。通过不断优化决策策略,DRL能在大量数据中学习最佳行为,尤其是大型语言模型(LLM)在任务中展现出的巨大潜力。然而,随着模型规模的扩大和任务复杂性的增加,传统的强化学习算法开始暴露出训练效率低、收敛速度慢等问题。为了解决这些挑战,DeepSeek公司提出了一个新的强化学习算法—

- Ai时代初期全球不同纬度的层级辐射现象

龙胥伯

人工智能

基于最新研究成果与行业动态,AI时代的"层级辐射"现象可被科学解构为以下六大维度,结合技术演进、产业实践和社会影响进行系统性分析:一、技术能力的层级跃迁模型效率革命DeepSeek研发的R1-Zero模型通过动态架构设计,将样本利用率提升40%以上,训练周期大幅缩短。这种技术突破推动AI从实验室走向规模化应用,在智能制造、生物医药等领域催生新生态。大语言模型的训练方式(预训练→多任务学习→强化学习

- PyTorch 深度学习实战(12):Actor-Critic 算法与策略优化

进取星辰

PyTorch深度学习实战深度学习pytorch算法

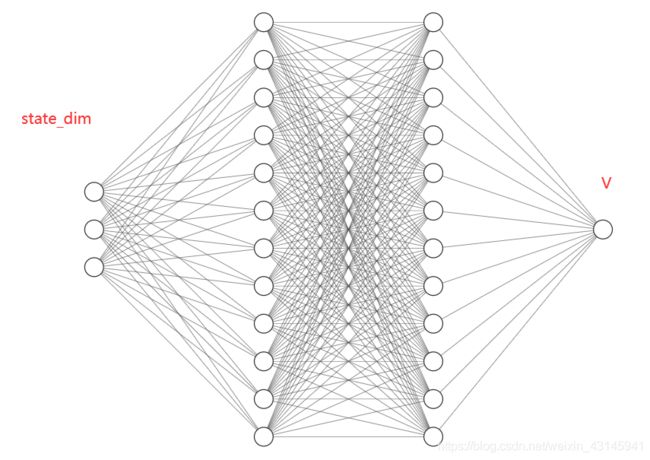

在上一篇文章中,我们介绍了强化学习的基本概念,并使用深度Q网络(DQN)解决了CartPole问题。本文将深入探讨Actor-Critic算法,这是一种结合了策略梯度(PolicyGradient)和值函数(ValueFunction)的强化学习方法。我们将使用PyTorch实现Actor-Critic算法,并应用于经典的CartPole问题。一、Actor-Critic算法基础Actor-Cri

- PyTorch 深度学习实战(17):Asynchronous Advantage Actor-Critic (A3C) 算法与并行训练

进取星辰

PyTorch深度学习实战深度学习pytorch算法

在上一篇文章中,我们深入探讨了SoftActor-Critic(SAC)算法及其在平衡探索与利用方面的优势。本文将介绍强化学习领域的重要里程碑——AsynchronousAdvantageActor-Critic(A3C)算法,并展示如何利用PyTorch实现并行化训练来加速学习过程。一、A3C算法原理A3C算法由DeepMind于2016年提出,通过异步并行的多个智能体(Worker)与环境交互

- DeepSeek在智慧物流管控中的全场景落地方案

猴的哥儿

笔记大数据交通物流python数据仓库微服务

一、智慧物流核心痛点与DeepSeek解决方案矩阵物流环节行业痛点DeepSeek技术方案价值增益仓储管理库存预测误差率>30%多模态时空预测模型库存周转率↑40%运输调度车辆空驶率35%强化学习动态调度引擎运输成本↓25%路径规划突发路况响应延迟>30分钟实时路况语义理解+自适应规划准时交付率↑18%异常检测50%异常依赖人工发现多传感器融合的异常模式识别异常发现时效↑6倍客户服务50%咨询需人

- 探索DeepSeek:前端开发者不可错过的新一代AI技术实践指南

formerlyai

人工智能前端

引言:为什么DeepSeek成为技术圈焦点?最近,国产AI模型DeepSeek凭借其低成本训练、高性能输出和开源策略,迅速成为开发者社区的热门话题。作为覆盖语言、代码、视觉的多模态技术矩阵,DeepSeek不仅实现了与ChatGPT相媲美的能力,还通过强化学习驱动的架构创新,解决了大模型落地中的成本与效率瓶颈。对于前端开发者而言,DeepSeek的API接入能力和私有化部署方案,为智能应用开发提供

- 【sklearn 02】监督学习、非监督下学习、强化学习

@金色海岸

sklearn学习人工智能

监督学习、非监督学习、强化学习**机器学习通常分为无监督学习、监督学习和强化学习三类。-第一类:无监督学习(unsupervisedlearning),指的是从信息出发自动寻找规律,分析数据的结构,常见的无监督学习任务有聚类、降维、密度估计、关联分析等。-第二类:监督学习(supervisedlearning),监督学习指的是使用带标签的数据去训练模型,并预测未知数据的标签。监督学习有两种,当预测

- 【人工智能基础2】机器学习、深度学习总结

roman_日积跬步-终至千里

人工智能习题人工智能机器学习深度学习

文章目录一、人工智能关键技术二、机器学习基础1.监督、无监督、半监督学习2.损失函数:四种损失函数3.泛化与交叉验证4.过拟合与欠拟合5.正则化6.支持向量机三、深度学习基础1、概念与原理2、学习方式3、多层神经网络训练方法一、人工智能关键技术领域基础原理与逻辑机器学习机器学习基于数据,研究从观测数据出发寻找规律,利用这些规律对未来数据进行预测。基于学习模式,机器学习可以分为监督、无监督、强化学习

- 从过拟合到强化学习:机器学习核心知识全解析

吴师兄大模型

0基础实现机器学习入门到精通机器学习人工智能过拟合强化学习pythonLLMscikit-learn

Langchain系列文章目录01-玩转LangChain:从模型调用到Prompt模板与输出解析的完整指南02-玩转LangChainMemory模块:四种记忆类型详解及应用场景全覆盖03-全面掌握LangChain:从核心链条构建到动态任务分配的实战指南04-玩转LangChain:从文档加载到高效问答系统构建的全程实战05-玩转LangChain:深度评估问答系统的三种高效方法(示例生成、手

- 基于DeepSeek R1构建下一代Manus通用型AI智能体的技术实践

zhangjiaofa

DeepSeekR1&AI人工智能大模型DeepSeekManus智能体AI

目录一、技术背景与目标定位1.1大模型推理能力演进趋势1.2DeepSeekR1核心特性解析-混合专家架构(MoE)优化-组相对策略优化(GRPO)原理-多阶段强化学习训练范式1.3Manus智能体框架设计理念-多智能体协作机制-安全执行沙箱设计二、系统架构设计2.1整体架构拓扑图-分层模块交互机制-数据流与控制流设计2.2核心组件实现-规划模块(GRPO算法集成)-记忆系统分级存储架构-工具调用

- 强化学习:时间差分(TD)(SARSA算法和Q-Learning算法)(看不懂算我输专栏)——手把手教你入门强化学习(六)

wxchyy

强化学习算法

目录前言前期回顾一、SARSA算法二、Q-Learning算法三、总结总结前言 前两期我们介绍了动态规划算法,还有蒙特卡洛算法,不过它们对于状态价值函数的估值都有其缺陷性,像动态规划,需要从最下面向上进行递推,而蒙特克洛则需要一个Episode(回合)结束才能对其进行估值,有没有更直接的方法,智能体能边做动作,边估值一次,不断学习策略?答案是有的。这就是本期需要介绍的算法,时间差分法(TimeDi

- 大型语言模型与强化学习的融合:迈向通用人工智能的新范式——基于基础复现的实验平台构建

(initial)

大模型科普人工智能强化学习

1.引言大型语言模型(LLM)在自然语言处理领域的突破,展现了强大的知识存储、推理和生成能力,为人工智能带来了新的可能性。强化学习(RL)作为一种通过与环境交互学习最优策略的方法,在智能体训练中发挥着重要作用。本文旨在探索LLM与RL的深度融合,分析LLM如何赋能RL,并阐述这种融合对于迈向通用人工智能(AGI)的意义。为了更好地理解这一融合的潜力,我们基于“LargeLanguageModela

- 强化学习-Chapter2-贝尔曼方程

Rsbs

算法机器学习概率论

强化学习-Chapter2-贝尔曼方程贝尔曼方程推导继续展开贝尔曼方程的矩阵形式状态值的求解动作价值函数与状态价值函数的关系贝尔曼方程推导Vπ(s)=E[Gt∣St=s]=E[rt+1+(γrt+2+…)∣St=s]=E[rt+1+γGt+1∣St=s]=∑a∈Aπ(s,a)∑s′∈SPs→s′a⋅(Rs→s′a+γE[Gt+1∣St+1=s′])=∑a∈Aπ(s,a)∑s′∈SPs→s′a⋅(R

- 【开源代码解读】AI检索系统R1-Searcher通过强化学习RL激励大模型LLM的搜索能力

accurater

人工智能深度学习R1-Searcher

关于R1-Searcher的报告:第一章:引言-AI检索系统的技术演进与R1-Searcher的创新定位1.1信息检索技术的范式转移在数字化时代爆发式增长的数据洪流中,信息检索系统正经历从传统关键词匹配到语义理解驱动的根本性变革。根据IDC的统计,2023年全球数据总量已突破120ZB,其中非结构化数据占比超过80%。这种数据形态的转变对检索系统提出了三个核心的挑战:语义歧义消除:如何准确理解"A

- PyTorch 深度学习实战(13):Proximal Policy Optimization (PPO) 算法

进取星辰

PyTorch深度学习实战深度学习pytorch算法

在上一篇文章中,我们介绍了Actor-Critic算法,并使用它解决了CartPole问题。本文将深入探讨ProximalPolicyOptimization(PPO)算法,这是一种更稳定、更高效的策略优化方法。我们将使用PyTorch实现PPO算法,并应用于经典的CartPole问题。一、PPO算法基础PPO是OpenAI提出的一种强化学习算法,旨在解决策略梯度方法中的训练不稳定问题。PPO通过

- 院士领衔、IEEE Fellow 坐镇,清华、上交大、复旦、同济等专家齐聚 2025 全球机器学习技术大会

CSDN资讯

机器学习人工智能

随着Manus出圈,OpenManus、OWL迅速开源,OpenAI推出智能体开发工具,全球AI生态正经历新一轮智能体革命。大模型如何协同学习?大模型如何自我进化?新型强化学习技术如何赋能智能体?围绕这些关键问题,由CSDN&Boolan联合举办的「2025全球机器学习技术大会」将于4月18-19日在上海隆重举行。大会云集院士、10所高校科研工作者、近30家一线科技企业技术实战专家组成的超50位重

- 推理大模型:技术解析与未来趋势全景

时光旅人01号

深度学习人工智能pythonpytorch神经网络

1.推理大模型的定义推理大模型(ReasoningLLMs)是专门针对复杂多步推理任务优化的大型语言模型,具备以下核心特性:输出形式创新展示完整逻辑链条(如公式推导、多阶段分析)任务类型聚焦擅长数学证明、编程挑战、多模态谜题等深度逻辑任务训练方法升级融合强化学习、思维链(CoT)、测试时计算扩展等技术2.主流推理大模型图谱2.1国际前沿模型OpenAIo1系列内部生成"思维链"机制数学/代码能力标

- 一文读懂强化学习:从基础到应用

LHTZ

算法时序数据库大数据数据库架构动态规划

强化学习是什么强化学习是人工智能领域的一种学习方法,简单来说,就是让一个智能体(比如机器人、电脑程序)在一个环境里不断尝试各种行为。每次行为后,环境会给智能体一个奖励或者惩罚信号,智能体根据这个信号来调整自己的行为,目的是让自己在未来能获得更多奖励。就像训练小狗,小狗做对了动作(比如坐下),就给它零食(奖励),做错了就没有零食(惩罚),慢慢地小狗就知道怎么做能得到更多零食,也就是学会了最优行为。强

- QwQ-32B企业级本地部署:结合XInference与Open-WebUI使用

大势下的牛马

搭建本地gptRAG知识库人工智能QwQ-32B

QwQ-32B是阿里巴巴Qwen团队推出的一款推理模型,拥有320亿参数,基于Transformer架构,采用大规模强化学习方法训练而成。它在数学推理、编程等复杂问题解决任务上表现出色,性能可媲美拥有6710亿参数的DeepSeek-R1。QwQ-32B在多个基准测试中表现出色,例如在AIME24基准上,其数学问题解决能力得分达到79.5,超过OpenAI的o1-mini。它在LiveBench、

- LLM Weekly(2025.03.03-03.09)

UnknownBody

LLMDailyLLMWeekly语言模型人工智能

网络新闻QwQ-32B:拥抱强化学习的力量。研究人员推出了QwQ-32B,这是一个拥有320亿参数的模型,它利用强化学习来提升推理能力。尽管参数较少,但通过整合类似智能体的推理和反馈机制,QwQ-32B的表现可与更大规模的模型相媲美。该模型可在HuggingFace平台上获取。**人工智能领域的先驱安德鲁·巴托(AndrewBarto)和理查德·萨顿(RichardSutton)因对强化学习的开创

- Chebykan wx 文章阅读

やっはろ

深度学习

文献筛选[1]神经网络:全面基础[2]通过sigmoid函数的超层叠近似[3]多层前馈网络是通用近似器[5]注意力是你所需要的[6]深度残差学习用于图像识别[7]视觉化神经网络的损失景观[8]牙齿模具点云补全通过数据增强和混合RL-GAN[9]强化学习:一项调查[10]使用PySR和SymbolicRegression.jl的科学可解释机器学习[11]Z.Liu,Y.Wang,S.Vaidya,F

- 用物理信息神经网络(PINN)解决实际优化问题:全面解析与实践

青橘MATLAB学习

深度学习网络设计人工智能深度学习物理信息神经网络强化学习

摘要本文系统介绍了物理信息神经网络(PINN)在解决实际优化问题中的创新应用。通过将物理定律与神经网络深度融合,PINN在摆的倒立控制、最短时间路径规划及航天器借力飞行轨道设计等复杂任务中展现出显著优势。实验表明,PINN相比传统数值方法及强化学习(RL)/遗传算法(GA),在收敛速度、解的稳定性及物理保真度上均实现突破性提升。关键词:物理信息神经网络;优化任务;深度学习;强化学习;航天器轨道一、

- django allauth 自定义登录界面

waterHBO

djangopythondjango数据库sqlitepython笔记经验分享

起因,目的:为什么前几天还在写强化学习,今天又写django,问就是:客户需求>个人兴趣。问题来源:allauth默认的登录界面不好看,这里记录几个问题。1.注册页面SignUp这里增加,手机号,邮编等等。2.使用谷歌来登录这个步骤其实也简单。xxxxxxxx一定要修改关键的信息,不能随便暴露给别人。xxxxxxxx#HowtouseGoogleLogin.1.createsuperuser.(m

- 人工智能机器学习算法分类全解析

power-辰南

人工智能人工智能机器学习算法python

目录一、引言二、机器学习算法分类概述(一)基于学习方式的分类1.监督学习(SupervisedLearning)2.无监督学习(UnsupervisedLearning)3.强化学习(ReinforcementLearning)(二)基于任务类型的分类1.分类算法2.回归算法3.聚类算法4.降维算法5.生成算法(三)基于模型结构的分类1.线性模型2.非线性模型3.基于树的模型4.基于神经网络的模型

- iOS http封装

374016526

ios服务器交互http网络请求

程序开发避免不了与服务器的交互,这里打包了一个自己写的http交互库。希望可以帮到大家。

内置一个basehttp,当我们创建自己的service可以继承实现。

KuroAppBaseHttp *baseHttp = [[KuroAppBaseHttp alloc] init];

[baseHttp setDelegate:self];

[baseHttp

- lolcat :一个在 Linux 终端中输出彩虹特效的命令行工具

brotherlamp

linuxlinux教程linux视频linux自学linux资料

那些相信 Linux 命令行是单调无聊且没有任何乐趣的人们,你们错了,这里有一些有关 Linux 的文章,它们展示着 Linux 是如何的有趣和“淘气” 。

在本文中,我将讨论一个名为“lolcat”的小工具 – 它可以在终端中生成彩虹般的颜色。

何为 lolcat ?

Lolcat 是一个针对 Linux,BSD 和 OSX 平台的工具,它类似于 cat 命令,并为 cat

- MongoDB索引管理(1)——[九]

eksliang

mongodbMongoDB管理索引

转载请出自出处:http://eksliang.iteye.com/blog/2178427 一、概述

数据库的索引与书籍的索引类似,有了索引就不需要翻转整本书。数据库的索引跟这个原理一样,首先在索引中找,在索引中找到条目以后,就可以直接跳转到目标文档的位置,从而使查询速度提高几个数据量级。

不使用索引的查询称

- Informatica参数及变量

18289753290

Informatica参数变量

下面是本人通俗的理解,如有不对之处,希望指正 info参数的设置:在info中用到的参数都在server的专门的配置文件中(最好以parma)结尾 下面的GLOBAl就是全局的,$开头的是系统级变量,$$开头的变量是自定义变量。如果是在session中或者mapping中用到的变量就是局部变量,那就把global换成对应的session或者mapping名字。

[GLOBAL] $Par

- python 解析unicode字符串为utf8编码字符串

酷的飞上天空

unicode

php返回的json字符串如果包含中文,则会被转换成\uxx格式的unicode编码字符串返回。

在浏览器中能正常识别这种编码,但是后台程序却不能识别,直接输出显示的是\uxx的字符,并未进行转码。

转换方式如下

>>> import json

>>> q = '{"text":"\u4

- Hibernate的总结

永夜-极光

Hibernate

1.hibernate的作用,简化对数据库的编码,使开发人员不必再与复杂的sql语句打交道

做项目大部分都需要用JAVA来链接数据库,比如你要做一个会员注册的 页面,那么 获取到用户填写的 基本信后,你要把这些基本信息存入数据库对应的表中,不用hibernate还有mybatis之类的框架,都不用的话就得用JDBC,也就是JAVA自己的,用这个东西你要写很多的代码,比如保存注册信

- SyntaxError: Non-UTF-8 code starting with '\xc4'

随便小屋

python

刚开始看一下Python语言,传说听强大的,但我感觉还是没Java强吧!

写Hello World的时候就遇到一个问题,在Eclipse中写的,代码如下

'''

Created on 2014年10月27日

@author: Logic

'''

print("Hello World!");

运行结果

SyntaxError: Non-UTF-8

- 学会敬酒礼仪 不做酒席菜鸟

aijuans

菜鸟

俗话说,酒是越喝越厚,但在酒桌上也有很多学问讲究,以下总结了一些酒桌上的你不得不注意的小细节。

细节一:领导相互喝完才轮到自己敬酒。敬酒一定要站起来,双手举杯。

细节二:可以多人敬一人,决不可一人敬多人,除非你是领导。

细节三:自己敬别人,如果不碰杯,自己喝多少可视乎情况而定,比如对方酒量,对方喝酒态度,切不可比对方喝得少,要知道是自己敬人。

细节四:自己敬别人,如果碰杯,一

- 《创新者的基因》读书笔记

aoyouzi

读书笔记《创新者的基因》

创新者的基因

创新者的“基因”,即最具创意的企业家具备的五种“发现技能”:联想,观察,实验,发问,建立人脉。

第一部分破坏性创新,从你开始

第一章破坏性创新者的基因

如何获得启示:

发现以下的因素起到了催化剂的作用:(1) -个挑战现状的问题;(2)对某项技术、某个公司或顾客的观察;(3) -次尝试新鲜事物的经验或实验;(4)与某人进行了一次交谈,为他点醒

- 表单验证技术

百合不是茶

JavaScriptDOM对象String对象事件

js最主要的功能就是验证表单,下面是我对表单验证的一些理解,贴出来与大家交流交流 ,数显我们要知道表单验证需要的技术点, String对象,事件,函数

一:String对象;通常是对字符串的操作;

1,String的属性;

字符串.length;表示该字符串的长度;

var str= "java"

- web.xml配置详解之context-param

bijian1013

javaservletweb.xmlcontext-param

一.格式定义:

<context-param>

<param-name>contextConfigLocation</param-name>

<param-value>contextConfigLocationValue></param-value>

</context-param>

作用:该元

- Web系统常见编码漏洞(开发工程师知晓)

Bill_chen

sqlPHPWebfckeditor脚本

1.头号大敌:SQL Injection

原因:程序中对用户输入检查不严格,用户可以提交一段数据库查询代码,根据程序返回的结果,

获得某些他想得知的数据,这就是所谓的SQL Injection,即SQL注入。

本质:

对于输入检查不充分,导致SQL语句将用户提交的非法数据当作语句的一部分来执行。

示例:

String query = "SELECT id FROM users

- 【MongoDB学习笔记六】MongoDB修改器

bit1129

mongodb

本文首先介绍下MongoDB的基本的增删改查操作,然后,详细介绍MongoDB提供的修改器,以完成各种各样的文档更新操作 MongoDB的主要操作

show dbs 显示当前用户能看到哪些数据库

use foobar 将数据库切换到foobar

show collections 显示当前数据库有哪些集合

db.people.update,update不带参数,可

- 提高职业素养,做好人生规划

白糖_

人生

培训讲师是成都著名的企业培训讲师,他在讲课中提出的一些观点很新颖,在此我收录了一些分享一下。注:讲师的观点不代表本人的观点,这些东西大家自己揣摩。

1、什么是职业规划:职业规划并不完全代表你到什么阶段要当什么官要拿多少钱,这些都只是梦想。职业规划是清楚的认识自己现在缺什么,这个阶段该学习什么,下个阶段缺什么,又应该怎么去规划学习,这样才算是规划。

- 国外的网站你都到哪边看?

bozch

技术网站国外

学习软件开发技术,如果没有什么英文基础,最好还是看国内的一些技术网站,例如:开源OSchina,csdn,iteye,51cto等等。

个人感觉如果英语基础能力不错的话,可以浏览国外的网站来进行软件技术基础的学习,例如java开发中常用的到的网站有apache.org 里面有apache的很多Projects,springframework.org是spring相关的项目网站,还有几个感觉不错的

- 编程之美-光影切割问题

bylijinnan

编程之美

package a;

public class DisorderCount {

/**《编程之美》“光影切割问题”

* 主要是两个问题:

* 1.数学公式(设定没有三条以上的直线交于同一点):

* 两条直线最多一个交点,将平面分成了4个区域;

* 三条直线最多三个交点,将平面分成了7个区域;

* 可以推出:N条直线 M个交点,区域数为N+M+1。

- 关于Web跨站执行脚本概念

chenbowen00

Web安全跨站执行脚本

跨站脚本攻击(XSS)是web应用程序中最危险和最常见的安全漏洞之一。安全研究人员发现这个漏洞在最受欢迎的网站,包括谷歌、Facebook、亚马逊、PayPal,和许多其他网站。如果你看看bug赏金计划,大多数报告的问题属于 XSS。为了防止跨站脚本攻击,浏览器也有自己的过滤器,但安全研究人员总是想方设法绕过这些过滤器。这个漏洞是通常用于执行cookie窃取、恶意软件传播,会话劫持,恶意重定向。在

- [开源项目与投资]投资开源项目之前需要统计该项目已有的用户数

comsci

开源项目

现在国内和国外,特别是美国那边,突然出现很多开源项目,但是这些项目的用户有多少,有多少忠诚的粉丝,对于投资者来讲,完全是一个未知数,那么要投资开源项目,我们投资者必须准确无误的知道该项目的全部情况,包括项目发起人的情况,项目的维持时间..项目的技术水平,项目的参与者的势力,项目投入产出的效益.....

- oracle alert log file(告警日志文件)

daizj

oracle告警日志文件alert log file

The alert log is a chronological log of messages and errors, and includes the following items:

All internal errors (ORA-00600), block corruption errors (ORA-01578), and deadlock errors (ORA-00060)

- 关于 CAS SSO 文章声明

denger

SSO

由于几年前写了几篇 CAS 系列的文章,之后陆续有人参照文章去实现,可都遇到了各种问题,同时经常或多或少的收到不少人的求助。现在这时特此说明几点:

1. 那些文章发表于好几年前了,CAS 已经更新几个很多版本了,由于近年已经没有做该领域方面的事情,所有文章也没有持续更新。

2. 文章只是提供思路,尽管 CAS 版本已经发生变化,但原理和流程仍然一致。最重要的是明白原理,然后

- 初二上学期难记单词

dcj3sjt126com

englishword

lesson 课

traffic 交通

matter 要紧;事物

happy 快乐的,幸福的

second 第二的

idea 主意;想法;意见

mean 意味着

important 重要的,重大的

never 从来,决不

afraid 害怕 的

fifth 第五的

hometown 故乡,家乡

discuss 讨论;议论

east 东方的

agree 同意;赞成

bo

- uicollectionview 纯代码布局, 添加头部视图

dcj3sjt126com

Collection

#import <UIKit/UIKit.h>

@interface myHeadView : UICollectionReusableView

{

UILabel *TitleLable;

}

-(void)setTextTitle;

@end

#import "myHeadView.h"

@implementation m

- N 位随机数字串的 JAVA 生成实现

FX夜归人

javaMath随机数Random

/**

* 功能描述 随机数工具类<br />

* @author FengXueYeGuiRen

* 创建时间 2014-7-25<br />

*/

public class RandomUtil {

// 随机数生成器

private static java.util.Random random = new java.util.R

- Ehcache(09)——缓存Web页面

234390216

ehcache页面缓存

页面缓存

目录

1 SimplePageCachingFilter

1.1 calculateKey

1.2 可配置的初始化参数

1.2.1 cach

- spring中少用的注解@primary解析

jackyrong

primary

这次看下spring中少见的注解@primary注解,例子

@Component

public class MetalSinger implements Singer{

@Override

public String sing(String lyrics) {

return "I am singing with DIO voice

- Java几款性能分析工具的对比

lbwahoo

java

Java几款性能分析工具的对比

摘自:http://my.oschina.net/liux/blog/51800

在给客户的应用程序维护的过程中,我注意到在高负载下的一些性能问题。理论上,增加对应用程序的负载会使性能等比率的下降。然而,我认为性能下降的比率远远高于负载的增加。我也发现,性能可以通过改变应用程序的逻辑来提升,甚至达到极限。为了更详细的了解这一点,我们需要做一些性能

- JVM参数配置大全

nickys

jvm应用服务器

JVM参数配置大全

/usr/local/jdk/bin/java -Dresin.home=/usr/local/resin -server -Xms1800M -Xmx1800M -Xmn300M -Xss512K -XX:PermSize=300M -XX:MaxPermSize=300M -XX:SurvivorRatio=8 -XX:MaxTenuringThreshold=5 -

- 搭建 CentOS 6 服务器(14) - squid、Varnish

rensanning

varnish

(一)squid

安装

# yum install httpd-tools -y

# htpasswd -c -b /etc/squid/passwords squiduser 123456

# yum install squid -y

设置

# cp /etc/squid/squid.conf /etc/squid/squid.conf.bak

# vi /etc/

- Spring缓存注解@Cache使用

tom_seed

spring

参考资料

http://www.ibm.com/developerworks/cn/opensource/os-cn-spring-cache/

http://swiftlet.net/archives/774

缓存注解有以下三个:

@Cacheable @CacheEvict @CachePut

- dom4j解析XML时出现"java.lang.noclassdeffounderror: org/jaxen/jaxenexception"错误

xp9802

java.lang.NoClassDefFoundError: org/jaxen/JaxenExc

关键字: java.lang.noclassdeffounderror: org/jaxen/jaxenexception

使用dom4j解析XML时,要快速获取某个节点的数据,使用XPath是个不错的方法,dom4j的快速手册里也建议使用这种方式

执行时却抛出以下异常:

Exceptio