flink任务优化总结

本博客总结为B站尚硅谷大数据Flink2.0调优,Flink性能优化视频的笔记总结。

1. 资源配置调优

Flink 性能调优的第一步,就是为任务分配合适的资源,在一定范围内,增加资源的分配与性能的提升是成正比的,实现了最优的资源配置后,在此基础上再考虑进行后面论述的性能调优策略。

提交方式主要是 yarn-per-job ,资源的分配在使用脚本提交 Flink 任务时进行指定。

标准的 Flink 任务提交脚本 (Generic CLI 模式)

从 1.11 开始,增加了通用客户端模式,使用-D指定其他的参数:

bin/flink run \

-t yarn-per-job \

-d \

-p 5 \ 指定并行度

-Dyarn.application.queue=test \ 指定 yarn 队列

-Djobmanager.memory.process.size=1024mb \ 指定 JM 的总进程大小

-Dtaskmanager.memory.process.size=1024mb \ 指定每个 TM 的总进程大小

-Dtaskmanager.numberOfTaskSlots=2 \ 指定每个 TM 的 slot 数

-c com.atguigu.flink.tuning.UvDemo \

/opt/module/flink-1.13.1/myjar/flink-tuning-1.0-SNAPSHOT.jar

如果是使用 -m yarn-cluster,则使用 -yD 指定其他的参数:

bin/flink run \

-m yarn-cluster \

-d \

-p 5 \ 指定并行度

-yDyarn.application.queue=test \ 指定 yarn 队列

-yDjobmanager.memory.process.size=1024mb \ 指定 JM 的总进程大小

-yDtaskmanager.memory.process.size=1024mb \ 指定每个 TM 的总进程大小

-yDtaskmanager.numberOfTaskSlots=2 \ 指定每个 TM 的 slot 数

-c com.atguigu.flink.tuning.UvDemo \

/opt/module/flink-1.13.1/myjar/flink-tuning-1.0-SNAPSHOT.jar

官网参数列表

1.1. 内存设置

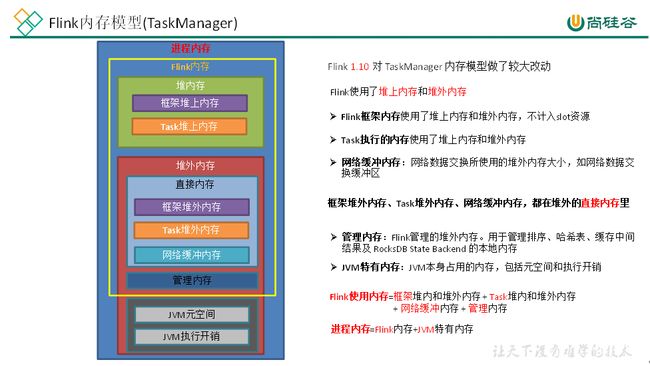

1.1.1. TaskManager 内存模型

-

内存模型详解

-

JVM 特定内存:JVM 本身使用的内存,包含 JVM 的 metaspace 和 over-head

-

JVM metaspace:JVM 元空间,taskmanager.memory.jvm-metaspace.size,默认 256mb

-

JVM over-head 执行开销:JVM 执行时自身所需要的内容,包括线程堆栈、IO、编译缓存等所使用的内存。

taskmanager.memory.jvm-overhead.fraction,默认 0.1

taskmanager.memory.jvm-overhead.min,默认 192mb

taskmanager.memory.jvm-overhead.max,默认 1gb

总进程内存*fraction,如果小于配置的 min(或大于配置的 max) 大小, 则使用 min/max 大小

-

-

框架内存: flink 框架,即 TaskManager 本身所占用的内存,不计入 Slot 的资源中。

堆内:taskmanager.memory.framework.heap.size ,默认 128MB

堆外:taskmanager.memory.framework.off-heap.size,默认 128MB -

Task 内存:Task 执行用户代码时所使用的内存

堆内:taskmanager.memory.task.heap.size,默认 none,由 Flink 内存扣除掉其他部分的内存得到。

堆外:taskmanager.memory.task.off-heap.size,默认 0,表示不使用堆外内存。 -

网络内存:网络数据交换所使用的堆外内存大小,如网络数据交换缓冲区

堆外:taskmanager.memory.network.fraction,默认 0.1

taskmanager.memory.network.min,默认 64mb

taskmanager.memory.network.max,默认 1gb

Flink 内存*fraction, 如果小于配置的 min(或大于配置的 max)大小, 则使用 min/max大小 -

托管内存:用于 RocksDB State Backend 的本地内存和批的排序、哈希表、缓存中间结果。

堆外:taskmanager.memory.managed.fraction,默认 0.4

taskmanager.memory.managed.size,默认 none,如果 size 没指定,则等于 Flink 内存*fraction

-

-

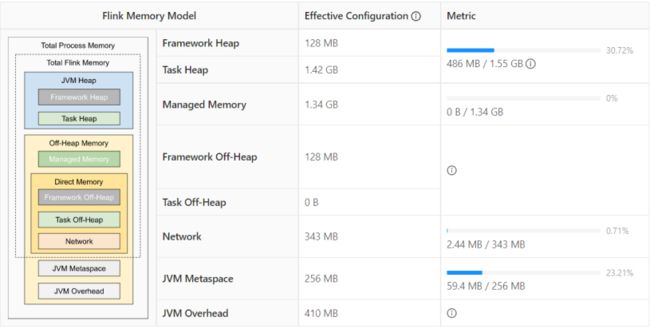

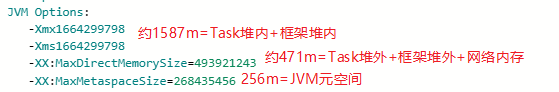

案例分析

基于 Yarn 模式,一般参数指定的是总进程内存,taskmanager.memory.process.size,比如指定为 4G,每一块内存得到大小如下:

所以进程内存给多大,每一部分内存需不需要调整,可以看内存的使用率来调整。

1.1.2. 生产资源配置示例

bin/flink run \

-t yarn-per-job \

-d \

-p 5 \ 指定并行度

-Dyarn.application.queue=test \ 指定 yarn 队列

-Djobmanager.memory.process.size=2048mb \ JM2~4G 足够

-Dtaskmanager.memory.process.size=4096mb \ 单个 TM2~8G 足够

-Dtaskmanager.numberOfTaskSlots=2 \ 容器核数 1core:1 slot 或 2 core:2 slot

-c com.atguigu.flink.tuning.UvDemo \

/opt/module/flink-1.13.1/myjar/flink-tuning-1.0-SNAPSHOT.jar

Flink 是实时流处理,关键在于资源能不能抗住高峰时期每秒的数据量,通常用 QPS/TPS 来描述数据情况。

1.2. 合理利用 cpu 资源

Yarn 的容量调度器默认情况下是使用 "DefaultResourceCalculator"分配策略,只根据内存调度资源,所以在 Yarn 的资源管理页面上看到每个容器的 vcore 个数永远都是 1。

可以修改策略为DominantResourceCalculator,该资源计算器在计算资源的时候会综合考虑 cpu 和内存的情况。在 capacity-scheduler.xml 中修改属性:

<property>

<name>yarn.scheduler.capacity.resource-calculatorname>

<value>org.apache.hadoop.yarn.util.resource.DominantResourceCalculatorvalue>

property>

1.2.1. 使用 DefaultResourceCalculator 策略

bin/flink run \

-t yarn-per-job \

-d \

-p 5 \

-Drest.flamegraph.enabled=true \

-Dyarn.application.queue=test \

-Djobmanager.memory.process.size=1024mb \

-Dtaskmanager.memory.process.size=4096mb \

-Dtaskmanager.numberOfTaskSlots=2 \

-c com.atguigu.flink.tuning.UvDemo \

/opt/module/flink-1.13.1/myjar/flink-tuning-1.0-SNAPSHOT.jar

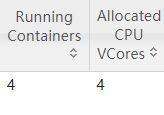

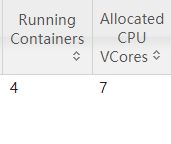

可以看到一个容器只有一个vcore:

1.2.2. 使用 DominantResourceCalculator 策略

修改 yarn 配置后,分发配置并重启 yarn, 再次提交 flink 作业:

bin/flink run \

-t yarn-per-job \

-d \

-p 5 \

-Drest.flamegraph.enabled=true \

-Dyarn.application.queue=test \

-Djobmanager.memory.process.size=1024mb \

-Dtaskmanager.memory.process.size=4096mb \

-Dtaskmanager.numberOfTaskSlots=2 \

-c com.atguigu.flink.tuning.UvDemo \

/opt/module/flink-1.13.1/myjar/flink-tuning-1.0-SNAPSHOT.jar

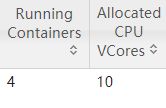

看到容器的 vcore 数变了:

TaskManager3 个,占用 3 个容器,每个容器 vcore=2,总 vcore=2*3=6,因为默认单个容器的 vcore 数=单 TM 的 slot 数

1.2.3. 使用 DominantResourceCalculator 策略并指定容器 vcore 数

指定 yarn 容器的 vcore 数,提交:

bin/flink run \

-t yarn-per-job \

-d \

-p 5 \

-Drest.flamegraph.enabled=true \

-Dyarn.application.queue=test \

-Dyarn.containers.vcores=3 \

-Djobmanager.memory.process.size=1024mb \

-Dtaskmanager.memory.process.size=4096mb \

-Dtaskmanager.numberOfTaskSlots=2 \

-c com.atguigu.flink.tuning.UvDemo \

/opt/module/flink-1.13.1/myjar/flink-tuning-1.0-SNAPSHOT.jar

JobManager 1 个,占用 1 个容器,vcore=1

TaskManager 3 个,占用 3 个容器,每个容器vcore =3,总 vcore=3*3=9

1.3. 并行度设置

1.3.1. 1全局并行度计算

开发完成后,先进行压测。任务并行度给 10 以下,测试单个并行度的处理上限。然后总 QPS/单并行度的处理能力 = 并行度

开发完 Flink 作业, 压测的方式很简单, 先在 kafka 中积压数据,之后开启 Flink 任务,出现反压,就是处理瓶颈。相当于水库先积水,一下子泄洪。

不能只从 QPS 去得出并行度,因为有些字段少、逻辑简单的任务,单并行度一秒处理几万条数据。而有些数据字段多,处理逻辑复杂,单并行度一秒只能处理 1000 条数据。

最好根据高峰期的 QPS 压测,并行度*1.2 倍,富余一些资源。

1.3.2. Source 端并行度的配置

数据源端是 Kafka , Source 的并行度设置为 Kafka 对应 Topic 的分区数。

如果已经等于 Kafka 的分区数,消费速度仍跟不上数据生产速度, 考虑下 Kafka 要扩大分区,同时调大并行度等于分区数。

Flink 的一个并行度可以处理一至多个分区的数据,如果并行度多于 Kafka 的分区数,那么就会造成有的并行度空闲,浪费资源。

1.3.3. Transform 端并行度的配置

-

Keyby 之前的算子

一般不会做太重的操作,都是比如 map、filter、flatmap 等处理较快的算子,并行度可以和 source 保持一致。 -

Keyby 之后的算子

如果并发较大,建议设置并行度为 2 的整数次幂,例如:128、256、512;

小并发任务的并行度不一定需要设置成 2 的整数次幂;

大并发任务如果没有 KeyBy,并行度也无需设置为 2 的整数次幂;

1.3.4. Sink 端并行度的配置

Sink 端是数据流向下游的地方,可以根据 Sink 端的数据量及下游的服务抗压能力进行评估。如果 Sink 端是 Kafka,可以设为 Kafka 对应 Topic 的分区数。

Sink 端的数据量小,比较常见的就是监控告警的场景,并行度可以设置的小一些。

Source 端的数据量是最小的,拿到 Source 端流过来的数据后做了细粒度的拆分,数据量不断的增加,到 Sink 端的数据量就非常大。那么在 Sink 到下游的存储中间件的时候就需要提高并行度。

另外 Sink 端要与下游的服务进行交互,并行度还得根据下游的服务抗压能力来设置,如果在 Flink Sink 这端的数据量过大的话,且 Sink 处并行度也设置的很大,但下游的服务完全撑不住这么大的并发写入,可能会造成下游服务直接被写挂,所以最终还是要在 Sink处的并行度做一定的权衡。

2. 状态及 Checkpoint 调优

2.1. RocksDB 大状态调优

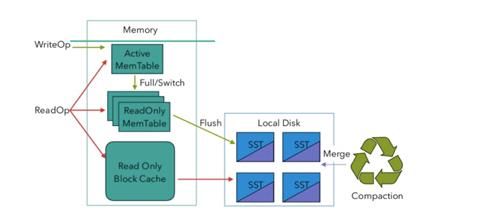

RocksDB 是基于 LSM Tree 实现的(类似 HBase),写数据都是先缓存到内存中,所以 RocksDB 的写请求效率比较高。RocksDB 使用内存结合磁盘的方式来存储数据,每次获取数据时,先从内存中的 blockcache 中查找,如果内存中没有再去磁盘中查询。使用 RocksDB 时,状态大小仅受可用磁盘空间量的限制,性能瓶颈主要在于 RocksDB 对磁盘的读请求,每次读写操作都必须对数据进行反序列化或者序列化。当处理性能不够时,仅需要横向扩展并行度即可提高整个 Job 的吞吐量。

从 Flink1.10 开始,Flink 默认将 RocksDB 的内存大小配置为每个 task slot 的托管内存。调试内存性能的问题主要是通过调整配置项 taskmanager.memory.managed.size,或者

taskmanager.memory.managed.fraction 以增加 Flink 的托管内存(即堆外的托管内存)。 进一步可以调整一些参数进行高级性能调优,这些参数也可以在应用程序中通过

RocksDBStateBackend.setRocksDBOptions(RocksDBOptionsFactory)指定。下面介绍提高资源利用率的几个重要配置。

2.1.1. 开启 State 访问性能监控

Flink 1.13 中引入了 State 访问的性能监控,即 latency trackig state。此功能不局限于 State Backend 的类型,自定义实现的 State Backend 也可以复用此功能。

State 访问的性能监控会产生一定的性能影响,所以默认每 100 次做一次取样(sample) ,对不同的 State Backend 性能损失影响不同:

-

对于 RocksDB State Backend,性能损失大概在 1% 左右

-

对于 Heap State Backend,性能损失最多可达 10%

#启用访问状态的性能监控 state.backend.latency-track.keyed-state-enabled: true #采样间隔 state.backend.latency-track.sample-interval: 100 #保留的采样数据个数,越大越精确 state.backend.latency-track.history-size: 128 #将状态名作为变量 state.backend.latency-track.state-name-as-variable: true

一般开启第一个参数即可。

bin/flink run \

-t yarn-per-job \

-d \

-p 5 \

-Drest.flamegraph.enabled=true \

-Dyarn.application.queue=test \

-Djobmanager.memory.process.size=1024mb \

-Dtaskmanager.memory.process.size=4096mb \

-Dtaskmanager.numberOfTaskSlots=2 \

-Dstate.backend.latency-track.keyed-state-enabled=true \

-c com.atguigu.flink.tuning.RocksdbTuning \

/opt/module/flink-1.13.1/myjar/flink-tuning-1.0-SNAPSHOT.jar

开启之后,即可通过 prometheus + grafana 来监控。

2.1.2. 开启增量检查点和本地恢复

-

开启增量检查点

RocksDB 是目前唯一可用于支持有状态流处理应用程序增量检查点的状态后端,可以修改参数开启增量检查点:#默认 false,改为 true。 state.backend.incremental:true或代码中指定

new EmbeddedRocksDBStateBackend(true) -

开启本地恢复

当 Flink 任务失败时,可以基于本地的状态信息进行恢复任务,可能不需要从 hdfs 拉取数据。本地恢复目前仅涵盖键控类型的状态后端(RocksDB),MemoryStateBackend 不支持本地恢复,可忽略此选项。state.backend.local-recovery: true -

设置多目录

如果有多块磁盘,也可以考虑指定本地多目录state.backend.rocksdb.localdir:/data1/flink/rocksdb,/data2/flink/rocksdb,/data3/flink/rocksdb注意:不要配置单块磁盘的多个目录,务必将目录配置到多块不同的磁盘上,让多块磁盘来分担压力。

bin/flink run \ -t yarn-per-job \ -d \ -p 5 \ -Drest.flamegraph.enabled=true \ -Dyarn.application.queue=test \ -Djobmanager.memory.process.size=1024mb \ -Dtaskmanager.memory.process.size=4096mb \ -Dtaskmanager.numberOfTaskSlots=2 \ -Dstate.backend.incremental=true \ -Dstate.backend.local-recovery=true \ -Dstate.backend.latency-track.keyed-state-enabled=true \ -c com.atguigu.flink.tuning.RocksdbTuning \ /opt/module/flink-1.13.1/myjar/flink-tuning-1.0-SNAPSHOT.jar

2.1.3. 调整预定义选项

Flink 针对不同的设置为 RocksDB 提供了一些预定义的选项集合,其中包含了后续提到的一些参数,如果调整预定义选项后还达不到预期,再去调整后面的 block、writebuffer 等参数。

当 前 支 持 的 预 定 义 选 项 有 DEFAULT、SPINNING_DISK_OPTIMIZED、SPINNING_DISK_OPTIMIZED_HIGH_MEM 或FLASH_SSD_OPTIMIZED。有条件上 SSD的 ,可以指定为 FLASH_SSD_OPTIMIZED

#设置为机械硬盘+内存模式

state.backend.rocksdb.predefined-options: SPINNING_DISK_OPTIMIZED_HIGH_MEM

2.1.4. 增大 block 缓存

整个 RocksDB 共享一个 block cache,读数据时内存的 cache 大小,该参数越大读数据时缓存命中率越高, 默认大小为 8 MB ,建议设置到 64 ~ 256 MB。

#默认 8m

state.backend.rocksdb.block.cache-size: 64m

2.1.5. 增大 write buffer 和 level 阈值大小

RocksDB 中,每个 State 使用一个 Column Family,每个 Column Family 使用独占的 write buffer ,默认 64MB ,建议调大。

调整这个参数通常要适当增加 L1 层的大小阈值 max-size-level-base,默认 256m。

该值太小会造成能存放的 SST 文件过少,层级变多造成查找困难,太大会造成文件过多,合并困难。建议设为 target_file_size_base(默认 64MB) 的倍数,且不能太小,例如 5~10倍,即

320~640MB。

state.backend.rocksdb.writebuffer.size: 128m

state.backend.rocksdb.compaction.level.max-size-level-base: 320m

2.1.6. 增大 write buffer 数量

每个 Column Family 对应的 writebuffer 最大数量 ,这实际上是内存中"只读内存表 "的最大数量,默认值是 2。对于机械磁盘来说,如果内存足够大,可以调大到 5 左右

state.backend.rocksdb.writebuffer.count: 5

2.1.7. 增大后台线程数和write buffer 合并数

-

增大线程数

用于后台 flush 和合并 sst 文件的线程数,默认为2,建议调大,机械硬盘用户可以改为 4 等更大的值tate.backend.rocksdb.thread.num: 4 -

增大 writebuffer 最小合并数

将数据从 writebuffer 中 flush 到磁盘时,需要合并的 writebuffer 最小数量,默认值为 1,可以调成 3。state.backend.rocksdb.writebuffer.number-to-merge: 3

2.1.8. 开启分区索引功能

Flink 1.13 中对 RocksDB 增加了分区索引功能 ,复用了 RocksDB 的 partitioned Index & filter 功能,简单来说就是对 RocksDB 的 partitioned Index 做了多级索引。

也就是将内存中的最上层常驻,下层根据需要再 load 回来,这样就大大降低了数据 Swap 竞争。线上测试中,相对于内存比较小的场景中,性能提升 10 倍左右。如果在内存管控下 Rocksdb 性能不如预期的话,这也能成为一个性能优化点。

#默认 false

state.backend.rocksdb.memory.partitioned-index-filters:true

2.1.9. 参数设定案例

bin/flink run \

-t yarn-per-job \

-d \

-p 5 \

-Drest.flamegraph.enabled=true \

-Dyarn.application.queue=test \

-Djobmanager.memory.process.size=1024mb \

-Dtaskmanager.memory.process.size=4096mb \

-Dtaskmanager.numberOfTaskSlots=2 \

-Dstate.backend.incremental=true \

-Dstate.backend.local-recovery=true \

-Dstate.backend.rocksdb.predefined-options=SPINNING_DISK_OPTIMIZED_HIGH_MEM \ -Dstate.backend.rocksdb.block.cache-size=64m \

-Dstate.backend.rocksdb.writebuffer.size=128m \

-Dstate.backend.rocksdb.compaction.level.max-size-level-base=320m \

-Dstate.backend.rocksdb.writebuffer.count=5 \

-Dstate.backend.rocksdb.thread.num=4 \

-Dstate.backend.rocksdb.writebuffer.number-to-merge=3 \

-Dstate.backend.rocksdb.memory.partitioned-index-filters=true \

-Dstate.backend.latency-track.keyed-state-enabled=true \

-c com.atguigu.flink.tuning.RocksdbTuning \

/opt/module/flink-1.13.1/myjar/flink-tuning-1.0-SNAPSHOT.jar

2.2. Checkpoint 设置

一般需求,我们的 Checkpoint 时间间隔可以设置为分钟级别 (1 ~5 分钟)。对于状态很大的任务,每次 Checkpoint 访问 HDFS 比较耗时,可以设置为 5~10 分钟一次 Checkpoint,并且调大两次 Checkpoint 之间的暂停间隔,例如设置两次 Checkpoint 之间至少暂停 4 或 8 分钟。同时,也需要考虑时效性的要求,需要在时效性和性能之间做一个平衡,如果时效性要求高,结合 end- to-end 时长, 设置秒级或毫秒级。如果 Checkpoint 语义配置为EXACTLY_ONCE,那么在 Checkpoint 过程中还会存在 barrier 对齐的过程,可以通过 Flink Web UI 的 Checkpoint 选项卡来查看 Checkpoint 过程中各阶段的耗时情况,从而确定到底是哪个阶段导致 Checkpoint 时间过长然后针对性的解决问题。

RocksDB 相关参数在前面已说明,可以在 flink-conf.yaml 指定,也可以在 Job 的代码中调用 API 单独指定,这里不再列出。

// 使⽤ RocksDBStateBackend 做为状态后端, 并开启增量 Checkpoint

RocksDBStateBackend rocksDBStateBackend = new RocksDBStateBackend("hdfs://hadoop1:8020/flink/checkpoints", true);

env.setStateBackend(rocksDBStateBackend);

// 开启 Checkpoint , 间隔为 3 分钟

env.enableCheckpointing(TimeUnit.MINUTES.toMillis(3));

// 配置 Checkpoint

CheckpointConfig checkpointConf = env.getCheckpointConfig();

checkpointConf.setCheckpointingMode(CheckpointingMode.EXACTLY_ONCE); // 最小间隔 4 分钟

checkpointConf.setMinPauseBetweenCheckpoints(TimeUnit.MINUTES.toMillis(4)); // 超时时间 10 分钟

checkpointConf.setCheckpointTimeout(TimeUnit.MINUTES.toMillis(10));

// 保存 checkpoint

checkpointConf.enableExternalizedCheckpoints(CheckpointConfig.ExternalizedCheckpointCleanup.RETAIN_ON_CANCELLATION);

3.1. 反压

Flink 网络流控及反压的介绍:[https://flink-learning.org.cn/article/detail/138316d1556f8f9d34e517d04d670626]{.underline}

3.1.1. 反压的理解

简单来说, Flink 拓扑中每个节点(Task)间的数据都以阻塞队列的方式传输,下游来不及消费导致队列被占满后,上游的生产也会被阻塞,最终导致数据源的摄入被阻塞。

反压(BackPressure)通常产生于这样的场景:短时间的负载高峰导致系统接收数据的速率远高于它处理数据的速率。许多日常问题都会导致反压,例如,垃圾回收停顿可能会导致流入的数据快速堆积,或遇到大促、秒杀活动导致流量陡增。

3.1.2. 反压的危害

反压如果不能得到正确的处理,可能会影响到 checkpoint 时长和 state 大小,甚至可能会导致资源耗尽甚至系统崩溃。

-

影响 checkpoint 时长:barrier 不会越过普通数据,数据处理被阻塞也会导致 checkpoint barrier 流经整个数据管道的时长变长,导致 checkpoint 总体时间(End to End Duration)变长。

-

影响 state 大小: barrier 对齐时,接受到较快的输入管道的 barrier 后,它后面数据会被缓存起来但不处理,直到较慢的输入管道的 barrier 也到达,这些被缓存的数据会被放到 state 里面,导致 checkpoint 变大。

这两个影响对于生产环境的作业来说是十分危险的,因为 checkpoint 是保证数据一致性的关键,checkpoint 时间变长有可能导致 checkpoint 超时失败,而 state 大小同样可能拖慢 checkpoint 甚至导致 OOM (使用Heap-based StateBackend) 或者物理内存使用超出容器资源 (使用 RocksDBStateBackend)的稳定性问题。

因此,我们在生产中要尽量避免出现反压的情况。

3.2. 定位反压节点

解决反压首先要做的是定位到造成反压的节点, 排查的时候, 先把 operator chain 禁用,方便定位到具体算子。

提交 UvDemo:

bin/flink run \

-t yarn-per-job \

-d \

-p 5 \

-Drest.flamegraph.enabled=true \

-Dyarn.application.queue=test \

-Djobmanager.memory.process.size=1024mb \

-Dtaskmanager.memory.process.size=2048mb \

-Dtaskmanager.numberOfTaskSlots=2 \

-c com.atguigu.flink.tuning.UvDemo \

/opt/module/flink-1.13.1/myjar/flink-tuning-1.0-SNAPSHOT.jar

3.2.1. 利用 Flink Web UI 定位

Flink Web UI 的反压监控提供了 SubTask 级别的反压监控,1.13 版本以前是通过周期性对 Task 线程的栈信息采样,得到线程被阻塞在请求 Buffer(意味着被下游队列阻塞)的频率来判断该节点是否处于反压状态。默认配置下,这个频率在 0.1 以下则为 OK,0.1至 0.5 为 LOW,而超过 0.5 则为 HIGH。

Flink 1.13 优化了反压检测的逻辑(使用基于任务 Mailbox 计时,而不在再于堆栈采样) ,并且重新实现了作业图的 UI 展示:Flink 现在在 UI 上通过颜色和数值来展示繁忙和反压的程度。

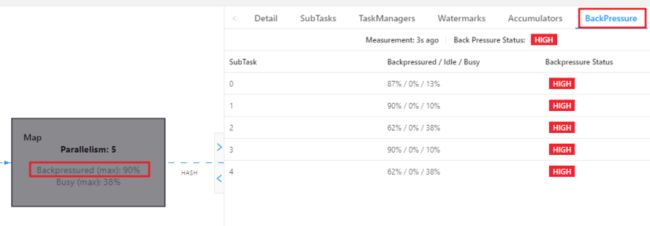

通过 WebUI 看到 Map 算子处于反压:

分析瓶颈算子

如果处于反压状态,那么有两种可能性:

- 该节点的发送速率跟不上它的产生数据速率。这一般会发生在一条输入多条输出的 Operator(比如 flatmap)。这种情况,该节点是反压的根源节点,它是从 Source Task 到 Sink Task

的第一个出现反压的节点。 - 下游的节点接受速率较慢,通过反压机制限制了该节点的发送速率。这种情况,需要继续排查下游节点,一直找到第一个为 OK 的一般就是根源节点。

总体来看,如果我们找到第一个出现反压的节点,反压根源要么是就这个节点,要么是它紧接着的下游节点。

通常来讲,第二种情况更常见。如果无法确定,还需要结合 Metrics 进一步判断。

3.2.2. 利用 Metrics 定位

监控反压时会用到的 Metrics 主要和 Channel 接受端的 Buffer 使用率有关,最为有用的是以下几个 Metrics:

| Metris | 描述 |

|---|---|

| outPoolUsage | 发送端 Buffer 的使用率 |

| inPoolUsage | 接收端 Buffer 的使用率 |

| floatingBuffersUsage(1.9 以上) | 接收端 Floating Buffer 的使用率 |

| exclusiveBuffersUsage (1.9 以上) | 接收端 Exclusive Buffer 的使用率 |

根据指标分析反压

分析反压的大致思路是:如果一个 Subtask 的发送端 Buffer 占用率很高,则表明它被下游反压限速了;如果一个 Subtask 的接受端 Buffer 占用很高,则表明它将反压传导至上游。反压情况可以根据以下表格进行对号入座(1.9以上)

| outPoolUsage 低 | outPoolUsage 高 | |

|---|---|---|

| inPoolUsage 低 | 正常 | 被下游反压,处于临时情况(还没传递到上游) |

| 可能是反压的根源,一条输入,多条输出的场景 | ||

| inPoolUsage 高 | 如果上游所有 outPoolUsage 都是低,有可能最终可能导致反压(还没传递到上游) | 被下游反压 |

| 如果上游的 outPoolUsage 是高,则为反压根源 |

可以进一步分析数据传输

Flink 1.9 及以上版本,还可以根据 floatingBuffersUsage/exclusiveBuffersUsage 以及其上游 Task 的 outPoolUsage 来进行进一步的分析一个 Subtask 和其上游 Subtask的数据传输。

在流量较大时,Channel 的 Exclusive Buffer 可能会被写满,此时 Flink 会向 BufferPool 申请剩余的 Floating Buffer。这些 Floating Buffer 属于备用 Buffer。

| exclusiveBuffersUsage 低 | exclusiveBuffersUsage 高 | |

|---|---|---|

| floatingBuffersUsage 低 所有上游 outPoolUsage 低 | 正常 | |

| floatingBuffersUsage 低 上游某个 outPoolUsage 高 | 潜在的网络瓶颈 | |

| floatingBuffersUsage 高 所有上游 outPoolUsage 低 | 最终对部分 inputChannel 反压 (正在传递) | 最终对大多数或所有 inputChannel 反压 (正在传递) |

| floatingBuffersUsage 高 上游某个 outPoolUsage 高 | 只对部分 inputChannel 反压 | 对大多数或所有 inputChannel 反压 |

总结:

-

floatingBuffersUsage 为高,则表明反压正在传导至上游

-

同时 exclusiveBuffersUsage 为低 , 则表明可能有倾斜,比如, floatingBuffersUsage 高、 exclusiveBuffersUsage 低为有倾斜,因为少数 channel 占用了大部分的 Floating Buffer。

3.3. 反压的原因及处理

注意:反压可能是暂时的,可能是由于负载高峰、 CheckPoint 或作业重启引起的数据积压而导致反压。如果反压是暂时的,应该忽略它。另外,请记住,断断续续的反压会影响我们分析和解决问题。

定位到反压节点后,分析造成原因的办法主要是观察 Task Thread。按照下面的顺序,一步一步去排查。

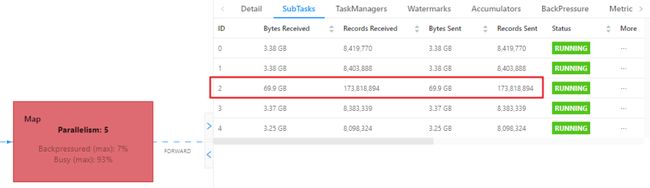

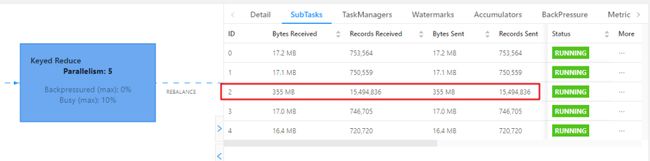

3.3.1. 查看是否数据倾斜

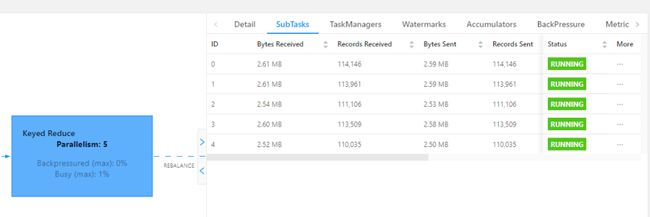

在实践中,很多情况下的反压是由于数据倾斜造成的,这点我们可以通过 Web UI 各个 SubTask 的 Records Sent 和 Record Received 来确认,另外 Checkpoint detail 里不同 SubTask 的 State size 也是一个分析数据倾斜的有用指标。

(关于数据倾斜的详细解决方案,会在下一章节详细讨论)

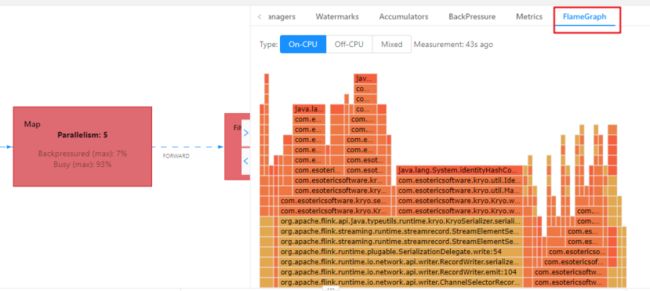

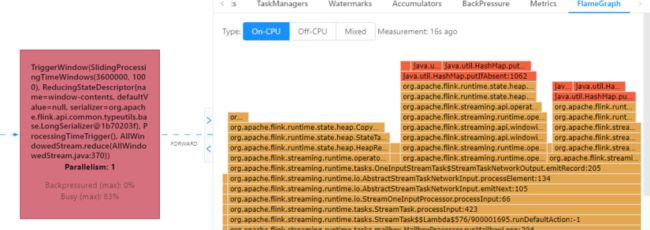

3.3.2. 使用火焰图分析

如果不是数据倾斜,最常见的问题可能是用户代码的执行效率问题(频繁被阻塞或者性能问题),需要找到瓶颈算子中的哪部分计算逻辑消耗巨大。

最有用的办法就是对 TaskManager 进行 CPU profile,从中我们可以分析到 Task Thread 是否跑满一个 CPU 核:如果是的话要分析 CPU 主要花费在哪些函数里面;如果不是的话要看 Task Thread 阻塞在哪里,可能是用户函数本身有些同步的调用,可能是 checkpoint 或者 GC 等系统活动导致的暂时系统暂停。

-

开启火焰图功能

Flink 1.13 的 WebUI 提供 JVM 的 CPU 火焰图,这将大大简化性能瓶颈的分析,默认是不开启的,需要修改参数:默认 false rest.flamegraph.enabled:true也可以在提交时指定:

bin/flink run \ -t yarn-per-job \ -d \ -p 5 \ -Drest.flamegraph.enabled=true \ -Dyarn.application.queue=test \ -Drest.flamegraph.enabled=true \ -Djobmanager.memory.process.size=1024mb \ -Dtaskmanager.memory.process.size=2048mb \ -Dtaskmanager.numberOfTaskSlots=2 \ -c com.atguigu.flink.tuning.UvDemo \ /opt/module/flink-1.13.1/myjar/flink-tuning-1.0-SNAPSHOT.jar -

火焰图是通过对堆栈跟踪进行多次采样来构建的。每个方法调用都由一个条形表示,其中条形的长度与其在样本中出现的次数成正比。

-

On-CPU: 处于 [RUNNABLE, NEW] 状态的线程

-

Off-CPU: 处于 [TIMED_WAITING, WAITING, BLOCKED] 的线程,用于查看在样本中发现的阻塞调用。

-

-

分析火焰图

颜色没有特殊含义,具体查看:

-

纵向是调用链,从下往上,顶部就是正在执行的函数

-

横向是样本出现次数,可以理解为执行时长。

看顶层的哪个函数占据的宽度最大。只要有"平顶"(plateaus),就表示该函数可能存在性能问题。

-

如果是 Flink 1.13 以前的版本, 可以手动做火焰图:

如何生成火焰图:http://www.54tianzhisheng.cn/2020/10/05/flink-jvm-profiler/

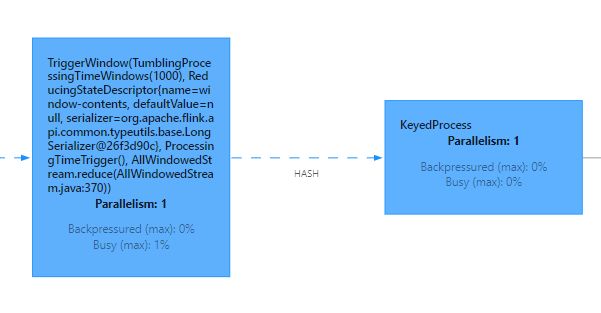

3.3.3. 分析 GC 情况

TaskManager 的内存以及 GC 问题也可能会导致反压,包括 TaskManager JVM 各区内存不合理导致的频繁 Full GC 甚至失联。通常建议使用默认的 G1 垃圾回收器。

可以通过打印 GC 日志(-XX:+PrintGCDetails) ,使用 GC 分析器(GCViewer 工具)来验证是否处于这种情况。

-

在 Flink 提交脚本中,设置 JVM参数,打印 GC 日志:

bin/flink run \ -t yarn-per-job \ -d \ -p 5 \ -Drest.flamegraph.enabled=true \ -Denv.java.opts="-XX:+PrintGCDetails -XX:+PrintGCDateStamps" \ -Dyarn.application.queue=test \ -Djobmanager.memory.process.size=1024mb \ -Dtaskmanager.memory.process.size=2048mb \ -Dtaskmanager.numberOfTaskSlots=2 \ -c com.atguigu.flink.tuning.UvDemo \ /opt/module/flink-1.13.1/myjar/flink-tuning-1.0-SNAPSHOT.jar -

下载 GC 日志的方式:

因为是 on yarn 模式,运行的节点一个一个找比较麻烦。 可以打开 WebUI,选择 JobManager 或者 TaskManager,点击 Stdout,即可看到 GC 日志,点击下载按钮即可将 GC 日志通过 HTTP 的方式下载下来。

-

分析 GC 日志:

通过 GC 日志分析出单个 Flink Taskmanager 堆总大小、年轻代、老年代分配的内存空间、 Full GC 后老年代剩余大小等,相关指标定义可以去 Github 具体查看。

GCViewer 地址: https://github.com/chewiebug/GCViewer

Linux 下分析:java -jar gcviewer_1.3.4.jar gc.logWindows 下分析:直接双击 gcviewer_1.3.4.jar,打开 GUI 界面, 选择 gc 的 log 打开

扩展:最重要的指标是 Full GC 后,老年代剩余大小这个指标, 按照《Java性能优化权威指南》这本书 Java 堆大小计算法则,设 Full GC 后老年代剩余大小空间为 M,那么堆的大小建议 3 ~ 4倍 M,新生代为 1 ~ 1.5 倍 M, 老年代应为 2 ~ 3 倍 M。

3.3.4. 外部组件交互

如果发现我们的 Source 端数据读取性能比较低或者 Sink 端写入性能较差,需要检查第三方组件是否遇到瓶颈,还有就是做维表 join 时的性能问题。

例如:

- Kafka 集群是否需要扩容, Kafka 连接器是否并行度较低

- HBase 的 rowkey 是否遇到热点问题,是否请求处理不过来

- ClickHouse 并发能力较弱,是否达到瓶颈

- …

关于第三方组件的性能问题,需要结合具体的组件来分析,最常用的思路:

-

异步 io+热缓存 来优化读写性能

-

先攒批再读写

维表 join 参考:

- https://flink-learning.org.cn/article/detail/b8df32fbc6542257a5b449114e137cc3

- https://www.jianshu.com/p/a62fa483ff54

4. 数据倾斜

4.1. 判断是否存在数据倾斜

相同 Task 的多个 Subtask 中,个别 Subtask 接收到的数据量明显大于其他 Subtask 接收到的数据量,通过 Flink Web UI 可以精确地看到每个 Subtask 处理了多少数据,即可判断出 Flink 任务是否存在数据倾斜。通常,数据倾斜也会引起反压。

另外,有时 Checkpoint detail 里不同 SubTask 的 State size 也是一个分析数据倾斜的有用指标。

4.2. 数据倾斜的解决

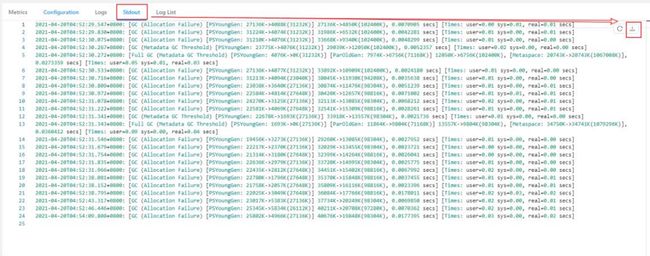

4.2.1. keyBy 后的聚合操作存在数据倾斜

提交案例:

bin/flink run \

-t yarn-per-job \

-d \

-p 5 \

-Drest.flamegraph.enabled=true \

-Dyarn.application.queue=test \

-Djobmanager.memory.process.size=1024mb \

-Dtaskmanager.memory.process.size=2048mb \

-Dtaskmanager.numberOfTaskSlots=2 \

-c com.atguigu.flink.tuning.SkewDemo1 \

/opt/module/flink-1.13.1/myjar/flink-tuning-1.0-SNAPSHOT.jar \

--local-keyby false

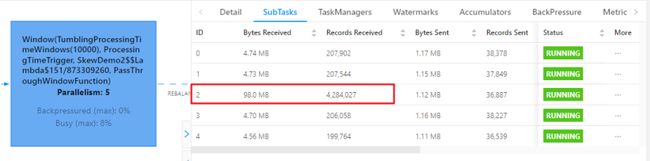

查看 webui:

-

为什么不能直接用二次聚合来处理

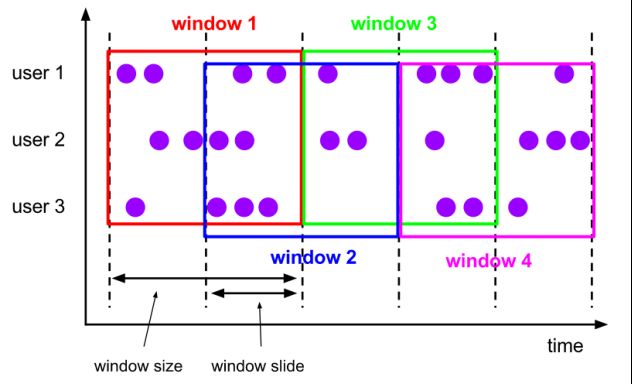

Flink 是实时流处理,如果 keyby 之后的聚合操作存在数据倾斜,且没有开窗口(没攒批)的情况下,简单的使用两阶段聚合,是不能解决问题的。因为这个时候 Flink 是来一条处理一条,且向下游发送一条结果,对于原来 keyby 的维度(第二阶段聚合)来讲,数据量并没有减少,且结果重复计算(非 FlinkSQL,未使用回撤流),如下图所示:

-

使用 LocalKeyBy 的思想

在 keyBy 上游算子数据发送之前,首先在上游算子的本地对数据进行聚合后,再发送到下游,使下游接收到的数据量大大减少,从而使得 keyBy 之后的聚合操作不再是任务的瓶颈。类似 MapReduce 中 Combiner 的思想,但是这要求聚合操作必须是多条数据或者一批数据才能聚合,单条数据没有办法通过聚合来减少数据量。从 Flink LocalKeyBy 实现原理来讲,必然会存在一个积攒批次的过程,在上游算子中必须攒够一定的数据量,对这些数据聚合后再发送到下游。

实现方式:-

DataStreamAPI 需要自己写代码实现

-

SQL 可以指定参数,开启 miniBatch 和 LocalGlobal 功能(推荐,后续介绍)

-

-

DataStream API 自定义实现的案例

以计算每个 mid 出现的次数为例,keyby 之前,使用 flatMap 实现 LocalKeyby 功能/** * 第一个泛型是输入值,第一个元素是单词,第二个元素是单词出现的次数

* 第一个泛型是输出值,第一个元素是单词,第二个元素是单词出现的次数

* * @author ziqiang.wang * @date 2022-04-30 15:10 **/ public class LocalKeyByFlatMapFunc extends RichFlatMapFunction<Tuple2<String, Long>, Tuple2<String, Long>> implements CheckpointedFunction { //Checkpoint 时为了保证 Exactly Once,将 buffer 中的数据保存到该 ListState 中 private ListState<Tuple2<String, Long>> listState; //本地 buffer,存放 local 端缓存的 mid 的 count 信息,实现实时累加计算结果 private HashMap<String, Long> localBuffer; //缓存的数据量大小,即:缓存多少数据再向下游发送 private final int batchSize; //计数器,获取当前批次接收的数据量,其实可以直接使用 integer ,因为每个子任务,都会单独 new 一个该对象,因此不会有线程问题 private AtomicInteger currentSize; //构造器,批次大小传参 public LocalKeyByFlatMapFunc(int batchSize) { this.batchSize = batchSize; } @Override public void flatMap(Tuple2<String, Long> value, Collector<Tuple2<String, Long>> out) throws Exception { // 1、将新来的数据累加到本地 buffer 中 Long count = localBuffer.getOrDefault(value.f0, 0L); localBuffer.put(value.f0, count + 1); // 2、如果到达设定的批次,则将 buffer 中的数据发送到下游 if (currentSize.incrementAndGet() >= batchSize) { // 2.1 遍历 Buffer 中数据,发送到下游 for (Map.Entry<String, Long> midAndCount : localBuffer.entrySet()) { out.collect(Tuple2.of(midAndCount.getKey(), midAndCount.getValue())); } // 2.2 Buffer 清空,计数器清零 localBuffer.clear(); currentSize.set(0); } } /** * 触发 checkpoint 时的逻辑 */ @Override public void snapshotState(FunctionSnapshotContext context) throws Exception { // 将本地 buffer 中的数据保存到状态中,来保证 Exactly Once listState.clear(); for (Map.Entry<String, Long> midAndCount : localBuffer.entrySet()) { listState.add(Tuple2.of(midAndCount.getKey(), midAndCount.getValue())); } } /** * 初始化,或从 checkpoint 恢复时的逻辑 */ @Override public void initializeState(FunctionInitializationContext context) throws Exception { // 从状态中恢复 buffer 中的数据 listState = context.getOperatorStateStore().getListState( new ListStateDescriptor<>("localBufferState", Types.TUPLE(Types.STRING, Types.LONG)) ); localBuffer = new HashMap<>(); if (context.isRestored()) { // 从状态中恢复数据到本地 buffer 中 for (Tuple2<String, Long> midAndCount : listState.get()) { // 如果出现次数 !=0,说明改变了并行度, ListState 中的数据会被均匀分发到新的 subtask 中 // 单个 subtask 恢复的状态中可能包含多个相同的 mid 的 count 数据 // 所以每次先取一下 buffer 的值,累加再 put long count = localBuffer.getOrDefault(midAndCount.f0, 0L); localBuffer.put(midAndCount.f0, count + midAndCount.f1); } // 从状态恢复时,默认认为本地 buffer 中数据量达到了 batchSize, 需要向下游发送结果数据 currentSize = new AtomicInteger(batchSize); } else { currentSize = new AtomicInteger(0); } } }

提交 localkeyby 案例:

bin/flink run \

-t yarn-per-job \

-d \

-p 5 \

-Drest.flamegraph.enabled=true \

-Dyarn.application.queue=test \

-Djobmanager.memory.process.size=1024mb \

-Dtaskmanager.memory.process.size=2048mb \

-Dtaskmanager.numberOfTaskSlots=2 \

-c com.atguigu.flink.tuning.SkewDemo1 \

/opt/module/flink-1.13.1/myjar/flink-tuning-1.0-SNAPSHOT.jar \

--local-keyby true

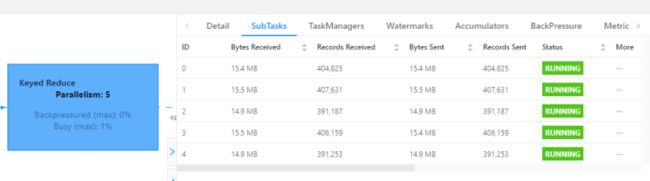

查看 webui:

可以看到每个 subtask 处理的数据量基本均衡,另外处理的数据量相比原先少了很多。

4.2.2. keyBy 之前发生数据倾斜

如果 keyBy 之前就存在数据倾斜,上游算子的某些实例可能处理的数据较多,某些实例可能处理的数据较少,产生该情况可能是因为数据源的数据本身就不均匀,例如由于某些原因,Kafka

的 topic 中某些 partition 的数据量较大,某些 partition 的数据量较少。

对于不存在 keyBy 的 Flink 任务也会出现该情况。

这种情况,需要让 Flink 任务强制进行 shuffle。使用 shuffle、rebalance 或 rescale 算子即可将数据均匀分配,从而解决数据倾斜的问题。

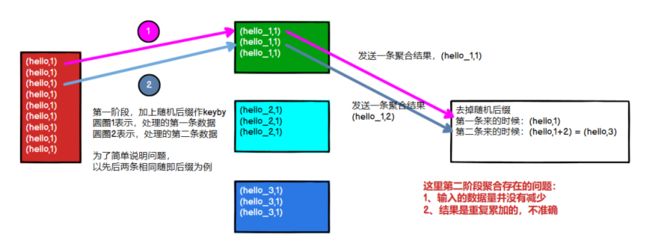

4.2.3. keyBy 后的窗口聚合操作存在数据倾斜

因为使用了窗口,变成了有界数据(攒批)的处理,窗口默认是触发时才会输出一条结果发往下游,所以可以使用两阶段聚合的方式:

-

实现思路:

-

第一阶段聚合:key 拼接随机数前缀或后缀,进行 keyby、开窗、聚合

注意:聚合完不再是 WindowedStream ,要获取 WindowEnd 作为窗口标记作为第二阶段分组依据,避免不同窗口的结果聚合到一起 -

第二阶段聚合:按照原来的 key 及 windowEnd 作 keyby 聚合

public class SkewDemo2 { public static void main(String[] args) throws Exception { StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment(); env.disableOperatorChaining(); SingleOutputStreamOperator<JSONObject> jsonobjDS = env // MockSourceFunction ,该类会不断产生 json 类型的随机字符串 .addSource(new MockSourceFunction()) .map(data -> JSONObject.parseObject(data)); // 过滤出 页面数据,转换成 (mid,1L) SingleOutputStreamOperator<Tuple2<String, Long>> pageMidTuple = jsonobjDS .filter(data -> StringUtils.isEmpty(data.getString("start"))) .map(r -> Tuple2.of(r.getJSONObject("common").getString("mid"), 1L)) .returns(Types.TUPLE(Types.STRING, Types.LONG)); // 按照mid分组,统计每10s,各mid出现的次数 ParameterTool parameterTool = ParameterTool.fromArgs(args); int randomNum = parameterTool.getInt("random-num", 5); // 拼接随机数打散,第一次聚合(窗口聚合) SingleOutputStreamOperator<Tuple3<String, Long, Long>> firstAgg = pageMidTuple .map(new MapFunction<Tuple2<String, Long>, Tuple2<String, Long>>() { Random random = new Random(); @Override public Tuple2<String, Long> map(Tuple2<String, Long> value) throws Exception { return Tuple2.of(value.f0 + "-" + random.nextInt(randomNum), 1L); } }) // mid拼接随机数 .keyBy(r -> r.f0) // 第一次按照 "mid|随机数" 分组 .window(TumblingProcessingTimeWindows.of(Time.seconds(10))) .reduce( (value1, value2) -> Tuple2.of(value1.f0, value1.f1 + value2.f1), new ProcessWindowFunction<Tuple2<String, Long>, Tuple3<String, Long, Long>, String, TimeWindow>() { @Override public void process(String s, Context context, Iterable<Tuple2<String, Long>> elements, Collector<Tuple3<String, Long, Long>> out) throws Exception { Tuple2<String, Long> midAndCount = elements.iterator().next(); long windowEndTs = context.window().getEnd(); out.collect(Tuple3.of(midAndCount.f0, midAndCount.f1, windowEndTs)); } } ); // 窗口聚合(第一次聚合),加上窗口结束时间的标记,方便第二次聚合汇总 // 按照原来的 key和windowEnd分组,第二次聚合 firstAgg .map(new MapFunction<Tuple3<String, Long, Long>, Tuple3<String, Long, Long>>() { @Override public Tuple3<String, Long, Long> map(Tuple3<String, Long, Long> value) throws Exception { String originKey = value.f0.split("-")[0]; return Tuple3.of(originKey, value.f1, value.f2); } }) // 去掉 拼接的随机数 .keyBy(new KeySelector<Tuple3<String, Long, Long>, Tuple2<String, Long>>() { @Override public Tuple2<String, Long> getKey(Tuple3<String, Long, Long> value) throws Exception { return Tuple2.of(value.f0, value.f2); } }) // 按照 原来的 key和 窗口结束时间 分组 .reduce((value1, value2) -> Tuple3.of(value1.f0, value1.f1 + value2.f1, value1.f2)) // 第二次真正聚合 .print().setParallelism(1); env.execute(); } }

-

-

提交原始案例

bin/flink run \ -t yarn-per-job \ -d \ -p 5 \ -Drest.flamegraph.enabled=true \ -Dyarn.application.queue=test \ -Djobmanager.memory.process.size=1024mb \ -Dtaskmanager.memory.process.size=2048mb \ -Dtaskmanager.numberOfTaskSlots=2 \ -c com.atguigu.flink.tuning.SkewDemo2 \ /opt/module/flink-1.13.1/myjar/flink-tuning-1.0-SNAPSHOT.jar \ --two-phase false -

提交两阶段聚合的案例

bin/flink run \ -t yarn-per-job \ -d \ -p 5 \ -Drest.flamegraph.enabled=true \ -Dyarn.application.queue=test \ -Djobmanager.memory.process.size=1024mb \ -Dtaskmanager.memory.process.size=2048mb \ -Dtaskmanager.numberOfTaskSlots=2 \ -c com.atguigu.flink.tuning.SkewDemo2 \ /opt/module/flink-1.13.1/myjar/flink-tuning-1.0-SNAPSHOT.jar \ --two-phase true \ --random-num 16

随机数范围,需要自己去测,因为 keyby 的分区器是:两次hash*下游并行度/最大并行度

注:如果是数据中包含了事件时间,是可以不使用两次 keyBy 操作来解决数据倾斜的,直接将数据的时间归算到窗口的结束时间点,然后将时间也作为 key 的一部分,在 keyBy 之前进行 localKeyBy 聚合,也能减少窗口需要进行计算的数据量。

SQL 写法参考,Flink教程-keyby 窗口数据倾斜的优化:https://zhuanlan.zhihu.com/p/197299746

5. Job 优化

5.1. 使用 DataGen 造数据

开发完 Flink 作业,压测的方式很简单,先在 kafka 中积压数据,之后开启 Flink 任务,出现反压,就是处理瓶颈。相当于水库先积水,一下子泄洪。

数据可以是自己造的模拟数据,也可以是生产中的部分数据。造测试数据的工具:DataFactory、datafaker 、 DBMonster、 Data-Processer 、 Nexmark、 Jmeter 等。

Flink 从 1.11 开始提供了一个内置的 DataGen 连接器,主要是用于生成一些随机数,用于在没有数据源的时候,进行流任务的测试以及性能测试等。

5.1.1. DataStream 的 DataGenerator

public class DataStreamDataGenDemo {

public static void main(String[] args) throws Exception {

Configuration conf = new Configuration();

conf.set(RestOptions.ENABLE_FLAMEGRAPH, true);

StreamExecutionEnvironment env = StreamExecutionEnvironment.createLocalEnvironmentWithWebUI(conf);

env.setParallelism(1);

env.disableOperatorChaining();

SingleOutputStreamOperator<OrderInfo> orderInfoDS = env

.addSource(new DataGeneratorSource<>(

new RandomGenerator<OrderInfo>() {

@Override

public OrderInfo next() {

// OrderInfo ,一个 pojo 类

return new OrderInfo(

random.nextInt(1, 100000),

random.nextLong(1, 1000000),

random.nextUniform(1, 1000),

System.currentTimeMillis());

}

}

))

.returns(Types.POJO(OrderInfo.class));

SingleOutputStreamOperator<UserInfo> userInfoDS = env

.addSource(new DataGeneratorSource<UserInfo>(

new SequenceGenerator<UserInfo>(1, 1000000) {

RandomDataGenerator random = new RandomDataGenerator();

@Override

public UserInfo next() {

// UserInfo ,一个 pojo 类

return new UserInfo(

valuesToEmit.peek().intValue(),

valuesToEmit.poll().longValue(),

random.nextInt(1, 100),

random.nextInt(0, 1));

}

}

))

.returns(Types.POJO(UserInfo.class));

orderInfoDS.print("order>>");

userInfoDS.print("user>>");

env.execute();

}

}

5.1.2. SQL 的 DataGenerator

public class SQLDataGenDemo {

public static void main(String[] args) throws Exception {

Configuration conf = new Configuration();

conf.set(RestOptions.ENABLE_FLAMEGRAPH, true);

StreamExecutionEnvironment env = StreamExecutionEnvironment.createLocalEnvironmentWithWebUI(conf);

env.setParallelism(1);

env.disableOperatorChaining();

StreamTableEnvironment tableEnv = StreamTableEnvironment.create(env);

String orderSql="CREATE TABLE order_info (\n" +

" id INT,\n" +

" user_id BIGINT,\n" +

" total_amount DOUBLE,\n" +

" create_time AS localtimestamp,\n" +

" WATERMARK FOR create_time AS create_time\n" +

") WITH (\n" +

" 'connector' = 'datagen',\n" +

" 'rows-per-second'='20000',\n" +

" 'fields.id.kind'='sequence',\n" +

" 'fields.id.start'='1',\n" +

" 'fields.id.end'='100000000',\n" +

" 'fields.user_id.kind'='random',\n" +

" 'fields.user_id.min'='1',\n" +

" 'fields.user_id.max'='1000000',\n" +

" 'fields.total_amount.kind'='random',\n" +

" 'fields.total_amount.min'='1',\n" +

" 'fields.total_amount.max'='1000'\n" +

")";

String userSql="CREATE TABLE user_info (\n" +

" id INT,\n" +

" user_id BIGINT,\n" +

" age INT,\n" +

" sex INT\n" +

") WITH (\n" +

" 'connector' = 'datagen',\n" +

" 'rows-per-second'='20000',\n" +

" 'fields.id.kind'='sequence',\n" +

" 'fields.id.start'='1',\n" +

" 'fields.id.end'='100000000',\n" +

" 'fields.user_id.kind'='sequence',\n" +

" 'fields.user_id.start'='1',\n" +

" 'fields.user_id.end'='1000000',\n" +

" 'fields.age.kind'='random',\n" +

" 'fields.age.min'='1',\n" +

" 'fields.age.max'='100',\n" +

" 'fields.sex.kind'='random',\n" +

" 'fields.sex.min'='0',\n" +

" 'fields.sex.max'='1'\n" +

")";

tableEnv.executeSql(orderSql);

tableEnv.executeSql(userSql);

tableEnv.executeSql("select * from order_info").print();

}

}

5.2. 算子指定 UUID

对于有状态的 Flink 应用,推荐给每个算子都指定唯一 ID(UUID)。

严格地说,仅需要给有状态的算子设置就足够了。但是因为 Flink 的某些内置算子(如window)是有状态的,而有些是无状态的,可能用户不是很清楚哪些内置算子是有状态的,哪些不是。

所以从实践经验上来说,我们建议每个算子都指定上 UUID。

默认情况下,算子 UID 是根据 JobGraph 自动生成的, JobGraph 的更改可能会导致 UUID 改变。手动指定算子 UUID ,可以让 Flink有效地将算子的状态从 savepoint 映射到作业修改后(拓扑图可能也有改变)的正确的算子上。比如替换原来的 Operator 实现、增加新的Operator、删除 Operator 等等,至少我们有可能与 Savepoint 中存储的 Operator 状态对应上。这是 savepoint 在 Flink 应用中正常工作的一个基本要素。

Flink 算子的 UUID 可以通过 uid(String uid) 方法指定,通常也建议指定 name。

算子.uid("指定 uid")

.reduce((value1, value2) - > Tuple3.of("uv", value2.f1, value1.f2 + value2.f2))

.uid("uv-reduce").name("uv-reduce")

提交案例:未指定 uid

bin/flink run \

-t yarn-per-job \

-d \

-p 5 \

-Drest.flamegraph.enabled=true \

-Dyarn.application.queue=test \

-Djobmanager.memory.process.size=1024mb \

-Dtaskmanager.memory.process.size=2048mb \

-Dtaskmanager.numberOfTaskSlots=2 \

-c com.atguigu.flink.tuning.UvDemo \

/opt/module/flink-1.13.1/myjar/flink-tuning-1.0-SNAPSHOT.jar

触发保存点:

#直接触发

flink savepoint <jobId> [targetDirectory] [-yid yarnAppId] #on yarn 模式需要指定-yid 参数

# //cancel 触发

flink cancel -s [targetDirectory] <jobId> [-yid yarnAppId] #on yarn 模式需要指定-yid 参数

bin/flink cancel -s hdfs://hadoop1:8020/flink-tuning/sp 98acff568e8f0827a67ff37648a29d7f -yid application_1640503677810_0017

修改代码,从 savepoint 恢复:

bin/flink run \

-t yarn-per-job \

-s hdfs://hadoop1:8020/flink-tuning/sp/savepoint-066c90-6edf948686f6 \

-d \

-p 5 \

-Drest.flamegraph.enabled=true \

-Dyarn.application.queue=test \

-Djobmanager.memory.process.size=1024mb \

-Dtaskmanager.memory.process.size=2048mb \

-Dtaskmanager.numberOfTaskSlots=2 \

-c com.atguigu.flink.tuning.UvDemo \

/opt/module/flink-1.13.1/myjar/flink-tuning-1.0-SNAPSHOT.jar

报错如下:

Caused by: java.lang.IllegalStateException: Failed to rollback to checkpoint/savepoint hdfs://hadoop1:8020/flink-tuning/sp/savepoint-066c90-6edf948686f6. Cannot map checkpoint/savepoint state for operator ddb598ad156ed281023ba4eebbe487e3 to the new program,because the operator is not available in the new program. If you want to allow to skip this, you can set the --allowNonRestoredState option on the CLI.

临时处理:在提交命令中添加 --allowNonRestoredState (short: -n) 跳过无法恢复的算子。

提交案例:指定 uid

bin/flink run \

-t yarn-per-job \

-d \

-p 5 \

-Drest.flamegraph.enabled=true \

-Dyarn.application.queue=test \

-Djobmanager.memory.process.size=1024mb \

-Dtaskmanager.memory.process.size=2048mb \

-Dtaskmanager.numberOfTaskSlots=2 \

-c com.atguigu.flink.tuning.UidDemo \

/opt/module/flink-1.13.1/myjar/flink-tuning-1.0-SNAPSHOT.jar

触发保存点:

//cancel 触发 savepoint

bin/flink cancel -s hdfs://hadoop1:8020/flink-tuning/sp 272e5d3321c5c1481cc327f6abe8cf9c -yid application_1640268344567_0033

修改代码,从保存点恢复:

bin/flink run \

-t yarn-per-job \

-s hdfs://hadoop1:8020/flink-tuning/sp/savepoint-272e5d-d0c1097d23e0 \

-d \

-p 5 \

-Drest.flamegraph.enabled=true \

-Dyarn.application.queue=test \

-Djobmanager.memory.process.size=1024mb \

-Dtaskmanager.memory.process.size=2048mb \

-Dtaskmanager.numberOfTaskSlots=2 \

-c com.atguigu.flink.tuning.UidDemo \

/opt/module/flink-1.13.1/myjar/flink-tuning-1.0-SNAPSHOT.jar

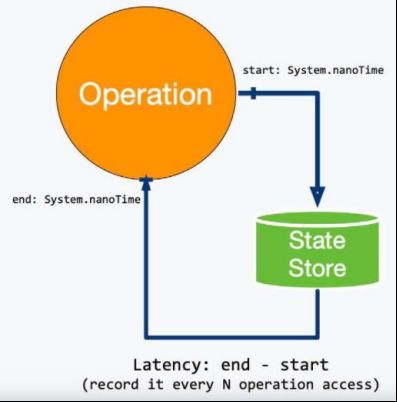

5.3. 链路延迟测量

对于实时的流式处理系统来说,我们需要关注数据输入、计算和输出的及时性,所以处理延迟是一个比较重要的监控指标,特别是在数据量大或者软硬件条件不佳的环境下。Flink 提供了开箱即用的 LatencyMarker 机制来测量链路延迟。开启如下参数:

#默认 0,表示禁用, 单位毫秒

metrics.latency.interval: 30000

监控的粒度,分为以下 3 档:

-

single:每个算子单独统计延迟;

-

operator(默认值):每个下游算子都统计自己与 Source 算子之间的延迟;

-

subtask:每个下游算子的 sub-task 都统计自己与 Source 算子的 sub-task之间的延迟。

#默认 operator metrics.latency.granularity: operator

一般情况下采用默认的 operator 粒度即可,这样在 Sink 端观察到的 latency metric 就是我们最想要的全链路(端到端)延迟。 subtask 粒度太细,会增大所有并行度的负担,不建议使用。

LatencyMarker 不会参与到数据流的用户逻辑中,而是直接被各算子转发并统计。为了让它尽量精确,有两点特别需要注意:

-

保证 Flink 集群内所有节点的时区、时间是同步的:ProcessingTimeService 产生时间戳最终是靠

System.currentTimeMillis()方法,可以用 ntp 等工具来配置。 -

metrics.latency.interval 的时间间隔宜大不宜小:一般配置成 30000(30秒)左右。一是因为延迟监控的频率可以不用太频繁,二是因为 LatencyMarker 的处理也要消耗一定性能。

提交案例:

bin/flink run \

-t yarn-per-job \

-d \

-p 5 \

-Drest.flamegraph.enabled=true \

-Dyarn.application.queue=test \

-Djobmanager.memory.process.size=1024mb \

-Dtaskmanager.memory.process.size=2048mb \

-Dtaskmanager.numberOfTaskSlots=2 \

-Dmetrics.latency.interval=30000 \

-c com.atguigu.flink.tuning.UidDemo \

/opt/module/flink-1.13.1/myjar/flink-tuning-1.0-SNAPSHOT.jar

可以通过该 metric 查看结果:flink_taskmanager_job_latency_source_id_operator_id_operator_subtask_index_latency

端到端延迟的 tag 只有 murmur hash 过的算子 ID (用 uid()方法设定的),并没有算子名称,(https://issues.apache.org/jira/browse/FLINK-8592)并且官方暂时不打算解决这个问题,所以我们要么用最大值来表示,要么将作业中 Sink 算子的 ID 统一化。比如使用了 Prometheus 和 Grafana 来监控,效果如下:

为了方便观看,可以将查出来的数据除以 1000 ,将花费时间单位修改为秒。

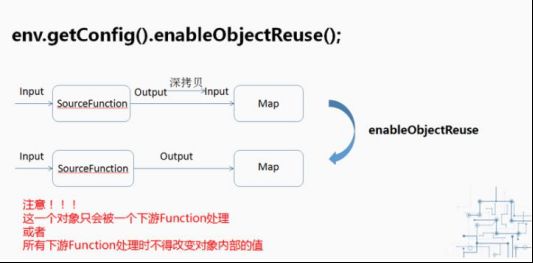

5.4. 开启对象重用

当调用了 enableObjectReuse 方法后, Flink 会把中间深拷贝的步骤都省略掉,SourceFunction 产生的数据直接作为 MapFunction 的输入,可以减少 gc 压力。但需要特别注意的是,这个方法不能随便调用,必须要确保下游 Function 只有一种(也就是一个流只会被一个算子处理),或者下游的多个 Function 均不会改变对象内部的值。否则可能会有线程安全的问题。

bin/flink run \

-t yarn-per-job \

-d \

-p 5 \

-Drest.flamegraph.enabled=true \

-Dyarn.application.queue=test \

-Djobmanager.memory.process.size=1024mb \

-Dtaskmanager.memory.process.size=2048mb \

-Dtaskmanager.numberOfTaskSlots=2 \

-Dpipeline.object-reuse=true \

-Dmetrics.latency.interval=30000 \

-c com.atguigu.flink.tuning.UidDemo \

/opt/module/flink-1.13.1/myjar/flink-tuning-1.0-SNAPSHOT.jar

5.5. 细粒度滑动窗口优化

-

细粒度滑动的影响

当使用细粒度的滑动窗口(窗口长度远远大于滑动步长)时,重叠的窗口过多,一个数据会属于多个窗口,性能会急剧下降。

我们经常会碰到这种需求:以 3 分钟的频率实时计算 App 内各个子模块近 24 小时的 PV 和 UV。我们需要用 1440 / 3 = 480 个滑动窗口来实现它,但是细粒度的滑动窗口会带来性能问题,有两点:- 状态

对于一个元素,会将其写入对应的(key, window)二元组所圈定的 windowState 状态中。如果粒度为 480,那么每个元素到来,更新 windowState 时都要遍历 480 个窗口并写入,开销是非常大的。在采用 RocksDB 作为状态后端时,checkpoint 的瓶颈也尤其明显。 - 定时器

每一个(key, window)二元组都需要注册两个定时器:一是触发器注册的定时器,用于决定窗口数据何时输出;二是 registerCleanupTimer() 方法注册的清理定时器,用于在窗口彻底过期(如 allowedLateness 过期)之后及时清理掉窗口的内部状态。细粒度滑动窗口会造成维护的定时器增多,内存负担加重。

- 状态

-

解决思路

DataStreamAPI 中,需要我们自己解决(https://issues.apache.org/jira/browse/FLINK-7001),flink 官方还未解决。

我们一般使用滚动窗口+在线存储+读时聚合的思路作为解决方案:- 从业务的视角来看,往往窗口的长度是可以被步长所整除的,可以找到窗口长度和窗口步长的最小公约数作为时间分片(一个滚动窗口的长度);

- 每个滚动窗口将其周期内的数据做聚合,存到下游状态或打入外部在线存储(内存数据库如 Redis ,LSM-based NoSQL 存储如 HBase);

- 扫描在线存储中对应时间区间(可以灵活指定)的所有行,并将计算结果返回给前端展示。

-

细粒度的滑动窗口案例

提交案例:统计最近 1 小时的 uv ,1 秒更新一次(滑动窗口)bin/flink run \ -t yarn-per-job \ -d \ -p 5 \ -Drest.flamegraph.enabled=true \ -Dyarn.application.queue=test \ -Djobmanager.memory.process.size=1024mb \ -Dtaskmanager.memory.process.size=2048mb \ -Dtaskmanager.numberOfTaskSlots=2 \ -c com.atguigu.flink.tuning.SlideWindowDemo \ /opt/module/flink-1.13.1/ -

时间分片案例

实现思路:-

比如每分钟计算一下过去 24 小时内的 pv ,因此,24 小时内会触发 1440 次窗口。

-

开启滚动窗口,时间为 1 分钟。

-

下游自定义算子实现

-

算子内维持一个先进先出、固定长度的阻塞队列,新到一条数据(上面1分钟窗口的聚合结果),就将该数据放到阻塞队列中,然后查看阻塞队列长度是否达到指定的长度,也就是 1440 。

-

达到

循环获取阻塞的所有数据,并进行累加计算,得到过去 24 小时的结果,将最新一条数据的时间作为结束时间,最旧一条数据的时间作为开始时间,然后输出本次计算出来的 24 小时的结果。记得计算完毕之后,删除阻塞队列末尾的数据。 -

未达到

什么事都不做。

-

-

记得实现 checkpoint 的相关逻辑,将阻塞队列中的数据保存到 checkpoint 中。

-

提交案例:统计最近 1 小时的 uv , 1 秒更新一次(滚动窗口+状态存储)

bin/flink run \ -t yarn-per-job \ -d \ -p 5 \ -Drest.flamegraph.enabled=true \ -Dyarn.application.queue=test \ -Djobmanager.memory.process.size=1024mb \ -Dtaskmanager.memory.process.size=2048mb \ -Dtaskmanager.numberOfTaskSlots=2 \ -c com.atguigu.flink.tuning.SlideWindowDemo \ /opt/module/flink-1.13.1/myjar/flink-tuning-1.0-SNAPSHOT.jar \ --sliding-split trueFlink 1.13 对 SQL 模块的 Window TVF 进行了一系列的性能优化,可以自动对滑动窗口进行切片解决细粒度滑动问题。

https://nightlies.apache.org/flink/flink-docs-release-1.13/docs/dev/table/sql/queries/window-tvf

-

6. FlinkSQL 调优

FlinkSQL官网配置参数:https://ci.apache.org/projects/flink/flink-docs-release-1.13/dev/table/config.html

6.1. 设置空闲状态保留时间

Flink SQL 新手有可能犯的错误,其中之一就是忘记设置空闲状态保留时间导致状态爆炸。列举两个场景:

-

FlinkSQL 的 regular join(inner、 left、 right),左右表的数据都会一直保存在状态里,不会清理!要么设置 TTL,要么使用 FlinkSQL 的 interval join。

-

使用 Top-N 语法进行去重,重复数据的出现一般都位于特定区间内(例如一小时或一天内),过了这段时间之后,对应的状态就不再需要了。

Flink SQL 可以指定空闲状态(即未更新的状态)被保留的最小时间,当状态中某个 key 对应的状态未更新的时间达到阈值时,该条状态被自动清理:

// API 指定

tableEnv.getConfig().setIdleStateRetention(Duration.ofHours(1));

// 参数指定

Configuration configuration = tableEnv.getConfig().getConfiguration();

configuration.setString("table.exec.state.ttl", "1 h");

6.2. 其他参数

可参考:flink-sql查询配置与性能优化参数详解。