点云 3D 天气数据增强 - Lidar Light Scattering Augmentation (LISA): Physics-based Simulation ... (arXiv 2021)

Lidar Light Scattering Augmentation(LISA): Physics-based Simulation of Adverse Weather Conditions for 3D Object Detection - 激光雷达光散射增强(LISA): 基于物理的3D目标检测不利天气条件模拟(arXiv 2021)

- 摘要

- 1. 引言

- 2. 相关工作

- 3. 准备工作

- 4. 提议的方法

- 5. 实验和结果

-

- 5.1. 模拟实验

- 5.2. 使用模拟数据进行网络性能改进的比较

- 5.3. 分析降雨对3D目标检测的影响

- 5.4. 雾和雪

- 5.5. 未来工作

- 6. 结论

- References

声明:此翻译仅为个人学习记录

文章信息

- 标题:Lidar Light Scattering Augmentation (LISA): Physics-based Simulation of Adverse Weather Conditions for 3D Object Detection (arXiv 2021)

- 作者:Velat Kilic, Deepti Hegde, Vishwanath Sindagi, A. Brinton Cooper, Mark A. Foster and Vishal M. Patel

- 文章链接:https://arxiv.org/pdf/2107.07004.pdf

- 文章代码:https://github.com/velatkilic/LISA

摘要

基于激光雷达的目标检测器是自动驾驶汽车等自动导航系统中3D感知管道的关键部分。然而,众所周知,由于信噪比(SNR)和信底比(SBR)降低,它们对雨、雪和雾等不利天气条件敏感。因此,根据正常天气下捕获的数据训练的基于激光雷达的目标检测器在这种情况下往往表现不佳。然而,在各种不利天气条件下收集和标记足够的训练数据既费力又昂贵。为了解决这个问题,我们提出了一种基于物理的方法来模拟不利天气条件下场景的激光雷达点云。然后,这些增强的数据集可以用于训练基于激光雷达的检测器,以提高其全天候可靠性。具体而言,我们引入了一种基于蒙特卡洛的混合方法,该方法处理(i)通过随机放置大颗粒并将其背向反射功率与目标进行比较来处理大颗粒的影响,以及(ii)通过根据Mie理论和粒度分布计算散射效率来平均处理衰减影响。使用这种增强数据对网络进行再训练提高了在真实世界雨天场景中评估的平均精度,并且我们观察到,相对于文献中的现有模型,我们的模型的性能有了更大的改进。此外,我们在模拟天气条件下评估了最近最先进的检测器,并对其性能进行了深入分析。

1. 引言

近年来,像自动驾驶汽车这样的自动导航系统越来越受到人们的关注。因此,构成这些系统关键骨干的3D目标检测取得了快速进展。[17,14,12,32,31,25,35]等几项工作已经成功地提高了不同基准数据集的性能。这些方法[35,30,13,32,23]中的大多数都是基于激光雷达数据的,主要是因为这些传感器提供了高度准确的距离测量,从而实现了可靠的检测性能。

然而,已知这些传感器对不利的天气条件[21,8,2,11]敏感,如雨、雪和雾,这是由于SNR和SBR降低以及随机液滴的大反向散射功率。当激光脉冲穿过散射介质时,由于散射,总强度随距离呈指数衰减。这导致反射率随天气而变化,并增加了射程的不确定性。在某些情况下,如果信号被降低到底噪声以下,这可能会导致误检测。此外,背景强度增加,特别是在传感器附近,这仅仅是因为来自随机液滴的反向散射激光功率的较大部分可用于传感器。特别是在最强返回模式下,这可能会使检测器混淆哪个脉冲来自真实目标,并导致靠近传感器的随机散射点和真实目标内相应的缺失点。所有这些影响都可以从图4和图6所示的激光雷达扫描中直观地观察到,当然,它们反过来又会对基于激光雷达的检测器的性能产生不利影响,这些检测器通常在干净的数据集上进行训练(不包含受不利天气影响的样本的数据集)。为了解决这个问题,一种方法是收集数据,以便明确尝试捕捉这些不利条件。然而,这一过程可能是劳动密集型的,而且成本高得令人望而却步。此外,在正常天气下不可能获得相同的激光雷达场景,这在3D场景理解的数据驱动方法中是经常需要的。因此,在这项工作中,我们专注于在现有的基于激光雷达的数据集上模拟不利天气条件。我们的模型将能够轻松生成各种天气条件下的逼真激光雷达点云,除了可以提高3D目标检测器的整体全天候可靠性外,还可以用于研究天气对其的影响。

值得注意的是,只有少数工作[21,8,2,11]试图应对这一挑战。例如,Rasshofer等人[21]通过计算双稳态激光雷达的消光系数和几何形状,对雨、雾和雪的平均影响进行理论建模。最近,Bijelic等人[2]通过假设发射的激光束强度被透射因子衰减并引入随机散射点来模拟雾状条件。Goodin等人[8]通过将降雨建模为降雨速率的函数,并引入与降雨速率相关的范围不确定性,开发了一种更具物理性的模拟器。

虽然这些工作试图开发用于模拟不同天气条件的简化模型,但它们存在以下缺点:(i)在[2]中,随机分散点的位置是从均匀随机分布中选择的。这是一个严重的过于简单化,因为探测到的激光功率是距离的一个强关联函数。换言之,非常靠近传感器的雨滴更有可能反向散射足够的激光功率,从而混淆检测器(见图6中的蓝框),(ii)在[2,11]中,信噪比(SNR)具有附加增益因子: S N R = L + g n SNR=\frac{L+g}{n} SNR=nL+g,其中L是激光强度,g是增益,n是噪声,这显然不是物理的,因为增益总是乘以SNR,即 g L n \frac{gL}{n} ngL。然后使用SNR项来预测哪些点应该随机分散,并且该误差使幸存点的反射率产生偏差。在极端情况下,对于非物理的大g或小n,根据这种不正确的模型,仍然可以可靠地检测到具有零返回(L=0)的信号。(iii)此外,依赖于SNR的距离不确定性(随着SNR的降低,距离不确定性增加)在当前模型中通常被忽略。这在很大程度上与边缘检测问题有关[4];在存在噪声的情况下,需要激进的滤波,这会降低定位精度。(iv)不同天气条件的消光系数是从[2]中的周期性分布和[11]中的未知分布中选择的,分布范围为[0.001,0.1]m−1。为了克服这些缺点,我们提出了一种基于蒙特卡洛的混合方法,该方法考虑了物理大气和激光雷达硬件参数,如最大和最小(双基地配置)激光雷达距离、距离精度、激光波长、降雨率等。我们使用所提出的模拟模型,并对不利天气条件对最近最先进的基于激光雷达的目标检测器的影响进行了深入分析[13,32,23,10]。

综上所述,以下是我们工作的主要贡献:

-

我们开发了一个基于物理的模拟模型,以生成不同不利天气条件下的激光雷达点云。具体而言,我们提出了一种基于蒙特卡洛的混合激光雷达散射体模拟器,用于雨、雪和不同类型的雾。

-

我们使用所提出的模型来增强Waymo数据集的扫描,并在此增强的数据上重新训练网络。使用我们的模型,我们观察到与现有模型相比,在有雨的真实世界场景中,性能有了更大的改进。

-

我们使用所提出的模型来分析天气导致的3D目标检测器的性能退化,并将其与其他模拟方法导致的性能退化进行比较。

2. 相关工作

天气效应的模拟:文献[21,8]中研究了激光雷达回波信号中与天气相关的噪声的影响,并使用天气模型来提高基于DNN的去噪器和目标检测器的性能[11,2]。Rasshofer等人为研究雨、雾和雪的平均影响提供了物理模型,并从理论上研究了它们对激光雷达传感器的影响[21]。

3D目标检测:最近对点集深度学习的研究[19,20]已经实现了神经网络的端到端训练,该网络可以消耗点云数据,而无需将其转换为中间表示,如深度或鸟瞰图格式。Qi等人[19]提出了PointNet,一种直接消耗点云并输出类标签的网络。几种方法结合雷达、激光雷达和图像数据,提供了多模态方法来解决3D目标检测[5,14,18]。在这项工作中,我们将重点关注在不利天气下评估检测器性能时的纯激光雷达方法。

在激光雷达点云中使用深度神经网络进行3D目标检测的方法可以广泛分类为基于体素的[36,13,30]、基于点的[32,10,24,18,33]或两者的组合[23,34]。

Zhou和Tuzel通过提出VoxelNet[36]将PointNet框架扩展到3D检测任务,VoxelNet涉及使用特征嵌入层对均匀大小的体素进行编码。Lang等人提出了PointPillars[13],该方法将点组织成均匀间隔的垂直列形式的体素,这些垂直列使用特征编码块进行编码。Shi等人在[20]的基础上提出了PointRCNN[24],包括逐点特征提取、3D提案生成和兴趣区域池。这种方法优于基于体素的方法,但计算成本很高。在[32]中,Yang等人提出了3DSSD,这是一种单阶段、基于点的目标检测网络,它使用融合采样方法来消除类似网络中使用的特征传播层[20,24],以提高推理速度。在PV-RCNN[23]中,Shi等人通过体素集抽象模块将体素汇总为关键点,集成了基于点的方法的集抽象和体素CNN的3D卷积。该方法优于基于纯体素的[13]和基于纯点的方法[32]。Bhat-tachariya等人[1]进一步扩展了这一点,其中包括用于执行关键点对齐的自适应变形和上下文融合模块。

3. 准备工作

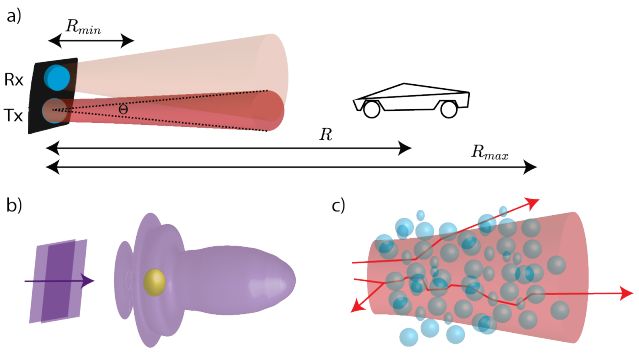

图1:a)双基激光雷达(其中接收器Rx和发射器Tx共享不同的光路)与天气增强计算相关的参数。b) 具有卡通辐射图案的波浪图中单个粒子的光散射。c) 光线图片中液滴随机集合的光散射。

如图1a所示,激光雷达通过发送光脉冲和测量后反射的飞行时间来测量目标距离。表征其天气性能的重要参数是最小范围Rmin、光束发散度θ和最大范围Rmax。激光强度在穿过散射介质时由于散射和吸收而衰减,如射线图中的图1c所示。可以使用比尔-兰伯特定律[21]计算通过散射介质的透射强度IT

![]()

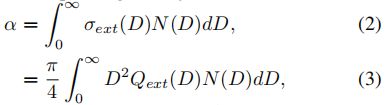

其中I0是入射强度,α是消光系数,R是目标距离。平均消光系数可以根据消光截面σext和相应的密度计算如下:

其中D是颗粒直径,Qext是消光效率。通过求解麦克斯韦方程并将总辐射通量(W)与平面波图中的入射通量W/m2进行比较,可以计算出每个粒子几何形状和材料的散射截面(以面积为单位,即m2),如图1b所示[3]。颗粒密度函数N(D)以m−3 mm−1(每体积m3每直径mm)为单位引用,并通过Marshall-Palmer分布或伽马函数模型进行建模[21]。

图2:a)作为雨滴直径函数的消光效率。b) 对于不同的降雨速率,使用Marshall-Palmer分布的降雨粒度分布。c) 根据Mie理论(橙色线)和[29]的渐近解(蓝色线)数值计算的作为降雨率函数的消光系数,发现其预测消光系数在实验获得值的25%以内。

图2b说明了对数尺度上不同降雨率下Marshall-Palmer分布预测的降雨颗粒尺寸分布。

下一步是计算给定的消光系数如何影响激光雷达的返回。透射脉冲和背反射脉冲在穿过散射介质时都呈指数衰减,这导致背反射信号的总衰减e−2αR。文献中的模型将目标反射率降低了这个数量[11,2]。然而,对于这些消光系数的确切值,他们对概率分布函数进行采样,该函数适合气候室的测量结果。尽管这是完全有效的,但我们注意到,通过物理学计算消光系数将有助于模型推广到更多的大气现象。

此外,Bijelic等人观察到,如果信噪比太小,那么激光雷达就无法可靠地测量距离。因此,定义了最大可检测范围

其中Pr是反射功率,Pn是噪声功率和Rmax是最大可检测范围。然而,SNR是通过以下非物理函数 S N R = L + g n SNR=\frac{L+g}{n} SNR=nL+g估计的,其中噪声(n)和增益(g)参数被拟合到实验雾数据[11,2]。相比之下,Goodin等人通过考虑目标反射率和射程来对探测功率进行建模。然后将距离校正功率与根据最大激光雷达距离估计的最小可检测功率进行比较[8]。

4. 提议的方法

在这里,我们建立在这些先前的模型的基础上,并通过基于物理的论点和引入基于蒙特卡洛的混合方法来扩展它们。该算法考虑了真实的设计参数,如激光雷达的最大和最小射程、测距精度、激光束发散度,以及真实世界的参数,如降雨率。为了将大气条件映射到光学参数,我们从散射理论中明确计算了消光系数。消光效率是散射体几何形状和材料组成的函数,并且通常没有闭合形式的分析解[3]。因此,我们假设散射体为球形粒子,可以根据Mie理论精确计算。虽然Mie理论提供了一个解析解,但它需要求和一个无穷级数。在正确的点停止级数求和在某种程度上是一门艺术[3],因此在这项工作中,我们使用了一种开源实现PyMieScott[27],该实现已被广泛使用和验证。图2a显示了905nm激光器的消光效率作为雨滴直径的函数。消光效率和颗粒分布可用于通过对方程3中的表达式进行数值积分来计算平均消光系数。为了测试Mie模型相对于真实天气现象的准确性,我们将其与渐近关系进行了比较,该渐近关系已被发现可以预测降雨实验测量值的25%以内的消光系数[29]:

![]()

其中,α以dB/km为单位,Rr是以mm/hr为单位测量的降雨率。在图2c中,我们将渐近模型与使用Marshall-Palmer雨滴分布的Mie模型进行了比较。尽管对于特定的天气条件可能存在一个简单的表达式,但我们提出了一个模型,其中可以有效地计算任意天气现象的影响。到目前为止,所有的论点都非常适合对雾等小型和密集散射体的效果进行建模。然而,强大的散射体,如大水滴、灰尘颗粒或雪花,可能会反射出比目标更大的功率。事实上,激光脉冲体积内的一组粒子(由脉冲宽度和持续时间决定)可能会混淆激光雷达探测器,即使每个粒子可能不会比目标反向散射更多的功率。

对于我们的算法,我们忽略了后一种影响,以保持计算简单,这相当于假设脉冲宽度极小。由有限脉冲宽度引起的范围不确定性已经被等式7所考虑。这一假设遗漏的唯一影响是来自非均匀粒子云的散射,这些粒子云可以稍后手动添加。完整的蒙特卡罗方法将随机放置所有散射体,计算每个粒子的反向反射功率,然后将其与脉冲形状卷积。

然而,为了保持计算简单,我们只考虑一定直径以上的粒子,因为小粒子不太可能反向散射足够的光来混淆探测器。

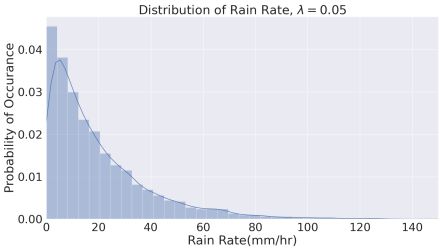

图3:降雨率发生概率与降雨率的关系图,单位为mm/hr,显示了模拟不利天气条件下激光雷达场景中的降雨率分布。所有模拟实验的降雨率都是从这种分布中采样的。

与[8]中的方法类似,我们观察到激光雷达的信噪比是距离和目标反射率的函数。因此,从制造商数据表中经常引用的最大范围估计最小可检测功率Pmin,然后单独计算激光雷达扫描中每个点的信噪比,是更可靠的。因此,在我们的模型中,所有具有低于Pmin的范围校正功率的点都被丢弃,因为它们无法可靠地测量,这与激光雷达的构建方式一致[9]。此外,小的信噪比会导致大的距离不确定性,我们通过雷达文献[6]中的模型计算得出,如下所示:

其中σR是距离噪声的标准偏差,∆R是由激光雷达系统的有限带宽确定的距离精度。噪声范围是通过将具有零均值和标准偏差σR的正态分布噪声相加来计算的。

现有激光雷达建模算法的另一个主要问题是,它们没有考虑光束发散,但激光束在自由空间传播过程中会衍射。换句话说,激光束腰随着传播而增加,这降低了远离激光雷达传感器的散射体的可用功率,从而影响随机散射点的PDF。我们使用高斯光学对距离相关的腰部尺寸进行建模,以保持模拟的简单性,尽管一些激光雷达可能使用光束质量较差的侧发射激光器(非高斯光束轮廓)。高斯光束的宽度可以通过

其中w0是衍射限制宽度,R0是瑞利范围[22]。对于较大的传播距离R>>R0,束腰变为

![]()

其中,θ是可以在激光雷达数据表中找到的发散角,其数量级为几mrad。

光束发散导致二次散射体范围PDF。如果我们假设散射体(即雨滴)在空间中均匀随机分布,那么每个范围内激光雷达光束照射的粒子数量将与光束横截面积成比例。由于波束宽度在范围内线性缩放,如等式9所示,波束面积按二次方缩放。因此,在我们的蒙特卡罗模拟中,随机散射体位置选自

![]()

其中R是对象范围,R是从[0,1]中均匀绘制的随机变量。Rrand的直方图应该产生一个二次曲线。由于在我们的混合方法中,我们只考虑蒙特卡洛部分的大液滴,因此使用菲涅耳方程(在法向入射时)计算它们的反射率[22]

其中n是散射体的复折射率。

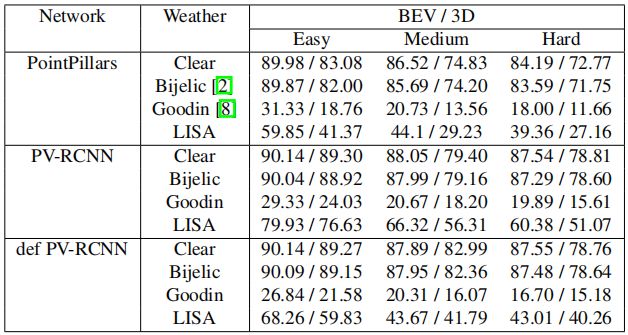

表1:KITTI数据集[7]中,使用[2]、[8]和LISA的算法,针对晴朗的天气场景和模拟的降雨场景,在“汽车”类上的最先进3D检测网络的百分比平均精度。

对于大的吸收粒子,菲涅耳反射率很好地近似于后向散射效率[3]。最后,从给定的尺寸分布中选择随机散射体的直径。对于Marshall-Palmer分布,颗粒直径由

其中,Drand是随机粒子直径,r是从[0,1]均匀得出的随机变量,∧是由降雨率确定的指数衰减常数,Dst是我们想要考虑的最小粒子的大小。Drand的直方图应该会产生指数衰减的轮廓。算法1中提出了全激光雷达光散射增强算法。使用Marshall-Palmer分布是因为它采样很快,但任何其他粒度分布也可以在这里工作。

除了降雨增强之外,我们还在KITTI数据集[7]中增加了雪、中等平流雾和强平流雾的激光雷达场景。雪的模拟算法与雨的模拟算法相似。雾的模拟方法由算法2描述,我们称之为mini-LISA。雾由密集的小粒子组成,因此忽略了来自大粒子的随机散射。场景中的雪量由以mm/hr为单位的降水率控制。雾模拟使用Gamma函数对粒子分布进行建模:

其中D是颗粒直径,Γ是伽马函数,DC是模式(最可能的)颗粒直径,a、γ和b是拟合参数[21]。我们将[21]中的参数用于雾和雪模拟。对于雾模拟,拟合参数是固定的,因此对于相同的雾类型,所有激光雷达扫描的消光系数都是相同的。

5. 实验和结果

在本节中,我们对KITTI数据集[7]和Waymo开放数据集[28]中室外场景的激光雷达点云进行天气模拟。我们比较了最近最先进的3D目标检测网络[23,1,13,30,26],并分析了模拟天气对其性能的影响。

5.1. 模拟实验

在这里,我们描述了降雨模拟过程的细节。为了进行反映现实不利天气趋势的模拟,我们从指数分布[16]中以λ=0.05 mm/hr的速率对降雨率进行采样,如图3所示。激光雷达传感器的最大范围(Rmax)是根据用于3D数据捕获的Velodyne传感器的规格选择的。在[7]的情况下,我们选择Rmax=120 m[15]。使用的其他参数包括Bdiv=3×10−3弧度的光束发散度和±4.5 cm(∆R=0.09 m)的测距精度,我们考虑直径Dst=50µm或以上的粒子进行随机散射。对于[2]中的模拟方法,我们考虑Marshall-Palmer降雨模型[21],其参数α对应于LISA模拟中使用的降雨率值。

图4显示了Waymo Open Detection数据集[28]在模拟降雨条件下的场景。我们将这些模拟与来自同一数据集的真实世界降雨场景进行了比较。正如所观察到的,我们的方法导致了点的丢失和能见度的降低,类似于真实降雨的场景。

图4:模拟降雨激光雷达场景的拟议增强方法与真实世界降雨数据的定性比较。顶部:Waymo开放数据集[28]中的晴朗天气场景(场景A)。左下:场景A使用我们的方法进行了增强,降雨量为35mm/hr。右下角:来自[28]的真实世界的雨天场景(场景B)。下雨会导致场景稀疏、范围不确定性增加和能见度降低(最佳视图放大)。

图5:在KITTI数据集上训练的三个网络,PointPillars[13](第一列)、PV-RCNN[23](第二列)和可变形PV-RCNN[1](第三列),雨前和雨后检测模拟的比较。第一行描述了正常条件下每个网络的预测,而第二行描述了雨天条件下的预测。绿色边界框是真值注释,而红色边界框是预测。

5.2. 使用模拟数据进行网络性能改进的比较

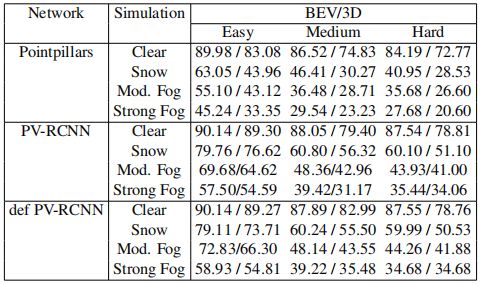

为了进一步比较降雨模拟方法的准确性,我们将表3中评估的网络与使用LISA、Bijelic[2]和Goodin[8]方法生成的模拟数据进行了重新训练,并在[28]的真实世界降雨激光雷达场景中对其进行了评估。比较结果见表2。

[2]中的模型是针对雾的,因此不考虑降雨率来模拟降雨场景。然而,它确实具有消光系数。在这里,我们通过计算给定降雨率下平均Mie处理的消光系数来修改并在某种意义上改进该模型。然后将消光系数输入到他们的算法中。为了在现有数据集上创建雨/雪模拟,每个样本都增加了从图3中的分布中采样的不同降雨率。为了进行评估和重新训练,对每个数据集的测试和训练集进行增强,并将其与真实世界不利天气场景的未增强样本和数据集进行比较。在大多数情况下,在LISA模拟数据上重新训练网络[30]、[23]和[26]会在真实世界的雨天场景中产生最佳性能。这验证了基于物理的建模方法优于现有方法。

5.3. 分析降雨对3D目标检测的影响

在本节中,我们分析了模拟降雨对最近最先进的检测方法的影响。我们进行了两组实验。(i) 我们在KITTI激光雷达数据集[7]上训练PointPillars[13]、PV-RCNN[23]和Deformable PV-RCNN[1],并在使用Bijelic[2]、Goodin[8]和所提出的模拟方法生成的模拟降雨激光雷达数据上对它们进行评估。这些评估的结果见表4。(ii)为了与真实世界的不利天气数据进行比较,我们在Waymo开放数据集[28]上训练SECOND[30]、PV-RCNN[23]和PartA^2[26],并在[28]的模拟场景和真实世界的降雨场景中对它们进行评估。这些评估的结果见表3。我们提出以下意见:

-

在模拟的雨天激光雷达场景中进行评估时,两个数据集中每个网络的性能都会下降。这是由于噪声的存在和通过场景中的丢失点而造成的信息丢失。

-

由于激光强度衰减和随机点比目标反向散射更大的功率,导致场景中出现缺失点,对检测网络的影响最大。在不利天气下捕获激光雷达数据可能会导致整个目标从场景中删除,尤其是那些距离传感器很远的目标。在表4中,这反映在我们针对KITTI数据训练的网络的方法中模拟数据的“中等”和“困难”类别网络的性能下降中。

-

PointPillars对整列进行编码,因此特别容易出现数据点丢失的问题,并且性能受雨水影响最大。点的丢失可能导致整个体素/柱的丢失,并对编码器提取的体素特征的质量产生负面影响。基于点的方法,以及那些利用体素化和集合抽象的组合的方法,在特征空间中不太容易出现这种信息损失,正如与PointPillars相比,其他网络的性能相对提高所表明的那样。

-

注意到LISA数据与Bijelic等人和Goodin等人在性能上的差异,我们得出的结论是,缺失的数据点对遗漏检测的贡献最大。[8]中的方法高估了降雨的影响,导致场景中有太多缺失和分散的点。这反映在表4和表3中极低的mAP值中。[2]中的方法低估了降雨对激光雷达场景的影响,表4中的性能下降可以忽略不计。

-

比较了PointPillars、PV-RCNN和可变形PV-RCNN在正常和中等降雨条件下(雨速10 mm/hr)[7]的激光雷达场景上的预测,图5直观地展示了网络可能会受到模拟不利天气的影响。与PointPillars相比,PV-RCNN和可变形PV-RCNN提供了与真值注释(绿色边界框)一致的更准确的预测(红色边界框),可变形PV-RCNN具有比PV-RCNN更少的错误预测。然而,所有网络都会受到降雨的不利影响,在分散的点周围出现错误检测,以及由于点的丢失而导致的几次漏检。

5.4. 雾和雪

KITTI在激光雷达场景上模拟雪和雾的视觉效果如图6所示。雪的影响与雨的影响相似,丢失的点离传感器更远,传感器附近存在散射点。这由中间图像中的蓝色边框表示。在有雪的情况下,散射量比预期的雨天要高(这就是为什么雪看起来是白色的)。缺失点的性质也与雪和雾场景不同。雾的存在大大降低了能见度,距离传感器一定距离以外的所有点都会丢失,比下雪的情况更严重。这可以通过比较第一列中的中间图像和最后图像来辨别。雾的存在也会对点产生“模糊”效应,导致目标由于距离不确定性的增加而进一步失去其结构保真度。

表2:在模拟降雨激光雷达场景上重新训练的最先进网络的平均精度值的比较,使用LISA、[2]和[8]在Waymo数据集[7]的真实世界降雨场景中评估“车辆”类。每个类别的最佳性能以粗体显示。

表3:Waymo开放数据集[28]中“车辆”类最先进3D检测网络的百分比平均精度,用于晴朗的天气场景、真实世界的降雨场景、使用[2]、[8]和LISA算法的模拟降雨场景。

5.5. 未来工作

增强模型之间的严格比较需要在真实降雨下进行测量,而不是在环境室中进行人工降雨,并进行相应的真值清晰扫描(即在相同位置的相同目标)。收集此类数据具有挑战性,目前还没有公开的此类数据集。然而,从物理论证来看,我们声称LISA比文献中的其他算法更准确。对这些说法的实验验证仍然是未来的研究方向。Bijelic等人的修改/改进模型以及LISA和Goodin等人的模型将公开,以促进这一方向的研究。

图6:KITTI数据集上雪和雾模拟的视觉比较。上图是正常天气条件下的场景。中间的图像显示了使用LISA方法模拟雪条件下的激光雷达场景。传感器附近的散射点以蓝色为界。最后一行显示了模拟中等雾条件下的相同场景。在每张图片的右边可以看到一辆汽车的近景。

表4:在模拟雾和雪条件下,KITTI数据集[7]的“Car”类最先进网络的平均精度值的比较。

6. 结论

总之,我们提出了一种有效的基于物理的模拟方法,用于增强在晴朗天气条件下获取的激光雷达数据,以使3D目标检测器对不利天气条件引入的噪声具有鲁棒性。模拟方法依赖于混合蒙特卡罗方法,其中平均处理小散射体的影响。通过将大粒子随机放置在激光束路径中并计算反向散射功率来计算大粒子的影响。Waymo数据集对真实世界降雨场景的初步结果显示,mAP值有了显著改善。此外,我们分析了天气对最近最先进的基于激光雷达的目标检测器的影响,并提出了开发天气鲁棒目标检测器的有前景的未来途径。

References

[1] P. Bhattacharyya and K. Czarnecki. Deformable pv-rcnn: Improving 3d object detection with learned deformations. ArXiv, abs/2008.08766, 2020.

[2] M. Bijelic, T. Gruber, F. Mannan, F. Kraus, W. Ritter, K. Dietmayer, and F. Heide. Seeing through fog without seeing fog: Deep multimodal sensor fusion in unseen adverse weather. In The IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 2020.

[3] C. F. Bohren and D. R. Huffman. Absorption and Scattering of Light by Small Particles. Wiley, 1998.

[4] J. Canny. A computational approach to edge detection. IEEE Transactions on Pattern Analysis and Machine Intelligence, PAMI-8(6):679–698, 1986.

[5] Xiaozhi Chen, Huimin Ma, Ji Wan, Bo Li, and Tian Xia. Multi-view 3d object detection network for autonomous driving. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 1907–1915, 2017.

[6] G. R. Curry. Radar System Performance Modeling. Artech House, 2 edition, 2005.

[7] Andreas Geiger, Philip Lenz, Christoph Stiller, and Raquel Urtasun. Vision meets robotics: The kitti dataset. International Journal of Robotics Research (IJRR), 2013.

[8] C. Goodin, D. Carruth, M. Doude, and C. Hudson. Predicting the influence of rain on lidar in adas. Electronics, 8, 2019.

[9] D. S. Hall. High definition lidar system. Velodyne Lidar Inc, Patent US7969558B2.

[10] Chenhang He, Hui Zeng, Jianqiang Huang, Xian-Sheng Hua, and Lei Zhang. Structure aware single-stage 3d object detection from point cloud. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 11873–11882, 2020.

[11] R. Heinzler, F. Piewak, P. Schindler, and W. Stork. Cnnbased lidar point cloud de-noising in adverse weather. IEEE Robotics and Automation Letters, 5(2):2514–2521, 2020.

[12] Jason Ku, Alex D Pon, and Steven L Waslander. Monocular 3d object detection leveraging accurate proposals and shape reconstruction. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 11867–11876, 2019.

[13] Alex H Lang, Sourabh Vora, Holger Caesar, Lubing Zhou, Jiong Yang, and Oscar Beijbom. Pointpillars: Fast encoders for object detection from point clouds. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 12697–12705, 2019.

[14] Ming Liang, Bin Yang, Yun Chen, Rui Hu, and Raquel Urtasun. Multi-task multi-sensor fusion for 3d object detection. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 7345–7353, 2019.

[15] Velodyne Lidar. https://velodynelidar.com/products/hdl-64e/#downloads.

[16] Dmitri Moisseev and V Chandrasekar. Examination of the µ - λ relation suggested for drop size distribution parameters. Journal of Atmospheric and Oceanic Technology, 24, 06 2007.

[17] Su Pang, Daniel Morris, and Hayder Radha. Clocs: Cameralidar object candidates fusion for 3d object detection. arXiv preprint arXiv:2009.00784, 2020.

[18] Charles R Qi, Wei Liu, Chenxia Wu, Hao Su, and Leonidas J Guibas. Frustum pointnets for 3d object detection from rgbd data. In Proceedings of the IEEE conference on computer vision and pattern recognition, pages 918–927, 2018.

[19] Charles R Qi, Hao Su, Kaichun Mo, and Leonidas J Guibas. Pointnet: Deep learning on point sets for 3d classification and segmentation. Proc. Computer Vision and Pattern Recognition (CVPR), IEEE, 2017.

[20] Charles R Qi, Li Yi, Hao Su, and Leonidas J Guibas. Point-net++: Deep hierarchical feature learning on point sets in a metric space. arXiv preprint arXiv:1706.02413, 2017.

[21] R. H. Rasshofer, M. Spies, and H. Spies. Influences of weather phenomena on automotive laser radar systems. Advances in Radio Science, 9:49–60, 2011.

[22] B. E. A. Saleh and M. C. Teich. Fundamentals of Photonics. John Wiley and Sons, Inc., 2 edition, 1991.

[23] Shaoshuai Shi, Chaoxu Guo, Li Jiang, Zhe Wang, Jianping Shi, Xiaogang Wang, and Hongsheng Li. Pv-rcnn: Point-voxel feature set abstraction for 3d object detection. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 10529–10538, 2020.

[24] Shaoshuai Shi, Xiaogang Wang, and Hongsheng Li. Pointrcnn: 3d object proposal generation and detection from point cloud. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 770–779, 2019.

[25] Shaoshuai Shi, Zhe Wang, X. Wang, and Hongsheng Li. Part-a2 net: 3d part-aware and aggregation neural network for object detection from point cloud. ArXiv, abs/1907.03670, 2019.

[26] Shaoshuai Shi, Zhe Wang, Xiaogang Wang, and Hongsheng Li. Part-a2 net: 3d part-aware and aggregation neural network for object detection from point cloud. CoRR, abs/1907.03670, 2019.

[27] B. J. Sumlin. https://github.com/bsumlin/PyMieScatt.

[28] Pei Sun, Henrik Kretzschmar, Xerxes Dotiwalla, Aurelien Chouard, Vijaysai Patnaik, Paul Tsui, James Guo, Yin Zhou, Yuning Chai, Benjamin Caine, et al. Scalability in perception for autonomous driving: Waymo open dataset. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 2446–2454, 2020.

[29] C. W. Ulbrich and D. Atlas. Extinction of Visible and Infrared Radiation in Rain: Comparison of Theory and Experiment. Journal of Atmospheric and Oceanic Technology, 2(3):331–339, 09 1985.

[30] Yan Yan, Yuxing Mao, and Bo Li. Second: Sparsely embedded convolutional detection. Sensors, 18(10):3337, 2018.

[31] Bin Yang, Wenjie Luo, and Raquel Urtasun. Pixor: Realtime 3d object detection from point clouds. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 7652–7660, 2018.

[32] Zetong Yang, Yanan Sun, Shu Liu, and Jiaya Jia. 3dssd: Point-based 3d single stage object detector. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 11040–11048, 2020.

[33] Zetong Yang, Yanan Sun, Shu Liu, Xiaoyong Shen, and Jiaya Jia. Ipod: Intensive point-based object detector for point cloud. 12 2018.

[34] Zetong Yang, Yanan Sun, Shu Liu, Xiaoyong Shen, and Jiaya Jia. Std: Sparse-to-dense 3d object detector for point cloud. In Proceedings of the IEEE International Conference on Computer Vision, pages 1951–1960, 2019.

[35] Yin Zhou and Oncel Tuzel. Voxelnet: End-to-end learning for point cloud based 3d object detection. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 4490–4499, 2018.

[36] Yin Zhou and Oncel Tuzel. Voxelnet: End-to-end learning for point cloud based 3d object detection. 2018.