【论文精读】TNNLS 2022 - 基于深度学习的事件抽取研究综述

【论文精读】TNNLS 2022 - 基于深度学习的事件抽取研究综述

【论文原文】:A Survey on Deep Learning Event Extraction Approaches and Applications

【作者信息】:Li, Qian and Li, Jianxin and Sheng, Jiawei and Cui, Shiyao and Wu, Jia and Hei, Yiming and Peng, Hao and Guo, Shu and Wang, Lihong and Beheshti, Amin

论文:https://ieeexplore.ieee.org/stamp/stamp.jsp?tp=&arnumber=9927311

代码:-

博主关键词:事件抽取

摘要

事件抽取是从海量文本数据中快速获取事件信息的一项重要研究任务。随着深度学习的快速发展,基于深度学习技术的事件抽取已成为研究热点。文献中提出了许多方法、数据集和评估指标,这增加全面更新调研的需求。本文通过回顾最先进的方法,特别是基于深度学习模型的通用领域事件抽取,填补了综述类文献空白。根据任务定义,我们为当前通用领域事件抽取研究的引入了一种新的文献分类。然后,我们总结了事件抽取方法的范式和模型,然后详细讨论了每一种方法。作为一个重要方面,我们总结了支持预测和评估指标测试的基准。本次调查还对不同方法进行了全面比较。最后,我们总结了该研究领域未来的研究方向。

1、简介

事件抽取(EE)是信息抽取研究中一项重要但具有挑战性的任务。作为一种特定的信息形式,事件是指在特定时间和特定地点发生的、涉及一个或多个参与者的特定事件,通常可以描述为状态的变化[1]。事件抽取任务旨在将非结构化纯文本中的此类事件信息抽取为结构化形式,主要描述真实世界中发生的事件的“who, when, where, what, why, how”。在应用方面,该任务方便人们检索事件信息并分析人们的行为,引发信息检索[2], [3]、推荐[4], [5]、智能问答[6], [7]、知识图构建[8], [9]以及其他与事件相关的应用[10], [11], [12]。

事件抽取可以分为两组:封闭领域事件抽取[13], [14], [15]和开放域事件抽取[16], [17], [18]。事件通常在被考虑在预定义的事件模式,其中一些特定的人和目标在特定的时间和地点进行交互。封闭域事件抽取任务旨在寻找属于特定事件模式的单词,该模式指的是发生的动作或状态变化,其抽取目标包括时间、地点、人和动作等,其可以被形式化定义为分类或聚类任务。开放域事件抽取是指获取与特定主题相关的一系列事件,通常由多个事件组成。无论是封闭域还是开放域事件抽取任务,事件抽取的目的都是从大量文本中捕捉我们感兴趣的事件类型,并以结构化的形式显示事件的基本论元。

通用领域的深度学习事件抽取已经做了很多工作,并且已经是一种相对成熟的分类研究法。它从文本中发现事件提及,并抽取包含事件触发词和事件论元,其中事件提及被称为包含一个或多个触发词和论元的句子。事件抽取需要识别事件,对事件类型进行分类,识别论元,判断论元角色。具体而言,触发词识别和触发词分类通常被定义为事件检测任务[19], [20], [21], [22],而论元识别和论元角色分类通常被限定为论元抽取任务。触发词分类是一个多分类[23], [24], [25]任务,用于对每个事件的类型进行分类。角色分类任务是一个基于单词对的多分类任务,用于确定句子中任何一对触发词和实体之间的角色关系。从技术角度来看,事件抽取可能依赖于其他一些基础的自然语言处理(NLP)任务,如命名实体识别(NER)[26], [27], [28],语义解析[29], [30], [31],以及关系抽取[32], [33], [34]。

我们给出了通用领域深度学习事件抽取的流程图,如图1所示。事件抽取是为了找到所关注的事件类型,并抽取具有其角色的论元。对于管道范式事件抽取,有必要区分给定文本中的文本事件类型,称为触发词分类。针对不同的事件类型,设计了不同的事件模式。然后,根据模式抽取事件论元,包括论元识别和论抱怨角色分类子任务。在最早的阶段,论元角色分类被视为一项单词分类任务,并对文本中的每个单词进行分类。此外,还有序列标注、机器阅读理解(MRC)和序列到结构生成方法。对于联合范式事件抽取,该模型同时对事件类型和论元角色进行分类,以避免触发词分类子任务产生错误。

1.1 贡献

对于传统的事件抽取方法来说,需要进行特征设计,而对于一般领域的深度学习事件抽取方法,可以通过深度学习模型进行端到端的特征抽取。现有综述主要介绍了主题事件的抽取,其中很少有基于深度学习模型的事件抽取方法[18], [35], [36]。近年来,人们提出了大量的事件抽取方法,基于Transformer的事件抽取法得到了显著的提升[37]。此外,事件抽取不再局限于分类和序列标注方式[38], [39], [40],还可以以使用机器阅读理解和生成[41], [42]的方式。因此,我们在通用领域全面分析了现有的基于深度学习的事件抽取方法,并对未来的研究工作进行了展望。本文的主要贡献如下:

- 我们介绍了通用领域的事件抽取技术,回顾了事件抽取方法的发展历史,并指出具有深度学习的事件抽取方法已成为主流。我们在表1中根据发布年份总结了深度学习模型的重要信息。

- 我们详细分析了各种基于深度学习的抽取范式和模型,包括它们的优缺点。我们介绍了目前可用的数据集,并给出了主要评估指标的指标。我们在表2中总结了主要数据集的重要信息。

- 我们在表4中总结了ACE 2005数据集上的事件抽取准确的分数和事件抽取应用。我们通过讨论事件抽取面临的未来研究趋势来结束这篇综述。

1.2 综述的整体结构

综述的其余部分组织如下。第2节介绍了事件抽取的概念和任务定义。第3节总结了与事件抽取相关的现有范式,包括基于管道的方法和基于联合的方法,构成了一个汇总表。第4节介绍了传统的事件抽取和基于深度学习的事件抽取,并进行了比较。第5节介绍了不同场景下的事件抽取。第6节和第7节主要事件抽取语料库和评估指标。然后,我们在第8节中给出了经典事件抽取数据集中领先模型的评估结果。最后,我们在第9节和第10节中总结了事件抽取应用程序和事件抽取的主要挑战,然后在第11节中总结全文。

2、Preliminary

2.1 概念

事件表示动作或状态发生变化,通常由动词或动名词驱动。它包含动作中涉及的主要组件,如时间、地点和角色。事件抽取技术从非结构化文本中抽取用户感兴趣的事件,并以结构化形式呈现给用户[39]。简而言之,事件抽取检测具有其类型的事件,并从文本中抽取核心论元,如图2所示。给定一个文本,事件抽取技术可以预测文本中提到的事件、每个事件对应的触发词和论元,并对每个论元的作用进行分类。事件抽取需要识别两个事件(Die和Attack),分别由单词“died”和“fired”触发,如图2所示。对于Die事件类型,我们意识到到“Baghdad”、“cameraman”和“American tank”分别扮演Place、Victim和Instrument的事件论元角色。在Attack事件中,“Baghdad”和“American tank”分别扮演事件辩论角色Place和Instrument。“cameraman”和“Palestine Hotel”扮演事件论元角色目标。

事件抽取涉及许多前沿学科,如机器学习、模式匹配和NLP。同时,各领域的事件抽取可以帮助相关人员从海量信息中快速抽取相关内容,提高工作时效性,为定量分析提供技术支持。因此,事件抽取在各个领域都有着广阔的应用前景。通常,自动内容抽取(ACE)描述了一个包含以下术语的事件抽取任务:

-

实体:实体是语义类别中的一个目标或一组目标。实体主要包括人、组织、地点、时间、事物等。在图2中,“Baghdad”、“cameraman”、“American tank”和“Palestine Hotel”是实体。

-

事件提及:描述事件的短语或句子包含触发词和相应的论元。

-

事件类型:事件类型描述了事件的性质,指的是事件所对应的类别,通常由事件触发词的类型表示。对于图2中的句子,它包含Die和Attack事件类型。

-

事件触发词:事件触发词是指事件抽取中的核心单元,是动词或名词。触发词识别是基于管道的事件抽取的关键步骤。对于图2中的Die事件,事件触发词为“died”。

-

事件论元:事件论元是事件的主要属性。它包括实体、非实体参与者和时间等。对于图2中的事件Die,事件论元是“Baghdad”、“cameraman”和“American tank”。

-

论元角色:论元角色是指论元在事件中所扮演的角色,即事件论元和事件触发词之间的关系表示。对于图2中Die事件的“Baghdad”论元,论元的角色是Place。

2.2 子任务

事件抽取包括四个子任务:触发词识别、触发词分类、论元识别和论元角色分类。

- 触发词识别:通常认为触发词是事件抽取中的核心单元,可以清楚地表达事件的发生。触发词识别子任务是从文本中查找触发词。在图2中,触发词识别的任务是识别触发词“died”和“fired”。

- 触发词分类:触发词分类是根据现有触发词来确定每一句话是否是一个事件。此外,如果句子是一个事件,我们需要确定句子所属的一个或多个事件类型。例如图2,子任务旨在将触发词“died”和“fired”的事件类型分类为Die和Attack。因此,触发词分类子任务可以看作是一个多标签文本分类任务。

- 论元识别:论元识别是从文本中识别事件类型中包含的所有论元。论元识别通常取决于触发词分类和触发词识别的结果。例如图2中的Die事件。论元识别是抽取单词“Baghdad”、“cameraman”和“American tank”。

- 论元角色分类:论元角色分类基于事件抽取模式中包含的论元,每个论元的类别根据识别的论元进行分类。对于图2中抽取的单词,如“cameraman”,此子任务是将单词分类到目标类别。因此,它也可以被视为一个多标签文本分类任务。

2.3 事件抽取方法

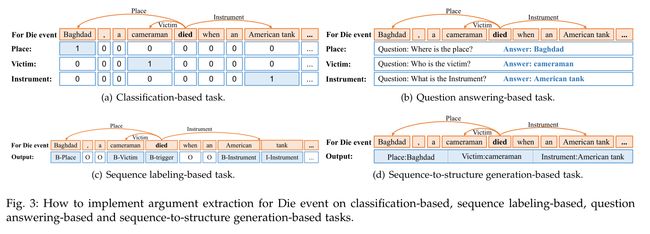

事件抽取是信息抽取中一个非常有代表性的热门主题,研究如何从包含事件信息的非结构化文本(新闻、博客等)中抽取特定类型的事件信息。它可以简化为多个分类任务,确定事件的类型和每个实体所属的论元角色。例如,图2中的单词“cameraman”。基于分类的方法是对其在给定角色集中所属的论元角色进行分类。分类方法依赖于命名实体识别,会导致错误信息的传播。在此基础上,提出了一种基于序列标注的事件抽取方法,该方法标记每个论元的开始和结束位置。基于序列标记的方法在BIO中给出了“cameraman"一词的标签,其中B代表“开始”,I代表“内部”,O代表“外部”。事件抽取的任务很复杂,而且论元之间有着密切的关系。机器阅读理解(MRC)被用来学习联系,每个论元都是通过问答对找到的。基于MRC的方法生成一个问题作为论元角色,例如Object,模型是找到扮演论元角色的单词Object。因此,事件抽取任务可以分为分类任务、序列标注任务和机器阅读理解任务。最近,一些工作侧重于使用生成方式[43], [44]。这四项任务的详细定义如下。

2.3.1 基于分类的任务

对于分类任务[45], [46],作者通常预先定义 n n n个事件类型及其相应的论元角色,例如,事件 e i ( i ∈ [ 1 , n ] ) e_i(i∈[1,n]) ei(i∈[1,n])包含一组论元角色 [ r i , 1 , r i , 2 … r i , l ] [r_{i,1},r_{i,2}\ldots r_{i,l}] [ri,1,ri,2…ri,l]。给定输入事件提及 m m m,模型需要输出结果向量 T T T,其中第 i i i个论元 T i T_i Ti表示 m m m属于事件 e i e_i ei的概率。在基于分类的任务中,触发词识别是对单词是否是触发词进行分类。在获得 m m m的最终事件(或集合) e k e_k ek之后,模型输出矩阵 R R R,其中论元 R i , j R_{i,j} Ri,j表示抽取的论元 a i a_i ai属于论元角色 r k , j r_{k,j} rk,j的概率。如图3(a)所示,它将每个实体分类为预定义的论元角色。

2.3.2 基于机器阅读理解的任务

机器阅读理解模型[47], [48], [49]可以用自然语言理解一段文本并回答有关问题[50]。在基于机器阅读理解的任务中,触发词识别也是为了对单词是否是触发进行分类。首先,为每个论元角色 r r r设计一个问题模式,称为 Q r Q_r Qr。

由于不同的事件类型具有不同的论元,因此模型需要首先识别文本所属的事件类型。然后,根据事件类型确定要抽取的论元角色。最后,基于机器阅读理解的事件抽取方法是输入文本 T T T,并将设计的问题 Q r Q_r Qr逐一应用到抽取模型中,如图3(b)所示。该模型抽取答案 A r A_r Ar,该答案 A r A_r Ar是每个论元角色 r r r的对应论元。

2.3.3 基于序列标注的任务

序列标记任务[51], [52], [53]是一个基于单词级别的多分类任务[54], [55], [56],可以基于单词级别事件类型抽取直接匹配事件论元。事件抽取主要包括两个核心任务:识别和分类事件类别和抽取事件论元。基于序列标记的事件抽取可以简单快速地实现事件类型和事件论元的匹配,而不需要额外的功能。在基于序列标记的任务中,触发词识别是为了标记一个单词是触发词。序列标记方法从文本中标记出目标,适用于事件抽取任务。如图3(c)所示,对于给定的文本 T = x 1 , x 2 , … , x N T=x_1,x_2,\ldots,x_N T=x1,x2,…,xN和事件模式,与论元相对应的论元角色 r r r用序列标记模型标记。输出 y = y 1 , y 2 , … , y N y=y_1,y_2,\ldots, y_N y=y1,y2,…,yN序列标记模型是对文本中的所有单词进行标记。

2.3.4 基于序列到结构的生成任务

基于序列到结构的生成事件抽取以端到端的方式从文本中抽取事件[43]。在基于序列到结构生成的任务中,触发词识别是生成触发词。它在一个模型中对所有任务进行统一建模,并普遍预测不同的标签。如图6所示,如图3(d)所示,基于序列到结构生成的方法直接生成所有论元及其角色。它通常采用编码器-解码器模型[43],这是一种将文本转换为结构化形式的简单方法。

3、事件抽取范式

事件抽取包括四个子任务:触发词识别、事件类型分类、论元识别和论元角色分类。根据解决这四个子任务的过程,事件抽取任务分为基于管道的事件抽取和基于联合的事件抽取。先前一般采用基于管道的方法[39], [57]。它首先检测触发词,并根据触发词判断事件类型。然后,论元抽取模型抽取论元,并根据事件类型和触发词的预测结果对论元角色进行分类。为了克服事件检测引起的错误信息传播,研究人员提出了一种基于联合的事件抽取范式[58], [59], [60]。它通过结合事件检测和论元抽取任务来减少错误信息的传播。

3.1 基于管道的事件抽取范式

基于管道的方法将所有子任务视为独立的分类问题[61], [62], [63]。管道的方法被广泛使用,因为它简化了整个事件抽取任务。如图4所示,基于管道的事件抽取方法将事件抽取任务转换为多阶段分类问题。所需的分类器包括:1)使用触发词分类器来确定文本中的事件触发词和事件类型。2)论元分类器用于确定单词是否是事件的论元。3) 论元角色分类器用于确定论元的类别。

基于经典深度学习的事件抽取模型动态多池化卷积神经网络(DMCNN)[39]使用两个动态多池化卷神经网络进行触发词分类和论元分类。触发词分类模型识别触发词。如果有触发词,则使用论元分类模型来识别论元及其角色。PLMEE[37]也使用了两个采用触发词抽取和论元抽取的模型。论元抽取模型使用触发词抽取的结果进行推理。它通过引入双向Transformer编码器表示(BERT)[64]取得更加有效的效果。

基于管道的事件抽取方法通过先前的子任务为后续的子任务提供额外的信息,并利用了子任务之间的依赖关系。Du等人[41]采用问答方法来实现事件抽取。首先,该模型通过设计的触发词的问题模板来识别输入句子中的触发词。模型的输入包括输入的句子和问题。然后,它根据识别的触发词对事件类型进行分类。触发词可以为触发词分类提供额外的信息,但错误的触发词识别的结果也会影响触发词分类。最后,该模型识别事件论元,并根据与事件类型对应的模式对论元角色进行分类。在论元抽取中,模型利用了上一轮内容的结果。

这种方法最显著的缺陷是错误传播。直观地说,如果第一步中的触发词识别存在错误,那么论元识别的准确性就会降低。因此,在使用基于管道的事件抽取时,会出现错误级联和任务拆分问题。基于管道的事件抽取方法可以通过使用触发词的信息来抽取事件论元。然而,这需要很高的触发词识别精度。错误的触发词会严重影响论元抽取的准确率。因此,基于管道的事件抽取方法将触发词视为事件的核心。

总结:基于管道的事件抽取方法将事件抽取任务转化为多阶段分类问题。基于流水线的事件抽取方法首先识别触发词,论元识别基于触发词识别的结果。它将触发词视为事件的核心。然而,这种分阶段的策略将导致错误的传播。触发词的识别错误将被传递到论元分类阶段,这将导致整体性能的下降。此外,由于触发词检测总是在参数论元之前,因此在检测触发词时不会考虑论元。因此,每个环节都是独立的,缺乏互动,忽略了它们之间的影响。因此,无法处理整个依赖关系,DMCNN[39]是典型的案例。

3.2 基于联合的事件抽取范式

事件抽取在NLP中具有重要的实用价值。在使用深度学习对事件抽取任务建模之前,联合学习方法已经出现在事件抽取的研究中。如图5所示,该方法根据第一阶段的候选触发词和实体来识别触发词和论元。在第二阶段,为了避免错误信息从事件类型传播,同时实现了触发词分类和论元角色分类。它将触发词“died”分类为Die事件类型,将论元“Baghdad”分类为Place论元角色等。

基于联合模型的深度学习事件抽取方法主要利用深度学习和联合学习与特征学习进行交互,可以避免学习时间的延长和复杂的特征工程[65], [66], [67]。Li等人[38]研究了基于传统特征抽取方法的触发词抽取和论元抽取任务的联合学习,并通过结构化感知器模型获得最优结果。Zhu等人[68]设计了高效的离散特征,包括特征词中包含的所有信息的局部特征和可以连接触发词和论元信息的全局特征。Nguyen等人[40]通过深度学习和联合学习成功构建了局部特征和全局特征。它使用循环神经网络将事件识别和论元角色分类相结合。构造的局部特征是文本序列特征和局部窗口特征。输入文本由单词向量、实体向量和事件论元组成。然后将文本转移到循环神经网络模型中,以获得深度学习的序列特征。还提出了一种带有记忆的深度学习模型来对其进行建模。它主要针对事件触发词之间、事件论元之间和事件触发词和事件论元之间的全局特性,去提升任务同时执行的效果。

事件抽取涉及实体识别等相关任务,这有助于改进事件抽取。Liu等人[69]利用论点的局部特征来辅助角色分类。他们首次为实体采用了联合学习任务,旨在降低任务的复杂性。前面的方法输入具有标记的特征的数据集,并输出事件。Chen等人[70]简化了过程,即纯文本输入和输出。在过程的中间,是对事件论元的联合学习。该联合学习因子主要提供每个输入事件内不同事件的关系和实体信息。

上述联合学习方法可以实现触发词和论元的联合建模事件抽取。然而,在实际工作过程中,触发词和论元的抽取是连续进行的,而不是同时进行的,这是一个亟待讨论的问题。此外,如果在深度学习中添加端到端模式,特征选择工作量将显著减少,这也将在后面讨论。联合事件抽取方法避免了触发词识别错误对事件论元抽取的影响,考虑到触发词和论元同等重要,但不能使用触发词的信息。

总结:为了克服基于管道的方法不足,研究人员提出了一种联合方法。联合方法构建了一个联合学习模型来触发识别和论点识别,其中触发词和论元可以相互促进对方的抽取效果。实验证明,联合学习方法的效果优于流水线学习方法。经典案例是通过循环神经网络进行联合事件抽取(JRNN)[40]。联合事件抽取方法避免了事件论元抽取中的触发词识别,但不能使用触发词的信息。联合事件抽取方法认为事件中的触发词和论元同等重要。然而,无论是基于管道的事件抽取还是基于联合的事件抽取,都无法避免事件类型预测错误对论元抽取性能的影响。此外,这些方法不能在不同的事件类型之间共享信息,也不能独立地学习每种类型,这不利于仅使用少量标记数据进行事件抽取。

4、事件抽取的深度学习模型

传统的事件抽取方法在学习深度特征方面具有挑战性,这使得依赖于复杂语义关系的事件抽取任务难以改进。最近的事件抽取工作基于深度学习架构,如卷积神经网络(CNN)[39], [101]、循环神经网络(RNN)[95], [102]、图神经网络(GNN)[82], [96], [103], [104], [105]、Transformer[37], [106], [107]或其他网络[58], [78]。如表1所示,我们根据发表年份显示了现有模型的基本信息。它包括作为模型探索的领域、发表模型的地点以及模型使用的数据集。此外,我们还得出了每个模型是否包含事件检测、论元抽取和命名实体识别的总结。深度学习方法可以捕捉复杂的语义关系,并显著改进多个事件抽取数据集。我们介绍了几种典型的事件抽取模型。

4.1 基于CNN的模型

在不使用复杂的自然语言处理工具的情况下自动抽取词汇和句子级别的特征,Chen等人[39]发表了一种单词表示模型,称为DMCNN。它捕捉单词的有意义的语义规则,并采用基于CNN的框架来捕捉句子级别的线索。然而,CNN只能捕捉句子中的基本信息,并且它使用动态多池化层来存储基于事件触发词和论元的更关键的信息。事件抽取是一种由具有自动学习特征的动态多池化卷积神经网络实现的两阶段多类分类。第一阶段是触发词分类。DMCNN对句子中的每个单词进行分类,以识别触发词。对于具有触发词的句子,此阶段应用类似的DMCNN为触发词分配论元并调整论元的角色。图6描述了论元分类的体系结构。词汇级特征表示和句子级特征抽取用于获取词汇线索和学习句子的组成语义特征。

CNN在句子中归纳出了k-grams的基本结构。因此,一些研究人员还研究了基于卷积神经网络的事件抽取技术。Nguyen等人[108]使用CNN来研究事件检测任务,与传统的基于特征的方法相比,该任务克服了复杂的特征工程和错误传播的限制。但它在很大程度上依赖于其他受监督的模块和人工资源来获得功能。在跨域泛化性能方面,它明显优于基于特征的方法。此外,为了考虑非连续k-gram,Nguyen等人[102]引入了非连续CNN。CNN模型通过具有丰富局部和全局特征的结构化预测应用于基于管道和联合的范式,以自动学习隐藏特征表示。与基于管道的方法相比,基于联合的范式可以缓解错误传播问题,并利用事件触发词和论元角色之间的相互依赖性。

4.2 基于RNN的模型

除了基于CNN的事件抽取方法外,相关研究学者还对RNN进行了其他一些研究。RNN用于对序列信息进行建模,以抽取事件中的论元,如图7所示。JRNN[40]提出了一种双向RNN,用于基于联合的范式中的事件抽取。它有编码阶段和预测阶段。在编码阶段,它使用RNN来总结上下文信息。此外,它还在预测阶段预测了触发词和论元角色。

以前的方法在很大程度上依赖于特定语言的知识和现有的NLP工具。Feng等人[109]开发了一种混合神经网络,用于在特定序列和信息片段的上下文中捕获信息,并将其用于训练多语言事件检测器,这是一种从数据中自动学习有用特征的更有前景的方法。该模型使用双向长短期记忆模型(LSTM)来获取文档的序列信息,并用于识别。然后利用卷积神经网络获取文档中的短语片段信息,将这两种信息结合起来,最终识别出触发词。该方法对多种语言(英语、中文和西班牙语)具有鲁棒、高效和准确的检测能力。在跨语言泛化性能方面,复合模型优于传统的基于特征的方法。深度学习中的树结构和序列结构比序列结构具有更好的性能。为了避免过度依赖词汇和句法特征,依赖桥接循环神经网络(DBRNN)[95]基于双向RNN进行事件抽取。DBRNN是通过桥接语法相关的单词来增强的。DBRNN是一个基于RNN的框架,它利用依赖关系图信息来抽取事件触发词和论元角色。

4.3 基于注意力的模型

通过深度学习模型自动抽取事件特征和通过外部资源增强事件特征主要关注事件触发词的信息,而较少关注事件论元和词间依赖性的信息。句子级序列建模在捕获非常长范围的依赖关系方面效率很低。此外,基于RNN和基于CNN的模型并不能完全建模事件之间的关联。注意力机制中结构信息的建模逐渐引起了研究人员的注意。随着研究方法的不断提出,添加注意力机制的模型逐渐出现,如图8所示。注意力机制的特征决定了它可以在不考虑位置信息的情况下使用全局信息来对局部上下文进行建模。它在更新单词的语义表示时具有良好的应用效果。

通过控制句子每个部分的不同权重信息,注意力机制使模型关注句子的重要特征信息,而忽略其他不重要的特征信息,并合理分配资源以抽取更准确的结果。同时,注意力机制本身可以作为一种对齐,解释端到端模型中输入和输出之间的对齐,使模型更具可解释性。

一些研究人员还使用层级注意力机制来进行信息的全局聚合。联合多事件抽取(JMEE)[96]由四个模块组成:单词表示、句法图卷积网络、自注意力触发词分类和论元分类模块。通过引入syntax shortcut arc来增强信息流。使用基于注意力的图卷积网络对图信息进行联合建模,以抽取多个事件触发词和论元。此外,当联合抽取事件触发词和论元以解决数据集失衡时,它优化了不平衡的损失函数。

4.4 基于图卷积网络的模型

句法表征提供了一种有效的方法,可以将单词直接链接到其信息上下文,用于句子中的事件检测[33], [82], [110], [111]。Nguyen等人[110]研究了基于依赖树的卷积神经网络来执行事件检测,他们是第一个将依赖树关系信息集成到神经事件检测中的人。该模型将所提出的模型与图卷积网络(GCN)[111]和基于实体提及的池化一起使用。他们提出了一种新的池化方法,该方法依赖于实体提及来聚合卷积向量。该模型对当前单词和句子中提到的实体的基于图的卷积向量进行池化。该模型聚合卷积向量以生成用于事件类型预测的单个向量表示。该模型是对来自实体提及的信息进行显式建模,以提高事件检测的性能。

在[77]中,文本分析会议知识库群体(TAC-KBP)事件槽用于填充任务中提出的四元时间表示,该模型预测事件的最早和最晚开始和结束时间,从而表示事件的模糊时间跨度。该模型基于共享的论元和时间关系为每个输入文档构建一个文档级事件图,并使用基于图的注意力网络方法在图上传播时间信息,如图9所示,其中实体用下划线表示,事件用粗体表示。Wen等人为输入文档构建了一种基于事件-事件关系的文档级事件图方法。将抽取文档中的事件论元。然后,根据诸如Before和After之类的关键字以及事件发生的时间逻辑,按时间顺序排列事件。实体论元在不同事件中被共享。模型实现将事件合并到一个更准确的时间线中。

4.5 基于Transformer的模型

利用在各种事件中扮演不同角色的论点来改进事件抽取是具有挑战性的。Yang等人[37]采用了一种方法,根据论元角色来分离论元预测,以克服角色重叠问题。此外,由于训练数据不足,该方法通过编辑原型和通过对质量进行排序来筛选开发的样本,从而自动生成标记数据。他们提出了一个框架,即基于预训练语言模型的事件抽取器(PLMEE)[37],如图10所示。PLMEE通过使用抽取模型和基于预训练的语言模型的生成方法的组合来促进事件抽取。它是一个两阶段的任务,包括触发词抽取和论元抽取,由触发词抽取器和论元抽取器组成,两者都依赖于BERT的特征表示。然后,它利用角色的重要性来重新加权损失函数。

GAIL[84]是一种基于ELMo的[112]模型,利用生成对抗性网络来帮助模型关注更难检测的事件。他们提出了一种基于生成对抗性模仿学习的实体和事件抽取框架。这是一种使用生成对抗性网络(GAN)的反向强化学习(IRL)方法。该模型通过使用IRL的动态机制,直接评估实体和事件抽取中实例的正确和不正确标记。

DYGIE++1[85]是一个基于BERT的框架,对句子和跨句子上下文中的文本跨度和捕获进行建模。许多信息抽取任务,如命名实体识别、关系抽取、事件抽取和共指解析,都可以受益于句子之间的全局上下文或不依赖于局部的短语。它们将事件抽取作为附加任务,并在事件触发词及其论元的关系图中进行跨度更新。跨度表示是在多句子BERT编码的基础上构建的。

总结:大多数传统的事件抽取方法都采用人工构建的方法进行特征表示,并使用分类模型对触发词进行分类和识别论元角色。近年来,深度学习在图像处理、语音识别和自然语言处理等方面表现出了突出的效果。为了解决传统方法的不足,系统地讨论了基于深度学习的事件抽取。在BERT模型出现之前,主流的方法是从文本中找到触发词,并根据触发词判断文本的事件类型。最近,随着BERT引入事件抽取模型,基于全文的事件类型识别方法成为主流。这是因为BERT具有出色的上下文表示能力,在文本分类任务中表现良好,尤其是在只有少量数据的情况下。

5、事件抽取场景

有一些工作专注于文档级、低资源、多语言和中文事件抽取,他们的目标是提高不同场景下的事件抽取能力。

5.1 文档级事件抽取场景

文档级事件抽取(DEE)旨在抽取文章中的事件。与句子级事件抽取(SEE)相比,提出了两个挑战:(i)论元分散:一个事件的论元可能分散在文档中的多个句子中,这意味着不能从单个句子中抽取一个事件记录;(ii)多事件:一个文档可能同时包含多个事件,这需要对事件之间的相互依赖性进行整体建模。到目前为止,现有的DEE研究通常可以分为两类。

第一类主要集中于抽取文档中的离散事件论元,即第一个挑战。早期的工作[113], [114]将文档级论元抽取作为MUC-4[115]的任务设置之后的填充范例。此外,研究人员[116], [117]将文档级事件论元视为RAMS[116]数据集中的论元链接问题,该数据集试图在给定事件触发词的整个文档中识别事件论元。尽管如此,上述工作是在预先给定事件类型或触发词的假设下进行的,这在现实世界中可能是不现实的。

第二类工作不是直接识别事件论元,而是遵循SEE中类似的先检测后抽取范式,从文档中抽取事件。具体而言,Yang等人[118]、Huang等人[119]和Li等人[120]首先识别特定的事件触发词来决定事件类型,然后抽取超出句子边界的事件论元。此外,研究人员[83], [121], [122]还试图在ChFinAnn数据集[83]中以无触发词的方式进行DEE,其中基于文档语义直接判断事件类型。Du等人[123]提出以生成模板的方式同时识别事件类型和论元。这些方法试图同时应对DEE的两个挑战,并引起了许多研究关注。

5.2 开放域事件抽取场景

在没有预定义事件模式的情况下,开放域事件抽取被设计为从文本中检测事件,并且在大多数情况下,通过抽取的事件关键词对类似事件进行聚类。事件关键词是那些主要描述事件的单词/短语,有时进一步分为触发词和参数。开放域事件抽取[16], [17], [18]没有固定论元角色模板。因此,论点通常是通过抽取关键词来获得的。Chau等人[16]提出了一种方法来过滤不相关的标题,并根据公共新闻标题进行初步事件抽取。价格和文本都被反馈到3D卷积神经网络中,以学习事件和市场走势之间的相关性。Liu等人[17]使用无监督生成方法设计了一种新的潜在变量神经模型,以探索潜在事件类型向量和实体提及冗余。实验结果表明,它可以扩展到非常大的语料库。

5.3 低资源下的事件抽取场景

由于数据标注是需要消耗大量的人力物力,通常只有不充分的数据来用完全监督的方法训练准确的EE模型。在这项调查中,我们将这种情况称为低资源情景。为了缓解数据稀疏性,现有研究已经探索了远程监督[91]方法来增强标注数据。此外,一些有前途的方法还研究了半监督方法[14], [75], [124]或多语言方法(见第5.4节),以丰富监督信息。最近,一些研究在三种典型的低资源环境中探索了EE,包括少样本学习环境、零样本学习环境和增量学习环境。在本节中,我们将简要介绍上述设置中的最新EE方法,作为快速参考。

少样本学习设置。最近,少样本学习方法[125], [126]在几个NLP任务[127], [128]中得到了广泛研究,其目的是在极其有限的(少样本,如1个示例、3个示例等)观察到的训练样本下进行任务预测。在事件抽取领域,现有的研究大多集中在少样本学习设置(FSED)中应用的事件检测子任务上。第一类工作[129], [130], [131], [132], [133], [134]旨在利用元学习方法在给定候选触发词的情况下进行触发词分类。为了接近实际应用,第二类工作[135], [136], [137]仅使用纯文本数据联合进行触发词识别和触发词分类。其中,Cong等人[136]进一步学习了具有原型摊销(prototypical)条件随机场(CRF)的稳健序列标签转换分数,实现了显著的改进。

零样本学习设置。以前的大多数监督EE方法都依赖于从手动标注派生的功能,如果没有额外的标注,这些功能就无法处理新的事件类型。一个极具挑战性的低资源场景是在没有任何可用标记数据的情况下实现EE。为了研究这种情况的可能性,最近的研究[61], [138]探索了用于事件抽取的零样本学习(ZSL)。Huang等人[61]首先解决了这个问题,利用事件提及和类型的结构本体进行表示,并通过语义相似性测量进行预测。Lyu等人[138]进一步研究了新事件的迁移学习方法,该方法将EE公式化为文本隐含(TE)和问答(QA)查询(例如,“A city was attacked”意味着“There is an attack”),并利用预先训练的TE/QA模型进行直接迁移。尽管这些方法与监督方法仍有很大差距,但它们揭示了一个富有洞察力的愿景,并为资源极低的EE提供了可能的改进方向。

增量学习设置。现有的ED方法通常需要固定数量的事件类型,并在固定的数据集上执行一次性训练。当不断出现新的事件类型和新出现的数据时,这种范式通常会遇到挑战。出于现实考虑,一个实用的ED系统应该逐步学习新的事件类型,同时对现有类型保持预测性,而不是需要一个固定的数据集来重新训练所有的事件类型。最近关于增量学习(也称为持续学习或终身学习)的研究[139], [140]集中在灾难性遗忘上,即学习系统在适应新类型时,通常会在旧类型上出现显著的性能下降。Cao等人[141]是第一个解决增量ED的工作,该工作通过提出的知识整合网络解决了灾难性遗忘和语义模糊问题,在增量ED上实现了有效的性能。

5.4 多语言事件抽取场景

事件抽取的单语言训练也是低资源环境中的一种有效方法[33], [142], [143]。Liu等人[143]提出了一种新的多语言方法,称为门控多语言注意力(GMLATT)框架,以同时解决这两个问题,并通过上下文注意力机制在多语言数据中开发一致的信息。它使用多语言数据中的一致证据,对其他语言提供的线索的可信度进行建模,并控制各种语言的信息集成。Ahmad等人[33]提出了一种图注意力转换器编码器(GATE)框架,该框架使用GCNS来学习与语言无关的句子。该模型将依赖关系结构嵌入到上下文表示中。它引入了一种自注意力机制来学习具有不同句法距离的单词之间的依赖关系。该方法可以捕获长距离依赖关系,然后通过掩码算法计算单词之间的句法距离矩阵。它在跨语言语句级关系和事件抽取方面表现良好。

5.5 中文事件抽取场景

与英语语料库中的事件抽取相比,中文事件抽取可视为事件抽取的一种特殊情况,具有特殊的价值和挑战。早期的方法[144], [145], [146], [147]使用精心设计的语言特征进行中文EE。在下文中,提出了基于神经网络的方法[99], [148],以减少对特征工程的严重依赖。注意,与英文EE相比,中文EE缺乏自然的单词分隔符,因此是按标记而不是按单词进行的。为了缓解中文标记语义的局限性,设计了巧妙的方法来整合单词级信息,以丰富标记语义。具体而言,Lin等人[149]提出了Nugget Proposal Networks(NPN),该网络通过从字符和单词中捕获结构和语义信息,导出用于事件触发词标记的混合字符表示。尽管如此,NPN中事件触发词的范围被限制在固定大小的窗口内,这使得它不灵活,并受到事件触发词之间重叠的影响。因此,Ding等人[150]提出了触发词感知Lattice神经网络(TLNN),该网络利用Lattice结构[151]将单词和字符语义结合起来。由于NPN和TLNN限制每个字符只能与一个匹配的单词交互,Cui等人[152]提出了一个配备了两种类型的节点(单词/字符)和三种边的异构图,以最大限度地保持单词-字符的交互。

6、事件抽取语料

用于事件抽取的标记数据集的可用性已成为快速发展背后的主要驱动力。在本节中,我们对这些数据集进行了总结。

6.1 文档级别

MUC-4。MUC-4是在第四次消息理解会议[115]中提出的。该数据集由1700个文档组成,其中五种类型的事件用相关的角色填充模板进行标注。

Google。谷歌数据集是事件、语言和语气全球数据库(GDELT)的一个子集事件数据库,事件相关单词检索包含11909篇新闻文章的30种事件类型的文档。

Twitter。Twitter数据集是从2010年12月发布的推文中收集的,应用了Twitter流媒体应用程序编程接口(API),包括20种事件类型和1000条推文。

NO.ANN,NO.POS,NO.NEG(DCFEE)。在论文[91]中,研究人员对四种类型的金融事件进行了实验,股权冻结事件、股权质押事件、股权回购事件和股权增持事件。通过自动生成数据,总共标记了2976个公告。公告数量(NO.ANN)表示可以为每个事件类型自动标记的公告数量。积极案例数(NO.POS)表示积极案例提及的总数。相反,消极案例量(NO.NEG)代表消极提及的次数。

ChFinAnn(Doc2EDAG)。在[83]中,基于十年ChFinAnn4文件和人类总结的事件知识库进行了基于远程监督(DS)的事件标记。新的中文事件数据集包括32040份文件和5种事件类型:股权冻结、股权回购、股权减持、股权增持和股权质押。

RAMS。Eber等人[116]发布了“跨多句角色”(Roles Across Multiple Pensiones,RAMS),用于论元链接任务,该任务旨在从5个语句窗口中识别给定事件触发词的事件论元。该数据集包含3194个文档,其中9124个事件是基于139个事件类型和65个角色的本体从新闻中标注的。

WIKIEVENTS。Li等人[120]将其作为文档级基准数据集发布。该数据集是从维基百科上描述真实世界事件的英文文章中收集的。

6.2 句子级别

Automatic Content Extraction(ACE)[1]。ACE 2005是事件抽取中使用最广泛的数据集。它包含一套完整的英文、阿拉伯文和中文训练数据,用于ACE 2005技术评估。语料库由语言数据联盟(LDC)为实体、关系和事件标注的各种类型的数据组成。它包括599个文档,其中包含8个事件类型、33个事件子类型和35个论元角色。

Text Analysis Conference Knowledge base Filling(TAC KBP)。作为KBP中的一个独立组件任务,TAC KBP事件跟踪(从2015年到2017年)的目标是抽取有关事件的信息,以便将其输入到知识库中。TAC KBP 2015 用英语定义了9种不同的事件类型和38种子事件类型。TAC-KBP 2016和TAC-KBP 2017有三种语言的语料库:英语、汉语和西班牙语,它们拥有8种事件类型和18种子事件类型。

Rich ERE。它扩展了实体、关系和事件本体,并扩展了什么是可标记的概念。Rich ERE还引入了事件跳跃的概念,以解决事件共指的普遍挑战,特别是在文档内和文档之间的事件引用以及事件论元的粒度变化方面,为创建(分层或嵌套)跨文档的事件表示铺平了道路。

FSED。基于ACE 2005和TAC KBP 2017,FSED数据集[135]是一个专门定制的生成少样本场景数据集。详细地说,它包含70852次提及,涉及19种事件类型和100个子事件类型。

GNBusiness。GNBusiness[17]从谷歌商业新闻中收集新闻报道,以描述来自不同来源的每一个事件。从2018年10月17日到2019年1月22日,共获得55618篇商业文章,共288批13047个新闻集群。全文语料库以GNBusinessFull text的形式发布。

FSD。第一个故事检测(FSD)数据集[153]是一个包括2499条推文的故事检测数据集。考虑到几个样本中提到的事件通常不重要,研究人员过滤掉了少于15个样本中提及的事件。它包括2453条推文,包含20种事件类型。

FBI dataset。FBI的城市级仇恨犯罪报告数据集[157]是通过抓取Patch“火灾与犯罪”类别中约37万篇未标记的新闻文章而建立的。它包含两个类别,用于对文本中是否存在特定的仇恨犯罪进行分类。此外,它还标注了仇恨犯罪文章的属性。

7、评估指标

对于事件抽取中定义的四个子任务[15], [37], [100], [164],使用包括精度(P)、召回率(R)和F1在内的三个指标来衡量性能。

这里,我们表示指标函数 I ( b o o l e a n ) : I ( T r u e ) = 1 , I ( F a l s e ) = 0 I(boolean):I(True)=1,I(False)=0 I(boolean):I(True)=1,I(False)=0。

触发词识别(TI):如果触发词的跨度偏移量与正确触发词完全匹配,则可以正确识别触发词。相应的指标包括:

P T I = ∑ I ( T D = T ∧ T D L = T L ∧ T D R = T R ) N T D (1) P_{TI}=\frac{\sum I(TD=T \wedge TD_L = T_L \wedge TD_R = T_R)}{N_{TD}} \tag{1} PTI=NTD∑I(TD=T∧TDL=TL∧TDR=TR)(1)

R T I = ∑ I ( T D = T ∧ T D L = T L ∧ T D R = T R ) N T (2) R_{TI}=\frac{\sum I(TD=T \wedge TD_L = T_L \wedge TD_R = T_R)}{N_{T}} \tag{2} RTI=NT∑I(TD=T∧TDL=TL∧TDR=TR)(2)

F 1 T I = 2 ∗ P T I ∗ R T I P T I + R T I (3) F1_{TI}=\frac{2*P_{TI}*R_{TI}}{P_{TI}+R_{TI}} \tag{3} F1TI=PTI+RTI2∗PTI∗RTI(3)

T D TD TD是被检测的触发词, T D L , T D R TD_L,TD_R TDL,TDR分别是 T D TD TD的左边界和右边界, T T T是正确的触发词, T L , T R T_L,T_R TL,TR分别是 T T T的左边界和右边界, N T D , N T N_{TD},N_T NTD,NT分别是预测的触发词数量和真实的触发词数量。

触发词分类(TC)。如果触发词的跨度偏移和事件子类型与正确触发词完全匹配,则对其进行正确分类。相应的指标包括:

P T C = ∑ I ( T D = T ∧ T D t = T t ∧ T D L = T L ∧ T D R = T R ) N T D (4) P_{TC}=\frac{\sum I(TD=T \wedge TD_t = T_t \wedge TD_L = T_L \wedge TD_R = T_R)}{N_{TD}} \tag{4} PTC=NTD∑I(TD=T∧TDt=Tt∧TDL=TL∧TDR=TR)(4)

R T C = ∑ I ( T D = T ∧ T D t = T t ∧ T D L = T L ∧ T D R = T R ) N T (5) R_{TC}=\frac{\sum I(TD=T \wedge TD_t = T_t \wedge TD_L = T_L \wedge TD_R = T_R)}{N_{T}} \tag{5} RTC=NT∑I(TD=T∧TDt=Tt∧TDL=TL∧TDR=TR)(5)

F 1 T C = 2 ∗ P T C ∗ R T C P T C + R T C (6) F1_{TC}=\frac{2*P_{TC}*R_{TC}}{P_{TC}+R_{TC}} \tag{6} F1TC=PTC+RTC2∗PTC∗RTC(6)

T D t y p e , T t y p e TD_{type},T_{type} TDtype,Ttype分别指的是预测得事件类型和真实的事件类型。

论元识别(AI)。如果论元的跨度偏移量和相应的事件子类型与正确论元完全匹配,则可以正确识别该论元。相应的指标包括:

P A I = ∑ I ( A D = A ∧ T D t = T t ∧ A D L = A L ∧ A D R = A R ) N A D (7) P_{AI}=\frac{\sum I(AD=A \wedge TD_t = T_t \wedge AD_L = A_L \wedge AD_R = A_R)}{N_{AD}} \tag{7} PAI=NAD∑I(AD=A∧TDt=Tt∧ADL=AL∧ADR=AR)(7)

R A I = ∑ I ( A D = A ∧ T D t = T t ∧ A D L = A L ∧ A D R = A R ) N A (8) R_{AI}=\frac{\sum I(AD=A \wedge TD_t = T_t \wedge AD_L = A_L \wedge AD_R = A_R)}{N_{A}} \tag{8} RAI=NA∑I(AD=A∧TDt=Tt∧ADL=AL∧ADR=AR)(8)

F 1 A I = 2 ∗ P A I ∗ R A I P A I + R A I (9) F1_{AI}=\frac{2*P_{AI}*R_{AI}}{P_{AI}+R_{AI}} \tag{9} F1AI=PAI+RAI2∗PAI∗RAI(9)

其中 A D AD AD是检测到的论元, A D L AD_L ADL和 A D R AD_R ADR是 A D AD AD的左右边界, A A A是正确论元, A L AL AL和 A R AR AR是的 A A A左右边界。 N A D N_{AD} NAD和 N A N_A NA表示预测的论元数量和实际论元数量。

论元分类(AC):如果论元的跨度偏移量、相应的事件子类型和论元角色与正确论元完全匹配,则对其进行正确分类。其相应的指标包括:

P A C = ∑ I ( A D = A ∧ T D t = T t ∧ A D r = A r ∧ A D L = A L ∧ A D R = A R ) N A D (10) P_{AC}=\frac{\sum I(AD=A \wedge TD_t = T_t \wedge AD_r = A_r \wedge AD_L = A_L \wedge AD_R = A_R)}{N_{AD}} \tag{10} PAC=NAD∑I(AD=A∧TDt=Tt∧ADr=Ar∧ADL=AL∧ADR=AR)(10)

R A C = ∑ I ( A D = A ∧ T D t = T t ∧ A D r = A r ∧ A D L = A L ∧ A D R = A R ) N A (11) R_{AC}=\frac{\sum I(AD=A \wedge TD_t = T_t \wedge AD_r = A_r \wedge AD_L = A_L \wedge AD_R = A_R)}{N_{A}} \tag{11} RAC=NA∑I(AD=A∧TDt=Tt∧ADr=Ar∧ADL=AL∧ADR=AR)(11)

F 1 A C = 2 ∗ P A C ∗ R A C P A C + R A C (12) F1_{AC}=\frac{2*P_{AC}*R_{AC}}{P_{AC}+R_{AC}} \tag{12} F1AC=PAC+RAC2∗PAC∗RAC(12)

A D r , A r AD_r,A_r ADr,Ar指的是预测的论元角色数量和真实的论元角色数量。

8、定量结果

本节主要总结了现有的事件抽取工作,并比较了ACE 2005数据集的性能,如表4和表5所示。评估指标包括precision、recall和F1。

近年来,事件抽取方法主要基于深度学习模型。如表4所示,就F1的值而言,基于深度学习的方法在事件检测和论元抽取方面都优于基于机器学习的方法和模式匹配方法。GATE(En2ZH)[33]正处于从英语到汉语的单一来源转换中,在论元角色分类方面表现良好。Li等人[163]提出了一种文档级神经网络事件论元抽取模型。它适用于ACE 2005,用于抽取所有事件类型的零样本事件。我们可以得到基于深度学习模型的事件抽取方法的有效性。这可能表明,基于深度学习的方法可以更好地学习事件抽取任务中论元之间的相关性。在基于深度学习的模型中,基于BERT的方法表现最好,如表4和表5所示。这表明BERT可以更好地学习句子的上下文信息,并根据当前文本学习单词的表示。它可以更好地学习当前上下文中单词的语义关联,并有助于学习论元之间的关联。

将基于管道的方法(RBPB[98]和DEEB-RNN[93])与没有Transformer[165]的基于联合的方法(JRNN[40]和DBRNN[95])进行比较,可以看出,联合模型的事件抽取方法优于管道模型,尤其是对于论元角色分类任务。从DMCNN[39]和DMCNN-MIL[70]可以得出结论,当外部资源用于基于深度学习的方法时,效果显著提高,略高于联合模型。Zeng等人[92]引入了外部资源,提高了触发词分类在精度和F1上的性能。因此,这可能表明增加外部知识是一种有效的方法,但将外部知识引入论元抽取仍需探索。

9、事件抽取应用

在本节中,我们将介绍几个与事件相关的应用,这些应用可以被视为事件抽取的直接下游任务。通常,识别的事件可用于事件图构建[166]、事件进化分析[167]和其他基于事件的NLP应用[168],如问答[169], [170]和阅读理解[171]。在这些任务中,我们重点研究了三个与事件相关的广泛研究的任务,即脚本事件预测(SEP)、事件真实性识别(EFI)和事件关系抽取(ERE)。

10、未来研究趋势

事件抽取是文本挖掘中一项重要而富有挑战性的任务,它主要从描述事件的相关文本中学习事件的结构化表示。事件抽取主要分为两个子任务:事件检测和论元抽取。事件抽取的核心是识别文本中与事件相关的单词,并将其分类到适当的类别中。基于深度学习模型的事件抽取方法自动抽取特征,避免了手工设计特征的繁琐工作。事件抽取任务被构建为一个端到端系统,使用具有丰富语言特征的词向量作为输入,以减少底层NLP工具造成的错误。以前的方法侧重于研究有效特征,以获取候选触发词、候选论元的词汇、句法和语义信息。此外,基于深度学习的方法探索了触发词之间的关系,与同一触发词相关的多个实体之间的依赖性,以及与同一实体相关的多个触发词之间的关系。根据事件抽取的特点和目前的研究现状,我们总结了以下技术挑战。

10.1 事件抽取语料库面临的挑战

事件抽取数据集构建。事件抽取任务复杂,现有的预训练模型缺乏对事件抽取任务的学习。现有的事件抽取数据集具有少量标记数据,并且手动注标注事件抽取数据集合具有较高的时间成本。因此,构建大规模事件抽取数据集或设计自动构建事件抽取数据集合也是未来的研究趋势。

外部资源。事件抽取的数据集很小。深度学习结合外部资源,构建大规模数据集,取得了良好的效果。由于构建标记数据集的困难和数据集的体积小,如何更好地利用深度学习,在外部资源的帮助下有效地抽取事件也是一个紧迫的研究方向。

事件抽取范式。事件抽取方法可分为封闭域事件抽取方法和开放域事件抽取方式。没有模式的事件抽取方法的效果很难评估,基于模板的事件抽取法需要根据不同的事件类型设计不同的事件模式。因此,如何设计一个基于事件特征的通用事件抽取模式是克服构建事件抽取数据集和类间共享知识困难的重要手段。

10.2 事件抽取模型面临的挑战

依赖性学习。使用BERT的事件抽取方法已成为目前的主流。然而,事件抽取与BERT模型在预训练的学习任务不同。论元抽取需要考虑事件论元角色之间的关系,以抽取同一事件类型下的不同角色。它需要事件抽取模型来学习文本的句法依赖关系。因此,建立事件论元之间的依赖关系是全面准确地抽取每个事件类型的论元所急需解决的问题。

端到端的学习模型。与传统方法相比,基于联合模型的深度学习方法的优势在于联合表示形式。事件抽取取决于实体的标签。因此,本文认为,建立基于深度学习的端到端自主学习模型是一个值得研究和探索的方向,如何设计多任务、多联邦是一个重大挑战。

多事件抽取。根据事件抽取的粒度不同,事件抽取可以分为句子级事件抽取和文档级事件抽取。关于句子层面的事件抽取,已经有很多研究。然而,文档级事件抽取仍处于探索阶段,文档级的事件抽取更接近实际应用。因此,如何设计文本的多事件抽取方法具有重要的研究意义。

领域性事件抽取。领域文本通常包含大量的技术术语,这增加了领域性事件抽取的难度[249]。例如,生物医学EE(BEE)旨在抽取捕捉生物医学实体之间相互作用的事件[250], [251], [252], [253]。抽取和利用它们有利于医学研究和疾病预防[254], [255]。因此,如何设计有效的方法来理解领域文本中深层的语义信息和上下文对应关系已成为亟待解决的问题。

事件抽取的可解释性。事件抽取包括四个子任务,现有的事件抽取通常考虑如何提高抽取的准确性,但对事件抽取的可解释性研究很少[256]。由于事件抽取的任务很复杂,很难直接理解为什么模型将一个单词划分为复杂文本的某个论元角色。这需要事件抽取模型是可解释的,以便于手动区分预测结果,这在生物和医学领域非常重要[257]。

11、总结

本文主要介绍了现有的用于事件抽取任务的深度学习模型。首先,我们从事件抽取的三个方面介绍了概念和定义。然后,我们将基于深度学习的事件抽取范式分为管道式和联合式,并分别介绍它们。基于深度学习的模型通过改进表示学习方法、模型结构以及额外的数据和知识来提高性能。然后,我们介绍了带有汇总表和评估指标的数据集。此外,我们在ACE 2005数据集的汇总表中给出了领先模型的定量结果。最后,我们总结了事件抽取未来可能的研究趋势。

【论文速递 | 精选】

>>> 阅读原文访问社区

阅读全文

最近工作