Attention U-Net:Learning Where to Look for the Pancreas 阅读记录

阅读目的:老师分享

标题:Attention U-Net:Learning Where to Look for the Pancreas(学习在哪里寻找胰腺)

作者团队:Ozan Oktay 生物医学图像分析组,帝国理工学院,伦敦,英国伦敦

来源:arXiv 2018

源码链接:https://github.com/ozan-oktay/Attention-Gated-Networks

数据集链接:https://github.com/ozan-oktay/Attention-Gated-Networks

摘要部分笔记:

1、提出的应用于医学图像的attention gate(AG)可以使模型自动学习聚焦于不同形状和大小的目标结构;

2、使用AGs训练的模型可以再抑制输入图像中的无关区域,同时突出对特定任务有用的显著特征;

3、AGs可以很容易地集成到标准CNN架构中,如U-Net模型,以最小的计算开心同时增加模型的敏感度(sensitivity)和预测精度(accuracy)

4、在两个大型CT腹部数据集上对提出的attention U-Net结构进行了评估,用于多类图像分割。实验结果表明,AGs在保持计算效率的同时,能持续提高U-Net在不同数据集和训练规模下的预测性能

介绍部分笔记(含文献综述):

1、在介绍动机(讲故事)时,着重说明本文提出的改进是针对级联框架的:

(1)FCN和U-Net在面对目标区域在形状和大小方便表现出很大的患者间差异时,这些结构依赖于多级级联CNN

(2)级联框架提取ROI,并对特定ROI进行dense prediction(机制类似于先定位再预测)

(3)但是级联框架占用了更多地计算资源,并导致了模型参数的冗余,例如级联中的所有模型都重复地提取类似的低级特征。

2、可训练注意力是通过设计强制执行的,分为硬注意力和软注意力。

硬注意力,例如迭代区域建议和裁剪,通常是不可微的,并且依赖于强化学习来进行参数更新,这使得模型训练更加困难;

软注意是概率性的,利用标准的反向传播,而不需要蒙特卡罗采样。

3、提到的几个不了解的概念:

(1)Moreover, our approach can be used for dense predictions since we do not perform adaptive pooling.

dense prediction 密集预测:标注出图像中每个像素点的对象类别,要求不但给出具体目标的位置,还要描绘物体的边界,如图像分割、语义分割、边缘检测等等。(绝了,只是换了个说法)

adaptive pooling 自适应池:自适应池化Adaptive Pooling与标准的Max/AvgPooling区别在于,自适应池化Adaptive Pooling会根据输入的参数来控制输出output_size,而标准的Max/AvgPooling是通过kernel_size,stride与padding来计算output_size(当我们使用Adaptive Pooling时,这个问题就变成了由已知量input_size,output_size求解kernel_size与stride)

从文中的意思是密集预测与自适应池化不能共存

算法部分笔记:

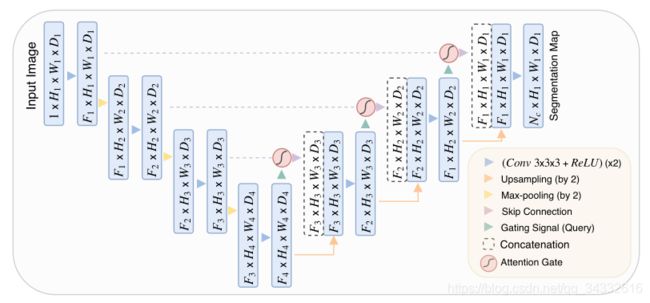

1、整体结构图

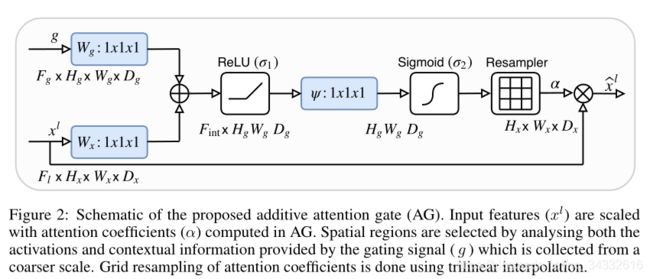

2、Attention Gates的结构

图中的xl为图1的绿色箭头,将深层次的语义特征输入门中进行特征筛选,g为图1中跳跃连接连接的部分

3、虽然图中没有画出,文中使用深度监督强制中间特征映射在每个图像尺度上具有语义判别性,这有助于确保不同尺度的注意单位能够影响对大范围图像前景内容的响应。

实验部分笔记:

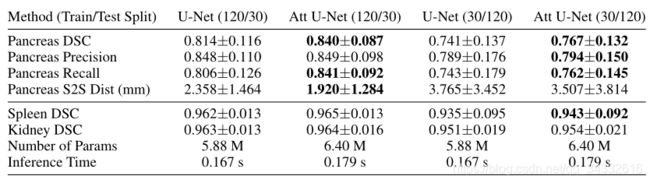

1、实验结果展示(与U-Net比较)

列出来的分别是胰腺,脾脏,肾脏

从这个图来看,应该是multi-class分割

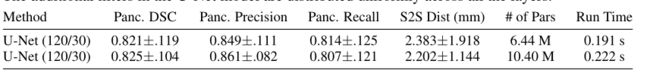

2、增加U-Net参数后的结果

简要总结:

1、这个Attention Gate的结构感觉已经出现在脑子里了,没有什么惊艳的感觉,加在跳跃连接上,更是满满地既视感,总感觉我们之前画过类似的结构,只不过attention模块里面的结构有些区别

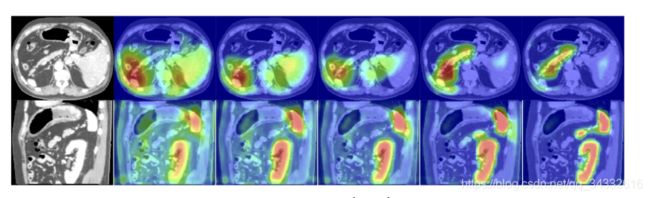

2、文中证明了在跳跃连接上进行操作是可行的,并且文中似乎实现了对多类器官应用多个AG,这样的话就可以使用一个主框架分别提取不同类别的特征了,但是具体实现方式现在想不到需要参考源码

The filtered feature activations (d-e, i-j) are collected from multiple AGs, where a subset of organs is selected by each gate.