大数据——hadoop之hive安装和配置

hadoop之hive安装和配置

- 安装Hive前,需要准备的条件

- 安装Hive

- 配置Hive

安装Hive前,需要准备的条件

- Hive需要hadoop环境

hadoop环境安装和配置 - Hive需要zookeeper环境

zookeeper安装和配置 - Hive需要myql数据库

mysql数据安装和设置

安装Hive

- 进入software目录

[root@hadoop100 ~]# cd /software

- 解压hive-1.1.0-cdh5.14.2.tar.gz到opt目录下

[root@hadoop100 software]# tar -zxvf hive-1.1.0-cdh5.14.2.tar.gz -C /opt

- 进入opt目录下

[root@hadoop100 software]# cd /opt

- 把hive-1.1.0-cdh5.14.2改名

[root@hadoop100 opt]# mv hive-1.1.0-cdh5.14.2/ hive

配置Hive

- 进入hive目录下,并创建个warehouse目录

[root@hadoop100 opt]# cd hive/

[root@hadoop100 hive]# mkdir warehouse

- 修改环境变量

[root@hadoop100 hive]# vi /etc/profile

- 输入

export HIVE_PATH=/opt/hive

export PATH=$PATH:$HIVE_PATH/bin

- 保存退出,使环境变量生效

[root@hadoop100 hive]# source /etc/profile

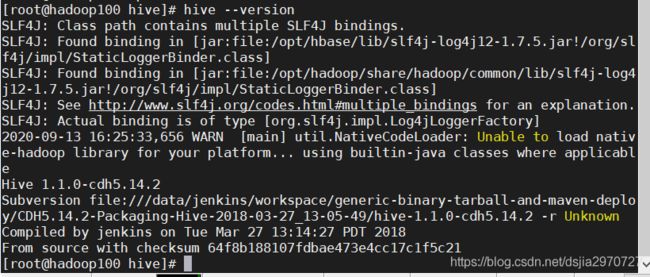

- 查看版本信息

[root@hadoop100 hive]# hive --version

- 进入conf目录下

[root@hadoop100 hive]# cd conf/

- 把hive-env.sh.template改名

[root@hadoop100 conf]# mv hive-env.sh.template hive-env.sh

- 配置hive-env.sh文件

[root@hadoop100 conf]# vi hive-env.sh

- 输入

HADOOP_HOME=/opt/hadoop

export HIVE_CONF_DIR=/opt/hive/conf

export HIVE_AUX_JARS_PATH=/opt/hive/lib

- 保存退出,创建hive-site.xml

[root@hadoop100 conf]# vi hive-site.xml

- 输入:

<configuration>

<property>

<name>hive.metastore.warehouse.dir</name>

<value>/opt/hive/warehouse</value>

</property>

<property>

<name>hive.metastore.local</name>

<value>true</value>

</property>

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://127.0.0.1:3306/hive?createDatabaseIfNotExist=true</value>

</property>

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

</property>

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>ok</value>

</property>

</configuration>

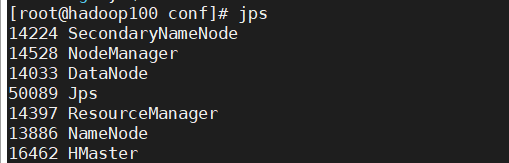

- 启动hdfs

[root@hadoop100 conf]# start-all.sh

- 启动Hbase

[root@hadoop100 conf]# hbase-daemon.sh start maseter

或

[root@hadoop100 conf]# start-hbase.sh

- 把mysql的mysql-connector-java-5.1.38.jar jar包放到hive目录下的lib目录下

- 重启mysql

[root@hadoop100 conf]# service mysql restart

- 格式化mysql

[root@hadoop100 conf]# schematool -dbType mysql -initSchema

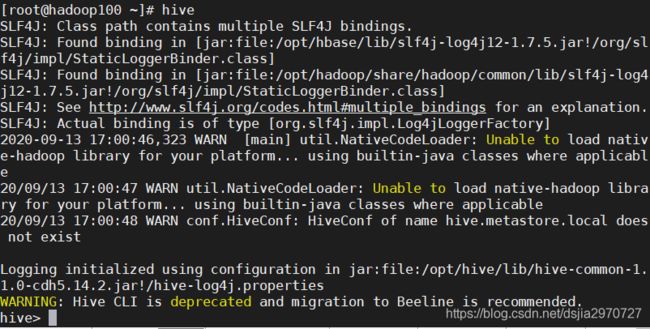

- 启动hive

[root@hadoop100 conf]# hive

如果启动hive报错,先进mysql里,把hive数据库删掉,再创建一次

mysql -uroot -pok

show databases;

drop database hive;

create database hive;

这时候再来启动hive

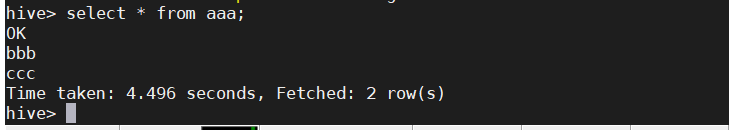

- 测试,建表

create table aaa(anname varchar(10));

- 添加数据

insert into aaa values('bbb'),('ccc');

- 查看数据

select * from aaa;

- 退出hive

quit;

- 关闭hbase

[root@hadoop100 conf]# hbase-daemon.sh stop maseter

或

[root@hadoop100 conf]# stop-hbase.sh

- 关闭hdfs

[root@hadoop100 conf]# stop-all.sh

注意:开启时:先要开启hdfs,再开启hbase,最后开启hive。

关闭时:先要关闭hive,再关闭hbase,最后关闭hbase