U-STN:U-shaped spatial–temporal transformer network for 3D human pose estimation

基于U形时空Transformer网络的三维人体姿态估计

源码:https://github.com/lfay/Pose3D.

摘要

随着卷积神经网络的发展,三维人体姿态估计技术取得了很大的进展。由于深度模糊和严重遮挡,从单视图图像或视频中准确估计3D关节位置仍然存在一些挑战。基于将视觉变换器引入计算机视觉任务的有效性,提出了一种基于U形时空变换器的三维人体姿态估计网络(U-STN)。该方法的核心思想是通过设计一个多尺度、多层次的U形变压器模型来处理人体关节。我们构建了一个具有三个不同尺度的人体骨骼拓扑的多尺度体系结构,其中局部和全局的功能通过三个不同的尺度与运动学约束进行处理。此外,通过融合来自U形网络的不同深度的中间特征,引入多级特征表示。通过为U-STN设计的骨架约束池化和去池化操作,网络可以跨不同尺度变换特征,并在所有级别提取有意义的语义特征。在两个具有挑战性的基准数据集上的实验表明,该方法在2D到3D姿态估计方面取得了良好的性能。

最近,视觉变换器已被广泛引入计算机视觉任务。由于Transformer架构嵌入了自注意和位置机制,它可以灵活地建模与输入序列的长范围的全局一致性信息。另外,如上所述,影响3D HPE的性能的核心因素是由模型提取的特征。具有出色表现能力的功能将提升3D HPE的性能。这些观察启发我们设计一个U形时空Transformer网络(U-STN),专注于如何有效地提取空间和时间特征,以提高3D HPE的性能。在我们的工作中,开发了一个多尺度和多层次的时空Transformer模型提取人体骨骼特征,其中的多尺度时空变换器架构建模,学习帧内不同的关节之间的相互作用,并捕获全局依赖帧间。由于多尺度特征表示可以捕获输入数据的从小到大分辨率的信息,因此它可以带来丰富的局部到全局信息。设计了多层次特征表示模型,融合了U型网络中不同深度的中间特征,能够从浅到深的各个层次上捕捉重要的语义信息。此外,通过为U-STN设计的骨架约束池化和解池化操作,网络可以跨不同尺度转换特征,并在所有级别提取有意义的语义特征。

总而言之,所提出的方法的贡献如下:

(1)提出了一种用于三维动态人体PE的U型时空变换网络,该网络将多尺度、多层次的时空变换特征表示与人体骨架拓扑结构相结合,构建了U型时空变换网络。

(2)对多尺度时空Transformer架构进行建模以从帧间学习不同关节之间的帧内交互和全局相关性,其中多尺度架构基于人体骨骼拓扑结构由三个不同尺度组成。

(3)引入多级特征表示来融合U形网络的不同深度的中间特征,其中执行骨架约束池化和解池化操作以用于跨不同尺度转换特征并在所有级别提取有意义的语义特征。

方法

1.Problem formulation

所提出的方法遵循用于视频中的3D HPE的2D到3D提升架构。给定2D姿态关节位置序列X xt,j| t 1,…T; j1,…作为输入,3D HPE的目标是重建3D关节坐标|t 1,…T; j1,…其中xt,j ∈ RJ×2和st,j ∈ RJ×3分别表示t ∈ T帧上二维和三维的第j个联合位置。T和J分别是视频帧和关节的数量。与主流的基于CNN的3D姿态估计模型不同,我们设计了一种用于3DHPE的U形时空Transformer网络。该网络首先采用时空Transformer模型来学习帧内不同关节之间的相互作用和帧间的全局相关性。然后,骨架约束池化和unpooling操作被引入到构建的U形模型,通过在不同的尺度上转换的功能和提取的语义特征,在所有级别的网络。通过将时空Transformer模型与多尺度、多层次特征结合在U形结构中,构造了U形时空变换网络(U-STN),继承了它们的优点,使模型更具有三维HPE的表达能力。

2.时空Transformer特征提取模型

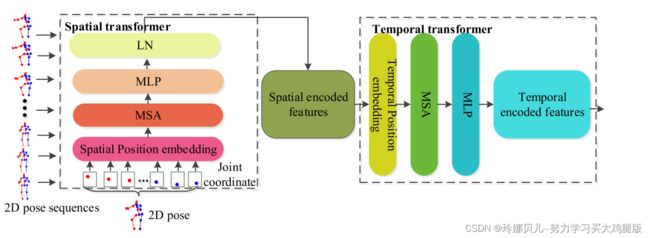

Transformer模型具有自注意和位置机制,具有强大的建模能力的短期和长期的输入序列的关系。由于帧内和帧间节点之间的相关性是至关重要的3DHPE,我们设计了一个时空Transformer特征提取模型,综合编码的局部和全局骨架功能在空间和时间维度上的空间变换器模型和时间变换器模型,分别。Transformer自注意编码周围关节之间的关系,有效地捕捉局部的帧内关节的相关性和全局的帧间的身体关节的依赖性。时空Transformer特征提取模型的框架如图1

2.1用于局部相关特征提取的空间Transformer模型(STM)

空间Transformer模型(STM)采用每帧内的自我注意力来捕捉不同关节之间的位置关系。利用2D关节的全面连通性,STM可以通过采用空间自注意来编码每个帧中关节到关节的空间关系来学习每个帧的更强的特征表示。假设帧t处的每个2D关节Xt,j ∈ Rx2作为输入令牌,采用[27]中的通用视觉变换架构来提取空间域中所有输入令牌的高维特征。首先,通过线性投影在每个关节的2D坐标上执行空间位置嵌入ESPos ∈ RJ×C,其中位置嵌入用于保留每个帧中关节的空间位置信息,如下所示:

其中E ∈ R(J·2)×C是将每条路径变换为高维特征的线性投影矩阵,C是空间嵌入的维数。

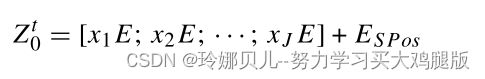

然后,将联合Zt0 ∈ RJ×C的高维特征输入到空间Transformer编码器模型的自注意层,该层由多层感知器(MLP)和归一化层(LN(·))组成的多头自注意层(MSA),MSA利用多头注意对输入的不同位置的关系进行建模,并嵌入特征.在L层空间Transformer编码器处理特征Zt,0之后,STM的编码器输出Zt,L ∈ RxC可以表示如下:

其中STM的空间编码器特征Zt L ∈ RJ×C的输出被馈送到时间Transformer模型以提取输入序列的全局依赖性。

2.2用于特征的全局依赖性提取的时间Transformer模型(TTM)

由于时间Transformer模型(TTM)中的自注意可以通过分析同一身体关节沿着时间维度的嵌入变化来有效地学习帧间每个关节的相关性。时间Transformer模型(TTM)是用来提取全局之间的依赖关系的输入序列的空间特征表示。我们首先将每个帧处的STM的空间编码器特征Zt L ∈ RJ×C平坦化为向量Zt ∈ R1×(J×C),并且将它们级联以形成输入Z 0 {Z1,Z2,…,ZT,其中Z 0 ∈ RT×(J×C).然后,对Z 0进行时间位置嵌入ETPos ∈ RT×(J×C),以保留输入帧的位置信息。(1)(2).在执行L个相同层MSA和MLP之后,时间Transformer的输出可以表示为时间编码特征Y ∈ RT×(J×C)。

3骨架约束池化和非池化层

现有的大多数三维HPE方法都是将二维骨骼关节作为一个整体的图形数据,只使用单尺度、单分辨率的特征来构建输入数据的拓扑关系。这些方法忽略了人体各关节具有不同的相对运动空间这一事实;例如膝盖和肘部比相邻的关节如臀部和肩部具有更大的运动空间。这可能会限制3D HPE模型的性能。由于特征表示能力是影响模型表达能力的核心因素,因此我们提取多尺度和多层次的特征形成U型网络,其中池化和反池化操作是构建U型网络多尺度特征的关键。因此,我们引入了一个骨骼约束池和unpooling操作,在不同的尺度上转换功能,并提取各级语义特征,旨在学习更全面的身体关节关系的功能和丰富我们的模型的性能。

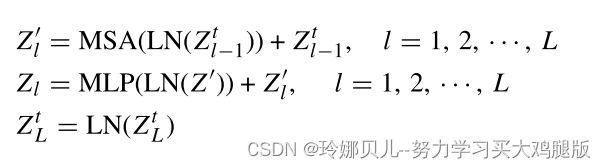

3.1空间池化层

由于多尺度特征所需的池化和去池化主要是针对图像定义的,忽略了图中节点的地理信息,不适用于图结构数据,导致图表示的信息丢失。因此,在我们的工作中,根据人体关节之间的连接关系,我们设计了一个多尺度的骨架结构,分别为17,11和7个节点的规模s1,2和3(s1,2,3涉及大,中,小规模)。如图2

具有全部17个关键点的大尺度S1可以提取小感受野内的每个关键点的局部特征。具有7个节点的小尺度S3可以在大的感受野内捕获全局轮廓特征。我们利用空间池层将相应的特征转换为低尺度的骨架结构特征,这对于减小特征图的尺寸和扩大感受野是重要的。给定在s尺度上的特征矩阵Xs ∈ RV×2,我们首先构造池化矩阵Ms ∈ RU×V以将尺度s中的v个节点减少到s + 1尺度中的U个组,然后,使用1*1卷积来自适应地融合特征,如下所示:

其中Xs +1 ∈ RU×2,Ms ∈{0,1}表示s尺度中的第v个关节是否属于第u个池化组中的s +1尺度。在我们的工作中,M2 ∈ R11×17,M3 ∈ R7×11。Ws ∈ RU×V是衡量组u中关节v重要性的可训练权重。是元素乘法,是矩阵乘法。

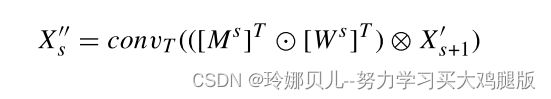

3.2空间unpooling层

由于unpooling操作是从原始分辨率恢复低尺度骨架信息所必需的,我们设计了一个骨架约束空间unpooling层来传递低尺度特征并将其融合以形成高尺度特征。当U组节点在s + 1尺度上经过空间池层后,对应的节点特征矩阵为Xs +1 ∈ RU×C。然后,使用2D转置卷积convT(·)来恢复较高尺度的骨架表示,如下所示:

其中[·]T是Ms和Ws的转置矩阵。(4),我们将特征X s+1从s + 1尺度变换为s尺度的特征X s。

4 U形时空Transformer网络(U-STN)

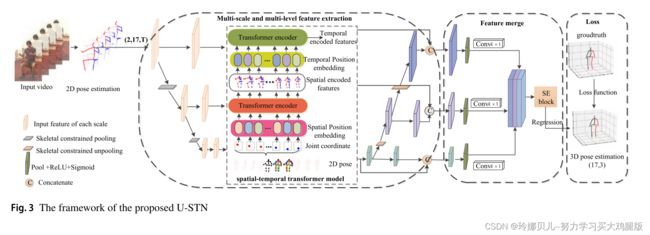

如图3,所提出的U形时空Transformer网络由三个阶段组成:(1)利用骨架约束池化和解池化的多尺度特征提取,(2)利用时空Transformer模型的多级特征提取,以及(3)多尺度和多级特征合并。

4.1具有骨骼约束池化和解池化的多尺度特征提取

U-STN从具有27*17*2人体关节的高分辨率分支特征开始。通过利用骨架约束空间池化执行下采样来形成新的分支,如在Sect. 3.3.我们设计了一个3分支(s1,2,3涉及大-中-小尺度),分别基于17、11和7三个不同节点的骨架结构。利用如在等式1中计算的多尺度特征提取中的空间池化和解池化。(3)以及(4),多尺度特征学习在各种尺度下整合来自不同分辨率的特征,其中在U-STN的相对低的尺度处引入更多的通道用于骨架表示。因此,随着在多尺度中执行的连续空间池化,引入更多通道并且逐渐扩大用于特征提取的感受野。这对于捕获从小到大分辨率的输入骨架的信息是有用的,并且减少了由于尺度变化而导致的信息损失。

4.2基于时空Transformer模型的多层次特征提取

由于模型中不同深度的多层次特征能够从浅到深的各个层次上捕捉到重要的语义信息,因此我们设计了一个U型时空变换特征提取模型来捕捉不同尺度的多层次中间特征.利用来自三种不同骨骼结构的多尺度特征,我们首先执行如Sect. 3.2对于每个分辨率特征。令Xs表示s尺度的特征矩阵,并且将其输入到STM。然后,在执行Eqs之后。(1)以及(2),STM [Zt L]s的输出被馈送到时间Transformer模型中。来自s尺度的TTM的对应输出Ys是等级s的特征。通过对来自三种不同骨架结构的多尺度特征进行时空Transformer模型,实现了具有不同形状和通道的三种不同层次的特征。由于时空Transformer模型从相邻帧学习不同关节之间的帧内交互和帧间相关性中的特征,因此它为3D HPE带来了有价值的语义信息。

4.3多尺度和多层次特征的特征合并模型

由于多尺度特征呈现图结构数据的空间域内的信息,并且多层次特征提供从浅到深的所有层次的语义信息,因此我们设计了特征合并模型,用于将它们连接以获得3D HPE的最终整体特征。针对时空Transformer模型从三个尺度上处理的三种不同分辨率的特征,首先采用Sect. 3.3将低尺度骨架特征嵌入到高尺度中。设Ys ∈ RJ×(C×T)表示时空Transformer模型在尺度s,s2上处理的特征,三个尺度s2上对应的节点部分为s2.来自较低尺度的特征由骨架约束解池化层处理以实现较高尺度特征,如下所示:

然后,为了更好地将来自U-STN网络的不同深度的多级中间特征嵌入到多尺度特征中以获得3DHPE的最终特征,我们设计了如图所示的特征合并模型。3.利用从Eq.(5)和Ys,每个尺度下的最终特征通过融合来自网络的不同级别的相同尺度特征来实现,如下所示:

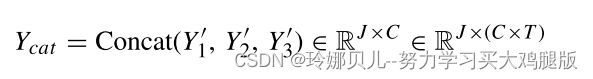

其中pool(·)是平均池化操作,其针对所有输入序列以及每个尺度下的每个通道中的骨架节点执行,旨在捕获Ys的逐通道统计信息。W1 ∈ RC×(C/r)和W2 ∈ R(C/r)×(C×U)表示两个全连通层的权值,r表示约简比。最后,来自三个尺度的特征与嵌入的不同深度的中间特征从不同的水平被用于3D HPE。这些特征首先通过1*1卷积变换为相同的形状,该卷积用于减少较低尺度特征的通道。然后,将来自U-STN的这三个尺度特征连接起来,以获得整体特征表示,如下所示:

其中J和C表示每个尺度中的节点和特征尺寸的数量。由于整体特征由跨U形网络的不同尺度和不同深度的多尺度和多级特征连接,因此它使模型能够从小到大的分辨率捕获特征,并在中间特征之间提供丰富的语义特征表示。然后,使用[28]中的挤压和激励块(SE块)来测量所有级联特征Ycat的通道权重。最后,将SE块的输出馈送到一个线性层进行3D回归,对应的输出st,j ∈ RJ×3| t 1,…T; j1,…J是中心帧的估计3D姿态。

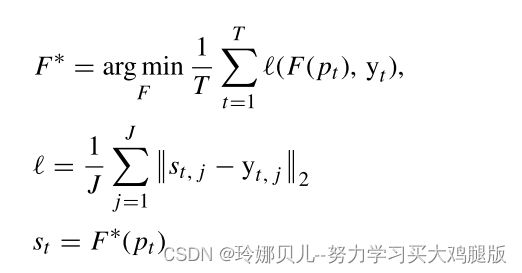

5 损失函数

所提出的模型是用均方误差(MSE)损失训练的,其用于最小化T帧中的估计姿态和地面实况姿态之间的误差,如下所示:

其中(·)是MPJEP(每关节位置误差的平均值)损失函数,st,j和yt,j是第t帧中的第j个关节的估计和真实3D关节位置。

结论

在本文中,我们已经开发了一个U形时空Transformer网络的3D HPE从单目图像。为了更好地编码帧内和帧间局部和全局骨架特征的互补特性,设计了一种基于时空Transformer架构的U型多尺度多层次特征提取模型。通过骨架约束池化和解池化层对不同尺度和不同深度的特征进行变换,该模型能够有效地将全局特征和局部特征从完整骨架到局部部分进行整合,从而提高了模型的特征表示能力。实验结果表明,该模型达到了最先进的性能在两个基准的2D到3D姿态估计数据集。