AI伦理:科技发展中的人性之声

文章目录

-

- AI伦理的关键问题

-

- 1. 隐私问题

- 2. 公平性问题

- 3. 自主性问题

- 4. 伦理教育问题

- 隐私问题的拓展分析

-

- 数据收集和滥用

- 隐私泄露和数据安全

- 公平性问题的拓展分析

-

- 历史偏见和算法

- 模型可解释性

- 自主性问题的拓展分析

-

- 自主AI决策

- 伦理框架

- 伦理教育的拓展分析

-

- 伦理培训

- 结论

欢迎来到AIGC人工智能专栏~AI伦理:科技发展中的人性之声

- ☆* o(≧▽≦)o *☆嗨~我是IT·陈寒

- ✨博客主页:IT·陈寒的博客

- 该系列文章专栏:AIGC人工智能

- 其他专栏:Java学习路线 Java面试技巧 Java实战项目 AIGC人工智能 数据结构学习

- 文章作者技术和水平有限,如果文中出现错误,希望大家能指正

- 欢迎大家关注! ❤️

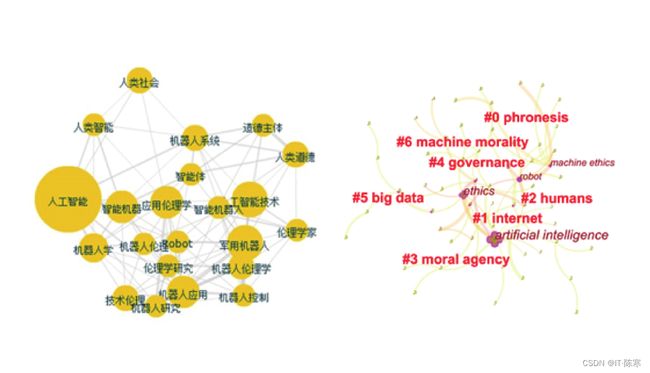

人工智能(Artificial Intelligence, AI)技术正以惊人的速度融入我们的日常生活中。AI系统如今可以用于各种应用,包括智能助手、自动驾驶汽车、医疗保健和金融服务。然而,随着AI技术的快速发展,我们也面临着一系列伦理问题,这些问题涉及到我们的隐私、公平性、自主性和责任等方面。本文将深入探讨AI伦理的各个方面,并为新手小白提供易懂的解释和示例。

AI伦理的关键问题

在深入讨论AI伦理之前,让我们首先了解一下AI伦理的核心问题。

1. 隐私问题

问题:AI系统需要访问和分析大量的个人数据,这可能对用户的隐私构成威胁。

示例:社交媒体平台使用用户的个人数据来定向广告。

解决方案:建立数据隐私法规,确保个人数据的收集和使用是受到监管的。

2. 公平性问题

问题:一些AI系统可能对某些人群产生不公平的影响,例如在招聘中出现性别或种族偏见。

示例:招聘算法可能会因为历史偏见而偏向于特定性别或种族的候选人。

解决方案:改进训练数据和算法,以更好地反映多样性和公平性。

3. 自主性问题

问题:自主AI系统(如自动驾驶汽车)可以在没有人类干预的情况下做出重要决策,这引发了责任问题。

示例:自动驾驶汽车在紧急情况下必须做出决策,例如避免事故。

解决方案:建立法律框架,明确自主AI系统的责任和法律责任。

4. 伦理教育问题

问题:开发人员和数据科学家需要受到伦理教育,以确保他们能够考虑和解决伦理问题。

示例:AI系统的开发人员需要明白伦理规范,以避免不当行为。

解决方案:在教育和培训中加强伦理内容的教育。

隐私问题的拓展分析

让我们深入研究第一个关键问题:隐私问题。AI系统的广泛应用导致了大量个人数据的收集和分析。这些数据包括文本、图像、视频和位置信息等,但随之而来的是数据滥用和隐私泄露的担忧。

数据收集和滥用

许多应用程序和在线服务需要访问您的个人数据,以提供更个性化的体验。例如,社交媒体平台可以分析您的帖子、喜好和行为,然后将这些信息用于广告定位。虽然这可以带来更相关的广告,但也引发了隐私问题。

# 代码示例:社交媒体广告定位

user_data = {

'name': 'Alice',

'age': 30,

'interests': ['travel', 'cooking', 'technology']

}

# 广告定位算法使用用户数据来显示相关广告

targeted_ads = get_targeted_ads(user_data)

解决方案:为了解决数据收集和滥用问题,需要制定严格的数据隐私法规,确保个人数据的收集和使用受到适当的监管。用户还可以通过隐私设置来控制其数据的使用。

隐私泄露和数据安全

随着个人数据的大规模收集,数据泄露和安全成为重要问题。黑客和不法分子可能会入侵数据库,获取敏感信息,这可能会对个人、企业和社会造成严重损害。

# 代码示例:数据泄露

def hack_database():

# 黑客入侵数据库并获取用户数据

data = database.get_sensitive_data()

return data

# 数据库安全性不足可能导致数据泄露

解决方案:为了保护个人数据的安全,需要采取数据加密、访问控制和网络安全措施。此外,组织需要建立有效的应急响应计划,以迅速应对数据泄露事件。

公平性问题的拓展分析

公平性问题涉及到AI系统对不同人群的影响是否公平。这是一个复杂的伦理问题,需要深入研究和讨论。

历史偏见和算法

许多AI系统在训练过程中使用历史数据,这可能包含偏见或不公平的信息。例如,招聘算法可能会因为历史偏见而对某些候选人不公平。

# 代码示例:招聘算法中的历史偏见

def biased_recruitment_algorithm(applicants):

# 基于历史数据的算法可能会偏向某些群体

selected_applicants = biased_selection(applicants)

return selected_applicants

解决方案:为了解决公平性问题,我们需要改进训练数据和算法,以减少历史偏见的影响。这可能需要采取重采样、重新权衡数据集或修改算法以确保公平性。

模型可解释性

另一个与公平性相关的问题是模型的可解释性。一些AI模型非常复杂,难以理解和解释它们的决策过程。这可能会导致不公平的结果,因为无法确定为何做出了特定的决策。

# 代码示例:难以理解的模型决策

def complex_model_decision(model_input):

# 复杂的深度学习模型决策不透明

decision = complex_model.predict(model_input)

return decision

解决方案:为了提高模型的可解释性,可以使用解释性AI技术,例如局部可解释性模型(Local Interpretable Model-Agnostic Explanations,LIME)或SHAP(SHapley Additive exPlanations)方法。这些方法可以帮助理解模型的决策过程。

自主性问题的拓展分析

自主AI系统,如自动驾驶汽车和机器人,可以在没有人类干预的情况下做出重要决策。这引发了一系列责任和法律问题。

自主AI决策

自主AI系统必须在复杂的情境中做出决策,例如在道路上行驶时遇到紧急情况。这些决策可能会涉及生命和财产的安全。

# 代码示例:自动驾驶汽车的紧急决策

def autonomous_vehicle_decision(sensors_data):

# 自动驾驶汽车必须在紧急情况下做出决策,例如避免事故

decision = autonomous_vehicle.make_decision(sensors_data)

return decision

解决方案:为了解决自主性问题,需要建立法律框架,明确自主AI系统的责任和法律责任。这可能涉及到制定法规,

规定在特定情况下人类驾驶员和AI系统的责任。

伦理框架

开发自主AI系统的公司和研究人员需要考虑伦理框架,以指导他们的行为。这包括如何处理决策、风险管理和道德考虑。

# 代码示例:自主AI系统的伦理决策

def ethical_decision_making(ai_system):

# 开发伦理框架以指导自主AI系统的决策

decision = ai_system.make_ethical_decision()

return decision

解决方案:制定伦理指南和框架,以帮助开发人员和组织确保他们的自主AI系统是道德和负责任的。

伦理教育的拓展分析

为了应对伦理挑战,开发人员和数据科学家需要受到伦理教育,以提高他们的伦理意识和决策能力。

伦理培训

在开发AI系统之前,开发人员应接受伦理培训,了解伦理原则和伦理框架。这有助于他们在设计和实施过程中考虑伦理问题。

# 代码示例:伦理培训

def ethics_training(data_scientist):

# 为数据科学家提供伦理培训,以增强他们的伦理意识

ethics_training_module = EthicsTraining()

ethics_training_module.complete_training(data_scientist)

解决方案:提供伦理培训课程和资源,以帮助开发人员和数据科学家了解伦理原则和最佳实践。

结论

AI伦理是人工智能领域的一个重要议题。随着AI技术的不断发展,我们必须认真思考伦理问题,以确保AI系统是公平、安全、负责任的。通过建立法律框架、改进训练数据和算法、提高模型的可解释性以及提供伦理培训,我们可以更好地应对AI伦理挑战,为科技发展中的人性之声提供指导。

希望本文对新手小白理解AI伦理问题有所帮助。在使用和开发AI技术时,请始终考虑伦理原则和最佳实践,以确保我们共同构建一个更好的未来。

结尾

❤️ 感谢您的支持和鼓励!

您可能感兴趣的内容:

- 【Java面试技巧】Java面试八股文 - 掌握面试必备知识(目录篇)

- 【Java学习路线】2023年完整版Java学习路线图

- 【AIGC人工智能】Chat GPT是什么,初学者怎么使用Chat GPT,需要注意些什么

- 【Java实战项目】SpringBoot+SSM实战:打造高效便捷的企业级Java外卖订购系统

- 【数据结构学习】从零起步:学习数据结构的完整路径