点云 3D 天气数据增强 - LiDAR Snowfall Simulation for Robust 3D Object Detection (CVPR 2022)

点云 3D 天气数据增强 - LiDAR Snowfall Simulation for Robust 3D Object Detection - 用于鲁棒3D目标检测的激光雷达降雪模拟(CVPR 2022)

- 摘要

- 1. 引言

- 2. 相关工作

- 3. LiDAR点云的降雪模拟

-

- 3.1 湿地面模型

- 4. 实验

-

- 4.1 定量结果

- 4.2 定性结果

- 5. 结论

- References

- 补充材料

- 1. 引言

- 2. 其他降雪模拟细节

- 3. 其他湿地模拟细节

- 4. 其他数据集详细信息

-

- 4.1 地面湿度分布

- 4.2 降雪划分

-

- 4.2.1 降雪强度分布

- 4.3 目标统计

- 5. 其他定量结果

- 6. 其他定性结果

- 7. 限制性讨论

- References

声明:此翻译仅为个人学习记录

文章信息

- 标题:LiDAR Snowfall Simulation for Robust 3D Object Detection (CVPR 2022)

- 作者:Martin Hahner, Christos Sakaridis, Mario Bijelic, Felix Heide, Fisher Yu, Dengxin Dai, Luc Van Gool

- 文章链接:https://openaccess.thecvf.com/content/CVPR2022/papers/Hahner_LiDAR_Snowfall_Simulation_for_Robust_3D_Object_Detection_CVPR_2022_paper.pdf

- 补充材料:https://openaccess.thecvf.com/content/CVPR2022/supplemental/Hahner_LiDAR_Snowfall_Simulation_CVPR_2022_supplemental.pdf

- 文章代码:https://github.com/SysCV/LiDAR_snow_sim

摘要

3D目标检测是自动驾驶等应用程序的中心任务,在自动驾驶系统中,即使在恶劣天气的情况下,系统也需要对周围的交通代理进行定位和分类。在本文中,我们解决了降雪条件下基于激光雷达的3D目标检测问题。由于在此设置中收集和注释训练数据的困难,我们提出了一种基于物理的方法来模拟降雪对真实晴朗天气LiDAR点云的影响。我们的方法对每个激光雷达线在二维空间中的雪粒子进行采样,并使用诱导的几何结构相应地修改每个激光雷达光束的测量值。此外,由于降雪经常导致地面潮湿,我们还模拟了激光雷达点云的地面湿度。我们使用我们的模拟生成部分合成的雪域激光雷达数据,并利用这些数据训练对降雪具有鲁棒性的3D目标检测模型。我们使用几种最先进的3D目标检测方法进行了广泛的评估,结果表明,与晴空基线和竞争模拟方法相比,我们的模拟在真实的雪域STF数据集上始终取得了显著的性能提升,同时不会牺牲晴空天气下的性能。我们的代码可在https://github.com/SysCV/LiDAR_snow_sim上获得。

1. 引言

光检测和测距(LiDAR)传感器是一种可用于多种应用的有源测距传感器[10,27,39,61]。其高质量的3D输出使LiDAR成为需要3D推理的多个任务的首选模式,例如3D目标检测[25,59]。随着LiDAR传感器越来越便宜[53],它们与自动驾驶汽车的集成也变得越来越可行。尽管如此,先前的传感器测试表明,这种主动脉冲系统在散射介质中很脆弱,导致在各种天气条件下感知距离的减少,如雨[4,14,52],雾[2,4,18,19,52]和雪[19,24,28],如图1所示。在这些条件下,光学介质包含水或雪的颗粒,它们与激光束相互作用并吸收、反射或折射其光子。这会产生两种影响:(i)与视线处目标相对应的接收功率的衰减,以及(ii)来自粒子的反向散射,导致接收功率中的寄生最大值,从而导致与目标真实范围不同的范围内的寄生回波。因此,由于强噪声(相对于在晴朗天气中捕获的点云有较大域偏移)测量质量严重下降,因此对诸如3D目标检测等高级任务的性能产生不利影响[1,16]。然而,根据美国交通部[49]和欧盟委员会[8]的报告,在恶劣天气中实现良好的感知是一个可取的目标,因为在恶劣天气下,人类驾驶员的死亡率明显更高。

图1. 在大雪中3D目标检测结果,与未进行增强(左上)相比,事先对所提出的数据增强方案进行了训练(右上)。底行显示RGB图像作为参考。

由于不利天气数据很难收集[1],先前的工作已经研究了模拟方法,以缩小雾[36]和雨[48]中相机数据的区域差距。最近,还提出了雾[1,16]和雨[14,22]中LiDAR传感器的模拟方法。受这一工作的启发,我们引入了一种基于物理的方法来模拟真实晴朗天气LiDAR点云上的降雪。特别地,我们使用[33]中引入的线性系统来模拟LiDAR脉冲的传输和传感器处的相关接收功率。我们通过显式采样雪粒子并将其建模为不透明球体来模拟降雪,其大小由降雪率控制[15,32]。在我们的采样中,我们遵循排除原理,即没有两个粒子彼此相交。给定雪粒子的样本,我们计算每个LiDAR光束与之相交的粒子集,并导出每个粒子反射的光束横截面的角度,同时考虑到潜在的遮挡。该推导直接提供了降雪情况下线性系统的修正脉冲响应,这允许对传感器处的接收功率进行分析计算。

与降雪相关的另一个条件是地面潮湿。这种出现的薄层增加了地表反射的镜面分量[44]。为了模拟地面反射,我们引入了一个使用菲涅耳方程和薄表面反射的光学模型,该模型为湿表面提供了合适的反射值。

使用我们的降雪和湿地面模拟生成的部分合成点云作为训练数据,用于优化最先进的3D目标检测方法,从而使所学习的模型在降雪情况下更加稳健。希望我们的基于物理的模拟足够逼真,从而使我们不再需要真正的雪地训练样本。我们在STF数据集[1]的具有挑战性的真实雪子集上对在这种情况下训练的模型进行了基准测试,并发现在我们的模拟雪上训练的模型与仅在晴朗天气和竞争模拟方法上训练的基线模型相比,始终取得了显著的性能提升。

2. 相关工作

不利天气研究可细分为气象出版物,提供计算机视觉方法的基础知识[15,32,33,38],不同天气条件下引入扰动模式的现象学推理[2,4,24],以及计算机视觉算法在此类挑战条件下的应用[1,29,37,48]。在[33]中,研究了预测各种天气类型(包括雨、雾和雪)对激光雷达影响的一般理论框架。作者根据散射粒子的统计分布研究了这些天气效应,如[15]和[38]中的雪。[32]中给出了降雪能见度的进一步含义。

对[4,14,52]中的雨、[2,4,18,19,52]的雾、[19,24,28]中的雪和[5,44,56]中的湿表面,对这些产生的扰动模式及其强度进行了现象学研究。在算法上,作者尝试通过稳健的融合算法[1]解决这些问题,开发了模拟技术,作为[36,48]中相机数据和[1,14,16,22]中激光雷达数据的数据增强。作者还在[6,17,43]中研究了消除不利天气影响的增强技术,或在[37]中应用了调整晴朗天气算法以适应不利天气的域自适应方法。[1,3,29,37,46]中介绍了包含不利天气样本的基础深度学习数据集。然而,经典的数据循环方法很难应用,因为恶劣天气样本很少,而且代表性很低[1]。

对不利天气的模拟可以通过数据合成减轻不利天气影响的罕见性和数据收集活动中的困难,如[35,36,48]所示。此外,在[17,43]中,它能够生成具有清晰真值的可再现条件,以学习图像增强技术,或在[48]中研究不同天气影响下可再现的不利天气噪声相关性能降低。在[1,14,16,22]中明确研究了LiDAR模拟方法。开发始于[1],在雾中采用数据驱动方法,该方法通过[16]进行了扩展,引入了基于物理的模型,并实现了更高的3D目标检测性能。[14]中介绍了雨的模拟方法,[22]中介绍了雪、雨和雾的一般方法。与[22]相反,我们的降雪模拟涉及功率信号域中的连续公式,这允许我们叠加不同粒子的反射,并推断粒子和目标之间的遮挡,从而更好地遵守激光传输的物理原理。此外,我们考虑了湿路的影响,允许我们以数据驱动的方式从干路强度中估计激光硬件参数作为噪声基底和发送强度。

近年来,3D目标检测取得了巨大进展。已经为RGB相机[45,54,60]、LiDAR[25,31,39–42,62]、门控成像器[20]或[7,23,30,51]中的多模态融合提出了几种方法。然而,在许多数据集排行榜中,顶级性能位置通常都是在基于LiDAR的方法中排序的[3,13,46]。在我们的工作中,我们使用了PV-RCCN[39]、VoxelRCNN Car[9]、CenterPoint[59]、Part-A²[42]、PointRCNN[41]、SECOND[57]和PointPillars[25]等方法。这些方法在点云表示、使用的特征提取主干和检测阶段的数量方面有所不同。作为输入模态,例如在体素空间[39,40,42,57,62]中处理点云,推断原始点云[31,41]或使用抽象表示,如[25]中的柱。

检测阶段的数量通常分为单阶段[25]和两阶段方法[39–41,57,59,62],其中单阶段方法直接离散输入空间并预测每个单独单元的目标[26]。两阶段方法首先预测提案,并按照[34]的一般思想在随后的合并特征空间中对其进行细化。

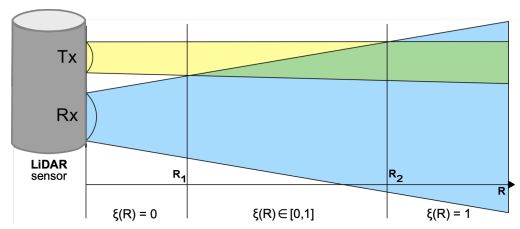

图2. LiDAR传感器示意图,其中发射器Tx和接收器Rx不具有同轴光学器件,但具有平行轴(称为双基地光束配置)。

3. LiDAR点云的降雪模拟

自由空间中的脉冲传播可以用几何光学来模拟,以实现高性价比的激光雷达系统。此类系统应用同步近场红外脉冲发射器Tx和雪崩光电二极管(APD)阵列作为接收器Rx,如图2所示和[55]所述。发出的激光脉冲P0被固体场景目标(通常称为目标)反射,反射率为ρ0,并被接收器捕获,提供捕获回波的时间延迟τ及其相应的功率PR。通过应用R=cτ计算目标距离R,其中c是光速。目标的3D位置[x,y,z]通过使用脉冲发射的方向获得。对于扩展目标,几何光学[11]可用于建模接收功率PR

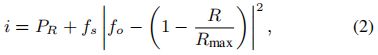

![]()

这适用于直径大于距离R处光束直径的目标,并且需要关于(i)入射角αin和(ii)与距离和时间无关的系统常数CA的附加信息。然而,由于光学和光束发散不同,每个扫描层的CA不同,因此接收的激光功率通常会被校正[11]。根据[21],可以报告四种不同级别的强度校准。对于我们实验中使用的Velodyne HDL-S3D传感器,根据传感器手册[50]应用光束发散校正。该修正定义为

其中fs是焦点斜率,fo是焦点偏移。从工厂侧校准中检索每个激光器的参数。在应用所提出的模拟方法之前,我们首先通过反转该强度校准来检索原始强度。在降雪中,光学介质中包含的粒子小于光束直径,因此必须考虑Mie散射和粒子的精确空间分布[33]。

[33]中引入的线性模型描述了散射粒子存在下的脉冲传播,该模型对非弹性散射有效。该模型将与距离相关的接收功率PR表示为时间相关的发射信号功率PT和光学系统的脉冲响应H之间的时间卷积:

发送脉冲的时间特征由

τH是半功率脉冲宽度,对于Velodyne HDL-S3D传感器设置为10 ns。脉冲响应H可以被分解为光信道HC和目标HT的脉冲响应:

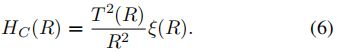

![]()

HC取决于光束发散、ξ(R)所描述的发射器和接收器的重叠以及介质的透射率T(R)

假设不存在其他散射体,则介质中不被雪颗粒占据的部分的透射率T(R)等于1。重叠ξ(R)可以从图2中几何推导得出

目标的脉冲响应HT允许我们对雪粒子进行建模,我们将在下面详细介绍。

场景反射通过HT定义了粒子与激光脉冲的相互作用。对于扩展的实体指定目标,我们可以写

![]()

ρ0是目标的反射率,δ是狄拉克δ函数。然而,在降雪中,除了固体指定目标外,激光束也被雪粒子部分反射。

图3. 模拟降雪量对应于降雪速率rs=2.5 mm/h。左侧块显示了清晰的未受干扰输入。右图显示了我们的降雪模拟(顶部)和LISA[22](底部)中的降雪模拟。请注意,我们真实地模拟散射,并仅衰减受单个雪花影响的点,而不是基于它们的距离衰减所有点。

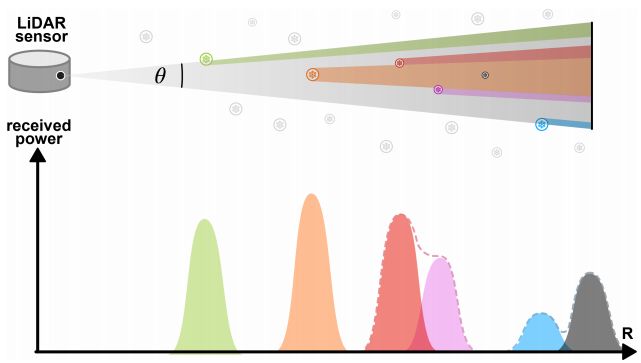

图4. 雪粒子干扰单个激光雷达光束(顶部)。相应接收功率回波的示意图(底部)。注意单个目标的接收功率如何相互重叠(cτH≈3 m,τH=10 ns)。

我们将雪粒子j建模为具有反射率ρs的球形目标,直径Dj遵循[15]中引入的分布,距离传感器的距离Rj,均匀地随机放置在传感器周围,使其不与任何其他粒子相交。颗粒的数量根据降雪率进行选择,通常范围为0-2.5 mm/h(更多详情请参见补充材料)。如图4(顶部)所示,粒子可以相互遮挡并遮挡指定的目标。因此,每个粒子j只反射光束开口角Θ的一小部分θj/Θ,也使光束的一部分θ0/Θ到达目标。补充材料中也给出了计算比率θj/Θ的详细信息。

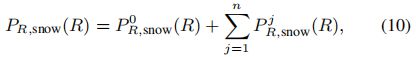

假设所有j的Dj≪cτH,我们可以写

其中 Θ = θ 0 + ∑ j = 1 n θ j Θ=θ_0+ \sum_{j=1}^n{θ_j} Θ=θ0+∑j=1nθj。将(4)、(5)、(6)和(9)插入(3),降雪时的接收功率为

其中

P R , s n o w 0 ( R ) P^0_{R,snow}(R) PR,snow0(R)可以通过在(11)的右侧用(θ0,R0,ρ0)替换(θj,Rj,ρs)来导出。

因此,接收功率是多个回波的叠加,每个回波与一个目标(雪粒子或指定目标)相关,如图4(底部)所示。至关重要的是,每个回波的大小取决于角度θj和相应目标与传感器的距离Rj的平方反比。在这项工作中,我们检索了作为激光雷达返回的接收功率的最大峰值。因此,如果雪粒子导致的峰值高于与指定的目标相关联的峰值,则会丢失真实回波,并在前一峰值的范围内将杂波点添加到模拟点云中。

否则,指定的目标强度将根据其遮挡百分比衰减。我们的完整降雪模拟在算法1中给出。在图3中,我们展示了一个冬季示例场景,一次用我们的降雪模拟进行了增强,一次使用LISA中提出的场景[22]。

图5. 干燥公路上的真实世界捕捉(顶部),水高度dw=0.53 mm(中部)的真实世界捕获,以及来自清晰参考的合成道路湿度(底部)。

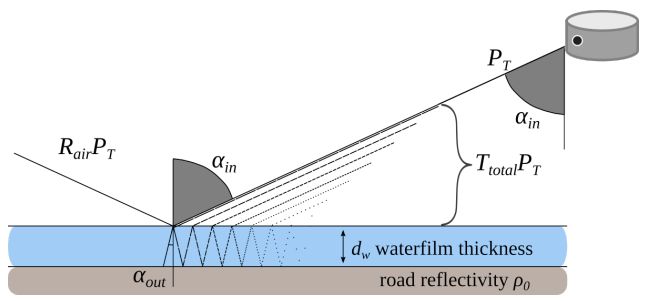

图6. 显示描述湿路面反射的几何光学模型的可视化。

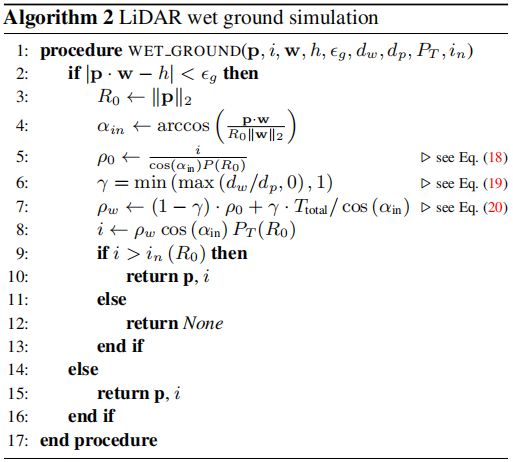

3.1 湿地面模型

激光雷达读数受周围表面湿度的影响。发射的光脉冲从潮湿的地面镜面反射,导致激光回波显著衰减,这取决于水的高度[5]。分析STF[1]的道路湿度统计数据(在补充材料中给出),很明显,潮湿的道路与不利天气(如降雪)一起出现,是道路表面丢点的主要原因(见图5)。

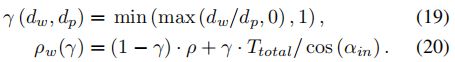

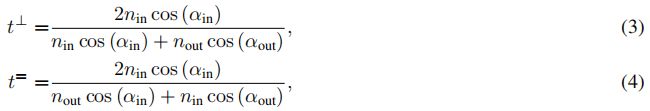

为了模拟道路湿度引起的衰减,我们应用几何光学模拟了单射线及其在薄层水上的折射,如图6所示。图5(底部)显示了一个定性示例。我们使用过渡点处的折射率(nin,nout)和角度(αin,αout)。角度αout可以根据Snell定律计算:

![]()

脉冲幅度的变化通过菲涅耳方程进行建模,菲涅耳方程分别由相对于地面的垂直和平行传输t⊥,t=和反射r⊥,r=描述(详情见补充材料)。从振幅到发射功率,我们可以推导出功率反射 R k p R_k^p Rkp和发射 T k p T_k^p Tkp:

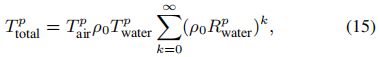

其中p∈(⊥,=)表示极化。如图6所示,我们总结了穿过回传感器的所有单独光线,得出几何级数

这可以简化为 ( ρ 0 R w a t e r ) < 1 (ρ_0R_{water}) < 1 (ρ0Rwater)<1 至

![]()

由于实际极化是专有的,我们假设制造商根据距离优化极化,以获得最佳性能,这意味着

![]()

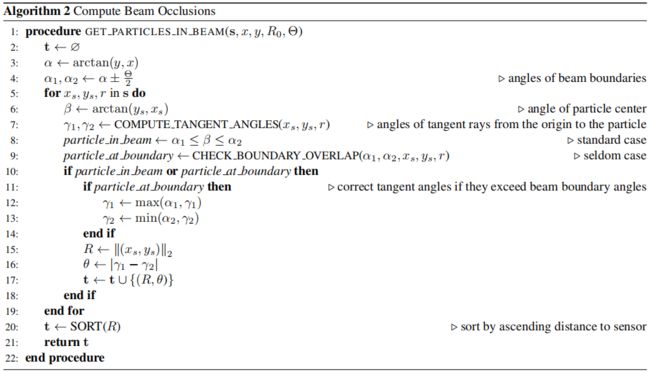

基于这个公式,我们设计了算法2。预处理步骤包括使用RANSAC[12]估计地平面法线w和截距h,如补充材料中所述。这些参数允许识别属于地面的所有点以及光束入射角αin。然后,可以根据测量的“干”强度重建修改后的强度,考虑到光束发散Θ已经通过工厂侧校准进行了校正,从而导致 i ∝ ρ 0 P T ( R ) ρ 0 c o s ( α i n ) i∝ρ_0P_T(R)ρ_0\ cos(α_{in}) i∝ρ0PT(R)ρ0 cos(αin)。用入射角 i ( R ) / c o s ( α i n ) i(R)/cos(α_{in}) i(R)/cos(αin)归一化i返回测量强度i和范围R之间的线性对应关系,从而我们可以根据已知给定回波线性近似功率 P T ( R ) P_T(R) PT(R)和噪声基底 i n ( R ) i_n(R) in(R)。然后我们可以获得每个点p的反射率ρ0:

![]()

这些校正后的反射率通过加权干反射和湿反射来增加,假设深度为dp的道路螺纹轮廓充满深度为dw的水

最后,根据修改后的反射率ρw更新测量的强度i,只有当强度i大于噪声本底in时,才保留得到的点p。

4. 实验

数据集。我们的实验是在STF数据集上进行的[1]。它提供了12997个带有精确3D边界框的注释样本,用于在各种天气条件下(包括轻雾、浓雾和雪)对汽车、行人和骑车人进行目标检测。在不否认行人和骑车人的重要性的情况下,在主要论文中,我们将重点放在最主要的类别上,即汽车。在补充材料中,我们提供了额外的结果。总共,在晴朗条件下可以使用3469帧进行训练,在下雪条件下提供3916帧。我们根据降雪强度将雪测试集中的3916个样本分为两个不同的子集,称为小雪和大雪,分别有2512个和1404个样本。受[29]的启发,我们通过利用DROR算法来执行此拆分[6]。小雪划分包含DROR[6]将从自我车辆前方的10×2×2m框中过滤10-79个点的帧,而大雪划分包含该框中至少80个点(补充材料中有更多细节)。

评估设置。对于评估,我们使用KITTI评估框架[13]和[58]中定义的3D目标检测度量。具体而言,[58]通过报告与目标距离相关的结果,引入了KITTI度量的扩展。由于第3节中详细描述的天气影响取决于距离,我们选择跟随其扩展,并按照[20]中的间隔报告结果。此外,我们遵循[45]并报告了40个召回位置的平均精度(AP),以提供公平的比较。除此之外,我们使用[13]中定义的典型重叠阈值。为了减轻潜在的统计波动,我们报告了每个实验在三次独立训练中的平均表现。

基线方法。总之,我们研究了我们的降雪模拟方案对七种众所周知的3D目标检测方法的有效性[9,25,39,41,42,57,59]。我们将我们的方法与清晰的天气基线和两种相互竞争的不利天气模拟方法进行了比较,一种用于雾[16],另一种用于降雪[22]。此外,我们还比较了使用DROR[6]对点云进行去噪。为了训练检测模型,我们使用OpenPCDet[47]并遵循每个方法的默认训练配置。所有方法都是从头开始训练的。

数据增强。我们选择将我们的模拟应用于每10个训练样本,其中降雪率从[0,0.5,…,2.5]mm/h采样,并设置传感器常数τH=10 ns,Rmax=120 m,Θ=0.003 rad,ρs=0.9和 ρ 0 = 1 × 1 0 − 6 π ρ_0=\frac{1×10^{−6}}{π} ρ0=π1×10−6。[22]使用了完全相同的设置。对于湿地面模拟,我们使用指数分布,并从0.1-1.2 mm的区间采样dw,同时将dp固定为1.2 mm,并将εg设置为0.5 m。

4.1 定量结果

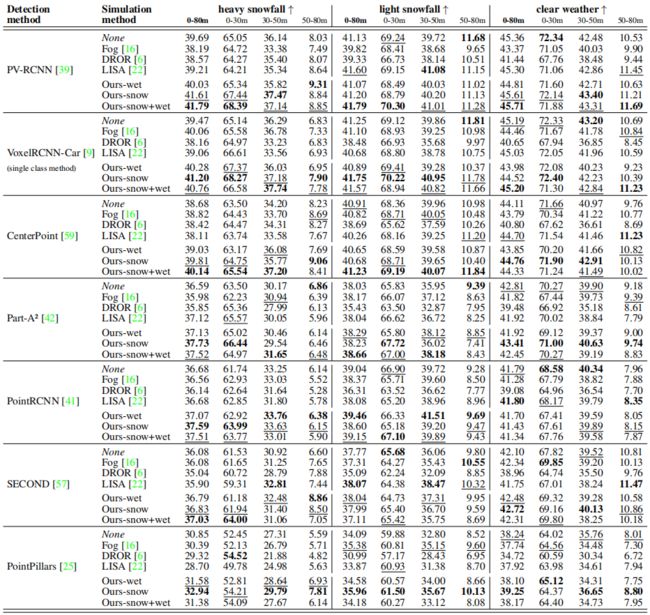

我们在表1中给出了定量结果。阅读表1时,读者应首先关注显示0-80m整个评估范围内AP的列,与基线方法以及所有竞争模拟[16,22]和去噪[6]方法相比,所有方法都有显著的优势。对于性能最好的检测方法,即PV-RCNN[39],这种对强降雪的改善尤其明显,我们的完整模拟在AP中以显著的2.1%击败了晴朗的天气基线。

对于PV-RCNN[39]、CenterPoint[59]和Part-A²[42],我们的完整模拟也在所有方法中提供了最佳的性能,表明我们的模拟的优势扩展到所有降雪强度。此外,在晴朗天气测试中,我们的降雪模拟(无湿地面建模)在七种检测方法中的六种检测方法的所有竞争方法中表现最好,在晴朗的天气基线上持续改进。这一发现表明,使用我们的降雪模拟进行训练可以提高在严重降雪条件下的检测性能,同时不会牺牲但也会提高在晴朗天气下的性能。

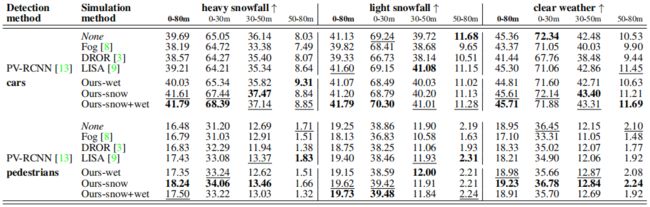

表1. STF上降雪中3D目标检测模拟方法的比较[1]。我们报告了三个STF划分的中等汽车的3D平均精度(AP):1404个样本的强降雪测试划分,2512个样本的轻降雪测试划分和1816个样本的晴朗天气测试划分。“Ours-wet”:我们的湿地面模拟,“Ours-snow”:降雪模拟,“Ours-snow+wet”:降雪和湿地面模拟的级联应用。

使用针对不同不利条件设计的模拟方法,如[16]中的雾模拟,由于各自的物理模型不同,无法很好地转换为降雪;对于大多数检测方法,[16]的性能略低于两种降雪划分的晴朗天气基线。DROR[6]作为去除杂波点的增强步骤的应用取得了最低的结果,因为它还去除了几个不属于降雪杂波的有效点。

图7. PV-RCNN[39]对含有强降雪的STF[1]样本的定性比较。最左边的一列显示了相应的RGB图像。其余的专栏显示了LiDAR点云和真值框,并使用清晰的天气基线(“无增强”)、DROR[6]、LISA[22]和我们成熟的模拟(“our snow+wet augmentation”)进行了预测。

4.2 定性结果

图7给出了显示所提出的数据增强方案的定性结果。这里,PV-RCNN[39]与无增强的晴朗天气基线DROR[6]和LISA[22]进行了比较。在第一行中,我们看到只有在训练期间应用我们提出的数据增强时,才能检测到降雪杂波中的行人。在第二行中,所有竞争方法都会出现额外的误报。最下面的一行显示了一个艰难的高速公路场景,雪尘飞扬。我们的数据增强方法很好地概括了这个示例,是检测领先车辆的唯一方法。还需要注意的是,在这样一种情况下,雪尘卷起,DROR[6]无法完全消除混乱。

5. 结论

在这项工作中,我们介绍了一种新的方法,用于从清晰的激光雷达捕获的模拟降雪和湿表面的物理精确方式中真实地合成冬季场景。此外,我们已经证明了所提出的算法的有效性,使用七种不同的3D目标检测方法测试了增强效果,并在大雪中实现了高达2.1%的AP一致改进。作为未来的工作,我们设想探索基于LiDAR的3D目标检测的时间线索。

Acknowledgements. This work is funded by Toyota Motor Europe via the research project TRACE-Z¨urich. The work also received funding by the AI-SEE project with national funding from the Austrian Research Promotion Agency (FFG), Business Finland, Federal Ministry of Education and Research (BMBF) and National Research Council of Canada Industrial Research Assistance Program (NRCIRAP). We also thank the Federal Ministry for Economic Affairs and Energy for support within “VVM-Verification and Validation Methods for Automated Vehicles Level 4 and 5”, a PEGASUS family project. Felix Heide was supported by an NSF CAREER Award (2047359), a Sony Young Faculty Award, and a Project X Innovation Award. We thank Emmanouil Sakaridis for verifying our derivation of occlusion angles in our snowfall simulation.

References

[1] Mario Bijelic, Tobias Gruber, Fahim Mannan, Florian Kraus, Werner Ritter, Klaus Dietmayer, and Felix Heide. Seeing through fog without seeing fog: Deep multimodal sensor fusion in unseen adverse weather. In IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2020. 1, 2, 5, 6, 7, 8

[2] Mario Bijelic, Tobias Gruber, and Werner Ritter. A benchmark for LiDAR sensors in fog: Is detection breaking down? In IEEE Intelligent Vehicles Symposium (IV), 2018. 1, 2

[3] Holger Caesar, Varun Bankiti, Alex Lang, Sourabh Vora, Venice Erin Liong, Qiang Xu, Anush Krishnan, Yu Pan, Giancarlo Baldan, and Oscar Beijbom. nuScenes: A multimodal dataset for autonomous driving. In IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2020. 2

[4] Alexander Carballo, Jacob Lambert, Abraham Monrroy Cano, David Robert Wong, Patiphon Narksri, Yuki Kitsukawa, Eijiro Takeuchi, Shinpei Kato, and Kazuya Takeda. LIBRE: The multiple 3D LiDAR dataset. In IEEE Intelligent Vehicles Symposium (IV), 2020. 1, 2

[5] Johan Casselgren, Mikael Sj¨odahl, and James LeBlanc. Angular spectral response from covered asphalt. Applied Optics, 46(20):4277–4288, 2007. 2, 5

[6] Nicholas Charron, Stephen Phillips, and Steven Waslander. De-noising of LiDAR point clouds corrupted by snowfall. In Conference on Computer and Robot Vision (CRV), 2018. 2, 6, 7, 8

[7] Xiaozhi Chen, Huimin Ma, Ji Wan, Bo Li, and Tian Xia. Multi-view 3D object detection network for autonomous driving. In IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2017. 2

[8] European Commission. Road safety in the European Union. https://doi.org/10.2832/169706, 2018. Accessed: 15 November 2021. 1

[9] Jiajun Deng, Shaoshuai Shi, Peiwei Li, Wengang Zhou, Yanyong Zhang, and Houqiang Li. Voxel R-CNN: Towards high performance voxel-based 3D object detection. In AAAI Conference on Artificial Intelligence, 2021. 2, 6, 7

[10] Ayush Dewan, Tim Caselitz, Gian Diego Tipaldi, and Wolfram Burgard. Motion-based detection and tracking in 3D LiDAR scans. In IEEE International Conference on Robotics and Automation (ICRA), 2016. 1

[11] Qiong Ding, Wu Chen, Bruce King, Yanxiong Liu, and Guoxiang Liu. Combination of overlap-driven adjustment and phong model for LiDAR intensity correction. Photogrammetry and Remote Sensing, 75:40–47, 2013. 3

[12] Martin Fischler and Robert Bolles. Random sample consensus: a paradigm for model fitting with applications to image analysis and automated cartography. Communications of the ACM, 24:381–395, 1981. 6

[13] Andreas Geiger, Philip Lenz, and Raquel Urtasun. Are we ready for autonomous driving? the KITTI vision benchmark

suite. In IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2012. 2, 6

[14] Christopher Goodin, Daniel Carruth, Matthew Doude, and Christopher Hudson. Predicting the influence of rain on LiDAR in ADAS. Electronics, 8, 2019. 1, 2

[15] Kevin Gunn and John Marshall. The distribution with size of aggregate snowflakes. Atmospheric Sciences, 15(5):452 – 461, 1958. 2, 4, 5

[16] Martin Hahner, Christos Sakaridis, Dengxin Dai, and Luc Van Gool. Fog simulation on real LiDAR point clouds for 3D object detection in adverse weather. In IEEE International Conference on Computer Vision (ICCV), 2021. 1, 2, 6, 7, 8

[17] Robin Heinzler, Florian Piewak, Philipp Schindler, and Wilhelm Stork. CNN-based LiDAR point cloud de-noising in adverse weather. IEEE Robotics and Automation Letters, 2020. 2

[18] Robin Heinzler, Philipp Schindler, J¨urgen Seekircher, Werner Ritter, and Wilhelm Stork. Weather influence and classification with automotive LiDAR sensors. In IEEE Intelligent Vehicles Symposium (IV), 2019. 1, 2

[19] Maria Jokela, Matti Kutila, and Pasi Pyyk¨onen. Testing and validation of automotive point-cloud sensors in adverse weather conditions. Applied Sciences, 9, 2019. 1, 2

[20] Frank Julca-Aguilar, Jason Taylor, Mario Bijelic, Fahim Mannan, Ethan Tseng, and Felix Heide. Gated3D: Monocular 3D object detection from temporal illumination cues. In IEEE International Conference on Computer Vision (ICCV), 2021. 2, 6

[21] Alireza Kashani, Michael Olsen, Christopher Parrish, and Nicholas Wilson. A review of LiDAR radiometric processing: From ad hoc intensity correction to rigorous radiometric calibration. Sensors, 15(11), 2015. 3

[22] Velat Kilic, Deepti Hegde, Vishwanath Sindagi, A. Brinton Cooper, Mark Foster, and Vishal Patel. LiDAR light scattering augmentation (LISA): physics-based simulation of adverse weather conditions for 3D object detection. arXiv preprint 2107.07004, 2021. 2, 4, 5, 6, 7, 8

[23] Jason Ku, Melissa Mozifian, Jungwook Lee, Ali Harakeh, and Steven Waslander. Joint 3D proposal generation and object detection from view aggregation. In IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS), 2018. 2

[24] Matti Kutila, Pasi Pyyk¨onen, Maria Jokela, Tobias Gruber, Mario Bijelic, and Werner Ritter. Benchmarking automotive LiDAR performance in arctic conditions. In IEEE International Conference on Intelligent Transportation Systems (ITSC), 2020. 1, 2

[25] Alex Lang, Sourabh Vora, Holger Caesar, Lubing Zhou, Jiong Yang, and Oscar Beijbom. PointPillars: Fast encoders for object detection from point clouds. In IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2019. 1, 2, 3, 6, 7

[26] Wei Liu, Dragomir Anguelov, Dumitru Erhan, Christian Szegedy, Scott Reed, Cheng-Yang Fu, and Alexander C. Berg. SSD: Single shot multibox detector. In European Conference on Computer Vision (ECCV), 2016. 3

[27] Weixin Lu, Yao Zhou, Guowei Wan, Shenhua Hou, and Shiyu Song. L3-Net: Towards learning based LiDAR localization for autonomous driving. In IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2019. 1

[28] Sebastien Michaud, Jean-Franc¸ois Lalonde, and Philippe Gigu`ere. Towards characterizing the behavior of LiDARs in snowy conditions. In Workshop on Planning, Perception and Navigation for Intelligent Vehicles, IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS), 2015. 1, 2

[29] Matthew Pitropov, Danson Evan Garcia, Jason Rebello, Michael Smart, Carlos Wang, Krzysztof Czarnecki, and Steven Waslander. Canadian adverse driving conditions dataset. The International Journal of Robotics Research, 40:681 – 690, 2021. 2, 6

[30] Charles Qi, Wei Liu, Chenxia Wu, Hao Su, and Leonidas Guibas. Frustum PointNets for 3D object detection from RGB-D data. In IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2018. 2

[31] Charles Qi, Hao Su, Kaichun Mo, and Leonidas Guibas. PointNet: Deep learning on point sets for 3D classification and segmentation. In IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2017. 2

[32] Roy Rasmussen, Jothiram Vivekanandan, Jeffrey Cole, Barry Myers, and Charles Masters. The estimation of snowfall rate using visibility. Applied Meteorology, 38(10):1542 – 1563, 1999. 2

[33] Ralph Rasshofer, Martin Spies, and Hans Spies. Influences of weather phenomena on automotive laser radar systems. Advances in Radio Science, 9, 2011. 2, 3

[34] Shaoqing Ren, Kaiming He, Ross Girshick, and Jian Sun. Faster R-CNN: Towards real-time object detection with region proposal networks. In Neural Information Processing Systems (NeurIPS), 2015. 3

[35] Christos Sakaridis, Dengxin Dai, Simon Hecker, and Luc Van Gool. Model adaptation with synthetic and real data for semantic dense foggy scene understanding. In European Conference on Computer Vision (ECCV), 2018. 2

[36] Christos Sakaridis, Dengxin Dai, and Luc Van Gool. Semantic foggy scene understanding with synthetic data. International Journal of Computer Vision, 126(9):973–992, 2018. 1, 2

[37] Christos Sakaridis, Dengxin Dai, and Luc Van Gool. ACDC: The Adverse Conditions Dataset with Correspondences for semantic driving scene understanding. In IEEE International Conference on Computer Vision (ICCV), 2021. 2

[38] R. S. Sekhon and R. C. Srivastava. Snow size spectra and radar reflectivity. Atmospheric Sciences, 27(2):299 – 307, 1970. 2

[39] Shaoshuai Shi, Chaoxu Guo, Li Jiang, Zhe Wang, Jianping Shi, Xiaogang Wang, and Hongsheng Li. PV-RCNN: Point-voxel feature set abstraction for 3D object detection. In IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2020. 1, 2, 3, 6, 7, 8

[40] Shaoshuai Shi, Li Jiang, Jiajun Deng, Zhe Wang, Chaoxu Guo, Jianping Shi, Xiaogang Wang, and Hongsheng Li. PVRCNN++: point-voxel feature set abstraction with local vector representation for 3D object detection. arXiv preprint 2102.00463, 2021. 2, 3

[41] Shaoshuai Shi, Xiaogang Wang, and Hongsheng Li. PointRCNN: 3D object proposal generation and detection from point cloud. In IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2019. 2, 3, 6, 7

[42] Shaoshuai Shi, Zhe Wang, Jianping Shi, Xiaogang Wang, and Hongsheng Li. From points to parts: 3D object detection from point cloud with part-aware and part-aggregation network. IEEE Transactions on Pattern Analysis and Machine Intelligence (TPAMI), 2020. 2, 6, 7

[43] Zheng Shi, Ethan Tseng, Mario Bijelic, Werner Ritter, and Felix Heide. Zeroscatter: Domain transfer for long distance imaging and vision through scattering media. In IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2021. 2

[44] Jungil Shin, Hyunsuk Park, and Taejung Kim. Characteristics of laser backscattering intensity to detect frozen and wet surfaces on roads. Sensors, 2019:8973248, 2019. 2

[45] Andrea Simonelli, Samuel Rota Bulo, Lorenzo Porzi, Manuel Lopez-Antequera, and Peter Kontschieder. Disentangling monocular 3D object detection. In IEEE International Conference on Computer Vision (ICCV), 2019. 2, 6

[46] Pei Sun, Henrik Kretzschmar, Xerxes Dotiwalla, Aurelien Chouard, Vijaysai Patnaik, Paul Tsui, James Guo, Yin Zhou, Yuning Chai, Benjamin Caine, Vijay Vasudevan, Wei Han, Jiquan Ngiam, Hang Zhao, Aleksei Timofeev, Scott Ettinger, Maxim Krivokon, Amy Gao, Aditya Joshi, Yu Zhang,

Jonathon Shlens, Zhifeng Chen, and Dragomir Anguelov. Scalability in perception for autonomous driving: Waymo open dataset. In IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2020. 2

[47] OpenPCDet Development Team. OpenPCDet: An open-source toolbox for 3D object detection from point clouds. https://github.com/open-mmlab/OpenPCDet, 2020. Accessed: 15 November 2021. 6

[48] Maxime Tremblay, Shirsendu S. Halder, Raoul de Charette, and Jean-Franc¸ois Lalonde. Rain rendering for evaluating and improving robustness to bad weather. International Journal of Computer Vision (IJCV), 126, 2021. 1, 2

[49] U.S. Department of Transportation: Federal Highway Administration. How do weather events impact roads? https : / / ops . fhwa . dot . gov / weather / q1 _roadimpact.htm, 2019. Accessed: 15 November 2021. 1

[50] Velodyne. Hdl-64e user’s manual, 2007. 3, 5

[51] Sourabh Vora, Alex Lang, Bassam Helou, and Oscar Beijbom. PointPainting: Sequential fusion for 3D object detection. In IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2020. 2

[52] Andrew Wallace, Abderrahim Halimi, and Gerald Buller. Full waveform LiDAR for adverse weather conditions. IEEE Transactions on Vehicular Technology, 69, 2020. 1, 2

[53] Dingkang Wang, Connor Watkins, and Huikai Xie. MEMS mirrors for LiDAR: A review. Micromachines, 11(5), 2020. 1

[54] Yan Wang, Wei-Lun Chao, Divyansh Garg, Bharath Hariharan, Mark Campbell, and Kilian Weinberger. Pseudo-LiDAR from visual depth estimation: Bridging the gap in 3D object detection for autonomous driving. In IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2019. 2

[55] George Williams. Optimization of eyesafe avalanche photodiode LiDAR for automobile safety and autonomous navigation systems. Optical Engineering, 56(3):1 – 9, 2017. 3

[56] Jacek Wojtanowski, Marek Zygmunt, Mirosława Kaszczuk, Zygmunt Mierczyk, and Michał Muzal. Comparison of 905 nm and 1550 nm semiconductor laser rangefinders’ performance deterioration due to adverse environmental conditions. Opto-Electronics Review, 22, 2014. 2

[57] Yan Yan, Yuxing Mao, and Bo Li. SECOND: Sparsely embedded convolutional detection. Sensors, 18, 2018. 2, 3, 6, 7

[58] Bin Yang, Wenjie Luo, and Raquel Urtasun. Pixor: Realtime 3D object detection from point clouds. In IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2018. 6

[59] Tianwei Yin, Xingyi Zhou, and Philipp Krahenbuhl. Center-based 3D object detection and tracking. In IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2021. 1, 2, 3, 6, 7

[60] Yurong You, Yan Wang, Wei-Lun Chao, Divyansh Garg, Geoff Pleiss, Bharath Hariharan, Mark Campbell, and Kilian Q Weinberger. Pseudo-LiDAR++: Accurate depth for 3D object detection in autonomous driving. In International Conference on Learning Representations (ICLR), 2020. 2

[61] Ji Zhang and Sanjiv Singh. LOAM : LiDAR odometry and mapping in real-time. Robotics: Science and Systems Conference (RSS), 2014. 1

[62] Yin Zhou and Oncel Tuzel. VoxelNet: End-to-end learning for point cloud based 3D object detection. In IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2018. 2, 3

补充材料

1. 引言

在本补充文件中,我们旨在提供支持主要手稿中结果的额外信息。我们在第2节提供了关于降雪模拟的额外信息,在第3节提供了湿地模拟。在第4节中,我们对SeeingThroughFog(STF)[1]数据集提供了额外的见解。在第5节和第6节中,我们分别提供了额外的定量和定性结果。在第7节中,我们讨论了我们工作的已知局限性。

2. 其他降雪模拟细节

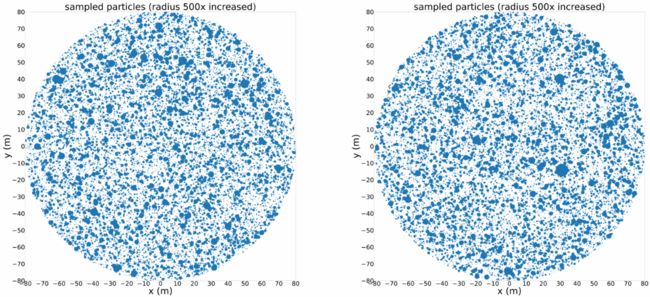

对于表1中的每一行,我们根据算法1在2D中采样nl=64个雪花分布模式。对于此采样,我们使用Rmax=80m,因为SeeingThroughFog(STF)数据集[1]提供的真实数据表明Velodyne HDL-S3D的有效范围仅为80m,而不是其手册[17]中所述的120m。两个示例雪花分布模式如图1所示。在训练过程中,我们从表1中给出的行中随机均匀采样,并从磁盘加载相应的预先计算的雪花分布模式。

雪的降水率rs以等效水的速率表示,取决于雨的降水率rr,通过

![]()

平均雪花直径D0以m为单位,雪花的平均终端速度vs以m/s为单位,雪的平均密度ρs以g/cm3为单位[12]。相反,降雨率rr可以从降雪率rs中得出

例如,我们使用这种连接将我们的模拟与LISA[9]进行比较,LISA[9]将降雨率rr作为输入,而不是直接将降雪率rs作为我们的降雪模拟(见主要手稿中的算法1)。

在本补充文档中,我们还介绍了如何在算法1中对雪花进行采样,并在算法2中计算光束遮挡。

3. 其他湿地模拟细节

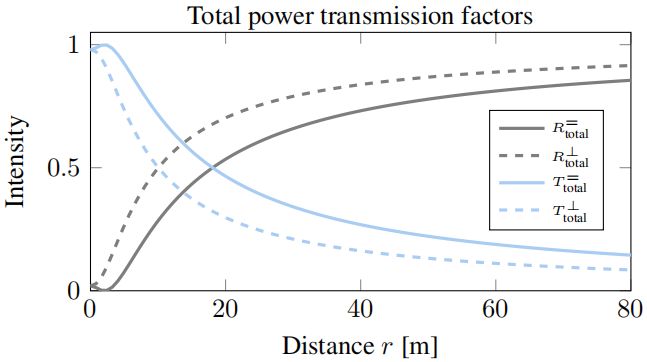

本节提供了湿地增强的更多实施细节和理论背景。正如主要手稿中所解释的,激光雷达测量受到路面湿水膜的影响,导致道路反射率降低。如果场景中存在水膜,则会导致光线越来越多地从测量激光雷达传感器镜面反射[2]。这些反射性质由菲涅耳方程建模,其描述如下:

表1. 用于我们的降雪模拟的参数。

图1. rs=1mm/h和vs=1.6m/s的两种雪花分布模式示例(表1中的第三行)。

菲涅耳方程明确地对发送的激光脉冲的振幅变化进行了建模,并取决于写为上标的偏振,其中,垂直偏振为⊥,平行偏振为=。为了对来自地面的总发射功率 T t o t a l T_{total} Ttotal进行建模,如主稿第3.1节中的等式(15)、(16)和(17)所示,必须如主稿中等式(13)至(14)所述导出传输功率 T k p T_k^p Tkp和反射功率 R k p R_k^p Rkp因子。ρ0=1和高度h=1.55m的传感器的总发射功率 T t o t a l p T^p_{total} Ttotalp和反射率 R t o t a l p R_{total}^p Rtotalp如图2所示。

为了运行湿地模拟(主要手稿中的算法2),需要根据地面上的清晰测量来估计地平面和入射角。因此,我们首先对地平面附近的点进行滤波。这些点p=[x,y,z]是集合的一部分:

![]()

然后,使用RANSAC算法[5]拟合线性平面,给出地平面的法线w和截距h。之后,我们估计属于地面的最终点通过主要手稿中的算法2进行了扩充:

![]()

其中εg是从地平面偏移的最大距离。

图2:ρ0=1的路面和高度h=1.55 m的传感器的总功率传输 T t o t a l p T^p_{total} Ttotalp和反射率 R t o t a l p R^p_{total} Rtotalp因子。p∈(⊥, =)分别表示垂直和平行偏振。

图3. 道路湿度由STF[1]中使用的专用道路摩擦传感器测量。

4. 其他数据集详细信息

在我们的工作过程中,我们使用了STF数据集[1]。在本节中,我们将提供数据集的其他详细信息。首先,在第4.1节中,我们展示了道路湿度高度的分布,这激发了我们的湿地模拟。其次,在第4.2节中,提供了关于产生小雪和大雪划分的额外细节。最后,在第4.3节中,我们提供了关于每个划分中可用的真值注释的统计数据。

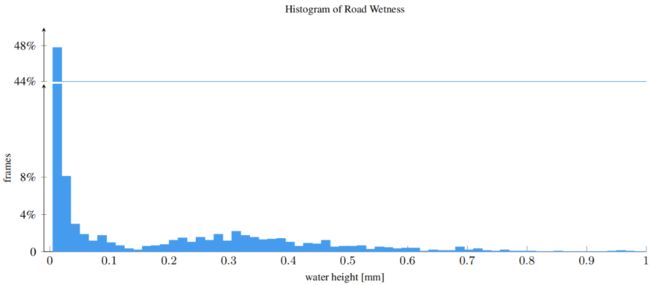

4.1 地面湿度分布

正如主要手稿第3.1节所指出的,我们认为STF[1]数据集中的大量激光雷达扫描受到潮湿路面的影响。为了分析这种情况的发生频率,我们可以查看专有道路摩擦传感器提供的道路湿度读数。该传感器报告地面上的水高度(见图3)。我们发现,对于STF[1]数据集中超过35%的可用帧,道路摩擦传感器报告的水高度至少为0.05毫米,这足以显著改变地面上激光雷达点的强度(参见主要手稿中的图5)。

4.2 降雪划分

通过STF数据集[1]的作者提供的4468帧的雪地测试集样本,我们发现其中许多帧在激光雷达扫描中实际上不包含或只包含很少的雪杂波。因此,我们正在寻找一种方法来清理雪地测试集,并从这个“雪地”测试集中过滤出清晰的帧。

图4. 该图显示了来自大雪测试集(第一列)和原始点云的场景的相机图像,包括我们提出的用于将雪测试集分类为两个子集(第二列)的框(蓝色)。第三列显示了作者提出的原始DROR[3]参数化,第四列显示了我们调整后的参数化。最好在屏幕上观看并放大。

对于这项任务,我们使用了DROR[3]滤波器,它在过滤雪景中的降雪杂波方面做得很好。然而,我们发现,对于用于记录STF[1]中的点云的主要激光雷达传感器Velodyne HDL-S3D来说,DROR[3]滤波器的拟议参数化过于激进。当我们将α设置为水平角分辨率(Velodyne HDL-S3D传感器[17]为0.35°)时,正如DROR[3]作者所提出的那样,与设置α=0.45时相比,滤波器去除的有效点明显更多(有效地软化了滤波器)。这种参数化通常会去除同样多的降雪杂波,但会在场景中保留更多的有效点(见图4)。

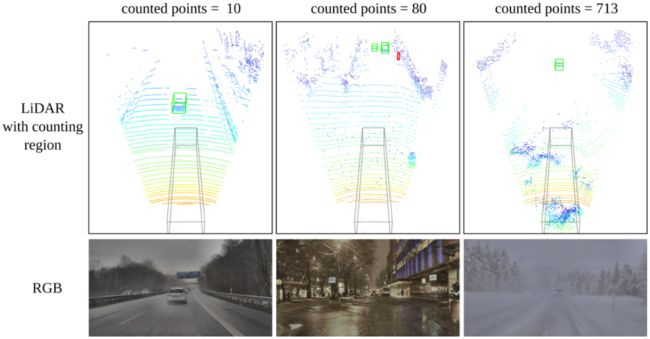

受加拿大不利驾驶条件(CADC)数据集[11]作者的启发,我们在ego车辆前方3米和激光雷达传感器位置下方1米处构建了一个10×2×2米的框(见图5顶行的灰色框)。在这个框中,我们计算DROR[3]过滤器删除的点数。如果DROR[3]没有从该框中删除任何点,我们将该样本视为“晴朗”,并将其从最初提供的“雪”测试集中排除。事实上,由于我们增强的参数化的DROR[3]滤波器仍然不完美,例如仍然从这个框中的目标中删除有效的前景点,我们决定不仅排除DROR[3]过滤器不删除点的帧,而且从“雪地”测试集中排除所有帧,其中DROR[3]过滤掉多达九个点。通过这种方式,我们可以确保不太清晰的样本能够进入经过校正的雪地测试集。最后,我们从最初的“雪地”测试集中排除了552个帧,剩下3916个帧,这些帧在我们提出的车辆前方的框中至少包含10个点,被DROR[3]滤波器分类为杂波。

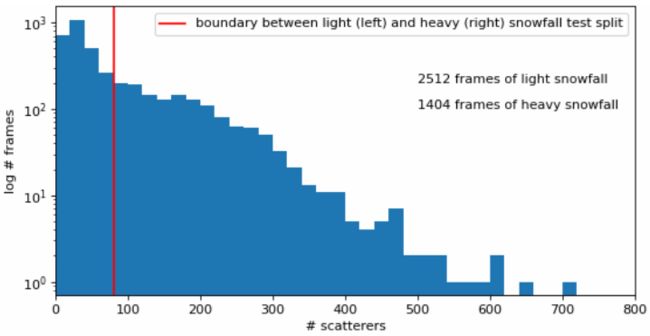

然后,由于我们已经使用了DROR[3]滤波器,并且认为DROR[3]分类为杂波的点的数量是场景中发生的降雪量的很好的代表,因此我们决定从这些剩余的3916个真实雪帧中构造两个子集。2512帧,其中DROR[3]将上述框内的10-79个点分类为杂波,构建小雪测试集,其余1404帧,其中DROR[3]将至少80个点(在最极端的场景中多达713个)分类为降雪杂波,构成大雪测试集。图5显示了一个例子,其中10、80和前面提到的最极端的场景,DROR[3]分别将713个点计算为我们框内的杂波。

请注意,我们首先尝试了CADC[11]中提出的框来计算DROR[3]分类为杂波的点的数量,但发现我们提出的框对场景中存在的实际降雪杂波给出了更好的估计。

4.2.1 降雪强度分布

小雪和大雪框架的降雪强度分布呈指数分布,如图6所示为对数尺度图。由于极端降雪情况很少见,这种数据集偏差解释了单个(降雪)测试集评估之间的差距大小。尽管如此,与表2中表现最好的方法PV-RCNN[13]相比,在0-30米的距离内,从晴朗的天气到大雪,“仅晴朗”的基线AP下降了7.29(72.34对65.05 AP),这是受降雪破坏最严重的地区。我们的模拟能够恢复45%的损失,将性能提高3.34 AP,同时在晴朗的天气下仅牺牲0.46 AP(72.34对71.88 AP)。在行人类上,我们的模拟甚至在没有任何牺牲的情况下恢复了50%以上。

图5. 具有用于创建小雪和大雪测试划分的阈值的示例场景。

图6. 每帧散射体的直方图(仓大小为20)。

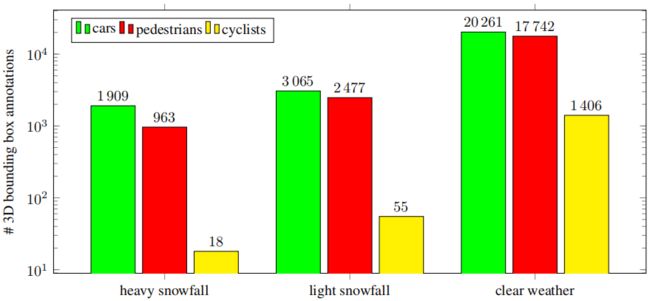

4.3 目标统计

在本节中,我们通过提供STF[1]数据集的主要类别的统计数据,为主要手稿中呈现的3D目标检测结果提供了更多上下文。图7显示了每个划分的可用三维边界框注释。我们可以看到,与汽车和行人的数量形成对比的是,在大雪和小雪中,没有足够的骑车人可以对这一类别得出任何有效的结论,不幸的是,它们在如此恶劣的条件下代表性太低(比晴朗条件下低两个数量级,也比同一降雪测试集中的汽车和行人级别低两个量级)。诚然,汽车和行人的数量也比晴朗天气下可用的注释低一个数量级,但我们相信,在大雪和小雪中可用的汽车和行人绝对数量是足够的,足以得出有意义的结论,尤其是对于汽车类而言。

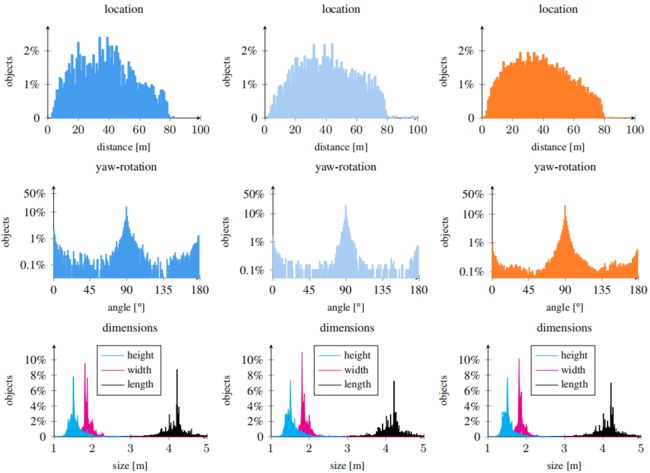

图8显示了大雪、小雪和晴朗测试集中汽车的注释统计(从左到右)。尽管所有三个划分的偏航旋转和尺寸分布看起来非常相同,但我们可以看到,在大雪中,与其他两个测试集相比,50-80m距离间隔内的可用注释相对稀疏。这可以通过在如此恶劣的条件下在如此距离处可用的较少的激光雷达点来解释。也就是说,每个3D边界框至少需要一个激光雷达点才能有效。因此,如果不存在属于目标的点,则也不存在3D边界框注释。我们还可以看到,晴朗测试集中的汽车往往更接近自我车辆/传感器,因此通常更容易检测和预测。

图7. 每个类和测试划分的可用3D边界框注释数。大雪测试部分包含1404帧,小雪测试部分包含2512帧,晴朗天气测试集包含1816帧。

5. 其他定量结果

在表2中,我们给出了最佳执行方法PV-RCNN[13]对行人类别的定量结果。为了完整起见,主要手稿中关于汽车类的结果已经准备好了。为了缓解潜在的统计波动,我们再次报告每个实验在三次独立训练中的平均表现。为了避免混淆,PV-RCNN[13]是一种多类别方法,所有三次运行都同时预测两个类别,即汽车和行人。因此,没有必要为每个类单独训练方法。我们可以看到,与汽车类类似,我们的降雪增强也优于所有竞争方法和在大雪和小雪测试集上的晴朗天气基线,同时在晴朗天气测试集上也获得了性能。然而,行人类的整体性能仍然明显低于汽车类的性能(例如,使用我们的降雪模拟进行训练时,41.61比18.24)。这表明易受伤害的道路使用者(VRU)仍然值得我们研究界更多的关注。

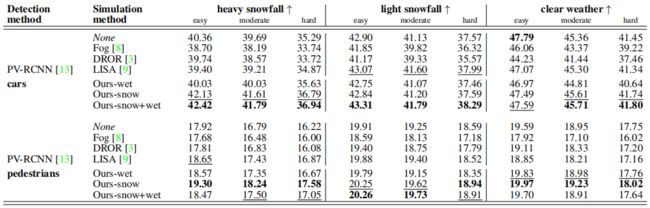

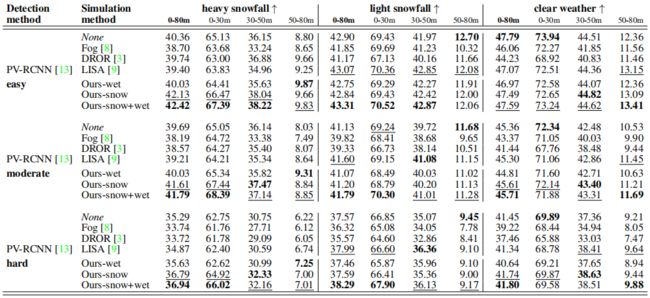

在表3中,我们报告了使用原始KITTI[6]评估框架的评估结果(包括[16]中提出的使用40个召回位置而不是11个召回位置的增强)。我们可以看到,除了在晴朗的天气测试集上的简单的汽车类外,无论是我们的降雪模拟还是我们的降雪和湿地联合模拟,在所有KITTI难度级别上都能获得最先进的结果,这支持了我们在主要手稿中对不同距离间隔的中型汽车所报告的发现。表4显示了对剩余难度等级的基于距离的简单和困难评估。为了完整起见,本文还包括了主要手稿中报告的中等难度。我们可以观察到,我们提出的模拟方法在大雪中的所有难度级别和所有单个距离间隔上都表现出优异的性能。

总的来说,我们可以看到,虽然容易难度和中等难度之间的性能差异相对较小,但中等难度和困难难度之间的表现差异较大。注意,根据[6]中等难度等级的定义,困难难度等级也包括所有中等和容易样本,中等难度等级也包含所有容易样本。这意味着,从中等到困难添加的样本似乎更难正确预测,否则中等和困难结果之间就不会有如此明显的差距。

最后,表5显示了使用DROR[3]滤波器的不同参数进行的消融研究。我们可以看到,对于主要手稿中使用的所有3D目标检测器,我们调整后的DROR[3]参数化(α=0.45)几乎总是优于[3]作者建议的参数化(a=0.35)。

6. 其他定性结果

在图9、10和11中,与出于相同目的使用竞争模拟和预处理方法相比,我们展示了用于训练PV-RCNN[13]目标检测器的全模拟方法的额外定性检测结果。在图9中,我们观察到,我们的方法能够始终如一地检测到因降雪而杂乱的远处汽车,这表明了高召回率,而不会引入误报。此外,我们的方法还检测到第二和第三场景中的显著行人,而竞争方法和晴朗的天气基线通常不能检测到这些行人。

在图10中,只有我们的方法在第一个场景中检测到ego车辆前面的汽车,这受到严重喷雾的影响。LISA[9]在第三个场景中错过了行人,而DROR[3]在第四个场景中输出假阳性检测,并预测该场景中汽车的方向不正确。相反,我们的方法正确地处理了这两个场景。

在图11中,晴朗的天气基线和LISA[9]在第一个场景中产生误报,这主要是由强降雪造成的混乱引起的,而我们的方法在同时正确预测场景中的两辆车的同时消除了所有误报。我们的方法也正确地处理了第二个场景,因为它准确地检测到了道路左侧的行人,没有任何误报。

图8. 大雪测试分为1404个样本(左栏),小雪测试分为2512个样本(中栏),晴朗天气测试分为1816个样本(右栏)。最上面一行显示到目标的距离,中间一行显示鸟瞰图(BEV)偏航旋转,最下面一行显示目标尺寸。

表2. 中等汽车和中等行人在三个STF划分上的3D平均精度(AP):大雪测试划分为1404个样本,小雪测试划分为2512个样本,晴朗天气测试划分为1816个样本。“Ours-wet”:我们的湿地模拟,“Ours-snow”:降雪模拟,“Ours-snow+wet”:降雪和湿地模拟的级联应用。

表3. 在三个STF划分上,简单、中等和困难的汽车和行人在整个0-80m范围内的3D平均精度(AP):大雪测试划分为1404个样本,小雪测试划分为2512个样本,晴朗天气测试划分为1816个样本。“Ours-wet”:我们的湿地模拟,“Ours-snow”:降雪模拟,“Ours-snow+wet”:降雪和湿地模拟的级联应用。

表4. STF上降雪中3D目标检测模拟方法的比较[1]。我们报告了三种STF划分的简单、中等、困难汽车的3D平均精度(AP):大雪测试划分为1404个样本,小雪测试划分为2512个样本,晴朗天气测试划分为1816个样本。“Ours-wet”:我们的湿地模拟,“Ours-snow”:降雪模拟,“Ours-snow+wet”:降雪和湿地模拟的级联应用。

表5. 关于DROR[3]滤波器参数化的消融研究。我们报告了三种STF划分的中等汽车的3D平均精度(AP):大雪测试划分为1404个样本,小雪测试划分为2512个样本,晴朗天气测试划分为1816个样本。“Ours-wet”:我们的湿地模拟,“Ours-snow”:降雪模拟,“Ours-snow+wet”:降雪和湿地模拟的级联应用。

第三个例子显示了一种情况,其中我们的方法是唯一正确预测场景中骑车人的方法。如第4.3节所述,与汽车和行人相比,骑车人在两个雪地测试中都相当罕见。在这个例子中,我们还可以看到一个故障案例,其中道路左侧停放的第二辆车没有被任何方法检测到,包括我们的方法。最后,对于第四个场景,尽管点云中有强烈的噪声,但只有DROR[3]和我们的方法检测到道路右侧的行人。

在我们的模拟管道上,我们找不到任何特定的3D目标检测方法的“失败模式”。可以说,在我们的模拟管道上训练的3D目标检测方法与在竞争方法上训练的方法犯的错误“相同”,只是更少,尤其是在0-30m范围内,这是受降雪噪声破坏最严重的区域。图11的第三行给出了一个例子,表明在我们的模拟管道上训练的3D目标检测方法会犯“相同”的错误。

7. 限制性讨论

在本节中,我们将讨论我们工作的局限性。首先,我们预计我们的工作不会产生任何潜在的负面社会影响。然而,我们希望借此机会解决我们所意识到的局限性。

我们当前降雪模拟的一个小限制是它的运行时间。根据每个场景的点数,我们的模拟每个点云可能需要几秒钟的时间。这一限制可以通过增强内部数据结构或从Python中的实现完全切换到C中的实现来克服。为了使我们的结果能够再现,并使社区能够做出调整并提出建议,我们计划开源我们的代码。

另一个限制可能是我们的模拟参数(降雪率rs和水位dw)的实例化选择。它们在很大程度上取决于测试集中的主要天气,而这些天气很难从原始点云本身推断出来。这些超参数的不同实例化可能会获得更好的结果。我们根据参数的常用范围选择参数,并没有在基础数据集上明确调整它们。

我们模拟管道的主要目标是将在晴朗天气下捕获的激光雷达点云转换为点云,就好像它们是在真实降雪下捕获的一样。我们的定性和定量结果表明,我们确实越来越接近真实降雪中捕捉到的激光雷达点云的实际外观。然而,我们(还)无法完全模仿/重新生成这些测量结果。正如我们的一位评审员正确指出的那样,我们没有为此解决的一个限制因素是“目标的湿度”。模拟潮湿目标是我们模型的一个有趣扩展,但需要额外的语义理解,例如行人是否带伞,但作为未来工作的另一个可能方向,这绝对是一个很好的建议。

References

[1] Mario Bijelic, Tobias Gruber, Fahim Mannan, Florian Kraus, Werner Ritter, Klaus Dietmayer, and Felix Heide. Seeing through fog without seeing fog: Deep multimodal sensor fusion in unseen adverse weather. In IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2020. 1, 4, 5, 6, 9, 12, 13, 14

[2] Johan Casselgren, Mikael Sj¨odahl, and James LeBlanc. Angular spectral response from covered asphalt. Applied Optics, 46(20):4277–4288, 2007. 1

[3] Nicholas Charron, Stephen Phillips, and Steven Waslander. De-noising of lidar point clouds corrupted by snowfall. In Conference on Computer and Robot Vision (CRV), 2018. 5, 7, 8, 9, 10, 12, 13, 14

[4] Jiajun Deng, Shaoshuai Shi, Peiwei Li, Wengang Zhou, Yanyong Zhang, and Houqiang Li. Voxel R-CNN: Towards high performance voxel-based 3d object detection. In AAAI Conference on Artificial Intelligence, 2021. 10

[5] Martin Fischler and Robert Bolles. Random sample consensus: a paradigm for model fitting with applications to image analysis and automated cartography. Communications of the ACM, 24:381–395, 1981. 2

[6] Andreas Geiger, Philip Lenz, and Raquel Urtasun. Are we ready for autonomous driving? the KITTI vision benchmark suite. In IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2012. 7

[7] Kevin Gunn and John Marshall. The distribution with size of aggregate snowflakes. Journal of Atmospheric Sciences, 15(5):452 – 461, 1958. 3

[8] Martin Hahner, Christos Sakaridis, Dengxin Dai, and Luc Van Gool. Fog simulation on real lidar point clouds for 3d object detection in adverse weather. In IEEE International Conference on Computer Vision (ICCV), 2021. 8, 9

[9] Velat Kilic, Deepti Hegde, Vishwanath Sindagi, Brinton Cooper, Mark Foster, and Vishal Patel. Lidar light scattering augmentation (LISA): physics-based simulation of adverse weather conditions for 3d object detection. arXiv preprint 2107.07004, 2021. 1, 8, 9, 12, 13, 14

[10] Alex Lang, Sourabh Vora, Holger Caesar, Lubing Zhou, Jiong Yang, and Oscar Beijbom. PointPillars: Fast encoders for object detection from point clouds. In IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2019. 10

[11] Matthew Pitropov, Danson Evan Garcia, Jason Rebello, Michael Smart, Carlos Wang, Krzysztof Czarnecki, and Steven Waslander. Canadian adverse driving conditions dataset. The International Journal of Robotics Research, 40:681 – 690, 2021. 5

[12] Roy Rasmussen, Jothiram Vivekanandan, Jeffrey Cole, Barry Myers, and Charles Masters. The estimation of snowfall rate using visibility. Journal of Applied Meteorology, 38(10):1542 – 1563, 1999. 1

[13] Shaoshuai Shi, Chaoxu Guo, Li Jiang, Zhe Wang, Jianping Shi, Xiaogang Wang, and Hongsheng Li. PV-RCNN: Point-voxel feature set abstraction for 3d object detection. In IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2020. 5, 7, 8, 9, 10, 12, 13, 14

[14] Shaoshuai Shi, Xiaogang Wang, and Hongsheng Li. PointRCNN: 3d object proposal generation and detection from point cloud. In IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2019. 10

[15] Shaoshuai Shi, Zhe Wang, Jianping Shi, Xiaogang Wang, and Hongsheng Li. From points to parts: 3d object detection from point cloud with part-aware and part-aggregation network. IEEE Transactions on Pattern Analysis and Machine Intelligence (TPAMI), 2020. 10

[16] Andrea Simonelli, Samuel Rota Bulo, Lorenzo Porzi, Manuel Lopez-Antequera, and Peter Kontschieder. Disentangling monocular 3d object detection. In IEEE International Conference on Computer Vision (ICCV), 2019. 7

[17] Velodyne. Hdl-64e user’s manual, 2007. 1, 5

[18] Yan Yan, Yuxing Mao, and Bo Li. SECOND: Sparsely embedded convolutional detection. Sensors, 18, 2018. 10

[19] Tianwei Yin, Xingyi Zhou, and Philipp Krahenbuhl. Center-based 3d object detection and tracking. In IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2021. 10

图9. PV-RCNN[13]对含有大雪的STF[1]样本的定性比较。最左边的一列显示了相应的RGB图像。其余栏目显示了带有真值框的激光雷达点云,并使用清晰的天气基线(“无增强”)、DROR[3]、LISA[9]和我们成熟的模拟(“我们的雪+湿增强”)进行预测。最好在屏幕上观看并放大。

图10. PV-RCNN[13]对含有大雪的STF[1]样本的定性比较。最左边的一列显示了相应的RGB图像。其余栏目显示了带有真值框的激光雷达点云,并使用清晰的天气基线(“无增强”)、DROR[3]、LISA[9]和我们成熟的模拟(“我们的雪+湿增强”)进行预测。最好在屏幕上观看并放大。

图11. PV-RCNN[13]对含有大雪的STF[1]样本的定性比较。最左边的一列显示了相应的RGB图像。其余栏目显示了带有真值框的激光雷达点云,并使用清晰的天气基线(“无增强”)、DROR[3]、LISA[9]和我们成熟的模拟(“我们的雪+湿增强”)进行预测。最好在屏幕上观看并放大。