NeurIPS 2021论文放榜!

点击上方“机器学习与生成对抗网络”,关注星标

获取有趣、好玩的前沿干货!

转载于:新智元

NeurIPS 2021接收的论文放出了!

《argmax centroid》「荣获」最短标题的称号。

作者是来自北京大学的Chengyue Gong,得克萨斯大学奥斯汀分校的Mao Ye和达特茅斯学院的Qiang Liu。

《Habitat 2.0: Training Home Assistants to Rearrange their Habitat》的作者最多,有21个。

https://arxiv.org/pdf/2106.14405.pdf

NeurIPS 2021 接收数据分析

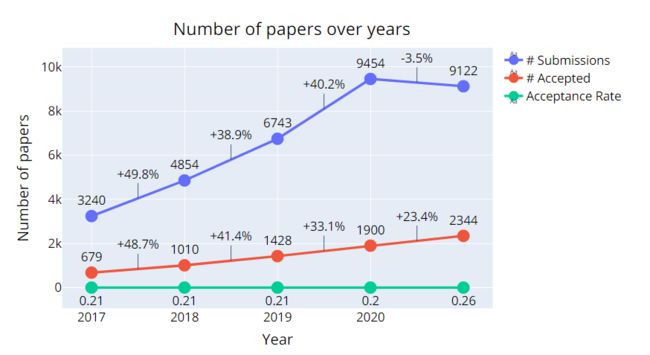

今年提交的论文总共有9122篇,其中有2344篇被接收,比例为26%。

相比于2020年,虽然投稿减少了332篇,但是被接收的反而增加了444篇。

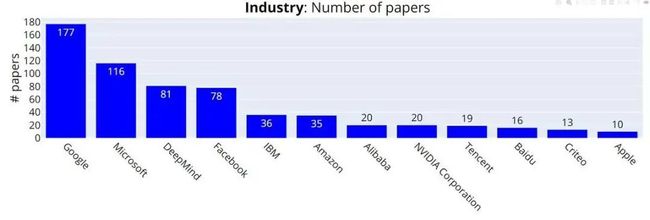

谷歌总共提交了177篇论文,成为投稿最多的公司。

微软、DeepMind、Facebook紧随其后,分别为116篇、81篇和78篇。

国内的BAT则再次聚首,以16篇、20篇和19篇分别排在第10、第7和第9位。

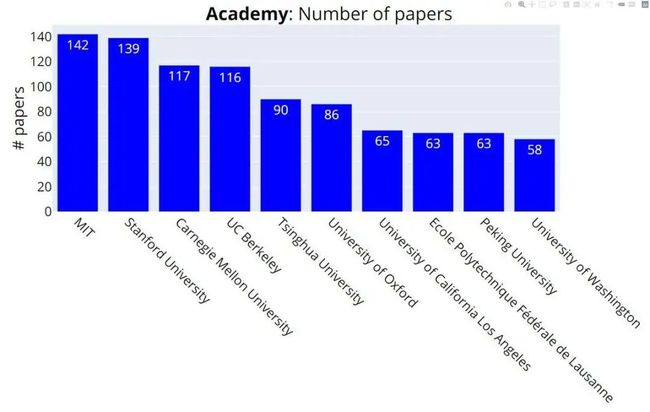

MIT总共提交了142篇论文,成为投稿最多的高校,以3篇论文的优势超过投稿139篇的斯坦福。

CMU以117篇论文排名第三,比第四名伯克利多了1篇。

清华位列第五,北大位列第九。

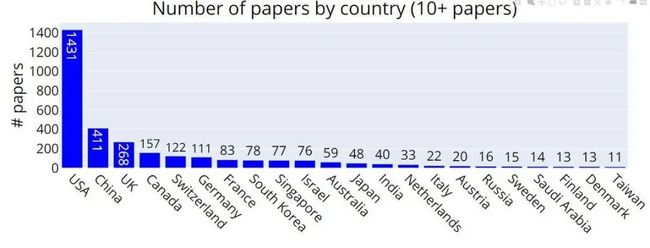

不出意料,美国依然霸榜投稿最多的国家,共提交了1431篇论文,占了总投稿的15.7%。

中国大陆排名第二,提交411篇论文,比美国要少1020篇。

英国位列第三,为268篇。

在被接收论文最多的22位学者中,华人占了8位。

其中,微软亚洲研究院副院长刘铁岩被接收论文最多有14篇,和斯坦福大学的Stefano Ermon并列第一。

得克萨斯大学奥斯汀分校的助理教授汪张扬也有13篇论文被接收。而且在ICLR 2021上,汪张扬被接收的论文数也高居华人学者榜首。

北京大学的王奕森和UCLA的Quanquan Gu以12篇论文紧随其后。

其中,王奕森的论文有两篇中了Top 3%的Spotlight。

华为诺亚方舟实验室的王云鹤、普林斯顿大学的Zhaoran Wang、微软亚洲研究院的秦涛和IBM的Pin-Yu Chen分别有10篇、8篇、8篇和8篇论文被接收。

Bengio被接收的论文也为8篇。

此外,在投稿的论文中,刘铁岩的合作者最多,高达61位。

汪张扬以51位排在第二。

王奕森为40位,超过Bengio的38位,排名第四。

大展风采的华人学者们

微软亚洲研究院副院长刘铁岩

刘铁岩博士,毕业于清华大学,先后获得电子工程系学士、硕士及博士学位。现任微软亚洲研究院副院长,领导微软亚洲研究院在机器学习领域的研究工作。

刘铁岩博士是人工智能领域的国际知名学者,国际电子电气工程师学会院士(IEEE Fellow),美国计算机学会杰出会员(ACM Distinguished Member)。

刘博士还是卡内基梅隆大学(CMU)兼职教授,诺丁汉大学荣誉教授,清华大学、中国科学技术大学、南开大学兼职教授和博士生导师。

他还担任了包括WWW/WebConf、SIGIR、KDD、NIPS、ICML、AAAI在内的诸多顶级国际会议的大会主席、程序委员会主席、本地主席和领域主席,以及IEEE模式分析和机器智能事务(TPAMI)、ACM信息系统事务(TOIS)、ACM网络事务(TWEB)在内的国际知名期刊的副主编或编委。

作为一名工业界实验室的研究员,刘博士为世界做出了独特的贡献。一方面,他的许多技术已经被应用到微软的产品和在线服务上,比如必应、微软广告、Windows、Xbox和Azure。另一方面,他也一直积极为学术界做贡献。

刘铁岩博士的先锋性工作促进了机器学习与信息检索之间的深度融合,被国际学术界公认为「排序学习」领域的代表人物。

他发明了几个非常有影响力的算法和理论,包括列表排序法、关系排序法和排序的统计学习理论,在网络搜索和计算广告学等方向取得了卓越的学术成果。

在「排序学习」领域,他的学术论文已被引用万余次,并受斯普林格(Springer)出版社之邀撰写了该领域的首部学术专著,并成为Springer计算机领域华人作者的十大畅销书之一。

同时,他是LETOR基准数据集的创建者,而LETOR是「排序学习」研究的必备实验平台。凭借他的深入研究和努力,「排序学习」已经成为当今各大搜索引擎的一项基础技术,并继续成为相关研究界最重要的方向之一。

刘博士在深度学习、强化学习、分布式机器学习等方面也颇有建树,发表了百余篇学术论文,被他引数万次。

他曾多次获得最佳论文奖、最高引用论文奖、Elsevier 最高引中国学者奖、中国计算机学会青竹奖、中国AI英雄风云榜技术创新人物奖、AMiner全球最具有响力学者奖(信息检索领域)等奖项。

早在2005年,刘博士就开发出了世界上最大的文本分类器,可以在20台机器上对超过25万个类别进行分类。

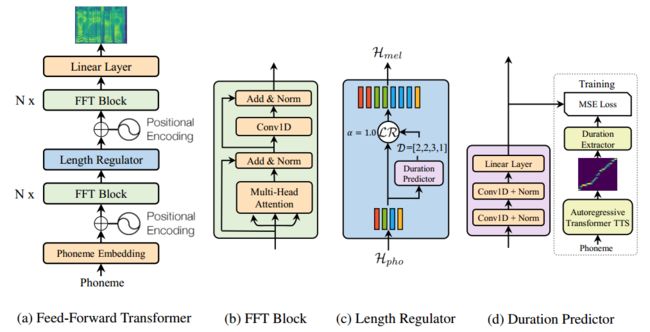

近几年,刘博士和他的团队开发了许多可扩展和高效的机器学习工具,包括世界上最快和最大的主题模型(LightLDA,拥有一百万个主题,发布在WWW 2015上)、最高效和可扩展的递归神经网络(LightRNN,发布在NIPS 2016上)和GBDT模型(LightGBM,目前已成为Kaggle比赛和KDD Cup中最受欢迎的机器学习工具之一),以及最快的神经TTS引擎(FastSpeech,发布在NeurIPS 2019上)。

FastSpeech的整体架构

2018年,他帮助微软在中英新闻翻译任务上达到了人类专家的水平,并于次年获得WMT机器翻译比赛8项冠军。

2019年,他率团队研发了史上最强麻将AI Suphx,在国际知名麻将平台「天凤」上荣升十段,稳定段位显著超越人类顶级选手。

微软亚洲研究院高级首席研究员秦涛

同是微软亚洲研究院的学者,秦涛博士此次NeurIPS 2021也有8篇论文被接收。

秦涛博士,目前是微软亚洲研究院的高级首席研究员,管理深度强化学习小组,在清华大学获得了博士学位和学士学位。

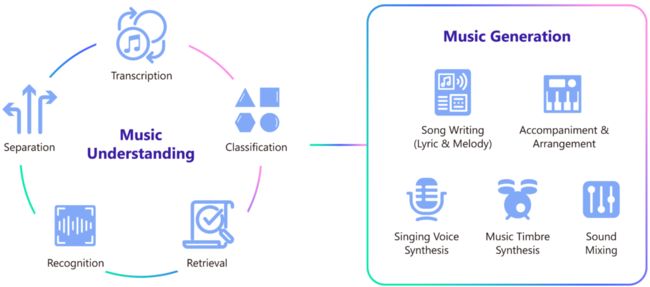

他的研究方向包括深度学习(应用于机器翻译、医疗保健、语音合成和识别、音乐理解和作曲)、强化学习(应用于游戏和现实世界问题)、博弈论和多智能体系统(应用于云计算、在线和移动广告)以及信息检索和计算广告。

他是美国计算机学会(ACM)和美国电气与电子工程师学会(IEEE)的高级会员,中国科学技术大学兼职教授(博士顾问)。

而且,秦涛博士在微软的2018年的中英新闻翻译达到人类专家水平,2019年获得的WMT机器翻译比赛8项冠军,世界上最强麻将AI Suphx的开发中,都做出了重要的贡献。

华为诺亚方舟实验室高级研究员王云鹤

王云鹤博士此次NeurIPS 2021有10篇论文被接收。

王云鹤是北京华为诺亚方舟实验室的高级研究员,从事深度学习、模型压缩、计算机视觉等方面的工作,在北京大学获得博士学位。

王云鹤博士凭借AdderNet系列研究,连获CVPR 2020 Oral论文(AdderNet:Do We Really Need Multiplications in Deep Learning?)和NeurIPS 2020 Spotlight论文(Kernel Based Progressive Distillation for Adder Neural Networks)。

AdderNet在不影响性能的情况下显著降低能耗和电路面积

AdderNet系列的目的是通过替换CNN中的所有卷积层(除了第一层和最后一层),依然可以在ResNet架构上获得与传统CNN相当的性能,但是显著降低能耗。

现在,他还在降低人工智能算法的成本这个领域继续探索,希望提升低级视觉、检测和自然语言处理等任务中AI模型的表现。

参考资料:

https://neurips.cc/Conferences/2021/AcceptedPapersInitial

https://www.msra.cn/zh-cn/people/tie-yan-liu

https://www.microsoft.com/en-us/research/people/tyliu/

https://www.microsoft.com/en-us/research/people/taoqin/

https://www.wangyunhe.site/

-------------------

END

--------------------

猜您喜欢:

等你着陆!【GAN生成对抗网络】知识星球!

CVPR 2021专题1:GAN的改进

CVPR 2021 | GAN的说话人驱动、3D人脸论文汇总

CVPR 2021 | 图像转换 今如何?几篇GAN论文

【CVPR 2021】通过GAN提升人脸识别的遗留难题

CVPR 2021生成对抗网络GAN部分论文汇总

经典GAN不得不读:StyleGAN

最新最全20篇!基于 StyleGAN 改进或应用相关论文

超100篇!CVPR 2020最全GAN论文梳理汇总!

附下载 | 《Python进阶》中文版

附下载 | 经典《Think Python》中文版

附下载 | 《Pytorch模型训练实用教程》

附下载 | 最新2020李沐《动手学深度学习》

附下载 | 《可解释的机器学习》中文版

附下载 |《TensorFlow 2.0 深度学习算法实战》

附下载 | 超100篇!CVPR 2020最全GAN论文梳理汇总!

附下载 |《计算机视觉中的数学方法》分享