【论文翻译 IJCAI-20】Heterogeneous Network Representation Learning 异构网络表示学习

文章目录

- 摘要

- 1 引言

- 2 异构网络挖掘

- 3 异构网络表示

-

- 3.1 异构网络嵌入

- 3.2 异构图神经网络

-

- 3.3 知识图谱与属性网络

- 3.4 应用

- 4 挑战、方向和开源数据

-

- 4.1 未来方向

-

- 避免设计元路径

- 多感官(Multi-sense)表示

- 异构GNN的预训练

- 多任务学习

- 动态性和可伸缩性

- 4.2 开源数据集和基线

- 5 结论

论文链接: Heterogeneous Network Representation Learning

作者:微软研究院、加州大学、清华大学

摘要

表示学习为各种人工智能领域提供了革命性的学习范式。在本研究中,我们研究和回顾了表示学习的问题,重点关注由不同类型的顶点和关系组成的异构网络。该问题的目标是将输入异构网络中的对象(最常见的是顶点)自动投影到潜在的嵌入空间中,以便对网络的结构和关系属性进行编码和保存。这些嵌入(表示)可以作为机器学习算法的特征来处理相应的网络任务。目前关于表达性嵌入学习的研究主要分为两大类:浅嵌入学习和图神经网络。在对现有文献进行彻底的回顾后,我们确定了几个尚未解决的关键挑战,并讨论了未来的方向。最后,我们构建了异构图基线,以促进这一快速发展的课题的开放研究。

1 引言

现实世界中的复杂系统通常与多种类型的对象和关系相关联。以科技企业为例,它涉及论文、作者、机构、场所和研究主题/领域五种类型的实体。其他例子也可以在社会、生物和经济系统中找到。通常,这些复杂系统可以有效地抽象为异构网络,不同类型的顶点在特定关系下相互连接[Sun and Han, 2012]。因此,科学企业可以被建模为一个异质学术网络,如开放学术图(OAG) [Zhang et al., 2019b;Wang等人,2020;唐等人,2008]。

传统的异构网络挖掘过程通常从提取类型结构特征开始,然后将其输入机器学习模型,用于下游图任务。这种挖掘和学习流程通常涉及异构网络中独特的元关系、网络模式和元路径概念,具体介绍如下[Sun and Han, 2012]。

元关系 异构网络中的每条边都与其元关系相关联。

网络模式 给定一个异构网络G,它的网络模式 T G = ( T V , T E ) T_G = (T_V, T_E) TG=(TV,TE),包含G中的所有元关系

元路径

近年来,异构网络的挖掘范式逐渐转向基于表示学习的技术。异构网络表示学习的目标是自动学习网络对象的潜在低维嵌入,如顶点、边和子图。它的前提是将输入网络的内在结构和语义属性编码到潜在的嵌入向量中,从而有利于异构网络上的应用和任务。例如,用户和商品的网络嵌入向量可以作为在线推荐系统的特征输入。

本文综述了近年来异构网络表征学习的研究进展,阐述了异构网络表示学习的挖掘和学习范式。具体来说,我们指出了表示学习问题的挑战,然后将现有的解决方案分为两组,即浅嵌入和基于图神经网络(GNNs)的发展。重要的是,我们确定了尚未解决的挑战和问题。

2 异构网络挖掘

简要介绍了异构网络挖掘技术的发展历史。在网络科学和图挖掘的发展过程中,已经有研究探索包含不同类型的顶点和边的网络,如推荐系统中的二部图、超图、多层网络和文献网络中的主题建模。

异构网络的形式化可以追溯到异构信息网络的研究,在该研究中,作者提出利用不同类型的顶点之间的链接生成集群。更重要的是,作者认为“多类型对象之间的交互在揭示网络承载的丰富语义方面起着关键作用”[Sun和Han, 2012]。除了聚类,图的异构性在其他的图挖掘任务中也得到了体现,包括顶点分类、排序、相似度搜索、链接预测、异常检测等。

传统的异构网络挖掘工作流程是首先在网络模式上定义元路径或其变体,如元图或元结构,然后将其作为特征来开发机器学习模型[Sun and Han, 2012]。以学术网络中的链接预测任务为例,我们可以定义“作者-论文-作者”元路径来提取异质结构特征,并利用它们来推断每对作者之间是否存在协作关系。

挑战 异构网络挖掘的主要挑战在于元路径的设计。通常,为了解决输入网络的特定图问题,我们必须手动定制特定于任务和数据的元路径,这需要相关的领域知识和经验。

此外,传统的元路径的使用仅限于离散空间。如果两个顶点在图中没有结构上的连接,基于元路径的技术就不能捕获它们的关系。例如,假设一个学者的论文全部发表在NeurIPS上,而另一个学者的论文全部发表在ICML上。根据“author-paper- venupaper -author”元路径,两者之间的相似性为零,由于NeurIPS和ICML之间具有很强的相关性,这是反直觉的[Dong et al., 2017]。这种来自离散结构的挑战可以通过在连续空间中使用潜在表示来自然地解决。

3 异构网络表示

在过去的几年里,神经表示学习(neural representation learning)通过使用神经网络来学习物体的潜在嵌入,为计算机视觉、自然语言处理和语音识别等领域提供了革命性的结果。受此启发,已经有人尝试将表示学习应用到网络中。网络表示学习的前提是,它可以自动将网络结构嵌入到潜在空间中,而不是手工加工结构特征,从而用于现有的网络挖掘任务。

神经网络表示学习的主要障碍是将非欧几里德图结构转化为欧几里德嵌入空间,因为图数据与神经网络之间存在差距。最近,弥合这一差距的主要进展是借鉴图论的思想。例如,一个方向的尝试是利用随机游走将图结构转换为序列,这些序列可以被基于序列的嵌入学习算法使用,如node2vec模型[Grover和Leskovec, 2016]。另一条努力线可以在图谱和卷积滤波器之间的连接上找到,利用它我们可以直接在图上设计神经网络操作,如图卷积网络(GCN) [Kipf和Welling, 2017]。

大多数异构网络上的表示学习技术都是在(同构)网络表示学习的基础上发展起来的。其核心问题是如何将不同类型的顶点和边之间的结构转换为潜在空间,从而使异构网络的结构和语义属性都能够被编码和保存。

3.1 异构网络嵌入

我们回顾了基于浅层学习的异构网络嵌入方法。“浅”方法的特点是一个嵌入查找表,这意味着它们直接将每个顶点编码为一个向量,这个嵌入表是要优化的参数。沿着这条线,方法可以根据它们所建立的假设进行分类。

基于分布式假设的方法 skip-gram是一种浅层嵌入学习算法,最初提出是为了捕获自然语言中单词的语义相似度。它基于分布假说[Harris, 1954],即“出现在相同语境中的单词往往具有相似的意思”。后来,这个假设被扩展到网络:具有相同结构上下文的顶点在嵌入空间中趋于接近。为了捕获它,已经提出了几种基于跳克的同构网络嵌入方法,如DeepWalk和node2vec,以及它们的矩阵分解理解NetMF [Qiu et al., 2018]。

为了对异构网络中的分布假设进行建模,PTE模型[Tang et al., 2015]首先将输入异构网络投射到多个同质/双部网络中。然后它定义了每个顶点的接近性,并假设:“具有相似邻居的顶点彼此相似,因此应该在低维空间中紧密地表示。”基于这个假设,PTE在每个网络上都采用了跳克框架,并联合优化了所有的嵌入表。

为了更好地捕捉图的异质性,提出了metapath2vec模型[Dong et al., 2017]。它的主要思想是扩大随机游走策略,它最初用于收集节点上下文来建模同构网络中的分布假设。具体来说,它引入了基于元路径的随机游走策略,其中游走器被限制在特定类型的顶点之间的过渡。与PTE相比,该策略可以更好地统一捕获不同类型顶点之间的结构依赖关系。对于嵌入学习,metapath2vec直接利用带有负采样的skip-gram来学习异构网络中所有类型的顶点的嵌入。此外,它的增强版本进一步提出了类型依赖的负抽样skip-gram,有效地建模了异构网络中的结构和语义依赖。

随后,各种解决方案利用元路径来构建异构上下文,以学习不同下游任务的表示。例如,类似于word2vec的phrase2vec扩展,HIN2vec [Fu et al., 2017]直接将元路径作为对象/上下文来学习顶点和元路径的嵌入。GA TNE [Cen et al., 2019]将该框架扩展到多路异构网络,TapEm [Park et al., 2019]进一步将顶点对嵌入与元路径嵌入相结合。最近,NeRank [Li等人,2019]提出利用基于元路径的跳gram嵌入模型来帮助异构网络的问答任务。HeteSpaceyWalk [He等人,2019]进一步完善了基于元路径的随机漫步,在元路径、图和模式的指导下,提出了异构个性化的空间随机漫步算法。更重要的是,这种随机游走策略与顶点之间的收敛平稳分布有关。

其他方法 除了基于跳gram的方法外,其他异构网络嵌入技术还包括标签传播、因式分解和基于生成对抗网络的方法。此外,这些技术中的大多数都是特定于任务的,需要监督信息。

2014年,学习异构网络表示的早期尝试之一是基于标签传播的LSHM模型[Jacob等人,2014]。对于异构网络,LSHM借用了同构网络中标签传播的平滑性假设——“两个连接的节点趋向于具有相同的标签”。它的思想是强制(不同类型的)顶点具有类似的表示,如果它们通过使用顶点类型特定的分类损失连接。该方法采用标签传播框架进行顶点分类。此外,还提出了一种类似的任务和结构损失联合优化方法来解决异构链路预测问题[Chen和Sun, 2017]。它的结构损耗是基于针对异构网络中特定任务手工设计的元路径来构造的。总之,这些方法是(半)监督的,作者认为不同类型之间的结构依赖和标签依赖可以建模。

与PTE类似,HERec模型也根据定制的元路径将输入异构网络投射到多个维度[Shi等人,2017]。然后使用每个投影中的metapath2vec框架来学习顶点嵌入,所有这些都通过一个基于因式分解的融合模型与来自推荐任务的监督信息合并。HueRec方法[Wang et al., 2019b]则认为不同的元路径之间存在相互关系,因此将它们统一为异构网络中推荐任务的端到端框架。

大多数基于skip-gram的嵌入方法都与负采样相关联,以实现可扩展和快速学习。更广泛地说,该技术属于噪声对比估计(NCE)领域,在此基础上,APE 模型[Chenet al., 2016]在“上下文相关的”噪声分布下,无论数据空间如何,都能有效地学习不同顶点类型之间的交互概率。此外,最近的一项研究提出了基于生成对抗网络(GAN)的框架HeGAN来实现这一点[Hu等人,2019]。HeGAN的目标不是直接采样,而是生成底层的顶点分布,从而产生具有异质结构的更好的负样本。

总结 在浅嵌入环境下,异构网络中存在无监督和有监督学习框架。大多数无监督方法都是基于分布假设在异构网络中的应用,如基于skip-gram的模型。对于(半)监督框架,学习目标通常是异构结构建模和任务特定优化的组合。

然而,在这两种学习设置下,大多数方法依赖于人工探索异构结构,即选择元路径或变体,以捕获结构和语义依赖。

3.2 异构图神经网络

在过去的几年中,图神经网络(GNNs)在建模结构和关系数据方面显示出了良好的结果。与浅层嵌入方法不同,GNN通常由更复杂的编码器授权,通常是一个深度神经网络,使结构和顶点属性的自然建模。在这一部分中,我们总结了用于异构网络表示学习的GNN的最新发展。

我们首先介绍用于关系数据的通用GNN框架。一种方法是将其视为一种神经信息传递框架,其中,输入图的结构被用作传播(顶点或边)信息的骨干,以形成表达表示。或者,我们可以将其视为特征聚合过程[Hamilton et al., 2017],其中对于每个顶点,其邻域被认为是一个接受域,它从接受域递归地聚合信息。

关系GCN 使用GNN的多关系图的第一个尝试是关系图卷积网络(RGCN) [Schlichtkrull等人,2018],它为每个边缘类型保持不同的线性投影权重。为了处理具有大量关系的图,RGCN还将关系特定的参数分解为几个基矩阵的线性组合

另一个值得注意的努力是Decagon模型[Zitnik等人,2018],该模型在以蛋白质、药物、多药副作用为顶点的多模态图的每一种关系上应用特定的图卷积滤波器。注意,Decagon中特定于关系的参数是为不同的顶点共享的。

异构GNNs 为了处理异构图结构和节点属性,异构图神经网络(HetGNN) [Zhang等人,2019a]使用特定类型的RNN来编码每种类型的邻居顶点的特征,然后另一个RNN来聚合不同类型的编码邻居表示。

异构图注意力 为了将注意力[V eliˇckovi´c et al., 2018]纳入异构GNN设计中,GEM方法[Liu et al., 2018]对每个关系利用不同的聚合器,并学习注意力系数来建模不同类型顶点的重要性。

随后,异构图注意网络(HAN) [Wang et al., 2019a]使用元路径作为边来扩大图,并对每个元路径定义的边保持不同的权重矩阵。它还利用高级语义注意来区分和聚合来自不同元路径的信息。

异构图Transformer 之前的所有工作都单独使用节点顶点类型或边类型来确定GNN权矩阵。然而,对于那些没有充分出现的关系,很难学习准确的特定于关系的权重。为了解决这个问题,异构图转换器(HGT) [Hu等人,2020b]使用每个边的元关系来参数化类似于转换器的自关注架构,这样就可以通过使用相同或更少的参数来捕获不同关系的共同和特定模式。此外,与现有大多数需要手工设计元路径的工作不同,HGT可以通过多层gnn的本质自动学习隐式元路径的重要性,以纳入高阶异构邻居信息。

另一项并发工作,Graph Transformer Networks [Yun等人,2019],学习边类型和复合关系的软选择,以生成有用的多跳元路径来增强输入图。之后,它对增强图采用普通的GCN层,以获得上下文化的顶点嵌入。

总结 图神经网络的本质确保了上述所有方法都可以得到任何不可见的顶点或图的归纳嵌入,而不是像浅层嵌入方法那样为图中的每个顶点维护一个大的查找表。此外,它们可以自然地利用神经网络编码器丰富的顶点属性。

为了适应异构设置,现有的所有模型对每种关系类型采用不同的权重矩阵。它们中的大多数利用人为设计的元路径来扩充图表,而一些最近的工作利用自注意机制来自动学习“软”元路径。

3.3 知识图谱与属性网络

异构网络与知识图和属性网络紧密相连。在这个简短的调查中,我们没有深入挖掘他们的差异和联系。知识图嵌入通常是一种用于完成知识图三元组的技术。它的主要解决方法可以分为两类:神经嵌入法和张量分解法。,基于RESCAL的模型。给出了与图神经网络输入相似的属性网络嵌入。值得注意的是,ANE和DANE模型被提出来建模网络结构和属性之间的内在关联,并扩展到动态环境。最近,Cen等人将属性多路异构网络的表示学习问题形式化。为了解决归属、多重和异构的挑战,他们提出了GA TNE框架,并对其表达优势进行了理论论证

3.4 应用

由于异构网络可以对现实世界的复杂系统进行抽象和建模,因此异构网络上的表示学习有许多应用,如相似度搜索、知识图推理、问答和推荐。例如,metapath2vec方法已经在Microsoft Academic2中部署用于相似性搜索。另一个受益于异构网络嵌入的行业系统是电子商务中的在线推荐模块[Cen等人,2019]。

4 挑战、方向和开源数据

在其发展过程中,表示学习为挖掘异构网络提供了范式转换。特别明显的是,图神经网络可以显著地重塑异构网络表示学习,从而有利于异构网络数据的所有可能的应用。因此,我们将重点讨论基于GNN技术的剩余挑战和未来发展方向。特别明显的是,图神经网络可以显著地重塑异构网络表示学习,从而有利于异构网络数据的所有可能的应用。因此,我们将重点讨论基于GNN技术的剩余挑战和未来发展方向。

4.1 未来方向

避免设计元路径

表示学习的广泛前提是,可以避免涉及手工工作和领域专业知识的特性工程。正如我们上面讨论的,大多数异构表示学习方法需要手动定制元路径或它们的变体(例如,元图),以便模型捕获给定的异构结构的语义。例如,metapath2vec、HetGNN和HAN必须将预定义的元路径作为输入来处理专用任务。本质上,它们的表示能力仅限于特定数据上的特定任务。避免元路径设计的一个有希望的尝试是最近的HGT模型[Hu等人,2020b],该问题可以通过gnn跨多层的特征传播自然解决。因此,为了充分发挥表示学习的威力,有必要在不预先设计元路径的情况下自动学习异构网络表示,即避免对网络结构和语义的预先探索

多感官(Multi-sense)表示

到目前为止,大多数嵌入是从复杂和多类型的异构网络中学习单一感觉。以分布假说为例,构造环境之间没有区别。具体地说,如果我们把“韩加伟”这个学者当作一个例证,我们就会对他有不同的感觉。在科学合作的意义下,与他最相似的学者是他的博士生“建培”和“喜凤眼”。或者,在场所出版物的意义下,“Philip S. Yu”和“Christos Faloutsos”与他最相似。或者,在数据挖掘的科学影响的意义下,他更类似于数据库中的“Rakesh Agrawal”和IR中的“Bruce Croft”。从这个例子中,我们可以清楚地看到异构网络中存在多意义表示。如何定义、学习和使用它们在很大程度上仍然是开放和未探索的。

异构GNN的预训练

如前一节所述,现有的(异构)gnn是在(半)监督设置下进行的端到端训练。换句话说,我们需要为每个数据集上的每个任务提供专用的标签数据,这在现实世界中通常是昂贵的,特别是对于web规模的异构图。为了解决标签稀缺问题,预先训练的神经模型已经被采用,并显著推进了各种人工智能领域的发展,如自然语言处理中的BERT。预训练模型的好处包括:1)大多数时候,它是在无监督(或自我监督)的方式下进行训练的,不需要特定任务和数据的标签信息;2)可用于对不同的下游任务进行微调,甚至可推广到各种数据。

在此,我们设想了两种类型(异构)GNN训练前的未来研究方向。首先,学习预先训练的模型来捕获输入网络的底层结构属性,这样它就可以用于相同输入数据上的不同任务。其次,我们在一组(不同类型)网络上预先训练一个GNN模型,目的是捕获这些网络的内在结构属性,从而促进不同(看不见的)网络的下游任务。自然,异构GNN的预训练也面临着图的异构性的挑战,这使得它不同于现有的同类文本/图像/语音数据的预训练技术,而且更具挑战性。

多任务学习

近年来,多任务学习使得深度学习方法在学习自然语言处理和CV表示方面优于传统的单任务学习。它的理念是同时处理多个任务,以识别和利用这些任务之间的相似性/差异性。研究报告称,这样做,与特定任务模型相比,整体表现可以得到改善。

请注意,给定一个由多种类型的顶点和边组成的异构网络,它通常与各种挖掘任务相关联。例如,在异构学术网络中有许多真实的应用,如姓名消歧、论文主题或作者研究兴趣的推理、文献和引文推荐、相似度搜索等。所有这些异构网络任务都可以从多任务学习中受益,在多任务学习中,可以跨任务学习共享表示,并且特定于任务的参数可以用于其他任务。异构网络的独特性质是包含多种类型的顶点和边,这可能是多任务学习的一种自然应用。

动态性和可伸缩性

在现实世界中,大多数网络都是随着时间的推移而发展的,其建模长期以来一直是一个研究挑战。当与不同类型的顶点和边耦合时,网络的动态问题变得特别具有挑战性——异构网络。现有的方法大多是根据时间戳将输入动态网络分解为多层网络。因此,不同层之间的结构和时间依赖性通常被忽略。为此,如何有效地对动态异构网络进行建模仍然是一个有待解决的问题,更不用说对它们进行表示学习了。

另一个常见的挑战是现实世界的大规模图表。OAG由数十亿个顶点和边组成,跨度从1800年到2020年(到目前为止)。其他大规模的图表甚至更大,如LinkedIn经济图表、维基百科实体图表、微软Office图表等。现有的研究主要集中在改进同构网络表示学习方法的可伸缩性方面。对于大多数现有的异构网络表示学习技术,在Webscale图上学习是非常昂贵的。因此,可扩展和计算可行的模型是未来工作的关键方向。

其他 除了上述针对异构网络的问题外,一般的GNN模型也面临着一些挑战,比如当许多GNN层被堆叠时,会出现过平滑和过拟合问题。这些问题的解决自然有利于异构网络表示学习。

4.2 开源数据集和基线

之前,我们讨论了异构网络表示学习的主要技术挑战。此外,社区还面临着数据挑战,尽管有几个公共的异构网络数据集,如DBLP/AMiner数据、Amazon/Yelp审查数据和IMDB数据。首先,这些数据集被不同的任务和评估指标以不同的方式使用。其次,对它们进行随机预处理,如不同版本、不同的训练-测试-验证分割、不同的顶点类型选择等。最后,即使在相同的数据和相同的预处理,不同的结果报告跨文献。

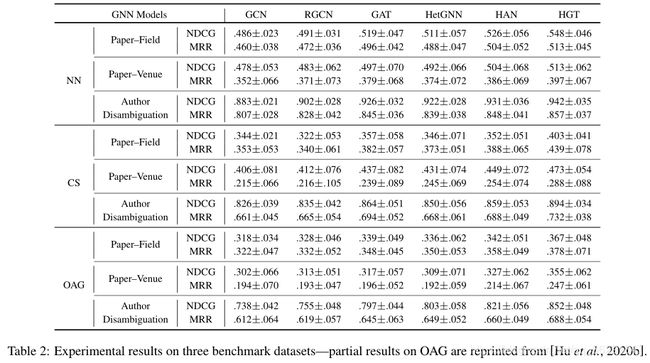

为了解决这些问题,我们建议用从OAG构建的三个数据集的第一个版本来构建异构图benchmark3。其思想类似于Open Graph Benchmark [Hu et al., 2020a]和GNN Benchmark [Dwivedi et al., 2020],但重点是异构图。目前的数据集是基于人工神经网络(Artificial Neural Networks, NN)、计算机科学(Computer Science, CS)和所有主题(all topics, OAG)等不同(高水平)的研究领域构建的。三个数据集的统计数据如表1所示。我们利用预定义的数据分割策略和特征定义构建了三个任务,包括论文的研究领域和发表地点预测,以及作者姓名消歧。此外,我们运行了几个流行的、功能强大的(异构)图神经网络,包括GCN、GAT、RGCN、HetGNN、HAN和HGT,以报告表2中每个数据集上的每个任务的统计显著结果,这可以称为基准性能

5 结论

在这项工作中,我们介绍了异构网络表示学习的问题,并讨论了其潜在的挑战。我们回顾了最近在应对这些挑战方面取得的进展。更重要的是,我们对问题进行更深层次的挖掘,揭示出今后需要解决的关键问题和痛点。为了促进对这个快速发展的主题的开放和可重复的研究,我们迈出了第一步,为研究社区发布异构图基准

总结

本文将异构图嵌入方法分为浅嵌入学习和异构图神经网络方法,分别进行了回顾总结。突出的贡献点在于为未来异构图神经网络的发展指明了方向,并且建立了基准数据集和基线。