01-初识大数据-我的大数据工程师成长之路:Hadoop介绍

首先声明由于学习过程是根据阿里云大学的大数据学习路线学习,所以本系列的文章也会引用来自该路线课程中的一些资料,如侵权请联系我删除,谢谢。

转载请注明来源:https://blog.csdn.net/yezisuifengbiao/article/details/115742261

很久没有更新博客了,最近因为工作原因,打算考一考阿里云ACP的大数据工程师认证,于是开始了我的大数据学习之路……

因为长期做前端APP,后面转型做RPA,Linux系统我从来没用过更别提里面的命令了,但我觉得我可以,写博客不是为了技术分享(因为这个领域是我从未涉猎过的),而且记录下自己的转型学习之路,更是一种在学习过程中复盘所学知识的办法,开始吧……

关于大数据的特点与概念我就不描述了,网上一搜都一大把,先从开源大数据分析系统Hadoop基础及应用开始。

Hadoop是什么?

1)Hadoop是一个有Apache基金会所开发的分布式系统基础架构。

2)主要解决海量数据的存储和海量数据的分析计算问题。

Hadoop三大发行版本:Apache、Cloudera、Hortonworks

Apache版本最原始(最基础)的版本,对于入门学习最好。

Cloudera在大型互联网企业中用的较多。

Hortonworks文档较好。

Hadoop的优势

1、高可靠性:Hadoop底层维护多个数据副本,所以即使Hadoop某个计算元素或存储出现故障,也不会导致数据的丢失。

2、高扩展性:在集群间分配任务数据,可方便的扩展数以千计的节点。

3、高效性:在MapReduce的思想下,Hadoop是并行工作的,以加快任务处理速度。

4、高容错性:能够自动将失败的任务重新分配。

Hadoop的组成

1、 1.x版本与2.x版本的区别

2、HDFS架构概述

1)NameNode(nn):存储文件的元数据,如文件名、文件目录结构,文件属性(生成时间、副本数、文件极限),以及每个文件的块列表和块所在的DataNode等。---------> 相当于目录

2) DataNode (dn):在本地文件系统存储文件块数据,以及块数据的检验和。---------> 相当于详细内容

3)Secordary NameNode (2nn):用来监控HDFS状态的辅助后台程序,每隔一段时间获取HDFS元数据的快照。

3、YARN的架构概述

3.1、YARN的运行流程

3.2、Resourcemanager

ResourceManager 拥有系统所有资源分配的决定权,负责集群中所有应用程序的资源分配,拥有集群资源主要、全局视图。因此为用户提供公平的,基于容量的,本地化资源调度。根据程序的需求,调度优先级以及可用资源情况,动态分配特定节点运行应用程序。它与每个节点上的NodeManager和每一个应用程序的ApplicationMaster协调工作。

ResourceManager的主要职责在于调度,即在竞争的应用程序之间分配系统中的可用资源,并不关注每个应用程序的状态管理。

ResourceManager主要有两个组件:Scheduler和ApplicationManager:Scheduler是一个资源调度器,它主要负责协调集群中各个应用的资源分配,保障整个集群的运行效率。

Scheduler的角色是一个纯调度器,它只负责调度Containers,不会关心应用程序监控及其运行状态等信息。同样,它也不能重启因应用失败或者硬件错误而运行失败的任务。

3.3、NodeManager

NodeManager是yarn节点的一个“工作进程”代理,管理hadoop集群中独立的计算节点,主要负责与ResourceManager通信,负责启动和管理应用程序的container的生命周期,监控它们的资源使用情况(cpu和内存),跟踪节点的监控状态,管理日志等。并报告给RM。

NodeManager在启动时,NodeManager向ResourceManager注册,然后发送心跳包来等待ResourceManager的指令,主要目的是管理resourcemanager分配给它的应用程序container。NodeManager只负责管理自身的Container,它并不知道运行在它上面应用的信息。在运行期,通过NodeManager和ResourceManager协同工作,这些信息会不断被更新并保障整个集群发挥出最佳状态

主要职责:

1、接收ResourceManager的请求,分配Container给应用的某个任务

2、和ResourceManager交换信息以确保整个集群平稳运行。ResourceManager就是通过收集每个NodeManager的报告信息来追踪整个集群健康状态的,而NodeManager负责监控自身的健康状态。

3、管理每个Container的生命周期

4、管理每个节点上的日志

5、执行Yarn上面应用的一些额外的服务,比如MapReduce的shuffle过程

3.4、Container

Container是Yarn框架的计算单元,是具体执行应用task(如map task、reduce task)的基本单位。

Container和集群节点的关系是:一个节点会运行多个Container,但一个Container不会跨节点。

一个Container就是一组分配的系统资源,现阶段只包含两种系统资源(之后可能会增加磁盘、网络、GPU等资源),由NodeManager监控,Resourcemanager调度。

每一个应用程序从ApplicationMaster开始,它本身就是一个container(第0个),一旦启动,ApplicationMaster就会更加任务需求与Resourcemanager协商更多的container,在运行过程中,可以动态释放和申请container。

3.5、ApplicationMaster

ApplicationMaster负责与scheduler协商合适的container,跟踪应用程序的状态,以及监控它们的进度,ApplicationMaster是协调集群中应用程序执行的进程。每个应用程序都有自己的ApplicationMaster,负责与ResourceManager协商资源(container)和NodeManager协同工作来执行和监控任务 。

当一个ApplicationMaster启动后,会周期性的向resourcemanager发送心跳报告来确认其健康和所需的资源情况,在建好的需求模型中,ApplicationMaster在发往resourcemanager中的心跳信息中封装偏好和限制,在随后的心跳中,ApplicationMaster会对收到集群中特定节点上绑定了一定的资源的container的租约,根据Resourcemanager发来的container,ApplicationMaster可以更新它的执行计划以适应资源不足或者过剩,container可以动态的分配和释放资源。

4、MapReduce架构概述

MapReduce将计算过程分为两个阶段:Map和Reduce

1) Map阶段并行处理输入数据

2)Reduce阶段对Map结果进行汇总

5、大数据技术生态体系

图中涉及的技术名词解释如下:

1)Sqoop:Sqoop是一款开源的工具,主要用于在Hadoop、Hive与传统的数据库(MySql)间进行数据的传递,可以将一个关系型数据库(例如:MySQL,Oracle等)中的数据导进到Hadoop的HDFS中,也可以将HDFS的数据导进到关系型数据库中。

2)Flume:Flume是Cloudera提供的一个高可用的,高可靠的,分布式的海量日志采集、聚合和传输的系统,Flume支持在日志系统中定制各类数据发送方,用于收集数据;同时,Flume提供对数据进行简单处理,并写到各种数据接受方(可定制)的能力。

3)Kafka:Kafka是一种高吞吐量的分布式发布订阅消息系统,有如下特性:

(1)通过O(1)的磁盘数据结构提供消息的持久化,这种结构对于即使数以TB的消息存储也能够保持长时间的稳定性能。

(2)高吞吐量:即使是非常普通的硬件Kafka也可以支持每秒数百万的消息。

(3)支持通过Kafka服务器和消费机集群来分区消息。

(4)支持Hadoop并行数据加载。

4)Storm:Storm用于“连续计算”,对数据流做连续查询,在计算时就将结果以流的形式输出给用户。

5)Spark:Spark是当前最流行的开源大数据内存计算框架。可以基于Hadoop上存储的大数据进行计算。

6)Oozie:Oozie是一个管理Hdoop作业(job)的工作流程调度管理系统。

7)Hbase:HBase是一个分布式的、面向列的开源数据库。HBase不同于一般的关系数据库,它是一个适合于非结构化数据存储的数据库。

8)Hive:Hive是基于Hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表,并提供简单的SQL查询功能,可以将SQL语句转换为MapReduce任务进行运行。其优点是学习成本低,可以通过类SQL语句快速实现简单的MapReduce统计,不必开发专门的MapReduce应用,十分适合数据仓库的统计分析。

9)R语言:R是用于统计分析、绘图的语言和操作环境。R是属于GNU系统的一个自由、免费、源代码开放的软件,它是一个用于统计计算和统计制图的优秀工具。

10)Mahout:ApacheMahout是个可扩展的机器学习和数据挖掘库。

11)ZooKeeper:Zookeeper是Google的Chubby一个开源的实现。它是一个针对大型分布式系统的可靠协调系统,提供的功能包括:配置维护、名字服务、分布式同步、组服务等。ZooKeeper的目标就是封装好复杂易出错的关键服务,将简单易用的接口和性能高效、功能稳定的系统提供给用户。

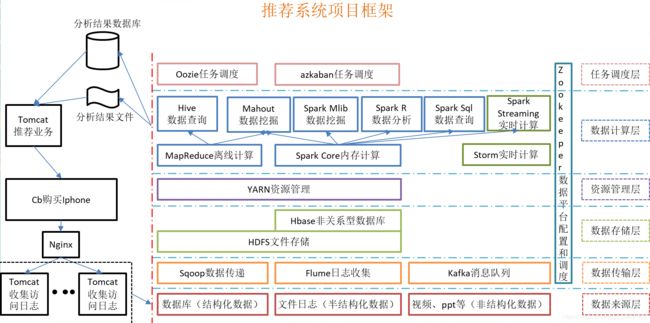

6、推荐系统框架图

以上内容就是Hadoop介绍的全部内容,让我们一起期待下一次的学习。