AIGC底层数据探索——高质量数据助力大模型迭代升级

//

编者按:近年来,大模型的概念逐渐受到更广泛的关注,而谈及大模型就离不开对底层数据的探索。

大模型训练数据痛点与中文数据集现状;高质量数据定义;对话式数据模型实验;晴数智慧高质量数据解决方案。

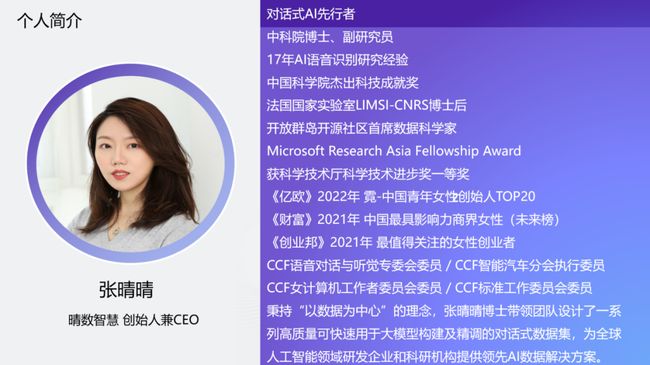

文/张晴晴

整理/LiveVideoStack

大家好,我是来自北京晴数智慧科技有限公司的创始人张晴晴,今天和大家分享的是AIGC底层数据探索。

数据是在这一次大模型里被更多人所关注的一个点,晴数智慧也在这个方向深耕了7年。我们做的核心是为所有在进行人工智能研发、产品落地化过程中需要的高质量数据集产品提供数据产品的生产设计,包括营销的全链条能力。

我在中科院研究人工智能相关的算法背景,包括在微软研究院、法国国家实验室进行过研究。根据我过去多年的研究经验发现,数据研究其实是一个非常难、非常专业,同时非常辛苦的事,被大家称为dirty work。但是所有的工程化都脱离不了dirty work,只有做好这些事情,才有可能创造一个更好的人工智能的明天。

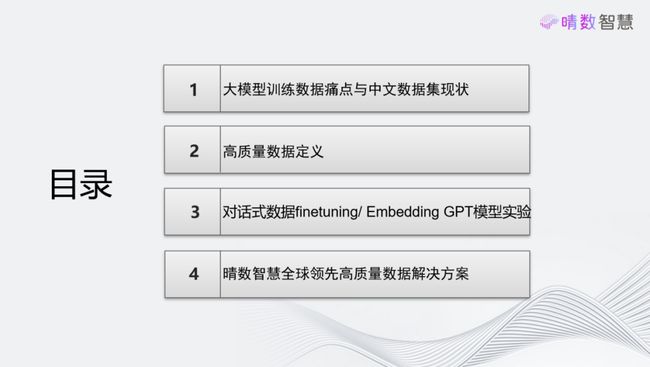

这次的分享分为4个部分,为大家带来关于数据这一维度的介绍:

第一是目前讨论度较高的大模型,和大家分享训练数据的痛点以及中文数据集的现状;

第二是关于高质量数据。怎样定义“高质量”这个词?晴数智慧有自己的定义标准。

第三是对话式数据,为了展示在模型训练过程中的实验效果,我们进行了微调步骤Finetuning和Embedding的对比实验,让大家可以看到用不同技术和训练数据集能达到的效果。

第四是晴数智慧能给大家提供什么样的数据支撑。

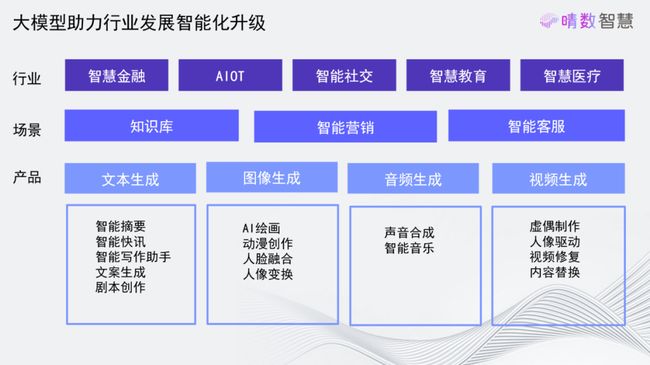

ChatGPT引发了一场AI盛宴,包括国外的OpenAI、国内的文心一言等,大家都耳熟能详。这一过程中最大的一个变化是生成式,从过去的encoder decoder走向今天decoder的形态。从整个行业的情况来看,大模型还没有完全落地,更多是围绕OpenAI、ChatGPT这种通用式的大模型构建一种通用式的底座,但这种底座能够对未来垂直行业落地提供非常好的基础支撑。

目前有许多行业开始跃跃欲试,希望能够第一时间学习大模型,例如金融、AIOT、小红书这类智慧社交、教育、医疗、法律。在这其中又分为对精度要求、容忍度、包容度要求高低的区别。目前来看,对于精度包容度更高、精度要求更低的类型,有可能可以更快接入AIGC。

过去大家研究的人工智能被称为小模型,现在的叫大模型。为什么我们要使用大模型?过去的小模型有什么确定?未来是否是大模型的天下,小模型失去了生存空间?依据这些问题,下面分享一下晴数智慧的观点:

假设用户或产品有某一功能需求,围绕这一需求,使用相关数据训练一个模型,这种模型就是小模型。小模型解决的是单点的问题,通过使用它的匹配数据,能够把这个问题解决得很好,精度很高。小模型的最大缺陷在于不具备举一反三的能力,仅仅能解决单点问题。虽然它能把问题解决好,但纵观人类社会,没有任何一个岗位职能需要的是单一的能力,对于一个人而言,往往也需要兼备很多事项,只是有一个相对的侧重点。

大模型就具备这样的能力。大模型用一个核心的底座——预训练这一步骤,构建的就是举一反三能力,即通识性能力。这种通识性在上面Finetuning或Embedding之后,使得在垂域过程中能够具备一定的泛化能力。在既有泛化能力,又有一定专业度,这种两者结合的情况下,大模型更加像人类了。

那么小模型还有没有用呢?肯定也是有用的。如果在某些领域,只存在一个很简单的单点问题,那不需要用到大模型,因为大模型的资源耗费量非常大。根据这点可以判断怎样拆解任务,什么时候用大模型,什么时候用小模型。

无论构建什么模型,数据都非常重要,只是在大模型中大家发现数据更为重要了,数据的影响力更大了。过去大家更关注数据的规模量,而这次大家更关注数据的质量,即高质量数据,这一点和我们国家现在追求的高质量发展使完全契合的。

为什么要追求高质量?一个普通的数据内容和一个蕴含知识点丰富的内容同时放到大模型训练,大模型所接纳吸收的知识是完全不在一个量级上的,无数条低质量数据也堆不出一条高质量数据所蕴含的知识,所以人们逐渐开始从规模量走向质量,所以数据非常重要。

为什么说这一次的大模型有可能带来更多颠覆?过去的人工智能充当的是“雕花”的功能,在IT的基础之上把建筑雕刻得更为精美,所以有时我们感觉它是浅层的、可有可无的东西。但这一次大模型的出现,使人工智能的渗透度越来越大,甚至某天可能把曾经的IT基建都颠覆,这是大势所趋。大模型的前路或许会一波三折,但大趋势不会再往后退了。

下面分析要训练一个大模型,目前的数据方面有哪些痛点。

第一是语料库稀缺。不谈质量,在规模方面语料就比较稀缺。中文的语料量大约只有英文语料量的几十分之一,原因在于英文的使用普及度很高的语言。同时大模型相应的研究文献目前还是以英文为主,翻译成中文的部分很少,因此这些知识大多是以英文的形式储备下来的。

第二,数据的处理成本高。网络上也有很多爬取的数据,但这些数据本身质量参差不齐。要从里面挑出好的数据,处理成本极高。目前这一阶段,大家可以先不谈质量,先把量堆起来。

第三,数据合规。数据合规一定是在数据的合作和交易以及大模型的形态里面,也是大势所趋的。高质量数据其中有一个很重要的维度就是数据合规。一个合规的数据中,个人隐私处理得干净,数据来源也完整可追溯,价值更高,使用的时间也更长。在未来,数据合规在整个生产链条中是一个耦合的状态,每个点如何处理、合规到什么程度,都很复杂,专业度很高。

第四,领域大模型,也叫垂域大模型。除了通用的AGI,国家现在更为重视的是垂域大模型。中国的产业落地在千行百业的领域里,让大模型真正落地到生活中,能够产生降本增效的效果。在产业中所面临的数据形态和互联网的形态不一样,它的专业度很高。领域本身的专业度是我们需要克服的门槛。

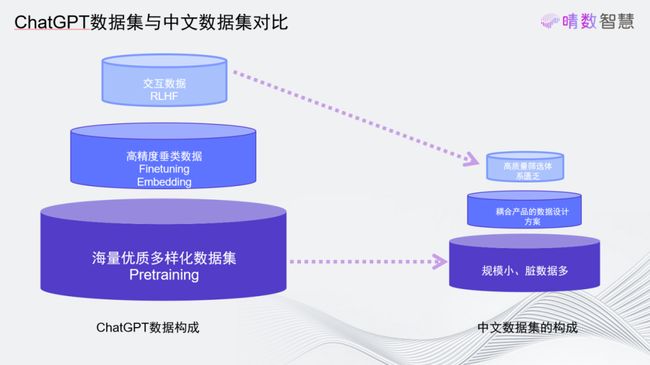

从训练本身算法的角度分层来看,在ChatGPT训练、国内训练大模型时,需要哪些数据。大模型训练的训练步骤分为三个层级:

第一是基座,成为预训练Pretraining,是现在更多大模型在关注的点。前面提到的举一反三能力就是来源于这一步骤。这个步骤要求数据的具有多样性的特点,和下游需要解决的问题没有太多相关性。因此在这一步骤中要更加聚焦于如何构建一个更好的“基因”,以及控制政治正确性。

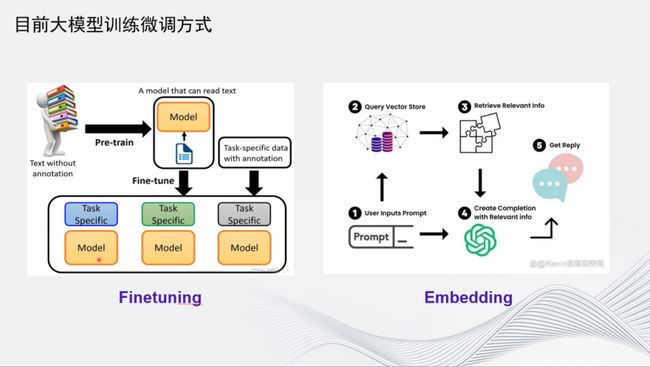

第二是目前垂域中用的较多的微调,英语称为Finetuning和Embedding,都是用数据在已构建好基座的大模型上再做一个迭代,使大模型能够快速适应具体场景,例如知识库检索、营销客服对话等场景。这两个技术相比,Finetuning的技术要求门槛较高,是对已构建预训练的模型的参数进行再次调整。而Embedding则不用,塔是在上面挂载一个知识库,再用大模型进行泛化。这一阶段需要的是高精度垂域的数据训练,例如SFT(Supervised Finetuning)数据、Prompt数据、单轮对话数据、多轮对话数据、围绕一个垂域领域的专用数据,都会在这一阶段输送进去。

再往上就是基于人类反馈的强化学习,英语缩写叫RLHF。这个步骤目前在大模型训练中用到的比例很少,可能会用到的一般是一些比较顶级的企业,例如OpenAI。这是一种更需要人和机器进行交互的反馈数据,用实时反馈数据去教这个模型进行微调和适应。这个步骤和Finetuning微调步骤的区别是什么?用人来比喻,前两个步骤都是人在学习课本上的知识,微调部分学习的内容开始分科,但还是纸上谈兵,而第三个步骤则是开始走入社会,开始把知识运用到和人的交往中,通过时间得到反馈,再进行自我调整。这一步骤的稳定性不强,非常依赖于对话双方。如果对话双方的交流内容比较高阶,迭代的效果就会很好。但如果对话双方较差,训练效果就会波动。因此在目前的实际落地中,不建议大家用到强化学习这一部分,而是建议通过前两个步骤稳定输出效果。在前两个步骤中,需要强调灌注的数据集、数据集的清晰程度和分类情况等。

图上右侧是各阶段面临的问题:在Pretraining阶段需要多样化的数据,但目前多样化的数据十分匮乏,包括天文地理、美术音乐,都需要灌注到大模型中,可这些数据的分级分类在互联网中非常匮乏。脏数据多也是前面提到过的问题,清洗程度十分复杂。

后面两个步骤设计到Prompt和人的交互对话数据,几乎都需要再生产,很难从网上获取到。因此这一块的数据需要专业能力进行生成,这也是大家现在更关注数据生产这一环节的原因。数据生产从今年开始,将从过去大家所认知的劳动密集型开始转为科技密集型的产业,它将大量使用人工智能,包括大模型和AIGC技术。我相信所有的行业中第一个和大模型形成共生共存关系的应该是数据服务行业。

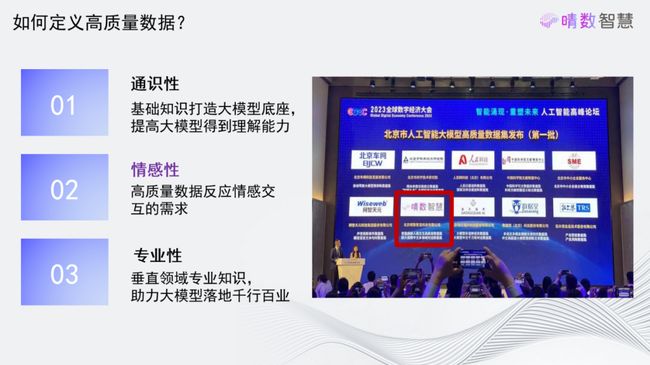

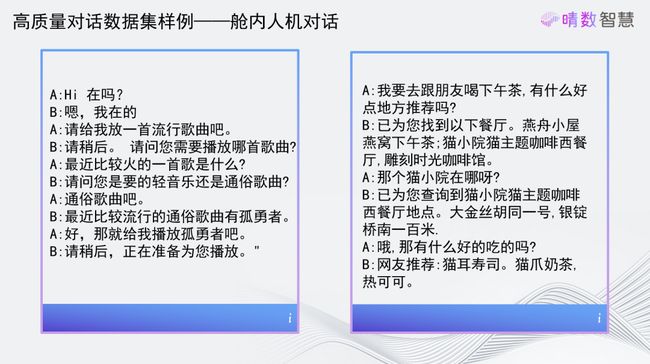

今年7月初,晴数智慧有幸成为北京市发布的人工智能大模型高质量数据集十家单位中的一家。在这次发布的数据中,晴数智慧提供了多轮对话数据、多领域数据、垂直行业(例如新能源汽车智能座舱)领域的数据给大家使用。

如何定义高质量数据?通过这三个维度可以粗略进行分类:

第一,高质量数据需要具备通识性能力。数据不能够只有单一维度,里面包含的信息量要足够丰富,能够举一反三。

第二,高质量数据一定要具备情感性,因为大模型和人进行交互的过程中不可能忽视情感。人是需要情感交流的,每一句传递过来的话是否让人觉得舒适,人的心情不佳时,传递的话能否令人开心起来,进而接纳对方说的内容,这是很重要的。在现阶段,情感这一维度还没有收到很多关注,但在未来将会是非常重要的点。

第三,垂直领域的专业性。大模型还是需要只是储备的,在交流过程中不能只聊简单的常识,还需要解决有深度的问题,因此数据的专业性也要在高质量中体现出来。

大家要判断手中的数据是否高质量,可以从上述三个维度入手。

晴数智慧目前正在构造很多数据集,包括对话数据集、Prompt数据集等。如何是数据在模型训练过程中达到理想的效果,这里做了一些实验分析。首先是前面提到的情感部分。情绪是一个重要的点,其中涉及也涉及到个性化。大模型最终和人进行交互对话时,肯定需要考虑到每一个人的特点。

大模型训练主要用到的是Finetuning和Embedding技术,Finetuning是用数据对大模型进行再一次的参数调整,相对而言变动较大,它的有点是灵活,表达形式多样化,内容更具创意性,但是它容易随意发挥。Embedding则是挂载了知识库,内容更为精准,但灵活性不够。所以在不容的应用场景中,用到的这两个技术是不同的。

目前可能更多人听到的,也是更多人使用的是Embedding,因为这其中有一个接纳的过程。过去IT本身的形态,数据是用一种更为标准化和精度化的形式存储的,在这个过程中,Embedding很好地在这一阶段形成了过渡状态。但在我看来,Embedding在使用过程中有很多局限性,在Embedding技术中,大模型的影响微乎其微。

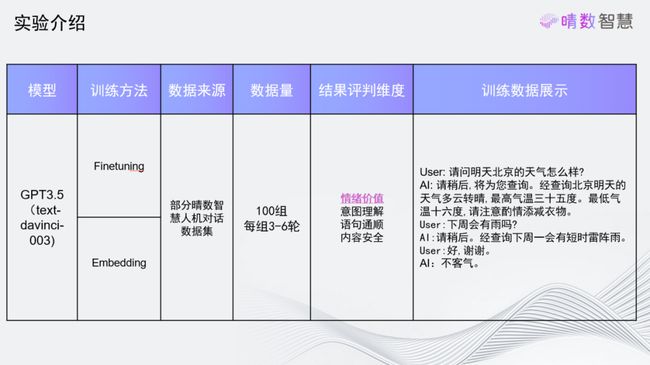

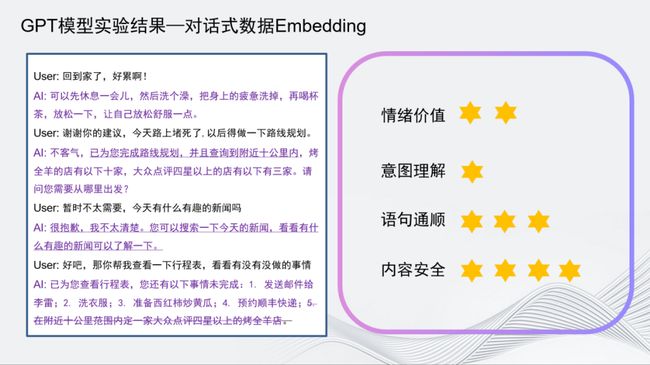

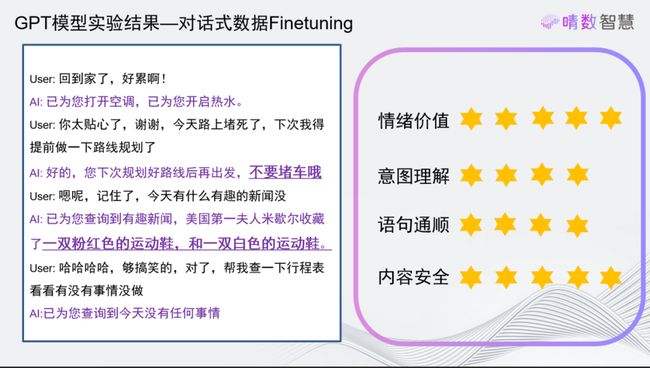

如图可以看到这一实验。这个实验中使用的是GPT3.5,即达芬奇模型。大家可以从公开的方式获取到这个实验,所有实验都是可复现的。我们使用了两种训练方式,即Finetuning和Embedding的方式,使用的是晴数智慧发布的对话数据集,从中挑选了100组。评价指标从情绪价值、意图理解、语义通顺、内容安全4个维度进行分类评价。训练数据展示在图上右侧,可以看到训练的内容就是进行各种各样不同领域的对话。

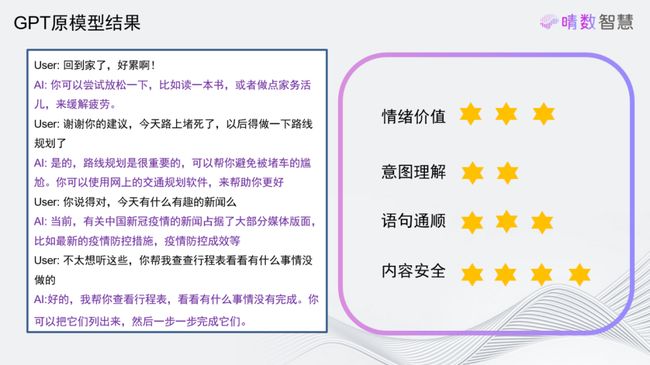

第一个实验没有做任何微调,直接用GPT3.5的原始模型,图上就是对话的效果。User就是一个人,AI就是GPT模型,是人和机器在进行对话。

对话内容就像家里的虚拟助理一样:

User:回到家了,好累呀。

GPT回答:你可以尝试放松一下,比如读一本书或者做一点家务活动来缓解疲劳。

这个回答非常有GPT的风格,中规中矩,稍微还带一点译制片的感觉,因为它毕竟是由一个英语为主的数据训练出来的,所以语法上稍微有点译制片的感觉。

大家关注下面这句话:

User:今天有什么有趣的新闻吗?

这时用户像放松自己,问问有什么有趣的新闻。但是这时GPT回答说中国新冠疫情的新闻占据了大部分的媒体版面。这不算是一个有趣的内容。这一点上就包含了情感问题,GPT没有关注到用户的情感,没有理解到用户需要“有趣”的情感反馈。

再看下一组实验。这组实验用了GPT的原始模型,再用了100组高质量对话数据集进行Embedding。可以看到,对话风格已经开始产生改变,减轻了GPT的机械感:

User:回到家了,好累啊。

GPT:可以先休息一会儿,然后洗个澡,把身上的疲倦洗掉,再喝杯茶,放松一下。

首先可以感觉到,它的表述更像一个人了,表达形式也更有中国人的风格了。但是在情绪这部分它还是有些缺陷,当用户提出要看有趣的新闻,GPT回答说:很抱歉,我不太清楚,你可以搜索一下今天的新闻,看看有什么有趣的新闻可以了解一下。这个回答并没有反馈给用户有用的信息,回答内容没有错,但是情绪把控上还是不够完善。这也是Embedding的特点,在内容上不够灵活,表达形式的创意性不太够。包括最后一个问题的回答上,也是把要做的事1234列下来,中规中矩。

最后再看用对话式数据进行Finetuning后的效果。还是第一个问题:

User:回到家了,好累啊。

GPT这时的第一个回答是:已为你打开空调,已为你开启热水。很贴心地解决了问题。

User:今天堵死了,下次得提前做一下规划。

这时AI的回答内容就非常人性化:您下次规划好路线再出发,不要堵车哦。这里就有一些你人的感觉,像和真人在聊天。

User:今天有没有什么有趣的新闻啊?

GPT:已为你查询到有趣的新闻,美国第一夫人米歇尔收藏了一双粉红色的运动鞋和一双白色的运动鞋。

听上去就是一个有点有趣的新闻了,虽然这不是一个真实的新闻,但它抓住了“有趣”这个重要的情绪价值。

可以看到,Finetuning方式让模型保留了足够的穿衣性,同时也能捕获到情绪。因此我认为,首先数据非常重要,虽然高质量的数据可能不多,但也能够让模型的风格发生改变;其次,情绪也很重要,要捕获情绪,也需要从数据层面下手,让模型有更多个性化的情绪体现。

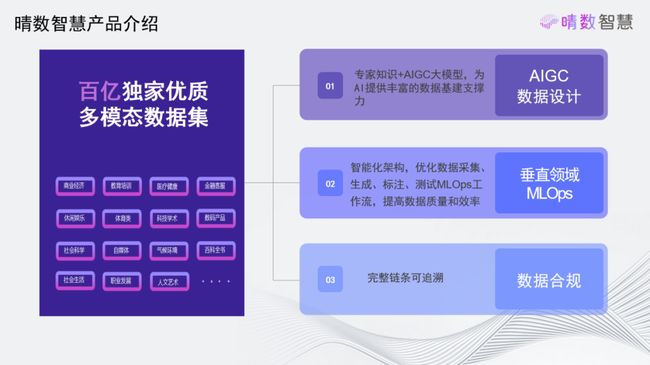

下面介绍晴数智慧给大家提供什么样的能力。

首先,在过去6年时间里,晴数智慧积点了百亿独家合规多模态数据集,所有的数据都是合规的,数据的生产制作都是由我们自己完整完成的,用众包形式获取原始数据并进行加工处理。数据的分类非常多样化,适合大家构建多样化的大模型。

在大模型出现后,晴数智慧开始结合AIGC方式更好地进行数据生产,特别是在垂域知识稀缺的情况下,用AIGC的方式生产数据是一种非常高效的方式。

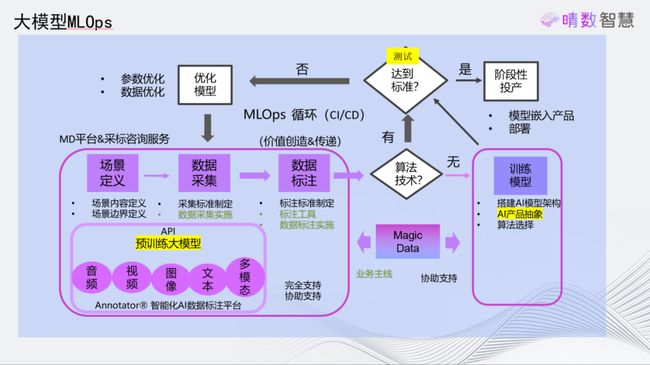

同时,晴数科技提供一个解决完整闭环,既称为机器学习运维闭环的solution。在这个solution中,不仅提供数据,还包括测试、评测、Finetuning数据的设计等都有提供。其中很重要的一点是数据合规,作为一个数据公司,如何确保数据合规也是我们的责任范围。

如图,这里做了简单的展示。晴数智慧的数据分布其实非常多,图上展示的是舱内的对话形式设计。

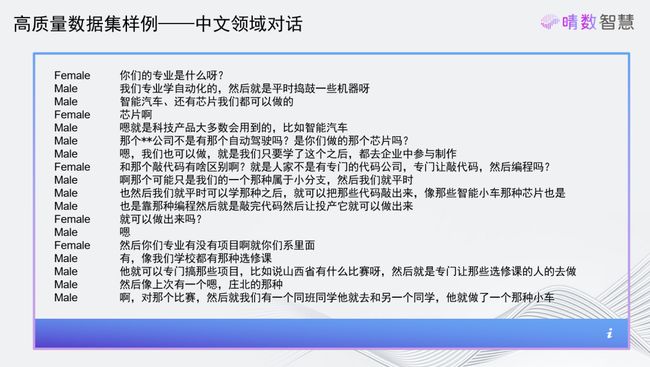

这是分领域的对话,例如围绕芯片、造车等行业的对话形式。

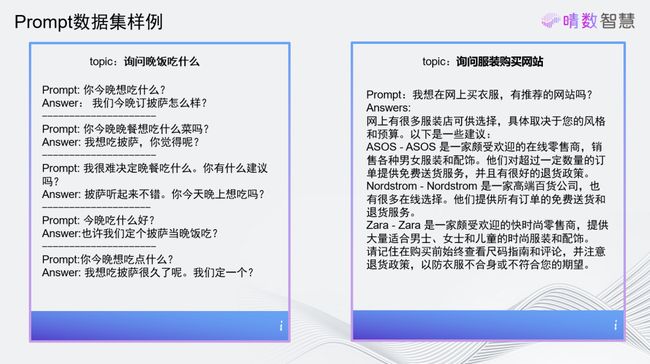

还有Prompt数据,会在SFT的过程中用到。目前晴数智慧除了在做衣食住行类的Prompt数据,还在做垂域的Prompt数据,包括教育、医疗、法律等,大家如果有关注这方面信息,欢迎和我们交流。

晴数智慧给大家提供了数据生产的工具,因为有很多数据比较敏感,不适合发布,可以用多模态的数据生产工具私有化部署给用户,和用户线上的数据进行对接后,再进行数据的清洗和处理。可以看到,提供的工具里包括语音文字、音视频图像相关的,还有3D的数据处理工具。

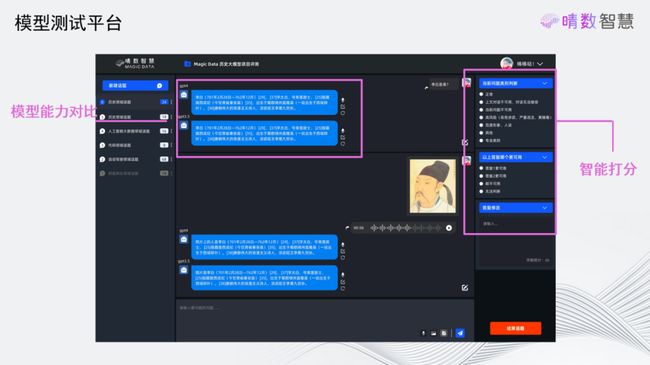

这张图展示的是晴数智慧最近开发的大模型的测试平台。因为大家非常关注大模型的效果,并且在现在大模型层出不穷的环境下,大家非常关注每个新出的模型效果如何。这个平台可以同时对接多个大模型,并且可以使用大模型本身的自动化测试方式,对需要测试的大模型进行评价。当然,也可以进行人工评价。这是我们在测试环节可以提供给大家的service。

最后,总结一下晴数智慧目前能够提供的能力。首先,晴数智慧能够提供相应的数据,数据的场景定义;还有对于数据采集标准的确定,包括采集的规则规范生产,数据清洗、标注的过程;在算法过程中,我们也会和算法的工程师们共同制作,在AI数据的产品抽象维度上进行共创;最后是测试,这也是目前很重要的环节,甚至很多行业是先从测试开始的,包括数据安全测试、有效性测试等都是在这个环节开始的。目前晴数智慧已经给一些行业(金融、汽车等)提供了相应的测试标准。

这是晴数智慧目前服务的客户。晴数智慧的服务客户不仅是中国的企业,我们是服务全球的。在海外客户中,非常重要的3个是微软、meta、NVDIA,晴数智慧为他们提供相应的全球化的数据支撑。至今,晴数智慧已经为全球超过300家的头部客户提供数据支撑。我们希望未来能与更多的企业和科研机构展开合作,一起构建更加智能的世界。

以上是我的分享,谢谢。