Visp_ros学习笔记(二):在Gazebo环境下实现Pionner3dx移动机器人视觉伺服仿真

开发环境:Unbuntu 18.04 LTS + ROS Melodic + ViSP 3.3.1

本文主要介绍了如何实现Pionner3dx移动机器人视觉伺服仿真,仿真环境是ROS+Gazebo,控制对象是Pioneer3dx(先锋)移动机器人,控制算法借助visp_ros工具实现。视觉伺服控制部分主要参考了visp_ros中的例程tutorial-ros-pioneer-visual-servo.cpp,但由于原本的例程是需要对真实的pionner机器人进行控制,对于没有pionner机器人的同学而言就无法使用了,所以我借助gazebo仿真工具,通过仿真的方法创建一个虚拟的pionner机器人并通过ros实现对机器人的运动控制。整个工程项目我已经上传至github:https://github.com/EmptyCity1995/visual_servo

首先通过一个视频,简单的演示一下视觉伺服控制的效果。

视觉伺服仿真效果演示

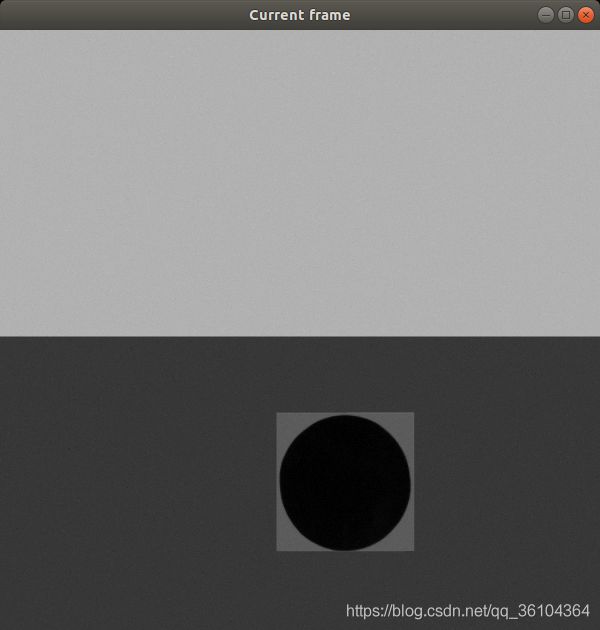

可以看到随着目标物体的移动,机器人会自动调整自己的位姿以保证目标始终处于相机的中心。在机器人相机视角观察的效果是这样的,一开始目标物体偏离相机视野中心位置

经过视觉伺服控制机器人运动之后,目标物体回到相机视野中心,绿色线条表示视野中心,红色十字表示目标物体的中心。

下面介绍整个工程实现方法,文件结构如下所示

visual_servo/

├── ar_tags

│ ├── blend

│ ├── images

│ ├── model

│ │ └── marker0

│ │ ├── materials

│ │ │ └── textures

│ │ └── meshes

│ └── scripts

├── include

│ └── visual_servo

├── launch

├── src

├── urdf

└── world

ar_tags是一个用于在gazebo中生成目标模型的脚本工具,原作的项目连接如下https://github.com/mikaelarguedas/gazebo_models;include中包含了项目需要的头文件;launch中包含了用于加载gazebo仿真环境的launch文件;src中包含了视觉伺服程序文件;urdf中包含了pionner3dx机器人模型文件,原作的项目连接如下https://gitee.com/navigation_planning/pioneer_simulator;world中包含了gazebo仿真环境文件;

首先需要配置环境,本项目的开发环境为Ubuntu18.04 + ROS Melodic + Visp_ros,所以要把必要的工具包都安装好,关于ViSP,visp_version, visp_ros的安装方法可参见这篇博客:Ubuntu18.04环境下visp、visp_ros、vision_visp手动安装完整指南 。

然后就是下载本文的工程文件了,需要将本工程放到ROS的工作空间中

cd ~/catkin_ws/src

git clone git://github.com/EmptyCity1995/visual_servo.git

git clone https://gitee.com/navigation_planning/pioneer_simulator.git

sudo apt install ros-melodic-p2os-urdf

sudo apt install ros-melodic-gazebo-plugins

sudo apt install ros-melodic-gazebo-ros-control

编译一下

cd ~/catkin_ws

catkin_make

source ./devel/setup.bash

利用ar_tags工具创建一个目标模型用于视觉伺服

cd ~/catkin_ws/src/visual_servo/ar_tags/scripts

./generate_markers_model.py -i ../images/

此时在gazebo模型库中会增加一个名为target的模型,路径为~/.gazebo/models/target,生成好模型文件后,我们不着急添加,先把机器人模型加载到仿真环境中

roslaunch visual_servo gazebo_pioneer_amcl.launch

此时程序会自动打开gazebo仿真环境,并添加一个机器人进去

我们可以通过insert添加我们的目标模型

cd ~/catkin_ws/src/visual_servo/src/

mkdir -p build

cd build

cmake ..

make

./tutorial-ros-pioneer-visual-servo

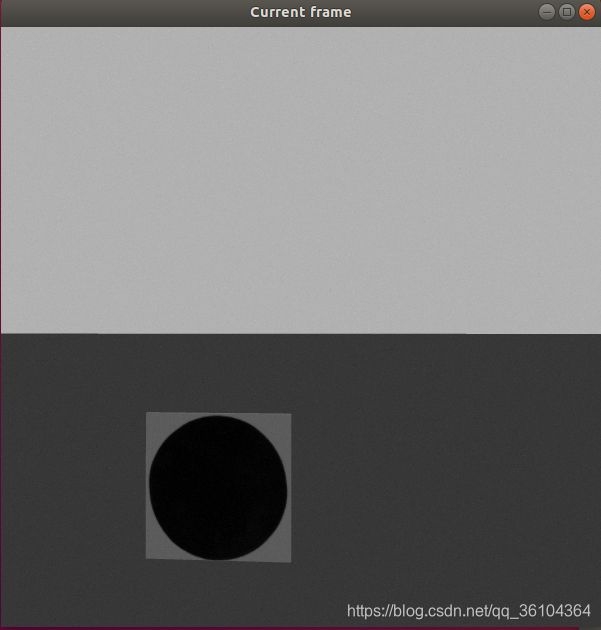

此时屏幕中会出现一个窗口,显示了机器人自带相机所捕捉到的画面

我们用鼠标点击目标模型中的黑色圆圈部分,用于选中视觉伺服的跟踪目标,并开始视觉伺服。小车会自动移动,最终是的目标物体处于相机视野的中央位置

在gazebo环境中移动目标物体,可以发现小车也会跟随目标移动。因为只使用了一个目标点(圆形区域的中心)所以只能对X方向进行约束,视觉伺服效果并不能达到很好,本项目旨在演示视觉伺服的效果和visp_ros+gazebo联合仿真的方法。最后介绍一下视觉伺服控制程序

#include 如果大家对于深度学习与计算机视觉领域感兴趣,希望获得更多的知识分享与最新的论文解读,欢迎关注我的个人公众号“深视”。