亚马逊云科技大语言模型下的六大创新应用功能

目录

前言

亚马逊云科技的AI创新应用

编辑

Amazon CodeWhisperer

Amazon CodeWhisperer产品的优势

更快地完成更多工作

自信地进行编码

增强代码安全性

使用收藏夹工具

自定义 CodeWhisperer 以获得更好的建议

如何使用Amazon CodeWhisperer

步骤 1

步骤 2

具体使用视频教程网址

Amazon SageMaker Neo

工作原理

优势之处

主要功能

Amazon Bedrock

工作原理

从一系列领先的基础模型中践行选择

构建能够动态调用API来执行的复杂业务任务的代理

通过将FM连接到公司特定的数据来源,使用RAG扩展FM的功能

支持数据安全性和合规性标准

优势之处

为什么选择 Amazon Bedrock?

Amazon OpenSearch Serverless

优势之处

使用案例

Amazon QuickSight

主要功能

为所有人构建

Amazon HealthScribe

AWS Health 服务

AWS 医疗保与和生命科学行业解决方案

AWS 医疗保健与生命科学解决方案计划

AWS 助力医疗保健与生命科学

前言

伴随着ChatGPT的横空出世,生成式AI(Artificial Intelligence Generated Content,也称AIGC)大潮也以锐不可当之势席卷全球。从各行各业的商业领袖,到千千万万的程序员和开发者,都在思考如何借助生成式AI技术来提高工作效率,推动业务创新,赢得竞争优势。

亚马逊云科技的AI创新应用

亚马逊云科技在人工智能和机器学习领域深耕20余年,在全球积累了超10万家客户。在实践中,亚马逊云科技致力于凭借自身产品和技术优势不断探索突破,以AI之力智启行业发展新动力。

Amazon CodeWhisperer

Amazon CodeWhisperer产品的优势

更快地完成更多工作

CodeWhisperer 经过数十亿行代码的训练,可以根据您的评论和现有代码实时生成从代码片段到全函数的代码建议。绕过耗时的编码任务,加速使用不熟悉的 API 进行的构建。

自信地进行编码

CodeWhisperer 可以标记或筛选类似于开源训练数据的代码建议。获取相关开源项目的存储库 URL 和许可证,以便您可以更轻松地查看它们并添加归因。

增强代码安全性

扫描您的代码以检测难以发现的漏洞,并获取代码建议以立即修复这些漏洞。遵循跟踪安全漏洞的最佳实践,例如开放全球应用程序安全项目 (OWASP) 概述的漏洞,或者不符合加密库最佳实践及其他类似安全最佳实践的漏洞。

使用收藏夹工具

CodeWhisperer 符合您的工作方式。从 15 种编程语言中进行选择,包括 Python、Java 和 JavaScript,以及您最喜欢的集成式开发环境(IDE),包括 VS Code、IntelliJ IDEA、AWS Cloud9、AWS Lambda 控制台、JupyterLab 和 Amazon SageMaker Studio。

自定义 CodeWhisperer 以获得更好的建议

您可以自定义 CodeWhisperer,使其了解您的内部库、API、包、类和方法,从而生成更相关的建议,显著加快开发速度。

如何使用Amazon CodeWhisperer

步骤 1

在您的集成式开发环境(IDE)中安装最新的 AWS 工具包插件。支持的 IDE 包括 Visual Studio(VS)Code 和 JetBrains IDE(IntelliJ、PyCharm、CLion、GoLand、WebStorm、Rider、PhpStorm、RubyMine 和 DataGrip)安装最新的 CodeWhisperer 扩展。CodeWhisperer 内置了 AWS Cloud9 和 AWS Lambda 控制台。

步骤 2

对于 VS Code 和 JetBrains IDE,打开 AWS 扩展面板,然后在开发人员工具 > CodeWhisperer 下选择“开始”按钮。在出现的弹出窗口中,选择“使用构建者 ID 登录”选项。使用您的电子邮件地址注册并使用您的 AWS 构建者 ID 登录。

具体使用视频教程网址

AI 代码生成器 - Amazon CodeWhisperer 资源 - AWS使用我们在 AWS 上提供的大量资源,收集与 Amazon CodeWhisperer 相关的更多信息。![]() https://aws.amazon.com/cn/codewhisperer/resources/#Getting_started

https://aws.amazon.com/cn/codewhisperer/resources/#Getting_started

Amazon SageMaker Neo

Amazon SageMaker Neo 使开发人员能够优化机器学习 (ML) 模型,以便在云中的 SageMaker 和 边缘的支持设备上进行推理。

ML 推理是使用经训练的机器学习模型进行预测的过程。在对模型进行高精度训练之后,开发人员通常会花费大量时间和精力来调整模型以实现高性能。在云中推理时,开发人员经常以较高成本转向内存高和处理能力强的大型实例,以实现更好的吞吐量。为了在计算和内存有限的边缘设备上进行推理,开发人员通常花费数月时间手动调优模型,以在设备硬件限制内实现可接受的性能。

Amazon SageMaker Neo 会自动优化机器学习模型,以便在云实例和边缘设备上进行推理,从而以更快的速度运行而不会损失准确性。首先,选择一个已使用 DarkNet、Keras、MXNet、PyTorch、TensorFlow、TensorFlow-Lite、ONNX 或 XGBoost 构建并在 Amazon SageMaker 中或其他任何地方训练过的机器学习模型。 然后,选择目标硬件平台,该平台可以是 SageMaker 托管实例,也可以是基于 Ambarella、Apple、ARM、Intel、MediaTek、Nvidia、NXP、Qualcomm、RockChip 或 Texas Instruments 处理器的边缘设备。只需单击一下,SageMaker Neo 即可优化训练后的模型并将其编译为可执行文件。编译器使用机器学习模型来应用性能优化,从而为您的模型在云实例或边缘设备上提取最佳可用性能。然后,您可以将模型部署为 SageMaker 终端节点或部署在支持的边缘设备上,并开始进行预测。

在云中推理时,SageMaker Neo 通过在SageMaker 托管中创建推理优化容器来加快推理速度并节省成本。在边缘推理时,SageMaker Neo 通过自动调优所选操作系统和处理器硬件的模型,为开发人员节省数月的手动调优时间。

Amazon SageMaker Neo 使用 Apache TVM 和合作伙伴提供的编译器和加速库为给定模型和硬件目标提供最佳可用性能。根据 Apache 软件许可,AWS 将编译器代码贡献给 Apache TVM 项目,将运行时代码贡献给 Neo-AI 开源项目,以使处理器供应商和设备制造商在通用的紧凑运行时上快速创新。

工作原理

优势之处

-

提升性能高达 25 倍

Amazon SageMaker Neo 可自动优化机器学习模型,可提高处理速度高达 25 倍,同时不会影响准确性。SageMaker Neo 使用最适合您的模型和目标硬件平台的工具链,同时提供用于模型编译的简单标准 API。

-

不到 1/10 的运行时轨迹

Amazon SageMaker Neo 运行时仅消耗相当于TensorFlow 或 PyTorch 等深度学习框架 1/10 的轨迹。无需将框架安装在目标硬件上,而是将紧凑型 Neo 运行时库加载到 ML 应用程序中。与 TensorFlow-Lite 之类的紧凑框架不同,Neo 运行时可以运行在 Neo 编译器所支持的任何框架中训练的模型。

-

更快的生产时间

只需在 Amazon SageMaker 控制台中单击几下,Amazon SageMaker Neo 即可轻松准备模型,在几乎任何硬件平台上部署。您可以毫不费力地获得手动调优的所有优势。

主要功能

- 优化推理而不会影响准确性

Amazon SageMaker Neo 在机器学习编译器中使用研究主导的技术,针对目标硬件优化模型。SageMaker Neo 自动应用这些系统的优化技术,可在不降低准确性的情况下加快模型的速度。

- 支持常用的机器学习框架

Amazon SageMaker Neo 将模型从 DarkNet、Keras、MXNet、PyTorch、TensorFlow、TensorFlow-Lite、ONNX 或 XGBoost 等特定于框架的格式转换为通用表示形式,优化计算并为目标 SageMaker 托管实例或边缘设备生成硬件特定的可执行文件。

- 通过标准 API 提供紧凑的运行时

Amazon SageMaker Neo 运行时占用 1MB 的存储空间和 2MB 的内存,比框架的存储和内存占用空间小许多倍,同时提供一个简单的通用 API 来运行源自任何框架的已编译模型。

- 支持常用的目标平台

Android、Linux 和 Windows 操作系统以及 Ambarella、ARM、Intel、Nvidia、NXP、Qualcomm 和 Texas Instruments 的处理器上均支持 Amazon SageMaker Neo 运行时。SageMaker Neo 还可以将 PyTorch 和 TensorFlow 模型转换为 Core ML 格式,以便在 Apple 设备上的 macOS、iOS、iPadOS、watchOS 和 tvOS 上进行部署。

- 针对 Amazon SageMaker 托管实例的推理优化容器

在云中推理时,Amazon SageMaker Neo 提供推理优化容器,其中包括与 Neo 运行时集成的MXNet、PyTorch 和 TensorFlow。之前,SageMaker Neo 可能无法编译使用不受支持运算符的模型。现在,SageMaker Neo 优化了每个模型,也就是说,编译器支持模型中的运算符,并使用该框架运行未编译模型的其余部分。因此,您可以在推理优化容器中运行任何MXNet、PyTorch 或 TensorFlow 模型,同时获得可编译模型的更好性能。

- 异构硬件的模型分区

Amazon SageMaker Neo 利用合作伙伴提供的加速器库为具有硬件加速器和 CPU 的异构硬件平台上的深度学习模型提供最佳可用性能。Ambarella CV Tools、Nvidia Tensor RT 和 Texas Instruments TIDL 等加速库均支持一组特定的功能和运算符。SageMaker Neo 会自动对模型进行分区,以便具有加速器支持的运算符的零件可以在加速器上运行,而其余模型则在 CPU 上运行。通过这种方式,SageMaker Neo 充分利用了硬件加速器,增加了可在硬件上运行的模型类型,同时提高了模型的性能,也就是说,加速器支持其运算符。

- 支持 Amazon SageMaker INF1 实例

Amazon SageMaker Neo 现在可以为 Amazon SageMaker INF1 实例目标编译模型。SageMaker 托管为基于 INF1 实例(基于 AWS Inferentia 芯片)的推理提供托管服务。SageMaker Neo 使用幕后原理的 Inferentia 处理器专用 Neuron 编译器,同时提供标准模型编译API,从而简化了准备在 SageMaker INF1 实例上部署模型的任务,同时提供 INF1 实例的最佳可用性能和成本节约优势。

Amazon Bedrock

AWS全面扩展了其全托管基础模型服务Amazon Bedrock,包括新增Cohere作为基础模型供应商,加入Anthropic和Stability AI的最新基础模型,并发布了新功能Amazon Bedrock代理。

Cohere可用于开发企业AI平台和前沿基础模型,其基础模型可以更直观地生成、检索和汇总信息。AI公司Anthropic最新的语言模型Claude 2已经接入到Amazon Bedrock。Stability AI则计划在Amazon Bedrock上发布其最新版的文生图模型套件Stable Diffusion XL 1.0 (SDXL 1.0)。

Amazon Bedrock代理功能可以帮助开发者创建全托管的人工智能代理(AI Agents),帮助企业加速交付生成式AI应用程序。这些应用程序可以通过对公司系统进行API调用来管理和执行任务。Amazon Bedrock代理功能可以扩展基础模型以理解用户请求,将复杂任务分解成多个步骤,通过对话收集更多信息,并采取行动来满足用户请求。借助Amazon Bedrock代理功能,应用可以为内部或外部客户自动执行任务,比如管理零售订单、处理保险索赔等。服务电商的生成式AI应用程序不仅能回答简单问题,还能帮助用户完成更新订单、管理交易等复杂任务。

工作原理

从一系列领先的基础模型中践行选择

-

从多种基础模型中进行选择

您可以访问来自 Amazon 和其他领先人工智能公司(例如 AI21 Labs、Anthropic、Cohere、Meta 和 Stability AI)的多种基础模型,并在试验环境中快速试验它们。这一系列基础模型包括 Amazon Titan、Jurassic-2、Claude 2、Command、Llama 2 和 Stable Diffusion XL,它们分别支持文本、嵌入和图像等不同模式。

-

专属定制基础模型

使用 Amazon Bedrock 控制台,无需编写代码,您就可以利用您的数据对模型进行微调,以完成公司的特定任务。只需选择存储在 Amazon Simple Storage Service(Amazon S3)中的训练和验证数据集,并在需要时调整超参数,即可实现可能的最佳模型性能。

-

单一 API

无论选择哪种模型,您都可以使用单一 API 进行推理。通过单一 API,您可以灵活地使用来自不同模型提供商的不同模型,并且只需对代码做出最少的更改,即可与最新的模型版本保持同步。

构建能够动态调用API来执行的复杂业务任务的代理

-

自动创建提示语

Amazon Bedrock 可根据开发者提供的指令(例如“你是专门处理未结理赔的保险代理人”)、完成任务所需的 API 架构,以及来自知识库(例如 Amazon OpenSearch 无服务器的向量引擎、Pinecone 和 Redis Enterprise Cloud)的公司数据来源详细信息创建提示语。在试验不同基础模型的提示语时,自动创建提示语可以为您节省数周时间。

-

编排计划

Amazon Bedrock 代理可将用户请求的任务分解为较小的子任务,从而做出周密安排,例如,对于“向所有具有待处理文件的保单持有人发送提醒”,它会将任务分解成:获取特定时间段的理赔,确定所需的文书工作,发送提醒。代理会确定正确的任务顺序,并处理中途出现的任何错误状况。

-

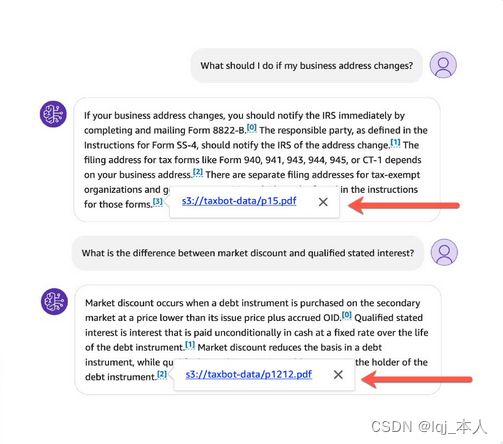

检索增强生成

Amazon Bedrock 代理可安全地连接到您公司的数据来源,自动将您的数据转换为数值形式,并使用相关信息增强用户请求,以生成更准确、更具相关性的回应。例如,如果用户询问理赔所需的文件,代理会从您选择的相应知识库(例如 Amazon OpenSearch 无服务器的向量引擎、Pinecone 或 Redis Enterprise Cloud)中查找信息,并提供正确的答案:“您需要驾照、汽车照片和事故报告。”

通过将FM连接到公司特定的数据来源,使用RAG扩展FM的功能

-

将基础模型连接到数据来源

借助 Amazon Bedrock 知识库,您可以将基础模型与组织的数据来源整合在一起,以提供更准确、更有关联性的回应。通过指定用于提取数据的数据来源 [如 Amazon Simple Storage Service(Amazon S3)]、用于将数据转换为向量格式的嵌入基础模型(如 Amazon Titan Embeddings),以及用于存储向量数据的目标向量数据库(如 Amazon OpenSearch 无服务器的向量引擎、Pinecone 和 Redis Enterprise Cloud),您可以快速添加知识库。

-

实现自动检测数据来源

利用知识库,Amazon Bedrock 代理可以识别相应的数据来源,然后根据用户输入检索相关信息,并将检索到的信息上下文整合到用户的查询中,以提供更准确的回应。

-

提供来源归属

从 Amazon Bedrock 知识库中检索到的所有信息都带有来源归属,可提高透明度,并最大程度地减少人工智能幻觉。

支持数据安全性和合规性标准

-

基于全面的数据保护和隐私保护构建

Amazon Bedrock 提供多种满足安全性和隐私性要求的功能,并兼容 GDPR 和 HIPAA 等常见合规标准。在 Amazon Bedrock 中,您的内容不会用于改进基本模型,也不会与第三方模型提供商共享。您可以将 Amazon PrivateLink 与 Amazon Bedrock 配合使用,在您的基础模型和本地网络之间建立私有连接,无需将流量暴露到互联网。

-

保护您的生成式人工智能应用程序

Amazon Bedrock 支持加密。无论是在传输过程中,还是在静态存储时,你的数据始终处于加密状态,您也可以使用密钥对数据加密。使用 Amazon Key Management Service(Amazon KMS)密钥,开发人员可以创建、拥有和管理加密密钥,从而完全控制如何加密用于自定义基础模型的数据。

-

实施治理和审计

Amazon Bedrock 提供全面的监控和日志记录功能,可为您的治理和审计需求提供支持。您可以使用 Amazon CloudWatch 跟踪使用情况指标,并构建带有审计所需指标的自定义仪表板。此外,在将其他系统集成到您的生成式人工智能应用程序时,您可以使用 Amazon CloudTrail 监控 API 活动并解决问题。您也可以选择将元数据、请求和响应存储在您的 Amazon Simple Storage Service(Amazon S3)桶中。 最后,为了防止潜在的滥用行为,Amazon Bedrock 实施了自动检测滥用机制。

优势之处

- 选择领先的基础模型

Amazon Bedrock 提供易于使用的开发者体验,可与来自 AI21 Labs、Anthropic、Cohere、Meta、Stability AI 和 Amazon 等领先人工智能公司的各种高性能 FM 合作。无论选择哪种模型,您都可以在操场上快速尝试各种 FM,并使用单个 API 进行推理,这样便可灵活使用来自不同提供商的 FM,并且只需最少的代码更改即可保持最新的模型版本。

- 利用开发者的数据自身定制

无需编写任何代码,即可通过可视化界面使用自己的数据私下自定义 FM。只需选择存储在 Amazon Simple Storage Service(Amazon S3)中的训练和验证数据集,并在需要时调整超参数即可实现可能的最佳模型性能。

- 可动态调整API来执行任务的完全托管代理

通过动态调用公司系统和 API,构建能够执行复杂业务任务(从预订旅行和处理保险索赔到制作广告活动、准备纳税申报和管理库存)的代理。Amazon Bedrock 的完全托管代理扩展了 FM 的推理能力,可以分解任务、创建编排计划并执行该计划。

- 为RAG提供本机支持,利用专有数据扩展FM的能力

借助 Amazon Bedrock 知识库,您可以安全地将 FM 连接到您的数据来源,以便在托管服务中增强检索,从而扩展 FM 本已强大的功能,使其更了解您的特定领域和组织。

- 数据安全性和合规性认证

Amazon Bedrock 提供了多种支持安全和隐私要求的功能,已获得 HIPAA 资格并符合 GDPR 合规性。在 Amazon Bedrock 中,您的内容不会用于改进基本模型,也不会与第三方模型提供商共享。您在 Amazon Bedrock 中的数据在传输和静态时始终处于加密状态,您可以使用自己的密钥对数据进行加密。您可以将 AWS PrivateLink 与 Amazon Bedrock 配合使用,在 FM 和您的 Amazon Virtual Private Cloud(Amazon VPC)之间建立专用连接,而无需将流量暴露到互联网。

为什么选择 Amazon Bedrock?

Amazon Bedrock 是一项完全托管的服务,使用单个 API 提供来自 AI21 Labs、Anthropic、Cohere、Meta、Stability AI 和 Amazon 等领先人工智能公司的高性能基础模型(FM),以及构建生成式人工智能应用程序所需的一系列广泛功能,在维护隐私和安全的同时简化开发。借助 Amazon Bedrock 的全面功能,您可以轻松尝试各种热门 FM,使用微调和检索增强生成(RAG)等技术利用您的数据对其进行私人定制,并创建可执行复杂业务任务(从预订旅行和处理保险索赔到制作广告活动和管理库存)的托管代理,所有这些都无需编写任何代码。由于 Amazon Bedrock 是无服务器的,因此您无需管理任何基础设施,并且可以使用已经熟悉的 AWS 服务将生成式人工智能功能安全地集成和部署到您的应用程序中。

Amazon OpenSearch Serverless

Amazon OpenSearch Serverless 是 Amazon OpenSearch Service 中的无服务器选项。作为开发人员,您可以使用 OpenSearch Serverless 运行 PB 级工作负载,而无需配置、管理和扩展 OpenSearch 集群。您可以获得如同 OpenSearch Service 的交互式毫秒级响应时间,同时获享无服务器环境的简易性。

优势之处

- 数秒内即可开始

使用熟悉的开源摄取和管道,而无需更改应用程序。

-

按需扩展

OpenSearch 无服务器可以自动预置并持续调整,以在使用模式和需求不断变化时快速摄取数据并在数毫秒内做出响应。

-

降低成本

自动扩展资源来为应用程序提供所需的容量,仅按实际用量付费,而不会影响数据摄取。

-

存储和搜索矢量嵌入

通过简单、可扩展且高性能的矢量搜索为您的生成式人工智能(AI)应用程序提供支持。

使用案例

-

通过可变工作负载实现灵活性

无缝扩展应用程序资源,而无需预先配置所需的计算能力和内存。

-

符合敏感服务水平协议(SLA)

预初始化应用程序资源并在数秒内实现响应时间。

-

创建开发和测试环境

快速创建开发和测试环境,根据不可预测的使用情况自动扩展,并缩短产品上市时间。

-

构建 ML 增强型搜索体验

通过托管矢量和文本搜索来生成更精确、更准确的搜索结果,为生成式人工智能应用程序提供支持。

Amazon QuickSight

Amazon QuickSight 允许您的企业中的所有人通过使用自然语言提问以了解您的数据,通过交互式控制面板探索,或自动查找由机器学习支持的模式和异常值。

QuickSight 每周为客户提供数百万计控制面板视图支持,允许其最终用户制定更完善的数据驱动型决策。

主要功能

-

使用 QuickSight Q 为所有人启用 BI

询问有关数据的对话式问题并使用 Q 的机器学习 (ML) 支持的引擎以获得相关的可视化,无需作者和管理员进行耗时的数据准备。

-

使用 ML Insights 执行高级分析

发现您的数据的隐藏洞察,执行准确的预测和 what-if 分析,或通过利用 AWS 的机器学习专长向控制面板添加易于理解的自然语言叙述。

-

嵌入分析使您的应用程序脱颖而出

轻松将交互式可视化和控制面板、复杂的控制面板编写或自然语言查询功能嵌入到您的应用程序中,使用户体验脱颖而出并解锁新的盈利机会。

为所有人构建

- 企业的最终用户以自然语言询问有关数据的业务问题,并通过相关的可视化获得准确答案。QuickSight Q 使用机器学习来解读问题的意图,并分析正确的数据以快速提供准确的业务问题答案。

- 业务分析师可以在数分钟内无缝创建无服务器 Pixel-Perfect 控制面板——安全地连接到 Amazon S3 中的 PB 级数据并使用 Amazon Athena 查询,同时与 Amazon QuickSight 中数以万计的用户共享,全部无需任何客户端软件或服务器基础设施。

- 开发人员可以使用稳健的 AWS API 向应用程序中数十万计的用户部署和扩展嵌入式分析。 与企业的每位用户共享数据可视化和洞察,无论通过 Web、手机、电子邮件或嵌入式应用程序。

- 由于 QuickSight 自动扩展到工作负载,管理员可以提供一致的性能。QuickSight 每两周提供更新,确保所有用户拥有最新功能,传统 BI 解决方案不会出现任何停机、版本冲突或兼容性问题。QuickSight 也是首款提供按会话付费定价的 BI 服务,使大规模部署经济高效。

Amazon HealthScribe

AWS 医疗保健与生命科学行业解决方案

从手术台到病床,全面加速创新

医疗保健和生命科学组织正重新构想开展协作、作出数据驱动型临床和手术决策、支持精准医疗以及降低护理成本的方式。为帮助医疗保健和生命科学组织实现其商业和技术目标,AWS 医疗保健与生命科学行业解决方案提供了一系列 AWS 服务和 AWS 合作伙伴解决方案,并得到全球数以千计客户的运用。

AWS Health 服务

-

AWS HealthScribe

在应用程序中,通过分析患者与临床医生的对话自动生成临床笔记。

-

AWS HealthLake

提供个人或患者群体健康数据的完整视图。

-

AWS HealthImaging

在云中以 PB 级规模存储、转换和分析医学影像。

-

AWS HealthOmics

将基因组、转录组和其他组学数据转化为见解。

AWS 医疗保与和生命科学行业解决方案

-

医疗保健解决方案

利用专门构建的解决方案实现医疗保健行业的转型。

-

生命科学解决方案

发现可帮助您将疗法更快推向市场的生命科学解决方案。

-

基因组学解决方案

利用可解锁深刻洞察的基因组学解决方案实现突破。

AWS 医疗保健与生命科学解决方案计划

-

AWS Health 公平性计划

为选定组织提供 AWS 服务抵扣金和技术专业知识,以帮助它们解决影响世界各地卫生服务不足或代表性不足社区的卫生不公平问题。

-

AWS 诊断研发计划

为四个项目领域的选定组织提供 AWS 服务抵扣金和技术专业知识:早期疾病筛查、诊断、预后和公共卫生基因组学。

- AWS 医疗保健加速器

为期四周的技术、业务和辅导加速器机会,对寻求利用 AWS 帮助解决医疗保健行业所面临最重大挑战的医疗保健初创公司开放。

AWS 助力医疗保健与生命科学

- 专门构建的健康服务和解决方案

了解利用专门构建的服务和解决方案来降低成本、提高运营和临床效率,并最终改善患者护理的新方式,为各种规模的医疗保健和生命科学组织提供支持。

- 值得信赖的健康合作伙伴网络

利用行业领先的 AWS 合作伙伴组成的庞大网络,以及 AWS Marketplace 这一全面的第三方软件、服务和数据数字目录优势,让客户轻松在 AWS 上开始构建,从而实现更快的创新速度。

- 卫生与科技交汇领域的专家

与专门的医疗保健和生命科学行业专家团队合作,为企业的数字化转型和创新计划提供鼎力支持。AWS 卫生领域的专家平均拥有 18 年的从业经验。

- 行业领先的安全性和可靠性

利用 130 多种符合 HIPAA 要求的服务提高安全性并简化合规工作。AWS 让客户能够享受极致全球性云基础设施的规模优势和可靠性。