论文导读 | 融合大规模语言模型与知识图谱的推理方法

前 言

大规模语言模型在多种自然语言处理相关任务上展现了惊人的能力,如智能问答等,但是其推理能力尚未充分展现。本文首先介绍大模型进行推理的经典方法,然后进一步介绍知识图谱与大模型融合共同进行推理的工作。

文章一:使用思维链提示方法“召唤”大模型的推理能力

本文方法主要提出了一个提示词构建方法,通过大规模语言模型完成复杂的推理任务。大量实验表明本文所提方法能够显著提高大模型执行复杂推理的能力。该项工作动机是人在进行复杂任务推理时往往将问题分解为多步简单问题,逐步解决每个简单问题后即可推理得到复杂问题的最终答案。

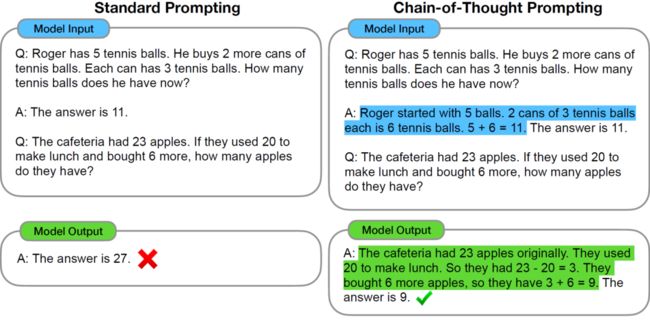

如下图例子中,左边是传统的提示词方法,首先给出一组问题样例及答案,然后给出问题,大模型输出内容即为最终答案。由于该数学问题较为复杂,大模型未能回答正确。不同于传统直接给出最终答案的提示词,右边图中的提示词在样例答案中给出了推理过程和最终答案(蓝色高亮),而大模型的回答同样给出了推理过程和正确答案。

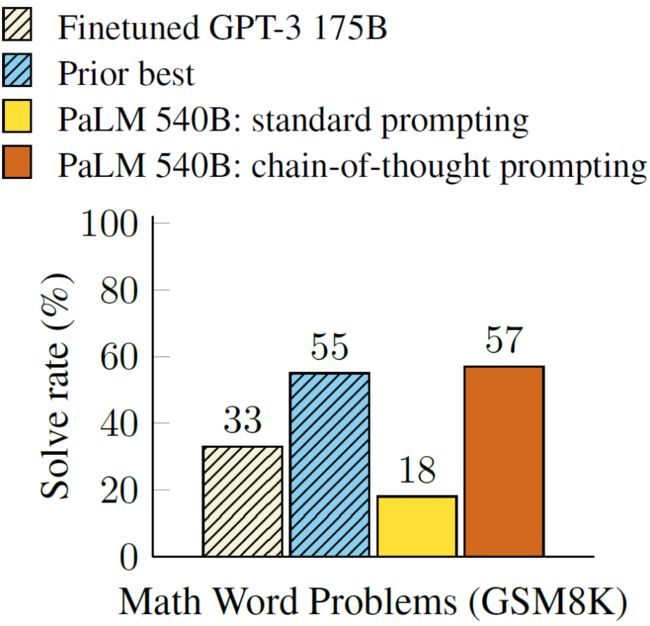

从实验结果可以看出,思维链提示方法(橙色)比传统提示方法(黄色)的解决率提高了三倍。

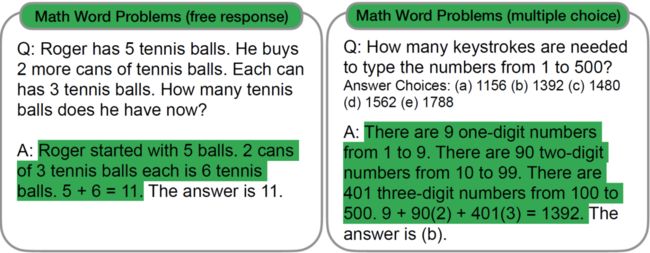

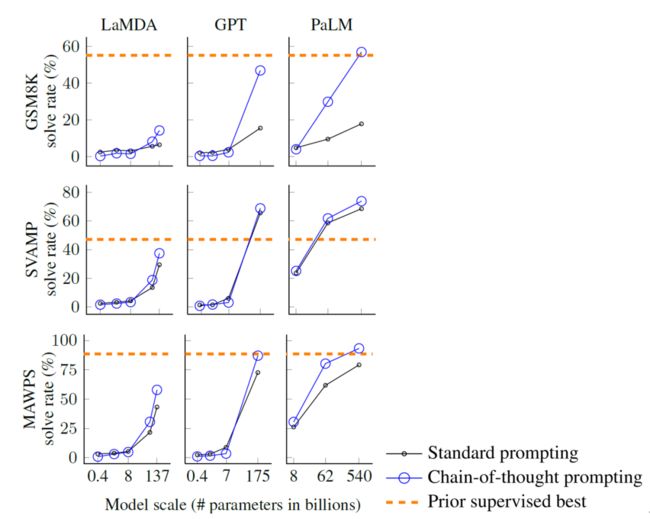

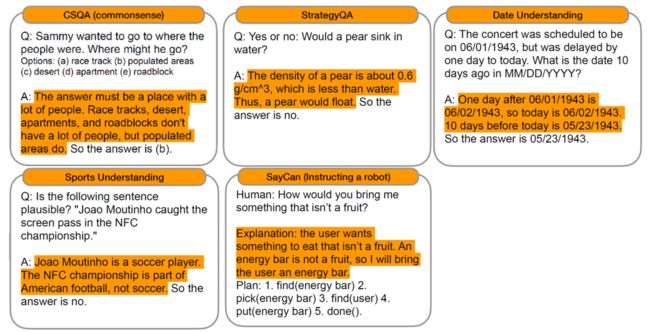

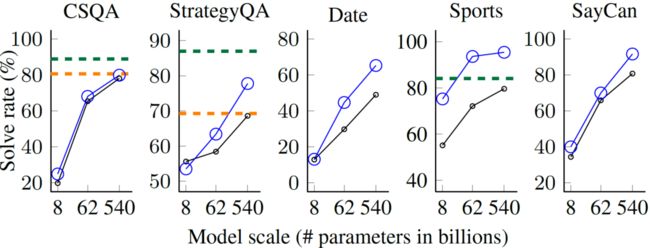

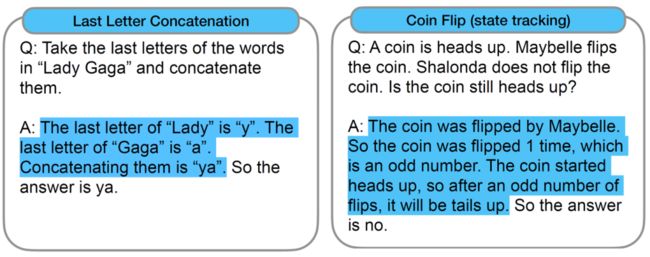

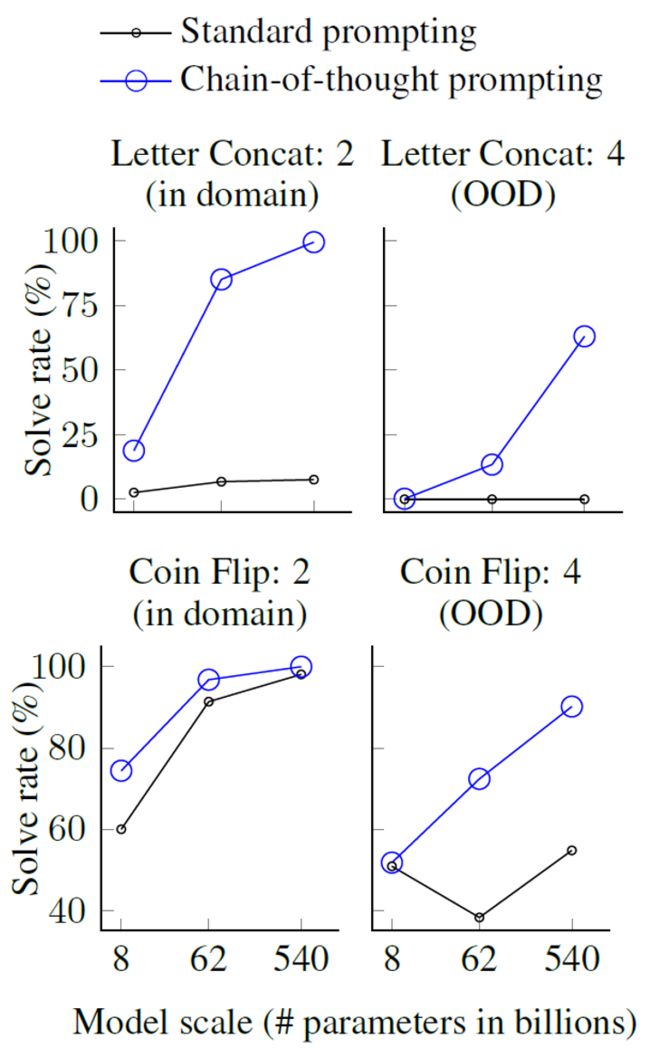

本文在数学推理、常识推理和符号推理三种任务上进行了广泛的测试,测试任务示例和结果见下图。

1. 数学推理问题

结果中蓝色圈点为本文所提方法,橙色虚线为有监督方法的最佳结果,可以看出在数学推理问题上,大模型在很多情况下都超过了有监督方法的表现。

2. 常识推理问题

结果中绿色虚线是人工推理结果,从中可以看出,在体育类常识推理任务上,大模型的推理能力甚至超越了人工表现。

3. 符号推理问题

从结果中可以看出,传统提示词方法下大模型基本不具备姓名尾字母缩写能力,而通过本文所提思维链提示方法,大模型在该任务的表现接近100%。

文章二:面向零样本知识图谱问答的知识增的强语言模型提示方法

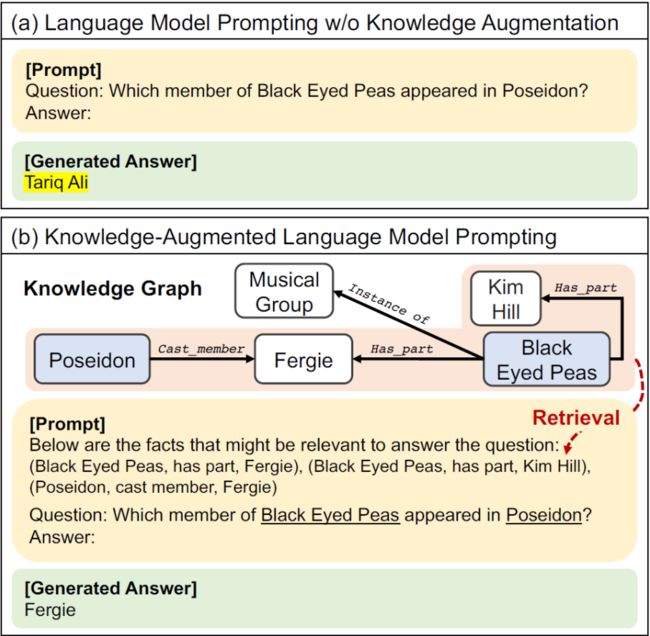

仅通过大规模语言模型进行问答可能包含过期数据等问题,而修改大模型的参数代价又较高,因此通过提示词方法向大模型注入准确的知识图谱数据可以使用大模型完成正确率更高的知识图谱问答。

本文提出了知识增强的大模型问答方法KAPING(Knowledge-Augmented language model PromptING),具体是从知识图谱中抽取相关的事实三元组,并将其作为提示信息输入到大模型。因此在这一方法中,如何抽取最相关的三元组是需要解决的主要问题。所提方法分为三个模块:知识获取-知识表达-知识注入。整体结构见下图。

1. 知识获取

知识获取的目标从给定问题中抽取相关的实体。例如问题“who is the author of Lady Susan?”中的相关实体为Lady Susan。本模块采用的方法为传统的实体链接方法。然而,该实体相关三元组可能规模较大,且并非所有都与问题相关。基于这一考虑,本文首先采用已有的句子表示模型,分别将三元组和问题映射到统一表示空间,选择前K个与问题语义最相似的三元组。

2. 知识表达

知识表达的目标是将三元组转化为文本形式的表示。本文方法中,直接将三元组表示为“(Lady Susan, written by, Jane Austen)”。

3. 知识注入

知识注入的目标是根据三元组和给定问题构建大模型提示词。构建方法为首先列出N个相关三元组,然后增加说明信息“Below are facts in the form of the triple meaningful to answer the question”。整体提示词示例见上图中黄色标识内容。

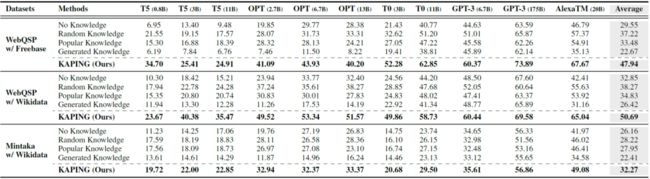

本文使用不同大模型在两个不同数据集上进行了大量实验,实验结果表明所提KAPING框架显著优于所有大模型的基线方法,且当大模型规模相对较小时,我们可以观察到更明显的性能改进。

文章三:基于知识图谱与大型语言模型的深度负责推理

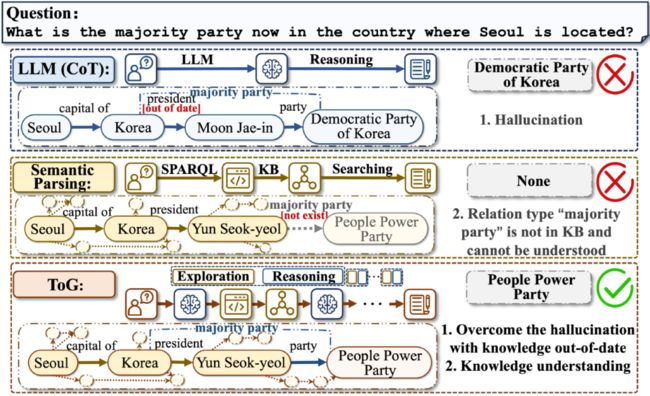

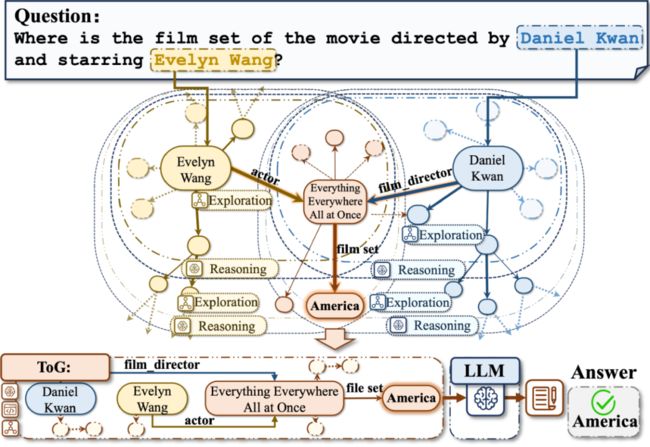

本文所提方法整体结构如下图所示(ToG),从给定问题出发,每一步推理都要经过扩展-推理的过程,每步推理都是基于问题通过大模型在知识图谱数据中搜索下一步推理的相关路径。在这一架构下,既可以避免大模型的数据过期问题,又可以增加模型推理结果的可解释性。

推理过程示例见下图。主要步骤为首先识别输入问题中的主题实体,然后利用大模型对外部知识图谱进行探索和推理,检索相关的路径。如此循环直到达到最大步数或得到推理答案。

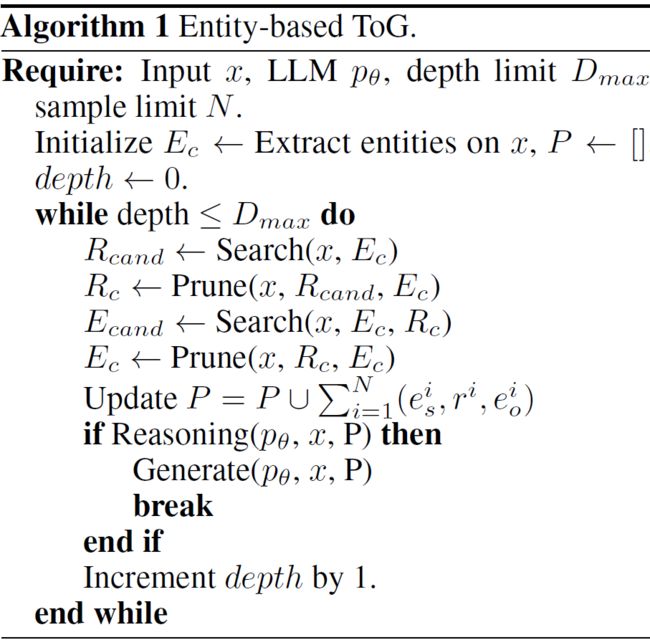

所提方法推理过程如下图中算法所示。

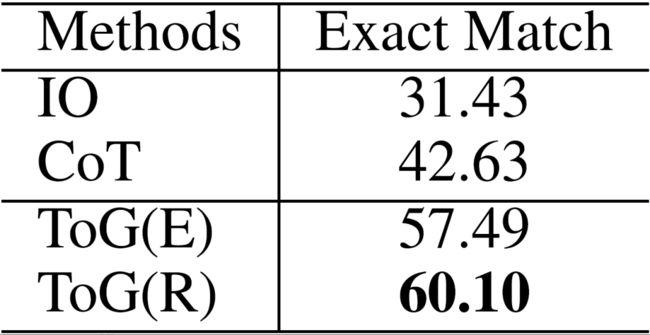

从简单的实验结果可以看出,本文所提方法相比于思维链提示推理方法,推理结果得到了显著提升。

总 结

大规模语言模型在推理领域的应用是近期的热门问题,将大规模语言模型隐式的参数化知识与知识图谱中结构化的知识融合进而增强推理能力是值得探索的方案之一。本文介绍的三项工作中,第一项工作通过简单的提示方法让大模型展现出了让人惊叹的推理能力,第二三项工作则是在大模型基础上,通过不同方法融合知识图谱的结构化知识,从而使用大模型进行推理,但是目前融合方法比较简单,该方向仍然存在一定研究空间。

参考文献

[1] Wei, J., Wang, X., Schuurmans, D., Bosma, M., Xia, F., Chi, E., ... & Zhou, D. (2022). Chain-of-thought prompting elicits reasoning in large language models. Advances in Neural Information Processing Systems, 35, 24824-24837.

[2] Baek, J., Aji, A. F., & Saffari, A. (2023). Knowledge-Augmented Language Model Prompting for Zero-Shot Knowledge Graph Question Answering.arXiv preprint arXiv:2306.04136.

[3] Sun, J., Xu, C., Tang, L., Wang, S., Lin, C., Gong, Y., ... & Guo, J. (2023). Think-on-graph: Deep and responsible reasoning of large language model with knowledge graph.arXiv preprint arXiv:2307.07697.

祝我们的少飞博后出站快乐,工作顺利。