机器学习三大基本要素学习准则

学习准则

令训练集 ![]() = 是由 N个独立同分布的样本组成,即每个样本( ,y ) ∈ X×Y 是从X 和Y的联合空间中按照某个未知分布P( ,y)独立地随机产生的。这里要求样本分布p( ,y) 必须是固定的(虽然可以是未知的),不会随时间而变化.如果 p( ,y)本身可变的话,就无法通过这些数据进行学习。

= 是由 N个独立同分布的样本组成,即每个样本( ,y ) ∈ X×Y 是从X 和Y的联合空间中按照某个未知分布P( ,y)独立地随机产生的。这里要求样本分布p( ,y) 必须是固定的(虽然可以是未知的),不会随时间而变化.如果 p( ,y)本身可变的话,就无法通过这些数据进行学习。

一个好的模型 (x,θ∗) 应该在所有 ( ,y) 的可能取值上都与真实映射函数y=(x)一致,即

或与真实条件概率分布p(|x)一致,即

其中ϵ是一个很小的正数,fy( ,θ∗)为模型预测的条件概率分布中y对应的概率。

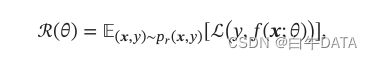

模型(x;θ)的好坏可以通过期望风险(Expected Risk)ℛ()来衡量,其定义为

其中p( ,y)为真实的数据分布,ℒ( ,( ;θ))为损失函数,用来量化两个变量之间的差异。

损失函数

损失函数是一个非负实数函数,用来量化模型预测和真实标签之间的差异。

下面介绍几种常用的损失函数.

0-1 损失函数 最直观的损失函数是模型在训练集上的错误率,即0-1 损失函数(0-1 Loss Function):

其中(⋅)是指示函数。

虽然0-1损失函数能够客观地评价模型的好坏,但其缺点是数学性质不是很好:不连续且导数为0,难以优化.因此经常用连续可微的损失函数替代。

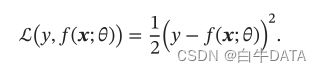

平方损失函数 平方损失函数(Quadratic Loss Function)经常用在预测标签y为实数值的任务中,定义为

平方损失函数一般不适用于分类问题.

交叉熵损失函数 (Cross-Entropy Loss Function)一般用于分类问题。假设样本的标签y ∈{1 , ⋯ ,C}为离散的类别,模型 (x; θ)∈ [0,1]^C的输出为类别标签的条件概率分布,即

并满足

我们可以用一个C维的one-hot向量y来表示样本标签。假设样本的标签为k,那么标签向量y只有第k维的值为1,其余元素的值都为0.标签向量y可以看作样本标签的真实条件概率分布p(|x),即第c维(记为yc,1 ≤ c≤C)是类别为 c的真实条件概率.假设样本的类别为k,那么它属于第 k类的概率为 1,属于其他类的概率为0。

对于两个概率分布,一般可以用交叉熵来衡量它们的差异.标签的真实分布y和模型预测分布(x ;θ)之间的交叉熵为

比如对于三分类问题,一个样本的标签向量为y =[0 ,0 ,1]^T,模型预测的标签分布为 (x; θ)=[0.3,0.3,0.4]^T,则它们的交叉熵为 −(0 × log(0.3) + 0 ×log(0.3) + 1 × log(0.4)) = − log(0.4).

因为y为one-hot向量,上面公式也可以写为

其中 fy( ;θ) 可以看作真实类别y 的似然函数.因此,交叉熵损失函数也就是负对数似然函数(Negative Log-Likelihood)。

Hinge 损失函数 对于二分类问题,假设 y的取值为 {−1, +1},(x; θ)∈R。

Hinge损失函数(Hinge Loss Function)为

其中[]+ = max(0, )。

风险最小化准则

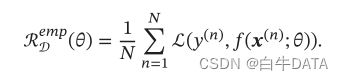

一个好的模型 (x; θ)应当有一个比较小的期望错误,但由于不知道真实的数据分布和映射函数,实际上无法计算其期望风险 ℛ().给定一个训练集D=![]() ,我们可以计算的是经验风险(Empirical Risk),即在训练集上的平均损失:

,我们可以计算的是经验风险(Empirical Risk),即在训练集上的平均损失:

因此,一个切实可行的学习准则是找到一组参数θ∗ 使得经验风险最小,即

这就是经验风险最小化(Empirical Risk Minimization,ERM)准则。

过拟合:根据大数定理可知,当训练集大小 | |趋向于无穷大时,经验风险就趋向于期望风险.然而通常情况下,我们无法获取无限的训练样本,并且训练样本往往是真实数据的一个很小的子集或者包含一定的噪声数据,不能很好地反映全部数据的真实分布.经验风险最小化原则很容易导致模型在训练集上错误率很低,但是在未知数据上错误率很高.这就是所谓的过拟合(Overfittin)。

过拟合问题往往是由于训练数据少和噪声以及模型能力强等原因造成的。为了解决过拟合问题,一般在经验风险最小化的基础上再引入参数的正则化(Regularization)来限制模型能力,使其不要过度地最小化经验风险。这种准则就是结构风险最小化(Structure Risk Minimization,SRM)准则:

其中‖||是ℓ2 范数的正则化项,λ用来减少参数空间,避免过拟合;λ用来控制正则化的强度。

正则化项也可以使用其他函数,比如 ℓ1 范数.ℓ1 范数的引入通常会使得参数有一定稀疏性,因此在很多算法中也经常使用。从贝叶斯学习的角度来讲,正则化是引入了参数的先验分布,使其不完全依赖训练数据。

和过拟合相反的一个概念是欠拟合(Underfittin),即模型不能很好地拟合训练数据,在训练集上的错误率比较高。欠拟合一般是由于模型能力不足造成的.图中给出了欠拟合和过拟合的示例。

总之,机器学习中的学习准则并不仅仅是拟合训练集上的数据,同时也要使得泛化错误最低.给定一个训练集,机器学习的目标是从假设空间中找到一个泛化错误较低的“理想”模型,以便更好地对未知的样本进行预测,特别是不在训练集中出现的样本.因此,我们可以将机器学习看作一个从有限、高维、有噪声的数据上得到更一般性规律的泛化问题。