论文阅读-PaLM-E:多模态语言模型

摘要

1. 介绍

2. 相关工作

3. PaLM-E:一种体现的多模态语言模型

3.1 仅解码器LLM

3.2 仅限前缀解码器LLM

3.3 在机器人控制回路中体现输出:PaLM-E

4. 不同传感器模式的输入和场景表示

4.1 状态估计向量

4.2 Vision Transformer (ViT)

4.3 以对象为中心的表示

4.4 对象场景表示Transformer(OSRT)

4.5 实体转介

5 训练方法

5.1 PaLM-E

5.2 随模型冻结而变化

6. 实验

6.1 机器人环境/任务

6.2 TAMP环境

6.3. Language-Table环境

6.4 移动操作环境

6.5 执行一般视觉语言任务

6.6 执行一般语言任务

7. 实验和讨论总结

7.1 通用模型与专业模型–迁移

7.2 数据效率

7.3 保留语言能力

PaLM-E: An Embodied Multimodal Language Model

https://palm-e.github.io/assets/palm-e.pdf

https://arxiv.org/pdf/2204.02311.pdf

Danny Driess, Fei Xia , Mehdi S. M. Sajjadi等人

Robotics at Google,TU Berlin ,Google Research

小虎AI珏爷:论文阅读:Language Models are Few-Shot Learners(巨无霸OpenAI GPT3 2020)

小虎AI珏爷:ControlNet:是时候放下画笔了,向文本到图像扩散模型添加条件控制(2023)

小虎AI珏爷:ChatGPT背后的技术之理解人类反馈强化学习(RLHF)

小虎AI珏爷:ColossalChat:完整RLHF平替ChatGPT的开源方案

00:49

00:50

00:45

摘要

大型语言模型已被证明可以执行复杂的任务。然而,在现实世界中实现一般推理,例如机器人问题,会带来接地气的挑战。论文提出了具体化的语言模型,以将真实世界的连续传感器模态直接结合到语言模型中,从而建立单词和感知之间的联系。具体语言模型的输入是多模态语句,它们交织了视觉、连续状态估计和文本输入编码。结合预训练的大型语言模型,对这些编码进行端到端训练,用于多个具体任务,包括顺序机器人操作规划、视觉问题解答和图像视频字幕描述。论文的评估表明,PaLM-E,一个单一的大型体现多模态模型,可以在多个实施例上处理来自各种观察模式的各种体现推理任务,并且进一步表现出积极的迁移:该模型受益于跨互联网规模的语言、视觉和视觉语言领域的各种联合训练。最大的模型PaLM-E-562B具有562B参数,除了接受机器人任务训练外,它是一种视觉语言通用,在OK-VQA上具有最先进的性能,并保持了日益扩大的通用语言能力。

图1:PaLM-E是用于具体推理任务、视觉语言任务和语言任务的单一通用多模态语言模型。

图1:PaLM-E是用于具体推理任务、视觉语言任务和语言任务的单一通用多模态语言模型。PaLM-E将视觉语言领域的知识转化为具体推理——从复杂动力学和物理约束环境中的机器人规划,到回答有关可观察世界的问题。PaLM-E对多模态句子进行操作,即标记序列,其中来自任意模态的输入(例如,图像、神经3D表示或状态,绿色和蓝色)与文本标记(橙色)一起插入,作为LLM的输入,进行端到端训练。

1. 介绍

大型语言模型(LLM)在各个领域表现出强大的推理能力,包括对话(Glaese等人,2022;Thoppilan等人,2022)、分步推理(Wei等人,2022年;Kojima等人,2022》)、数学问题解决(Lewkowycz等人,2022,Polu等人,2022”)和代码编写(Chen等人,2021a)。然而,现实世界中此类推理模型的局限性在于基础问题:尽管在大量文本数据上训练LLM可能会导致与我们的物理世界相关的表示,将这些表示与真实世界的视觉和物理传感器模态相连接对于解决计算机视觉和机器人学中更广泛的基础现实世界问题至关重要(Tellex等人,2020)。先前的工作(Ahn等人,2022)将LLM的输出与学习到的机器人策略和启示功能联系起来,以做出决策,但受限于LLM本身仅提供文本输入,这对于场景的几何配置很重要的许多任务来说是不够的。此外,在论文的实验中,论文表明当前最先进的视觉语言模型在典型的视觉语言任务(如视觉问题解答(VQA))上训练,不能直接解决机器人推理任务。

在本文中,论文提出了具体化语言模型,它直接结合了来自具体化代理的传感器模态的连续输入,从而使语言模型本身能够为现实世界中的顺序决策做出更为基础的推断。图像和状态估计等输入被嵌入到与语言标记相同的潜在嵌入中,并由基于Transformer的LLM的自注意力层以与文本相同的方式进行处理。论文从预训练的LLM开始,在LLM中,通过编码器注入连续输入。这些编码器被端到端地训练,以输出自然文本方面的顺序决策,该自然文本可以由具体化的代理通过调节低级策略来解释,或者给出具体化问题的答案。在各种设置中评估该方法,比较不同的输入表示(例如,视觉输入的标准与以对象为中心的ViT编码),在训练编码器时冻结与微调语言模型,并调查在多个任务上的联合训练是否能实现传输。

为了研究该方法的广度,论文对三个机器人操作领域(其中两个是真实世界中的闭环)、标准视觉语言任务(如VQA和图像字幕)以及语言任务进行了评估。结果表明,与单个任务的训练模型相比,多任务训练提高了性能。论文研究表明,跨任务的这种迁移可以导致机器人任务的高数据效率,例如,从大量训练示例中显著提高学习成功率,甚至演示了对对象或不可见对象的新组合的few-shot或zero-shot泛化。

图2:PaLM-E-562B可以进行zero-shot多模态chain-of-thought推理。

图2:PaLM-E-562B可以进行zero-shot多模态chain-of-thought推理,可以在给定图像的情况下讲述视觉条件下的笑话,并展示了一系列与机器人相关的多模态知情能力,包括感知、视觉基础对话和计划。PaLM-E还将zero-shot推广到多图像提示,尽管只针对单个图像提示进行了训练。PaLM-E还可以对带有文本交错手写数字的图像进行数学运算。此外,该模型可以在时间标注的以自我为中心的视觉上执行、zero-shot、提问和回答,类似于(Zeng等人,2022)中所示,但端到端都在一个模型中。

论文将PaLM-E缩放到562B参数,将540B PaLM(Chowdhery等人,2022)LLM和22B视觉Vision Transformer(ViT)(Deghani等人,2023)集成到目前报告的最大视觉语言模型中。PaLM-E-562B在OK-VQA(Marino等人,2019)基准上实现了最先进的性能,无需依赖特定任务的微调。虽然不是实验的重点,但论文还发现(图2)PaLM-E-562B展示了广泛的能力,包括zero-shot多模态思维链(CoT)推理、few-shot提示、无OCR数学推理和多图像推理,尽管只针对单个图像示例进行了训练。zero-shot CoT(Kojima等人,2022)最初是一个纯语言的概念,已通过任务特定程序在多模态数据上显示(Zeng等人,2022年),但据我们所知,并非通过端到端模型。

论文的主要贡献,(1)提出并证明,通过将具体数据混合到多模态大型语言模型的训练中,可以训练一个通用、迁移学习、多实施决策主体。论文表明(2)尽管当前最先进的开箱即用的通用视觉语言模型(zero-shopt)不能很好地解决具体推理问题,但有可能训练出一个合格的通用视觉模型,它也是一个有效的具体推理器。在研究如何最好地训练此类模型时,(3)引入了新的架构思想,如神经场景表示和实体标记多模态token。最后,除了将PaLM-E作为一个具体的推理器之外,论文(4)还表明,PaLM-E也是一个定量胜任的视觉和语言通用,并且(5)证明,缩放语言模型大小可以实现多模态微调,同时减少灾难性遗忘。

2. 相关工作

通用视觉语言模型。基于大语言(Brown等人,2020;Devlin等人,2018)和视觉(Dosovitskiy等人,2020)模型的成功,近年来人们对大视觉语言模型(VLM)的兴趣越来越大(Li等人,2019;Lu等人,2019年;Hao等人,2022年;Gan等人,2022)。与前辈不同,VLM能够同时理解图像和文本,并且可以应用于诸如视觉问答(Zhou等人,2020;Zellers等人,2021b)、字幕(Hu等人,2022)、光学字符识别(Li等人,2021)和物体检测(Chen等人,2021)等任务。整合图像的方法各不相同。例如,Alayrac等人(2022)使用直接关注单个上下文图像的机制来增强预训练的语言模型。相比之下,PaLM-E将图像和文本表示为潜在向量的“多模态句子”,允许它在句子的任何部分以灵活的方式处理多个图像。与论文的工作更密切相关的是Frozen(Tsimpoukelli等人,2021),其中视觉编码器参数通过通过冻结LLM的反向传播进行优化(Lu等人,2021)。受这项工作的启发,论文通过引入替代输入模态(例如,神经场景表示)在更大范围内研究设计,并且论文提出的方法在VQAv2基准上以超过45%的经验表现优于Frozen。更重要的是,论文证明PaLM-E不仅适用于感知任务,也适用于具体任务。

动作输出模型。之前的工作侧重于将具体环境中的视觉和语言输入与直接行动预测目标相结合(Guhur等人,2022年;Shridhar等人,2022b;a;Zhang&Chai,2021;Silva等人,2021;Jang等人,2022.Nair等人,2022.Lynch等人,2022,Brohan等人,2020年)。在这些方法中,VIMA(Jiang等人,2022)探索了类似于PaLM-E的多模态提示。在这些作品中,语言的作用被描述为任务规范也许是最恰当的。相反,PaLM-E以文本形式生成高级指令;在这样做的过程中,模型能够自然地根据自己的预测进行调整,并直接利用嵌入其参数中的世界知识。这不仅实现了具体的推理,而且还实现了问题的回答,正如论文的实验所证明的那样。在输出动作的作品中,可能最相似的是Gato(Reed等人,2022)中提出的方法,该方法与PaLM-E一样,是一种通用的多实施体代理。与Gato相比,论文展示了不同任务之间的正向迁移,其中模型受益于跨多个领域的不同联合训练。

具体任务规划中的LLM。已经提出了几种方法来在具体领域中利用LLM。尽管许多工作侧重于理解自然语言目标(Lynch&Sermanet,2020;Shridhar等人,2022a;Nair等人,2022;Lynch等人,2022),但很少有人将自然语言作为规划本工作重点的代表。LLM包含大量关于世界的内部化知识(Bommasani等人,2021),但如果没有基础,生成的计划可能无法执行。一项研究采用了提示,通过利用LLM生成与合格指令集之间的语义相似性(Huang等人,2022b),结合启示功能(Ahn等人,2022),视觉反馈(Huang等,2022c),生成世界模型(Nottingham等人,2023;Zellers等人,2021a),在图形和地图上进行规划(Shah等人,2022;Huang等人,2022a)、视觉解释(Wang等人,2023)、程序生成(Liang等人,2022年;Singh等人,2022),或向提示中注入信息(Zeng等人,2022。相比之下,PaLM-E被训练为直接生成计划,而无需依赖辅助模型进行接地。这反过来又使存储在预训练的LLM中的丰富语义知识能够直接集成到规划过程中。

除少数例外情况外,许多此类工程中使用的LLM的参数均按原样使用,无需进一步训练。在LID(Li等人,2022)中,该约束被放松,LLM参数被微调以产生用于生成高级指令的规划网络。(SL)3(Sharma等人,2021)解决了同时微调两个LLM的更具挑战性的任务:一个生成高级指令的规划网络,和一个选择行动的低级政策网络。论文研究了一个跨多种模式的通用多实施模式。

3. PaLM-E:一种体现的多模态语言模型

PaLM-E的主要架构思想是将连续的、具体化的观察(如图像、状态估计或其他传感器模态)注入预训练的语言模型的语言嵌入空间。这是通过将连续观察结果编码为与语言标记的嵌入空间具有相同维度的向量序列来实现的。因此,连续信息以类似于语言标记的方式注入到语言模型中。PaLM-E是一种仅用于解码器的LLM,它在给定前缀或提示的情况下自动生成文本补全。称论文的模型为PaLM-E,因为论文使用PaLM(Chowdhery等人,2022)作为预训练语言模型,并使其具体化。

PaLM-E的输入包括文本和(多个)连续观察。对应于这些观察的多模态标记与文本交错,以形成多模态句子。这样一个多模态句子的例子是问:<img 1>和<img 2>之间发生了什么?其中<img i>表示图像的嵌入。PaLM-E的输出是模型自回归生成的文本,它可以是问题的答案,也可以是PaLM-E以文本形式生成的一系列决策,这些决策应由机器人执行。当PaLM-E负责制定决策或计划时,论文假设存在一个低级策略或计划器,可以将这些决策转化为低级行动。先前的工作讨论了训练此类低级政策的各种方法(Lynch&Sermanet,2020;Brohan等人,2022),论文直接使用这些先前的方法而不进行修改。

3.1 仅解码器LLM

仅解码器大型语言模型(LLM)是经过训练的生成模型,用于预测一段文本 w1:L=(w1,…,wL) 的概率 p(w1:L) ,该文本由一系列标记 wi∈W 表示。(1)p(w1:L)=∏l=1LpLM(wl∣w1:l−1)其中pLM是大型Transformer网络。

3.2 仅限前缀解码器LLM

由于LLM是自回归的,预训练的模型可以以前缀 w1:n 为条件,而无需更改架构,

(2)p(wn+1:L∣w1:n)=∏l=n+1LpLM(wl∣w1:l−1)

令牌嵌入空间。标记 wi 是固定词汇W的元素,固定词汇W是与自然语言中的(子)单词相对应的离散有限集合。在内部,LLM通过 γ:W→X, i.e. pLM(wl∣x1:l−1) with xi=γ(wi)∈Rk 将 wi 嵌入到单词令牌嵌入空间 X⊂Rk 中。映射 γ 通常表示为大小为 k×|W| 的大嵌入矩阵,并进行端到端的训练。在论文的案例中, |W|=256000 (Chowdhery等人,2022)。

多模态句子:连续观察的注入。通过跳过离散令牌级别并将连续观察直接映射到语言嵌入空间 X 中,可以将诸如图像观察的多模态信息注入到LLM中。为此,训练编码器 ϕ:O→Xq 将(连续)观测空间O(详见第4节)映射为 X 中q个向量序列。然后将这些向量与普通嵌入文本标记交错,以形成LLM的前缀。这意味着前缀中的每个向量 xi 由单词标记嵌入器 γ 或编码器 ϕi 构成:

(3)xi={γ(wi) if i a is text token, or ϕj(Oj)i if i corresponds to observation Oj注意,单个观测 Oj 通常被编码为多个嵌入向量。可以在前缀中的不同位置交错不同的编码器 ϕi ,以组合例如来自不同观测空间的信息。以这种方式将连续信息注入LLM将重用其现有的位置编码。与其他VLM方法(例如,(Chen等人,2022))相比,观察嵌入没有插入固定位置,而是动态地放置在周围文本中。

3.3 在机器人控制回路中体现输出:PaLM-E

PaLM-E是一种生成模型,基于多模型句子作为输入生成文本。为了将模型的输出连接到实施例。论文区分了两种情况。如果任务可以通过仅输出文本来完成,例如,在具体的问题回答或场景描述任务中,则模型的输出被直接认为是任务的解决方案。

或者,如果PaLM-E用于解决一个具体的计划或控制任务,它会生成一个文本来调节低级命令。特别是,假设可以使用一些(小的)词汇表来执行低级技能的策略,而PaLM-E的成功计划必须包含一系列此类技能。请注意,PaLM-E必须根据训练数据和提示自行确定哪些技能可用,并且不使用其他机制来约束或过滤其输出。尽管这些策略受语言限制,但它们无法解决长期任务或接受复杂指令。因此,PaLM-E被集成到一个控制回路中,在该回路中,机器人通过低级策略执行其预测决策,从而产生新的观察结果,如果需要,PaLME能够根据这些观察结果重新规划。从这个意义上讲,PaLME可以理解为一种高级策略,它对低级策略进行排序和控制。

4. 不同传感器模式的输入和场景表示

在本节中,将描述结合到PaLM-E中的各个模态,以及如何设置它们的编码器。为每个编码器 ϕ:O→X 提出了不同的架构选择将相应的模态映射到语言嵌入空间中。研究2D图像特征的状态估计向量、Vesrion Transformer(ViTs)(Dosovitskiy等人,2020;Chen等人,2022;Ryoo等人,2021)和3D-ware对象场景表示Transformer(OSRT)(Sajjadi等人,2022a)。除了全局表示输入场景的编码器之外,论文还考虑以对象为中心的表示,这些表示将观察结果转化为表示场景中各个对象的标记。

4.1 状态估计向量

状态向量,例如来自机器人或对象的状态估计,可能是输入到PaLM-e中最简单的。设 s∈RS 是描述场景中对象状态的向量。例如,s可以包含这些对象的姿势、大小、颜色等。然后,MLP ϕstate 将状态s映射到语言嵌入空间。

4.2 Vision Transformer (ViT)

ViT ϕ~ViT (Dosovitskiy等人,2020)是一种将图像I映射为多个令牌嵌入 x~1:m=ϕ~ViT(I)∈Rm×k~ 的Transformer体系结构,这两者都已经在图像分类上进行了预训练。论文考虑了几个变体,包括Chen等人(2022)的40亿参数模型(称之为ViT-4B)和类似的220亿参数模型ViT22B(Deghani等人,2023),这两个模型都已在图像分类上进行了预训练。进一步研究了ViT令牌学习者体系结构(ViT+TL)(Ryoo等人,2021),它是从头开始的端到端训练。注意,ViT嵌入的维数与语言模型的维数不一定相同。因此,将每个嵌入投影到 xi=ϕViT(I)i=ψ(ϕ~ViT(I)i) 中,ψ是一个学习的仿射变换。

4.3 以对象为中心的表示

与语言不同,视觉输入不是预先构造成有意义的实体和关系的:虽然ViT可以捕捉语义,但表示的结构类似于静态网格,而不是对象实例的集合。这对与经过符号预训练的LLM接口以及解决需要与物理对象交互的具体推理都提出了挑战。因此,论文还探索了结构化编码器,其目的是在将视觉输入注入LLM之前将其分离成不同的对象。给定真是对象实例掩码 Mj ,对于对象j,可以将ViT的表示分解为 x1:mj=ϕViT(Mj∘I) 。

4.4 对象场景表示Transformer(OSRT)

另一种不需要真实标注分割的方法是OSRT(Sajjadi等人,2022a):它们不是依赖于关于对象的外部知识,而是通过架构中的归纳偏见以无监督的方式发现(Locatello等人,2020)。基于SRT(Sajjadi等人,2022b),OSRT通过新的视图合成任务学习域内数据上的3D中心神经场景表示。它的场景表示由对象槽 oj=ϕ¯OSRT(I1:v)j∈Rk→ 组成。将这些槽中的每一个投影到具有MLP ψ的 x1:mj=ψ(ϕ¯OSRT(I1:v)j) 。请注意,每个对象总是标记为多个嵌入,即 ψ:Rk¯→Rm×k 映射成m个嵌入。

4.5 实体转介

对于具体的计划任务,PaLM-E必须能够在其生成的计划中引用对象。在许多情况下,包括大多数实验,场景中的对象可以通过其独特的财产在自然语言中识别。然而,也存在这样的设置,即对象不容易通过语言用几个词来识别,例如,如果在不同位置的同一颜色的表上有多个块。对于以对象为中心的表示(如OSRT),在输入提示中标记与对象对应的多模态标记,如下所示:对象1是<obj 1>。对象j是<obj j>。这使得PaLM-E能够在其生成的输出语句中通过obj j形式的特殊标记来引用对象。在这种情况下,假设低级策略也对这些令牌进行操作。

5 训练方法

5.1 PaLM-E

PaLM-E是在 D={(I1:uii,w1:Lii,ni)}i=1N 形式的数据集上训练的,其中每个示例i由 ui 多连续观察 Iji 、文本 w1:Lii 和索引 ni 组成。尽管是仅解码器模型,但文本由前缀部分和索引 ni 构成,索引 ni 由多模态句子形成,预测目标仅包含文本标记。因此,损失函数是在各个非前缀令牌 wni+1:Lii 上平均的交叉熵损失。为了在模型中形成多模态句子,论文在文本中有特殊的标记,这些标记在文本中的位置被编码器的嵌入向量所取代。将PaLM-E基于PaLM的预训练8B、62B和540B参数变体,作为仅解码器LLM,通过输入编码器将连续观测值注入其中。这些编码器要么经过预训练,要么从头开始训练,见第4节。论文将结合4B ViT的8B LLM称为PaLM-E12B,类似地,将62B LLM+22B ViT称为PaLM-E-84B,将540B LLM+202B ViT称作PaLM-E-562B。

5.2 随模型冻结而变化

大多数架构由三个部分组成,编码器 ϕ~ 、投影器 ψ 和 LLM pLM 。在训练PaLM-E时,一种方法是更新所有这些组件的参数。然而,如果提供适当的提示,LLM显示出令人印象深刻的推理能力(Wei等人,2022)。因此,论文研究是否有可能冻结LLM并仅训练输入编码器,如果有,不同的模态编码器如何比较。在这种情况下,编码器必须产生嵌入向量,使得冻结的LLM基于观测,并且还将关于实施例的能力的信息传播给LLM。训练这种编码可以理解为一种与正常软提示相关的输入条件软提示形式(Tsimpoukelli等人,2021)(Lester等人,2021)。在 ϕOSRT 的实验中,论文还冻结了槽表示,即我们只更新了充当OSRT和LLM之间接口的小投影器 ψ 。

6. 实验

实验考虑了三个不同机器人实施例中的不同机器人(移动)操纵任务,在模拟中,使用两个不同的真实机器人虽然不是工作的重点,但论文还对PaLM-E进行了一般视觉语言任务的评估,如视觉问题解答(VQA)、图像字幕和既定语言模型任务。

图3:PaLME演示的迁移学习概述:在三个不同的机器人领域中,使用PaLM和ViT预训练以及机器人和通用视觉语言数据的完全混合,与仅在各自的领域内数据上进行训练相比,可以显著提高性能。

论文将实验研究分为两大类。首先,比较了第4节中关于性能、泛化和数据效率的不同输入表示。第二个实验线程集中于一个架构,即主要的PaLM-E版本,由预训练的ViT和PaLM语言模型组成,该模型将原始图像作为连续输入。这里,论文表明,在多个数据集的混合上、跨不同任务和跨机器人实施例训练的单个模型可以同时在所有这些任务上实现高性能。至关重要的是,论文研究了在这些数据集上的联合训练是否能够实现迁移(图3):尽管任务和实例不同,但通过对混合任务的训练,单个任务的性能会提高。论文研究了联合训练策略和模型参数大小对性能、泛化和数据效率的影响。最后,考虑冻结LLM并仅仅训练向LLM注入vision的ViT是否是一条可行的道路。

作为基线,考虑了最先进的视觉语言模型PaLI(Chen等人,2022),该模型尚未在实例机器人数据上进行训练,以及SayCan算法(Ahn等人,2022年),该算法提供了预言启示。

6.1 机器人环境/任务

论文的三个机器人环境(图1)包括一个任务和运动规划(TAMP)域,其中机器人必须操纵(抓取和堆叠)对象,一个桌面推动环境,以及一个移动操纵域。在每个领域中,PaLM-E都根据该领域的专家数据进行训练。在许多情况下,每个任务的数据量都很稀少。TAMP任务涉及可能计划上的大型组合数学,许多决策序列是不可行的。PaLM-E必须生成包含多个步骤的计划,具有复杂的决策边界。多对象桌面推送环境取自公开可用的语言表数据集(Lynch等人,2022),具有挑战性,因为它包括多个对象、大量语言和复杂的推送动态。对于TAMP和语言表环境,PaLM-E都必须考虑对象的姿势。仅仅知道表上有哪些对象或知道它们的粗略关系是不够的,关于场景几何体的更精细的细节对于解决任务非常重要。最后,考虑一个类似于SayCan(Ahn等人,2022)的移动操作领域,机器人必须解决厨房环境中的各种任务,包括在抽屉中找到物体,将其拣起来,并将其带给人类。对于所有领域,都考虑这些环境中的规划和VQA任务。对于移动操作和语言表环境,PaLM-E被集成到控制回路中以在现实世界中执行计划,并且必须在存在外部干扰或低级控制策略故障的情况下调整计划。

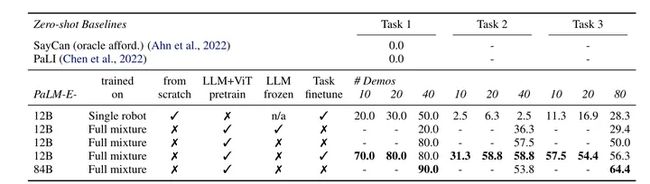

表1:TAMP环境中不同输入表示的比较。

表1:TAMP环境中不同输入表示的比较(就成功率而言),其中来自TAMP的数据仅占总训练数据大小的1%(即,p1、p2各320个样本)。PaLM-E在具体的VQA和规划任务上优于PaLI和SayCan。观察到跨域迁移,因为在全数据混合上训练的具有ViT-4B的PaLM-E提高了规划性能。尽管OSRT没有使用大规模数据,但它为学习提供了最有效的输入编码。(GT)指提供的以地面真相为中心的信息。在所有实验中,LLM都是冻结的。非以对象为中心的ViT-4B变体利用颜色来参考对象,因此q1无法在此处进行评估。LLM在这些实验中被冻结(除了没有经过预训练的情况)。

6.2 TAMP环境

表7:不同输入表示的TAMP环境的成功率。场景中的3-5个对象对应于训练分布。OOD任务指的是通过颜色引用对象的分发外任务,尽管在训练数据中,在以对象为中心的情况下,它们被其特殊标记objj引用。SayCan基线(Ahn等人,2022)利用了预言,一步启示功能。

表7显示了TAMP环境的规划成功率和VQA性能。LLM在这些实验中被冻结(对于预训练的LLM)。对于表7中报告的结果,输入表示在仅包含TAMP环境的96000个训练场景的数据集上进行训练,即没有其他数据是混合的一部分。对于场景中的3-5个对象(与训练集中的数量相同),大多数输入表示的表现类似。然而,当增加对象的数量时,事实证明,使用预训练的LLM可以显著提高性能,尤其是在实体引用时。此外,论文表明,与8B变体相比,62B LLM表现出更好的分布外泛化,而未经预训练的LLM基本上不表现出分布外泛化。SayCan基线(Ahn等人,2022)利用了预言启示功能,但很难解决这一环境,因为启示功能仅限制了当前可能的情况,但信息不足,无法让LLM在TAMP环境中构建长期计划。

表1显示了在1%的数据集上训练时3-5个对象的结果,这对应于两个计划任务中的每个任务的320个示例。在这里,看到输入表示之间存在显著差异,特别是对于规划任务。首先,在状态输入的低数据状态下,预训练LLM是有益的。第二,两种ViT变体(ViT+TL、ViT-4B)在解决这一小数据的规划任务方面表现不佳。然而,如果我们在所有其他机器人环境以及通用视觉语言数据集(ViT-4B通用型)上进行联合训练,那么ViT-4B的性能将提高一倍以上。这显示了不同机器人实施例和任务之间的显著传递效果。最后,使用OSRT作为输入表示可获得最佳性能,展示了3D感知对象表示的优势。我们在这里还观察到另一个迁移实例:当论文删除TAMP VQA数据并仅对640个计划任务示例进行训练时,性能会有(轻微)下降。没有在机器人数据上训练的最先进视觉语言模型PaLI(Chen等人,2022)无法解决任务。论文只对 q2 (表上的左/右/中心对象)和 q3 (垂直对象关系)进行了评估,因为它们最类似于典型的VQA任务。

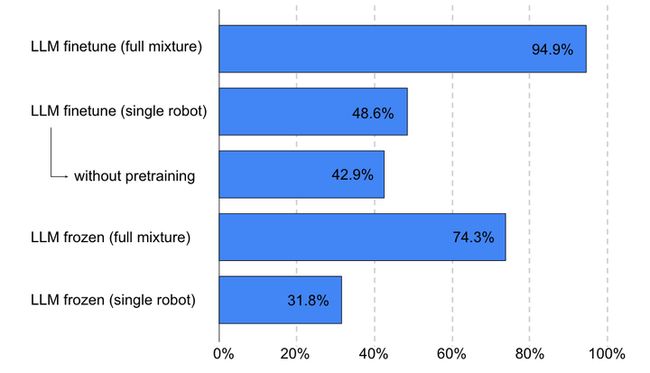

图4:PaLM-E-12B在TAMP环境中的规划成功结果(1%数据),比较了PaLM-E模型的效果(i)使用完整的训练混合物,(ii)预训练(ViT和PaLM),以及(iii)冻结或微调语言模型。从完全混合物中转移特别有效。请注意,对于此处评估的任务,完全混合仅包含1%的训练数据(每个320个示例)。所示为任务p1、p2的

6.3. Language-Table环境

表2:Lynch等人(2022)在模拟环境中规划任务的结果。

表3:表2的任务提示。

表2报告了Language-Table环境中长期任务的成功率(Lynch等人,2022)。PaLM-E集成到一个控制回路中,该回路将长期任务和当前图像作为输入,并输出低级别策略的指令。论文看到,互联网规模的视觉和语言联合训练为机器人规划带来了一个更有效的模型,特别是在每个任务只有10个演示的few-shot模式下。将12B模型扩展到84B模型可以改进3项任务中的2项。与TAMP环境一样,SayCan和zero-shot PaLI都不有效,无法解决最简单的测试任务。

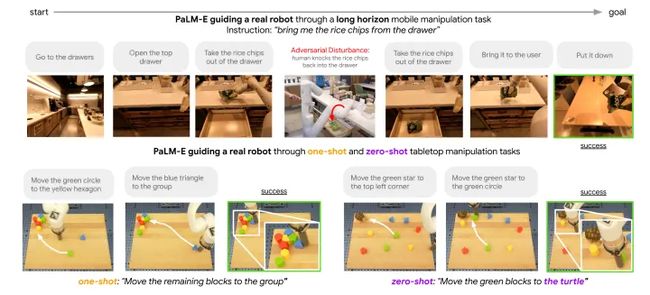

图5:单个PaLM-E模型指导两个真实机器人的低级策略。图中显示的是厨房中的长视野移动操作任务,以及桌面操作机器人的oen-shot/zero-shot概括。

图6:一般语言任务的结果(NLG=自然语言生成):规模的增加导致相应的PaLM-E模型与其继承的PaLM模型之间的灾难性遗忘减少。

图7:PaLM-E交互式地指导真实机器人完成语言表上的长时间操纵任务,同时保持对对抗性干扰的鲁棒性。证据表明,PaLM-E能够进行one-shot和zero-shot推广。

真实机器人结果和few-shot泛化。(在图7,a)中,看到PaLM-E能够引导真正的机器人完成多阶段桌面操作任务,同时保持对对抗性干扰的鲁棒性。给定观察到的图像和长期目标,例如“按颜色将块分类到角落”,PaLM-e以1Hz输出语言子目标到Lynch等人(2022)的策略,以5Hz输出低级机器人动作。之前的工作(Lynch等人,2022)改为让人在循环中交互指导子目标和纠正。在图5中,b)看到PaLME能够进行few-shot和zero-shot次学习。在这里,在100个不同的长期任务上对PaLM-E进行了微调,每个任务都有一个训练示例,例如“将所有块放在中心”,“将蓝色块从线中移除”。还发现,PaLM-E可以将zero-shot推广到涉及新对象对的任务(图7,c),以及涉及原始机器人数据集或微调数据集中看不到的对象的任务,例如玩具乌龟(图5,d)。

6.4 移动操作环境

论文演示了PaLM-E在具有挑战性和多样性的移动操作任务中的性能。论文在很大程度上遵循了Ahn等人(2022)的设置,其中机器人需要根据人类的指令规划一系列导航和操纵动作。例如,给定“我把饮料洒了,你能给我拿点东西来清理吗?”的指令,机器人需要计划,1.找块海绵,2.拿起海绵,3.把它带给用户,4.放下海绵。”受这些任务的启发,论文开发了3个用例来测试PaLM-E的具体推理能力:启示预测、故障检测和长期规划。低级策略来自RT-1(Brohan et al.,2022),这是一种Transformer模型,它采用RGB图像和自然语言指令,并输出末端效应器控制命令。

表4:移动操作环境:故障检测和启示预测(F1得分)。

可承受性预测。论文研究了PaLM-E在可承受性预测方面的性能,即低级别策略的技能是否可以在当前环境中执行。这可以表述为VQA问题Given<img>。Q: 这里有可能<skill>吗?。PaLM-E优于PaLI(zero-shot),以及使用QT-OPT训练的值函数的阈值(表4)。

真正的机器人成果:长远规划。最后,使用PaLM-E为移动操作任务执行端到端的具体规划。此任务的提示结构为Human:。PaLM-E被训练以生成计划的下一步,条件是所采取步骤的历史和场景的当前图像观察。在解码每个步骤之后,论文将它们映射到Ahn等人(2022)中定义的低级策略。该过程以自回归方式进行,直到PaLM-E输出“终止”。通过使用来自(Ahn等人,2022)的运行来训练模型,该运行包含2912个序列。论文在真实厨房中对该模型进行了定性评估,发现该模型可以执行长期移动操作任务,即使在对抗性干扰下也是如此(图5)。

6.5 执行一般视觉语言任务

表5:一般视觉语言任务的结果。对于通用模型,它们在不同的评估中是相同的检查点,而特定于任务的微调模型对不同的任务使用不同的微调模型。COCO使用Karpathy拆分。†是OK-VQA上的32次拍摄(未微调)。

虽然这不是论文工作的重点,但在表5中报告了一般视觉语言任务的结果,包括OKVQA(Marino等人,2019)、VQA v2(Goyal等人,2017)和COCO字幕(Chen等人,2015)。单一的、通用的PaLM-E-562B模型在OK-VQA上实现了最高的报告数量,包括优于专门针对OK-VQA进行微调的模型。与(Tsimpoukelli等人,2021)相比,据我们所知,PaLM-E在VQA v2上取得了最高的性能,拥有一个冻结的LLM。这证明了PaLM-E是一个有竞争力的视觉语言通才,同时也是机器人任务的具体推理者。

6.6 执行一般语言任务

表8:原始PaLM模型和相关PaLM-E(未冻结)模型的NLU和NLG任务的全语言评估任务结果。具有冻结LLM的PaLM-E模型具有与其对应的基础PaLM模型相同的性能。

表8报告了PaLM-E在自然语言理解(NLU)和自然语言生成(NLG)任务的21个通用语言基准上的平均性能。值得注意的趋势是,随着模型规模的增加,对语言能力的灾难性遗忘大大减少。如图6所示,对于最小的(PaLM-E-12B)模型,其NLG性能(相对)的87.3%在多模式训练期间下降,而对于最大的模型(PaLME-562B),仅3.9%下降。

7. 实验和讨论总结

7.1 通用模型与专业模型–迁移

表9:移动操作环境:故障检测,显示个人精度和召回分数。

如图3所示,论文在这项工作中展示了几个迁移实例,这意味着与单独在不同任务上训练的模型相比,在不同任务和数据集上同时训练的PaLM-E会显著提高性能。在图4中,在“完全混合”上进行的联合训练取得了两倍以上的成绩。在表9中,添加LLM/ViT预训练,以及对完全混合的训练,而不是仅使用移动操作数据,可以看到性能的显著提高。对于表2中的语言表实验,观察到类似的行为。

7.2 数据效率

与现有的大量语言或视觉语言数据集相比,机器人数据的丰富程度要低得多。如上一段所述,论文的模型展示了迁移能力,这有助于PaLM-E从机器人领域的极少数训练示例中解决机器人任务,例如,语言表的10到80或TAMP的320。OSRT结果显示了使用几何输入表示的数据效率的另一实例。未来工作的一个有希望的机会是将其与受益于大规模视觉数据的方法相结合。

7.3 保留语言能力

论文展示了在多模式训练期间保持模型语言能力的两种途径。作为一种选择,冻结LLM并仅训练输入编码器是构建具体语言模型的可行途径,尽管这种方法偶尔会在机器人任务中遇到困难(表2)。作为一种替代途径,当整个模型进行端到端训练时,随着模型规模的增加,模型保留了更多的原始语言性能(图6)。