Motion-Attentive Transition for Zero-Shot Video Object Segmentation(2020 AAAI)

Motion-Attentive Transition for Zero-Shot Video Object Segmentation

- Introduction

- Proposed Method

-

- Network Overview

- MAT

-

- SA:

- AT:

- SSA

- BAR

- Implementation Details

-

- Training Loss

- Trainging Settings

- Runtime

- Experiments

-

- Ablation Study

- Result

链接: arxiv.

链接: VOS论文总结.

Introduction

论文中提供了一种利用运动信息来增强时空对象表示的方法,在深度学习时代之前,对象运动就一直被视为视频对象分割的有益提示:

1、在双流 encoder中设计了一个非对称注意力模块(An asymmetric attention block), 被称作Motion-Attentive Transition (MAT),在每一个res stage处,借助于该模块,将外观特征转化为专注于运动的表示形式,可以在encoder编码期间就实现了对象运动和外观之间紧密的分层交互。 这优于典型的双流体系结构,它们在每个分支中分别处理运动和外观,并且经常会过度拟合外观信息。

2、提出了一种 bridge network ,可以获得一个 compact, discriminative and scale-sensitive representation for multi-level encoder features(紧凑、具有识别力、尺寸敏感的multi-level 编码器特征),并将特征送入解码器,得到最终的分割结果。

生物机制:

Cloutman,2013 表明,在HVS(人眼视觉系统(Human Visual System))中,the dorsal pathway(用于运动感知)的激活反应比the ventral pathway (用于客观/语义感知)的激活反应更快,并且倾向于沿the ventral pathway发送信号进行多级连接,以促使它专注于处理最突出的对象。 这种多模式系统使人类能够首先专注于物体的运动部分,然后将注意力转移到整个图片的外观上。 因此,考虑到这种生物学机制,并以分级的方式将对象运动纳入外观学习中,以实现更有效的时空对象表示。

通过考虑从运动到外观的信息流,我们可以减轻对象外观的歧义(例如,视觉上与周围环境相似),从而减轻了对象表示学习的压力。

Proposed Method

1、MATNet的核心是深层交互的双流编码器,其具有双流模型在多模态特征学习中的优势,同时还逐步迁移了中间运动注意力特征以促进外观学习。 Transition(迁移)是由多个运动注意力转换模块(MAT)执行的。 每个MAT在Encoder的卷积阶段都采用输入图像和光流图的中间特征。 在模块内部,建立了一个不对称的关注机制,该机制首先根据光流推断出感兴趣的区域,然后 transfers the inference为外观特征提供更好的选择性。 每个MAT模块输出的attentive appearance and motion features送入接下来的ResNet block。

2、解码器接受从编码器学来的特征作为输入,并逐步逐个细化粗略特征以获得准确的分割。 解码器由以级联方式组织的多个边界感知优化(BAR)块组成。 每个BAR都明确利用多尺度特征(ASPP),并在对象边界预测的帮助下进行分割推断,以获得更精细的结果。

3、不是通过跳跃连接直接连接编码器和解码器,而是提出了比例敏感注意力(SSA, follow CBAM,仅有一个小的改动)来自适应地选择和变换编码器特征:添加到每对编码器和解码器层的SSA具有two-level attention scheme,其中local-level attention用于选择聚焦区域(就是CBAM),而global-level则有助于重新校准不同比例对象的特征。

Network Overview

MATNet is an end-to-end deep neural network for Z-VOS, consisting of three concatenated networks, i.e.

- an interleaved encoder: 依赖于双流分支的结构来编码对象的外观和运动,为每一层使用了MAT模块,其提供了信息从运动到外观的迁移。使用ResNet-101的前5个block作为backbone,在给定img和flow的情况下,在第2、3、4、5个res block处提取中间特征,通过MAT模块,利用Flow Feature增强RGB Feature,送入下一个RGB分支res block中,并通过concat得到object的时空对象特征,通过bridge network送入decoder中。

- a bridge network: 被期望能够选择性地将编码器特征转移到解码器(通过SSA模块实现,每个SSA模块充分利用对应的第I个stage中提取的特征U,并预测一个attention-aware的特征Z,其通过two-level attention scheme,local-level attention采用channel-wise和spatial-wise注意力机制来使输入特征聚焦到正确的对象区域并且抑制冗余特征中可能存在的噪声。同时global-level attention旨在重新校准特征,以考虑不同尺寸的物体。

- a decoder with BAR: 按照由粗到精细的方案进行分割,其由4个BAR模块组成(2,3,4,5),每个模块对应于encoder中第I个res block,特征图的分辨率通过更多低层细节来补偿high-level粗糙特征而逐渐提高,BAR2产生最终(最好)的特征图,分辨率为输入特征的1/4,通过两个额外的层(conv(3*3,1),sigmoid)来得到最终的mask 输出。

MAT

MAT由两个单元组成:1、一个soft attention(SA)2、一个attention transition(AT)

SA:

SA单元能够帮助专注于输入的重要区域。

该单元在空间的每个位置softly加权输入特征图(vm,va): 若输入特征为vm,可以得到一个关于motion-attention的权重,并用该权重加权输入特征,从而得到一个motion-attentive feature。其中为卷积操作,w为11的conv kernel,将输入映射为显著性图,并使用softmax执行归一化,得到一个soft attention map A,U是一个attention-aware 特征图。 右上角的c表示将特征切片为c通道特征,通过SA,给定CHW的特征v,可以得到motion-attentive/appearance-attentive的特征U(CHW)

AT:

AT单元迁移运动注意力特征以促进外观特征的学习。

为了迁移motion-attentive features,首先通过non-local的方法计算Ua和Um之间相似性矩阵,W是一个可学习的权重矩阵(C*C),相似性矩阵可以有效的捕捉两个特征空间之前的成对关系,但是这也会引入大量参数,会增加计算成本并产生过度拟合的风险。 为了解决这个问题,W被分解为两个低秩(low-rank)矩阵P(C * C/d)和Q(C * C/d),d是减少的比率。这个操作就等价于在执行相似性矩阵计算前,对Ua和Um执行channel-wise的特征变换,将特征通道数减少为C/d,这不仅减少了参数数量,还为每个model生成了紧凑的channel-wise特征表示。对于相似性矩阵S执行row-wise的softmax归一化得到attention map,并与外观特征结合,生成增强的外观特征。

可以看到(c)中是RGB分支提取出的外观特征,此时的外观特征无法聚焦于显著性对象上,但是一旦提供了motion-attention,外观特征就可以有效地聚焦在感兴趣的区域。(在消融实验中也证明了MAT模块对于Jmean和Fmean都有显著提升)

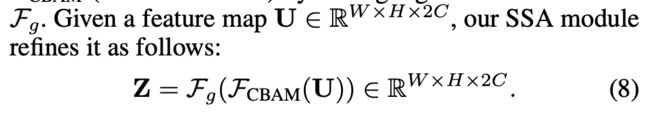

SSA

SSA由一个轻量的CBAM和一个global-level attention

(论文中提到添加的global-level attention,以重新校准不同比例对象的特征,不知道什么原理)

将RGB和Flow双流分支concat在一起的特征(HW2C) 作为输入,先通过CBAM模块,再通过一个global-level attention。

CBAM包含两个顺序的子模块,channel attention和spatial attention:

(与CBAM论文有些许差异:链接: arxiv.)

对于channel attention:Fs是一个压缩算子,将U的全局空间信息聚合到一个向量s(2C)中,Fe是一个激励算子,捕获通道相关性,并输出注意力向量e。Fs被定义为对每一个feature channel执行avgpooling;Fe被定义为四个步骤:

- fc(2C/16)

- Relu()

- fc(2C)

- sigmoid()

Zc(HW2C)为执行了channel-wise attentive features。

对于spatial attention:Fp利用Zc的空间关系,生成空间注意力图,被定义为两个步骤:

- conv(7*7,1)

- sigmoid()

在之后得到了Zcbam作为local-level feature。

对于global-attention,其和CBAM模块用相同的压缩算子,并且将激励算子更改为:

- fc(2C/16)

- fc(1)

- sigmoid()

最终输出一个scale-sensitive factor(1 channel):

![]()

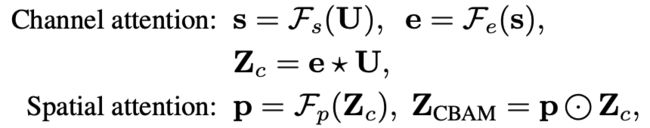

BAR

BAR模块接受两个输入;相关联的SSA模块的输出Z,还有前一个BAR模块的输出F。

为了获得更锋利的mask输出,BAR模块首先使用一个边界检测模块来生成对象边界,其能够完善更精确的对象细节,然后生成的边界图M与两个输入一起为下一个BAR模块生成更精细的特征。

BAR模块从两个因素取得收益:

1、Atrous Spatial Pyramid Pooling (ASPP): 其转换为多尺度表示,有助于扩大感受野,并且获得更多的空间细节来进行解码。

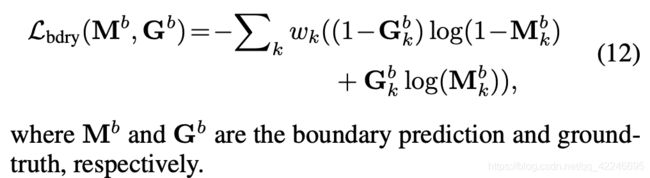

2、引入了一种启发式方法,用于自动挖掘困难负例像素以支持Fbdry的训练。对于每个训练帧,使用off-the-shelf HED model来生成边界图E([0,1],H*W),Ek表示像素k是边界像素的可能性。如果像素概率>0.2并且处于扩张的ground truth区域,则被认为是hard pixel;如果k是hard pixel,则其对应的权重w=1+Ek,否则对应的权重为w=1。w被用来对边界损失进行加权,以便在对hard pixel进行错误分类时,对其进行严重的惩罚。

Implementation Details

Training Loss

输入RGB和Flow尺寸:473*473

使用segmentation mask prediction和4个boundary prediction 来计算损失

Trainging Settings

使用end-to-end的方式训练

Training data:

- DAVIS 2016 : 2K frames

- Youtube-VOS: 12K frames

Total data: 14K frames samples

Runtime

对于尺寸为4734733的test image,前向传播用时0.05s

optical flow estimation: 0.2s

CRF-based post-processing:0.5s

Experiments

Ablation Study

MAT中进行了完整的Ablation Study,在使用ResNet101作为backbone,使用MAT、SSA、HEM,Jmean可以达到82.4,Fmean可以达到80.7

(1、从MATNet移除MAT模块的结果可以看到,Jmean减少了**-2.9**,Fmean减少了**-3.4**,Flow信息对于RGB信息增强后对于性能具有显著的提升。

2、SSA在CBAM的基础上增加了Global Attention,轻量且有效,可以作为多模态融合的baseline,但是我没有实验CBAM和SSA的性能差距。

3、HEM和4个boundary loss 致力于优化boundary,对于Fmean的提升较大,但是在Jmean上的表现有限。

4、在自己的baseline上,实验MAT和SSA的性能,证实MAT提升有限,其在MAT中性能提升的有效性可能来自于HEM以及4个ASPP带来的增益。

5、更好的backbone可以给Jmean和Fmean带来增益)

MATNet中使用Deep MAT,其包含L个cascaded MAT blocks,论文中同样给出了关于L的实验,最终L=5时,能够达成最高性能。

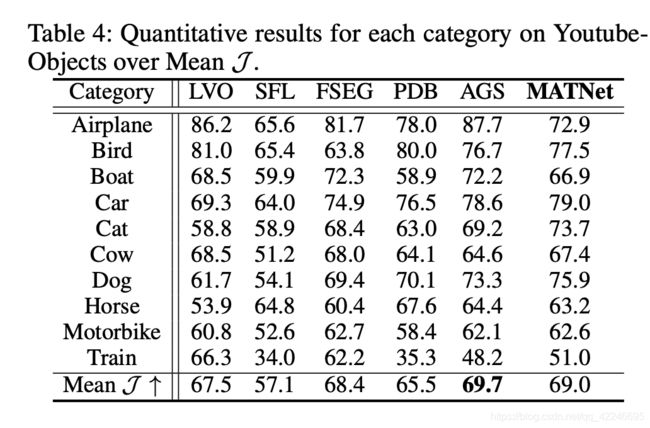

Result

Z-VOS论文普遍都在Davis 2016 、Youtube-Objects、FBMS三个数据集上测试性能。(实现了无监督17的论文会给出在Davis17上的结果。)

MAT实现了仅使用crf后处理的最高性能:Jmean:82.4 Fmean:80.7

(Learning Discriminative Feature with CRF for Unsupervised Video Object Segmentation论文中使用了额外的后处理,从80.4提升至83.4)