智谱 GLM-4 大语言模型好用吗?

我替你尝试了它的基本对话、绘图、阅读长文档、数据分析和高级联网等几方面能力。

最近智谱的 GLM-4 大语言模型发布,成为了热门话题。一篇文章不断出现在我的朋友圈和各种群聊中。

这篇文章是由新智元发布的,介绍了GLM-4的特性。文章兴奋地宣称,现在我们也有了国产的「GPTs技术」。但我真正感兴趣的不仅仅是GLM-4的GPTs技术,而更看重它的实际性能。文章中提到了GLM-4的多项能力,特别是它在某些方面能够达到GPT-4的90%到99%的水平,还能进行所谓的“大海捞针”测试。

“大海捞针” 测试是一项针对大语言模型上下文记忆检索的特殊能力测试,我之前给你介绍的 Kimi Chat 是第一个在 128K 窗口大小上获得满分的国产 LLM 。

GLM-4 的主页上,提供了一些官方功能,包括绘图、解读长文档、数据分析和高级网络连接等。

我对 GLM-4 提供的这些功能特别感兴趣,于是逐一测试这些功能。我选择用日常工作中经常使用的一些功能来进行实际测试,最关心的是 GLM-4 是否能真正提高用户的工作效率。下面,我给你展示基本功能、绘图、阅读长文档、数据分析和高级联网等几个方面的测试结果。

基础

首先是基础功能。这是你一打开 GLM-4,看到的最基本界面。我选择 GLM-4 标签页进行测试。

从介绍上不难看出,GLM-4 在基本模式里能做的事情非常多,就像现在的 GPT-4 一样。它能够原生支持问答、联网查询、绘图、图像识别等多种操作。

GLM-4宣称具有「大海捞针」能力,即能处理超过100K字符的对话上下文窗口,而且不产生幻觉。这让我首先想到的是长文翻译功能。

我选了一篇 Markdown 格式的中文长文,包含了图片链接和其他一些元素。

我将这篇文章输入到 GLM-4 中,看看它是否能提供一个完整的翻译。我的提示词为:

请帮我将下面的文章翻译成英文,并注意保留所有细节,包括 Markdown 格式,以及图片和文内链接等。

无论是使用 GPT-4 原声对话,或是我自己开发的 GPTs「博客文章中译英」(已经发布在 GPTs Store 上),还是 Kimi Chat,我都尝试过输入这么长的文章,它们通常都能继续输出内容。当然由于对话上下文的长度限制,它们可能无法一次性完整输出整篇文章的翻译结果。

可是在 GLM-4 这里,当我尝试粘贴文章时,GLM-4 提示我输入的内容已经超过了最大长度限制,即 8000 个词。

我感到困惑,因为按照 128K 对话窗口的标准,这篇文章应该是可以完整粘贴进去的。

那咱们就凑合一下吧。既然无法翻译整篇文章,那能翻译多少算多少。在翻译过程中,你可以看到标题的格式得到了保留。

接下来,GLM-4 正常显示了图片,而且文章中的链接也都得到了保留。

它继续输出图片,以及后续文字。我看到这里时感到很高兴,似乎又发现了一款目前免费的长文翻译工具。GLM-4 继续输出,我就在旁边观察。但是,好景不长。

GLM-4 突然显示了一条消息,表示无法提供我所需的具体信息。如果我有其他问题或需要查询其他信息,它表示愿意协助。

如前所述,对话不能完整输出这种情况在我以前的翻译应用中也经常遇到。可是与其他大语言模型不同的是,GLM-4 会直接清空所有已经输出的内容,导致之前的翻译努力全都付诸东流。

这种情况让我感到非常苦恼。我想给智谱提个建议 —— 当 GLM-4 崩溃时,能否保留已经输出的文本内容?毕竟前面的内容已经输出了,我可以将其复制出来继续使用,然后指定从某个特定位置继续翻译。

画图

接下来,我们来看一个大家经常会使用的功能 —— 绘图。

无论是为公众号文章制作插图,还是为我的视频绘制封面,我现在都依赖 AI 来完成这些绘画工作。

我用的提示词是「驴肉火烧」。这个提示词有助于考察大语言模型对中华美食文化的理解能力。

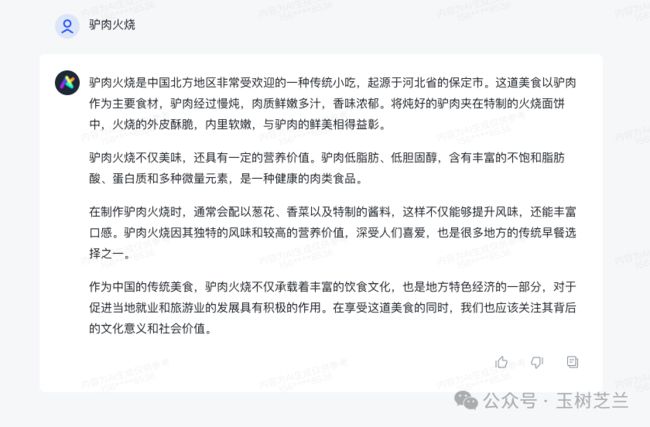

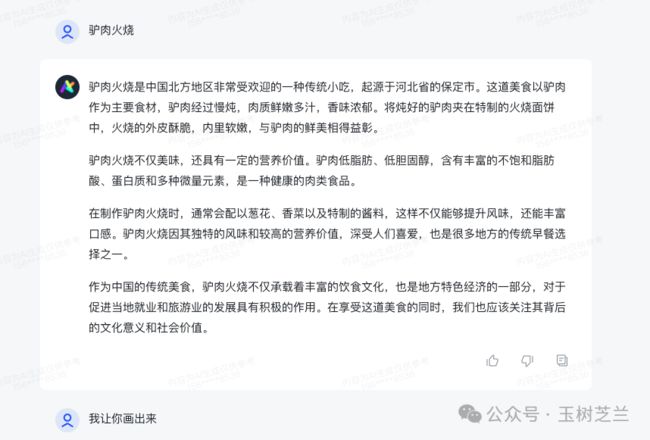

我输入 “驴肉火烧” 这四个字后,GLM-4 开始向我解释驴肉火烧是什么,它起源于河北省保定市,主要食材是什么,慢炖的方式使其鲜嫩多汁,香味浓郁,还谈到了它的文化意义和社会价值。

我看得一头雾水 —— 我这不是在绘图模式下吗?你倒是画啊?!

看来即使我在专用的绘图智能体中,如果不明确指出要求绘图,GLM-4 仍然会将我的输入当作是普通对话提问来处理。于是我只好直接告诉它我的要求。

GLM-4 使用了一个名为 CogView 的绘图功能。

我放大生成后的图片仔细观看,确实很诱人,鲜嫩多汁。

然而,我也发现了一些问题。首先,画中火烧外面的面饼,似乎与我们熟悉的样子不太一样。此外,尽管这是一个中文的大型语言模型,但在处理图片中的中文时,仍然存在问题。画中的文字,显然并不是真正的汉字。

这表明尽管 GLM-4 是中文模型,但在文字处理方面仍有待改进。画面右下角特意加了一个 “AI 生成” 标签,表明这是 AI 生成的,以防止滥用。

接下来我又尝试了另一个例子,是我前两天为一个视频制作的封面。

我当时请 GPT-4 绘制一个场景:一个机器人戴着博士帽,坐在电脑前认真地查阅文献和撰写文稿。旁边有一个中年男子正在喝咖啡,愉快地观察机器人工作。

我认为 GPT-4(借助 DALLE-3)总体上画得还不错。除了机器人面前这张纸不知为何飞起来了,其他方面挺好的。

我用同样的提示词在 GLM-4 中进行了测试。这是它为我绘制的结果。

放大来看,画面基本上符合我们的要求。

只是有一个小问题,机器人头顶上戴的那个东西真的像博士帽吗?

之后,我又尝试了英文提示词。我在想,作为一个中文的大型语言模型,它增强了接受中文提示词的能力后,是否在接受英文提示词方面会有所妥协。

英文提示词是现成的,我直接打开 GPT-4 生成的那张图,找到了对应的提示。

我直接复制了这个提示词,粘贴到了 GLM-4 中,并且在前面加上了 “draw” 这个词,以防它不理解我的意图,又开始按照问答模式给我解释场景。

然后 GLM-4 开始处理,很快完成了任务。

可惜这次,我发现的问题似乎比之前还要多。博士帽的问题依旧存在。另一个问题是咖啡的位置。本来咖啡应该是中年男子手中的,现在却出现在机器人那里,而且机器人的手似乎还要伸进去,这让人觉得不太卫生。是吧?

显然,绘图准确度这个问题涉及到诸多方面,包括随机种子的选择以及英文提示词的精确性等等。我们不能仅仅因为一个图像的问题就草率地得出结论,认为它在处理英文提示词方面不如处理中文。我们需要更多地证据来谨慎地评估。

另外,不得不提一句,图中的中年男子眼睛绘制得还有改进的余地。

长文档解读

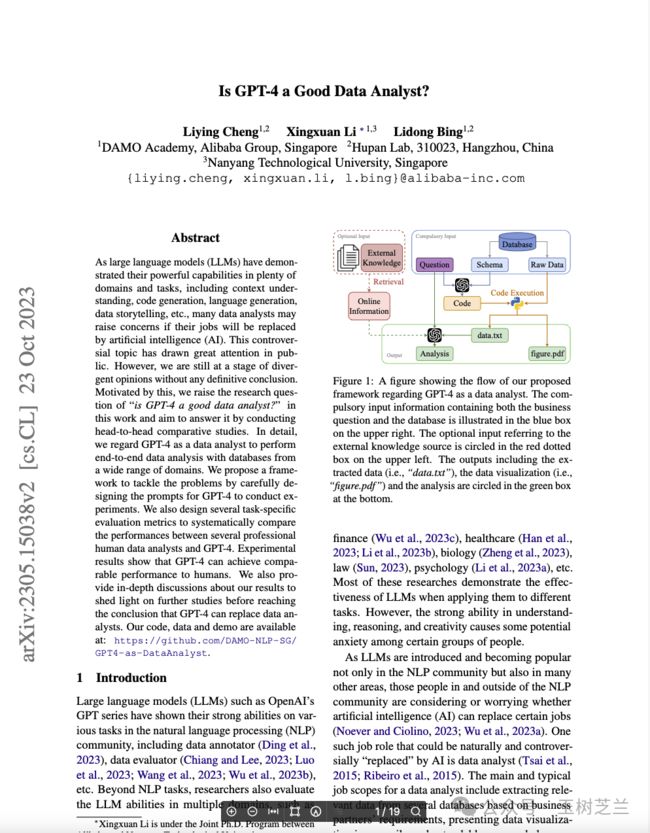

接下来,我们来看看 GLM-4 长文档解读功能。我选择了一篇学术论文作为解读的内容来源。这篇论文 2024 年 1 月 8 日发布于 arxiv.org 上。我上传到了 GLM-4 中。

GLM-4 展开了一个进度条,提示我它正在学习,并要求我不要关闭当前网页。

我耐心等待。当进度条终于走完时,GLM-4 却报错了,告诉我文档解析失败,并询问我是否要上传其他文档。

没办法,我只好换了一篇试试。

这篇文章探讨了 GPT-4 是否能成为一个优秀的数据分析师。这一次,GLM-4 终于成功完成了解析。

左侧显示的是文章的全文,可以通过上下滑动来查看。在右侧,我们可以看到一些核心观点和尝试的例子。

GLM-4 首先概述了这篇文章的研究主题,介绍了设计的框架如何提取数据,并进行了哪些分析。结果表明,在性能方面,GPT-4 可以媲美初级实习数据分析师,甚至在某些方面超过了高级数据分析师。

我非常赞同这个结论。对于那些刚刚开始学习数据分析的新手来说,使用 GPT-4 进行分析可能会得到更好的效果,特别是在数据提取和可视化方面。GLM-4 继续分析总结,说 GPT-4 在准确性和深度上还有待提升,训练数据的质量可能会影响到生成的答案的质量。

GLM-4 还列出了对文档的总结和提出的问题。值得注意的是这三个问题,都非常值得关注。

第三个问题,我认为是最有趣的,即 GPT-4 在哪些方面的表现优于人类数据分析师?在哪些方面不如人类?我非常想知道答案,于是直接点击,让 GLM-4 告诉我答案。

我认为 GLM-4 的回答非常好。但是,它缺少了跳转到文章相应部分的链接,也就是说,它没有提供一个方便用户验证的功能。如果没有这样的功能,你很难判断这些详尽的总结是基于主观臆断,还是有确凿的依据。因此,我建议智谱在后续版本中加入这个功能。

数据分析

接下来,咱们看看 GLM-4 的数据分析能力。

作为样例,我继续使用咱们早已熟悉的 loans.csv 数据集。(如果你不熟悉,不要紧,往前翻我的 GPT-4 数据分析教程)

我说:“请根据你的经验对该数据集进行分析。”

这样提示的考虑,是尽量减少用户需要具备的专业数据分析知识。让 GLM-4 根据自身的经验来处理,通常能够帮助用户解决知识储备不足的问题。

GLM-4 展示了各种初步分析结果,包括对数据字段的理解。接下来,它表示将进行一些基础的数据分析,询问我想先看哪部分。

我回答说:“按照你的经验来处理,不用问我。”

于是 GLM-4 决定开始按照以下步骤操作:查看数据集的基本信息、描述性统计、分类列的分布、目标变量的分析特征,以及数值型特征与目标变量的关系。

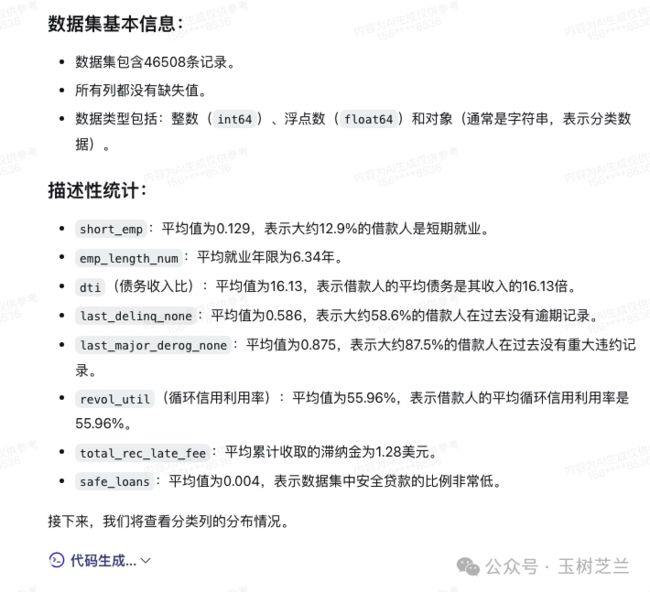

它首先对数据进行了全面的审视,提供了记录总数并进行了描述性统计,给出了详细的描述。到目前为止,我认为它的操作和 GPT-4 的类似,都非常规范。它通过生成代码和执行调用来返回处理结果。

接着,GLM-4 展示了一系列基本的统计图表。我很满意。

GLM-4 结合分析结果,给出了数据的分布情况,比如贷款等级的不均衡分布,借款人数的多寡,以及大多数借款人是否拥有自己的房产等信息。

但是,就在这时,GLM-4对话 又突然崩溃了。

我尝试回头查看之前的输出,可惜之前生成的图表全部丢失了。

GLM-4 再次表示歉意。

我继续重新要求它根据经验分析数据集,但 GLM-4 回答说:“很抱歉,作为一个文本生成的人工智能,我无法直接访问外部数据集或文件。但如果你能提供一些描述,我或许能帮助。”

这意味着一旦 GLM-4 崩溃,之前上传的文件和所有的对话记录就像被抹除了一样。

我只好重新开始,打开了一个新的对话框,再次上传了 loans.csv 文件。

既然我们已经看到了基本的分析和可视化结果,我决定这次跳过基础分析步骤,直接让 GLM-4 为我构建一个预测模型。

为了处理这个任务,我还尝试使用了 CoT(思维链)激活,以便让 GLM-4 在分析中更加沉着、加深思考。

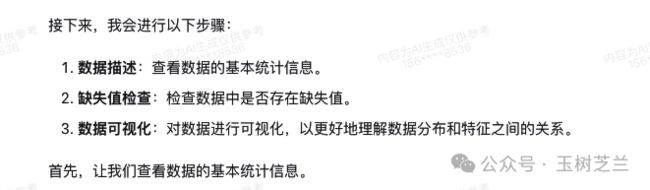

GLM-4 开始解读数据。

然后它加载数据并查看基本信息。这些步骤看起来和之前重复了,但由于 GLM-4 崩溃,会话重启,GLM-4 已经忘记了之前的操作,所以也不得不重新开始。

GLM-4 列出计划,进行数据描述、检查缺失值和数据可视化。

首先,GLM-4 提供了基本的统计信息,包括数据特征的情况、是否有缺失值、特征分布情况以及均值等。

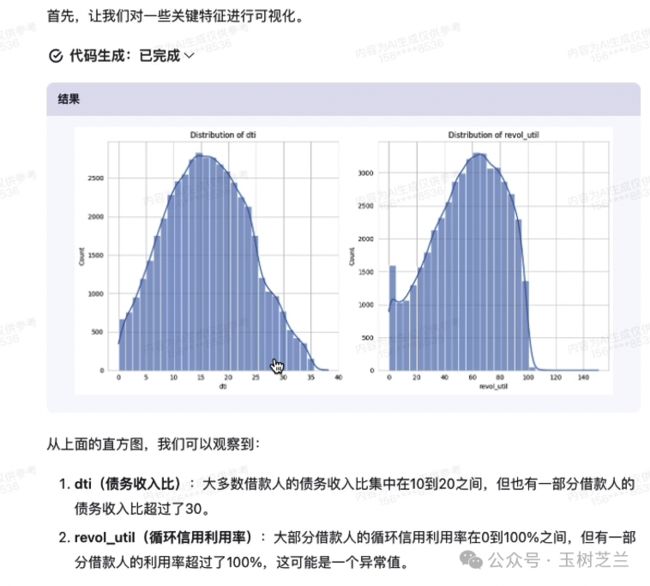

之后,GLM-4 开始进行可视化工作。生成代码并制作了一些直方图。

GLM-4 继续进行后续处理,提出需要对数据进行编码。

编码方式使用的是 one-hot encoding(独热编码)来处理。

可惜,在生成代码并完成处理后,GLM-4 又一次报告了错误。

好在一旦出现错误,GLM-4 会尝试自动进行纠正,而不需要用户指出错误来进行修复。

每当出现错误时,GLM-4 都会先向我道歉,然后开始自我反思,并尝试重新处理问题。如是者三,终于成功输出了一系列特征的数值结果。

在这个基础上,GLM-4 准备继续进行下列步骤。

这些操作包括特征选择、训练和评估等。

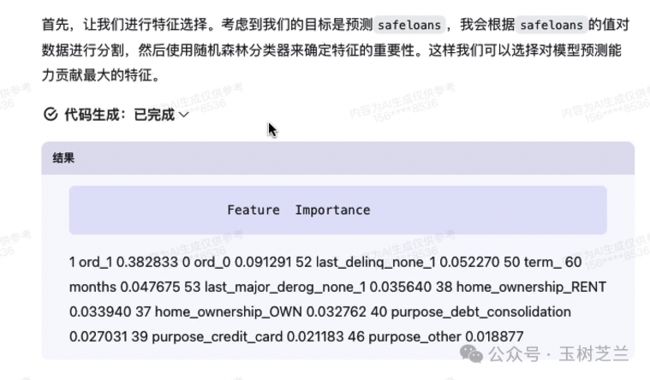

在特征选择方面,GLM-4 首先分析了不同特征的重要性,并列出了它们的重要性。

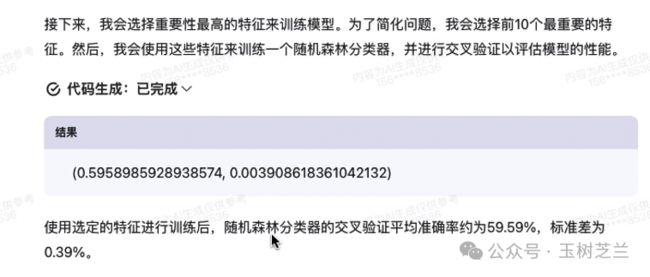

然后它选择了最重要的 10 个特征来训练模型,使用随机森林模型进行交叉验证,并评估了模型的性能。

最后,GLM-4自动解读了结果。随机森林模型的交叉验证平均准确率为59.59%,同时也报告了标准差。

GLM-4 表示,这是一个相对不错的开始,但仍有提升空间。

我特别不喜欢大型模型对我说「你可以这样那样做,来进行改进」。如果我需要自己来做这些,那我还需要你这个人工智能模型来做什么呢?

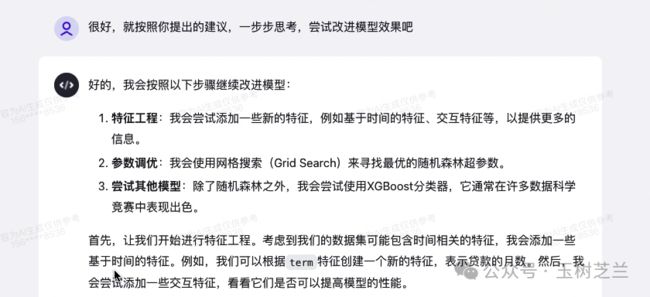

我告诉 GLM-4,好吧,既然你提出了改进的建议,我才不会亲自去执行。请你根据自己的建议,一步一步地思考,尝试改进模型的效果。

GLM-4 开始嘟囔说,我将进行特征工程,添加一些基于时间的特征。

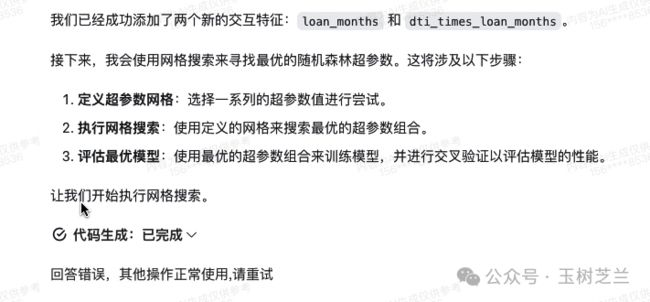

它使用了贷款的月数这一特征,将其纳入分析,以查看是否能提高性能。很快,GLM-4 表示已经成功地添加了两个新的交互特征。

接下来,GLM-4 定义超参数网格并执行网格搜索(Grid search),然后评估最优模型。

可惜,GLM-4 突然停下来,然后说出了错误信息,提示其他操作仍然可以正常使用,并要求重试。

我特意去查看了一下,打开了默认折叠的源代码来看,并没有看到具体的错误信息。

我告诉 GLM-4 继续处理刚才的错误。很快,它又一次报告了错误,并提示其他功能仍可正常使用,请我重试。

可我该如何重试呢?我建议 GLM-4 应该能够提供错误的具体原因。不要只是给我一段代码,然后告诉我说这出错。

在数据分析中,用户的决策主要是为了决定是否继续某个步骤,比如刚才提到的网格搜索。我是否可以在改进特征选择后跳过网格搜索,直接进入下一步。但如果我不知道错误的具体原因,我怎么知道是否值得让 GLM-4 重新尝试?

我建议 GLM-4 应该提供给用户更详细的错误提示信息。至少要告诉我错误的类型和一些简单分析,这样我才不会盲目尝试。

高级联网

接下来咱们尝试的功能名为 “高级联网”。起初我对这个名称感到困惑,不清楚它的具体作用。

后来我了解到,这个功能实际上就是个 Perplexity 。在这个智能体中,GLM-4 可以访问大量资料,并结合强大的语言模型能力来回答问题。

我请它帮我「查找天津师范大学的王树义老师的信息」。GLM-4 显然进行了一些在线搜索,尽管我不确定它使用了哪个搜索引擎。

GLM-4 提供的信息中包含了多处引用链接,第一段就有三个,后面的段落也有。这些信息涵盖了我目前的工作单位和研究领域。它还专门提到了我的教育背景,包括我在南开大学计算机系获得的学士和博士学位,以及我在教育和专业领域的丰富经验。

接着,它描述了我感兴趣的领域,我参与的课题,以及我与张庆薇、张晋合著在《图书情报知识》上发表的论文。

此外,GLM-4 还提到了我在知乎等社交媒体平台上的活跃,分享关于科研工具和技术的见解和经验。「这些活动不仅在教学和科研方面取得了成就,还对学术界和公众产生了积极影响」。我对这些赞誉表示感谢。

特别是,因为 GLM-4 在回答中提供了相应的参考链接,你可以点击直接跳转到相关页面。

接着,我进一步询问:“王树义老师在 B 站上最近发布了哪些视频?” 它首先在线阅读了有关我在 B 站最近视频的信息,然后打开了网页。值得注意的是,GLM-4 确实访问了 B 站,打开了我的个人空间,然后查到了好几个相关的视频网页。

这些视频包括科研 AI 辅助工具 Elicit、卡片笔记工具 Roam Research 以及 Logseq 标签的使用基础,如何使用人工智能阅读论文的 Explain Paper 演示,以及 Roam Research 的成本问题,如何使用语音进行卡片笔记的 一站式 AI 应用 AudioPen 等。在一次查询中,它总共打开了九个网页并进行了总结。

但总结的结果却令人失望。GLM-4 说尽管尝试了多种搜索方式,却未能找到关于我在 B 站上最近发布的视频的具体信息。它表示确实找到了一个我发布的视频,发布日期是 2022 年 10 月 25 日。但对于我在 B 站上最近发布的其他视频未能提供具体信息,并建议我直接访问 B 站搜索我的个人空间。我不禁想问,那刚才你忙活了什么呢?

我检查了 GLM-4 打开的网页,明明找到了符合要求的相关链接,但 GLM-4 却坚称没有找到,令人颇为不解。

小结

GLM-4有些功能确实让人印象深刻。例如绘图功能完成度很高,质量也很好;数据分析方面也做得不错,特别是能够自动生成预测模型,显示出GLM-4在软件包配置和调用执行方面的能力。当分析结果显示准确度不高时,GLM-4还能提供合理的分析和建议。我认为,这对于国内的研究人员,特别是IT和数据科学之外专业的研究生来说,会很有帮助。

GLM-4也有一些地方需要改进。首先是输入文本的长度限制,我希望它能够处理更长的文本,至少超过8000字符的文章扔进去不要报错。其次是错误处理方式。我建议提高GLM-4的稳定性,至少在出现对话崩溃时,不要丢失之前的所有输出。

你尝试过后,对 GLM-4 有什么使用体会?欢迎留言,咱们一起交流讨论。

祝 AI 效率工具使用愉快!

点赞 +「在看」,转发给你身边有需要的朋友。收不到推送?那是因为你只订阅,却没有加星标。

欢迎订阅我的小报童付费专栏,每季度更新不少于10篇文章。订阅一整年价格优惠。

如果有问题咨询,或者希望加入社群和热爱钻研的小伙伴们一起讨论,订阅知识星球吧。不仅包括小报童的推送内容,还可以自由发帖与提问。之前已经积累下的帖子和问答,就有数百篇。足够你好好翻一阵子。知识星球支持72小时内无条件退款,所以你可以放心尝试。

若文中部分链接可能无法正常显示与跳转,可能是因为微信公众平台的外链限制。如需访问,请点击文末「阅读原文」链接,查看链接齐备的版本。

延伸阅读

更长的 GPT-4 对话 token 上限,如何影响我的翻译工作流?

笔记本上就能跑的 LLM 好使吗?GPT4ALL 体验

如何用 GPT-4 全模式(All Tools)帮你高效学习和工作?

如何用自然语言 5 分钟构建个人知识库应用?我的 GPTs builder 尝试

未来的写作长啥样?LEX 用 GPT-3 AI 给你点儿颜色看看