On the Road with GPT-4V(ision): Early Explorations of Visual-Language Model on Autonomous Driving

@[TOC](On the Road with GPT-4V(ision): Early Explorations

of Visual-Language Model on Autonomous Driving)

摘要

对自动驾驶技术的追求取决于感知、决策和控制系统的复杂集成。传统的方法,无论是数据驱动的还是基于规则的,都因无法把握复杂驾驶环境的细微差别和其他道路使用者的意图而受到阻碍。这一直是一个重要的瓶颈,特别是在开发安全可靠的自动驾驶所需的常识推理和细致入微的场景理解方面。视觉语言模型(VLM)的出现代表了实现完全自动驾驶汽车的新前沿。本报告对最新的VLM GPT-4V(Vision)及其在自动驾驶场景中的应用进行了详尽的评估。我们探索模型的能力,理解和推理驾驶场景,作出决定,并最终采取行动的能力的驱动程序。我们的综合测试涵盖了从基本的场景识别到复杂的因果推理和各种条件下的实时决策。我们的研究结果表明,GPT-4V表现出上级性能的场景理解和因果推理相比,现有的自治系统。它展示了在真实的驾驶环境中处理配送外场景、识别意图和做出明智决策的潜力。然而,挑战仍然存在,特别是在方向识别,交通灯识别,视觉基础和空间推理任务。这些局限性突出了进一步研究和开发的必要性。项目现已在GitHub上提供,供感兴趣的各方访问和利用:GitHub添加链接描述

图一:这幅插图展示了从传统自动驾驶管道到GPT-4V等视觉语言模型集成的过渡。这张照片是由DALL·E3生成的。

1.介绍

1.1Motivation and Overview

长期以来,对全自动驾驶汽车的追求一直受到依赖于感知、决策和规划控制系统的管道的限制。传统的方法,无论是基于数据驱动的算法还是基于规则的方法,都在几个关键领域存在不足。具体来说,他们表现出的弱点,准确地感知开放词汇的对象,并努力解释周围的交通参与者的行为意图。其原因在于传统方法只能描述有限采集数据的抽象特征或根据预定规则处理问题,而它们缺乏处理罕见但重要的角落情况的“常识”,并且无法从数据中总结驾驶相关知识以进行细致入微的场景理解和有效的因果推理。

大型语言模型(LLM)的出现,例如GPT-3.5 [12],GLM [7,24],Llama [18,19]等,在解决这些问题方面显示出了一线希望。LLM配备了基本的常识推理形式,从而在理解复杂的驾驶场景方面显示出希望。然而,它们在自动驾驶中的应用主要局限于决策和规划阶段[8,20,5,11]。这种限制是由于它们固有的无法处理和理解视觉数据,而视觉数据对于准确感知驾驶环境和安全驾驶车辆至关重要。

GPT-4V [15,16,13,22]是一种前沿的视觉语言模型(VLM),它的最新发展为研究和开发开辟了新的前景。与其前身(GPT-4 [14])不同,GPT-4V具有强大的图像理解能力,标志着在缩小自动驾驶技术的感知差距方面迈出了重要一步。这一新发现的优势提出了一个问题:GPT-4V能否作为提高自动驾驶中场景理解和因果推理的基石?

在本文中,我们的目的是回答这个关键问题进行详尽的评估GPT-4V的能力。我们的研究深入研究了模型在自动驾驶领域内场景理解和因果推理的复杂方面的表现。通过详尽的测试和深入的分析,我们阐明了GPT-4V的功能和局限性,预计将为研究人员在自动驾驶行业中探索潜在的未来应用提供宝贵的支持。

我们对GPT-4V的能力进行了难度越来越大的测试,从场景理解到推理,最后在真实驾驶场景中测试其作为驾驶员的持续判断和决策能力。我们对GPT-4V在自动驾驶领域的探索主要集中在以下几个方面:

1.情景理解:该测试旨在评估GPT-4V的基本识别能力。它涉及识别驾驶时的天气和照明条件,识别各国的交通信号灯和标志,以及评估不同类型相机拍摄的照片中其他交通参与者的位置和行动。此外,出于好奇心,我们探索了不同视角的模拟图像和点云图像。

2.推理:在测试的这一阶段,我们深入研究了在自动驾驶环境中评估GPT-4V的因果推理能力。这项评价包括几个关键方面。首先,我们仔细研究了它在处理复杂的角落情况下的性能,这通常会挑战数据驱动的感知系统。其次,我们评估了它在提供环绕视图方面的能力,这是自动驾驶应用中的一个重要功能。鉴于GPT-4V无法直接处理视频数据,我们利用连接的时间序列图像作为输入,以衡量其时间相关性的能力。此外,我们还进行了测试,以验证其将真实场景与导航图像相关联的能力,进一步检查其对自动驾驶场景的整体理解。

3.充当司机:为了充分发挥GPT-4V的潜力,我们赋予它经验丰富的驾驶员角色,让它根据环境在真实的驾驶情况下做出决策。我们的方法涉及以一致的帧速率对驾驶视频进行采样,并逐帧将其馈送到GPT-4V。为了帮助其做出决策,我们提供了重要的车辆速度和其他相关信息,并传达了每个视频的驾驶目标。我们要求GPT-4V采取必要的行动,并为其选择提供解释,从而在现实驾驶场景中突破其能力的界限。

总之,我们提供了初步的见解,作为激励未来GPT-4V自动驾驶领域研究工作的基础。基于上述信息,我们使用独特且引人入胜的图像-文本对汇编,有条不紊地构建并展示了我们调查的定性结果。虽然这种方法可能不那么严格,但它提供了进行全面分析的机会。

1.2 Guidance

本文重点介绍自动驾驶领域的测试,采用精选的代表不同驾驶场景的图像和视频。测试样本来自各种渠道,包括开源数据集,如nuScenes [3],Waymo Open数据集[17],Berkeley Deep Drive-X(eXplanation)Dataset(BDD-X)[9],D2-city [4],Car Crash Dataset(CCD)[2],TSDD [1],CODA [10],ADD [21]以及DAIR-V2X [23]和CitySim [25]等V2X数据集。此外,一些样本来自CARLA [6]仿真环境,其他样本来自互联网。值得注意的是,测试中使用的图像数据可能包括时间戳截至2023年4月的图像,可能与GPT-4V模型的训练数据重叠,而本文中使用的文本查询完全是重新生成的。

本文中详细描述的所有实验均在2023年11月5日之前进行,使用网络托管的GPT-4V(Vision)(9月25日版本)。我们承认,最新版本的GPT-4V在11月6日OpenAI DevDay之后获得了更新,与我们的测试结果相比,当呈现相同的图像时,可能会产生不同的响应。

2.Basic Capability of Scenario Understanding

为了实现安全有效的自动驾驶,一个基本的先决条件是对当前场景的透彻理解。复杂的交通场景包括无数的驾驶条件,每个驾驶条件都有各种各样的交通参与者。对这些元素的准确识别和理解是自动驾驶汽车做出明智和适当驾驶决策的基本能力。在本节中,我们提出了一系列旨在评估GPT-4V理解交通场景的能力的测试。我们专注于两个主要方面:模型对周围环境的理解及其识别各种交通参与者的行为和状态的能力。通过这些评估,我们的目标是揭示GPT-4V的能力,在解释动态交通环境。

2.1 Understanding of Environment

在评估GPT-4V理解周围环境的能力时,我们进行了一系列测试,包括以下关键方面:识别时间的能力,对主要天气条件的理解,以及识别和解释交通信号灯和标志的能力。这些要素在塑造自动驾驶系统的决策过程中具有至关重要的意义。例如,很明显,在夜间或在具有挑战性的天气条件下驾驶需要高度的谨慎,而在白天或在有利的天气条件下,可以采用更悠闲的驾驶策略。此外,交通信号灯和道路标志的正确解释对于自动驾驶系统的有效性至关重要。在本节中,我们使用车辆的 前视图像 作为主要的视觉输入。这里使用的视觉数据来自nuScenes [3],D2-city[4],BDD-X [9]和TSDD [1]。

一天中的时间理解。我们评估GPT-4V的理解时间差异的能力,通过提供白天和夜间的图像。我们指示模型描述这些图像中描绘的交通场景,结果如图2所示。研究结果表明,当呈现白天场景时,GPT-4V成功地将其识别为具有“中等交通”的多车道城市道路。此外,该模型熟练地认识到存在的人行横道上的道路。当面对类似的夜间场景时,GPT-4V的表现甚至更好。它不仅能分辨出时间是“黄昏还是傍晚”,还能检测到远处尾灯亮着的车辆,并推断出“它要么静止不动,要么正在远离你”。

图2:在一天中全面理解时间的能力的结果。绿色突出了理解中的正确答案。查看第2.1节的详细讨论。

图3:识别车辆行驶季节的结果。绿色突出了理解中的正确答案。有关详细讨论,请参阅第2.1节

天气理解天气是影响驾驶行为的重要环境因素。我们从nuScenes [3]数据集中选择了在不同天气条件下在同一个十字路口拍摄的四张照片。我们让GPT-4V负责识别这些图像中描绘的天气状况。结果如图3所示。结果表明,GPT-4V在识别每幅图像中的天气状况(即多云、晴天、阴天和雨天)方面具有显著的准确性。此外,它为这些结论提供了合理的理由,引用了诸如阳光阴影或街道潮湿等因素。

图4:理解红绿灯能力的结果。格林强调了理解中的正确答案。有关详细讨论,请参阅第2.1节。

图5:理解交通灯的能力的结果。绿色表示理解上的正确答案,红色表示理解上的错误答案。查看第2.1节的详细讨论。

交通灯理解交通信号灯的识别在自动驾驶系统的功能中起着关键作用。不正确识别或错过交通信号灯不仅会导致违反交通法规,而且会造成交通事故的严重风险。不幸的是,GPT-4V在该测试中的性能福尔斯不足,如图4和图5所示。在图4中,GPT-4V展示了区分黄色路灯和红色交通灯的能力,特别是在夜间条件下。然而,在图5中,当面对一个较小的交通灯,在图像的远处有一个倒计时计时器时,GPT-4V错误地将倒计时识别为红色,并忽略了真正的2秒红色倒计时。只有当交通灯被放大到占据图像的重要部分时,模型才能提供正确的响应。此外,GPT-4V在随后的测试中出现了错误识别交通信号灯的情况,这对于成熟的自动驾驶系统来说是不可接受的。

交通标志理解交通标志包含司机需要遵守的各种规则和指示。自动驾驶系统可以通过识别交通标志来理解并遵守这些规则,从而降低交通事故的风险,提高驾驶安全性。因此,我们选择了来自新加坡和中国的代表性图像进行测试。从图6中的左侧示例可以看出,该模型可以识别大多数道路标志,包括附近的“SLOW”和远处的高度限制“4.5m”,但它错误地识别了“Speed Bump”标志。右边样本中的三个符号都被正确识别。这表明GPT-4V具有值得称赞的识别交通标志的能力,但仍有进一步改进的余地。

2.2 Understanding of Traffic Participants

准确理解交通参与者的状态和行为是驾驶的基础。现有的自动驾驶系统通常使用各种摄像头和传感器来感知交通参与者,以便获得关于他们的更全面的信息。在本节中,我们评估了GPT-4V使用各种传感器输入(包括2D图像、3D点云可视化以及从V2X设备和自动驾驶模拟软件获取的图像)理解交通参与者行为的能力。这里使用的视觉数据来自nuScenes [3],ADD [21],Waymo [17],DAIR-V2X [23],CitySim [25]和Carla [6]模拟。

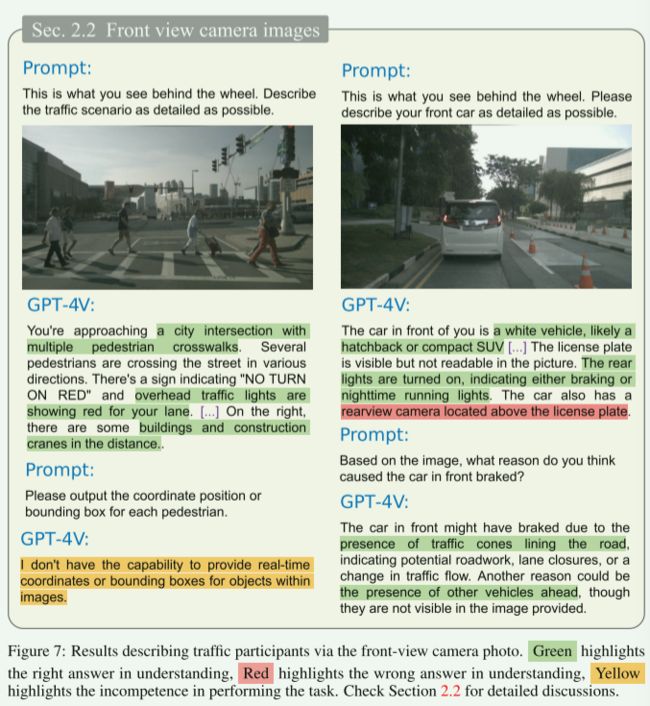

前视图相机照片。为了测试模型的基本识别能力,包括交通参与者识别和车辆计数,我们输入了一系列的驾驶场景的前视图,并获得了GPT-4V的输出结果。从图7的左侧可以看出,该模型可以完整准确地描述驾驶场景:它可以识别行人,交通标志,交通灯状态和周围环境。图7的右侧显示,模型可以识别车辆类型及其尾灯,并可以猜测其打开尾灯的意图。但是,模型在不相关的地方输出了一些不正确的语句,例如认为前面的汽车有后视摄像头。在图8中,对GPT-4V的计数能力进行了测试。

图7:通过前视摄像头照片描述交通参与者的结果。绿色表示理解上的正确答案,红色表示理解上的错误答案,黄色表示执行任务上的无能。查看第2.2节的详细讨论。

图8:通过前视摄像头照片描述交通参与者的结果。绿色表示理解上的正确答案,红色表示理解上的错误答案,黄色表示结果正确但细节错误。查看第2.2节的详细讨论。

利用白天和夜间快照从车辆的前视图,该模型精确地吻合车辆的存在和它们的状态在日光捕捉。相比之下,在夜间条件下,尽管GPT-4V准确地列举了可识别的车辆,但其对每辆车的详细描述有时会达不到福尔斯的准确性。

鱼眼相机照片。鱼眼相机是自动驾驶汽车系统中常用的成像设备,也被用来评估GPT-4V的感知能力。图9中记录了从鱼眼透镜捕获的图像得出的结果。GPT-4V对独特的鱼眼失真表现出令人印象深刻的鲁棒性,并对室内停车环境表现出值得称赞的理解。它可以可靠地识别停放的车辆和附近的行人,尽管有幻觉描述一个不存在的充电站。此外,当被问及用于拍摄照片的潜在设备时,GPT-4V准确地将其识别为鱼眼相机的作品。

图9:通过鱼眼相机拍摄的照片描述交通参与者的结果。绿色表示理解上的正确答案,红色表示理解上的错误答案。查看第2.2节的详细讨论。

点云可视化图像。出于好奇,我们捕获了64线LiDAR点云的两个截图,一个是鸟瞰图,另一个是正视图。虽然在二维图像上压缩点云不可避免地会丢失三维几何信息,但仍然可以识别和分类一些显著特征。测试如图10所示。随后,我们将这两幅图像输入GPT-4V,令我们惊讶的是,它显示出识别其中某些道路和建筑物模式的能力。由于模型以前很少看到这种类型的数据,因此它不可避免地假设鸟瞰图中的圆形图案代表环形交叉路口或中心广场。此外,当负责识别车辆时,该模型在估计场景中的车辆数量方面基本上是成功的。我们还观察到前视图中的计数错误,这是由于某些车辆的轮廓不完整且难以辨别而导致的。通过该试验,证明了该模型处理非常规数据的强大能力。

V2X设备照片。V2X是Vehicle-to-Everything的缩写,它包含一系列技术,使车辆不仅能够相互通信,还能够与基础设施和各种其他实体进行通信。V2X摄像头在捕捉和处理视觉信息方面发挥着关键作用,是这个互联生态系统的一部分。在图11中,我们展示了GPT-4V针对无人机视图照片和两个交叉摄像机图像生成的响应。GPT-4V在所有三种情况下都表现出值得称赞的性能。在无人机视图中,GPT-4V准确地识别出两个方向的高速公路,并识别出位于照片右侧的入口匝道。在十字路口V2X设备视图中,响应识别图像中包含汽车、骑自行车者和行人的混合交通流,以及准确的交通灯识别。

图11:通过V2X设备的照片描述交通参与者的结果。绿色表示理解上的正确答案,红色表示理解上的错误答案。查看第2.2节的详细讨论。

在CARLA模拟器中拍摄的图像。在自动驾驶研究和开发领域,像CARLA这样的模拟器是非常宝贵的工具,它提供了一个可控的虚拟环境,在此可以测试、训练和改进算法,然后再将其部署到现实道路上[6]。我们在CARLA的Town 10地图中拍摄了一系列图像,使用Ego汽车作为主要视点。随后,我们根据这些图像提出了几个问题,结果如图12所示。GPT-4V不仅可以识别这些图像来自模拟软件,还可以展示出对其中虚拟车辆和行人的高度认识。此外,在模拟行人闯红灯的罕见情况下,GPT-4V在其响应中适当地承认了这种情况。然而,值得注意的是,该模型在模拟中仍然难以识别交通信号灯,比如将红灯误认为黄灯。

图12:通过CARLA模拟器中拍摄的图像描述交通参与者的结果。绿色表示理解上的正确答案,红色表示理解上的错误答案。查看第2.2节的详细讨论。

3.Advanced Capability of Reasoning(高级推理能力)

推理是正确驾驶行为的另一个重要特征。由于交通环境的动态性和不可预测性,驾驶员经常会遇到一系列意想不到的事件。熟练的驾驶员在面对这种不可预见的情况时,必须利用他们的经验和常识做出准确的判断和决定。在本节中,我们进行了一系列测试,以评估GPT-4V对意外事件的反应及其在动态环境中导航的能力。

3.1 Corner Cases

在正在进行的自动驾驶研究中,增强系统处理突发事件能力的常用方法是通过持续收集数据。然而,鉴于驾驶环境的动态性、连续性和随机性,所收集的数据只能近似其边界,但永远无法完全封装它,即意外事件是不可避免的。具备常识的人类驾驶员通常能够即兴发挥,并在这些不可预见的情况下安全驾驶。这凸显了不仅要将数据驱动的方法,还要将推理和常识的原则纳入自动驾驶系统的重要性。这里使用的视觉数据来自CODA [10]和互联网。

在本节中,我们精心策划了一组感知角案例,以评估模型的常识推理能力。这些例子故意包括脱离典型分布的物体,通常对传统的感知系统构成挑战,并在决策规划中造成困难。现在,让我们来看看GPT-4V在解决这些问题方面的表现。

在图13的左侧,GPT-4V可以清楚地描述不常见的车辆的外观,地面上的交通锥,以及车辆旁边的工作人员。在识别这些条件后,模型意识到自我汽车可以稍微向左移动,与右侧的工作区域保持安全距离,并谨慎驾驶。在右边的示例中,GPT-4V熟练地识别复杂的交通场景,包括橙子工程车辆、人行道、交通灯和骑自行车的人。当被问及其驾驶策略时,它表达了与工程车辆保持安全距离的意图,并在其通过时执行平稳加速,同时认真观察行人的存在。

图13:GPT-4V在极端情况下做出正确决策的能力的图示。绿色突出了理解中的正确答案。查看第3.1节的详细讨论。

在图14的左侧,GPT-4V可以准确识别出一架飞机在道路上紧急降落,当局正在附近处理情况。对于传统的感知算法来说,如果没有特定的训练,很难识别。在这些条件下,模型知道它应该减速并打开危险灯,同时等待许可通过飞机,然后恢复正常驾驶。在右边的例子中,GPT-4V可以准确识别水泥搅拌车和前方的红灯。它认识到与领头卡车保持安全距离的重要性,直到红灯转变为绿色,此时它继续行驶。

图14:GPT-4V在极端情况下做出正确决策的能力的图示。绿色突出了理解中的正确答案。查看第3.1节的详细讨论。

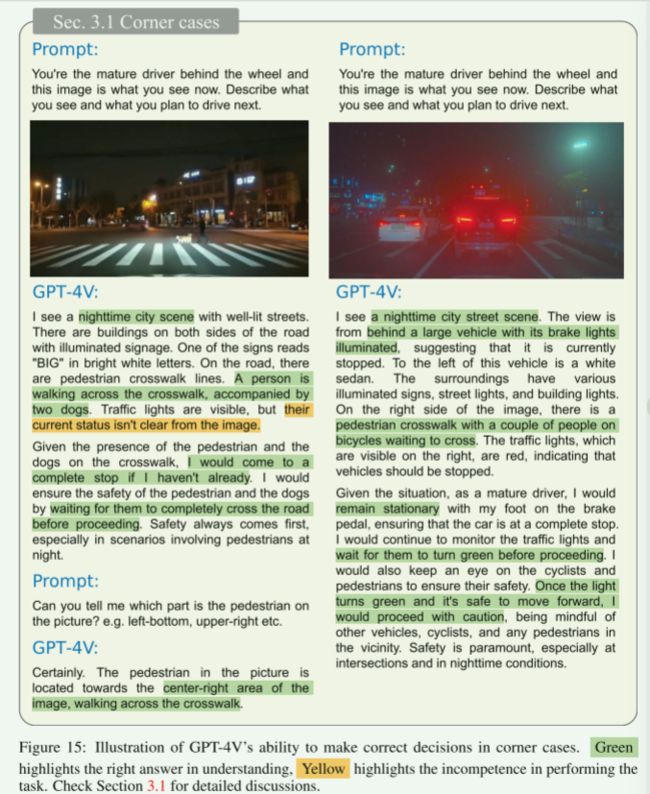

在图15的左侧,GPT-4V描述了一个场景,其中一个行人伴随着两只狗正在穿过人行横道,位于图像的中心右侧区域。值得注意的是,该模型准确地计算了在场的狗的数量。该模型得出的结论是,车辆应该耐心等待行人和狗清理道路,然后再继续行驶,尽管它仍然无法确定交通灯的状态。值得一提的是,这并不是GPT-4V第一次发生此类事件。右图描绘了夜间交通场景,这是GPT-4V很好地识别的。在这种情况下,模型敏锐地辨别出前方车辆亮起的刹车灯,并注意到行人和骑自行车的人的存在,耐心地等待过马路。它聪明地推断出,它应该保持静止,直到交通信号变成绿色,在继续它的旅程时保持应有的谨慎。

图15:GPT-4V在极端情况下做出正确决策的能力的图示。绿色表示理解上的正确答案,黄色表示执行任务上的无能。查看第3.1节的详细讨论。

3.2 Multi-view Images

通过使用多视角摄像头,GPT-4V可以捕捉驾驶环境的全面视图。精确解释这些相机与图像内重叠区域之间的空间关系对于模型有效利用多视图相机系统的潜力至关重要。在本节中,我们将评估GPT-4V在处理多视图图像方面的能力。本节中的所有数据都来自nuScenes [3]数据集。

在图16中,我们选择了一组周围的图像,并将它们以正确的顺序输入到模型中。该模型能够熟练地识别场景中的各种元素,如建筑物、车辆、障碍物和停车场。它甚至可以从重叠的信息中推断出场景中有两辆汽车,一辆白色SUV位于前方,一辆卡车和一辆拖车位于右侧。虽然该模型的性能一般是令人印象深刻的,一个微不足道的错误是错误识别的行人过街。

图16:GPT-4V推断多视图图像之间关系的能力的图示。绿色突出了理解中的正确答案。查看第3.2节的详细讨论。

在图17所示的另一个实验中,我们类似地采用一组组合的周围图像进行测试。虽然该模型设法提供了对场景的大致准确的描述,但它也出现了一些识别错误,特别是在车辆的数量和形状方面。值得注意的是,该模型产生了一些令人困惑的错觉,例如认为图片上有左转标志。我们假设这些问题可能是由于模型有限的空间推理能力造成的。

图17:GPT-4V推断多视图图像之间关系的能力的图示。绿色表示理解上的正确答案,红色表示理解上的错误答案,黄色表示执行任务上的无能。查看第3.2节的详细讨论。

最后,在图18中,我们展示了正确的前视图,并尝试让GPT-4V识别和排序无序的周围图像。尽管模型执行了大量似乎有意义的分析和推理,但它最终仍然输出了所有错误的答案。很明显,该模型在建立相邻图像之间的连接方面遇到了挑战。我们认识到这项任务的复杂性。

图18:GPT-4V推断多视图图像之间关系的能力的图示。红色表示理解上的错误答案。查看第3.2节的详细讨论。

3.3 Temporal Sequences

在本节中,我们评估GPT-4V在理解时间图像方面的能力。我们的方法包括利用第一人称驾驶视频中的多个序列。从每个视频片段中,我们提取四个关键帧,用序列号标记它们,并将它们联合收割机组合成单个图像以供输入。随后,我们要求GPT-4V描述在这段时间内发生的事件,以及自我车辆采取的行动及其背后的原因。这些示例来自nuScenes [3],D2-city和Carla [6]模拟。

图19显示了在CARLA的10号镇地图中捕获的视频,其中GPT-4V清楚地解释了由于行人过马路而在人行横道上停下来的自我汽车的动作,就在交通信号灯变红之前。

图19:GPT-4V理解时间序列图像的能力的图示。绿色突出了理解中的正确答案。查看第3.3节的详细讨论。

图20展示了从NuScene数据集[3]中提取的视频片段。在捕获关键帧的过程中,我们分别将标签“1”和“2”分配给领先的SUV和行人。GPT-4V不仅能准确地回答有关这些标签所代表的物体的询问,还能全面解释前面的SUV和行人之间的相互作用。这种相互作用需要行人过马路,而白色SUV则让出通行权。

图20:GPT-4V理解时间序列图像的能力的图示。绿色突出了理解中的正确答案。查看第3.3节的详细讨论。

图22中描绘的视频序列展示了由雨引起的明显的相机闪光。尽管如此,GPT-4V熟练地识别十字路口信号灯和前尾灯。它还推断了红灯变绿色后前车启动的语义信息。然而,重要的是要注意,GPT-4V并不总是能够准确地完全分析时间驾驶场景。

如图21所示,该视频片段捕捉到车辆进行车道变换以超越前方的踏板车。令人遗憾的是,GPT-4V错误地解释了踏板车的行动,好像它是在车辆前面穿过车道,并将车辆的行为误认为是减速以屈服于踏板车。这强调了GPT-4V在时间视频上下文中的空间推理的局限性。同样在图22中,GPT-4V再次将绿色灯误识别为红灯。

图21:GPT-4V理解时间序列图像的能力的图示。绿色表示理解上的正确答案,红色表示理解上的错误答案。查看第3.3节的详细讨论。

图22:GPT-4V理解时间序列图像的能力的图示。绿色表示理解上的正确答案,红色表示理解上的错误答案。查看第3.3节的详细讨论。

3.4 Visual-Map Navigation

在实际驾驶场景中,驾驶员经常利用来自外部设备的辅助信息来增强其决策。例如,地图应用程序可以提供有关道路几何形状和路线指导的详细信息,使驾驶员能够做出更明智和理性的驾驶决策。在本节中,我们为GPT-4V配备了前视摄像头图像和来自地图软件的相应导航信息。这种设置允许GPT-4V描述场景并做出明智的决定,反映了人类驾驶员在类似情况下的方式。

如图23所示,GPT-4V使用前视摄像头和地图APP信息准确定位其位置,随后执行正确的左转机动。它利用前视摄像头对道路状况进行合理评估,并结合地图软件提供的速度信息,提供适当的驾驶建议。

图23:GPT-4V获取信息能力的图示结合了地图APP上的导航和前视摄像头图像。绿色突出了理解中的正确答案。查看第3.4节的详细讨论。

如图24所示,即使在更复杂的情况下,GPT-4V也能够准确地定位自身。然而,在这种特殊情况下,它错误地决定左转。尽管如此,GPT-4V还是展示了基于前视摄像头识别路边停放的汽车和商店信息的熟练程度。它还正确地从地图软件中获得了速度和距离信息。

图24:GPT-4V获取信息能力的图示结合了地图APP上的导航和前视摄像头图像。绿色突出了理解中的正确答案。查看第3.4节的详细讨论。

4.Act as A Driver

自动驾驶算法的最终目标是复制人类驾驶员的决策能力。实现这一目标需要精确识别,空间意识,并深入了解各种交通要素之间的时空关系。在本节中,我们通过测试GPT-4V在五种不同的现实驾驶场景中的决策能力,来评估其在自动驾驶方面的全部潜力。这些场景包括不同的交通状况、一天中的不同时间和多种驾驶任务。在评估过程中,提供了自车速度和其他相关信息,并希望GPT-4V产生的观察和驾驶行动。通过这些精心设计的评估,我们的目标是推动GPT-4V在现实驾驶场景中的能力,揭示其作为未来自动交通驱动力的潜力。

4.1 Driving in Parking Lot

在本节中,我们测试了GPT-4V在封闭区域内的驾驶决策能力。选择的场景是右转离开停车场,这需要通过安全检查。如图25所示,在第一帧中,GPT-4V准确识别影响驾驶的关键要素,如行人和车灯。然而,GPT-4V对于行人和远处车辆的状态具有模糊性。因此,它通过保持低速并准备停车来提供保守的驾驶决策。在第二帧中,GPT-4V检测到行人已经离开,但错误地提到了斑马线的信息。它仍然遵循谨慎的右转驾驶策略。在第三帧中,GPT-4V可以准确地识别诸如门控检查站、警卫亭和围栏等元素,推断车辆正在接近出口并准备停车接受安全检查。在第四帧中,GPT-4V正确识别出安全检查站现在完全打开,因此我们可以安全地离开停车场。

图25:GPT-4V在停车场行驶能力的示意图。绿色突出了理解中的正确答案。红色表示理解上的错误答案。黄色突出了在执行任务时的无能。查看第4.1节的详细讨论。

此外,GPT-4V还可以定位出口区域附近的行人,并建议等待他们安全通过后再慢慢离开。从这个例子中,GPT-4V可以准确地识别封闭区域(如停车场)内的关键元素,包括门控检查站,警卫亭和围栏。此外,GPT-4V了解离开停车场的驾驶程序,这需要等待安全检查并注意行人和车辆。但仍可能出现一些误判,比如错误地提到斑马线。

4.2 Turning at Traffic Intersection

在本节中,我们评估GPT-4V在交通路口的转弯能力。如图26所示,所选场景是交通繁忙的十字路口。在第一帧中,GPT-4V观察到交通灯为绿色,并推断驾驶动作为继续左转。在第二帧中,由于距离和有限的感知场,GPT-4V认为交通灯是不可见的,但它观察到前面的车辆根据它们的尾灯刹车。因此,它的驱动策略是保持目前的位置。在第三帧中,GPT-4V误认为交通灯的状态,认为不允许转弯。在第四帧中,GPT-4V仍然错误的交通灯状态。最后的决定是谨慎左转,同时通过避免与其他车辆和行人碰撞来确保安全。

图26:GPT-4V在交通路口转弯能力的示意图。绿色突出了理解中的正确答案。红色表示理解上的错误答案。查看第4.2节的详细讨论。

本例显示了在十字路口转弯时,GPT-4V会注意交通信号灯和其他车辆的尾灯等各种信息。然而,GPT-4V的能力,以确定在长距离(如遥远的交通灯)的小物体的状态是穷人,这可能会影响其在十字路口的行为决策。

4.3 Turning at Highway Ramp

在本节中,我们测试GPT-4V在高速公路区域行驶的能力。如图27所示,我们选择了一个具有挑战性的场景,其中车辆需要在夜间执行高速公路匝道转弯。在第一帧中,GPT-4V准确地识别出箭头标志和分隔车道线,并从前车的红色尾灯推断出它正在减速。因此,自我车辆应该减速并遵循车道线。在第二帧中,虽然GPT-4V弄错了前面车辆的数量,但它精确地定位了车道线和路标,指示前方左转。因此,GPT-4V建议轻踩刹车,并向左发出信号通知其他司机。在第三帧中,由于夜间能见度有限,GPT-4V仅定位黄色分道器。因此,它建议使用这些分隔线作为参考,在车道线内缓慢驾驶。在第四帧中,GPT-4V准确地确定自我车辆已经进入主公路道路,并观察到其右侧的潜在合并车辆。因此,它决定调整高速公路行驶的速度,同时偶尔在法律的限制内激活远光灯,以扩大夜间能见度范围。

图27:GPT-4V在高速公路坡道转弯能力的图示。绿色突出了理解中的正确答案。红色表示理解上的错误答案。黄色突出了在执行任务时的无能。查看第4.3节的详细讨论。

从这个例子中,我们可以看到,当在高速公路区域行驶时,GPT-4V会跟随路标行驶,并根据周围车辆的状态辅助决策。然而,它在夜间的物体识别和定位方面存在局限性。

4.4 Road Merging

在本节中,我们将评估GPT-4V的车道合并能力。如图28所示,所选场景是在夜间离开主干道并并入坡道。在第一帧中,GPT-4V准确识别车道标记,并确定当前车道正在结束或合并。于是,它决定减速,准备并入右转车道。在此过程中,它错误地识别出附近的医院标志,并谨慎地考虑注意附近的行人和紧急车辆。在第二帧中,GPT-4V正确识别了合并点,并建议平稳地转向车道。在第三帧中,基于车道的变化,GPT-4V预测并道即将结束,同时提醒我们小心其他车辆切入。在第四帧中,GPT-4V确定其已成功并入道路。然而,它错误地检测到一条白色实线,并错误地认为摩托车在同一车道上。最后给出的决定是,注意主干道上的摩托车,必要时调整速度或变道。

图28:GPT-4V并入其他道路的能力示意图。绿色突出了理解中的正确答案。红色表示理解上的错误答案。黄色突出了在执行任务时的无能。查看第4.4节的详细讨论。

从这个例子中可以看出,GPT-4V可以通过观察车道的变化并提供合理的驾驶建议来评估当前的合并进度。然而,在夜间误判路标和车道的可能性仍然增加。总的来说,GPT-4V在车道合并方面倾向于采取保守的方法。

4.5 U-Turning at Traffic Intersection

在本节中,我们将测试GP-4V的U形转弯能力。如图29所示,我们选择在夜间交通繁忙的十字路口执行U形转弯的场景。在第一帧中,GPT-4V准确识别前方其他车辆并提醒本车保持距离,但省略了远处的红绿灯。在第二帧中,GPT-4V仍然无法定位交通灯,但从周围车辆的行为推断可能有控制十字路口的信号。它建议放慢速度,为进入U形转弯做准备。在第三帧中,GPT-4V忽略了时间和空间背景,并将支路上的交通灯误认为是其当前车道的控制信号。因此,它决定继续停止。在第四帧中,GPT-4V仍然错误的交通灯,导致保持静止的位置作为其策略。

图29:GPT-4V在交通路口掉头的能力示意图。绿色突出了理解中的正确答案。红色表示理解上的错误答案。黄色突出了在执行任务时的无能。查看第4.5节的详细讨论。

从这个例子中,我们可以看到,当遇到重大变化的道路结构,如掉头,GPT-4V往往忽略了时间和空间的上下文关系。尽管如此,提供的总体驾驶策略相当保守。

通过上述五项测试,可以观察到GPT-4V已经初步获得了类似于人类驾驶员的决策能力。它可以联合收割机组合各种业务单元的状态(例如,行人、车辆、交通灯、路标、车道),以提供最终的驾驶策略。此外,GPT-4V可以在停车场,十字路口,高速公路和坡道等各种驾驶场景中做出合理的决策。总的来说,GPT-4V表现出对规则和安全意识的强烈遵守,并具有相对保守的驾驶策略。但是,它的驾驶性能仍然存在局限性。例如,它很难确定远处物体(车辆、交通灯)的状态,而且它的感知范围在夜间受到限制。这些限制会影响进一步的驾驶决策。此外,GPT-4V的时空上下文推断能力仍然有限(例如,GPT-4V在有多个红绿灯的掉头场景中会混淆)。

5.总结

5.1 Capabilities of GPT-4V in Autonomous Driving

在本文中,我们对GPT-4V在各种自动驾驶场景中进行了全面和多方面的评估。结果表明,GPT-4V在场景理解、意图识别和驾驶决策等方面具有超越现有自动驾驶系统的潜力。

在极端情况下,GPT-4V利用其先进的理解能力来处理分布外的场景,并可以准确地评估周围交通参与者的意图。GPT-4V利用多视图图像和时间照片来实现对环境的完整感知,准确识别交通参与者之间的动态交互。此外,它还可以推断出这些行为背后的潜在动机。正如第4节所强调的,我们还见证了GPT-4V在开放道路上做出连续决策的性能。它甚至可以以类似人类的方式解释导航应用程序的用户界面,帮助和指导驾驶员的决策过程。

总的来说,GPT-4V的性能证明了视觉语言模型(VLM)在解决自动驾驶领域复杂挑战方面的巨大潜力。

5.2 Limitations of GPT-4V in Autonomous Driving

然而,在我们的测试中,我们还发现GPT-4V在以下任务上表现不佳:

区分左右:如图17所示,有些情况下模型难以识别方向,这是自主导航的一个关键方面。在图8和图21中也观察到类似的问题。这些数字突出了模型在解释复杂路口或做出换道决定时偶尔出现的混乱。

交通灯识别:在图12、15、22、26和29中观察到问题。我们怀疑这个问题是由于包含在完整的图像中的广泛的语义信息,导致在交通灯的嵌入信息的损失。当图像中的交通灯区域被裁剪并单独输入时,模型能够成功识别,如图5所示。

Vision Grounding tasks:如图7所示,GPT-4V发现很难指定像素级坐标或边界框,只能指示图像中的近似区域。

空间推理:准确的空间推理对于自动驾驶汽车的安全操作至关重要。无论是如图18所示的多视图图像的拼接,还是如图21所示的踏板车和自动驾驶汽车之间的相对位置关系的估计,GPT-4V都难以做出精确的判断。这可能源于基于二维图像输入理解和解释三维空间的固有复杂性。

此外,模型对非英语交通标志的解释也存在问题,这在标志上使用多种语言的地区构成了挑战。在拥挤的环境中,重叠的对象可能会发生计数交通参与者的准确性也被认为是不太可靠的。

总之,上述局限性表明,即使是最先进的视觉语言模型(VLM)目前表现出的基本方向识别和交通灯识别的缺陷,以及缺乏3D空间推理能力。此外,VLM很难在各种场景中准确定位关键实体,这表明它们还不是现有自动驾驶管道中使用的感知方法的合适替代品。然而,值得注意的是,VLM表现出对流量常识的深刻理解,以及在非分布情况下的强大泛化能力。展望未来,一个关键的发展领域将是将VLM固有的常识知识与传统的自动驾驶感知技术相结合。此外,确保VLM输出的安全性和可靠性仍然是一个重要的持续挑战。