自动驾驶中的4D毫米波雷达:综述

自动驾驶中的4D毫米波雷达:综述

摘要

4D毫米波(mmWave)雷达能够测量目标的距离、方位、俯仰和速度,因此在自动驾驶领域引起了相当大的关注。这归功于其在极端环境中的强大鲁棒性以及出色的速度和俯仰测量能力。然而,尽管与其感知理论和应用相关的研究迅速发展,但关于4D毫米波雷达的综述仍然明显缺乏。为填补这一空白,促进该领域未来的研究,本文提出了关于4D毫米波雷达在自动驾驶中的综合综述。首先对4D毫米波雷达的理论背景和进展进行综述,包括信号处理流程、分辨率改进方法、外参标定过程和点云生成方法。然后介绍了自动驾驶感知、定位和地图任务中使用的相关数据集和应用算法。最后,本文通过预测4D毫米波雷达领域的未来趋势来总结。据我们所知,这是专门针对4D毫米波雷达的首个综述。

I. 引言

自动驾驶技术旨在提供安全、便利和舒适的交通体验,正在迅速发展。为实现高级别的自动驾驶,环境感知、定位和地图绘制等能力至关重要。因此,自动驾驶车辆上的传感器,如摄像头、激光雷达和雷达,以及它们的算法,越来越受到研究的关注。

在各种传感器中,毫米波雷达以其小巧、低成本、全天候运行、测速能力和高距离分辨率等优势而被广泛用于自动驾驶[1]。然而,传统的毫米波雷达,也被称为3D毫米波雷达,在测量目标高度方面表现较差,其数据通常仅包括距离、方位和速度信息。此外,3D毫米波雷达受到杂波、噪声和低分辨率的影响,特别是在角向维度上,这进一步限制了它们在复杂感知任务中的适用性。

多输入多输出(MIMO)天线技术的最新进展提高了仰角分辨率,引发了4D毫米波雷达的出现。顾名思义,4D毫米波雷达可以测量四种类型的目标信息:距离、方位、仰角和速度。

4D毫米波雷达不仅是毫米波雷达的改进版本,还引入了许多重要的研究课题。4D毫米波雷达的原始数据大小远远大于传统雷达的数据大小,这给信号处理和数据生成带来了挑战,更不用说杂波和噪声了。与激光雷达点云相比,现有信号处理流程中生成的4D毫米波雷达点云的稀疏性和噪声更为严重,因此需要仔细设计能够考虑4D毫米波雷达固有特性的感知、定位和地图绘制算法。

研究人员对毫米波雷达的理论和应用进行了许多调查。近年来,Bilik等人[2]回顾了毫米波雷达在自动车辆和未来趋势中的挑战。Venon等人[3]全面总结了自动驾驶中毫米波雷达的理论和现有感知算法,而Harlow等人[4]专注于机器人领域中毫米波雷达的应用。显然,大多数综述集中在3D毫米波雷达上。

尽管4D毫米波雷达及其相关算法的崛起是革命性的,但专门的综述文章却很少。为填补这一空白,本文全面审查了在自动驾驶中使用的4D毫米波雷达。本工作的主要贡献总结如下:

- 据我们所知,这是第一篇专注于自动驾驶中的4D毫米波雷达的综述。

- 鉴于4D毫米波雷达的独特性,本综述专门介绍了其理论背景和信号处理流程。

- 本文对自动驾驶中4D毫米波雷达应用算法进行了详尽的综述,涵盖了感知、定位

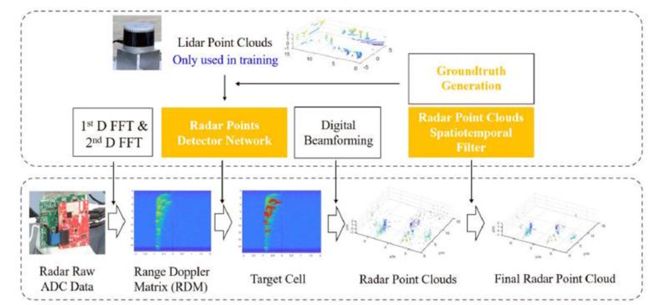

Fig. 1. The traditional signal processing flow and corresponding data formats of 4D mmWave radars [5] [6] [7]

II. 4D毫米波雷达的背景

对于专注于自动驾驶研究的学者,对4D毫米波雷达的基础知识往往可能被忽视。本节简要回顾了4D毫米波雷达的基本理论和提高分辨率的方法,作为以下各节的基础。

A. 信号处理流程

4D毫米波雷达的传统信号处理流程和相应的数据格式如图1所示。在第1步中,毫米波从发射(TX)天线发射。在到达周围目标后,波被反射到接收(RX)天线。大多数现有4D毫米波雷达的波形是频率调制连续波(FMCW),与其他波形相比,它提供了更优越的分辨率。在FMCW雷达的每个工作周期(即调制周期)中,发射天线的信号频率线性增加,具有起始频率![]() 、带宽

、带宽![]() 、频率斜率

、频率斜率![]() 和时间持续时间

和时间持续时间![]() 。通过测量接收到的信号的频率,可以计算目标的距离

。通过测量接收到的信号的频率,可以计算目标的距离![]() ,计算公式如下:

,计算公式如下:

![]()

第一个方程是多普勒效应公式,![]() 和

和![]() 分别是相邻两个啁啾接收信号之间的频率漂移和相位漂移。显然,距离和多普勒分辨率取决于

分别是相邻两个啁啾接收信号之间的频率漂移和相位漂移。显然,距离和多普勒分辨率取决于![]() 等参数,读者可以参考[3]了解详细信息。

等参数,读者可以参考[3]了解详细信息。

为了估计目标的到达方向(DOA),毫米波FMCW雷达通常采用多输入多输出(MIMO)天线设计。![]() 个TX天线和

个TX天线和![]() 个RX天线包括

个RX天线包括![]() 个虚拟TX-RX对。为了分离发送信号,不同的TX天线应该发送正交信号。通过比较不同TX-RX对之间的相位漂移,可以计算到同一目标的不同对之间的距离差。进一步考虑沿着TX和RX天线的位置关系,可以获得目标的DOA。

个虚拟TX-RX对。为了分离发送信号,不同的TX天线应该发送正交信号。通过比较不同TX-RX对之间的相位漂移,可以计算到同一目标的不同对之间的距离差。进一步考虑沿着TX和RX天线的位置关系,可以获得目标的DOA。

每对的信号在步骤2由混频器混合,然后在步骤3由模数转换器(ADC)转换以获得原始ADC数据。应该注意,图1中的对矩阵的坐标分别表示啁啾和帧内的样本时间戳,每个单元格中的值对应反射强度。然后,在步骤4,沿着距离和多普勒维度进行二维快速傅里叶变换(FFT)以生成距离-多普勒图,其坐标是距离和速度。随后,有两种主流信号处理流程。前者是首先沿着不同的TX-RX对进行FFT以引入方位和俯仰信息(步骤5a)。获得4D距离-方位-俯仰-多普勒张量,而对于3D毫米波雷达,结果是3D距离-方位-多普勒张量。在步骤6a,通常在四个维度上应用恒虚警率(CFAR)算法[8],通过每个单元格的强度过滤张量,并为下游任务获取点云格式中的实际目标[9]。相比之下,后者的信号处理流程首先使用CFAR算法过滤RD图以生成目标单元格(步骤5b),然后在步骤6b中采用数字波束形成(DBF)方法恢复角度信息并生成雷达点云[6]。

B. 提高分辨率的方法

如上所述,4D毫米波雷达的最关键能力之一是测量目标的俯仰角,这等同于提高俯仰分辨率。具体的方法可以分为硬件和软件两个层面:

1. 硬件:在硬件层面上,增加TX-RX对的数量或者增大天线孔径是提高分辨率的两种主要方法,具体包括:

- 级联:简单地级联几个标准的毫米波雷达芯片[10]可以增加TX-RX对,从而提高角分辨率。例如,通过级联四个标准的3TX-4RX(12对)雷达芯片,可以形成一个12TX-16RX(192对)的4D毫米波雷达。这是最直接的方法,但尺寸和功耗也会增加。

- 芯片集成:在芯片上集成更多的天线是另一种有前途的技术[11]。它有望替代级联,但天线之间的干扰仍然是一个尚未解决的问题。

- 超材料:由超材料构建的孔径可以显著提高角分辨率,同时控制尺寸[12],但这样的方法还不够成熟,尚未广泛应用。

2. 软件:通过在处理流程中实现虚拟的硬件改进或优化信号处理算法,可以在软件层面上提高雷达分辨率。

- 虚拟孔径成像:受传统合成孔径雷达(SAR)的启发,一些研究人员通过软件设计尝试通过虚拟扩展天线孔径,从而提高角分辨率[13]。这种方法在提高角分辨率方面效果显著,但通常需要通过级联来减小噪声。

- 超分辨率:超分辨率可以通过用创新算法[14],甚至是基于学习的算法[15]替代信号处理流程中的传统方法来实现。然而,这也需要更深入的研究以实现实际应用。

III. 外部标定

雷达点云相对稀疏,频谱数据不够直观。由于多径效应和杂波干扰,噪声也相当显著,给标定带来了挑战。对于4D毫米波雷达,更高的分辨率缓解了这个问题,但仍然缺乏足够健壮的在线标定方法。

在遵循3D毫米波雷达的传统标定方法的基础上,常用retro-reflectors来提高标定精度。通过在特定位置精心放置几个retro-reflectors,分析4D毫米波雷达的感知结果,并将其与LiDAR和相机数据进行比较,可以进行外部参数的标定[16]。Domhof等人并没有逐个标定每一对传感器,而是直接相对于移动机器人的机体进行了所有传感器的标定,实现了仅有0.02°的中位旋转误差[17]。

然而,retro-reflectors 在实际场景中的实用性有限。近年来,一些研究人员设计了不需要特别放置retro-reflectors的4D毫米波雷达标定方法。相反,利用雷达运动测量来对雷达[18]或雷达-相机对[19]进行标定。这些方法的便利性是得到了保证的,但在极端天气条件下的验证仍然需要实施。

IV. 基于学习的雷达点云生成

4D雷达点云稀疏的一个主要原因是CFAR引起的大量信息丢失。为解决这个问题,越来越多的基于学习的方法被提出来替代CFAR,直接处理RD图或4D张量,以提高4D雷达点云的质量和下游自动驾驶任务(如感知和定位)的性能。相关的研究以及接下来将要介绍的4D毫米波雷达的数据集、感知、定位和建图算法在图2中都按照时间线统一展示。

一般来说,如果单元是独立且同分布的,CFAR是一种最优的检测算法。然而,由于现实世界中的目标通常具有不同的形状并占据多个单元,CFAR类型的方法会导致掩蔽效应,降低点云的分辨率并遭受信息丢失。

Brodeski等人首次将卷积神经网络(CNN)应用于RD图,用于检测和定位多个目标,称为DRD(深度雷达检测)网络[20]。他们将RD图中的目标检测形式化为分割任务,并采用类似于2D-U-Net的模型结构[21]。面对特定于雷达RD图的缺乏良好注释的数据集,他们参考雷达标定过程,在吸声室中安排retro-reflectors收集相应的数据,并将其映射回RD图作为标签。实验证明,DRD网络可以实时运行(推理时间约20毫秒),在检测精度方面优于经典方法。

然而,对于RD图的标注仍然存在挑战,因为在吸声室中收集的数据与在现实世界的行驶场景中收集的数据不同,后者更具挑战性,存在多径反射、干扰、衰减等问题。为了解决这一挑战,程等人[6] [22]使用LiDAR点云作为监督,并基于U-Net [23] 和GAN [24]连续设计了网络结构。在复杂的道路场景中,与经典的CFAR检测器相比,[22]生成的4D雷达点云不仅包含更少的杂波点,而且提供了真实目标更密集的点云。

Fig. 2. Timeline of 4D mmWave radar point cloud generation, datasets, perception, localization and mapping algorithms

Fig. 3. Overview of the radar signal processing chain with [22]

V. 数据集

本节介绍目前具有4D毫米波雷达的可用数据集,总结如表◻所示。

表I 4D毫米波雷达数据集

*ADC:原始ADC数据;RT:雷达张量;RPC:雷达点云;

**Coloradar是用于雷达测距的数据集,包含2小时的数据,没有边界框标签。

公共数据集对于推动4D毫米波雷达算法的研究至关重要,它们为开发、测试和比较不同算法提供了平台,促进了相关研究领域的创新。截至撰写本文时,以下数据集已被整理,并其详细信息如下:

- Astyx HiRes 2019 数据集 [25]:

包含500个同步帧,其中包括雷达、激光雷达和相机数据。

提供大约3,000个精确标注的3D对象注释。

主要用于研究3D对象检测和定位。

- ColoRadar 数据集 [9]:

专用于定位和地图制图研究。

包含大约2小时的雷达、激光雷达和姿态地面真值数据。

为雷达数据提供了三个处理级别:原始ADC数据、通过压缩4D雷达张量的多普勒维度得到的3D距离-方位-高度张量,以及雷达点云。

在室内和室外捕获了各种环境的数据。

- VoD 数据集 [26]:

用于多类别3D对象检测的多传感器汽车数据集。

包含经过校准和同步的激光雷达、相机和雷达数据。

包含在复杂的城市交通场景中获取的8,693帧数据。

为移动和静止对象提供了123,106个3D边界框注释,以及每个注释对象的跟踪ID。

- Tj4DRadSet 数据集 [16]:

包含44个连续序列,总共有7,757帧数据。

使用3D边界框和轨迹ID进行了良好标注。

涵盖了更丰富且更具挑战性的驾驶场景剪辑(如城市道路、高速公路、工业园区)。

就目前所知,K-Radar 目前是基于4D毫米波雷达的最大规模数据集,收集了35,000个帧条件(例如晴天、雾天、雨天、雪天)[27]。除了4D雷达数据外,K-Radar 还提供高分辨率的激光雷达点云、四个立体相机的周围RGB图像,以及自车的RTK-GPS和IMU数据。值得一提的是,K-Radar 是目前唯一提供4D雷达张量的数据集。为了便于对各种神经网络结构进行实验,K-Radar 还提供了一个可视化程序,以模块化神经网络训练代码。虽然4D毫米波雷达受到学术界越来越多的关注,越来越多的数据集已经发布,但与视觉或激光雷达相比,数据量仍然不够大。

VI. 感知应用

目前,4D毫米波雷达的点云密度已经达到了与低束激光雷达相媲美的水平,并且在低能见度和恶劣天气条件下,4D毫米波雷达表现出卓越的鲁棒性。因此,研究人员一直在尝试将激光雷达点云处理模型转移到4D毫米波雷达上,用于目标检测、场景流预测等任务。此外,如第IV节所述,经过CFAR之前的雷达数据包含更丰富的信息,促使一些研究人员直接使用RD图或4D张量,绕过点云生成任务。

相关工作可以进一步分为仅依赖于4D雷达或多模态传感器融合的方法。

A. 仅基于4D雷达的方法

自然而然地,大多数相关的仅基于4D雷达的方法都源自于基于激光雷达的方法。然而,由于毫米波雷达的稀疏性和噪声特性,仍然需要特定的网络设计。

3D检测:在3D目标检测任务方面,根据模型架构的差异,感知方法可以分为基于CNN和基于Transformer的方法。

Palffy等人[26]首次将PointPillars应用于4D雷达点云,用于多类道路用户的3D检测。通过时间集成和引入额外的特征,如高度和多普勒速度,性能得到改进。然而,所提出的方法的结果(mAP 47.0)仍然远远不及64梁激光雷达的激光雷达检测器(mAP 62.1)。

RPFA-Net [28]通过引入雷达pillar特征关注(PFA)模块取得了进展。它利用自注意力而不是简化的PointNet [29]从pillar中提取全局上下文特征,旨在有效地捕捉长距离上的信息并提高航向角估计精度。

作为集合操作符,基于注意力的Transformer在处理具有排列不变性的这些点集时具有固有的优势。因此,为了应对4D毫米波雷达的稀疏和噪声数据,谭等人[30]提出了一种基于多帧点云的3D目标检测框架。他们首先从点云中获取自车速度和补偿速度信息,然后将附近帧累积到最后一帧。

除了直接在雷达点云上处理感知任务外,一些研究还关注了RD图或4D张量,旨在利用更多底层的隐藏信息。K-Radar数据集[27]提出了一种直接使用4D张量作为输入的3D目标检测基线,并验证了4D张量的高度信息对于3D目标检测的重要性。所提出的模型还展示了基于4D张量的感知的鲁棒性,尤其是在恶劣天气条件下。

场景流估计:场景流估计旨在计算表示环境内静态和动态元素运动的3D运动矢量场,相对于自主代理。虽然传统上有许多研究依赖于不同的感知模态,如相机或激光雷达进行场景流估计,但也有利用4D毫米波雷达数据完成此任务的方法。

代表性地,丁等人[31]提出了一种通过跨模态学习进行4D雷达场景流估计的新方法,这受到了现代自动驾驶车辆中同地感知冗余的驱动。这种冗余隐含地为雷达场景流估计提供了各种形式的监督线索,可以有效解决对雷达点云进行标注的困难。具体而言,该工作引入了跨模态学习问题的多任务模型架构。广泛的实验证明了该方法的最先进性能,并证明了跨模态监督学习对推断更准确的4D毫米波雷达场景流的有效性。

B. 融合方法

考虑到4D毫米波雷达已经可以提供点云信息,一些学者将其与相机或激光雷达进行目标检测融合,希望提高感知模型的准确性和鲁棒性。一般而言,对于不同模态,有三个融合层次:数据层次、特征层次和决策层次。现有研究主要集中在特征层次融合上。

至于4DRV(4D雷达和视觉)融合,4D毫米波雷达可以以低成本提供高精度的深度和速度信息,弥补了相机的缺点,从而提高了3D检测的准确性。在最近的研究中,4D毫米波雷达信号通常被转换为2D图像样式的特征,以便可以与相机图像一起实际部署。

代表性的研究是Meyer等人[32]应用了基于[33]的网络,用于4D毫米波雷达和相机的融合,该网络最初是为相机激光雷达融合而开发的。为了弥补数据格式差异,他们放弃了多普勒信息,仅保留了4D毫米波雷达点云的位置信息和反射强度。每帧的点云用于生成BEV图像,然后生成3D提议。令人惊讶的是,当雷达数据替代激光雷达时,融合网络的精度更高,达到了Astyx数据集[25]上的61%AP的平均精度。作者认为原因可能是激光雷达传感器只有16束,但仍需要进一步的研究。

随后,Cui等人[34]进行了一项新添加的自监督模型适应块的研究[35],该块根据对象属性动态调整不同模态的融合。此外,从雷达点云中生成与BEV图像一起的前视图地图。所提出的方法在3D AP方面比前一项研究[32]提高了最多9.5%。前视图地图可以更好地利用4D毫米波雷达提供的高度信息,并且更容易与单目相机特征融合,平衡检测精度和计算效率。

尽管4DRV融合具有上述优势,但在面对剧烈的光照变化或恶劣的天气条件时,基于视觉的分支仍可能难以正常工作,从而影响模型的整体性能。因此,Wang等人[36]首次探索了4DRL(4D雷达和激光雷达)融合的优势,采用了基于交互的融合框架InterFusion。他们设计了一个InterRAL模块(雷达和激光雷达的交互),并更新了两种模态的pillar以增强特征表达。通过消融实验证明了其有效性。

在随后的研究中,Wang等人[37]提出了一个称为M2 Fusion的网络,该网络集成了一种基于交互的多模态融合方法,称为IMMF,和一种基于中心的多尺度融合方法,称为CMSF。在Astyx数据集[25]上进行评估,它在很大程度上超过了主流的基于LiDAR的目标检测方法。由于LiDAR可以在近距离精确检测物体,而4D毫米波雷达由于其穿透性具有远距离探测范围,因此4DRL融合具有成本低、质量高的潜在可靠技术解决方案。

Fig. 4. Overview of the M2 4DRL fusion model [37]

VII. 定位和地图应用

在卫星定位信息不准确或高清地图不可用的严峻环境中,使用感知传感器进行定位和地图绘制是必要的。使用新兴的4D毫米波雷达进行了一些相关研究。由于雷达点云比张量轻得多,而且可以通过轻微调整将LiDAR的研究转移到雷达上,关于雷达张量的定位和地图的研究几乎没有。

A. 里程计

雷达里程计估计是定位的核心,也是SLAM的关键组成部分。关于4D毫米波雷达的相关研究还是相当多的。然而,由于雷达的稀疏性和噪声,里程计大多数是在惯性测量单元(IMU)的帮助下生成的。

Doer和Trommer在使用无人机(UAV)方面在这个领域做出了很多贡献。在[38]中,他们通过气压计估计了无人机的高度,然后利用基于随机采样一致性(RANSAC)的最小二乘法,利用雷达点云的多普勒信息来估计自车速度。最终使用IMU数据构建了基于扩展卡尔曼滤波器(EKF)的雷达惯性里程计。在此基础上,他们考虑了曼哈顿世界假设,该假设认为环境中的平面是相互正交的,实现了与最先进的视觉惯性里程计[39]相当的精度。这项贡献扩展到多个雷达,并在视觉条件恶劣的情况下表现出令人满意的性能,而且计算资源要求很小[40] [41]。此外,他们还研究了4D毫米波雷达与视觉和热成像信息的融合,以进一步增强结果[42]。这些研究的唯一缺点是基于EKF的算法可能在大规模环境中遇到困难,因为里程计漂移会增加。在大多数工作中,曼哈顿世界的假设可能会限制在严峻的户外环境中的适用性。

Michalczyk等人也采用了EKF框架[43]。他们没有直接将IMU与由雷达点云估计的自车速度融合,而是实现了在稀疏、嘈杂的雷达扫描之间进行3D点匹配,以测量雷达扫描之间的位移。在总行驶距离的末尾,无人机的3D轨迹估计达到了3.32%的漂移。

还探讨了基于学习的雷达里程计估计。Lu等人[44]通过CNN和RNN编码器分别提取雷达点云和IMU的特征。然后,设计了一个两阶段的跨模态注意层来融合这些特征,并使用RNN来建模长期动态。整个网络的输出是6-DOF里程计,其绝对轨迹误差(ATE)达到了0.8米。性能在RGB相机或深度相机的辅助下进一步升级。

B. 重定位

重定位依赖于高精度的在线地图,对于使用高清晰度地图或在SLAM中检测环路闭合时尤为重要。考虑到4D毫米波雷达点云的稀疏性和噪声,程等人 [45] 利用多普勒速度去除移动物体,然后通过合并多个连续扫描来增强点云。在著名的PointNet的启发下,他们采用基于多层感知器(MLP)的网络来将每个点的维度从4增加到1024,以进行逐点特征提取。通过比较当前扫描和全局地图提取的特征,可以实现重定位。

C. SLAM

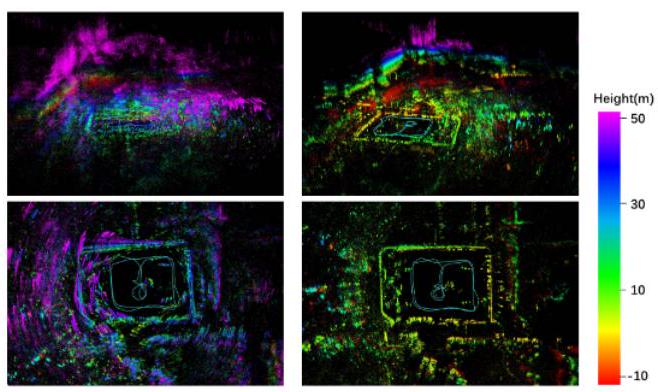

由于上述里程计和重定位对于SLAM是不可或缺的,因此对于4D毫米波雷达SLAM的研究最近才出现。庄等人 [46] 基于迭代扩展卡尔曼滤波器(EKF)开发了一个完整的4D毫米波雷达点云SLAM过程。为了避免类似RANSAC方法引起的稀疏性,他们通过迭代重新加权最小二乘法进行了自我速度估计。每个雷达点的权重还反映了其动态特性,因此可以帮助去除移动物体。扫描和子图之间的非传统分布匹配进一步减小了稀疏性的影响。效果如图5所示。zhuge [47]应用位姿图构建了一个SLAM系统,该系统改编自名为hdl_graph_slam的LiDAR SLAM方法 [48]。在烟雾和雨水的影响下进行了一些令人印象深刻的实验证明了4D毫米波雷达在极端环境中的稳健性。

Fig. 5. the mapping performance of 4D iRIOM [46]

VIII. 未来趋势

4D毫米波雷达有潜力对自动驾驶领域产生深远影响。然而,目前仍处于不够成熟的阶段。未来4D毫米波雷达的趋势可能主要依赖于以下领域。

- 点云增强:作为最常用的数据格式,与其他传感器相比,4D毫米波雷达点云明显质量较低。点云的数据质量受雷达特性的严重影响,如多径效应。此外,迫切需要通过精心设计的基于学习的方法替换CFAR,特别是在信号处理流程中减少信息丢失。未来研究还可以探索用于超分辨角度估计的学习方法,而不是DBF方法的DOA估计的学习方法。

- 应用算法重新设计:除了改进4D毫米波雷达点云之外,信号处理后的应用算法是另一个不可忽视的问题。到目前为止,许多用于4D毫米波雷达的应用算法都是从相应的LiDAR算法修改而来。未来研究应进一步探索4D毫米波雷达的特殊性,例如速度测量能力和在极端环境中的自适应能力。对于感知任务,多模态融合无疑是未来的发展方向。然而,尚需探讨在集成其他传感器分支的情况下,4D雷达在极端天气条件下的稳健性是否会受到削弱。对于4D毫米波雷达的定位和地图制作,与LiDAR和摄像头的传感器融合有很大的发现空间。

- 预点云数据利用:就4D毫米波雷达信号处理流程中的独特数据格式而言,如原始ADC数据、RD地图和4D张量,利用这些数据进行感知、定位和地图制作是一个有趣但几乎未触及的主题。利用这些数据中丰富信息的基于学习的模型,同时保持可接受的实时性能,可能是一个研究热点。

- 数据集丰富化:与所有其他数据驱动的研究领域一样,4D毫米波雷达的数据集在相关研究中发挥着重要作用。包含4D毫米波雷达的现有数据集相对较少。数据格式和场景丰富度是待扩展的两个主要领域。

IX. 结论

本文全面介绍了自动驾驶中的4D毫米波雷达。它依次涵盖了信号处理理论、数据集、外参校准方法、基于学习的雷达点云生成算法、在感知、定位和地图制作中的应用,以及未来趋势。在自动驾驶领域对4D毫米波雷达的研究仍在进行中,并具有未来进展的巨大潜力。

REFERENCES

[1] M. Jiang, G. Xu, H. Pei, Z. Feng, S. Ma, H. Zhang, and W. Hong, " 4 d high-resolution imagery of point clouds for automotive mmwave radar,' IEEE Transactions on Intelligent Transportation Systems, pp. 1-15,2023![]() .

.

[2] I. Bilik, O. Longman, S. Villeval, and J. Tabrikian, "The rise of radar for autonomous vehicles: Signal processing solutions and future research directions," IEEE Signal Processing Magazine, vol. 36, no. 5, pp. 20-31, Sep. 2019.

[3] A. Venon, Y. Dupuis, P. Vasseur, and P. Merriaux, "Millimeter wave fmcw radars for perception, recognition and localization in automotive applications: A survey,' IEEE Transactions on Intelligent Vehicles, vol. 7, no. 3, pp. 533-555, Sep. 2022.

[4] K. Harlow, H. Jang, T. D. Barfoot, A. Kim, and C. Heckman, "A new wave in robotics: Survey on recent mmwave radar applications in robotics," May 2023.

[5] S. Abdulatif, Q. Wei, F. Aziz, B. Kleiner, and U. Schneider, "Microdoppler based human-robot classification using ensemble and deep learning approaches," in 2018 IEEE Radar Conference (RadarConf18), Apr. 2018, pp. 1043-1048.

[6] Y. Cheng, J. Su, H. Chen, and Y. Liu, "A new automotive radar 4 d![]() point clouds detector by using deep learning," in ICASSP 2021 . 2021 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), Jun. 2021, pp. 8398-8402.

point clouds detector by using deep learning," in ICASSP 2021 . 2021 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), Jun. 2021, pp. 8398-8402.

[7] G. Hakobyan and B. Yang, "High-performance automotive radar: A review of signal processing algorithms and modulation schemes," IEEE Signal Processing Magazine, vol. 36, no. 5, pp. 32-44, Sep. 2019.

[8] H. Rohling, "Radar cfar thresholding in clutter and multiple target situations," IEEE Transactions on Aerospace and Electronic Systems, vol. AES-19, no. 4, pp. 608-621, Jul. 1983.

[9] A. Kramer, K. Harlow, C. Williams, and C. Heckman, "Coloradar: The direct 3d millimeter wave radar dataset," The International Journal of Robotics Research, vol. 41, no. 4, pp. 351-360, Apr. 2022.

[10] A. Och, C. Pfeffer, J. Schrattenecker, S. Schuster, and R. Weigel, "A scalable 77ghz![]() massive mimo fmcw radar by cascading fullyintegrated transceivers," in 2018 Asia-Pacific Microwave Conference (APMC), Nov. 2018, pp. 1235-1237.

massive mimo fmcw radar by cascading fullyintegrated transceivers," in 2018 Asia-Pacific Microwave Conference (APMC), Nov. 2018, pp. 1235-1237.

[11] P. Ritter, M. Geyer, T. Gloekler, X. Gai, T. Schwarzenberger, G. Tretter, Y. Yu, and G. Vogel, "A fully integrated 78ghz![]() automotive radar system-an-chip in 22nm fd-soi cmos," in 2020 17th European Radar Conference (EuRAD), Jan. 2021, pp. 57-60.

automotive radar system-an-chip in 22nm fd-soi cmos," in 2020 17th European Radar Conference (EuRAD), Jan. 2021, pp. 57-60.

[12] J. Jiang, Y. Li, L. Zhao, and X. Liu, "Wideband mimo directional antenna array with a simple meta-material decoupling structure for x-band applications," The Applied Computational Electromagnetics Society Journal (ACES), pp. 556-566, May 2020.

[13] Z. Wu, L. Zhang, and H. Liu, "Generalized three-dimensional imaging algorithms for synthetic aperture radar with metamaterial aperturesbased antenna," IEEE Access, vol. 7, pp. 59 716-59727, 2019.

[14] F. Zhang, C. Wu, B. Wang, and K. J. R. Liu, "mmeye: Super-resolution millimeter wave imaging," IEEE Internet of Things Journal, vol. 8, no. 8, pp. 6995-7008, Apr. 2021.

[15] H.-W. Cho, W. Kim, S. Choi, M. Eo, S. Khang, and J. Kim, "Guided generative adversarial network for super resolution of imaging radar," in 2020 17th European Radar Conference (EuRAD). New York: Ieee, Jan. 2021, pp. 144-147.

[16] L. Zheng, Z. Ma, X. Zhu, B. Tan, S. Li, K. Long, W. Sun, S. Chen, L. Zhang, M. Wan, L. Huang, and J. Bai, "Tj4dradset: A 4d radar dataset for autonomous driving," in 2022 IEEE 25th International Conference on Intelligent Transportation Systems (ITSC), Oct. 2022, pp. 493-498.

[17] J. Domhof, J. F. P. Kooij, and D. M. Gavrila, "A joint extrinsic calibration tool for radar, camera and lidar," IEEE Transactions on Intelligent Vehicles, vol. 6, no. 3, pp. 571-582, Sep. 2021.

[18] Y. Bao, T. Mahler, A. Pieper, A. Schreiber, and M. Schulze, "Motion based online calibration for 4 d![]() imaging radar in autonomous driving applications," in 2020 German Microwave Conference (GeMiC), Mar. 2020, pp. 108-111.

imaging radar in autonomous driving applications," in 2020 German Microwave Conference (GeMiC), Mar. 2020, pp. 108-111.

[19] E. Wise, J. Persic, C. Grebe, I. Petrovic, and J. Kelly, "A continuoustime approach for 3d radar-to-camera extrinsic calibration," in 2021 IEEE International Conference on Robotics and Automation (ICRA), May 2021, pp. 13 164-13 170.

[20] D. Brodeski, I. Bilik, and R. Giryes, "Deep radar detector," in 2019 IEEE Radar Conference (RadarConf), Apr. 2019, pp. 1-6.

[21] C. Zhang, W. Luo, and R. Urtasun, "Efficient convolutions for realtime semantic segmentation of 3d point clouds," in 2018 International Conference on 3D Vision (3DV), Sep. 2018, pp. 399-408.

[22] Y. Cheng, J. Su, M. Jiang, and Y. Liu, "A novel radar point cloud generation method for robot environment perception," IEEE Transactions on Robotics, vol. 38, no. 6, pp. 3754-3773, Dec. 2022.

[23] O. Ronneberger, P. Fischer, and T. Brox, "U-net: Convolutional networks for biomedical image segmentation," in Lecture Notes in Computer Science, ser. Lecture Notes in Computer Science, N. Navab, J. Hornegger, W. M. Wells, and A. F. Frangi, Eds. Cham: Springer International Publishing, 2015, pp. 234-241.

[24] P. Luc, C. Couprie, S. Chintala, and J. Verbeek, "Semantic segmentation using adversarial networks," in NIPS Workshop on Adversarial Training, 2016.

[25] M. Meyer and G. Kuschk, "Automotive radar dataset for deep learning based 3d object detection," in 2019 16th European Radar Conference (EuRAD), Oct. 2019, pp. 129-132.

[26] A. Palffy, E. Pool, S. Baratam, J. F. P. Kooij, and D. M. Gavrila, "Multi-class road user detection with 3+1d radar in the view-of-delft dataset," IEEE Robotics and Automation Letters, vol. 7, no. 2, pp. 4961-4968, Apr. 2022.

[27] D.-H. Paek, S.-H. Kong, and K. T. Wijaya, "K-radar: 4d radar object detection for autonomous driving in various weather conditions," in Thirty-Sixth Conference on Neural Information Processing Systems Datasets and Benchmarks Track, 2022.

[28] B. Xu, X. Zhang, L. Wang, X. Hu, Z. Li, S. Pan, J. Li, and Y. Deng, "Rpfa-net: A 4d radar pillar feature attention network for 3 d![]() object detection," in 2021 IEEE International Intelligent Transportation Systems Conference (ITSC), Sep. 2021, pp. 3061-3066.

object detection," in 2021 IEEE International Intelligent Transportation Systems Conference (ITSC), Sep. 2021, pp. 3061-3066.

[29] R. Q. Charles, H. Su, M. Kaichun, and L. J. Guibas, "Pointnet: Deep learning on point sets for 3 d![]() classification and segmentation," in 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu, HI: IEEE, Jul. 2017, pp. 77-85.

classification and segmentation," in 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu, HI: IEEE, Jul. 2017, pp. 77-85.

[30] B. Tan, Z. Ma, X. Zhu, S. Li, L. Zheng, S. Chen, L. Huang, and J. Bai,

" 3 d![]() object detection for multi-frame 4 d

object detection for multi-frame 4 d![]() automotive millimeter-wave radar point cloud," IEEE Sensors Journal, pp. 1-1, 2022.

automotive millimeter-wave radar point cloud," IEEE Sensors Journal, pp. 1-1, 2022.

[31] F. Ding, A. Palffy, D. M. Gavrila, and C. X. Lu, "Hidden gems: 4 d![]() radar scene flow learning using cross-modal supervision," in Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2023, pp. 9340-9349.

radar scene flow learning using cross-modal supervision," in Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2023, pp. 9340-9349.

[32] M. Meyer and G. Kuschk, "Deep learning based 3d object detection for automotive radar and camera," in 2019 16th European Radar Conference (EuRAD), Oct. 2019, pp. 133-136.

[33] J. Ku, M. Mozifian, J. Lee, A. Harakeh, and S. L. Waslander, "Joint 3 d![]() proposal generation and object detection from view aggregation," in 2022 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS), Oct. 2018, pp. 1-8.

proposal generation and object detection from view aggregation," in 2022 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS), Oct. 2018, pp. 1-8.

[34] H. Cui, J. Wu, J. Zhang, G. Chowdhary, and W. R. Norris, " 3d![]() detection and tracking for on-road vehicles with a monovision camera and dual low-cost 4d mmwave radars," in 2021 IEEE International Intelligent Transportation Systems Conference (ITSC), Sep. 2021, pp. 2931-2937.

detection and tracking for on-road vehicles with a monovision camera and dual low-cost 4d mmwave radars," in 2021 IEEE International Intelligent Transportation Systems Conference (ITSC), Sep. 2021, pp. 2931-2937.

[35] A. Valada, R. Mohan, and W. Burgard, "Self-supervised model adaptation for multimodal semantic segmentation," International Journal of Computer Vision, vol. 128, no. 5, pp. 1239-1285, May 2020.

[36] L. Wang, X. Zhang, B. Xv, J. Zhang, R. Fu, X. Wang, L. Zhu, H. Ren, P. Lu, J. Li, and H. Liu, "Interfusion: Interaction-based 4d radar and lidar fusion for 3d object detection," in 2022 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS), Oct. 2022, pp. 12247-12253![]() .

.

[37] L. Wang, X. Zhang, J. Li, B. Xv, R. Fu, H. Chen, L. Yang, D. Jin, and L. Zhao, "Multi-modal and multi-scale fusion 3d object detection of 4d radar and lidar for autonomous driving," IEEE Transactions on Vehicular Technology, vol. 72, no. 5, pp. 5628-5641, May 2023.

[38] C. Doer and G. F. Trommer, "An ekf based approach to radar inertial odometry," in 2020 IEEE International Conference on Multisensor Fusion and Integration for Intelligent Systems (MFI), Sep. 2020, pp. 152-159![]() .

.

[39] —— , "Yaw aided radar inertial odometry using manhattan world assumptions," in 2021 28th Saint Petersburg International Conference on Integrated Navigation Systems (ICINS), May 2021, pp. 1-9.

[40] — , "X-rio: Radar inertial odometry with multiple radar sensors and yaw aiding," Gyroscopy and Navigation, vol. 12, no. 4, pp. 329-339, Dec. 2021.

[41] C. Doer, J. Atman, and G. F. Trnmmer, "Gnss aided radar inertial odometry for uas flights in challenging conditions," in 2022 IEEE Aerospace Conference (AERO), Mar. 2022, pp. 1-10.

[42] C. Doer and G. F. Trommer, "Radar visual inertial odometry and radar thermal inertial odometry: Robust navigation even in challenging visual conditions," in Gyroscopy and Navigation, Sep. 2021, pp. 331338 .

[43] J. Michalczyk, R. Jung, and S. Weiss, "Tightly-coupled ekf-based radar-inertial odometry," in 2022 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Kyoto, Japan: IEEE, Oct. 2022, pp. 12336-12343.

[44] C. X. Lu, M. R. U. Saputra, P. Zhao, Y. Almalioglu, P. P. B. de Gusmao, C. Chen, K. Sun, N. Trigoni, and A. Markham, "milliego: Single-chip mmwave radar aided egomotion estimation via deep sensor fusion," Oct. 2020.

[45] Y. Cheng, C. Pang, M. Jiang, and Y. Liu, "Relocalization based on millimeter wave radar point cloud for visually degraded environments," Journal of Field Robotics, vol. 40, no. 4, pp. 901-918, Jun. 2023.

[46] Y. Zhuang, B. Wang, J. Huai, and M. Li, " 4 d iriom: 4d imaging radar inertial odometry and mapping," Mar. 2023.

[47] H. Zhuge, "A 4d imaging radar slam system for large-scale environments based on pose graph optimization," Master's thesis, Nanyang Technological University, Singapore, 2023.

[48] K. Koide, J. Miura, and E. Menegatti, "A portable three-dimensional lidar-based system for long-term and wide-area people behavior measurement," International Journal of Advanced Robotic Systems, vol. 16, Feb. 2019.

- Han and Jiahao Wang contribute equally to this work.

This work was supported by the National Natural Science Foundation of China (NSFC) under grant number 52221005.

1![]() School of Vehicle and Mobility, Tsinghua University, Beijing, China

School of Vehicle and Mobility, Tsinghua University, Beijing, China

2![]() Xingjian College, Tsinghua University, Beijing, China

Xingjian College, Tsinghua University, Beijing, China

*Correspondence: [email protected] (L.H.); [email protected] (S.X.); wjqlwsetsinghua.edu.cn (J.W.)