LSTM--概念、作用、原理、优缺点以及简单的示例代码

LSTM的概念

LSTM(Long Short-Term Memory)是一种特殊的递归神经网络(RNN),最早由Sepp Hochreiter和Jürgen Schmidhuber在1997年提出。LSTM设计的主要目的是解决标准RNN中的长时依赖问题。RNN在处理长序列时,由于梯度消失或梯度爆炸问题,难以捕捉到长期依赖关系,而LSTM通过引入“记忆单元”(memory cell)和“门控机制”(gating mechanism)来有效地解决这一问题。

LSTM的作用

LSTM主要用于处理序列数据,广泛应用于自然语言处理(NLP)、时间序列预测、语音识别、机器翻译等领域。具体来说,LSTM在以下任务中表现出色:

- 语言模型:预测序列中的下一个词或字符。

- 文本生成:根据输入生成相应的文本序列。

- 时间序列预测:如股票价格、气象数据的预测。

- 语音识别:将语音信号转化为文本。

- 机器翻译:将一种语言翻译成另一种语言。

LSTM的原理

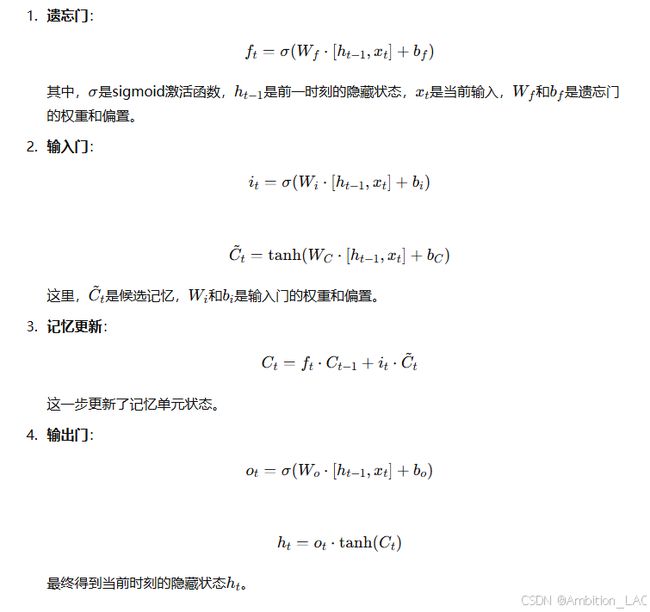

LSTM通过引入三个“门”来控制信息的流动:

- 遗忘门(Forget Gate):决定遗忘多少来自前一时刻的信息。

- 输入门(Input Gate):决定有多少新信息会被存入记忆单元。

- 输出门(Output Gate):决定从记忆单元中输出多少信息。

此外,LSTM还有一个记忆单元(Cell State),用于保存跨时间步长的信息。通过这些门控机制,LSTM能够在时间步长之间灵活地存储和删除信息,从而有效解决了长时间依赖问题。

LSTM的结构

LSTM的优缺点

优点:

- 解决长时依赖问题:相比于传统RNN,LSTM能够更好地捕捉序列中的长时依赖关系。

- 适用性广泛:LSTM可以处理不同类型的序列数据,如文本、语音、时间序列等。

- 在复杂任务中的表现更好:如机器翻译、图像字幕生成等任务。

缺点:

- 计算开销大:LSTM结构复杂,计算量大,训练时间较长。

- 难以调参:LSTM模型包含多个超参数,如层数、隐藏单元数量等,调参较为复杂。

- 容易过拟合:由于模型复杂,训练时容易发生过拟合,需要加入正则化手段。

简单的LSTM示例代码

以下是一个使用Python和Keras库实现LSTM的简单示例代码,来完成一个基本的时间序列预测任务:

import numpy as np

import matplotlib.pyplot as plt

from keras.models import Sequential

from keras.layers import LSTM, Dense

# 生成示例数据

def generate_data(seq_length=100, num_samples=1000):

X = []

y = []

for _ in range(num_samples):

start = np.random.rand()

seq = np.sin(np.linspace(start, start + 2*np.pi, seq_length))

X.append(seq[:-1])

y.append(seq[-1])

return np.array(X), np.array(y)

# 数据集

seq_length = 50

X, y = generate_data(seq_length)

# 调整形状以符合LSTM输入要求

X = np.expand_dims(X, axis=2)

# 构建LSTM模型

model = Sequential()

model.add(LSTM(50, activation='tanh', input_shape=(seq_length-1, 1)))

model.add(Dense(1))

model.compile(optimizer='adam', loss='mse')

# 训练模型

model.fit(X, y, epochs=20, batch_size=32)

# 测试模型

test_seq = np.sin(np.linspace(0, 2*np.pi, seq_length-1))

test_seq = np.expand_dims(test_seq, axis=0)

test_seq = np.expand_dims(test_seq, axis=2)

predicted = model.predict(test_seq)

# 显示结果

plt.plot(np.linspace(0, 2*np.pi, seq_length), np.sin(np.linspace(0, 2*np.pi, seq_length)), label='True')

plt.plot(np.linspace(0, 2*np.pi, seq_length-1), test_seq.flatten(), label='Input')

plt.scatter([2*np.pi], predicted, color='red', label='Predicted')

plt.legend()

plt.show()

代码解释

- 数据生成:

generate_data函数生成了一些模拟的正弦波数据作为训练集。 - LSTM模型:模型包含一个LSTM层和一个Dense层,用于输出预测值。

- 模型训练:使用MSE(均方误差)作为损失函数,Adam优化器进行训练。

- 测试和可视化:用训练好的模型对一个完整的正弦波进行预测,并与真实值进行对比。

这个示例展示了LSTM如何被应用于一个简单的时间序列预测任务中。根据任务的复杂度,LSTM模型的层数、单元数以及其他超参数可以进行调整。