可商用、性能超强!新开源Mamba架构纯代码模型

7月17日,法国著名开源大模型平台Mistral.ai在官网开源了,基于 Mamba架构的纯代码模型——Codestral Mamba。

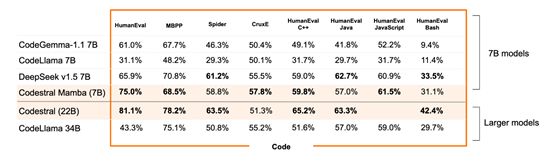

根据测试数据显示,Codestral Mamba只有70亿参数,但性能却是Meta开源的知名代码模型CodeLlam 7B的两倍,成为同类最强代码模型之一。

开源地址:https://huggingface.co/mistralai/mamba-codestral-7B-v0.1

此外,Codestral Mamba支持256k上下文窗口可商业化,其架构使用的是目前比较流程的Mamba。

Mamba架构的核心优势在于其线性时间推理能力,这意味著能在处理序列数据时,无论序列长度如何增长,推理时间都能保持线性增长,而非指数级的膨胀。

这一点与传统的Transformer架构形成了鲜明对比,它在处理长序列时,由于自注意力机制的计算复杂度,会面临计算成本随序列长度增加而急剧上升的问题。Mamba架构的这一特性使得它在处理大规模数据集和长序列时更加高效,为实时交互和大规模数据处理提供了可能

在计算效率上,Mamba通过改进的注意力机制,减少了处理序列数据所需的计算量。这种机制不仅加快了数据处理速度,而且提高了数据访问的效率。

Mamba在内存使用上进行了优化,这对于移动设备和边缘计算等资源受限的场景尤为重要,确保了即使在硬件条件有限的情况下,模型也能顺畅运行。

Mamba架构的另一个显著优势是其出色的可扩展性,允许模型更容易地扩展到更大的尺寸,而不会牺牲性能。这一点对于那些需要处理更复杂任务和更大模型的应用来说,是一个巨大的吸引力。

所以,Mamba架构不仅能够加快模型的训练速度,减少迭代和实验的时间,还能在推理时提供更低的延迟,这对于需要实时响应的应用场景至关重要。

此外,Mamba架构在保持或提高模型性能的同时,减少了所需的计算资源,这对于中小型企业、个人开发者来说帮助非常大,同时可以在更小的硬件上运行。

Mistral.ai还建议开发者在使用Codestral Mamba时与其之前开源的mistral-inference搭配一起使用效果更好。

mistral-inference开源地址:https://github.com/mistralai/mistral-inference

本文素材来源Mistral.ai官网,如有侵权请联系删除

END