人机交互30年

人机交互30年

自1982年ACM成立人机交互专门兴趣小组SIGCHI(Special Interest Group on Computer-Human Interaction)以来,人机交互(Computer-Human Interaction,CHI)已走过了近30年历程。键盘的出现,将计算机带入了字符用户界面时代。1964年,美国人道格·恩格尔巴特(Doug Engelbart)发明了鼠标(图1),图形用户界面(Graphical User Interface,GUI)随之出现,才有了计算机的主机时代和个人计算机时代,为此,恩格尔巴特也获得了1997年的图灵奖。自图形用户界面出现至今的几十年中,人机交互技术经历了几代人的努力,成就了PC时代的辉煌。

图1 Doug Engelbart和他发明的鼠标

70年代Xerox研究中心的Alan Kay提出了Smalltalk面向对象程序设计等思想,并发明了重叠式多窗口系统。

1989年Tim Berners-Lee在日内瓦的CERN用HTML及HTTP开发了WWW网,随后出现了各种浏览器(网络用户界面),使互联网飞速发展起来。

图2 Alan Kay和Tim Berners-Lee

由于笔式交互、触摸、语音、以及基于视频等自然交互设备的出现,新的计算模式被提出,人机交互进入了普适计算(Pervasive Computing)时代。

90年代美国麻省理工学院N.Negroponte领导的媒体实验室在新一代多通道用户界面方面(包括语音、手势、智能体等),做了大量开创性的工作。

90年代美国Xerox公司PARC的首席科学家Mark Weiser首先提出“无所不在计算(Ubiquitous Computing)”思想 。

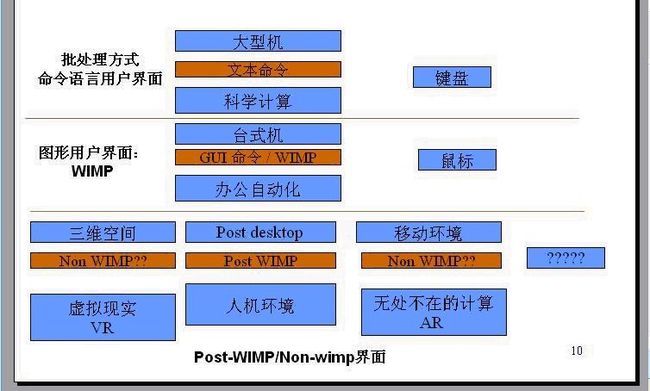

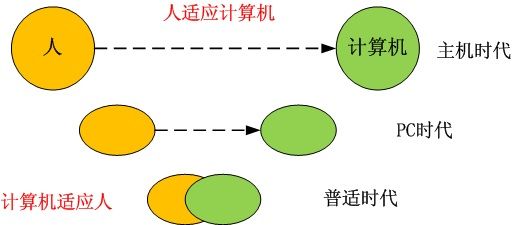

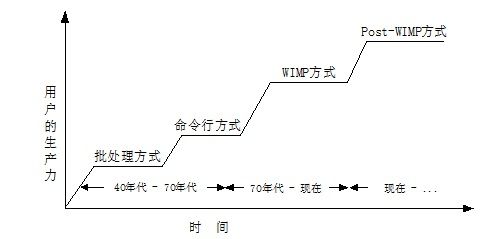

人机交互是研究人类所使用的交互式计算系统的设计、实施、评估以及相关主要现象的学科,用户界面(User Interface,UI)是人与计算机之间传递、交换信息的媒介和对话接口,是计算机系统的重要组成部分,用户界面是人机交互技术的物质表现形式。所以在普适计算时代自然交互是其研究的重要主题,人机交互的历史也是从人适应计算机到计算机不断地适应人的发展史。回顾人机交互的发展史,主要经历了以下几个阶段(图3):

1、早期的手工作业阶段;

2、作业控制语言及交互命令语言阶段;

3、图形用户界面(GUI)阶段;

4、网络用户界面的出现;

多通道、多媒体的智能人机交互阶段。

图3 界面范式的发展过程

在早期的命令语言用户界面时代,人和计算机的交互主要是通过键盘来完成的。而此时的计算机主要是大型机,用来进行科学计算,接受文本命令;随着图形界面和鼠标的出现,计算机进入了个人PC时代,接受GUI命令,并帮助我们我们实现了办公自动化。WIMP界面范式是图形界面电脑所采用的界面典范。在人机互动领域之中是最普遍的电脑互动界面,WIMP堪称无人能出其右,举凡微软的Windows、苹果电脑的MacOS,甚至其它以X-Window为基础的操作系统,均采用WIMP此一界面典范。WIMP是由“视窗”(Window)、“图标”(Icon)、“选单”(Menu)以及“指标”(Pointer)所组成的缩写,其命名方式也指明了它所倚赖的四大互动元件。曾经有人这样评价图形用户界面:“PC plus GUI made the history”。但随着计算机硬件设备的进步和软件技术的发展,WIMP界面的缺点逐渐地体现出来。目前研究者们将研究的焦点聚集到下一代的用户界面的研究上,提出了Post-WIMP(或Non-WIMP)的界面形式。

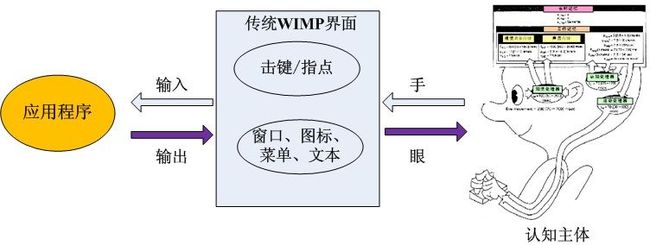

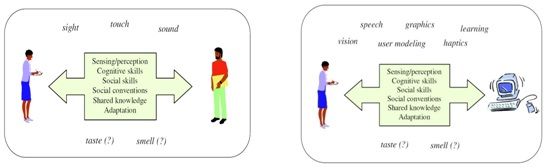

用户界面技术的每一次飞跃都需要认知心理学成果的支撑,在人机交互的心理学研究当中,自然、智能用户界面目标是:帮助计算机了解用户,帮助用户更好地使用计算机。WIMP界面概念模型中,认知主体和计算机的交互过程如图5所示,认知主体通过击键或指点向应用程序输入指令,应用程序通过窗口、图标、菜单以及文本向认知主体反馈信息。这种界面模型将认知主体的注意力集中在如何使用计算机上而不是任务的本身。

图4 人机交互的适应发展 图5 传统WIMP界面范式的交互过程

人机交互大师Turk曾给自然地用户界面下过如下定义:最自然的人机交互技术是指那些能够利用人类自然地认知和感知能力、社会技能以及我们从小就养成的行为习惯。由图6的五种人的感知通道所衍生出的界面形式称为可感知用户界面(Perceptual User Interface, PUI)

图6 PUI的几种感知通道

可感知用户界面(PUI)目前主要集中在以下几大领域:触控交互、笔式交互、机器视觉交互、语音交互、脑-机交互、其他传感器类交互以及多通道交互领域。

触控交互技术已普遍渗入到人的生活当中,触控手机和平板电脑就是这类交互技术的应用实例。美国苹果公司(Apple)将电容屏应用到智能手机当中,推出了iPhone、iTouch以及iPad智能手机和智能平板电脑系列,随后这种触控交互的电子产品风靡全球,几乎将现在所有的智能手机的交互方式都更新了一遍。

图7 iPhone和iPad

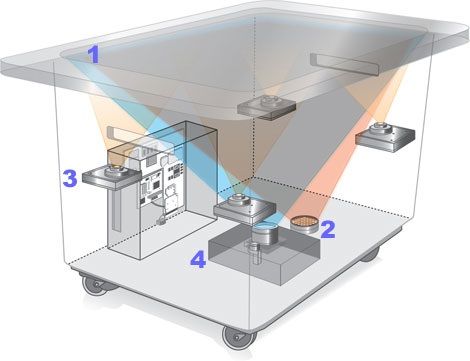

微软(Microsoft)是多点触控技术的先行者,Microsoft Surface强调使用更为直觉,不需使用任何鼠标及键盘。搭配30寸的大型显示器,其机构外型很像张桌子,可以同时让很多人在上面触控操作。与一般触控式电脑最大不同在于提供了多点触控(Multi-Touch)功能,可以同时辨识多点的触控资讯,可让多人同时使用一台Surface电脑。严格意义上来讲,像Surface这类交互设备应属于机器视觉交互的范畴,图8右图是Surface的内部构造,它是由位于底部的一个摄像机来获取到人手指的位置和运动信息然后进行分割识别处理而得到交互语义的。但是在交互过程中不存在机器视觉交互的“金手指”问题,所以它更具备触控交互的特点。

图8 微软Surface应用和构造

笔式交互技术应该也属于触控交互,但由于在交互设备上需要用一支电子笔,所以将其单独划为一类。“汉王”的手写设备就是这类交互方式的典型代表。这类设备和上面的触控设备相比不同处除了多了一只电子笔外,其所用的触屏多是电阻屏。笔式交互提倡回归文明、回归自然,特别是对于具有悠远文字文明的我们,笔式交互让我们更贴近汉字文明。

图9 笔式手写设备

视觉通道是人与人之间进行交流的一种重要途径,尽管有很多其他方法可以替代视觉进行交流,但人们更原意采用可视的途径交流,因为这样更符合人们的交流习惯-面对面的交流。基于视觉的交互也称为基于视觉的用户界面(Vision Based Interface, VBI),在人机交互上下文环境中,使用计算机视觉技术来感知用户称为基于视觉的交互。VBI是PUI的一个研究子域,它更多地关注于用户的视觉感知行为。这是一个多学科交叉领域,它结合了计算机视觉、图像处理、模式识别、人机交互、行为心理学等研究成果。视觉用户界面试图回答以下问题【Turk 1998】

1、存在和位置:有人在那里么?有多少人他们在哪里?[人脸检测、身体检测、头部和身体跟踪]

2、身份:他们是谁?[人脸识别、步态识别]

3、表情:用户正在微笑、皱眉、大笑还是说话?[面部表情识别、表情建模和分析]

4、注意焦点:用户正在看什么?[头部/面部跟踪,目光跟踪]

5、身体姿势和运动:用户的整体姿势和运动是什么?[身体建模和跟踪]

6、手势:用户的头部、手、身体的运动表达了什么样的语义信息?[手势识别、头部跟踪]

7、行为:用户正在做什么事情?[人体运动分析]

利用视觉手势可以方便、有效地完成以下任务:

1、代替鼠标完成指点和勾画任务;

2、虚拟环境中漫游以及操纵虚拟对象;

3、控制家电设备(例如电视、CD播放机等)和指挥机器人;

4、通过手语进行交流。

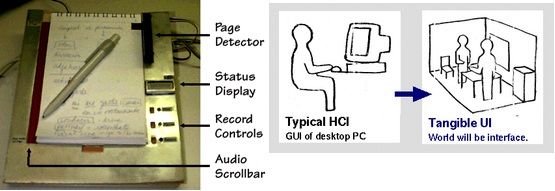

目前,基于视觉的交互是人机交互领域的一个研究热点。如智能相机、Anote 数码笔以及微软的XBOX体感游戏机都是这一领域的研究成果。严格地讲,Anote数码笔虽然采用了视觉处理技术,但应该属于实物操作界面(Tangible User Interface, TUI)的范畴。实物操作界面倡导的是周围环境中的物体都是交互的接口(World will be interface.)。Anote数码笔是由数码纸和数码笔组成的,所谓的数码纸就是普通的纸,数码笔就是一支普通的圆珠笔。它通过微型摄相头读入笔尖高速书写的笔迹和Anote 数码纸的微点坐标,微处理器分析处理后通过蓝牙无线或USB等方法转送到电脑或携带手机之中。们只需用「Anote 数码笔」在「Anote 数码纸」上与平常一样书写与记录、就可以将信息简便的输入电脑。

图10 Anote数码笔和TUI交互

视觉交互技术的另一项商业化应用就是东芝公司推出的具有手势识别功能的笔记本。东芝Qosmio G55可通过摄像头来识别用户的手势,之后软件可把手势转换成指令进行相关操作。用户通过手势可进行音乐、视频播放以及PowerPoint演示等操作,使用者在摄像头前3英尺到10英尺的范围内做出手势便可。

(1) (2) (3)

图11 (1)为东芝Qosmio G55可手势识别笔记本;(2)CamSpace;(3)微软体感交互家庭游戏机。

由CamSpace小组开发的视觉交互软件基于实际物体的颜色特征,可在短时间内创建一个自己的游戏控制器。真正做到了“any game, any webcam”。只是精确度上要比任天堂的WII手柄略逊一筹。

视觉交互领域另一个不得不提的里程碑式的应用就是微软的体感控制器KINECT,它将以色列人的深度传感器推向了商业化应用。KINECT的出现弥补了彩色摄像头的不足,使得普通摄像头下无法解决的难题迎刃而解。自从2011年11月KINECT发布以来,这项技术已被应用到诸多领域,而且以后还会得到更长远的发展。KINECT是一款基于Light Coding技术的立体成像传感器。它可以实时(目前是每秒30帧,实际应该比这个还要高)地捕获到空间的三维信息。微软将其用于对人体动作的识别领域,通过肢体分割和动作识别可以分析出人的动作然后转化成相应的控制信号对虚拟人物或其他设备进行控制。

语音交互技术已发展多年,微软的Windows操作系统从Vista版本以后都集成了语音指令操作功能。用户可以通过语音操作指令来完成基本的操作功能,如打开文件、输入字符等。其实,微软在早期就发布了TTS(Text to Speech)语音发音包和语音识别包,开发者可以利用这两个语音包实现语音发音和语音识别的功能;此外,IBM/Via Voice连续中文语音识别系统经过不断改进,也已广泛应用于Office/XP的中文版等办公软件和应用软件中,在中文语音识别领域有重要影响。

图12 语音识别

脑-机交互目前只能在实验室中见到,脑-机交互也称之为“意念交互”、脑-机接口(Brain-computer interface, BCI)。利用脑电信号实现人脑与计算机或其他电子设备的直接通讯和控制。 BCI技术结合了神经科学、心理认知科学和智能信息处理等领域的最新成果 。

图13 脑-机交互

除了上述的交互领域,我们还会看到很多基于其他传感器的交互方式,如任天堂的WII操作手柄。这是一款主要面向游戏娱乐的操作设备,它里面包含了固态加速计和陀螺仪,可以实现倾斜和上下旋转、倾斜和左右旋转、围着主轴旋转(像使用螺丝刀)、上下加速度、左右加速度、朝向屏幕加速和远离屏幕加速等功能。类似的设备在现实中也较为常见,如PPT控制器也属此类,一般通过蓝牙技术与主机进行通信。

图14 WII手柄和WII操作场景

多通道交互(Multi-Modal Interaction, MMI)是一种使用多种通道与计算机通信的人机交互方式。采用这种方式的计算机用户界面称为“多通道用户界面”。通道(Modality)这个词源于心理学的概念,涵盖了用户表达意图、执行动作或感知反馈信息的各种通信方法,如言语、眼神、脸部表情、唇动、手动、手势、头动、肢体姿势、触觉、嗅觉或味觉等。

按照摩尔(Moore)定律,计算机硬件每18个月就翻新一代,计算机软件每5年升级一代,而用户界面则要15到20年更新一代。迄今为止,用户界面的发展经历了三个主要的时代。这三个时代可以用三种截然不同的界面风格来划分。每一种界面风格都持续了若干年,并不断被当时新的硬件技术所优化,然后形成进入下一个时代。每一个新的时代都较前一个时代而言,能更大限度地拓展人机交流的带宽,提高用户的生产力。在60年代到70年代,用户界面主要是字符界面,键盘是主要的交互设备;80到90年代进入了图形用户界面时代,鼠标作为主要的指点和定位设备;21世纪将会进入用户界面的新时代。

图15 人机交互范式和用户的生产力

计算机的运算速度、存储能力、以至整体计算能力一直在按照Moore定律成倍翻新。另一方面,人的认知能力(包括记忆、理解能力)是不随时间成倍增长的。因此人和计算机的交互就会存在严重的不平衡 。人机交互技术,从本质上讲,是为了减轻人的认知负荷,增强人类的感觉通道和动作通道的能力。所以新一代的用户界面将会秉承“无所不在的计算思想”,在五个“any”( access Any body, Any thing, Any-where, at Any time, via Any device)上进行延伸。计算机将会从我们的“眼前”消失融入到我们周围的环境中去。在这个过程中,图形用户界面(GUI)不会被替代,而是会被增强。图形用户界面将在以下几方面继续发展:

1、从直接控制到非直接控制(smart X, agents, SUI简易用户界面);

2、从二维到三维视感;

3、更准确的语音、手势识别;

4、高质量的触觉反馈设备;

5、更方便的界面开发工具;

6、增强“智能代理”功能;

7、 用视频摄像来识别用户的身份、位置、眼动和姿势。

人机交互作为一个年轻的学科其实并不年轻,在计算机诞生的那刻起人机交互就随之诞生了。在美国马里兰州召开的第一届人机交互大会,掀开了这一学科的展新篇章。转眼间,它已走过了30年。在这30年中,从理论到实践都取得了巨大的发展,相信未来几十年人机交互会给我们带来意想不到的惊喜。

最有影响的一些事件和成果:

(1)1945年,美国罗斯福总统的科学顾问Bush(1894~1974)在大西洋月刊上发表的《As we may think》的著名论文,提出了应采用设备或技术来帮助科学家检索、记录、分析及传输各种信息的新思路和名为Memex的一种工作站构想,影响着一大批最著名计算机科学家。

(2)1963年,美国麻省理工学院Sutherland开创了计算机图形学的新领域,并获1988年ACM图灵奖,他还在1968年开发了头盔式立体显示器,成为现代虚拟现实技术的重要基础。

(3)1963年,美国斯坦福研究所的Engelbart发明了鼠标器,他预言鼠标器比其他输入设备都好,并在超文本系统、导航工具方面取得了杰出的成果(Augmented Human Intellect Project),获1997年ACM图灵奖,鼠标器经过不断地改进,成为影响当代计算机使用的最重要成果。

(4)20世纪70年代,当时在Xerox研究中心的Alan Kay提出了Smalltalk面向对象程序设计等思想,并发明了重叠式多窗口系统,后经苹果、微软、麻省理工学院等单位的不断研究和开发,形成了目前广泛使用的图形用户界面的标准范式。

(5)1989年,TimBerners Lee在日内瓦的CERN用HTML及HTTP开发了WWW网,随后出现了各种浏览器(网络用户界面),使互联网飞速发展起来

(6)20世纪90年代,美国麻省理工学院Negroponte(他早在30年前就提出了交谈式计算机概念)领导的媒体实验室在新一代多通道用户界面方面(包括语音、手势、智能体等)做了大量开创性的工作他是畅销书数字化生存(Being Digital)的作者。

(7)20世纪90年代,美国Xerox公司PARC的首席科学家Mark Weiser(1952~1999),首先提出无所不在计算(Ubiquitous Computing)思想,并在此领域做了大量开拓性的工作。

本文提到的用户界面结构;

CHI

----GUI

----PUI

----VBI

----BCI

----TUI

----SUI