hadoop2.6的源码,都是一个模块,一个project,我怎么吧这些源码导入eclipse中了?

1. 选择你要导入了模块。common , hdfs , mapreaduce

2. maven 编译,不要编译整个源码,那样太耗时了

cmd下操作:

首先进入hadoop-maven-plugins文件夹 , mvn install

然后进入hadoop-common-project

mvn install -DskipTests

mvn eclipse:eclipse

有点慢.....

这样就把common project下的几个模块编译成了几个java工程,可以直接导入eclipse

3. 在进入hdfs-project , mapreduce 文件夹,编译:

mvn eclipse:eclipse 这就很快了!

4. 如果你只要看HDFS文件系统,你就可以只编译common包,然后导入hdfs里面的jar包,那么接下来就可以

调用hdfs提供的api写junit进行调试了。

要把common下的所有项目导入,要不然就会出现一个大的红色感叹号!

5. 我当时把整个项目都编译了一边,(注意一点,源文件夹地址不要有中文),然后直接把所有的项目都导入到了

可是哎,myEclipse启动到能用,没有十分钟不行啊.....!!![]()

还是要看那部分再导入把......

6. 还是多装几个eclipse把,要学那一块,就用哪个eclipse , 要不然,还没学,兴致就坏在这个慢慢的eclipse上面了。

怎样在windows上访问ubuntu?

也就是说,我们只是在linux中部署好了应用,但是可以通过windows

访问得到?这就有点像服务器和客户机的概念了,linux就是一个服务器!

在hadoop应用中,我在linux中已经部署好了hadoop,但是我想通过浏览器访问hadoop的节点信息的时候

我又不喜欢在ubutu上面去访问,其二,当我开发hdfs , mapreaduce 程序的时候,我想在linux上写,因为我所以

IDE都是在window上的,又要在linux上装一遍,麻烦!

所以,有没有一种方法,可以使所有的操作都在window上操作,而只是在linux中部署hadoop程序了?

1. 使ubutu的网络连接方式为仅主机模式

ubuntu网络连接的三种方式:

1. 桥接方式

2. NAT

3. 仅主机模式

2. 打开你的网络共享中心(联网的那个图标) , 然后更改适配器设置,只要按照了vmware就会有下面这两个:

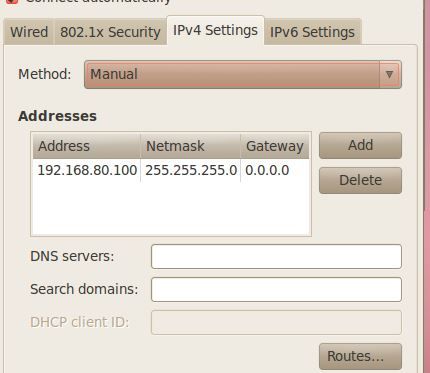

接下来, 右击vmnet1 ---> 属性---->双击ipv4-->填入如下属性:

因为接下来,我们就要设置ubutu的ip地址为192.168.80.1 到 192.168.80.255网段内某个!

3. 修改ubutu的ip地址 :

右击这个表示联网的图标,选择edit connection

然后,add : 选择iPv4 setttings , method 选 manual ,

ip地址为上面80网段中的任一个..其余两个相同。

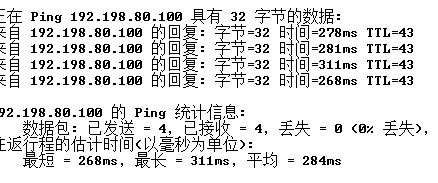

那么 接下来,就可以测试看是否能够连接上了 :

可以在window的cmd中输入 ping 192.168.80.100(ubuntu的ip)

这样,就可以访问了。你也可在linux中,ping 192.168.80.1测试。

那么接下来,你就可以在linux中,start-dfs.sh , 在window中的浏览器中输入192.168.80.100:50070进行访问了。

同样,通过pietty 输入 192.168.80.100 就可以在windows中,使用命令行操作ubuntu了,只是有点慢。

接下来就可以在window上,通过eclispe访问Ubuntu中的HDFS了?

可是这里有个揪心的地方,在eclipse中调用HDFS的api进行访问,设置的PATH= "hdfs://master:9000/" 可是

就是连接拒绝,但是浏览器却可以通过! 问题就在于不要把Ubuntu中的core-site.xml 中defaultFS的url写成localhost

要改成对应的ip或主机名!!! 但是现在又报一个异常,权限不足:

org.apache.hadoop.security.AccessControlException:Permission denied:user=Administrator,access=WRITE,inode="tmp":root:supergroup:rwxr-xr-x 。

这错误就得修改你电脑现在的用户名Adminstrator (开始菜单中有显示), 为ubutu中的普通用户名

现在你就可以通过eclipse在window中调用hdfs的api进行操作了!

只是我的报这种异常 :

Could not locate executable null\bin\winutils.exe in the Hadoop binaries

不过没关系,对hdfs的操作还是可以完成.

下一步就是,eclipse 的hadoop插件的安装!

自己下载对应版本的插件!!!!