Eclipse下Hadoop的MapReduce开发之eclipse配置

hadoop的安装部署这里就不赘述了。不了解的可以百度下或者看下我的前几篇文章。

首先下载Eclipse LUNA,这里注意如果你是想在远程电脑上使用eclipse,也就是hadoop安装在linux下,而你想在win系列的电脑上连接并编写MapReduce程序,那么需要进行一项配置。

打开hadoop文件目录,找到etc/hadoop/下的hdfs-site.xml,增加如下配置来关闭hdfs的权限设置

<property> <name>dfs.permissions</name> <value>false</value> </property>

这里为了方便截图,我将eclipse安装在了远程电脑上,win7系统。eclips的安装其实就是解压,无论是linux还是win系列都是一样的,这里就不介绍了。

下载完成后,还要下载一个eclipse的hadoop插件下载地址在此,然后解压eclipse。解压完成后找到${eclipse_home}/plugins文件夹,再将刚才下的插件粘贴进去,注意只要jar文件即可,hadoop2.6版本的jar名称应该是hadoop-eclipse-plugin-2.6.0.jar,最后启动eclipse。

eclipse启动后,找到Window>>preferences,找到Hadoop Map/Reduce,在右边设置hadoop的文件路径(如何非远程直接设置路径即可,如果远程需在本地电脑解压一个与安装hadoop同样版本的hadoop,然后指向这个目录即可,不用对此设置任何东西,这个目录主要提供一些依赖jar)

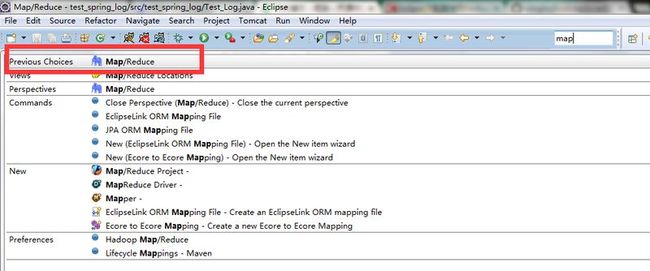

然后在工具栏找到一个文本框似的的东西,点击它输入Map,在弹出来的选择项中找到第一个,双击

双击后,在下面控制台部分会出现一个叫Map/Reduce Locations的页签,点击它,在面板里右键选择New Hadoop Location

在弹出来的页面中要设置如下几项;

location name:链接名称,随便写,比如hadooptest

Map/Reduce(V2) Master:master的地址和端口

DFS Master:文件系统的端口

User name:linux中运行hadoop的账户名称

其余默认即可,然后点击Finish。

点击后在左侧project explorer可以看到一个叫DFS Locations的项目,打开它就能看到hadoop文件系统中的所有文件,在这里你可以上传,可以下载,可以删除,也可以增加,比在linux下用命令操作舒服多了。