基于http live streaming视频直播在android上的实现(版本更新,支持高清AAC视频)

最近将视频客户端移植到了ANDROID平台。 分享一下开发心得。

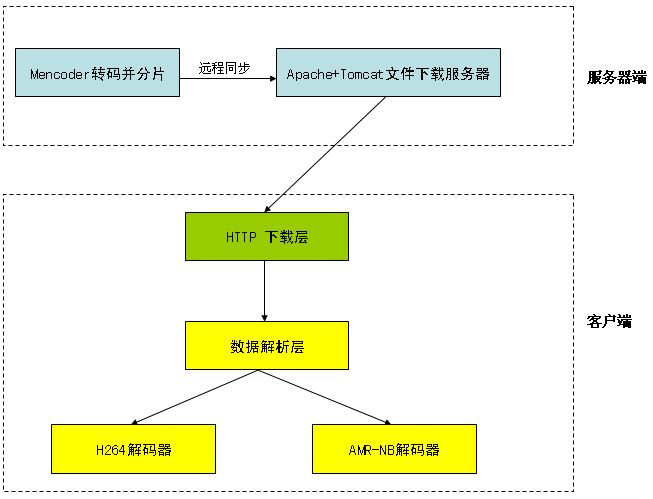

类似HTTP LIVE STREAMING的流式下载方式, 但APPLE的TS格式冗余数据太多, 我用的是私有格式,更加节省带宽资源。H264+AMRNB编码。每个分片文件20秒。整体架构如下图:

作为HTTP下载模块对稳定性要求比较高,用NDK的话debug会很麻烦,JAVA层下载效率也还行,所以采用JAVA层的HttpURLConnection类, 服务器端在Response header里包含了下一个文件的filename,下一次的连接时将把filename作为URL的一个参数发送。这样就能做到流式的下载。 建立一个bytearrayoutputstream实例来缓存数据。 并通过JNI传递给文件解析层。

因为JAVA与JNI层数据交互很耗时,所以选择下载好一个完整文件再feed给Parser。

AUDIO必须要流畅,所以单开一个thread, Video来得及的话可以用一个timer(减少一点功耗),开一个thread也行。

H264和AMR-NB都移植自OPENCORE, 手机用baseline够了。如果要支持AAC可用helix的AAC解码器或者OPENCORE AAC Decoder.

JNI解码好再回传给JAVA层显示所造成的延时是无法忍受的,所以选择在NDK层直接render画面和声音。 可参考android ffmpeg开源工程里的做法,或者有网友已经总结提取了方法:http://www.cnblogs.com/mcodec/。 付出的代价就是可移植性, 因为现成的libjnivideo.so和libjniaudio.so都是android 2.2版本的, 其他版本会提示can not load libjnivideo.so, 需要在ANDROID工程里重新编译。 ffmpeg和android media framework的代码都可下载:https://github.com/havlenapetr

发现在NDK使用usleep时CPU占用骤增, 所以在做音视频同步的时候,最好不要用usleep.

在V880上测试,在EDGE网络较稳定的情况下, 176*144, 10帧,视频码率48k,音频码率7.95k, 可以流畅播放。 以下是真机效果。(直播我暂时用feature phone的码流 码率只有32K,画面比较模糊)

最新版本美化了UI, 更加稳定优化的播放内核。 适配2.2以及2.3--4.0平台,2.3以上采用opengles+opensl es的方式渲染音视频。

支持标清(48-60k码率, H264+AMRNB编码),高清视频(300k-400k码率, H264+AAC编码)。效果见下图