搭建Hadoop时候遇到的一些问题以及解决方法

首先我的OS是ubuntu 12.10.

1、记住最好先装Open jdk。要是先装了Sun的其实也行,就是后面配置的时候优先级要设置的高一点,设置个3000神马的,这样才能识别为自动项。

2、我很没出息的下载的是.deb包,而不是源代码。因为简单使用

dpkg -i hadoop1.0.4.deb

就可以完成安装。当然安装之前的准备工作还是要做的。这边我要提醒大家注意的就是自己在装ubuntu系统的时候要注意home目录的安装权限,否则和我一样二逼兮兮到最后没办法创建新的用户,当然这个问题我还没有解决。估计只能重装系统了。

具体可以参考http://www.cnblogs.com/tippoint/archive/2012/10/23/2735532.html 或者Hadoop实战那本书

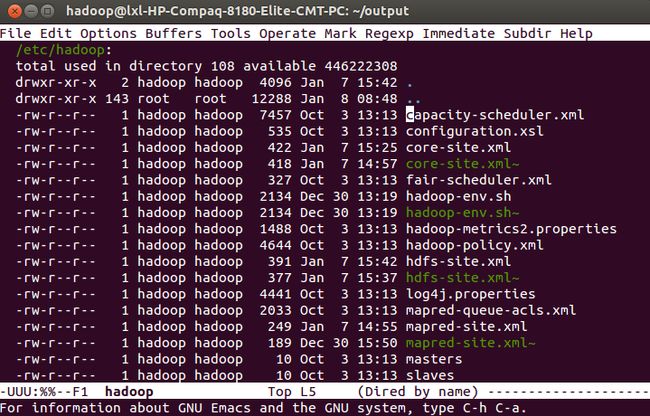

3、使用dpkg安装之后有几个路径需要记住,一个是

这个里面都是Hadoop相关的配置文件。所谓的伪分布式配置啦之类的东西都在这里

记住,一定要重新设置该文件夹的owner,如果owner不是hadoop的话

chown -R hadoop:hadoop /etc/hadoop第二个文件目录是这个

这个就是examples还有一些lib啊之类所在

也要Chown的!!!!!

4、若是使用

hadoop fs -ls的时候报错,类似与无法链接local host的那种,首先检查是不是namenode配置的问题。如果不是那就是因为默认的hadoop会把一些临时文件放在/tmp文件夹下面。这样每次重启之后namenode相关的信息就会丢失,这个时候就会导致无法链接的问题。

我们需要重新设置tmp目录。在你喜欢的地方建立haoop_tmp文件夹存放临时文件

然后在/etc/hadoop/coresite.xml中

<property> <name>hadoop.tmp.dir</name> <value>~/hadoop_tmp</value> <description>A base for other temporary directories</description> </property>一定要记得给这个刚刚建立额hadoop_tmp也要chown!!!!!!不然后面会一直有permission denied的问题!!!!!!!!!!!!!!

5、最后,在使用wordcont的时候。上传本地文件到hdfs上的命令如下

hadoop fs -put [src] [dest]获得Haoop上面的文件的命令是

hadoop fs -get [src] [dest]

要是还有什么其他的问题下次接着记下来