Hbase完全分布式集群安装配置

(Hbase1.0.0,Hadoop2.6.0)

1.安装软件

OS:centos6.5

Hadoop:hadoop2.6.0

Hbase:hbase.1.0.0

JDK: jdk1.7.0_51

集群机器:

192.168.153.130(hadoop130 namenode)

192.168.153.131 (hadoop131datanode)

192.168.153.132 (hadoop132datanode)

2.安装步骤

如下安装步骤假设的JDK已经安装,如果未安装请自行查找JDK安装教程。

2.1 安装hadoop

(1)下载hadoop版本(hadoop2.6.0),下载地址:http://www.apache.org/dyn/closer.cgi/hadoop/common/ 在此路径下选择相应的版本下载。

(2)解压hadoop-2.6.0.tar.gz

tar zxvf hadoop-2.6.0.tar.gz -C /home/hadoop001/thirdparty/

将hadoop解压到/home/hadoop001/thirdparty/ 目录下。

(3)将hadoop添加到环境变量中

vim ~/.bashrc 打开.bashrc文件添加HADOOP_HOME

exportJAVA_HOME=/home/hadoop001/thirdparty/jdk1.7.0_51

export PATH=$HADOOP_HOME/bin:$PATH

(4)修改配置文件($HADOOP_HOME/etc/hadoop目录下)

配置core-site.xml

配置hdfs-site.xml:

配置mapred-site.xml文件

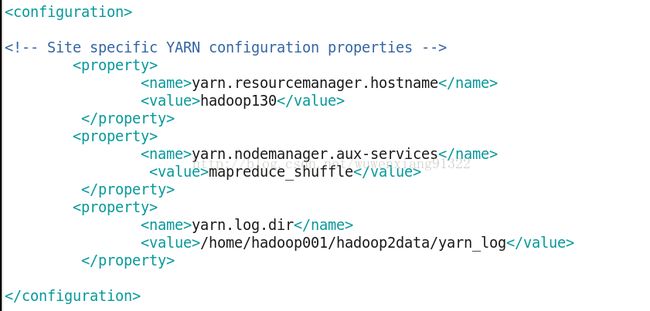

配置yarn-site.xml文件

修改slaves文件,添加datanode节点hostname到slaves文件中

hadoop131

hadoop130

(5)格式化集群,在hadoop130节点上执行如下命令:

hadoopnamenode -format

(6)启动集群,在hadoop130节点上执行如下命令:

start-all.sh

(7) 通过浏览器查看hadoop是否安装成功:

输入: http://hadoop130:50070

输入:http://hadoop130:8088/

2.2 安装Hbase

(1)下载hbase版本

下载地址:http://www.apache.org/dyn/closer.cgi/hbase/,在此路径下选择相应的版本下载,本次安装下载hadoop1.0.0版本

(2)解压hbase-1.0.0-bin.tar.gz

tar zxvf hbase-1.0.0-bin.tar.gz �C/home/hadoop001/thirdparty/

(3)将hbase添加到环境变量中

exportHBASE_HOME=/home/hadoop001/thirdparty/hbase-1.0.0

export PATH=$HBASE_HOME/bin:$PATH

(4)修改配置文件

修改hbase-env.sh

exportJAVA_HOME=/home/hadoop001/thirdparty/jdk1.7.0_51

修改hbase-site.xml

备注:

在上面的配置文件中,第一个属性指定本机的hbase的存储目录;第二个属性指定hbase的运行模式,true代表全分布模式;第三和第四个属性是关于Zookeeper集群的配置。我的Zookeeper安装在hadoop130,hadoop131和hadoop132上。

修改regionservers,在regionservers文件中添加如下内容:

hadoop131

hadoop130

(5)启动hbase

启动hbase时要确保hdfs已经启动。在主节点上执行:

start-hbase.sh

启动成功后集群会多出如下进程:

NameNode节点:

Datanode节点:

通过浏览器查看:

输入:http://hadoop130:16030

2.3 Hbase shell测试

(1)执行hbase shell 命令:

(2)创建testtable表

create 'testtable', 'colfaml'

(3)put数据

hbase shell是基于Ruby实现的,因此使用过程中可以将hbase shell与Ruby代码混合使用,此示例参考《HBase权威指南》p-66页shell介绍。

for i in 'a'..'z' do for j in 'a'..'z' do \

put 'testtable' , "row-#{i}#{j}","colfaml:#{j}" ,"#{j}" end end(4)查看插入数据

scan 'testtable'

部分结果截图:

3.常用参数(待续)

4.备注

目前安装所有配置都是最简配置,并没有考虑参数优化,此教程的目的是让Hbase先跑起来,优化后期继续做。