第十集 特征选择

本讲首先介绍了VC维的概念——该概念能够将关于ERM一般误差的界的结论推广到无限假设类的情形;之后介绍了模型选择问题——具体介绍了交叉验证方法以及几种变形;最后介绍了特征选择问题——具体介绍了两类方法:封装特征选择和过滤特征选择。

VC维

定义:给定一个由d个点构成的集合![]() ,如果假设类集合H可以实现S的任意一种标记方式(labley),我们就说H能够分散集合S。

,如果假设类集合H可以实现S的任意一种标记方式(labley),我们就说H能够分散集合S。

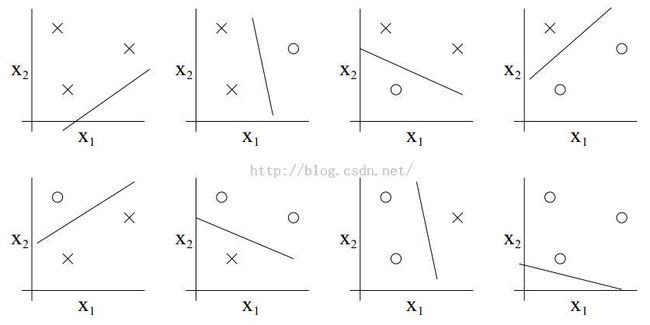

假设H是一个包含了所有二维线性分类器的假设类,如图所示:

以上图形表示了这三个点所构成的集合能够被H分散。

定义:VC维:VC(H)表示能够被H分散的最大集合的大小。

下面不加证明的提出:![]() 。例如对于包含了所有二维线性分类器的假设类H,其VC维就为3。

。例如对于包含了所有二维线性分类器的假设类H,其VC维就为3。

要证明一个假设类的VC(H)=d,只需找到至少一个集合S满足要求即可。

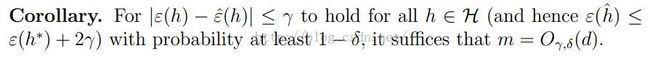

一致收敛:

给定一个假设类H,令VC(H)=d,在至少为 的概率下, ![]() 。

。

因此,在至少为 的概率下,我们可以得到:

具体证明过程上节课提到过,另外这里的大O符号省略了2这个系数。

下面提出一个引理:

这说明了样本数目基本要与VC维d成正比关系。

其实对于多数合理的假设类,VC维也总是和模型参数的数量呈正比。举例来说,在logistic回归中,特征向量x为n维,参数![]() 有n+1个,VC维也为n+1。

有n+1个,VC维也为n+1。

注意到上述证明是没有用到假设类H是有限的这一假设的,也就是说上述结论可以应用到假设类H味无穷的情况下。

下面陈述一个事实,具有较大间隔的线性分类器的假设类都具有较低的VC维。若仅考虑半径R以内的点,设分类器的min margin为gamma,则:![]()

,那个比较奇怪的符号为上取整。

模型选择

在实际的学习问题中,我们可以有多种模型来进行选择。比如要拟合一组样本点,可以使用线性回归,也可以用多项式回归。那么使用哪种模型好呢(能够很好的完成偏差方差权衡)?

还有参数选择的问题:例如我们要进行局部加权回归分析,那怎么去寻找权重项中最优的波长系数?还有如何确定在L1 norm 软间隔SVM中的C来进行适当的惩罚?

设![]() 为包含有限个模型的集合。我们要在其中找出最优的模型。可能会有人问,为什么不直接遍历所有的模型来寻找最小的训练误差从而找出最优的模型?这是因为如果遍历的话,注定会造成过拟合和高方差,缺乏泛化性。

为包含有限个模型的集合。我们要在其中找出最优的模型。可能会有人问,为什么不直接遍历所有的模型来寻找最小的训练误差从而找出最优的模型?这是因为如果遍历的话,注定会造成过拟合和高方差,缺乏泛化性。

交叉验证

这部分参考博客园用户JerryLead的笔记。

对于leave-one-outcross validation来说,它只适用于样本数量非常非常少的情况下,因为它所要求的计算量相当大。

特征选择

前向搜索(前向选择)算法和后向搜索(后向选择)算法理论上都能取得很好的结果,但是计算复杂度很高。