第3课通过案例对SparkStreaming 透彻理解:解密SparkStreaming运行机制和架构进进阶之Job和容错

作者:大数据技术爱好者--谢彪

一、集群上运行案例:

package com.dt.spark.sparkstreaming

import org.apache.spark.SparkConf

importorg.apache.spark.streaming.{Seconds,StreamingContext}

object OnlineForeachRDD2DB {

defmain(args:Array[String]){

valconf = new SparkConf()//创建SparkConf对象

conf.setAppName("OnlineForeachRDD")//设置应用程序的名称,在程序运行的监控界面可以看到名称

// conf.setMaster("spark://Master:7077")//此时,程序在Spark集群

conf.setMaster("local[6]")

//设置batchDuration时间间隔来控制Job生成的频率并且创建SparkStreaming执行的入口

valssc = new StreamingContext(conf, Seconds(5))

val lines =ssc.socketTextStream("Master", 9999)

val words =lines.flatMap(_.split(" "))

valwordCounts = words.map(x => (x, 1)).reduceByKey(_ +_)

wordCounts.foreachRDD{ rdd =>

rdd.foreachPartition{ partitionOfRecords => {

//ConnectionPool is a static, lazily initialized pool ofconnections

valconnection = ConnectionPool.getConnection()

partitionOfRecords.foreach(record=> {

valsql = "insert into streaming_itemcount(item,count)values('" +record._1 + "'," + record._2 + ")"

valstmt = connection.createStatement();

stmt.executeUpdate(sql); })

ConnectionPool.returnConnection(connection) //return to the pool forfuturereuse

} }

}

ssc.start()

ssc.awaitTermination()

}

}

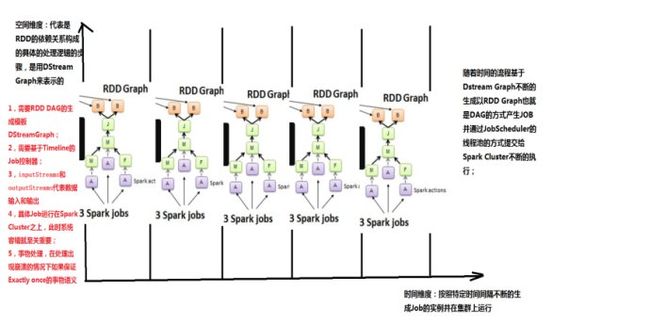

二、通过运行上述案例代码,从web界面中可知其背后的RDD的依赖关系

以上述图可知:

1、在StreamingContext调用start方法的内部其实是会启动JobScheduler的Start方法,进行消息循环,在JobScheduler的start内部会构造JobGenerator和ReceiverTacker,并且调用JobGenerator和ReceiverTacker的start方法:

(1)、JobGenerator启动后会不断的根据batchDuration生成一个个的Job

(2)、ReceiverTracker启动后首先在SparkCluster中启动Receiver(其实是在Executor中先启动ReceiverSupervisor),在Receiver收到数据后会通过ReceiverSupervisor存储到Executor并且把数据的Metadata信息发送给Driver中的ReceiverTracker,在ReceiverTracker内部会通过ReceivedBlockTracker来管理接受到的元数据信息

(3)、每个BatchInterval会产生一个具体的Job,其实这里的Job不是SparkCore中所指的Job,它只是基于DStreamGraph而生成的RDD的DAG而已,从Java角度讲,相当于Runnable接口实例,此时要想运行Job需要提交给JobScheduler,在JobScheduler中通过线程池的方式找到一个单独的线程来提交Job到集群运行(其实是在线程中基于RDD的Action触发真正的作业的运行)。

2、为什么使用线程池呢?

(1)、作业不断生成,所以为了提升效率,我们需要线程池;这和在Executor中通过线程池执行Task有异曲同工之妙。

(2)、有可能设置了Job的FAIR公平调度的方式,这个时候也需要多线程的支持。

-

资料来源于:DT_大数据梦工厂(Spark发行版本定制)

-

DT大数据梦工厂微信公众号:DT_Spark

-

新浪微博:http://www.weibo.com/ilovepains

-

王家林老师每晚20:00免费大数据实战

YY直播:68917580